Introduction

Pour peu que l’on soit intéressé par les voitures de course, on a forcément débattu des performances de deux modèles avec quelqu’un d’autre. L’un peut avoir plus de chevaux-vapeur, une vitesse maximale plus élevée, une meilleure tenue de route ou encore un poids mieux contenu. Ce genre de discussion débouche généralement sur la comparaison des chronos sur un circuit, jusqu’au moment où l’on finit par se rappeler que ces voitures sont de toute manière inaccessibles.

L’appréciation des cartes graphiques haut de gamme est assez similaire sur de nombreux points : on a par exemple le débit d’ips en moyenne, la variance interimages, le bruit émis par le système de refroidissement ainsi que des niveaux de prix qui peuvent aller jusqu’au double d’une PS4 ou Xbox One. Certaines des dernières cartes graphiques vont même jusqu’à profiter de carénages en aluminium ou magnésium, exactement comme les voitures de course. Ceci étant dit, certaines différences subsistent : on se voit mal parader dans les rues avec la meilleure carte graphique du moment entre les mains.

Quel est donc l’équivalent du temps au tour pour une carte graphique ? Quelle est LA mesure qui permet de départager les produits à coût égal ? Il est bien évident que l’on ne peut pas se contenter des performances moyennes en ips vu la part belle que nous avons faite à la variance interimages, au tearing et micro-saccades ainsi qu’aux dissipateurs qui font un bruit de réacteur. On en vient alors aux caractéristiques techniques avancées : fill rate, performances en calcul, bande passante mémoire. Quel est le poids de ces indicateurs ? A l’image d’un mécanicien dans un paddock de Formule 1, faut-il se résigner à mettre un casque pour tolérer le bruit d’une nouvelle carte graphique ? Enfin, comment tenir compte du potentiel d’overclocking de chaque modèle lorsque nous les évaluons ?

Avant de s’attaquer aux mythes qui entourent les cartes graphiques actuelles, commençons par définir la notion de performance.

La performance ne se limite pas à un seul indicateur : elle est globale

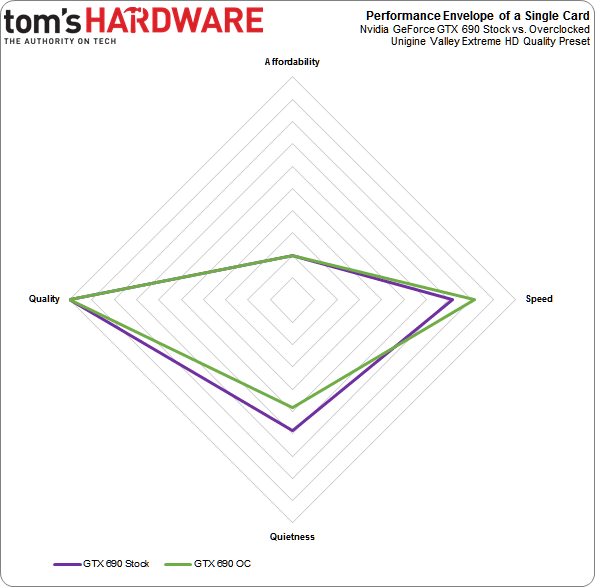

Les discussions portant sur la performance d’un GPU sont souvent limitées à des généralisations sur les FPS ou encore le nombre d’ips en moyenne, alors que la performance est une notion qui va au-delà de la vitesse à laquelle une carte est capable de rendre les images. Mieux vaut donc raisonner en termes d’enveloppe selon quatre principaux critères : vitesse (images par seconde, latence interimages et input lag), qualité (définition et qualité d’image), nuisances sonores (performances acoustiques, essentiellement dépendantes de la consommation et du dissipateur) et bien entendu le prix.

L’attractivité d’une carte graphique dépend également d’autres facteurs comme par exemple un bundle de jeux ou encore les technologies propres aux constructeurs. Nous les aborderons rapidement sans pour autant essayer de mesurer leur intérêt : CUDA, Mantle ou encore ShadowPlay sont des fonctionnalités très intéressantes pour certains, tandis que d’autres les perçoivent comme gadget.

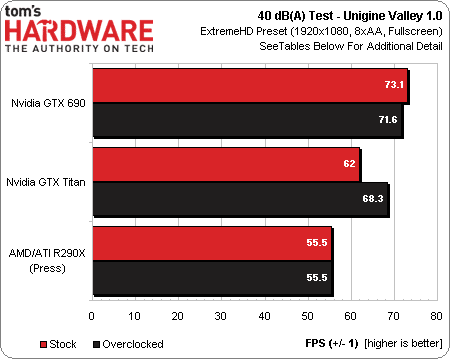

Le graphique ci-dessus illustre le positionnement de la GTX 690 au sein de l’enveloppe variable que nous venons de décrire. A fréquences d’origine, elle atteint 71,5 ips sur Unigine Valley 1.0 en profil Extreme HD (la configuration de test est décrite sur la page suivante). La carte génère alors un bruit audible sans pour autant être dérangeant : 42,5 dB(A). A condition d’accepter un niveau sonore que l’on qualifierait presque de bruyant, il est possible d’overclocker facilement la GTX 690 pour atteindre 81,5 ips stables sur le même test. Bien entendu, la baisse de la définition ou du niveau d’anti-aliasing (et donc la qualité visuelle) permettait d’obtenir des performances encore plus élevées, de même que le prix avoisinant les 1000 euros est une constante.

Dans le but de faire des tests avec un contrôle plus important que ce que l’on a l’habitude de voir, commençons par définir une performance de référence.

Pour cet article, nous précisons les performances suivant le nombre d’ips qu’une carte est capable de débiter dans un cadre déterminé (jeu, définition) selon l’enveloppe définie et les conditions suivantes :

- Réglages maximum pour chaque programme/jeu (typiquement Ultra ou Extreme)

- Définition réglée à un niveau constant (1920×1080, 2560×1440, 3840×2160 ou encore 5760×1080 sur trois moniteurs en fonction du programme/jeu)

- Pilotes réglés par défaut (qu’il s’agisse de paramètres globaux ou par application)

- Tests effectués dans un boitier fermé, avec un niveau de bruit de 40 dB(A) à environ un mètre de la configuration (idéalement, sur une machine profitant d’une évolution matérielle annuelle)

- Température ambiante de 20°C et pression atmosphérique constante (critères importants vu qu’ils ont une influence directe sur l’abaissement automatique des fréquences en cas de surchauffe)

- Fréquences GPU et mémoire parvenant à un équilibre après mise en sécurité (le but étant de les stabiliser autant que possible suivant une cible de 40 dB(A), avec des ventilateurs fonctionnant à la vitesse qui en découle)

- Maintenir la variance interimages au 95ème centile en dessous de 8 ms, c’est-à-dire une demi-image pour un moniteur 60 Hz

- Utiliser les GPU à 100 % ou presque (important pour montrer l’absence de goulet d’étranglement sur le reste de la configuration, faute de quoi les résultats des benchmarks ne sont pas vraiment significatifs)

- Moyenne d’ips et variance interimages calculées au moins trois fois pour chaque mesure donnée, à raison d’une minute minimum par boucle de test sachant qu’une carte ne doit pas afficher d’écarts supérieurs à 5 % par rapport à la moyenne (nous souhaitons idéalement tester plusieurs modèles d’une même série, a fortiori lorsque nous sommes convaincus qu’il existe des écarts d’une marque à l’autre)

- Relever les mesures avec Fraps pour une carte seule (ou tout autre compteur d’ips intégré) ; FCAT est une nécessité pour les configurations en SLI/CrossFire

Naturellement, la performance de référence dépend non seulement du jeu mais aussi de la définition. Ceci étant dit, nous la caractérisons de manière à pouvoir répéter et vérifier chaque test individuellement : de cette manière, l’approche est vraiment scientifique. Qu’il s’agisse de particuliers comme de professionnels, nous encourageons d’ailleurs tout le monde à reproduire nos tests pour porter d’éventuelles failles à notre attention. Il n’y a pas de meilleure garantie pour ce qui est de l’intégrité de notre travail.

La définition de la performance de référence ne tient pas compte de l’overclocking, ni de la variété de comportements qu’un GPU est susceptible de montrer d’une carte à l’autre. Fort heureusement, nous verrons que ce point n’est que rarement problématique. Les dispositifs de régulation modernes sont conçus pour que les cartes débitent un maximum d’ips dans un très large éventail de situations : plus que jamais, les cartes graphiques fonctionnent au plus près de leurs limites. Ces dernières sont souvent atteintes avant que l’overclocking ne puisse avoir un intérêt en situation de jeu réel.

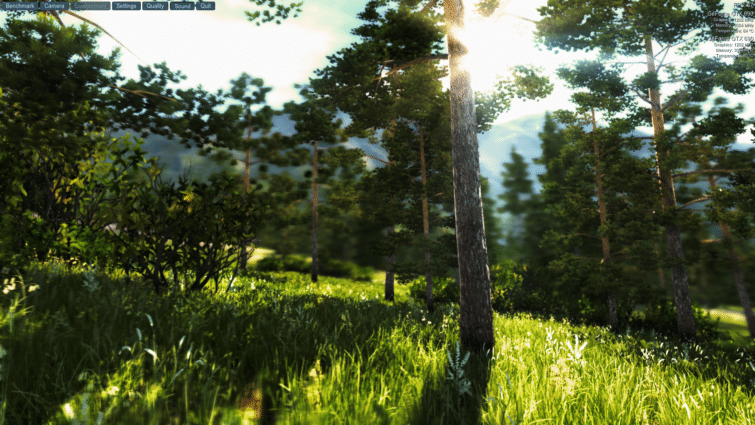

Nous avons eu largement recours à Unigine Valley 1.0 pour cet article, du fait qu’il contienne de nombreuses fonctionnalités permises par DirectX 11 et produise des résultats particulièrement constants. D’autre part, il ne s’appuie pas autant sur les calculs physiques (et donc au processeur) que 3D Mark (tout du moins dans les tests globaux et combinés de ce dernier).

Quel est le but de la démarche ?

Nous prévoyons d’aborder chaque composante de l’enveloppe de performances des cartes graphiques au cours de cet article en deux parties, afin de pouvoir répondre à quelques questions courantes. Input lag, display ghosting et tearing seront également évoqués parce qu’à défaut d’être spécifiquement liés au nombre d’ips, ces trois points sont conditionnent également l’expérience de jeu. Nous souhaitons d’ailleurs utiliser ces indicateurs pour comparer les cartes. Comme on peut l’imaginer, cette approche est extrêmement chronophage, mais il nous semble qu’elle apporte un nouvel éclairage qui en vaut bien la peine. Ceci ne veut pas dire que nos tests de cartes graphiques vont changer du jour au lendemain : il s’agit d’une expérimentation que nous souhaitons partager.

Après avoir défini la notion de performance, il nous reste encore à aborder le protocole de test, la synchronisation verticale, le bruit, le niveau de bruit ajusté des cartes graphiques et enfin la quantité de mémoire vidéo nécessaire. Ces sujets sont abordés dans cette première partie, tandis que les différentes méthodes d’anti-aliasing, les conséquences qui découlent du choix de moniteur, les diverses configurations PCI Express et enfin la notion de rapport performances/prix seront abordés au cours de la deuxième partie.

Passons maintenant à la configuration du test, plus importante qu’à l’accoutumée dans la mesure où elle contient d’importantes informations relatives aux tests effectués.

Configuration du test

Tous les tests ont été effectués sur deux configurations différentes : l’une s’appuie sur un Intel Core i7 950 qui va sur ses quatre ans, tandis que l’autre se base sur un Core i7 4770K.

| Configuration n°1 | |

|---|---|

| Boîtier | Corsair Obsidian Series 800D, format grand tour |

| Processeur | Intel Core i7-950 (Bloomfield), O/C @ 3,6 GHz, Hyper-Threading et économies d’énergie désactivées |

| Dissipateur | CoolIT Systems ACO-R120 ALC, pâte Tuniq TX-4 T, ventilateur Scythe GentleTyphoon 1850 tpm |

| Carte mère | Asus Rampage III Formula Intel LGA 1366, chipset Intel X58, BIOS 903 |

| DRAM | Corsair CMX6GX3M3A1600C9, 3 x 2 Go, 1600 MT/s, CAS 9 |

| Cartes graphiques | AMD Radeon R9 290X 4 Go (version presse) NVIDIA GeForce GTX 690 4 Go (version commerce) NVIDIA GeForce GTX Titan 6 Go (version presse) |

| Stockage | Samsung 840 Pro, SSD 128 Go, SATA 6 Gb/s |

| Alimentation | Corsair AX850, 850 Watts |

| Réseau | Cisco-Linksys WMP600N (Ralink RT286) |

| Carte son | Asus Xonar Essence STX |

| Logiciels et pilotes | |

| OS | Windows 7 Professionnel 64 bits, Aero désactivé (voir notes ci-dessous) Windows 8.1 Pro 64 bits (seulement à titre de référence) |

| DirectX | DirectX 11 |

| Graphiques | AMD Catalyst 13.11 Beta 9.5; NVIDIA GeForce 331.82 WHQL |

| Configuration n°2 | |

|---|---|

| Boîtier | Cooler Master HAF XB |

| Processeur | Intel Core i7-4770k (Haswell), O/C @ 4,6 GHz, Hyper-Threading et économies d’énergie désactivées |

| Dissipateur | Xigmatek Aegir SD128264, pâte Xigmatek, ventilateur Xigmatek 120 mm |

| Carte mère | ASRock Extreme6/ac Intel LGA 1150, chipset Intel Z8, BIOS 2.20 |

| Dram | G.Skill F3-2133C9D-8GAB, 2 x 4 Go, 2133 MT/s, CAS 9 |

| Cartes graphiques | AMD Radeon R9 290X 4 Go (version presse) NVIDIA GeForce GTX 690 4 Go (version commerce) NVIDIA GeForce GTX Titan 6 Go (version presse) |

| Stockage | Samsung 840 Pro, SSD 128 Go, SATA 6 Gb/s |

| Alimentation | Cooler Master V1000, 1000 Watts |

| Réseau | carte mini-PCIe Wi-Fi 802.11ac incluse |

| Carte son | puce Realtek ALC1150embarquée |

| Logiciels et pilotes | |

| OS | Windows 8.1 Professionnel 64 bits |

| DirectX | DirectX 11 |

| Graphiques | AMD Catalyst 13.11 Beta 9.5; NVIDIA GeForce 332.21 WHQL |

La première configuration de test devait nous permettre de faciliter la reproductibilité des tests en dehors du laboratoire, raison pour laquelle nous avons choisi une configuration relativement ancienne (mais loin d’être dépassée) sur socket LGA 1366 au sein d’un boitier au format grand tour.

La seconde configuration devait répondre à des besoins plus spécifiques :

- Gérer le PCIe 3.0 avec un nombre de lignes limité (une carte mère LGA 1150 avec un processeur Haswell, lequel n’en propose que 16).

- Pas de pont PLX

- Prise en charge du CrossFire à trois cartes en 8x/4x/4x et du SLI en 8x/8x

ASRock nous a envoyé sa Z87 Extreme6/ac dont l’UEFI s’est avéré très pratique : il est possible de régler le débit des ports PCI Express un par un, ce qui nous a permis d’exécuter successivement les tests en PCIe révision 1,2 et 3 sur la même carte mère. Les résultats obtenus seront présentés au sein de la deuxième partie de cet article.

Cooler Master nous a fait parvenir son HAF XB dont nous avons pu voir les qualités il y a un peu moins de 6 mois.

Les deux configurations de test comparées

Au-delà de leurs architectures respectives, il est frappant de voir comment ces deux configurations se tiennent dans un mouchoir de poche lorsqu’il s’agit d’ips : voici le duel sous 3DMark Firestrike pour s’en convaincre.

On peut donc voir que les performances sont quasiment identiques lorsqu’il s’agit de tests graphiques, alors que la deuxième configuration bénéficie d’un meilleur débit mémoire (2133 contre 1800 MT/s, ce qui est contrebalancé par le fait que Nehalem s’appuie sur une architecture triple channel contrairement au dual channel utilisé par Haswell). Seuls les tests dépendants des ressources processeur permettent au Core i7 4770K de montrer sa supériorité.

La deuxième configuration a également un meilleur potentiel d’overclocking comme avantage : notre i7 4770K tient 4,6 GHz avec un dissipateur à air, tandis que le Core i7 950 ne dépasse pas les 4 GHz en watercooling.

Notons par ailleurs que nous avons systématiquement utilisé Windows 7 64 bits au lieu de Windows 8.1 sur la première configuration pour trois raisons :

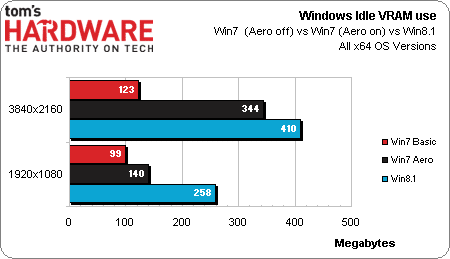

- Premièrement, le gestionnaire de bureau Windows (Windows Aero ou wdm.exe) utilise une quantité de mémoire vidéo non négligeable. En 2160p, cela se traduit par 200 Mo supplémentaires sous Windows 7 et 300 Mo sous Windows 8.1 par rapport aux 123 Mo déjà réservés par Windows. Si l’on peut remédier à cela sous Windows 7 en passant tout simplement à un thème basique, il n’est pas possible d’en faire autant sans de sévères effets secondaires sous Windows 8.1. 400 Mo représentent 20 % de la mémoire d’une carte graphique doté de 2 Go.

- Avec un thème basique, l’usage mémoire de Windows 7 est constant : 99 Mo en 1080p et 123 Mo en 2160p en utilisant une GeForce GTX 690. Ce critère est particulièrement important au regard de la reproductibilité des tests. A l’opposé, les quelques 200 Mo supplémentaires nécessités par Aero peuvent varier d’environ 40 Mo à la hausse comme à la baisse.

- Depuis les pilotes GeForce 331.82 WHQL, un bug est apparu en 2160p lorsque Windows Aero est activé. Il ne concerne que les écrans en « tuiles » comme l’Asus PQ321Q que nous avons vu en octobre dernier : l’utilisation du GPU diminue pour fluctuer entre 60 % et 80% de ses capacités au lieu des 100 % attendus, ce qui se traduit par une baisse de performances d’environ 15 %. NVIDIA a été informé du problème.

| Matériel complémentaire | |

|---|---|

| Photo | Canon EOS 400D Objectif Canon EF 50 mm f/1.8 1/400s, ISO 800, f/1.8-2.8 |

| Mesure de la pression sonore | ART SPL-8810, dB(A), réglages Bas/Rapide |

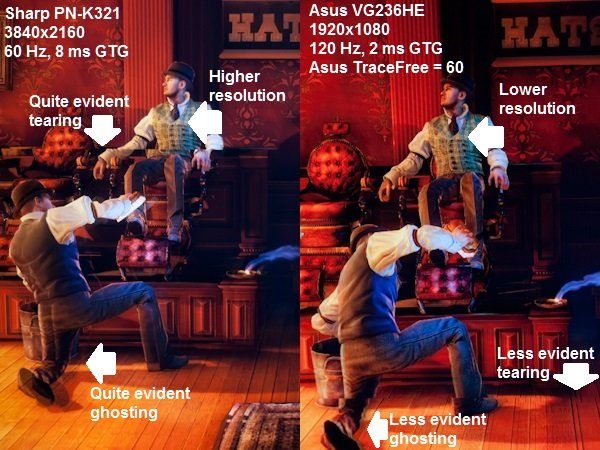

Le tearing et le ghosting n’étant pas ou très peu perceptibles dans les captures ou vidéos de gameplay, nous avons utilisé un reflex pour illustrer ces problèmes.

La température au sein du boitier est mesurée avec la sonde thermique du Samsung 840 Pro. Pour ce qui est de l’environnement, la température ambiante allait de 20 à 22°C tandis que la pression sonore était de 33,7 dB(A), à plus ou moins 0,5 dB(A).

| Jeux | |

|---|---|

| The Elder Scrolls V: Skyrim | Version 1.9.32.0.8, benchmark THW, HWiNFO64 |

| Hitman: Absolution | Version 1.0.447.0, benchmark intégré, HWiNFO64 |

| Total War: Rome 2 | Patch 7, benchmark”Forest” intégré, HWiNFO64 |

| BioShock Infinite | Patch 11, Version 1.0.1593882, benchmark intégré, HWiNFO64 |

| Tests synthétiques | |

| Ungine Valley | Version 1.0, profil Extreme HD, HWiNFO64 |

| 3DMark Fire Strike [Extreme] | Version 1.1 |

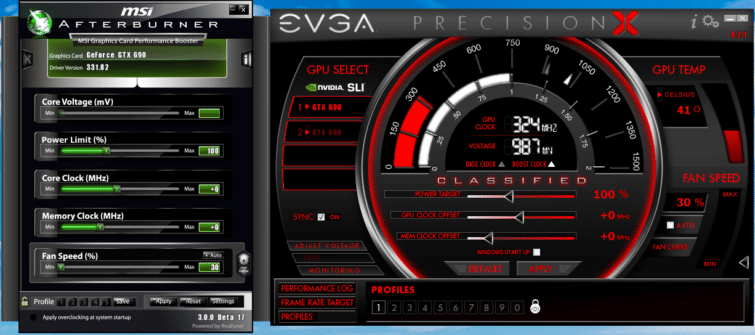

Plusieurs utilitaires permettent de mesurer l’utilisation de la mémoire vidéo. Nous avons opté pour HWiNFO64 et relevé les valeurs maximales, sachant que les mêmes résultats peuvent être obtenus avec MSI Afterburner, EVGA Precision X ou encore RTSS (Rivatuner Statistics Server).

Avec ou sans V-Sync ?

Le nombre d’ips est le premier indicateur qui vient à l’esprit lorsqu’il s’agit d’évaluer une carte graphique. Dans quelle mesure le dernier GPU haut de gamme fait-il mieux que n’importe quel autre précédent modèle ? Internet est riche en benchmarks de sources multiples qui tentent de répondre à cette question.

Commençons donc par voir quelles sont les variables qu’il faut prendre en compte pour vraiment apprécier les capacités d’une carte graphique.

Mythe : le débit d’ips est un indicateur qui suffit à caractériser les performances d’une carte graphique

Il est communément admis qu’un titre est jouable à partir du moment où l’on obtient 30 ips et plus. Certains peuvent s’accommoder d’un peu moins, tandis que d’autres trouvent le seuil de 30 ips trop faible.

Ce débat occulte parfois le fait que le nombre d’ips ne traduit qu’un simple débit, alors qu’il faut également prendre d’autres éléments en compte. Si le débit d’un film est constant, le rendu des jeux est variable par essence et se voit donc exprimé en moyenne. La variation est un sous-produit de la puissance de calcul nécessaire au rendu d’une scène donnée : dès lors que le contenu à l’écran évolue, le débit d’ips en fait de même.

L’idée est simple : l’expérience de jeu repose sur des notions autrement plus complexes que la vitesse à laquelle les images sont rendues à l’instant T (ou en moyenne). La régularité du débit est un facteur supplémentaire : imaginons que l’on roule à 130 Km/h de manière constante sur autoroute, par rapport au même trajet effectué à 130 Km/h en moyenne. Le temps nécessaire pour arriver à destination est similaire, mais l’expérience de conduite est assez significativement différente.

Mettons donc de côté la question « quel niveau de performance suffit ? » pour le moment. Nous y viendrons après avoir abordé quelques points importants.

V-Sync

Mythes : il ne sert à rien d’avoir plus de 30 ips vu que l’œil humain n’est pas capable de faire la différence au-delà. Sur un écran 60 Hz, il n’est pas nécessaire de dépasser les 60 ips vu que le moniteur se rafraîchit déjà 60 fois par seconde. La V-Sync devrait toujours être activée. La V-Sync devrait toujours être désactivée.

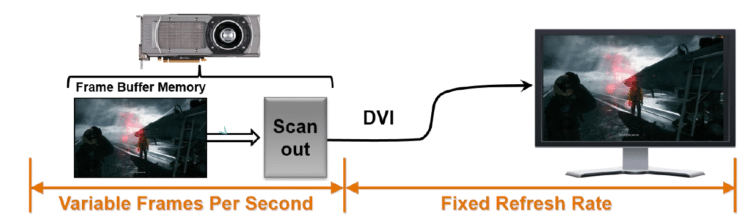

Comment les images rendues sont-elles affichées ? Vu le mode de fonctionnement de la plupart des écrans LCD, l’image à l’écran est actualisée X fois par seconde, X étant constant. Dans la grande majorité des cas, l’opération s’effectue 60 fois, mais certains écrans proposent des dalles capables de se rafraîchir 120 voire 144 fois par seconde. Il s’agit bien entendu de la fréquence de rafraîchissement, exprimée en Hertz.

Le débit d’images irrégulier d’une carte graphique et la fréquence de rafraîchissement fixe d’un moniteur ne font pas bon ménage : on assiste à un phénomène de déchirement de l’image, le tearing, lorsque deux images ou plus sont rendues lors d’un seul cycle de rafraîchissement du moniteur. Sur l’image ci-dessus, les colonnes de couleur signalent des images uniques que la carte graphique envoie à l’écran dès qu’elles sont rendues. Ce phénomène peut être particulièrement désagréable, tout particulièrement sur les FPS en ligne.

L’image ci-dessous montre une autre anomalie bien connue et assez courante, mais pourtant pas évidente à illustrer. Parce que cette anomalie est produite par le périphérique d’affichage, on ne la voit pas sur des captures d’écran mais de visu. Il faut un appareil photo rapide pour isoler le problème : autant FCAT permet d’illustrer le tearing au travers des deux captures réalisées sur Battlefield 4 ci-dessus, autant le ghosting n’apparaît pas.

Le tearing est évident sur ces deux captures de Bioshock Infinite, bien qu’autrement plus sensible sur la dalle Sharp 60 Hz par rapport à celle d’Asus, dont les 120 Hz permettent une fréquence de rafraîchissement doublée. Cette anomalie indique très clairement que la synchronisation verticale est désactivée.

L’autre problème rencontré avec BioShock: Infinite est le ghosting, particulièrement apparent dans le coin inférieur gauche de l’image. Le phénomène est dû à la réactivité de l’écran : pour résumer, les pixels sont trop longs à changer de couleur, provoquant ainsi une trainée. Cette anomalie est nettement plus dérangeante en conditions de jeu que par le biais d’une image. Une dalle proposant un temps de réponse gris à gris de 8 ms, comme celle de Sharp, provoquera des effets de flou dès lors que l’on a des mouvements rapides à l’écran. De ce fait, ces dalles ne sont généralement pas recommandées pour jouer aux fps.

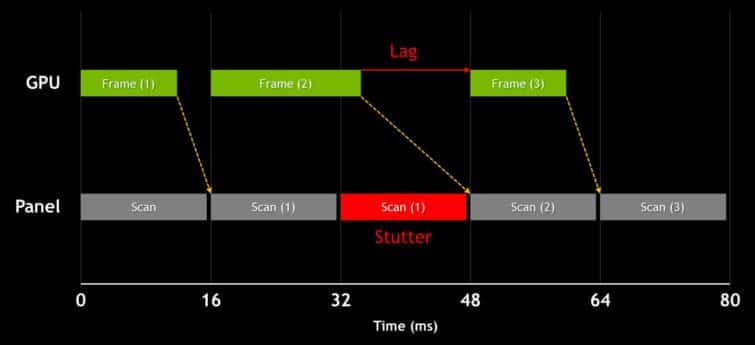

Revenons au tearing. La synchronisation verticale (V-sync) est une vieille solution au problème. Pour résumer, cette technologie demande à la carte vidéo de se synchroniser avec la fréquence de rafraîchissement de l’écran, éliminant donc complètement le tearing. Cependant, si la carte graphique en question n’arrive pas à maintenir un minimum de 60 ips (sur un écran 60 Hz), le nombre d’ips affichées à l’écran ne cesse de varier sur la base de multiples entiers de la fréquence de l’écran (60, 30, 20, 15 ips et ainsi de suite), provoquant ainsi des saccades (stutter).

Le débat sur l’activation/désactivation de la V-sync perdure depuis l’apparition des premiers jeux 3D. Certains abordent le problème de façon binaire, tandis que d’autres préfèrent changer leurs réglages suivant le titre auquel ils jouent.

Que choisir ?

Partons du principe que la majorité d’entre nous est équipée de moniteurs 60 Hz. La V-sync devrait être systématiquement désactivée si l’on remplit ne serait-ce qu’un seul des critères suivants :

- FPS en ligne

- Perception de l’input lag

- Configuration incapable de maintenir un minimum de 60 ips sur un jeu en particulier

- Benchmarks GPU

La V-sync ne devrait être activée qu’à partir du moment où l’on souffre d’un tearing prononcé sans remplir un seul des critères précités.

Si l’on a la chance d’avoir un écran gamer 120/144 Hz, la V-sync ne devrait être activée qu’à partir du moment où l’on ne descend pas en-dessous de 120 ips et sous réserve là encore d’avoir un tearing prononcé.

Précisons qu’il existe quelques rares cas de figure pour lesquels la V-sync n’est pas pénalisante en termes d’ips, comme par exemple lorsque le triple buffering est pris en charge, mais il s’agit clairement d’exceptions. D’autre part, quelques titres comme The Elder Scrolls V: Skyrim activent la V-sync par défaut. Sa désactivation via les fichiers de configuration peut perturber le moteur du jeu ; mieux vaut donc ne pas y toucher.

G-Sync, FreeSync et l’avenir

Notre article dédié à G-Sync a donné un aperçu de la solution trouvée par NVIDIA pour résoudre le problème. AMD a commencé à répondre en présentant FreeSync au CES 2014, mais nous ne savons toujours pas si cette technologie est viable au-delà des écrans de portables. SI les deux entreprises visent à supprimer les compromis inhérents à la V-sync en permettant aux écrans de fonctionner selon des fréquences de rafraîchissement variables, AMD mérite d’être applaudi pour son approche open source.

Il est difficile de dire quels seront les choix de l’industrie à terme, mais le fait est que nous ne sommes franchement pas partisans des solutions propriétaires (il en va très probablement de même pour la plupart des intégrateurs). On aimerait ainsi voir NVIDIA ouvrir G-Sync à toute la communauté, mais au vu des déclarations des représentants de la société ainsi que son historique en la matière, ce changement de politique est peu vraisemblable.

Faut-il s’inquiéter de l’input lag ?

Mythe : les cartes graphiques influent sur l’input lag

Imaginons que l’on se fasse abattre dans un FPS multijoueur avant même d’avoir pu réagir. Soit l’on n’est pas au niveau, soit les adversaires trichent, soit un autre problème se manifeste.

Au-delà de la tricherie, occasionnelle mais bien réelle, il est bien possible que des réflexes apparaissant comme surhumains soient dus à la technologie, ne serait-ce que partiellement. La carte graphique n’a peut-être quasiment rien à voir avec ces réflexes.

Il existe nécessairement un décalage entre ce qui se produit dans un jeu et ce qui est affiché à l’écran. De même, personne ne réagit de façon instantanée, tout comme clavier et souris nécessitent un temps de traitement. Ce dernier est quelque peu improprement appelé input lag : si l’on active la commande de tir dans un FPS et que l’arme ne s’active que 0,1 seconde plus tard, l’input lag effectif est alors de 100 millisecondes.

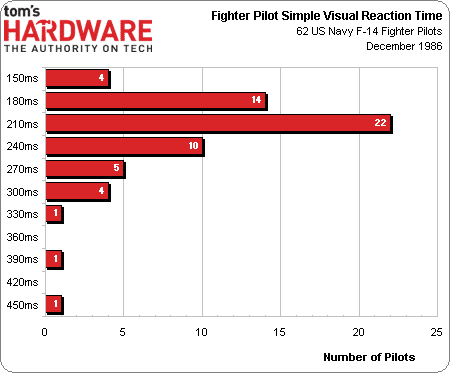

Naturellement, nous ne sommes pas tous égaux en matière de temps de réaction. D’après une étude menée par l’U.S. Navy en 1986, un pilote de F-14 met en moyenne 223 ms à réagit à un stimulus visuel. Bien que l’on puisse penser le contraire, l’Homme réagit plus rapidement aux stimulations auditives : la moyenne se situe aux alentours de 150 ms.

Chacun peut s’amuser à tester ses propres réactions grâce à un test visuel, ainsi qu’un test auditif.

Fort heureusement, aussi mal configuré qu’un PC puisse être, on n’atteindra probablement pas 200 ms d’input lag. Autrement dit, ce sont les temps de réaction de l’utilisateur qui priment avant tout.

Ceci étant dit, plus l’input lag augmente et plus l’expérience de jeu est modifiée. Imaginons un joueur professionnel avec un temps de réaction comparable à ceux des meilleurs pilotes de l’étude ci-dessus, c’est-à-dire 150 ms. L’ajout de 50 ms d’input lag se traduit par des réflexes ralentis de 30 % (soit quatre images par seconde sur un écran 60 Hz) par rapport à un rival ne souffrant pas du tout d’input lag. Au niveau professionnel, cet écart est considérable.

Pour le commun des mortels (y compris la rédaction, aux alentours de 200 ms sur le test visuel mentionné plus haut) et pour chacun d’entre nous préférant jouer à Civilization V de temps en temps plutôt que participer à des tournois de Counter Strike 1.6, le constat est radicalement différent. Dans la majorité des cas, on peut tout simplement ignorer l’input lag.

Ceci étant dit, voici les circonstances aggravantes en termes d’input lag :

- Jouer sur un TV HD (a fortiori dans un mode autre que « jeux ») ou tout autre écran LCD effectuant un quelconque traitement vidéo qui ne peut être contourné. La base de données de Display Lag est particulièrement bien fournie à ce sujet.

- Jouer sur des écrans LCD à dalle IPS (temps de réponse allant généralement de 5 à 7 ms en gris à gris), plutôt que TN+Film (1 à 2 ms GTG pour les meilleurs) ou moniteur CRT (ce qui se fait de mieux en la matière).

- Jouer sur un écran ayant une fréquence de rafraîchissement inférieure ou égale à 60 Hz : les meilleurs écrans gamer sont à 120/144 Hz

- Avoir un faible débit d’ips : 30 ips correspond à une image toutes les 33 ms ; 144 ips correspond à une image toutes les 7 ms

- Utiliser une souris lente à échanger sa position avec l’unité centrale. Les 125 Hz par défaut se traduisent par un cycle de 6 ms environ, soit un input lag de ~3 ms en moyenne. Une souris gamer peut atteindre les 1000 Hz, ce qui correspond à un input lag de ~0,5 ms en moyenne.

- Utiliser un clavier peu réactif (l’input lag du au clavier est généralement de 16 ms, mais les mauvais élèves nécessitent plus)

- Activer la V-sync, a fortiori de concert avec le triple buffering (contrairement à ce que l’on peut parfois lire ici ou là, Direct3D propose bel et bien plusieurs mises en tampon, mais peu de jeux utilisent cette possibilité).

- Jouer avec un nombre d’images pré-rendues élevé. La valeur par défaut est de trois images pour Direct3D, ou 48 ms à 60 Hz. Cette valeur peut être augmentée jusqu’à 20 pour une « meilleure fluidité » ou encore abaissée jusqu’à 1 pour une plus grande réactivité contrebalancée par une variance interimages plus prononcée et parfois, une baisse du nombre d’ips. Précisons qu’il n’existe pas de valeur nulle : le fait de renter 0 ne fait que rétablir la valeur par défaut (3).

- Jouer avec une connexion internet souffrant d’une latence importante. Bien que cette notion aille au-delà de ce que l’on peut définir comme étant l’input lag, elle a pour effet de s’additionner à l’input lag.

En revanche, d’autres facteurs n’engendrent aucune différence :

- Utiliser un clavier PS/2 plutôt qu’USB (cf. notre comparatif de claviers mécaniques)

- Utiliser une connexion Wi-Fi ou Ethernet (il suffit de tester son propre routeur pour s’en rendre compte : le ping devrait être inférieur à 1 ms dans tous les cas)

- Utiliser un SLI ou CrossFire. Ces technologies ont beau nécessiter un nombre d’images pré-rendues plus élevé qu’avec une seule carte, leur débit d’image bien plus élevé tend à compenser.

L’Input lag n’a donc d’importance que pour les jeux diffusés sur Twitch et ne se révèle primordial qu’en situation de jeu très compétitif.

La notion d’input lag ne se limite pas à l’écran ou à la carte graphique : le reste des composants, réglages matériels, réglages de l’écran et des programmes influent également sur cette mesure.

Quelle quantité de mémoire vidéo ?

La quantité de mémoire est souvent utilisée comme outil marketing par les marques, parce qu’elles savent le grand public conditionné à penser qu’il en faut autant que possible. On voit ainsi régulièrement des cartes entrée de gamme embarquer plus de mémoire qu’elles ne peuvent exploiter, mais l’immense majorité d’entre nous sait bien que, comme pour tous les autres composants d’un PC, la notion d’équilibre est primordiale.

Pour simplifier, les GPU bénéficient d’une mémoire dédiée pour ne pas répercuter la charge de travail sur la mémoire système. Plusieurs normes de mémoire sont utilisées pour les cartes graphiques, les plus courantes étant la DDR3 et la GDDR5.

Mythe : les cartes comportant 2 Go de mémoire sont plus rapides que celles ne proposant qu’un seul Go

Sans surprise, les marques équipent leurs cartes entrée de gamme avec une quantité de mémoire excessive (ce qui leur permet par ailleurs d’augmenter leurs marges) parce que monsieur tout le monde peut croire qu’une carte embarquant plus de mémoire sera plus rapide. Soyons clairs : la capacité mémoire d’une carte graphique n’influe pas sur ses performances tant que les réglages d’un jeu ne la sature pas intégralement.

A quoi cela peut-il donc servir d’avoir plus de mémoire vidéo ? Pour répondre à cela, il faut déjà savoir à quoi sert cette mémoire. En simplifiant, on arrive aux quatre usages suivants :

- Charger les textures

- Accueillir le tampon graphique

- Accueillir le tampon de profondeur (« Z Buffer »)

- Accueillir les autres éléments nécessaires au rendu de l’image (shadow maps par exemple)

Naturellement, la taille des textures chargées en mémoire dépend non seulement du jeu mais aussi des réglages graphiques. Pour prendre un exemple, le pack de textures haute résolution pour Skyrim inclut 3 Go de textures. La plupart des programmes font un usage dynamique des textures, c’est-à-dire qu’elles sont chargées/déchargées pour ne pas rester en mémoire graphique. En revanche, les textures nécessaires au rendu d’une scène particulière doivent rester en mémoire.

Le tampon graphique est utilisé pour stocker l’image lorsqu’elle est rendue, avant ou au cours de son envoi au périphérique d’affichage. De ce fait, son empreinte mémoire dépend de la définition de l’écran (une image en 1920x1080x32 bpp pèse environ 8,3 Mo contre 33,2 Mo pour une autre en 3840x2160x32 bpp) ainsi que du nombre de tampons (au moins deux, rarement trois ou plus).

Etant donné que certains modes d’anti-aliasing (FSAA, MSAA, CSAA, CFAA mais pas le FXAA ou le MLAA) ont pour effet d’augmenter le nombre de pixels à rendre, ils augmentent proportionnellement la quantité de mémoire vidéo nécessaire. L’anti-aliasing basé sur le rendu est particulièrement gourmand de ce point de vue, sachant que les besoins s’amplifient de pair avec l’échantillonnage (x2, x4, x8 etc.). Les tampons additionnels occupent également la mémoire vidéo.

Une quantité de mémoire vidéo importante permet donc de :

- Jouer dans des définitions plus élevées (à condition que le GPU puisse suivre)

- Jouer avec des textures de meilleure qualité

- Jouer avec un fort anti-aliasing basé sur le rendu

Mythe : il faut 1, 2, 3, 4 ou 6 Go de mémoire vidéo pour jouer à telle définition, peu importent les jeux/réglages

La quantité de mémoire vidéo nécessaire est déterminée avant tout par la définition à laquelle on joue : naturellement, plus elle est élevée et plus les besoins sont conséquents. Le second facteur est l’utilisation d’un des types d’anti-aliasing mentionnés plus haut. Si l’on part du principe que l’on joue avec des réglages équivalents d’un jeu à l’autre, les autres facteurs sont moins importants.

Avant de passer aux mesures à proprement parler, un rappel s’impose : les cartes haut de gamme bi-GPU (Radeon 6990 et 7990, GeForce GTX 590 et 690) proposent une quantité de mémoire vidéo impressionnante mais du fait de leur conception, les données sont dupliquées en mémoire. Il ne faut donc pas additionner la mémoire dédiée à chaque GPU : une GTX 690 avec 4 Go se comporte ainsi comme une paire de cartes avec 2 Go chacune. Par ailleurs, le fait d’ajouter une deuxième carte graphique pour jouer en SLI/CrossFire ne double pas la quantité de mémoire vidéo : chaque carte accède exclusivement à sa mémoire dédiée.

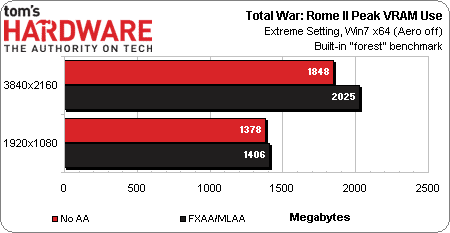

Les tests ont été conduits sous Windows 7 64 bits sans Aero. Au cas où l’on utilise Aero, il convient d’ajouter ~200 Mo à chacune des mesures et ~300 Mo dans le cas de Windows 8/8.1 comme on peut le voir ci-dessus.

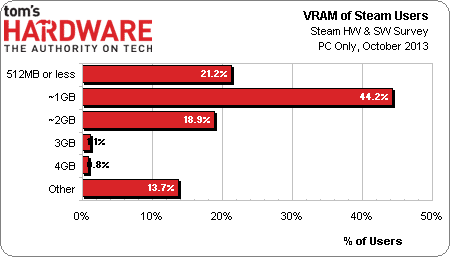

D’après lesstatistiques disponibles sur Steam, la majorité relative des utilisateurs dispose d’un Go de mémoire vidéo, un peu moins de 20 % ont 2 Go et moins de 3 % ont 3 Go ou plus.

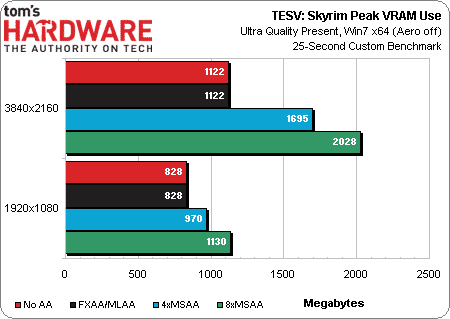

Nous avons utilisé Skyrim avec le pack de textures haute résolution officiel. Comme on peut le voir, 1 Go de mémoire vidéo suffit pour jouer en 1080p avec FXAA/MLAA ou sans anti-aliasing, mais on n’est vraiment pas loin de la saturation avec le MSAA 4x. Avec 2 Go, il est possible de pousser le MSAA encore plus loin en 1080p ou encore de jouer en 2160p sans forcer sur l’anti-aliasing. Pour jouer avec le profil Ultra en 2160p, avec MSAA 8x, il faut nécessairement plus de 2 Go.

Le Creation Engine de Bethesda se distingue des autres moteurs représentés dans ce test : il n’est pas souvent limité par les performances graphiques, mais peut souffrir de limitations du côté CPU. Cependant, ces tests montrent que Skyrim peut pâtir d’un manque de mémoire vidéo avec le niveau de détails le plus élevé.

Précisons également que le FXAA ne consomme pas du tout de mémoire vidéo : il s’agit donc d’une possibilité à considérer non seulement quand les performances sont trop faibles pour utiliser le MSAA, mais également quand la mémoire vidéo est insuffisante.

Quelle quantité de mémoire vidéo ? (suite)

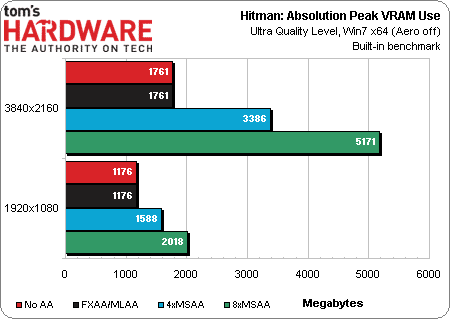

Hitman: Absolution s’appuie sur le moteur Glacier 2 d’IO Interactive, lequel est assez gourmand en mémoire : dans notre suite de tests, seul le moteur Warscape de Creative Assembly (Total War : Rome II) se montre encore plus vorace avec les détails graphiques les plus élevés.

Une carte n’ayant qu’un seul Go de mémoire ne permet pas de jouer à Hitman : Absolution en 1080p avec détails Ultra. Avec 2 Go, il est possible de jouer avec MSAA 4x en 1080p ou encore sans MSAA en 2160p.

Il faut une carte 3 Go pour activer le MSAA 8x en 1080p et rien de moins qu’une Titan 6 Go afin de passer en 2160p avec le même anti-aliasing.

Rappelons que le FXAA n’engendre aucune pénalité en termes de ressources mémoire.

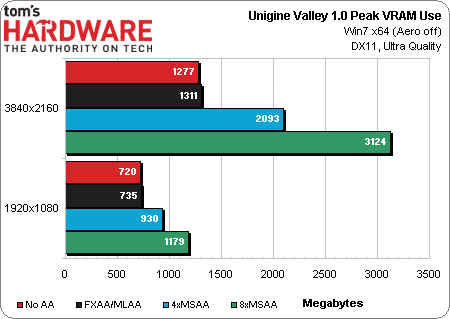

Nb : le dernier benchmark en date d’Unigine, Valley 1.0, ne prend pas directement en charge MLAA/FXAA. Les résultats que l’on voit ci-dessus avec ces filtrages sont obtenus en forçant leur activation via les pilotes.

Pour ce qui est de la gestion mémoire, Valley tourne donc bien sur une carte 2 Go en 1080p. Il est même possible d’utiliser une carte 1 Go pour le voir à cette définition avec MSAA 4x, ce qui constitue une exception par rapport aux jeux. La situation se complique en 2160p : une carte 2 Go s’en sort avec un anti-aliasing post processing FXAA/MLAA mais il n’est pas question d’activer le MSAA. L’ultra HD avec MSAA 8x nécessite plus de 3 Go de mémoire, réservant ainsi le benchmark dans cette configuration aux GTX Titan et AMD R9 290/290X.

Total War : Rome II s’appuie sur une évolution du moteur Warscape qui ne gère pas le SLI pour le moment (aucun problème pour le CrossFire en revanche), ni le MSSA et ses dérivés. Le seul anti-aliasing qui soit fonctionnel est le MLAA, technique propriétaire d’AMD, qui équivaut au SMAA et FXAA (développé par NVIDIA).

Une fonctionnalité particulière de ce moteur est sa capacité à spontanément baisser la qualité d’image en fonction de la mémoire vidéo disponible : le jeu reste donc aussi fluide que possible sans demander l’intervention de l’utilisateur. L’absence de prise en charge du SLI rend par contre ce RTS injouable sur les GeForce en 3840×2160. Dans l’immédiat, il faut avoir une/des Radeon si l’on compte jouer à Rome II en 4K.

Sans MLAA, le titre de Creative Assemby consomme 1848 Mo de mémoire vidéo sur son benchmark intégré « forêt » en 3840×2160, profil « Extreme ». Les 2 Go par GPU de la GTX 690 sont saturés dès lors que l’on ajoute le MLAA.

La surprise vient ici du fait qu’une technologie AMD sensée être propriétaire (MLAA) fonctionne sur une carte NVIDIA. Cependant, FXAA et MLAA sont tous deux des filtres post-processing, il n’y a donc aucune contrainte technique qui empêche leur interchangeabilité. Soit Creative Assembly bascule en douce vers le FXAA si une GeForce est détectée (le fichier de configuration ne précise pas cette possibilité), soit le département marketing d’AMD n’a pas relevé cette situation ou décidé de laisser courir.

Il faut donc au moins 2 Go de mémoire vidéo pour jouer à Rome II en 1080p profil « Extreme », ainsi qu’un CrossFire de cartes ayant chacune un minimum de 3 Go pour une expérience de jeu fluide en 2160p. On peut espérer arriver à jouer en 1080p avec une carte 1 Go, mais il faudra nécessairement faire des compromis sur la qualité visuelle.

Que se passe-t-il lorsque la mémoire vidéo est saturée ? Pour faire simple, les données graphiques sont alors temporairement envoyées à la mémoire système via le bus PCI Express. Il en résulte une énorme baisse des performances, a fortiori lors du chargement de textures : un jeu devient tout simplement insupportable dans ces conditions.

Que choisir ?

Quand bien même on possède une carte 1 Go et un écran 1080p, il n’y a probablement pas lieu de changer de carte graphique dans l’immédiat. Cependant, nous encourageons à opter pour un modèle 2 Go lors du prochain achat afin de pouvoir activer un anti-aliasing plus exigeant que le FXAA/MLAA sur la plupart des jeux.

En 1440p, 1600p, 2160p ainsi que sur les configurations multi-écrans, nous recommandons de viser au-delà de 2 Go pour éviter d’avoir à faire une croix sur le MSAA. 3 Go par GPU semble être un bon choix.

Comme nous l’avons évoqué plus tôt, la notion d’équilibre est primordiale : les cartes équipées de DDR3 doivent être évitées, de même que le passage de 2 à 4 Go sur une Radeon R9 270X n’a pas vraiment d’intérêt. Le fait de tester les cartes graphiques au travers de plusieurs jeux, avec des niveaux de détail et des définitions différentes permet justement de vérifier cet équilibre : on ne peut pas formuler de conseils d’achat sans avoir constaté les limites des cartes au préalable.

La gestion thermique des cartes graphiques récentes

Depuis quelques temps, Radeon et GeForce embarquent des dispositifs de protection qui augmentent la vitesse des ventilateurs et réduisent éventuellement fréquences et tensions pour éviter la surchauffe. Cette régulation ne garantit pas la parfaite stabilité du système (surtout si l’on est en train d’overclocker) : son but est surtout d’éviter les dégâts matériels.

Il y a eu beaucoup de débats pour distinguer une température GPU encore acceptable d’une température excessive. Sous réserve que le GPU les tolère, les températures élevées peuvent toutefois être souhaitables dans la mesure où la dissipation thermique en sera meilleure (puisque l’écart avec la température ambiante, et donc la quantité de chaleur pouvant être transférée, est plus élevé). D’un point de vue technique, on peut donc comprendre qu’AMD soit frustré des réactions reçues vis-à-vis du plafond thermique de son GPU Hawaii. A notre connaissance, il n’existe pas d’étude sérieuse montrant la viabilité de températures bien précises dans le temps : nous devons donc nous en tenir aux données constructeur pour le moment.

Ceci étant dit, le fait que les transistors en silicium se comportent généralement mieux avec de basses températures est clairement établi : ce n’est donc pas pour rien que l’azote liquide est utilisé pour l’overclocking extrême.

La Radeon HD 7990 et la GeForce GTX 690 font partie des cartes les plus énergivores qui soient avec des TDP respectifs de 375 et 300 Watts. Toutes deux sont des cartes bi-GPU ; si les cartes mono-GPU tendent bien entendu à consommer moins, les Radeon R9 290/290X se rapprochent du seuil de 300 Watts. Pour ces quatre cartes, la quantité de chaleur à dissiper est franchement conséquente.

Le refroidissement des cartes étant un sujet régulièrement abordé depuis de nombreuses années, voyons plutôt ce qu’il se passe lorsque l’on envoie une charge de travail à un GPU récent :

- On lance une application nécessitant des traitements intensifs comme par exemple un jeu 3D ou encore un extracteur de Bitcoin

- Les fréquences de la carte augmentent jusqu’à leur valeur nominale/maximale (boost) ; la carte voit ses températures grimper du fait qu’elle absorbe plus de courant

- La vitesse du/des ventilateur(s) augmente progressivement jusqu’au niveau défini par le firmware. En général, la ventilation est stabilisée aux alentours de 50 dB(A)

- Si la ventilation programmée est insuffisante pour maintenir les températures du GPU sous un certain seuil, les fréquences sont diminuées de manière à repasser sous le seuil thermique défini

- La carte doit en principe fonctionner selon une plage de fréquences et températures assez limitée jusqu’à fermeture de l’application exerçant la charge de travail

Comme on peut s’en douter, la mise en sécurité d’un GPU dépend de nombreux facteurs comme par exemple une charge spécifique, la ventilation du boitier, la température ambiante et même la pression de l’air ambiant. De ce fait, les cartes ne se mettent pas en sécurité au même moment, voire pas du tout. Cette protection thermique peut être utilisée pour définir un niveau de performance servant de référence. De plus, on peut créer une mesure relative au bruit en gérant manuellement la vitesse du/des ventilateur(s) : voyons maintenant quelle en est l’utilité.

Tests avec une limite constante de 40 dB(A)

La mesure en décibels acoustiques a pour particularité d’ajuster la pression sonore en fonction d’une courbe reproduisant la sensibilité de l’oreille humaine, à certains niveaux sonores sur différentes fréquences.

La valeur de 40 décibels est généralement considérée comme représentative du bruit ambiant moyen pour un appartement calme. Les studios d’enregistrement peuvent se situer aux alentours de 30 dB, tandis que 60 dB peuvent caractériser une conversation normale. 0 dB est souvent considéré comme le seuil d’audition pour l’oreille humaine, bien que les personnes capables d’entendre des signaux entre 0-5 dB soient rares au-delà de 5 ans. L’échelle des décibels est logarithmique et non pas linéaire : la valeur 50 dB est donc deux fois plus bruyante que 40 dB.

La pièce la plus silencieuse au monde est à -9 dB. Le silence est tel que dans l’obscurité, elle provoquerait des hallucinations en l’espace de 45 min à cause de la privation sensorielle.

Un PC fonctionnant à 40 dB(A) tend à se fondre dans le bruit ambiant d’un logement : normalement, on ne devrait pas l’entendre.

Comment atteindre 40 dB(A) constants ?

Le profil sonore d’une carte graphique est affecté par plusieurs variables, dont la vitesse de son/ses ventilateur(s). Bien entendu, tous les ventilateurs ne génèrent pas la même intensité sonore pour un nombre de tours/minute défini, mais on peut trouver la vitesse à laquelle chaque ventilateur atteint une intensité sonore bien définie.

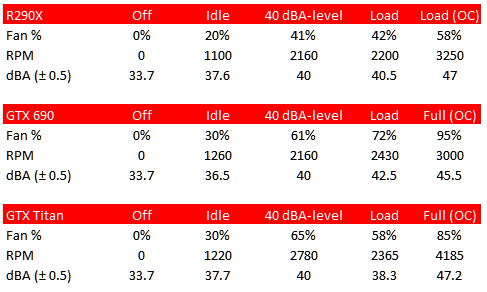

Nous avons donc utilisé un sonomètre à environ 1 mètre de la configuration de test pour modifier le profil de ventilation des cartes graphiques de manière à atteindre 40 dB(A).

| Carte | Réglage ventilateur % | Tpm | dB(A) ±0,5 |

|---|---|---|---|

| Radeon R9 290X | 41% | 2160 | 40 |

| GeForce GTX 690 | 61% | 2160 | 40 |

| GeForce GTX Titan | 65% | 2780 | 40 |

Le tableau ci-dessus montre que la Radeon R9 290X et la GeForce GTX 690 atteignent toutes deux 40 dB(A) à 2160 tpm, mais le réglage des ventilateurs est différent. Celui de la Radeon peut être globalement poussé plus loin, atteignant ainsi des vitesses de rotation et nuisances sonores supérieures à celui de la GTX 690. De son côté, la GTX Titan a un profil sonore différent puisqu’elle atteint les 40 dB(A) à 2780 tpm, soit 65 % de la capacité de fonctionnement de son ventilateur, ce qui la rapproche de la GTX 690 (61 %).

Ce tableau illustre diverses situations : une fois overclockées, les cartes peuvent se montrer franchement bruyantes en charge (entre 45 et 47 dB(A)). La GTX Titan est la plus silencieuse en charge avec 38,3 dB(A) tandis que la GTX 690 est la plus bruyante avec 42,5 dB(A).

L’overclocking peut-il nuire aux performances à 40 dB(A) ?

Mythe : l’overclocking se traduit toujours par des gains de performance

Le fait de paramétrer un profil de ventilation spécifique pour laisser les cartes se mettre en sécurité jusqu’à ce qu’elles se stabilisent nous permet de créer un test fiable (pouvant être répété) et intéressant.

| Carte | T. ambiante (°C) | Ventilateur | Tpm | dB(A) ±0,5 | Fréq. GPU1 | Fréq. GPU1 | Fréq. mémoire | Ips |

|---|---|---|---|---|---|---|---|---|

| Radeon R9 290X | 30 | 41% | 2160 | 40 | 870-890 | / | 1250 | 55,5 |

| Radeon R9 290X O/C | 28 | 41% | 2160 | 40 | 831-895 | / | 1375 | 55,5 |

| GeForce GTX 690 | 42 | 61% | 2160 | 40 | 967-1006 | 1032 | 1503 | 73,1 |

| GeForce GTX 690 O/C | 43 | 61% | 2160 | 40 | 575-1150 | 1124 | 1801 | 71,6 |

| GeForce GTX Titan | 30 | 65% | 2780 | 40 | 915-941 | / | 1503 | 62 |

| GeForce GTX Titan O/C | 29 | 65% | 2780 | 40 | 980-1019 | / | 1801 | 68,3 |

La GeForce GTX Titan est la seule à voir ses performances progresser avec overclocking. La Radeon R9 290X ne connait aucun gain de performances tandis que la GTX 690 perd du terrain dans ce test plafonné à 40 dB(A), diminuant ses fréquences jusqu’à 575 MHz lorsque l’on essaie de l’overclocker.

Ce test montre l’avantage considérable dont dispose la GTX Titan par rapport aux deux autres cartes. Certes, elle ne rejoint pas la GTX 690 mais s’en rapproche tout en laissant derrière elle la Radeon R9 290X avec un écart plus important que certains tests ne le laissent penser.

On remarque par ailleurs une augmentation considérable de la température au sein du boitier avec la GTX 690 (12-14°C). Ceci s’explique notamment par le fait que cette dernière est équipée d’un unique ventilateur axial en son centre, lequel rejette l’air chaud au sein du boitier et limite donc la marge de manœuvre thermique. Bien que nous ayons utilisé Unigine Valley 1.0 ici, ce test n’en est pas moins représentatif pour autant : chacun jugera de l’opportunité des compromis entre augmentation des performances et augmentation du bruit (et inversement).

Cette première partie nous a donc permis de faire le point sur la V-sync, l’input lag, la mémoire vidéo ainsi que les tests conduits suivant une empreinte acoustique prédéterminée. La deuxième partie de cet article sera l’occasion d’aborder les débits des ports PCI Express suivant leur génération, la taille des écrans, les technologies propriétaires et enfin le rapport performances-prix.