Intro

100 millions d’euros. Ce n’est pas tous les jours que l’on s’offre un cadeau de ce prix. Et c’est pourquoi l’investissement d’Orange dans son nouveau data center de Val de Reuil est tout à fait significatif. Val de Reuil a vocation a soutenir l’expansion des services Cloud d’Orange aussi bien à l’usage de ses clients, particuliers ou professionnels, que pour les besoins propres de l’opérateur. Ce datacenter, baptisé Normandie est aussi le premier de cette taille en France à fonctionner sur le principe du Free Cooling. Voici ce que nous avons pu découvrir en le visitant.

Situation

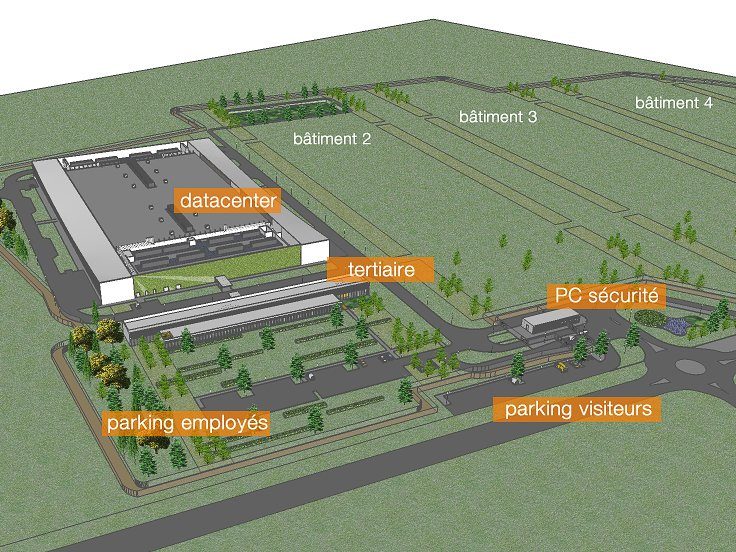

Situé dans une zone industrielle en périphérie de la ville nouvelle de Val de Reuil, le data center est installé sur un terrain de 18 hectares, divisé en quatre parcelles égales. Pour le moment une seule parcelle est occupée par un bâtiment occupant 16 000 m2 au sol. Il renferme quatre salles informatiques de 1 200 m2 chacune. Le reste est dévolu aux installations de support : bureaux pour le personnel, mais surtout machineries de climatisation et alimentation électrique.

Lorsque les trois autres parcelles seront occupées, Orange disposera de presque 20 000 m2 de salles informatiques, ce qui fera de Normandie le plus gros data center de l’opérateur.

Les clients

Inauguré en juin 2012, le data center Normandie est aujourd’hui utilisé à 25 %. Si Orange conserve son rythme d’expansion actuel les quatre salles seront opérationnelles d’ici 18 mois. Son premier client est Orange lui même qui a migré une partie de son système informatique de gestion. Le second client est Cloudwatt, le Cloud français souverain voulu par le gouvernement. Cloudwatt vient à peine d’ouvrir ses offres commerciales et utilise pour le moment deux pods dans une salle de Normandie pour 48 baies soit potentiellement 2000 serveurs 1U.

Sécurité

La sécurité physique du site est renforcée. L’enceinte est gardée par des grillages et barbelés. À la porte d’entrée, hautes grilles et caméra surveillent les visiteurs. Chacun doit montrer patte blanche et s’identifier auprès du poste de sécurité. Seuls les personnels préalablement autorisés sont admis.

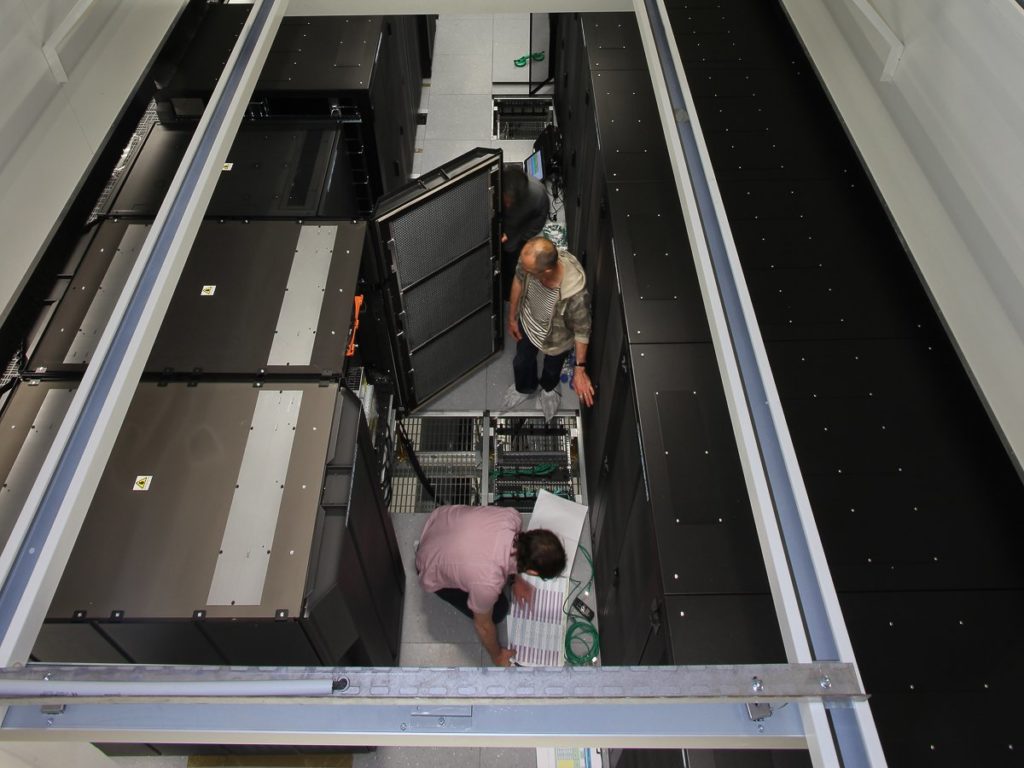

A l’intérieur du bâtiment, l’accès aux serveurs est contrôlé par un système d’identification biométrique (des capteurs d’empreintes digitales). Les clients les plus sensibles peuvent même demander l’installation de grilles supplémentaires à l’intérieur des salles, bloquant l’accès aux serveurs qui leurs sont dédiés.

99,995 %

Le site de Val de Reuil réunit de nombreux atouts, dont un faible risque industriel et un faible risque naturel (sismique notamment). La proximité de deux centrales nucléaires EDF a aussi permis d’alimenter le data center par deux voies distinctes, redondantes. Grâce à ces conditions avantageuses, Normandie a obtenu une classification Tier III+, ce qui représente la quasi perfection pour un data center. Le taux de disponibilité garanti contractuellement par Orange est de 99,995 %.

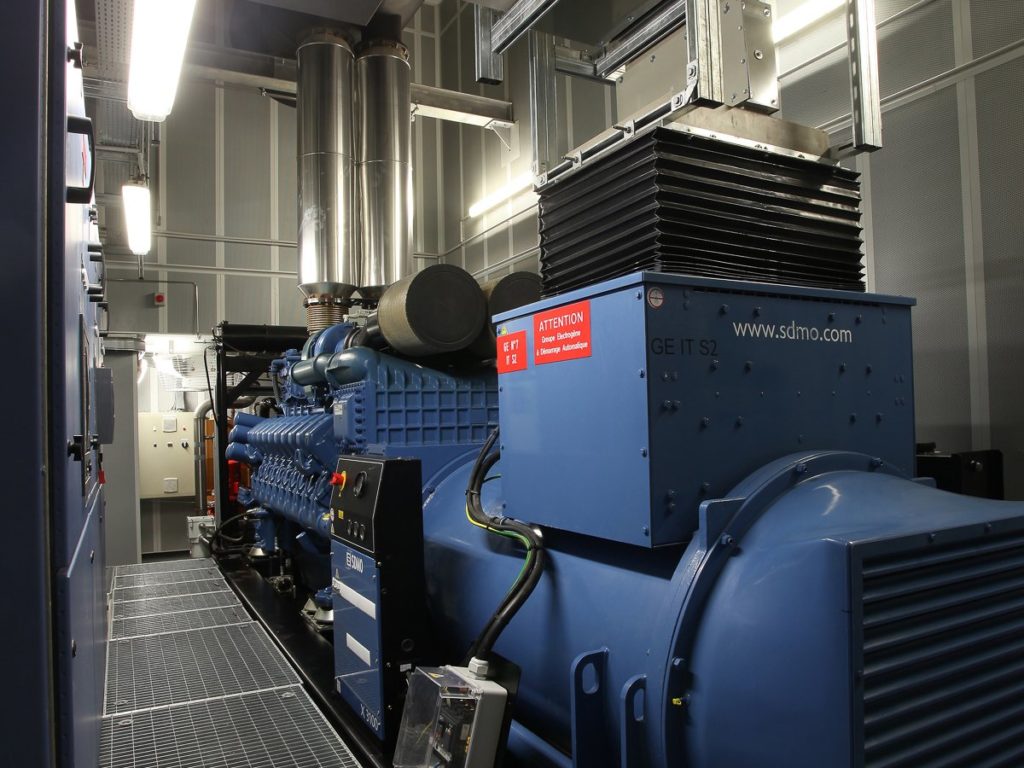

Groupes électrogènes

Pour assurer la continuité de l’activité même en cas de coupure de l’alimentation électrique, aussi improbable que cela soit, Orange a installé des groupes électrogènes. Le site compte cinq de ces mastodontes, capables de générer chacun 2500 kW. Pour alimenter une des quatre salles informatiques, il en faut deux. Grâce à eux, et à une réserve de 600 000 litres de fioul, le data center Normandie peut fonctionner en autonomie totale pendant au moins 72 h.

L’alimentation électrique n’est pas la seule installation redondante. Tous les éléments de l’environnement technique sont redondés : connexions au réseau, production de froid et réseaux d’eau froide, ventilation, etc.

Free cooling

Un autre atout de Val de Reuil est son climat. Grâce à la faible température règnant à Val de Reuil (la ville ne dépasse les 20 °C que trois mois par an, et n’a pas dépassé les 25 °C ces 5 dernières années), le data center peut fonctionner sur le principe du free cooling : les serveurs sont refroidis à l’aide de l’air extérieur, sans recours à un circuit de climatisation, pendant 10 mois sur 12 en moyenne. Un tel circuit est néanmoins prévu pour les courtes périodes où la température extérieure dépasse le seuil tolérable. Mais même durant les mois les plus chauds, une partie du refroidissement est assurée par free cooling.

Le bâtiment

Mais le climat ne fait pas tout. La conception du bâtiment a dû être adaptée au free cooling. Ainsi les salles sont vastes et volumineuses. Un mur végétal comptant 23 000 plantes recouvre les façades les plus exposées aux rayons du soleil. En dehors de son aspect esthétique, il constitue un excellent isolant, qui minimise l’accumulation de chaleur dans les murs. Les autres murs sont peints en blancs. L’orientation du bâtiment a aussi été pensée de sorte à maximiser le refroidissement par les vents dominants.

Les salles informatiques

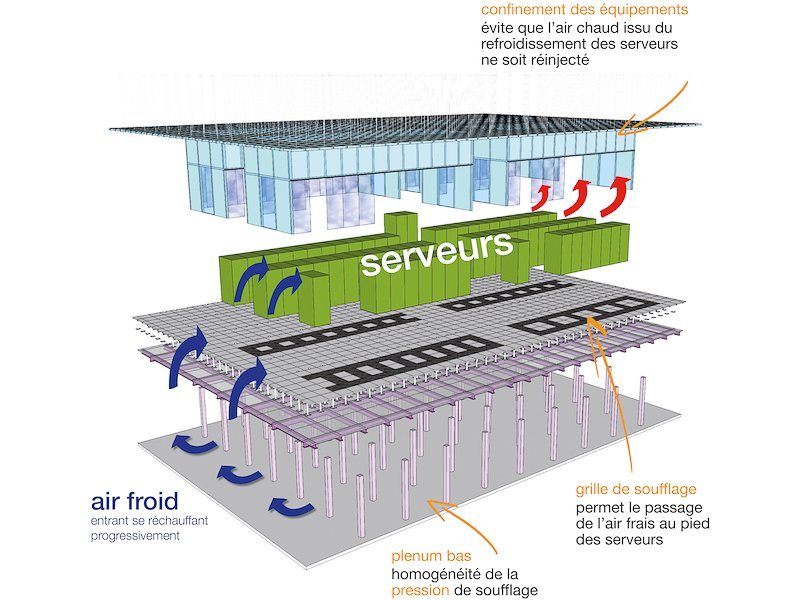

Les salles informatiques, elles aussi, ont dû être spécialement conçues pour favoriser le free cooling et réduire les dépenses d’énergie. Les baies sont espacées et regroupées en pod, cloisonnés, qui canalisent l’air chaud. L’air frais entre sous le plancher, dans un plénum très vaste (environ 3 m de haut) et pénètre devant les baies de serveurs. Il est aspiré par les machines et recraché derrière les baies, à l’intérieur des pods. Il ne peut en ressortir que par le haut, puis il s’échappe vers l’extérieur. Aucune ventilation forcée n’est nécessaire, l’air circule par convection naturelle et grâce aux ventilateurs des serveurs.

Température et consommation

Grâce à cette architecture, la température de fonctionnement des salles peut être maintenue entre 17 et 23 degrés et l’hygrométrie entre 30 et 70 % sans dépense d’énergie. La climatisation ne se déclenche que si l’air en sortie des serveurs monte au-delà de 35 °C. Ses températures sont d’ailleurs susceptibles d’évoluer, Orange se conformant aux meilleures pratiques de l’industrie.

Le free cooling n’est pas seulement là pour faire écolo et donner une bonne image au groupe. Grâce à lui, le PUE du data center Normandie est de 1,3 seulement en moyenne sur l’année (il monte à 1,8 en été lorsque la climatisation doit se mettre en route). Autrement dit, lorsque le site fonctionnera à pleine capacité, il consommera 13 MW, dont 10 MW serviront à pour alimenter ses serveurs et seulement 3 MW seront utilisés pour le refroidissement et les fonctions de support. Pour Orange, le free cooling se traduit directement en de grosses économies sur le coût de fonctionnement.

Les salles informatiques

Chacune des quatre salles informatiques de 1200 m2 abrite 16 800 serveurs 1U répartis sur 400 baies. La plupart sont peuplées de serveurs standards, par exemple de type lames achetés chez les grands noms du marché, tel HP. Certaines baies accueillent au contraire des machines plus spécifiques, comme des serveurs IBM Power 795. Orange adaptera la configuration en fonction des besoins de ses clients. Toutefois, Normandie n’est pas prévu pour le HPC, qui recours à des serveurs dont la puissance serait incompatible avec l’architecture du bâtiment.

Le coeur de réseau est en fibre 40 Gbit/s d’ores et déjà compatible 100 Gbit/s. Orange pourra faire évoluer les performances de son data center sans modifier toute son infrastucture. L’architecture est totalement redondante : chaque serveur d’une salle est répliqué dans une seconde salle pour éviter toute interruption de service en cas de panne.

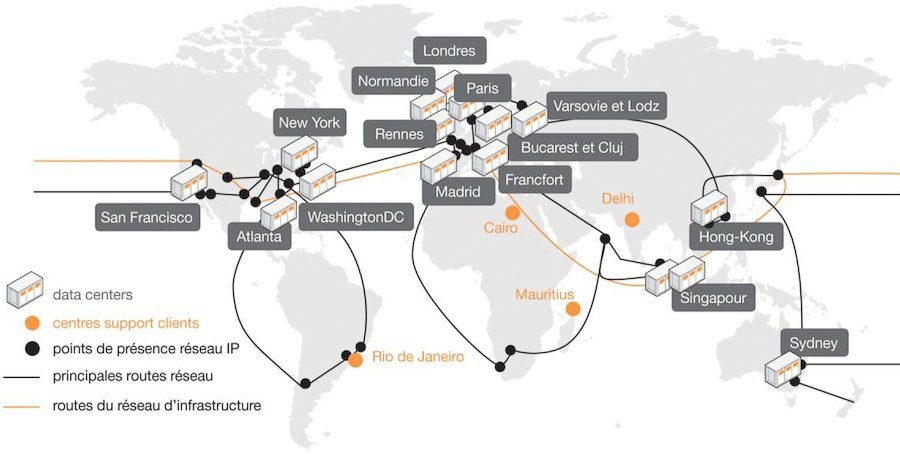

L’explosion du Cloud

Orange doit faire face à une explosion de l’utilisation des services en ligne, en Cloud. L’opérateur voit par exemple le trafic sur son réseau doubler tous les deux ans. Pour cela, il lui faut augmenter la capacité de ses data centers tout en réduisant ses coûts d’exploitation. Aujourd’hui Orange opère 16 datacenter en France (parmi 50 dans le monde), ils ne devraient cependant plus être que 5 ou 6 d’ici à 2020. Les actuels data center sont le plus souvent d’anciens centraux téléphoniques reconvertis, dont l’architecture est mal adaptée aux besoins d’un data center et dont la surface ne peut évoluer. Pour Orange il est plus efficace de construire du neuf que de réaménager de l’ancien. Normandie restera le principal site du groupe grâce à sa capacité record.

Les derniers articles