Introduction

Imaginons que l’on investisse de larges ressources dans le cadre de sa profession, qu’il s’agisse de services dans le secteur des technologies et de la communication, de réalisation audiovisuelle, de gastronomie ou encore de nettoyage à sec. N’importe qui est capable d’imaginer ce que l’on fait au quotidien. En revanche, rares sont ceux qui parviennent à comprendre comment s’y prend-t-on.

Bien qu’elle puisse paraître triviale, cette notion a une réelle importance. Pour reprendre l’exemple des services dans le secteur des TIC, les clients potentiels comprenant l’activité prennent mieux conscience de l’expertise et du sérieux que l’on propose. N’importe quel pressing peut prétendre assurer le meilleur nettoyage à sec via son site Internet, mais il n’est pas question d’adhérer à cette affirmation sans connaitre les agents chimiques ainsi que les équipements utilisés.

Cette notion s’applique bien entendu aux fabricants de disques durs. Seagate consacre deux milliards de dollars par an à la recherche et au développement, ce qui se traduit notamment par un taux de panne de 1,2 % par an. Les modèles destinés aux entreprises ayant un taux de panne inférieur à celui des disques durs destinés aux particuliers, il faut souligner le fait que ce pourcentage s’applique à la totalité des modèles vendus par Seagate. Ceci étant dit, cette statistique n’est pas très révélatrice si l’on ne va pas plus loin.

Dans cette optique, nous avons engagé un photographe local (Noah Katz) avant de nous rendre dans le comté de Boulder, au Colorado. Seagate a la réputation d’être une entreprise cultivant le secret, ce qui n’est pas sans fondement : il est très rare que ce géant du stockage ouvre ses portes aux journalistes, a fortiori lorsqu’il s’agit d’un de ses quatre centres de recherche et développement (deux en Asie, un dans le Minnesota et enfin celui de Longmont où nous nous sommes rendus, le plus grand des quatre). Bien entendu, lorsque Seagate nous a donné l’autorisation de rentrer dans leurs murs, nous avons sauté sur l’occasion.

En anglais « sea gate » renvoie à une route ou canal donnant accès à l’océan, ou à l’inverse offrant une protection contre la mer. Lorsque l’entreprise a été créée en 1978 (précisons qu’elle s’appelait alors Shugart Technology), la métaphore de l’ « univers numérique » était encore loin d’être répandue. On parlait plutôt de « mer de données ». Naturellement, les disques durs constituaient alors le conduit pour cette masse de données croissante dont les limites semblaient déjà pouvoir s’étendre à l’infini. Le thème de la mer persiste encore aujourd’hui comme en témoigne l’architecture du centre R&D de Longmont, dont la façade ressemble au safran (ou la proue suivant la perspective) d’un navire et dont l’intérieur regorge de poutres apparentes.

Pour filer encore un peu plus la métaphore, on pourrait considérer que le centre R&D de Longmont reprend un rôle comparable à celui des explorateurs marins des siècles passés. Pour dompter ces mers de données, on commence par tracer un itinéraire. De même que l’on entend très rarement parler des explorateurs parvenus jusqu’au fond de l’océan, on ne sait que peu de choses sur les choix technologies et conceptions qui ont fini au fond d’une benne. On se contente surtout d’une capacité plus importante pour un prix plus agressif que jamais tout en attribuant cela à l’ordre des choses, sauf que ce processus n’a rien de naturel. En effet, les avancées nécessitent des années de réflexion intense, de travail acharné et d’investissements colossaux.

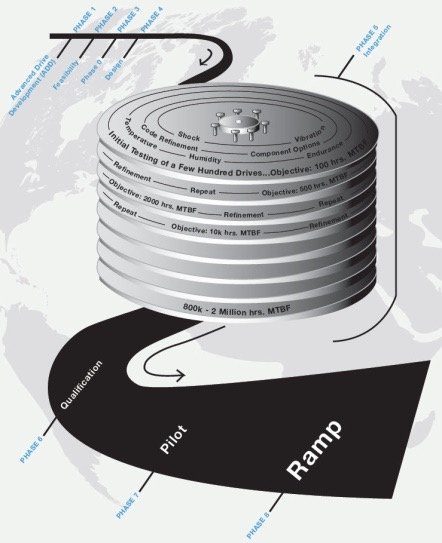

Après avoir passé 35 ans à lancer des produits, acquérir bon nombre de concurrents pour ensuite consolider son activité, Seagate s’appuie sur son PDP (Processus de Développement de Produits)comme s’il s’agissait d’un texte sacré. Le PDP se décompose en huit phases que voici :

Cette infographie met en avant la phase d’intégration, qui est celle qui appelle le plus d’efforts de la part du centre R&D de Longmont. Néanmoins, ce dernier commence à travailler un peu plus tôt dans le processus. Après une période consacrée à l’élaboration d’une feuille de route et l’appréciation de la faisabilité technologique pouvant s’étendre sur cinq ans au maximum, les équipes marketing passent le relais aux ingénieurs, lesquels constituent alors une équipe restreinte chargée de développer et finaliser une conception de disque dur. Cette conception ne doit pas être confondue avec un disque dur spécifique. Pour prendre un exemple récent, une évolution a consisté à passer de cinq à six plateaux, légèrement améliorer ces derniers, modifier la conception des têtes de lecture et actualiser le micrologiciel. Au final, cette nouvelle conception s’est traduite par le Seagate Entreprise Capacity 3,5 pouces 6 To, là où l’ancienne conception avait permis de lancer le modèle 4 To. S’il s’agit d’une série de mises à jour et non pas de bouleversements, le fait est que Seagate a dû passer par là pour faire évoluer sa gamme de disques durs 7200 tr/min. Ceci étant dit, chaque nouvelle conception se traduit par de multiples modèles et parfois plusieurs familles de disques durs suivant le résultat de telle combinaison de critères au fil du développement.

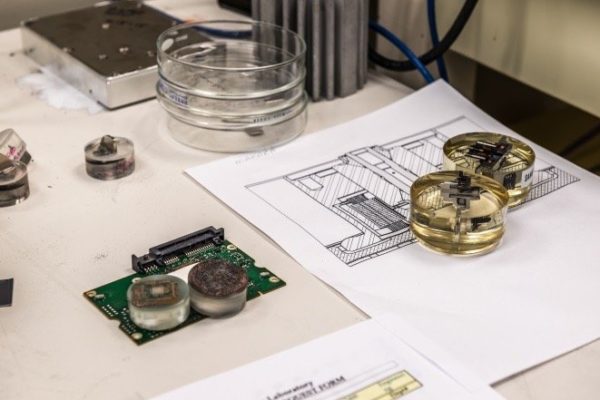

Revenons à notre équipe restreinte d’ingénieurs. Leur travail commence dans ce genre de pièce où les réunions peuvent s’enchainer pendant plus d’un an. L’équipe restreinte devient alors une sorte de seconde famille afin de stimuler les idées et le travail collaboratif. On pourrait s’étonner de la durée de cette phase baptisée AAD (Advanced Drive Development), mais la quantité de détails à régler peut s’avérer affolante quand bien même les changements de conception sont modestes. Pour reprendre l’exemple du passage de cinq à six plateaux, il a fallu remanier intégralement le circuit imprimé utilisé précédemment. L’assemblage du moteur à bobine mobile (VCMA) a nécessité trois vis au lieu d’une. Le positionnement des trous de montage a dû changer. Le filtre de régénération de l’air a dû être agrandi. Un nouveau type de lubrifiant pour plateaux a été utilisé … tout ceci a nécessité des mois entiers d’analyse et simulation.

Après avoir enfin déterminé comment la nouvelle conception pouvait être menée, l’étape de faisabilité détermine si cette conception doit aller jusqu’à son terme. Dans le cas des six plateaux, destinés à alimenter les derniers disques durs en date visant le monde professionnel, les ingénieurs de Seagate savaient que les disques durs à hélium constitueraient leur concurrence directe en 2015. Les tests préliminaires ont démontré un avantage d’environ 20 % en faveur de Seagate pour parcourir l’intégralité des plateaux. Si le résultat avait débouché sur un score négatif, la nouvelle conception aurait vraisemblablement été abandonnée afin de ne pas engendrer des pertes inutiles : à prix égal, personne n’achète un disque dur moins performant qu’un autre. Dans cette même optique, l’équipe en charge de la faisabilité doit s’assurer qu’une nouvelle conception est compatible avec les attentes de la marque en termes de profit tout en proposant des produits à un prix suffisamment attractif.

A partir du moment où une nouvelle conception passe le cap de la faisabilité, elle doit ensuite obtenir le feu vert des décideurs marketing et développement durant la phase 0 : ces décideurs établissent un contrat pour l’équipe d’ingénieurs restreinte contenant les mesures essentielles qui doivent être atteintes, les plages de consommation et performances ainsi que la méthodologie de test pour prouver que les objectifs sont atteints ou surpassés.

Enfin, la phase de conception aboutit sur une preuve de concept, élément qui précède le prototype. Une fois la conception arrêtée, le projet entre dans sa phase d’intégration : cette période de six mois dédiée aux optimisations techniques constitue le sel de notre visite chez Seagate.

Phase de tests – 1ère partie

D’une certaine manière, toutes les opérations menées durant la phase d’intégration servent un unique objectif : produire un disque dur fiable. Pour cela, les ingénieurs de Seagate ont l’avantage de savoir précisément quels sont les niveaux de performance à atteindre. L’Enterprise Capacity devait par exemple pouvoir atteindre un MTBF (durée moyenne entre défaillances) de 1 400 000 heures. Cet objectif est non seulement courant mais aussi attendu sur certains disques durs destinés au monde professionnel : à défaut, l’Enterprise Capacity aurait eu du mal à se vendre par rapport aux produits concurrents.

Deux choses doivent être précisées à ce stade. Premièrement, les ingénieurs pourraient concevoir un disque dur présentant un MTBF largement supérieur. L’un d’entre eux nous a confié qu’il était possible de produire un disque capable de fonctionner une centaine d’années, mais personne ne l’achèterait vu le prix auquel il serait vendu. Il faut donc comprendre qu’un MTBF de 800 000 ou 2 000 000 heures correspond aux niveaux couramment attendus par certains segments du marché des disques durs. Un PC de particulier qui fonctionnerait trois heures par jour sur cinq ans (soit environ 5 500 heures) n’a donc pas besoin d’un MTBF de deux millions d’heures, ce qui permet de s’affranchir du surcoût engendré par des composants plus robustes ainsi que l’ingénierie plus avancée qu’exige cet objectif. Un MTBF de 800 000 heures n’implique donc pas qu’un disque dur soit de mauvaise qualité : il s’agit simplement d’un rapport performances-prix optimisé pour un certain segment du marché.

Deuxièmement, les disques durs n’entrent pas en phase d’intégration avec leur MTBF final comme objectif. A l’image des temps de vol très réduits des premiers aviateurs, les ingénieurs de Seagate visent un MTBF de 300 heures ou moins pour leur première vague d’échantillons. Sachant cela, la production se limite alors à 200 disques durs grand maximum, lesquels sont soumis à une batterie de tests basiques afin d’examiner leurs performances ainsi que l’origine de leurs défaillances. Une fois cette analyse terminée, la nouvelle conception subit toutes les modifications jugées nécessaires par les ingénieurs avant d’être à nouveau produite en petite quantité pour subir la série de tests précédemment évoquée. Après avoir franchi ce premier obstacle, Seagate augmente l’échantillon de disques durs et intensifie les tests, approche qui se répète à plusieurs reprises.

Au terme de la phase d’intégration, un disque dur comme l’Enterprise Capacity 3,5 pouces 8 To aura subi plus de cinq cent tests, dont bon nombre s’étalent sur plusieurs semaines.

« En fait, nous essayons de déterminer la durée de vie du produit sur le terrain lorsqu’il est utilisé normalement », nous a confié un des ingénieurs. « Dans un deuxième temps, les tests sont rendus plus intenses pour que l’on puisse éprouver la maturité de la conception. On essaie alors de voir quelles seront les tolérances en matière de températures, d’humidité, sécheresse, plages de tensions, scripts. On envoie toute une série de paramètres au disque dur suivant différentes combinaisons et l’on constate alors ses limites ».

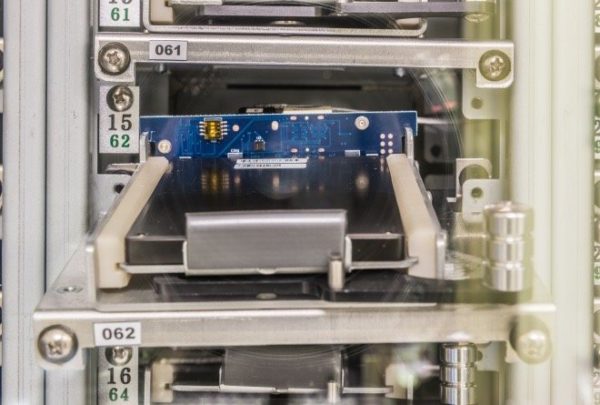

On voit ci-dessus deux armoires de tests à trente compartiments chacune, tout en sachant que Seagate utilise également des modèles à soixante compartiments. Ces dernières constituent en quelque sorte le couteau suisse pour tester les disques durs de par leur capacité à générer des températures allant de -50 à 100°C. En outre, ces armoires gèrent le taux d’humidité ainsi que les tensions 5 et 12 Volts de manière distincte. Chacun des trente compartiments dispose de son propre ordinateur monocarte à processeur Pentium, lesquels sont reliés à un système de serveurs envoyant scripts et logiciels développés en interne. Ceci permet aux ingénieurs d’exercer un contrôle total sur tous les paramètres de tests, suivre et gérer à distance les disques durs et bien entendu de générer des journaux de test.

Sachant que chaque compartiment dispose de son propre ordinateur, une panne dans un des slots n’interrompt pas la procédure pour les autres. Toutefois, chaque défaillance donne lieu à une enquête en détail pour savoir dans un premier temps si la panne vient du disque dur ou du compartiment. Dans le cas où le disque dur est en cause, ce dernier est marqué puis envoyé au laboratoire d’analyse qui détermine ensuite l’origine de la défaillance (origine matérielle ou logicielle). Les bugs dans le code sont généralement résolus, auquel cas le firmware du disque dur est réinitialisé avant qu’il ne reparte pour une série de tests. Si la panne est d’origine mécanique, qu’il s’agisse des plateaux ou des têtes de lecture, le disque dur est disséqué et analysé jusqu’à ce que le problème soit identifié.

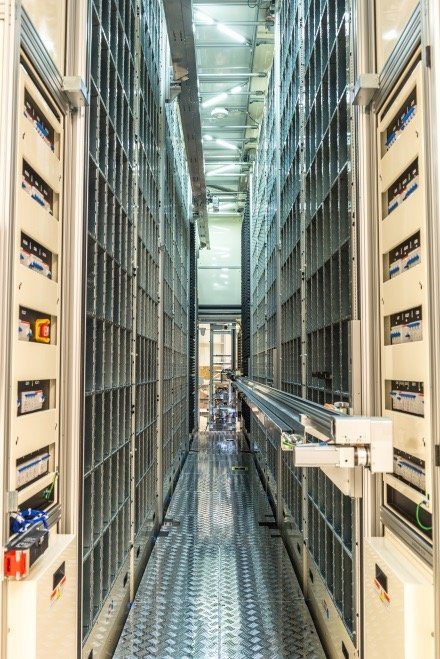

Lorsque la production commence à augmenter, les ingénieurs passent à des armoires de test plus imposantes, lesquelles peuvent contenir cent disques durs chacune. Précisons que les armoires que l’on voit ci-dessus ne servent qu’à exécuter des scripts dans des conditions de température élevée.

Seagate dispose de nombreuses armoires pour tester ses disques durs sur le long terme. La pièce que l’on voit ici, située immédiatement sous le laboratoire, est maintenue à température élevée afin de répliquer des conditions d’usage proches de celles d’un grand centre de données.

Voici une autre vue de la salle dédiée aux tests de fiabilité après avoir reculé de quelques mètres. Cette photo a malheureusement du mal à restituer la sensation que l’on éprouve en étant au beau milieu de dizaines d’armoires, lesquelles cherchent à détecter les pannes dans un certain silence.

Comme certains d’entre nous ont pu le remarquer un peu plus haut, l’écran LCD des armoires de test au moment de notre passage rapportait une température de 58°C, valeur très proche des 60°C annoncés sur la fiche technique du disque dur. A cette température en charge, le plateau inférieur grimpe jusqu’à 64 ou 65°C, tandis que les puces au niveau du PCB affichent des valeurs encore plus élevées. L’objectif de ces conditions thermiques est double. En premier lieu, les ingénieurs doivent s’assurer que les disques durs fonctionnent correctement à ce niveau de température, lequel correspond à ce que l’on mesure dans un centre de données ou un désert. Deuxièmement, le fait d’augmenter les températures sert à pousser les disques durs plus loin dans leurs retranchements et donc à raccourcir le délai avant une panne. Il est bien évident que les ingénieurs ne peuvent pas se permettre d’attendre 1,4 millions d’heures à température ambiante, alors qu’il est possible de faire des projections à partir des résultats obtenus sur quelques années avec une température élevée.

Une entreprise comme Seagate pourrait-elle tricher sur la méthodologie afin de tromper les algorithmes utilisés pour les tests ? Cela ne fait aucun doute. Il faut néanmoins mesurer les conséquences d’un tel choix, à savoir les pannes prématurées dans un premier temps et l’image de marque qui en pâtirait dans un second, puis une évolution des ventes en conséquence. Seagate œuvre donc à ajuster les paramètres de manière à garantir la solidité de ses produits sur la base du MTBF annoncé.

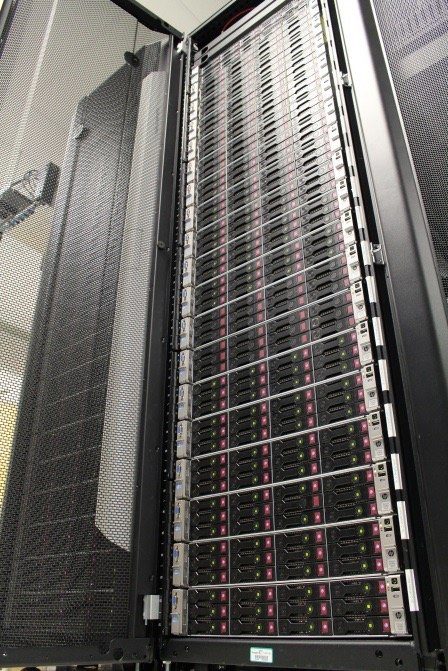

Bien entendu, les tests ne sont pas systématiquement conduits avec une température élevée. Voici les racks qu’utilise la marque pour exécuter en premier lieu des scripts sur les disques SAS/SATA, ainsi que les mettre en état de charge/repos à température ambiante.

Les images ci-dessous illustrent les chambres servant à jouer sur l’altitude. En effet, les machines que l’on aperçoit sont capables de modifier la pression de l’air afin de simuler une altitude allant d’environ 60 mètres sous le niveau de la mer jusqu’à 3050 mètres pour vérifier le bon fonctionnement des disques durs (il est même possible de reproduire les conditions d’une altitude de 12 200 mètres au besoin). Ces conditions de test sont essentielles : les têtes de lecture volant à une distance microscopique des plateaux, le moindre changement dans la pression de l’air au sein du disque peut avoir des conséquences dramatiques : incapacité à lire/écrire des données et dans le pire des cas de figure, écrasement des têtes de lecture sur les plateaux avec les pertes de données qui s’en suivent. Précisons qu’en plus de pouvoir jouer sur la pression de l’air, ces chambres permettent également de moduler la température.

L’utilité des chambres de test où l’on place des disques durs, sans les mettre sous tension, dans des conditions de pression et température extrêmes est de refléter une situation de transport. Une palette de disques durs est par exemple susceptible de rester des heures sur le tarmac d’un aéroport en Chine où en Equateur, pays où la chaleur et l’humidité peuvent atteindre des valeurs très élevées. Seagate stocke donc des disques durs dans des chambres comme celles que l’on voit ci-dessus pendant 21 jours d’affilée avec une température de 60°C et un taux d’humidité de 80 %. Quelques spécimen sont susceptibles d’être retirés durant cette période, mais la plupart subissent le test jusqu’à son terme. Les disques durs sont ensuite envoyés au laboratoire de chimie pour démontage et analyse complète comme nous allons le voir.

Les matériels de tests sont bien entendu surveillés. L’écran que l’on voit à l’image affiche toutes les chambres de test situées dans le laboratoire de Longmont. En cas de problème, la grille utilise un code couleur ainsi que des codes alphanumériques pour indiquer le degré d’alerte. Cette même grille notifie également aux techniciens l’échéance des sessions de maintenance et calibration des chambres. L’un d’entre eux nous a également montré qu’il était possible de passer à une grille similaire, laquelle relayait l’état des chambres de tests situées dans le centre R&D de Thaïlande.

« Si un compresseur rencontre un problème et commence à émettre des vibrations dans l’armoire de test, nous recevons une alerte », nous a expliqué un ingénieur. « Ce sont les disques durs qui communiquent alors avec la grille pour lui dire : je vois beaucoup de NRRO (erreurs non répétitives)/Il y a beaucoup de vibrations, que se passe-t-il ?/Le compresseur est-il hors-service ?/Les ventilateurs sont-ils déséquilibrés ? Voilà le genre de mesures qui apparaissent. Si une chambre réglée à une température précise n’arrive pas à maintenir cette température quelle qu’en soit la raison, nous aurons également une alerte. A nous de voir si le problème vient du compresseur. Ce qui est très appréciable, c’est que les données de la chambre de test sont distinctes des informations provenant des disques durs. Le degré de contrôle que nous avons est assez incroyable ».

Phase de tests – Vibrations

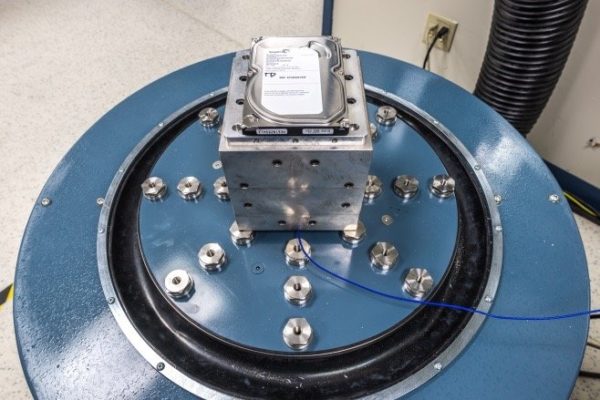

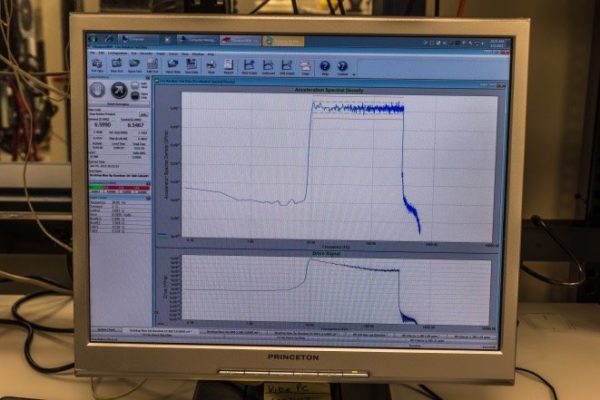

Comme l’on peut s’en douter, le test des disques durs ne s’arrête pas aux épreuves de température et d’humidité. C’est ainsi que des machines ont pour but de générer des vibrations. On voit sur l’image ci-dessous une machine cylindrique qui nous arrivait en-dessous de la taille, entourée par un carénage impressionnant ainsi qu’un tuyau d’extraction d’air dont le diamètre ne l’est pas moins vu la taille de la machine. L’explication est venue d’elle-même lorsque les ingénieurs l’ont allumée avant de la faire grimper dans les tours : la machine fait tout simplement le bruit d’un réacteur au décollage (ce dont on peut se rendre compte avec les vidéos). Un mouvement en 3D est alors imprimé aux pauvres disques durs, sous le contrôle de la station de travail située immédiatement à côté, laquelle enregistre également les résultats du test en temps réel. Comme on le déduit vu l’absence de nappes d’alimentation et données sur la plupart des images ci-dessous, les ingénieurs n’ont pas mis les disques en fonctionnement lors de cette séance de torture.

Sur l’image ci-dessous, on voit l’empreinte de la vibration telle qu’envoyée à la machine. Celle-ci démarre à 10 Hz, avant d’augmenter et se stabiliser à 300 Hz. L’amplitude est de 0,15 d2 par Hertz. Bien que l’on ne s’en rende pas forcément compte avec les vidéos, le fait est que ce test de vibrations est assez « destructeur », a fortiori avec des vibrations aléatoires. Si le disque n’est pas physiquement endommagé, le test rendra a minima les opérations en lecture/écriture extrêmement difficiles. Les différentes familles de produits sont attendues à différents niveaux de performances suivant les conditions exercées. Les tests à contrôle fin comme ceux-ci servent à confirmer que le niveau de performance est bien atteint.

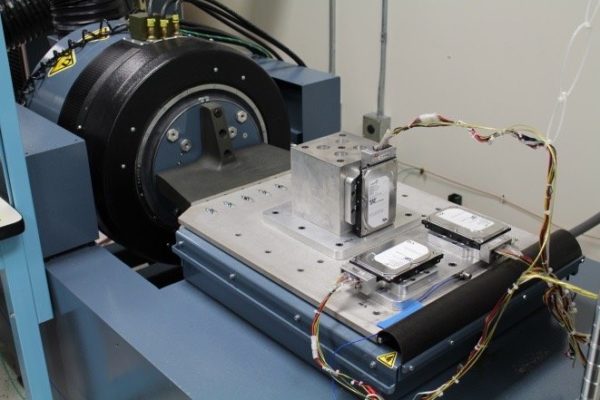

Les ingénieurs ont parfois besoin d’examiner les conséquences du mouvement sur un axe particulier. C’est là que la « table de glissement » devient utile, cette dernière limitant le mouvement à un unique plan.

Enfin, Seagate utilise plusieurs tables à vibrations rotatives. Nettement plus compactes que les autres machines, leur rôle n’en est absolument pas moins important pour autant. Cette compacité tient au fait qu’un seul disque est monté à la perpendiculaire de la table. L’énergie rotative influe tout particulièrement sur les disques durs du fait que ces derniers embarquent des plateaux suivant un mouvement rotatif, tandis que les têtes de lecture essaient de se déplacer au-dessus des plateaux avec une très grande précision, tout en suivant des arcs de cercle. L’énergie rotative tend à faire « dérailler » les têtes de lecture, ce qui empêche d’écrire des données ou pire, engendre des écritures sur la piste adjacente à celle qui devait les recevoir. D’après les ingénieurs de Seagate, ces tables à vibrations rotatives jouent un rôle plus important que celui des modèles plus imposants.

On pourrait croire qu’un disque dur monté dans un rack ou un PC n’est pas sujet aux interférences de l’énergie rotative, mais il s’agit malheureusement d’une idée reçue.

« La majeure partie de l’énergie devient rotative compte tenu de la mécanique du châssis et de tous les composants connectés » nous a confié un technicien. « Le disque dur lui-même peut être une source de vibrations rotatives. Prenez le cas des recherches aléatoires : l’énergie est envoyée au rotor du disque dur, avant d’être transmise à la monture de ce dernier. Peu importe que la monture soit rigide, qu’elle ait des patins. Elle renverra forcément l’énergie au rotor du disque dur, ce qui va être pénalisant en termes de débits du fait de l’énergie rotative ».

Ce phénomène est une des nombreuses raisons pour lesquelles les disques durs dédiés au stockage nearline (c’est-à-dire à mi-chemin entre stockage en ligne et archivage hors-ligne) embarquent des accéléromètres au niveau de leur PCB. L’énergie rotative est mesurée, suite à quoi les mesures sont envoyées vers des boucles d’asservissement capables de compenser. Les disques durs destinés aux particuliers ne sont pas armés de telles contre-mesures et doivent donc subir les conséquences directes des vibrations.

Phase de tests – Chutes

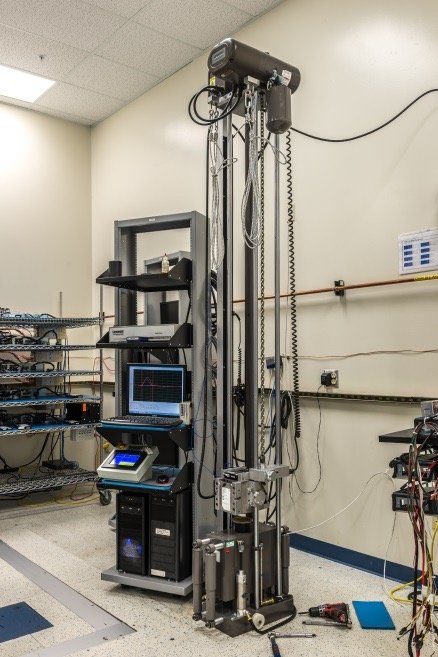

Lorsque l’on parle de tests relatifs aux vibrations, la résistance aux chocs n’est généralement pas loin. Le principe de base pour ce second type de tests est on ne peut plus simple : faire tomber le disque dur depuis une certaine hauteur et mesurer les conséquences du choc. Bien entendu, des machines de précision sont nécessaires pour obtenir des résultats fiables.

Le test de chute auquel nous avons assisté a été réalisé avec une amplitude de 600G et des impulsions d’ondes sinusoïdales d’une milliseconde. Plus la largeur de l’impulsion est réduite, plus la fréquence d’entrée ou l’amplitude du choc s’amplifie. On peut faire un parallèle avec la boxe : si un athlète prend un crochet dans la mâchoire et que celui met deux secondes à exercer sa force, il devrait encaisser le coup. Si la force s’exerce en un dixième de seconde, il finira par terre à coup sûr. Les fonctionnalités au sein d’un disque dur répondent différemment en fonction de la largeur d’impulsion du choc.

« Nous devons tester les disques à différentes largeurs d’impulsions et amplitudes pour vérifier que le résultat est satisfaisant suivant diverses fréquences », nous a confié un technicien. « Si un disque prend un choc en conditions d’utilisation réelles, l’impulsion dépend de la surface sur laquelle il tombe. De même, la réaction ne sera pas la même si c’est la configuration accueillant le disque dur qui encaisse un choc. Nous observons donc la solidité du produit avec des tests maîtrisés, à diverses amplitudes et largeurs d’impulsions, de manière à avoir une bonne idée de son comportement en conditions réelles ».

Afin de contrôler la largeur des impulsions, les ingénieurs gèrent certains des paramètres de chute avec des patins circulaires en mousse. Cela nous a paru assez incroyable : des tests extrêmement précis sont conduits sur des machines coûtant plusieurs milliers d’euros, avec des composants qui ressemblent à des sous-verres.

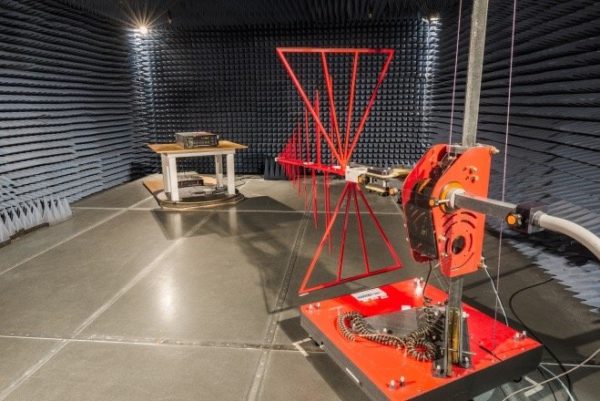

Phase de tests – 4ème partie

Nous voici dans le laboratoire dédié aux interférences électromagnétiques (EMI) du centre de Longmont, passage obligé pour les produits afin qu’ils répondent aux normes électroniques en vigueur. Pour simplifier, Seagate teste trois aspects à ce stade :

- L’énergie électromagnétique émise par les disques durs en fonctionnement

- La sensibilité des disques durs aux EMI

- La tolérance des disques durs aux chocs électrostatiques

A l’aide d’un détecteur d’EMI (structure rouge ci-dessous), Seagate mesure les émissions des disques durs, depuis le boitier d’un serveur dans le cas de la photo ci-dessous. L’antenne peut tout à fait subir une rotation afin de mieux déceler les émissions suivant différentes polarités. Notons également que le serveur et sa table sont posés sur une plateforme circulaire, ce qui permet aux ingénieurs d’orienter l’ensemble de diverses manières afin que les émissions puissent être étudiées sous tous les angles.

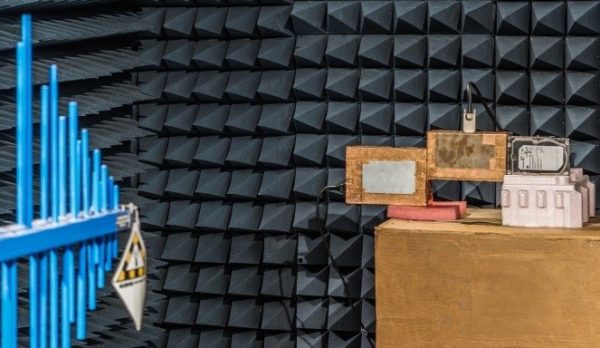

On voit ici l’autre versant des tests EMI, c’est-à-dire la sensibilité des disques durs aux interférences électromagnétiques. Dans une chambre anéchoïque comme celle-ci, les meubles et accessoires tendent à être conçus en bois ou en mousse : les composants métalliques risqueraient de renvoyer des EMI et donc de fausser les tests. C’est également pour cette raison que les murs sont recouverts de mousse découpée en pyramides. Tout comme l’isolation sonore, cette mousse sert à absorber les radiations électromagnétiques et minimiser les renvois de signaux, d’où l’appellation an-échoïque.

L’appareil utilisé ici ressemble à un taser et pour cause : c’en est un. Naturellement, les ingénieurs peuvent moduler la charge envoyée par l’appareil, suite à quoi les composants comme les performances des disques durs testés sont examinés dans le détail. L’opération représentée ci-dessous consiste à envoyer un choc électrostatique modéré à un pc, d’une intensité comparable à ce que l’on peut obtenir avec sa propre main après avoir par exemple marché sur un tapis lors d’une journée sèche. Les PC sont supposés être reliés à la terre, mais Seagate ne souhaite pas prendre de risques quant à la fiabilité de ses produits.

L’acoustique peut constituer un critère très important dans certaines applications pratiques du stockage, comme par exemple les disques durs équipant les boitiers multimédia et certains systèmes embarqués. Même au sein d’une tour, nous savons tous combien un disque dur peut devenir excessivement bruyant lors des opérations de recherche. La pièce que l’on voit ci-dessous est l’une des trois sur le site de Longmont permettant à Seagate de s’assurer du niveau sonore de ses produits. Il s’agit de la plus petite des trois : la seconde permet plus de mouvements autour du matériel de test, tandis que la troisième est encore plus grande afin de permettre la prise de mesures sur des préliminaires de prototypes qui ne sont pas nécessairement montés comme le sont nos disques durs.

Comme le montre la photo, de nombreux micros sont disposés de manière à entourer les produits testés. Précisons que pour certains tests, la configuration que l’on distingue sur son rack peut être éloignée afin de ne pas perturber les mesures. Particulièrement optimisés pour un bruit électrique le plus faible possible, les micros utilisés sont chacun accompagnés de leur propre préamplificateur et coûtent environ 7000 € pièce. Le buste qui sert à mesurer la qualité sonore (et non pas la puissance sonore), vaut à peu près 50 000 € à lui seul. La pièce dans lequel nous avons pris la photo a été construite sur sa propre dalle en béton afin de limiter les vibrations et coûte la bagatelle de 400 000 €. La valorisation de ces éléments permet de mieux prendre la mesure des efforts et coûts déployés pour concevoir des disques durs capables d’atteindre les valeurs acoustiques annoncés.

Analyses

Le site de Longmont abrite également un laboratoire de production entier et complètement automatisé, capable de produire des milliers d’exemplaires de chacun des disques durs de la marque. Ce laboratoire aurait pu constituer à lui seul la matière pour un article entre ses robots, les retours d’expérience visuels pour la calibration, les systèmes de suivi capables non seulement d’identifier le lot d’origine d’un disque dur mais aussi son rack d’origine et même sa position sur le rack.

[https://youtu.be/-huVTjY0wRY]

Ceci étant dit, ce laboratoire est infime à côté des véritables usines de production situées en Asie. Des produits contaminants pourraient finir par se retrouver dans de nouvelles conceptions durant leur processus de développement, ou bien durant leur production. Malgré le fait que l’assemblage soit fait dans des conditions de propreté très strictes, le risque zéro n’existe pas. La contamination pourrait également venir des disques durs comme de sources extérieures : un certain type de lubrifiant, une émission chimique émise par un nouveau composant au sein d’un PCB etc. Certains facteurs incombent à Seagate, d’autres sont de la responsabilité des fournisseurs de la marque. Nous avons évoqué plus tôt le fait que les disques durs étaient analysés après un séjour en armoire de tests atmosphériques : la contamination peut également venir des conditions atmosphériques. Bien entendu, si la contamination touche les plateaux ou les têtes de lecture, les conséquences peuvent être catastrophiques.

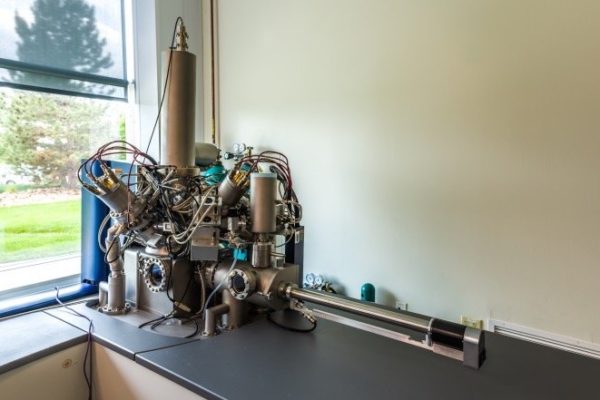

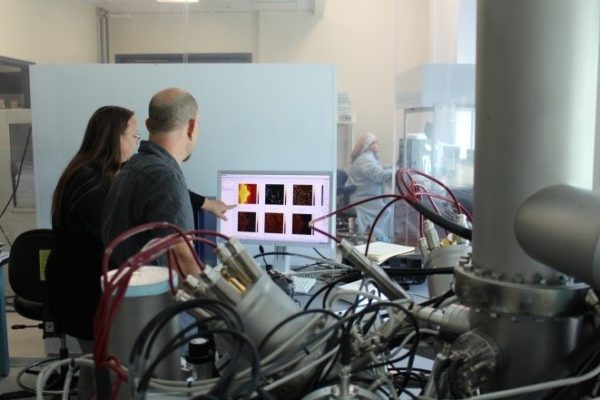

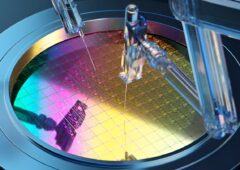

La recherche de contaminants commence ici, avec spectromètre de masse à ionisation secondaire. En résumé, les scientifiques l’utilisent pour analyser les matériaux se trouvant sur les couches supérieures des têtes de lecture et plateaux, avec une finesse permettant d’aller jusqu’aux molécules.

Lorsque nous sommes arrivés dans le laboratoire de spectrométrie, les chercheurs étaient en train d’examiner un contaminant de type hydrocarbure fluoré. Selon toute vraisemblance, il provenait d’un des lubrifiants utilisés par le disque dur. Précisons à ce sujet qu’un disque dur est susceptible d’utiliser différents lubrifiants en fonction des composants, chacun d’entre eux se présentant évidemment différemment sous le spectromètre. Ceci permet aux scientifiques de mieux identifier la source de contamination potentielle.

Le laboratoire de métrologie des particules se situe immédiatement à côté de la pièce accueillant le spectromètre de masse à ionisation secondaire. C’est là que chaque particule pouvant être extraite d’un composant est analysée. Les techniciens mesurent évidemment des quantités, mais ils caractérisent également les différentes particules présentes soit en raison des matériaux, soit en tant que contaminants.

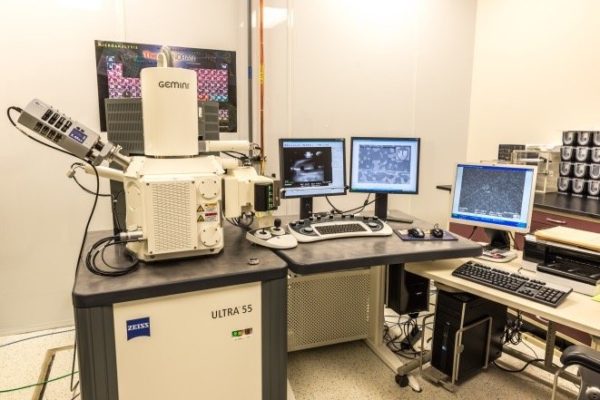

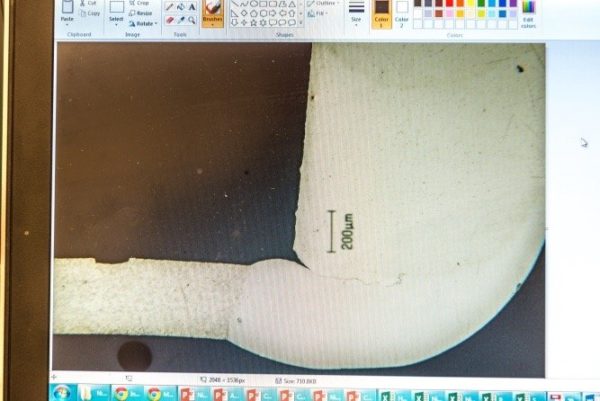

Un laboratoire d’analyse digne de ce nom doit nécessairement avoir un microscope électronique à balayage (SEM) ou deux. Au cours de notre visite, nous avons pu voir une machine prendre des extractions filtrées (donc séchées), depuis le laboratoire de métrologie des particules puis les faire analyser par le SEM pour identification. Sur le second SEM que l’on voit ci-dessous, les points blancs représentent des traces de corrosion mesurant quelques dizaines de molécules seulement. Ces traces ont été retrouvées sur les têtes des disques durs exposés pendant trois semaines aux conditions d’humidité et température précédemment évoquées. Les techniciens évaluent l’état de la tête et utilisent un algorithme maison pour lui donner un score. Si ce dernier est trop élevé, certains composants de la nouvelle conception devront être remaniés.

L’analyse n’est pas systématiquement chimique. En effet, notre dernière étape au sein de l’aile du bâtiment dédiée aux travaux d’analyse s’est faire dans le laboratoire de métallographie, lequel travaille essentiellement par études transversales.

« Nous effectuons des analyses transversales sur chaque composant, chaque sous-assemblage » nous a expliqué un technicien. « On va même jusqu’à faire des analyses transversales sur des disques durs en entier ; il y a de nombreuses raisons à cela. Bien souvent, cela permet à l’équipe chargée de la conception mécanique de constater les tolérances à partir de composants issus de la production. Nous analysons aussi les composants qui ont été exposés à des conditions auxquelles on ne survivrait pas pour ensuite évaluer la tenue du composant ou du sous-assemblage. Le fait est que les disques durs sont de plus en plus fréquemment utilisés dans des environnements extrêmes. Nous envoyons les disques durs pour des tests de corrosion, pollution et chaleur, suite à quoi nous évaluons les conséquences, surtout en ce qui concerne les circuits imprimés. Notre souci est notamment d’évaluer la nécessité des garanties étendues sur les disques durs destinés aux entreprises, mais aussi de répondre à la demande pour des produits capables de fonctionner normalement dans des environnements hostiles ».

La quantité d’informations que l’on peut tirer d’études transversales est fascinante. Un technicien peut intentionnellement décider de fracturer un disque pour voir ce qu’il advient de ces composants, notamment en surface de ces derniers. Le PCB nécessite une attention particulière, surtout en dessous des puces, comme les points de soudure en général. Sans surprise, ces préoccupations sont encore plus importantes lorsque l’on conçoit et améliore des disques durs remplis d’hélium. Sur les images ci-dessous, on voit des coupes transversales de l’assemblage des moteurs.

Ici, nous voyons des découpes transversales du rotor d’une nouvelle conception de disque dur. Au microscope, on aperçoit une fissure qui ressemble à un cheveu : c’est exactement ce genre de problème que les ingénieurs souhaitent voir résolus par le biais du processus de développement des produits.

Conclusion

Il nous faut insister sur le fait que les tests et analyses évoqués au travers de cet article et bien d’autres sont répétés à nombreuses reprises. Un changement de composant dans une nouvelle conception peut donner de bons résultats à température ambiante, comme dégager des résidus s’il est exposé de manière prolongée à des températures élevées. La résolution de ce problème est susceptible de perturber l’équilibre du disque ou encore d’engendrer une faiblesse structurelle, ce qui forcera également les ingénieurs à trouver des solutions. Bien souvent, on en vient à évaluer le pourcentage de composants défectueux par million d’unités (DPPM), un des principaux indicateurs utilisés au fil du processus de développement des produits (PDP), de la fabrication et enfin de l’intégration. Lorsque le taux de DPPM est suffisamment faible et qu’en parallèle, les autres indicateurs de performance et d’endurance pour un stade d’Intégration donné sont satisfaisants, la nouvelle conception avance vers la phase de tests suivante. La production augmente, tandis que les tests et analyses reprennent depuis le début avec des critères encore plus élevées. Le fait qu’une nouvelle conception puisse passer de quelques heures de fonctionnement à plus d’un million au cours des six mois sur lesquels s’étend la phase d’intégration tient un peu du miracle au final.

Comme si le centre de Longmont n’était pas assez occupé avec ses propres projets de PDP, les usines de Seagate lui envoient régulièrement des échantillons issus de la production à fins de tests et d’analyse. Le but est de confirmer que les produits répondent bien à la conception originale bien que le processus de fabrication soit différent. Si les nouvelles conceptions sont généralement passées au crible avant d’arriver chez les consommateurs, on a déjà vu des équipementiers découvrir un problème durant leur propre cycle d’intégration et transmettre une solution au centre de Longmont pour examen approfondi.

Pour couronner le tout, les ingénieurs doivent également préparer l’avenir. Sur la photo ci-dessous, on peut apercevoir la ligne de production dédiée à la prochaine génération de disques durs chez Seagate : répondant au nom de code « Falcon », elle promet d’étendre les capacités actuelles. Cette ligne de production était en cours d’assemblage lorsque nous sommes passés, mais elle se destine bien entendu aux usines de production à terme. Une fois finalisée, elle sera elle aussi produite à grande échelle de manière à débiter des disques durs proposant 10 téraoctets d’espace et plus.

Nous avons concentré ce reportage sur les disques durs, mais il ne faudrait pas oublier que Seagate travaille également sur sa gamme de SSD à Longmont comme on peut le voir ci-dessous.

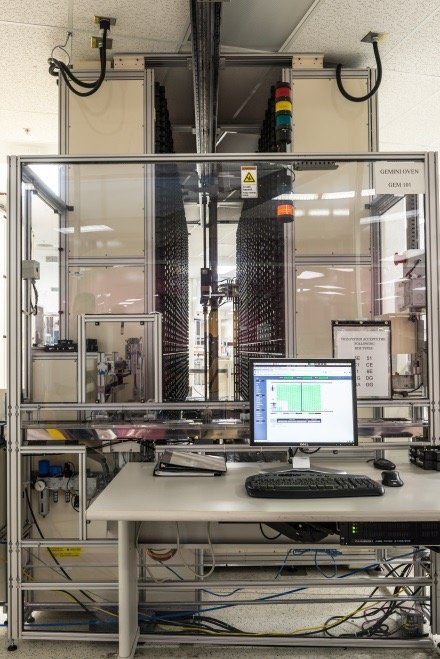

C’est l’une des dernières étapes de notre visite qui nous a probablement le plus marqués. Sur les deux dernières images de cet article, on voit l’un des cinq testeurs Gemini présents sur le site : il s’agit d’une énorme machine robotisée pouvant accueillir 6288 disques durs. Elle sert à faire tourner une quantité impressionnante de scripts sur de nouvelles conceptions, tout particulièrement celles destinés aux applications cloud. Gemini facilite par ailleurs les changements de firmware suivant les scripts utilisés et permet d’exécuter de nombreux tests. Seagate nous a confié que par rapport à son prédécesseur, Gemini occupait 60 % de place en moins tout en réduisant sa consommation de 28 %, permettant ainsi d’arriver à une baisse de 40 % des coûts de fonctionnement.

Tout ce que nous avons vu mène à la commercialisation de disques durs fiables et abordables tels qu’utilisés dans nos PC comme chez d’énormes entreprises comme Seagate. On comprend mieux pourquoi la recherche et le développement représente un investissement annuel de 2 milliards de dollars à la marque américaine, ainsi que le taux de panne annuel de 1,2% à l’échelle de l’ensemble des disques durs qu’elle produit. Les indicateurs constituent une source d’information appréciable, mais il est autrement plus enrichissant de se retrouver au cœur des processus et prendre la mesure des milliers d’heures passées à tester et re-tester les produits de manière à pouvoir afficher de telles promesses en termes de fiabilité. Pour notre part, l’expérience a été suffisamment marquante pour que l’on ne regarde plus jamais un disque dur (a fortiori un modèle professionnel) de la même manière.