Introduction

En ce début d’année, voici 25 technologies qu’il faut surveiller de près. Certaines ont le potentiel de transformer l’industrie dans peu de temps. D’autres ne seront pas viables avant au moins 2020 et d’autres enfin sont dans ce classement parce qu’elles font rêver.

Nous n’avons pas tenté de deviner le futur. L’exercice serait futile. Nous avons par contre essayé de résumer ce qui intéresse les chercheurs et les centres de recherche et développement.

Batterie rapide, flexible et originale

Les batteries connaissent une évolution lente. On utilise toujours des ions lithium et les innovations améliorent principalement la capacité des cellules et l’électronique affectant leur rendement et leur longévité. Il serait néanmoins maladroit de ne pas surveiller ce domaine de près.

Les chercheurs travaillent principalement sur trois fronts. Ils tentent tout d’abord d’accélérer les temps de recharge (cf. « Une batterie au silicium qui se recharge en 10 minutes ») et l’autonomie. Ils se penchent aussi sur de nouveaux matériaux prometteurs, comme le sodium et la saccharose, du graphène ou des éléments organiques (cf. « Des batteries Li-ion aidées par les dents de mollusques marins »). Enfin, ils cherchent à créer des cellules flexibles et transparentes qui pourraient s’adapter aux terminaux du futur.

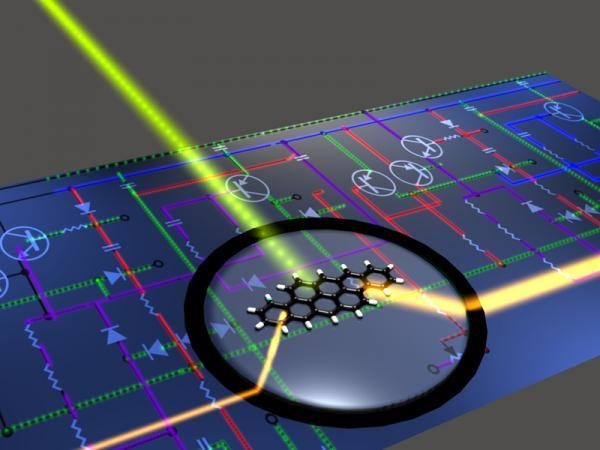

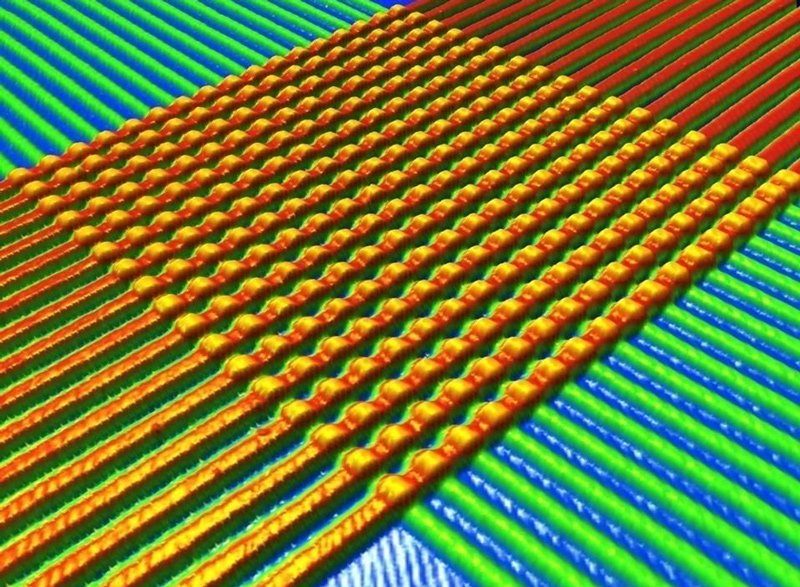

Circuits optiques

L’informatique repose depuis ses débuts sur le transport d’un courant électrique. Il alimente les systèmes, mais il est aussi à la base du langage binaire qui décrit généralement si l’électricité passe ou pas. Néanmoins, les circuits optiques sont très prometteurs et continuent de faire l’objet de nombreuses recherches. Le principe est simple : utiliser la rapidité de la lumière pour multiplier les performances sans augmenter la chaleur de la puce.

IBM est un des grands acteurs de ce domaine (cf. « IBM montre un lien optique haute fréquence pour circuits intégrés »). Il tente de trouver des solutions aux défis que posent ces systèmes, comme la miniaturisation des lasers utilisés et les rendements nécessaires pour leur fonctionnement. Les premiers résultats sont prometteurs (cf. « IBM invente une interface optique à 8 Tbit/s »), mais il reste encore beaucoup de travail à faire (cf. « IBM : un pas de plus vers des ordinateurs optiques »).

Claytronics

On entend peu parler de la Claytronics en ce moment, mais elle reste un domaine intéressant qui est porteur de grandes promesses. Pour mémoire, il s’agit d’une technologie développée en priorité par Intel et l’université Carnegie Mellon. Cette argile électronique (clay electronic en anglais d’où le nom claytronic) utilise des catoms, des nano-ordinateurs qui forment les briques des objets à créer à l’instar d’un atome.

Ces machines sont capables en principe de communiquer entre elles pour se repositionner et créer de nouveaux objets. Les catoms les plus courants utilisent les forces électrostatiques pour se regrouper et se diviser. La Claytronics utilise aussi ses propres langages de programmation, principalement le Meld et le LDP.

Détecteurs de mouvements

Les détecteurs de mouvements sont de plus en plus courants. On les retrouve sur console avec le célèbre système Kinect de Microsoft et le rachat de PrimeSense par Apple a fait couler beaucoup d’encre. Ces systèmes continuent néanmoins de faire l’objet de nombreuses recherches. Il faut dire que ce système a créée un engouement important auprès des chercheurs qui ont multiplié les projets à la Minority Report.

On remarque que la recherche tente de donner du sens à ce système de détection des mouvements et qu’au-delà du jeu, on étudie des applications marketing et promotionnelles (cf. « Un panneau publicitaire SoftKinetic à la Minority Report »). Les universitaires tentent aussi d’améliorer la précision de ces systèmes en utilisant de meilleurs capteurs ou en faisant appel à d’autres outils à porter sur soi (cf. « La souris gant inspirée de Minority Report »). Enfin, les industriels cherchent à les démocratiser en les rendant moins chers tout en remplaçant la souris traditionnelle (cf. « Leap Motion arrive dans les PC de HP »).

Détection des visages

Les systèmes de détection des visages sont loin d’être nouveaux, mais la recherche continue d’avancer lentement. La plupart des applications grand public sont utilisés dans les appareils photo capables de détecter une ou plusieurs personnes afin d’optimiser la prise du cliché (cf. « Un brevet chez HP pour brouiller les visages »). L’autre grande utilisation de cette technologie est sécuritaire puisqu’elle tente de substituer le mot de passe traditionnel au visage de l’utilisateur (cf. « Le mobile à reconnaissance de visage de Sharp »). Dans les faits, ce dernier type d’usage est encore peu utilisé (cf. « Reconnaissance de visage sur les portables Toshiba »).

La recherche se penche aussi sur l’interprétation des émotions (cf. « Un ordinateur qui ressent vos émotions »). C’est un domaine complexe qui laisse rêver. L’ordinateur pourrait détecter la joie, le bonheur ou la frustration et la haine de l’utilisateur pour optimiser l’interface et le contenu qui provoque cette réaction. Imaginez un moteur de recherche qui sait à l’avance ce qui vous fait plaisir et vous pouvez comprendre la portée de cette technologie.

FeRAM

La FeRAM (Ferroelectric RAM) est proche de la DRAM, mais son condensateur utilise un matériau ferroélectrique, ce qui en fait une mémoire non volatile (elle n’a pas besoin d’être alimentée pour garder son bit en mémoire). Grossièrement, en changeant la polarité du matériau ferroélectrique, on écrit un 1 ou un 0. Son avantage est qu’elle offre des débits rapides. Le problème est qu’elle reste difficile à fabriquer, qu’il n’y a pas eu beaucoup d’avancées dans ce domaine ces dernières années (cf. « Toshiba : de la FeRAM à 1,6 Go/s ! ») et qu’elle souffre d’une concurrence acharnée des MRAM (cf. « Ramtron et Texas Instrument vous dévoilent la FRAM »).

Concrètement, les scientifiques utilisent toujours principalement un film en céramique de PZT (Titano-Zirconiate de Plomb) qui contient des dipôles électriques (cf. « Ferroelectric RAM – Wikipedia, the free encyclopedia »). L’application d’un champ électrique aligne ces dipôles. Une polarisation négative équivaut à un 1. Une polarisation positive représentera un 0. Pour l’instant, il semblerait que les chercheurs tentent principalement de trouver un moyen de pouvoir en produire en masse et d’améliorer leurs performances, ce qui est encore loin d’être évident.

Graphène

Nous y avons consacré tout un dossier, donc nous n’y reviendrons que brièvement, mais le transistor en graphène reste dans tous les esprits (cf. « Futur : la course aux transistors en graphène ») et ce matériau continue de fasciner les chercheurs. Il est utilisé comme système de refroidissement, comme anode dans les batteries, comme convertisseur optoélectronique ou comme support de stockage.

Le problème est qu’il reste difficile à fabriquer en masse et dur à manipuler. Les scientifiques continuent de découvrir de nouvelles propriétés (cf. « L’argent faciliterait la fabrication du graphène »). Il faudra néanmoins attendre encore de nombreuses années avant que la révolution du graphème ait lieu.

High-tech transparent

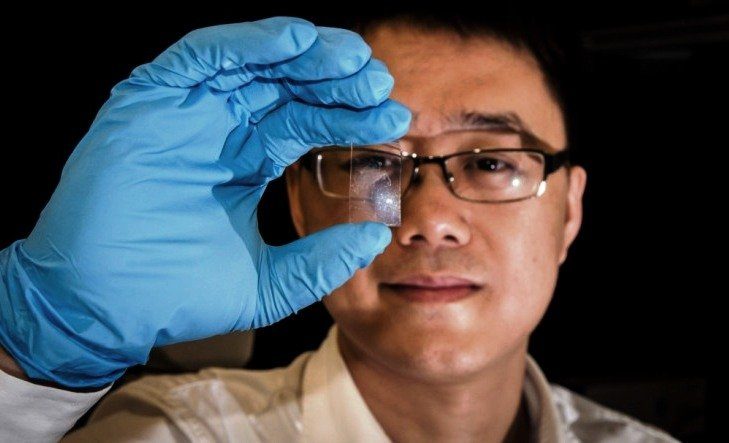

Pour qu’un produit soit transparent, il faut que tous ses composants le soient, ce qui n’est pas une mince affaire. Néanmoins, la recherche avance à grands pas. Il y a déjà des mémoires transparentes, les TRRAM qui utilisent des oxydes de métaux transparents. Stanford a aussi montré une batterie transparente (cf. « Et voici la batterie Li-ion transparente ») et on a déjà pu voir des écrans LCD transparents (cf. « SmartWindow : un LCD transparent de 46″ »).

Le problème est que pour l’instant, ces produits restent des vitrines technologiques et ne dépassent pas vraiment le cadre des laboratoires. Ils sont mis en avant par les divisions de recherche et développement, comme Microsoft Research, et on a pu voir quelques prototypes (cf. « Un smartphone totalement transparent chez Polytron »), mais il reste encore beaucoup de défis industriels et technologiques. Il y a aussi la question de l’utilité de ce genre de terminaux qui est pour l’instant sans réponse.

IBM Racetrack

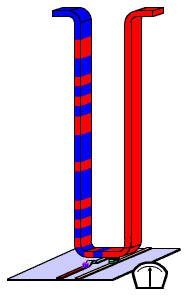

La Racetrack d’IBM est une mémoire qui prend le fonctionnement classique des solutions de stockage à contrepied. Au lieu d’aller chercher l’information avec une tête de lecture, comme sur un disque dur, ou un contrôleur, comme dans une mémoire Flash ou une DRAM, c’est le bit de mémoire qui se déplace.

La Racetrack (ou champ de courses en Français) est une piste de quelques dizaines de nanomètres d’épaisseur. Cette piste stocke les données et sert donc de mémoire. Lorsque le système cherche à savoir si un bit est présent, il va l’ordonner de se déplacer sur la piste pour arriver à un endroit précis. En théorie, ce système serait nettement plus rapide que n’importe quel autre mémoire (cf. « La mémoire Racetrack d’IBM progresse »). En pratique, même IBM ne pense pas pouvoir avoir un produit commercialisable avant 2020 si tout va bien (cf. « La mémoire IBM Racetrack pourrait être une réalité en 2020 »).

Impression 3D

On parle beaucoup des imprimantes 3D, parce qu’elles posent de nouveaux dilemmes, tels que l’impression d’armes à feu. Le concept n’est pas nouveau, mais il est devenu un sujet de conversation du grand public l’an dernier (cf. « Que penser des imprimantes 3D ? Révolution ou gadget ? »). Pour l’instant, l’impression 3D reste un marché de niche destiné à la création de prototypes. Les imprimantes sont chères, les modèles sont complexes à fabriquer et les applications sont pour l’instant limitées.

Les industriels et les ingénieurs multiplient les projets visant à démocratiser ces machines (cf. « 25 projets de financement collaboratif pour geeks »). Le problème est que même les grandes compagnies ont encore du mal à créer des modèles bon marché et ce n’est pas faute d’avoir essayé (cf. « Une imprimante 3D HP abordable cette année »).

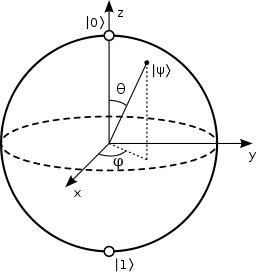

Informatique quantique

L’informatique classique repose sur la présence ou l’absence d’un courant électrique. L’informatique quantique utilise quant à lui le mouvement d’un ou plusieurs électrons ou photons, entre autres. Cela veut concrètement dire qu’il utilise un système qui est par essence nettement plus difficile à maîtriser, mais qui a un potentiel inégalé. Au lieu d’avoir un bit 0 et un bit 1, un système informatique quantique utilise des qubits, une représentation vectorielle de l’élément quantique que l’on mesure et qui peut en théorie avoir un nombre de valeur infinie.

L’exemple grand plus public le plus classique est celui de la sphère de Bloch qui montre qu’un électron ayant un spin en direction du Nord représente ket 0 (représentation vectorielle qui serait équivalente à un bit 10) et qu’un mouvement angulaire en direction du Sud représente ket 1 et que l’électron peut avoir un nombre infini de mouvements angulaires entre les deux. Le problème est que mesurer, stocker et manipuler un électron est encore très difficile et qu’il n’existe pas vraiment d’ordinateur quantique au sens classique du terme. D-Wave a conçu une machine que Google a acquise l’an dernier (cf. « Google s’achète un ordinateur quantique D-Wave »). Elle n’utilise pas des circuits quantiques classiques, mais adiabatiques. Très schématiquement, la machine fait évoluer un groupe d’électrons très lentement pour qu’il ne change pas d’état tout en encodant la solution du problème que l’on cherche à résoudre. C’est un moyen de contourner les défis actuels et si les limites de ces systèmes sont connues, ils méritent tout de même d’être étudiés en attendant de pouvoir concevoir des circuits quantiques classiques.

Interfaces neuronales

Les interfaces neuronales ont connu une traversée du désert depuis 2012, mais le gain de popularité des systèmes de réalité virtuelle les remet au gout du jour. Après tout, s’il faut avoir un casque sur la tête pour jouer, autant l’utiliser pour détecter son activité cérébrale.

On se souvient qu’OCZ avait tenté de sortir un système répondant au nom de NIA qui était voué à remplacer une souris (cf. « La souris par la pensée : le test »). Dans les faits, la machine était trop imprécise, peu pratique et demandait un apprentissage trop long. Le projet EPOC s’est donc alors imposé comme le plus prometteur (cf. « Une manette contrôlée par la pensée »). Néanmoins, en réponse à son manque d’intérêt par le grand public, il s’est reconverti pour cibler les personnes souffrant d’un handicap moteur. Les chercheurs continuent d’essayer de trouver des applications grand public (cf. « Samsung pense à une tablette contrôlée par la pensée ») et les casques de réalités virtuelles, à l’instar de l’Oculus Rift pourraient être la solution tant attendue.

Invisibilité

En décembre dernier, des chercheurs de l’université de Toronto ont montré une « cape d’invisibilité ». Il s’agissait en fait de petites antennes émettant un champ électromagnétique permettant de rendre un objet indétectable par un radar. Cet exemple montre que le principe d’invisibilité veut dire différentes choses en fonction des situations et des chercheurs.

Généralement, lorsque le grand public entend parler d’invisibilité, il pense à la faculté de rendre un objet indétectable à l’oeil nu. Les scientifiques se sont penchés sur des métamatériaux capables de détourner ou absorber la lumière autour d’un objet. Néanmoins, les recherches dans ce domaine semblent avoir stagné depuis quelques années. D’autres universitaires se sont alors penchés sur l’utilisation de nanotubes de carbones chauffés ou de coques plasmoniques. Les résultats étaient prometteurs, surtout pour cette dernière technologie capable de cacher des objets en 3D. Néanmoins, on reste encore loin d’un outil viable à grande échelle.

Li-Fi

Le Li-Fi est sans doute la technologie la plus récente de ce dossier. En 2008, des chercheurs de l’université de Boston ont montré qu’il était possible de créer un réseau sans fil en utilisant les pulsations de lumières générées par des ampoules grand public. Des LED clignotent à des fréquences élevées indétectables à l’oeil nu et transmettent ainsi un signal.

Moins de quatre ans plus tard, nous disposions d’un réseau au débit élevé (cf. « Adieu WiFi : un réseau à LED atteint 800 Mb/s ») et en 2013, des compagnies commençaient déjà à faire la promotion de leurs produits Li-Fi au MWC (cf. « LiFi, la lumière comme alternative au WiFi »). Les débits en condition réelle d’utilisation sont encore faibles (cf. « Du Li-Fi à 150 mégabits/s »), mais la recherche avance à grands pas (cf. « Le Li-Fi atteint 10 Gbit/s en laboratoire ») et les fabricants semblent vouloir intégrer cette technologie dans des produits grand public (cf. « Un smartphone LiFi au CES »), ce qui va faciliter sa démocratisation.

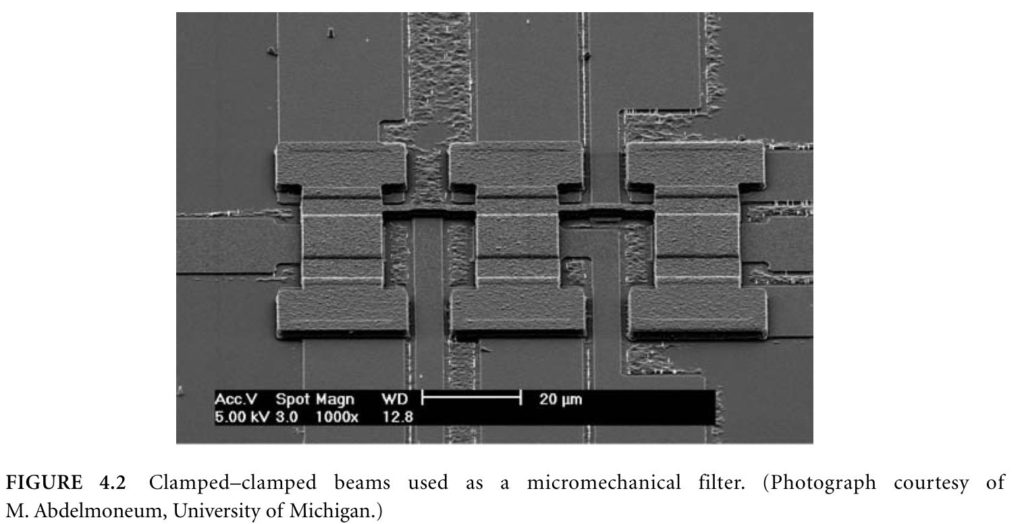

MEMS RF

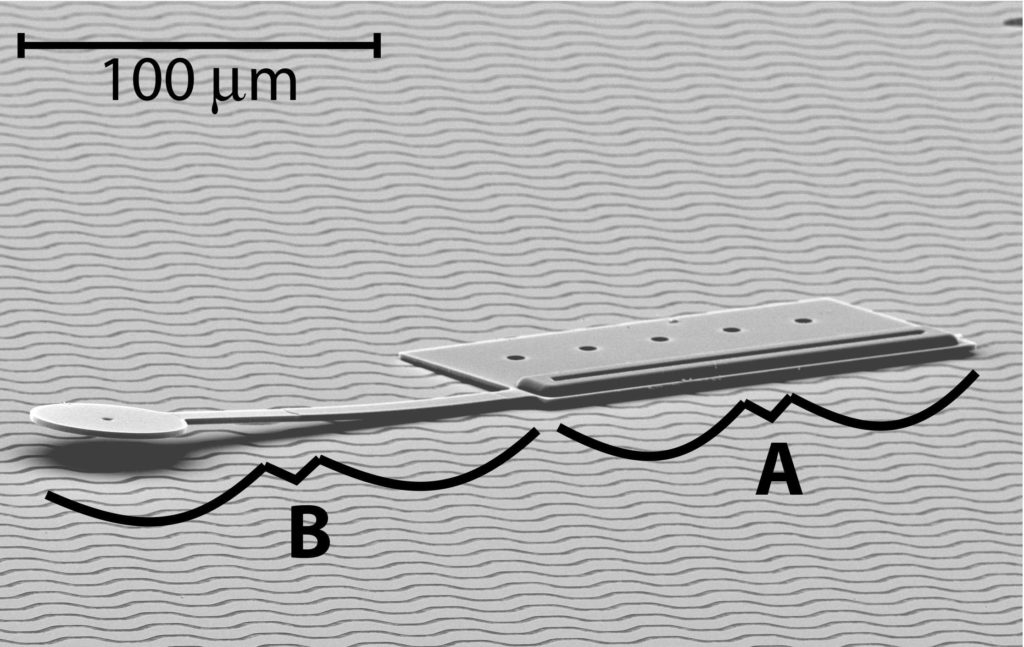

Les MEMS continuent de transformer le monde de l’électronique grand public, mais nous avons voulu nous pencher sur les MEMS RF. Il est évident que les gyroscopes et les capteurs continuent d’occuper le devant de la scène et mérite toute notre attention. Néanmoins, nous avons décidé de privilégier les MEMS RF pour deux raisons. Tout d’abord, ils restent des composants essentiels aux terminaux mobiles qui utilisent de nouveaux réseaux, à l’instar du LTE. Ils sont directement responsables de la qualité des appels et des débits proposés aux publics. À l’heure où les chercheurs développent des réseaux cellulaires toujours plus rapides (cf. « Le Japon teste un réseau sans fil de 10 Gb/s »), les MEMS RF sont les composants essentiels pour pouvoir atteindre ces nouveaux débits.

L’autre raison pour laquelle nous pensons que les MEMS RF méritent notre attention particulière est le fait que de plus en plus de constructeurs arrivent à les intégrer dans des SoC. Ils peuvent ainsi proposer des designs plus compacts. Néanmoins, comme nous l’avons souligné dans notre dossier sur ces composants (cf. « Les MEMS RF – MEMS : le monde microscopique de votre smartphone »), leur intégration est une prouesse en soi qui différencie aujourd’hui les fabricants à succès, à l’instar de Qualcomm, de ceux qui souffrent, comme Intel.

Motes

En 2001, DARPA (l’agence américaine pour les projets de recherche avancée de défense) a développé le concept d’une poussière intelligente appelé « motes » ou « smart dust » en anglais. Elles servent à capter et analyser la lumière, la température, les vibrations ou des agents chimiques. La recherche dans ce domaine avance assez lentement, mais elle est principalement limitée par les finesses de gravure encore trop grossière pour pouvoir créer des petits robots minuscules. Néanmoins, une fois les processus de fabrication maîtrisés, il n’y a rien qui empêcherait la création de ces poussières intelligente.

Pour mémoire, les motes ne demandent pas d’organisation particulière. Il suffit de les placer dans l’environnement et les capteurs s’occupent de mesurer certaines données pour ensuite les envoyer à un serveur qui interprète les données. On peut ainsi imaginer mesurer l’usure structurelle d’une infrastructure ou personnaliser une publicité en fonction de la météo ou des personnes qui passent.

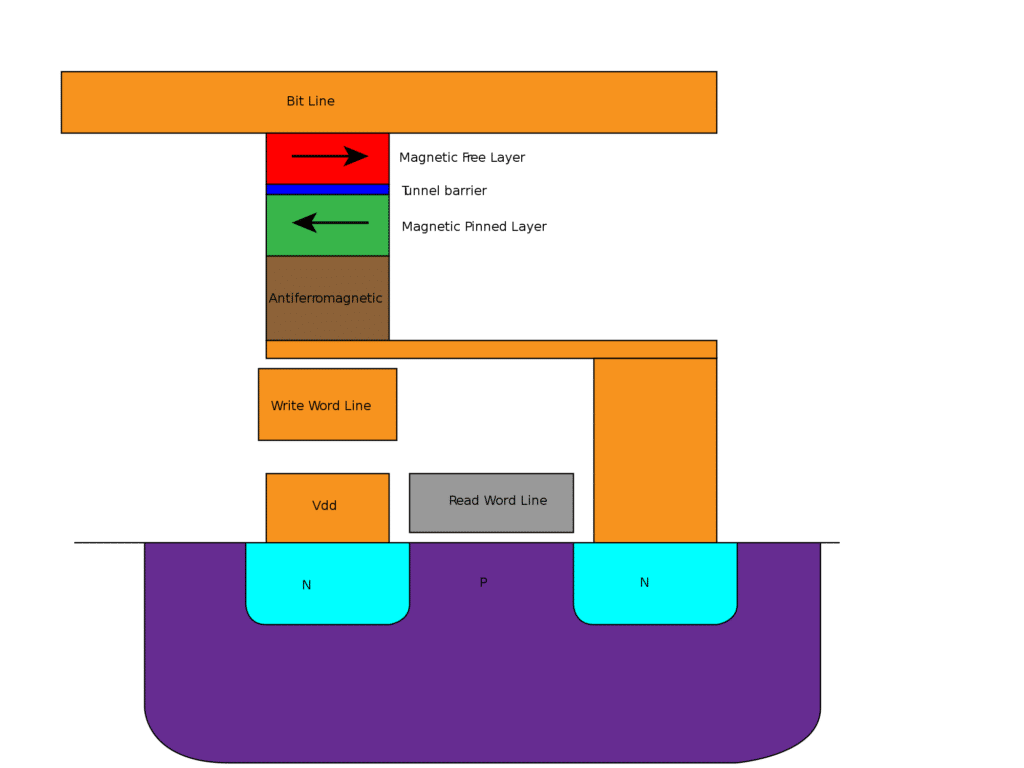

MRAM

MRAM (Magnetoresistant Random Access Memory) est l’une des mémoires du futur les plus prometteuses. Son fonctionnement repose sur la résistante magnétique des cellules. Une forte résistance représente un 1, tandis qu’une faible résistance représente un 0. On mesure la résistance en envoyant un courant électrique. Les MRAM sont déjà utilisées par quelques fabricants pour des produits de niche bien précis. Il faut dire qu’elle reste chère, mais les scientifiques travaillent sur l’utilisation de nouveaux matériaux, comme le cobalt pris entre une couche de platine et un oxyde d’aluminium.

La STT-MRAM reste la MRAM qui a le plus de chance d’être popularisée. La Spin-Transfer Torque – Magnetoresistive random access memory utilise un jonction tunnel magnétique pour stocker ses données. Très schématiquement, une cellule utilise deux éléments ferromagnétiques composés d’un alliage de cobalt et fer et séparés par une couche de ruthénium. L’un des éléments est piégé (il ne bouge pas), tandis que l’autre est libre. On va ensuite envoyer un courant électrique polarisé en spin pour influencer la position de l’élément libre qui va adopter la polarité du courant. Si la polarité de l’élément libre est identique à celle de l’élément fixe, la résistance est faible. Inversement, si les polarités sont opposées, la résistance sera forte.

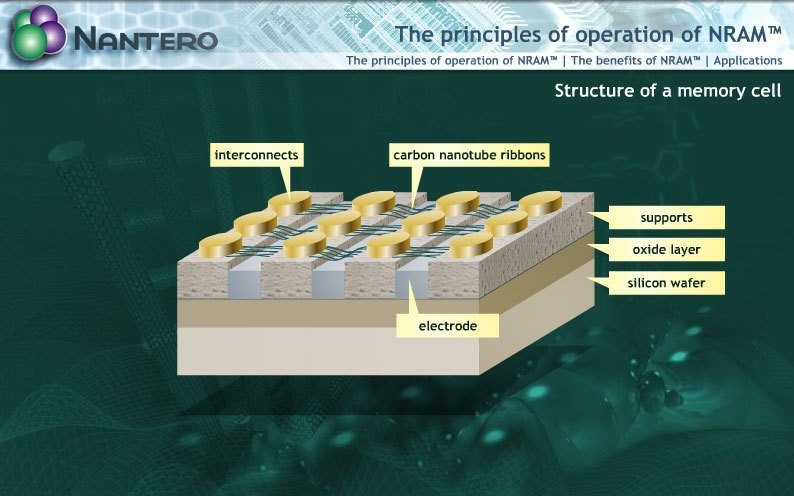

NRAM

La NRAM a deux grands problèmes. Elle est le fruit de Nantero, une société américaine, ce qui signifie qu’elle ne bénéficie pas du même soutien qu’une mémoire standard et que les industriels y réfléchiront à deux fois avant de s’y investir en raison des licences qu’il faudra acquérir pour travailler dessus. L’autre problème est qu’elle repose sur l’utilisation de nanotubes de carbones que l’on a encore du mal à maîtriser et qui restent difficiles à produire. Néanmoins, cela est aussi un atout, car ces matériaux continuent de susciter la curiosité des chercheurs qui le considèrent comme le nouvel eldorado. Cela explique pourquoi Nantero a reçu une nouvelle vague de financement en novembre 2012 de 42 millions de dollars (31 millions d’euros) et que la société fait partie des 10 startups à surveiller de près, selon EETimes. Bref, il serait maladroit de mettre cette technologie de côté.

Le nanotube de carbone est suspendu au-dessus d’un jeu de deux électrodes. Si le courant passe entre ces électrodes, le nanotube de carbone est attiré vers elle et va la toucher. On va ensuite mesurer si le courant passe entre l’électrode et le nanotube de carbone pour déterminer s’il le touche et si l’on doit renvoyer un 1 ou un 0. Malgré les apparences, cette mémoire est non-volatile, car une fois que le nanotube de carbone touche l’électrode, il n’a pas besoin que le courant passe entre les deux électrodes pour y rester. De plus, les performances sont proches de celles d’une SRAM, elles demandent très peu d’énergie et elle tolère en théorie une augmentation importante de la finesse de gravure.

OLED flexibles

Les écrans OLED flexibles sont très proches de la démocratisation. Nous avons suivi leur évolution depuis 2007 (cf. « LG.Philips présente un écran AMOLED couleur et flexible ») et leur fabrication en masse a déjà commencé (cf. « LG fabrique des OLED flexibles »). Pour arriver à leurs fins, les industriels ont utilisé un substrat en plastique bien plus facile à manier et fabriquer que l’ancien substrat en verre.

Deux questions subsistent néanmoins. La première est de savoir si une compagnie peut en produire en très grand volume. Samsung avait promis d’en vendre pour Noël dernier (cf. « Les écrans OLED flexibles seront là à Noël »). Il n’en a finalement sorti qu’en Corée du Sud (cf. « Le Galaxy Round ne sortira pas de la Corée du Sud »). L’autre question est de savoir si ce genre de dalle a une réelle utilité. Elle est plus solide qu’un modèle rigide, mais à part cela, les fabricants n’ont pas encore montré pourquoi les consommateurs devaient privilégier un écran OLED flexible qui reste assez cher.

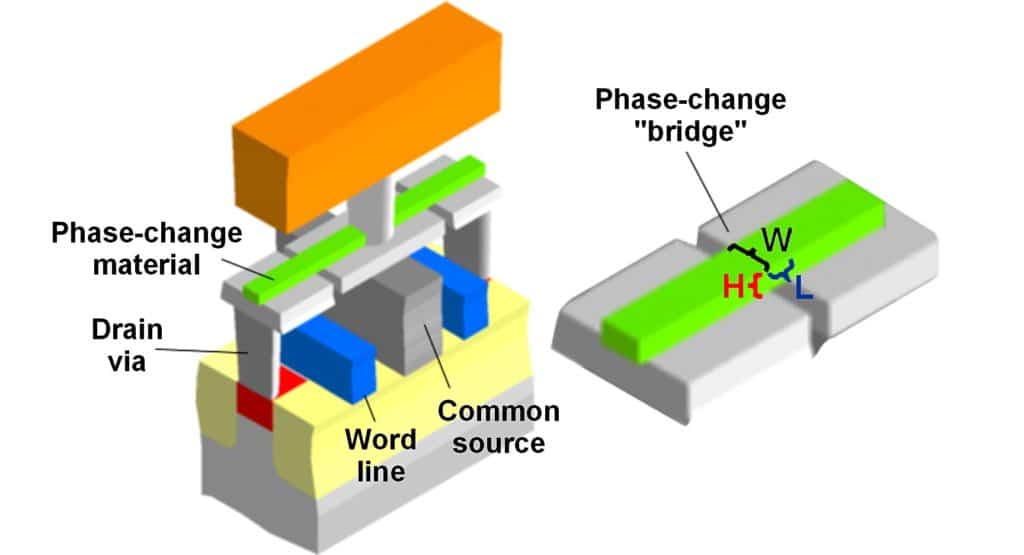

PRAM

PRAM (Phase-change RAM), se nomme aussi PCM ou Chalcogenide RAM [C-RAM]). Elle est la grande concurrente à la MRAM. Les chercheurs continuent d’en apprendre sur ses propriétés (cf. « Une PRAM réfléchissante »). Elle utilise un verre chalocogénide qui change d’état en fonction de la chaleur. Il suffit donc de faire chauffer une résistance pour le faire passer d’un état amorphe (un bit 1) à un état cristallin (un bit 0) et vice-versa. L’état se mesure à l’aide d’un courant électrique, puisque l’état amorphe a une très grande résistance.

Le verre chalcogénide est déjà utilisé dans les CD-RW et DVD-RW et la PRAM est nettement plus rapide que la mémoire Flash. Le problème est que les capacités sont encore très limitées. Pour l’instant, la recherche et les industriels semblent vouloir se concentrer sur le marché des smartphones et autres terminaux mobiles.

Projections holographiques

L’holographie est encore loin d’être démocratisée et il faudra attendre au moins 2020 avant que cela devienne une réalité courante (cf. « Projections holographiques massives pour 2022 »). Les types d’holographies et les technologies utilisés sont aussi très variés, mais l’idée est la même, projeter une image en trois dimensions dans un espace précis. Microsoft Research a présenté Vermeer, un système holographique utilisant un jeu de miroir, à l’instar du Dreamoc de RealFiction. Ces systèmes ont le grand avantage d’utiliser un environnement fermé et donc plus facilement contrôlable. Ils sont par contre moins convaincants.

L’autre grand système utilise un jeu de lumière et parfois de gaz pour projeter l’image. Il est nettement plus complexe, mais plus réaliste. Certains tentent de mélanger les deux concepts et Microsoft a sans doute fait la démonstration la plus impressionnante (cf. « Holodesk : un bureau holographique chez Microsoft »).

ReRAM

Le ReRAM (Resistive Random Access Memory, aussi appelée RRAM) utilise la résistance électrique des matériaux pour représenter un bit. Une résistance élevée représente un 1, une résistance faible un 0. Ces mémoires peuvent être facilement miniaturisées en théorie, et elles ont une grande longévité et des performances élevées (cf. « Une nouvelle ReRAM par Globalfoundries »). Les ReRAM étaient le grand sujet de conversation en 2012. La recherche semble avoir stagné.

Il y a deux grands types de ReRAM. La première utilise des matériaux classiques, généralement de l’oxyde de silicium ou des oxydes de métaux (tantale, nickel-titane, etc. cf. « Une nouvelle ReRAM ultra rapide »). La PRAM est d’ailleurs une sorte de ReRAM. La seconde provient de HP et utilise un memristor qui est le quatrième composant électrique passif après le condensateur, la résistance et la bobine. Il a la particularité de posséder plusieurs niveaux de résistance et il peut donc jouer le rôle de mémoire non volatile et de résistance à la fois.

Super Wi-Fi

Le Super Wi-Fi est un terme utilisé aux États-Unis pour désigner un réseau faisant appel aux bandes de fréquences entre les chaînes de télévision et le 2,4 GHz. Il serait utilisé par les fournisseurs d’accès à Internet pour offrir une connexion sans fil aux personnes ne bénéficiant pas des infrastructures nécessaires. L’avantage de cette technologie est qu’elle traverse mieux les murs que le WiMAX.

Pour l’instant, le réseau a été déployé en Amérique et au Canada (Calgary). Le dernier déploiement en date a eu lieu à l’université de la Virginie de l’Ouest. Les premiers résultats semblent prometteurs et cette technologie pourrait être utilisée en campagne ou dans des zones reculées où poser le câble, la fibre optique ou les lignes ADSL représente un investissement trop important pour les fournisseurs.

TRAM

La TRAM ou Thyristor RAM est la seule mémoire volatile de notre classement. Elle veut remplacer la SRAM en proposant une meilleure densité et des débits nettement plus élevés. GlobalFoundries a déjà montré son enthousiasme (cf. « GlobalFoundries veut produire la Thyristor RAM »).

Le Thyristor est un composant qui laisse passer le courant lorsqu’un courant positif traverse sa « gâchette ». Il cesse par contre de laisser passer le courant lorsque le courant passe de l’anode à la cathode et qu’il est supérieur à sa tension de seuil. Bref, son fonctionnement repose sur le principe de résistance négative, un phénomène où un accroissement du courant entraîne une baisse de la tension. Après la faillite de Silicon Innovation et la mort de la ZRAM, trop chère à fabriquer, la TRAM semble être la meilleure alternative à la SRAM.

WiGig

Le WiGig est un réseau Wi-Fi haut débit destiné à remplacer les câbles des systèmes Home Cinema. Il n’est pas voué à succéder ou concurrencer le Wi-Fi ac puisqu’il a une utilisation très différente. Il utilise en fait des bandes de 60 GHz ce qui permet un très haut débit théorique (7 Gbit/s), mais d’une très courte portée (10 mètres environ).

L’an dernier le Wireless Gigabit Alliance, qui a défini le WiGig, a rejoint la Wi-Fi Alliance. Concrètement, cela signifie qu’elle est donc officiellement reconnue comme étant le standard 802.11ad et que les membres de la Wi-Fi Alliance pourront plus facilement fabriquer des produits et puces compatibles. Auparavant, la Wireless Gigabit Alliance était devenue membre de l’HDMI Licensing pour envoyer des flux HDMI et gérer le HDCP 2.0. Le standard est soutenu par de plus en plus d’acteurs du marché de l’électronique grand public. Il a fait une petite apparition au CES 2014 où l’on pouvait voir une installation WiGig jouer un film en 4K. L’adoption devrait néanmoins être lente.

Les derniers articles