Introduction

Dans Retour vers le Futur 2, Robert Zemeckis peint un monde futuriste avec des planches à roulettes volantes, des chaussures qui se bouclent toutes seules et des voitures qui fonctionnent aux déchets domestiques. Peu de gens se souviennent néanmoins que cette réalité est censée arriver dans trois ans, le 21 octobre 2015 pour être précis. Le monde d’aujourd’hui tel qu’on l’imaginait avant est très différent, principalement parce que les révolutions technologiques qui ont transformé notre monde depuis la sortie du film en 1989 ne sont pas celles que nous attendions. La génération née dans les années 2000 n’aura pas connu un monde sans Internet, elle commence à remplacer les clients mails par Facebook et elle joue, tweet, lit ses livres, écoute sa musique et voit ses films sur des terminaux qui servent en principe à téléphoner et qui rentrent dans une poche.

Cet article marche donc sur le sentier miné de l’imagination et même si nous passons en revue dix technologies attendues dans le futur, nous reconnaissons d’entrée de jeu que les révolutions de demain ne sont probablement pas là où nous les attendons. Néanmoins, munis des informations que nous avons aujourd’hui, des avancées scientifiques et de notre imagination, nous allons tenter de jeter un coup d’oeil sur le monde hypothétique du futur.

La sélection présentée aujourd’hui est un cocktail composé de technologies très prometteuses, comme le transistor en graphène et de recherches au point mort, comme la Claytronics. On trouve des sujets très courants pour nos lecteurs, à l’instar de la MRAM et d’autres que nous n’avons jamais traité, comme l’invisibilité. Il y a des concepts qui n’agitent pas les foules, comme le Wi-Fi ac et des ordinateurs quantiques qui laissent rêveurs. Bref, nous avons tenu à mélanger le familier et l’inconnu, le fou et le normal.

Enfin, l’exercice que nous nous apprêtons à entreprendre est aussi très arbitraire. La liste des technologies choisies demande que l’on sacrifie des sujets pertinents sur l’autel du pragmatisme. Nous ne parlerons pas de projections holographiques, d’interfaces répondants aux mouvements de l’utilisateur, des systèmes de détection des visages et tous ces autres sujets qui auraient mérité une place dans ce tour d’horizon. Il fallait s’arrêter quelque part. Nous avons choisi le chiffre dix et une liste éclectique qui vise à être plus surprenante que populaire. Néanmoins, si vous avez d’autres technologies en tête ou si un deuxième volet vous intéresse, faites-le-nous savoir. Il y a de la place pour une trilogie.

OLED flexibles

Nous vous parlons des écrans OLED flexibles depuis 2007 (cf. « LG.Philips présente un écran AMOLED couleur et flexible »). À l’époque, un écran 4 pouces était limité à une définition de 320 x 240. La flexibilité était très faible et les prototypes étaient tenus hors de portée des spectateurs. Cette technologie a commencé à être prise au sérieux en 2009, lorsque des laboratoires ont commencé à montrer des modèles plus aboutis, plus grands et plus souples.

Parmi les écrans en démonstration cette année-là, nous retiendrons principalement la dalle 5,8 pouces de NHK (cf. « Un ecran OLED flexible abouti chez NHK ») et le modèle 6,5 pouces de Samsung (cf. « Samsung aussi a son OLED flexible »). Les fabricants ont toujours beaucoup travaillé sur les matériaux à utiliser dans ce genre de dalle. Jusqu’à ce moment là, ils faisaient appel à un substrat en verre. Des scientifiques avaient aussi essayé du caoutchouc, mais les résultats étaient peu convaincants pour l’époque (cf. « Un écran OLED caoutchouc »).

Vers du plastique et une couche organique en PXX

Vers du plastique et une couche organique en PXX

2010 fut néanmoins une année charnière. Après que des chercheurs américains ont posé du plastique sur un substrat en verre, afin d’améliorer la flexibilité de l’ensemble (cf. « Un OLED flexible prêt à la commercialisation ? »), Samsung et TDK ont complètement abandonné le verre pour du plastique. Cette idée n’était pas nouvelle néanmoins puisque des chercheurs avaient prouvé que cela était possible en 1992 lorsqu’ils ont remplacé le substrat en verre par un modèle en polyéthylène téréphtalate (un polyester saturé) et publiés leurs résultats dans la revue Nature.

Le modèle de TDK utilisait une résine plastique intéressante de 0,3 mm d’épaisseur (cf. « Votre écran OLED, flexible ou transparent ? »). Celui de Samsung faisait néanmoins appel à un plastique souple plus convaincant. En effet, pour la première fois, on pouvait voir un écran OLED flexible de 4,5 pouces d’une définition SVGA (800 x 600) disposant d’un rayon de courbure de 1 cm. Quelques mois auparavant, Sony avait aussi marqué les esprits en présentant un OLED flexible disposant d’un rayon de courbure de seulement 4 mm. Concrètement, cela signifie que l’écran pouvait être enroulé autour d’un crayon à papier. Le Japonais a ainsi révélé avoir utilisé une nouvelle couche organique à base de «p»-Xanthénoxanthène. Abrégé PXX, il s’agit d’un composé organique semi-conducteur. Pour mémoire, les écrans OLED n’utilisent pas un système de rétroéclairage, mais une couche organique qui, lorsqu’elle est excitée par un courant électrique, va s’éclairer.

Des écrans de smartphones résistant mieux aux chocs d’ici quelques années

Des écrans de smartphones résistant mieux aux chocs d’ici quelques années

Au CES 2011, Samsung n’a pas cherché à montrer un écran d’une plus grande définition ou d’une taille supérieure. Il a simplement vanté la résistance du système. Les écrans OLED flexibles ne permettront pas de tordre le téléphone comme on le désire, principalement parce que les autres composants, comme le processeur, la mémoire ou le châssis, ne tolèrent pas ce genre de manipulation. D’ailleurs, tous les écrans OLED flexibles demandent des composants situés à l’extérieur de la dalle, parce que ces puces ne sont pas aussi souples que le reste. S’il n’est donc pas question d’enrouler sont smartphones autour d’un crayon, une dalle en plastique flexible apporte une plus grande résistance au choc, ce qui est un avantage important pour ce genre de produit. À titre anecdotique, 2011 fut la première fois qu’un constructeur frappait son écran OLED flexible avec un marteau pour faire ressortir ses qualités (cf. « Écran AMOLED flexible chez Samsung »).

Fin 2011, le constructeur créa aussi la surprise en annonçant la commercialisation d’un écran OLED flexible dans un téléphone début 2012. Jamais un fabricant n’avait avancé une date de commercialisation aussi précise. Nous sommes tout de même sceptiques par rapport à cette prévision, principalement parce que nous n’avons vu aucun signe de production de masse. Aucun exemplaire de test n’est disponible et les prototypes montrés jusqu’à présent restent encore précaires (cf. « Un smartphone à écran OLED flexible en 2012 ? »). Les méthodes de fabrication sont loin d’être évidentes et demandent souvent d’apposer la couche organique sur le substrat à l’aide d’un processus similaire à celui d’une impression à jet d’encre. De plus, les distorsions continuent d’avoir un impact important sur la durée de vie de l’appareil. Nous serions néanmoins heureux de voir une démonstration d’un smartphone disposant d’un OLED flexible et une annonce officielle plus précise lors du Mobile World Congress qui se tiendra à la fin du mois.

ReRAM et MRAM

ReRAM : les memristors ont-ils une place dans ce monde ?

ReRAM : les memristors ont-ils une place dans ce monde ?

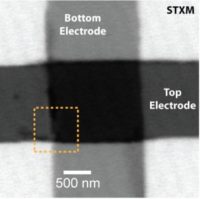

Qu’en est-il des autres technologies dont nous vous parlions en 2006 et qui étaient censées remplacer la NAND et la DRAM ? Parmi tous les candidats, deux sortent du lot, la ReRAM (Resistive Random Access Memory, aussi appellée RRAM) et la MRAM (Magnetoresistant Random Access Memory). La première a récemment fait l’objet d’une actualité lorsque Elpida a annoncé sa commercialisation en 2013. Pour rappel, il s’agit d’une mémoire qui exploite la variation de la résistance électrique d’un matériau selon la tension qu’on lui applique. Les premières cellules utilisaient un oxyde de nickel et titane (cf. « Fujitsu améliore sa ReRAM, la mémoire du futur ? »). Néanmoins, en 2008, HP a frappé un grand coup en prouvant l’existence des memristors, le quatrième composant électrique passif (après les condensateurs, les résistances et les bobines) qui n’était qu’une théorie formulée en 1971 par le professeur Leon Chua.

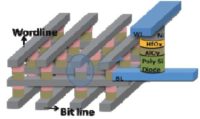

Très schématiquement, un memristor, qui utilise un oxyde de titane, est un croisement entre une mémoire et une résistance. Il est capable de changer de résistance en fonction de la tension appliquée et les chercheurs commencent tout juste à comprendre son fonctionnement (cf. « HP pense vendre des memristors en 2013 »). Il est aussi capable d’accomplir des calculs booléens, mais pour l’instant, il est principalement destiné aux ReRAM (cf. « Une nouvelle propriété des memristors »). Le problème est que la production en masse de puces combinant des millions de memristors semble encore loin. Certains n’hésitent donc pas à chercher ailleurs. C’est le cas de Globalfoundries qui a montré une ReRAM utilisant une couche de nickel, un oxyde de hafnium, un oxyde d’aluminium et une électrode en polysilicium (cf. « Une nouvelle ReRAM par Globalfoundries »). Le problème, encore une fois, est qu’à l’heure actuelle, même si les fondeurs parlent de commercialisation, personne n’envisage un module de ReRAM capable de concurrencer un modèle similaire en NAND ou DRAM. Les performances, la capacité et les rendements ne sont pas encore au rendez-vous.

La MRAM ou STT-MRAM :: des promesses pas encore tenues

La MRAM ou STT-MRAM :: des promesses pas encore tenues

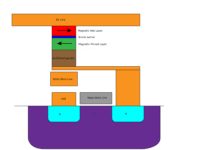

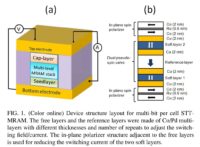

Le salut pourrait venir de la MRAM, qui utilise le mouvement angulaire des électrons (leur spin) qui va déterminer la polarité de la cellule et par voie de conséquence, sa résistance électrique. On vous parle de la MRAM depuis 2006 (cf. « Toshiba et NEC pour la MRAM »), date à laquelle Freescale a commencé à en commercialiser (cf. « Freescale commercialise les MRAM »). Le problème est qu’elle n’a jamais eu le succès escompté. À 25 $ la puce 4 Mbit, elle était très chère et demandait beaucoup d’énergie. Certains fabricants de puces très spécialisées en ont acquis. C’est par exemple le cas de SpriteSat, fournisseur de produits pour satellite. Néanmoins, devant la faible de demande, Freescale s’est séparé de sa division MRAM pour en faire une filiale qui répond au nom d’Everspin. Les scientifiques n’ont tout de même pas dit leur dernier mot et récemment, une structure utilisant une couche de cobalt prise en sandwich entre une couche de platine et un oxyde d’aluminium a été présentée dans la revue Nature.

La recherche a aussi fait des progrès et les STT-MRAM (Spin-Transfer Torque- Magnetoresistive random access memory) pourraient être la solution. Ces mémoires reposent sur une jonction tunnel magnétique qui est une structure composée de deux éléments ferromagnétiques (un alliage de cobalt et fer chez Toshiba) séparés par une couche isolante de ruthénium. Très schématiquement, l’un des éléments ferromagnétiques est piégé, tandis que l’autre est libre. En envoyant un courant polarisé en spin, l’élément libre va adopter le spin du courant. S’il est parallèle à celui de l’élément piégé, la résistance électrique sera faible. S’il est opposé, elle sera forte. Toshiba parle d’une commercialisation d’ici 2014 (cf. « Toshiba sortirait une STT-MRAM dans 3 ans ») et son partenariat avec Hynix laisse penser que les recherches sont sur la bonne voie (cf. « Hynix et Toshiba s’unissent pour la STT-MRAM »). IBM et Samsung croient aussi en la STT-RAM, mais il faudra attendre encore quelques années avant de savoir s’il s’agit réellement d’une option viable.

Wi-Fi ac, WiGig et Super Wi-Fi

Le Wi-Fi a déjà parcouru un long chemin depuis la commercialisation des premiers terminaux 802.11a au début des années 2000 à la démocratisation de ce réseau sans fil sur les ordinateurs portables et son utilisation massive aujourd’hui dans les foyers et les entreprises. Le futur du standard passera nécessairement par le 802.11 ac ; les premières puces compatibles ont été présentées par Broadcom au CES 2012 (cf. « Broadcom adopte le WiFi 802.11ac : plus de 1 Gbit/s ! »). Si les débits théoriques sont censés atteindre les 3,6 Gbit/s, les composants d’aujourd’hui se limitent à 1,3 Gb/s. Les caractéristiques du standard ne devraient pas être finalisées avant fin décembre, mais on pourra voir des modules au sein d’ordinateurs et routeurs très prochainement (cf. « Le 802.11ac chez Apple en 2012 »).

Très schématiquement, le 802.11ac est une extension du Wi-Fi n. Le standard 802.11n prévoyait l’utilisation maximum de 4 antennes MIMO (Multiplie Input Multiple Output), le prochain format en comptera 8. Le Wi-Fi n utilise des canaux d’une largeur de 40 MHz. Le Wi-Fi ac fera appel à une largeur de 80 MHz et proposera un mode 160 MHz en option. Au final, les transmissions seront plus larges et il sera possible de traiter plus de données à la fois. L’encodage a aussi été optimisé. Concrètement, on utilisera une modulation de 256 QAM identique à la télévision par câble. Enfin, le Wi-Fi ac sera limité à du 5 GHz. Pour mémoire, la version n est compatible 2,4 GHz et 5 GHz.

Le WiGig pour remplacer les câbles du salon

Le WiGig pour remplacer les câbles du salon

Le Wi-Fi est un succès et les grands noms de l’industrie ont décidé de s’en inspirer pour créer un réseau destiné à remplacer les câbles des systèmes home cinema. Le WiGig (ou 802.11ad) est développé par la Wireless Gigabit Alliance qui en parle officiellement depuis 2009 (cf. « Un nouveau réseau pour le streaming sans fil »). La version 1.0 du standard fut publiée en mai 2010 et une mise à jour 1.1 parut en juin 2011 qui est la plus récente.

Le WiGig est rétrocompatible avec le Wi-Fi n. Il gère des bandes de fréquences de 2,4 GHz et 5 GHz, mais il a la grande particularité de pouvoir aussi travailler sur du 60 GHz, ce qui lui permet d’atteindre des débits théoriques de 7 Gbit/s. L’utilisation d’une telle bande de fréquence limite grandement la portée qui serait de 10 mètres environ. Il ne vise donc pas à remplacer le Wi-Fi mais simplement à connecter les différents terminaux d’un home cinema. En juin 2011, l’alliance est devenue membre de l’HDMI Licensing pour pouvoir envoyer des flux HDMI en plus des flux DisplayPort qu’il pouvait déjà retransmettre. La norme gère aussi le HDCP 2.0. Comparativement au Wireless HDMI ou WiDi d’Intel, le WiGig a une ambition plus large. Il peut transporter toutes sortes de données et pourrait aussi connecter des enceintes, une box Internet et d’autres terminaux ensemble.

Il ne reste plus qu’à faire du WiGig un standard intégré à tous les produits du salon. Le fait que le consortium soit composé de géants comme Nokia, Microsoft, LG, Dell, Samsung, Marvell, NEC, Intel et Broadcom entre autres, est un bon signe, mais il faudra attendre encore quelques années avant que la technologie soit intégrée par défaut dans les équipements multimédias grand public. Or, les chercheurs ne se reposent pas sur leurs lauriers et le consortium pourrait se voir concurrencer par un réseau japonais capable d’offrir un débit théorique de 30 Gbit/s. Fonctionnant sur une bande de fréquence de 3 THz, il tente aussi de remplacer les câbles du salon (cf. « Un réseau sans fil à 30 Gb/s ») et s’il est encore réservé aux laboratoires, il laisse entrevoir ce que le futur nous réserve.

Le Super Wi-Fi pour offrir Internet de partout

Le Super Wi-Fi pour offrir Internet de partout

On entend aussi beaucoup parler du Super Wi-Fi et il est important de préciser que ce réseau n’est pas l’oeuvre de la Wi-Fi Alliance et n’utilise pas les mêmes bandes de fréquences. Destiné aux fournisseurs d’accès à Internet, il fait appel à des bandes de fréquences comprises entre celles utilisées par les chaînes de télévision et le 2,4 GHz. Les États-Unis comptent mettre ces bandes de fréquences à disposition des opérateurs gratuitement. Elles permettraient de propager le signal plus loin et mieux traverser les murs que le WiMAX. Pour l’instant, seuls quelques tests ont eu lieu en Amérique du Nord et seuls deux réseaux ont été déployés, le premier dans l’est de Houston, au Texas et le second en Caroline du Nord. Bref, malgré l’utilisation très contestée du terme Wi-Fi, il s’agit d’une technologie très différente.

Après le transistor en silicium

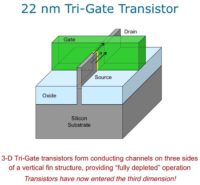

Les FinFET témoignent aussi des limites des transistors classiques. La simple miniaturisation des structures actuelles ne suffit plus. Les scientifiques en parlent depuis des années mais la recherche sur les transistors en 3D est une solution parfois décriée, car elle complexifie la fabrication des puces. C’est pourtant aujourd’hui la plus simple et la plus pratique à mettre en place. Il faut aussi tempérer le ton parfois alarmiste de certains experts. Le silicium a encore de beaux jours devant lui et les chercheurs arrivent à réaliser des prouesses fascinantes (cf. « Le plus petit transistor au monde »).

L’indium antimoine et le graphène : les deux solutions privilégiées

L’indium antimoine et le graphène : les deux solutions privilégiées

Néanmoins, de nombreux travaux visent à remplacer le silicium. En 2005, Intel annonçait travailler sur des transistors en indium antimoine (cf. « Intel annonce la fin des transistors en silicium ? »), après avoir lancé un partenariat avec Qinetiq (cf. « Intel crée un transistor consommant dix fois moins »). Si aucune application commerciale n’a encore vu le jour, et même si le fondeur n’en parle pas beaucoup, cette idée est loin d’être morte. En 2010, un directeur technologique de la société a affirmé qu’un transistor en indium-antimoine pourrait voir le jour en 2015. La firme étudie néanmoins d’autres options et elle n’est pas la seule.

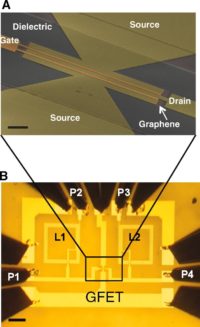

Le graphène est probablement le matériau le plus prometteur aujourd’hui. Pour rappel, il s’agit d’une couche d’atomes de carbones adoptant une structure en nid d’abeille qui possède des propriétés électriques excellentes. Les premières démonstrations datent de 2006, mais elles étaient loin d’être concluantes. En 2008, les scientifiques ont montré qu’il était possible de modifier sa constitution pour offrir un rapport on-off supérieur aux modestes résultats obtenus jusqu’alors (cf. « Le transistor en carbone démontré »). C’est une caractéristique importante pour pouvoir facilement distinguer les deux états et réduire la consommation de la puce. Les chercheurs continuent d’optimiser la structure de ces composants et certains penchent aujourd’hui pour une architecture à trois couches (cf. « Les transistors en graphène se rapprochent »). Enfin l’an dernier, IBM a aussi franchi une étape importante en montrant pour la première fois une puce de 10 GHz regroupant plusieurs éléments en graphène sur un même die (cf. « Avancée majeure : IBM signe le premier die en graphène »). Il reste encore un long chemin à faire avant leur commercialisation, mais elle est aujourd’hui envisageable.

Le nanotube et les autres matériaux

Le nanotube et les autres matériaux

Le nanotube de carbone, qui est en fait une feuille de graphènes enroulée, offre aussi des possibilités intéressantes (cf. « Un nanotube de carbone comme transistor »). Utilisé avant tout comme canal entre la source et le drain, il pourrait venir au secours du silicium lorsque ce-dernier atteindra ses limites physiques (cf. « Un transistor de 9 nm en nanotube de carbone »). Les transistors en nanotubes de carbone furent démontrés en 2009, mais souffrent encore beaucoup de problèmes de fiabilité. Ils ont la fâcheuse tendance de se dégrader très rapidement et tolèrent mal les champs électriques importants. De plus, ils sont complexes à fabriquer et chers.

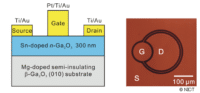

En attendant, les chercheurs étudient d’autres solutions dont, entre autres, un transistor en oxyde de gallium, en molybdénite, en fluor, en plastique et même en diamant. Chaque solution essaie de trouver une parade aux limites du silicium qui reste indétrônable. C’est d’ailleurs le paradoxe de notre temps. Les chercheurs multiplient les efforts pour le remplacer et les industriels ne peuvent pas vivre sans, principalement parce qu’il est très bon marché et que tous leurs équipements dépendent de ce matériau. Bref, tant qu’il sera moins cher et plus facile à utiliser que les autres alternatives, il continuera d’être le matériau privilégié des industriels et les fondeurs continueront de trouver des parades à ses limites.

High-tech transparente

Des composants transparents

Nous sommes loin de pouvoir produire un objet complexe transparent, tel un smartphone, principalement parce que les composants dont il a besoin ne sont pas encore prêts, mais la recherche avance. La TRRAM est une mémoire transparente non volatile qui est fabriquée à l’aide de couches d’oxyde de métaux transparents empilées les unes sur les autres (cf. « Des mémoires transparentes pour téléphones portables »). Il est bon de rappeler que les innovations dans le domaine des semi-conducteurs passent presque toujours par les mémoires qui sont des structures simples permettant de maîtriser une technologie pour l’utiliser ensuite dans des puces plus complexes. Le dernier exemple en date est le transistor en 3D d’Intel qui a d’abord été démontré dans des SRAM en 2006 et qui sera commercialisé cette année dans les processeurs de la société.

Des chercheurs de Stanford ont aussi montré une batterie transparente utilisant du polydiméthylsiloxane (PDMS), un polymère dans lequel sont gravées des électrodes de 35 µm de large invisibles à l’oeil nu et qui baignent dans un électrolyte transparent. (cf. « Et voici la batterie Li-ion transparente »). Enfin, les recherches avancent pour mieux comprendre le comportement des oxydes transparents semiconducteurs afin d’optimiser leur conductivité. Ces avancées rapprochent les marchés des concepts similaires au Morph de Nokia.

Des écrans transparents

Des écrans transparents

Le premier produit transparent qui devrait devenir une réalité commerciale devrait être l’écran. Il y a un mois, Samsung présentait son SmartWindows, une dalle LCD transparente tactile de 46 pouces destinée à des fins publicitaires et marketing. On vous parle de ce genre de technologie depuis 2006 (cf. « Un écran OLED transparent ? ») et avec les années, les chercheurs mettent au point de nouvelles structures, comme cet écran flexible et transparent utilisant des nanotubes de carbone (cf. « Un écran TFT flexible et transparent »). Pour pouvoir sortir ce genre de produit en masse, ils travaillent sur des matériaux transparents plus résistants capables de subir les processus de fabrication actuels qui imposent des contraintes très difficiles (cf. « Un film transparent qui chauffe à 260 ºC »).

Néanmoins, rien ne témoigne aussi bien de l’évolution de cette technologie que l’augmentation de la définition et de la diagonale. En 2010, les écrans présentés dans les salons variaient entre 2,4 pouces (cf. « Un écran multitouch transparent ») et 19 pouces (cf. « Un écran OLED de 19 pouces transparent ») en passant par des ordinateurs portables de 14 pouces (cf. « Un écran transparent en démonstration ») et des smartphones (cf. « Votre écran OLED, flexible ou transparent ? »). Le fait que cette technologie intègre des produits finis au lieu de se limiter à une dalle exposée dans une vitrine est aussi encourageant.

Les composants qui assurent le fonctionnement de ces dalles sont placés sur les côtés ou en dessous du système pour ne pas rompre l’effet de transparence. En effet, si les fabricants savent facilement fabriquer des dalles LCD transparentes (celles de nos écrans le sont déjà), un écran a besoin de beaucoup d’autres composants qui sont aujourd’hui opaques. Enfin, on peut se poser la question de l’utilité d’un tel système. Voir au travers d’un téléphone ou une tablette ne semble pas toujours une si bonne idée et pourrait se révéler être une distraction néfaste lors de son utilisation. Bref, la recherche avance, mais jusqu’à maintenant, les démonstrations sont limitées à quelques marchés de niche.

L’invisibilité

L’invisibilité est aussi un sujet qui passionne les chercheurs et dont nous ne parlons jamais. Nous avons donc décidé de procéder à un tour d’horizon rapide, principalement parce qu’une étape importante a été franchie il y a quelques semaines, lorsque des scientifiques américains ont montré pour la première fois qu’il était possible de rendre un objet 3D immobile invisible à certaines fréquences.

Les métamatériaux

Jusqu’à présent, la recherche dans ce domaine s’est principalement concentrée sur les métamatériaux. Il s’agit de matériaux composites artificiels disposant de propriétés que l’on ne trouve pas dans la nature. Nos collègues de Tom’s Style rapportaient les études américaines sur des métamatériaux capables d’absorber, réfléchir ou déformer la lumière autour d’un objet (cf. « La première cape d’invisibilité est enfin créée »). La structure était composée d’une matrice de résonateurs en or modifiant les propriétés de la soie qui servait de support.

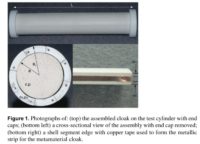

Cette technologie a fait ses débuts publiquement en 2006 lorsque des universitaires de Duke ont créé un métamétériau capable de rendre une partie d’un tube en cuivre invisible aux spectres des micro-ondes. Pour la première fois, les scientifiques prouvaient qu’il était possible de manipuler des ondes électromagnétiques afin de cacher un objet à certaines fréquences. Leurs résultats ont été publiés dans la revue Science et jusqu’à présent, les recherches étaient principalement concentrées dans ce domaine. Néanmoins, les défis de cette technologie sont importants et la communauté scientifique n’est pas sûre de pouvoir l’utiliser pour rendre un objet de taille humaine invisible à l’oeil, ni s’il est possible de maintenir l’invisibilité lorsque l’objet est en mouvement.

Les alternatives

Les alternatives

Ces derniers mois, deux nouveaux projets de recherches issus de l’Université du Texas ont revitalisé ce domaine. En octobre dernier, des scientifiques ont montré qu’il était possible d’utiliser des couches de nanotubes de carbones pour atteindre l’invisibilité. La vidéo ci-dessous montre qu’en les faisant chauffer à haute température, on crée un gradient de température au sein de l’empilement des couches, qui va dévier les rayons de sorte qu’ils contournent l’objet recouvert par les nanotubes de carbone, rendant le tout invisible. Ce phénomène est très similaire à ce qui se passe lors d’un mirage. Dans le désert par exemple, le gradient de température augmente lorsque l’on se rapproche du sol et les rayons lumineux ne sont plus rectilignes, mais courbes et montants. L’image du ciel bleu apparaît alors au milieu du désert et le cerveau l’associe à une oasis. Avec les nanotubes de carbone, on ne fait pas apparaître un objet à un endroit où il n’est pas, on le fait disparaître.

Il s’agit sans aucun doute de l’illusion optique la plus élaborée, mais on doute qu’elle trouve une application commerciale. En effet, l’idée de rendre un objet invisible à l’aide d’une illusion optique n’est pas nouvelle. Néanmoins, les scientifiques ne cherchent pas de simplement cacher un objet, mais à jouer avec les rayons de la lumière pour le rendre réellement indétectable.

Informatique quantique

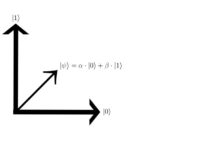

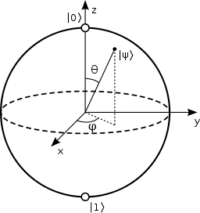

Initié par le célèbre Richard Feynman en 1982, le monde électronique quantique est vaste. Aujourd’hui, lorsque l’on parle d’informatique quantique, on désigne généralement les calculs réalisés par une puce qui travaille sur des qubits au lieu de bits classiques. Un bit est représenté par un 1 ou un 0. Il est la plus petite unité de mesure et il se manifeste généralement par l’absence ou le passage d’un courant, la présence ou l’absence d’un groupe d’électrons, l’orientation de leur polarité ou la haute ou faible résistance électrique d’une structure, etc. Il n’y a que deux états possibles, 0 ou 1. Schématiquement, les qubits (quantum bits ou bits quantiques, en français) disposent aussi d’un état 0 similaire au 0 d’un bit classique, d’un état 1, lui aussi presque identique au 1 d’un bit traditionnel et d’une superposition du 0 et 1. Pour comprendre cette idée de superposition, il faut revenir sur la définition de l’état quantique d’un qubit.

Au centre de l’informatique quantique : le qubit

Les qubits 0 et 1 sont très similaires au 0 et 1 du bit classique en ce qu’ils désignent deux états opposés. La différence réside dans leur manifestation. Tout d’abord, ils utilisent une nomenclature différente. Le 0 d’un qubit est désigné par un ket 0 et le 1 est représenté par un ket 1.

On utilise un ket pour souligner l’aspect vectoriel de l’état dont on parle et distinguer ainsi le bit classique figé du qubit en mouvement. En effet, les états quantiques reposent presque toujours sur les mouvements de photons, d’électrons ou de noyaux atomiques, par exemple. Bref, on peut très schématiquement représenter l’état quantique d’un qubit par une représentation vectorielle. Ainsi, si l’on représente grossièrement ket 0 par un vecteur horizontal allant vers l’est et ket 1 par un vecteur vertical se dirigeant vers le nord, la superposition des deux états

(ket Ψ, que l’on prononce ket psi) sera une trajectoire vectorielle entre ket 0 et ket 1 tel que ket psi = alpha.ket0+beta.ket1.

On comprend ainsi que le mot superposition ne désigne pas la présence concomitante d’un bit 0 et 1, comme on pourrait le penser en s’arrêtant à la définition classique du mot, mais une combinaison linéaire dont le résultat est nécessairement 1.

De la grande complexité du monde électronique quantique

De la grande complexité du monde électronique quantique

En 2007, D-Wave a créé la surprise en présentant Orion, le premier processeur utilisant 16 qubits. (cf. « D-Wave présente son processeur quantique »). C’est le premier ordinateur quantique commercialisé. Après des années de recherches et une intervention de la NASA pour rassurer les sceptiques (cf. « La NASA vient au secours du calculateur quantique »), l’Université de la Californie du Sud en a récemment mis un en service (cf. « D Wave One : Le 1er ordinateur quantique mis en service »). La machine est un premier pas dans le monde de l’informatique quantique. Elle demande des températures extrêmement basses pour fonctionner et ses puissances de calculs sont encore très limitées. Néanmoins, les chercheurs espèrent dompter ce Nouveau Monde pour pouvoir tirer parti de la grande puissance de calcul qui réside dans ce système.

Nous tenons aussi à préciser que le monde de l’électronique quantique ne se limite pas aux processeurs. On parle de plus en plus des diodes laser à boîte quantique qui utilisent un ensemble de quasi-particules emprisonné dans un nanocristal pour amplifier la lumière. (cf. « Des points quantiques rendent la fibre optique obsolète »). Il y a aussi les mémoires optiques quantiques qui jouent avec les photons pour offrir un système sécurisé (cf. « Mémoire optique quantique ») et des batteries qui reposent sur les effets quantiques pour accroître leur autonomie (cf. « Une batterie quantique »). Bref, les chercheurs continuent de s’inspirer des principes qui régissent la physique quantique pour transformer notre monde électronique, pas à pas.

Claytronics

Intel et l’Universtié Carnegie Mellon travaillent depuis le début des années 2000 sur la Claytronics, aussi nommée matière programmable, qui est destinée à être l’argile (clay en anglais) électronique de demain. Le concept est de pouvoir créer des formes reprogrammables à volonté. Les recherches semblent avoir atteint un point mort. Le dernier papier publié date de 2009, mais son absence dans nos colonnes et le potentiel de cette technologie, comme le montre la vidéo ci-dessous, nous a poussés à en parler succinctement aujourd’hui.

Les catoms

Les catoms

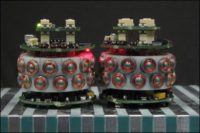

Très schématiquement, tout comme le monde repose sur les atomes, la Claytronics repose sur les catoms ou Claytronics Atoms qui sont en fait des nano-ordinateurs qui vont être assemblés les uns aux autres à l’aide des forces électrostatiques. Ils sont représentés par des petites boules de plombs dans le reportage ci-dessous. Concrètement, ces structures doivent pouvoir recevoir un signal, le traiter, exécuter une commande en prenant une position particulière et coopérer avec les autres catoms pour créer la forme désirée.

Les chercheurs ne semblent pas encore capables de produire des nano-catoms. Ils se limitent donc aujourd’hui à des simulations bien plus grandes. Ils travaillent principalement avec cinq types de catoms. Les catoms plats sont des concepts destinés à tester les forces en jeu et l’électronique. Les catoms électrostatiques sont les plus courants. Ils utilisent les forces électrostatiques pour regrouper et diviser un groupe de catoms et créer des formes très primitives. Les chercheurs utilisent aussi des catoms en forme de ballon remplis d’hélium et des catoms en forme de cubes lors des simulations. Enfin, le dernier type de catom est le stochastique qui fait appel à des mouvements aléatoires pour former des motifs prédéfinis.

Meld et LDP : deux langages de programmation pour la Claytronics

Si la conception des catoms est un énorme défi en soi, l’autre grand obstacle est la conception d’algorithmes et d’un langage de programmation capable d’envoyer les formes 3D désirées et contrôler ce groupement massif d’ordinateurs. Le programme de recherche Claytronics de Carnegie Mellon et Intel se concentre donc aussi sur le développement d’outils logiciels capables de gérer ce réseau. Les scientifiques se sont inspirés en partie d’Internet qui est probablement le modèle qui se rapproche le plus aujourd’hui de ce qu’ils recherchent. Les catoms n’ont pas d’adresses uniques, de positions fixes et ne communiquent pas à l’aide d’un réseau câblé, comme les ordinateurs sur la Toile, mais les chercheurs essaient de reproduire des noeuds capables de contrôler la propagation de l’information et les mouvements de ces structures.

Cette quête pour un langage de programmation est d’autant plus difficile que les modèles actuels, tels que le C++ ou le Java, sont inadéquats. Ils demandent des instructions longues et des machines relativement indépendantes du réseau avec des positions et adresses précises et l’intervention de l’utilisateur. Or, pour un réseau de catoms, les scientifiques cherchent des syntaxes abrégées plus faciles à gérer par des machines complètement dépendantes du réseau qui est constitué de liens souvent instables en raison des mouvements incessants.

Les universitaires ont donc développé deux nouveaux langages de programmation, Meld et LDP (Locally Distributed Predicates ou attributs distribués localement, en français). Le premier utilise un paradigme de programmation déclaratif, c’est-à-dire que les composants sont indépendants du contexte. Appeler un composant avec les mêmes arguments produit le même résultat quel que soit le moment où il est appelé. Le HTML est un exemple de langage déclaratif, car on décrit ce que contient la page qui sera toujours identique. On ne décrit pas comment l’afficher, contrairement aux langages impératifs comme le C. En l’espèce, un code sous Meld a une perspective globale et permet de contrôler l’ensemble du réseau au lieu d’avoir à écrire une commande pour chaque catom. LDP est un paradigme réactif tourné vers le flot d’information. Il a la particularité d’analyser les catoms et leur place dans le réseau ainsi que leur comportement. Il travaille sur un bout du réseau à la fois au lieu de l’ensemble.

Les applications d’une telle technologie sont nombreuses. On peut imaginer créer et modifier des formes à la volée selon les besoins de l’utilisateur. Le principal enjeu des chercheurs est néanmoins de transformer le monde des télécommunications en projetant une apparition physique de l’interlocuteur. Une personne à distance serait reproduite en Claytronics, afin non seulement de la voir et l’entendre, mais aussi la toucher et interagir avec elle comme si elle était présente physiquement.

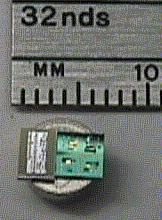

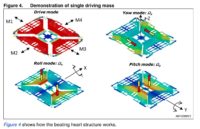

Des robots et des MEMS

Les MEMS (Micro Electro Mechanical Systems) sont un sujet d’actualité de plus en plus récurent, principalement parce que ces structures microscopiques continuent à transformer nos appareils électroniques (cf. « Le 1er gyroscope dual core au monde ») et notre société (cf. « mChip, un MEMS qui sauve des vies au Rwanda »). Dans notre dossier consacré aux MEMS (cf. « MEMS : le monde microscopique de votre smartphone »), nous avons volontairement passé sous silence les applications robotiques, principalement par souci de concision et pour nous concentrer sur les applications grand public. Un dossier sur les technologies du futur permet néanmoins de revenir brièvement sur cette thématique.

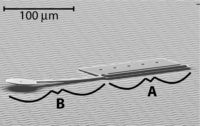

Des robots MEMS

Lorsque l’on parle de MEMS et de robotique, on pense le plus souvent à des robots microscopiques destinés à des applications médicales et ce n’est pas faux. Depuis des années, les chercheurs tentent de fabriquer des robots sans fil, contrôlables à distance, de l’ordre du micromètre. Les MEMS, qui reposent sur un fonctionnement mécanique, sont des candidates idéaux pour ce genre d’application. En effet, de très nombreux défis physiques et technologiques rencontrés dans la fabrication de gyroscopes ou actionneurs se retrouvent dans les robots microscopiques (cf. « Complexité des MEMS »).

Les prototypes en démonstration aujourd’hui sont encore très primaires et nous sommes encore très loin des films de science-fiction de type Transformers. La première vidéo ci-dessous montre un micro-robot de 60 µm x 250 µm x 10 µm capable de faire tourner un bras et d’être contrôlé à distance. Ce prototype est issu de l’Université de Dartmouth aux États-Unis qui a réalisée une valse des robots MEMS sur la musique du beau Danube bleu de Johann Strauss.

Motes et poussières intelligentes

Motes et poussières intelligentes

Si ces robots sont encore très loin d’avoir une application concrète, les motes (que l’on pourrait traduire par « grain » en français) sont beaucoup plus proches de nous. Ces structures microscopiques pourraient être assimilées à un MEMS indépendant qui regroupe la partie mécanique, l’électronique, une alimentation électrique (le plus souvent un générateur piézoélectrique) et un système de communication sans fil pour recevoir et transmettre des données. On en trouve déjà dans les voitures. Ce sont des structures très simples qui permettent par exemple de contrôler la pression des pneus.

Les scientifiques travaillent aussi sur un mote nettement plus poussé et aux applications bien plus importantes, qui répond au nom de poussière intelligente (smart dust sur la vidéo ci-dessous). Ces structures sont très proches des motes d’aujourd’hui, mais elles ont pour but de capter et analyser la lumière, la température, les vibrations ou des agents chimiques et elles sont destinés à faire partie d’un énorme réseau de millions, voire milliards de poussières permettant de créer un outil d’analyse en temps réel. Développée en partenariat avec DARPA (l’agence américaine pour les projets de recherche avancée de défense) la poussière intelligente est apparue dans les premiers papiers scientifiques en 2001, mais le concept a été imaginé dans les années 1990 par le chercheur Kris Pister.

Très schématiquement, la poussière intelligente est assez unique, car elle ne demande pas une organisation précise des grains. Il suffit de les saupoudrer sur une surface pour qu’ils fonctionnent et jouent leur rôle. Sur une route, ils permettent de surveiller le trafic et envoyer des informations en temps réel sur un embouteillage ou un accident. Sur un pont, ils peuvent mesurer l’usure structurelle et sur un mur, ils peuvent reconnaître les piétons et personnaliser les publicités. L’avenir de cette technologie est encore incertain et les applications mentionnées sont pour l’instant limitées à l’imagination des chercheurs. Le futur des poussières intelligentes dépend beaucoup de la miniaturisation des composants et le développement d’outils capables de gérer ce réseau et traiter ses informations.

Des MEMS pour améliorer les machines d’aujourd’hui

Des MEMS pour améliorer les machines d’aujourd’hui

L’une des applications les plus communes aujourd’hui est l’intégration de MEMS classiques au sein des robots existants pour accroître leurs fonctionnalités et optimiser leur fonctionnement. Par exemple, des MEMS sur les doigts et les bras articulés permettent des mouvements plus précis et plus fiables. Dans le cas de membres artificiels pour patients ayant été amputés, cela permet de retrouver une sensation plus humaine. Dans le cas d’appareils électroménagers, cela se traduit par une plus grande autonomie et moins d’intervention de la part de l’utilisateur. Bref, l’idée est d’apporter plus de confort, mais dans certains cas, comme celui de la poussière intelligente, cela pourrait se traduire par une perte de sa vie privée.

Interfaces neuronales

Les interfaces neuronales sont loin d’être nouvelles, mais les recherches les ont récemment mis au goût du jour avec des avancées importantes pour les personnes à mobilités réduites. Les premiers travaux datent des années 1970, mais le grand public fut exposé à ce genre de technologies au milieu des années 90, lorsque les scientifiques ont commencé à abandonner les tests sur des animaux pour des expériences sur l’homme. Très schématiquement, on place un jeu d’électrodes sur la tête du sujet afin de réaliser un électroencéphalogramme pour lire et reconnaître l’activité cérébrale de l’utilisateur. On traduit ensuite les résultats, à l’aide d’algorithmes, sous forme de commandes qui permettent de contrôler un ordinateur.

Les interfaces neuronales pour les jeux : une technologie qui n’est pas encore assez finie pour être réellement utile

Les premiers produits destinés à être commercialisés sur le marché grand public étaient destinés au monde du jeu vidéo. Emotiv Systems présenta son Projet EPOC en 2007 à la Game Developpers Conference (cf. « Une manette contrôlée par la pensée »). Il a la particularité de pouvoir mesurer quatre états mentaux, treize pensées différentes (avancer, reculer, tourner à droite ou à gauche, par exemple). Des gyroscopes captent aussi les mouvements de la tête. On se retrouve donc avec une tête virtuelle qui imite instantanément les mouvements et sentiments du sujet. Initialement prévu pour une sortie en 2008, l’EPOC fut repoussé à 2009 (cf. « Epoc : attendre 2009 pour jouer par la pensée »). Il est depuis vendu à 299 $ sur le site du constructeur.

L’autre plateforme qui a fait beaucoup de bruit auprès du grand public est la NIA d’OCZ (Neural Impulse Actuator ou actionneur à impulsions neuronales, en français). Présentée en 2008 (cf. « OCZ scanne votre cerveau »), elle représente l’interface neuronale la plus accessible au grand public jusqu’à ce jour. Vendue à 159 $, elle ne demandait qu’un sert-tête au lieu d’un casque. Elle était aussi destinée au jeu et à un contrôle très simple de la souris. Les tests ont montré que les interfaces neuronales de l’époque en étaient clairement à leurs balbutiements et qu’elles ne remplaceraient pas la souris de si tôt, mais les résultats étaient prometteurs. (cf. « La souris par la pensée : le test »). OCZ a néanmoins décidé d’abandonner son projet qui était une vitrine technologique intéressante, mais un fiasco commercial. La firme n’en fabrique plus et a cessé toute commercialisation.

La recherche se concentre aujourd’hui sur les tétraplégiques

La recherche se concentre aujourd’hui sur les tétraplégiques

Depuis 2009, le grand public n’entend plus vraiment parler d’interfaces neuronales censées bouleverser l’expérience des joueurs. La raison principale est que les industriels ont décidé que la technologie n’était pas encore prête pour le grand public. Ils ont donc choisi de se concentrer sur les besoins des personnes à mobilité réduite. Le premier système neuronal à être apparu dans nos colonnes est le BrainGate de Cyberkinetics Neurotechnology Systems (cf. « Commandez votre PC par la pensée ») qui date de 2005. Nous avons décidé de n’en parler qu’à la fin de notre tour d’horizon, car il est sans conteste celui qui est le plus prometteur et le plus avancé. Comme le montre un reportage de 2008 de l’équipe américaine de 60 Minutes (deuxième vidéo ci-dessous), c’est le seul système qui permet de contrôler un curseur, mais aussi les mouvements d’un membre artificiel ou un fauteuil roulant. Il est aussi capable de reconnaître les lettres de l’alphabet afin de taper du texte.

En 2009, Cyberkinetics a reçu les autorisations nécessaires pour le BrainGate 2, une mise à jour de la première version qui fut installée dans le crâne de cinq patients afin de lire leur activité cérébrale avec plus de clarté. Les recherches avancent et les sujets continuent d’être surveillés. Les scientifiques publient encore des papiers relatant leurs conclusions. Le dernier en date, paru en avril 2011 dans la revue Journal of Neural Engineering, témoigne de la viabilité de la technologie 1 000 jours après la greffe des électrodes sur le cerveau des patients.

Les chercheurs imaginent déjà une interface neuronale qui permettra de faire une recherche dans Google en fonction de ses émotions ou son humeur et influencer ainsi son monde numérique à l’aide de sa pensée. Nous sommes néanmoins encore très loin de ce genre d’application. En attendant, cette technologie aide déjà les tétraplégiques à communiquer et interagir avec le monde extérieur.

Conclusion

Plusieurs constats s’offrent à nous. Tout d’abord, certaines des technologies présentées aujourd’hui sont très proches de nous et leur commercialisation semble inévitable. D’ici trois ans, nous devrions avoir des écrans OLED flexibles dans des smartphones et le Wi-Fi ac devrait devenir un standard pour les routeurs et cartes réseaux. Il est même possible que le WiGig se démocratise finalement, même si cela reste moins sûr. Leur succès est en grande partie à attribuer au fait que les coûts en recherche et développement sont relativement faibles, car il s’agit principalement d’évolutions de technologies existantes bien maîtrisées. Les OLED flexibles utilisent des processus et matériaux connus et le 802.11ac est une mise à jour du 802.11n. Le succès à court terme d’une technologie dépend du coût qu’elle implique. Cela pourrait d’ailleurs être une leçon à retenir pour le Thunderbolt qui pourrait être handicapé par sa politique tarifaire élevée.

Les ReRAM, MRAM et l’ordinateur quantique contiennent un plus grand degré d’incertitude. On peut raisonnablement s’attendre à de nombreux papiers sur ces sujets et dire qu’ils commenceront à être commercialement envisageables dans cinq ans n’est pas une prévision absurde. Il y a encore de nombreux obstacles à leur fabrication à grande échelle, tels que des processus compliqués et des structures instables et coûteuses. De plus, la ReRAM, la MRAM et l’ordinateur quantique ne dominent pas les technologies actuelles du point de vue des performances. Ces mémoires n’ont pas une capacité supérieure ou de meilleures vitesses que les NAND ou DRAM. Elles ont un énorme potentiel, mais elles ne rivalisent pas avec ce qui se fait de mieux aujourd’hui. C’est aussi le cas du D-Wave One qui est une merveilleuse vitrine technologique, mais il est aujourd’hui plus facile et pratique de commander un supercalculateur que de compter sur les qubits. Bref, on oublie souvent qu’une technologie, aussi prometteuse soit-elle, évolue dans un marché extrêmement concurrentiel qui privilégiera les performances à l’innovation. C’est ce qui explique que l’avenir des transistors à indium antimoine ou au graphène soit encore très incertain et si une sortie dans cinq ans est envisageable, le silicium sera difficilement remplacé.

Il y a enfin les technologies qui ne verront pas d’application pratique avant dix à quinze ans au mieux, comme la Claytronics ou l’invisibilité qui en sont à leur balbutiement et qui demandent des processus de fabrication qui n’ont pas encore été inventés ou qui ne sont pas encore maîtrisés. Ces idées laissent rêveurs, mais elles sont pour l’instant incapables de sortir des laboratoires, voire de l’imagination des chercheurs. Il faudra aussi prouver leur utilité, ce qui n’est pas toujours évident, à l’instar de la high tech transparente. Avoir un écran transparent est le rêve de nombreux fans de science-fiction, mais en pratique, on doute que ce soit utile, voire souhaitable.

Bref, s’il ne fallait retenir qu’une chose, se seraient probablement que le succès d’une technologie dépend de sa faisabilité, son efficacité et son utilité.