Une carte qui fait son effet, mais pas longtemps.

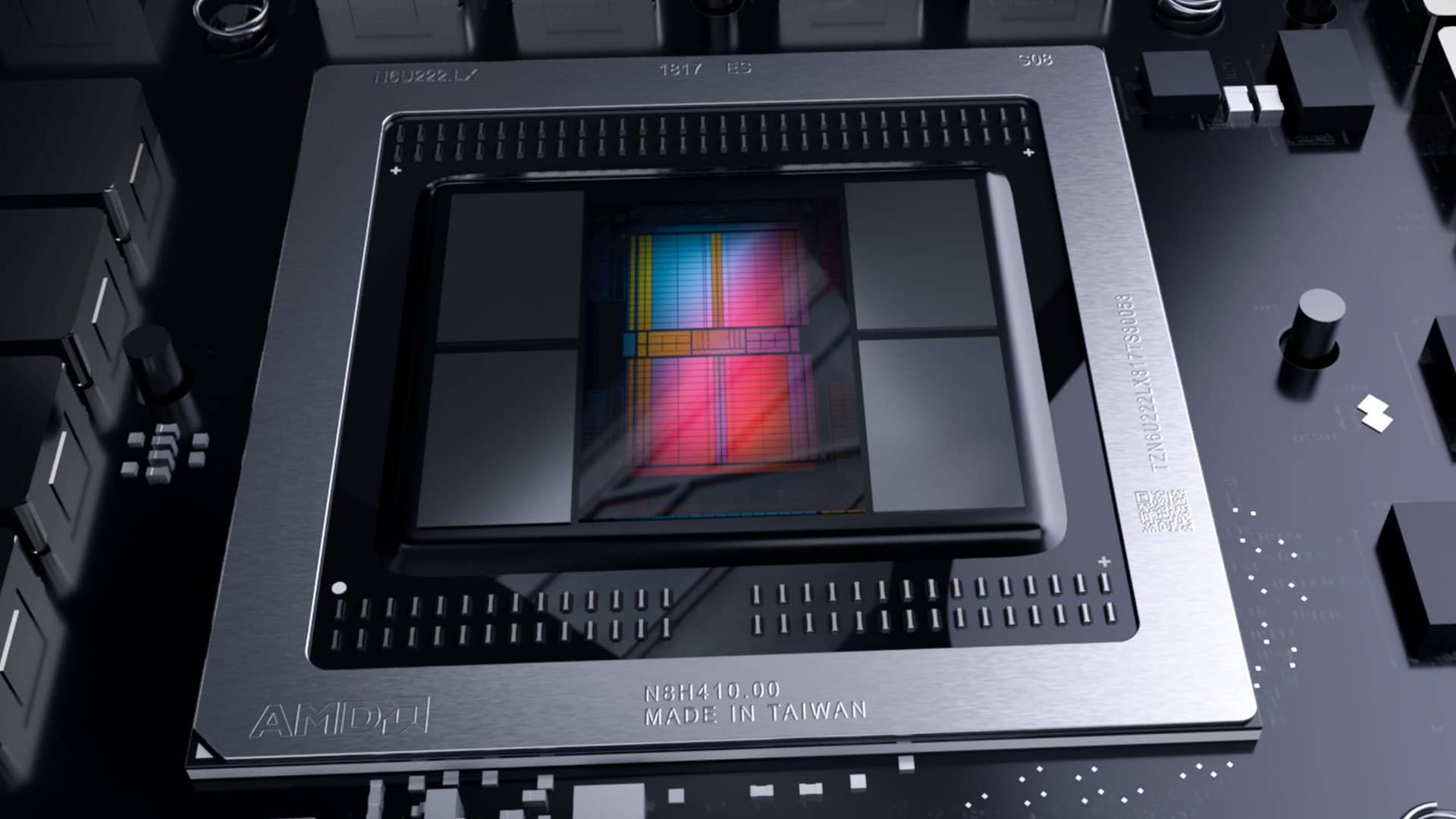

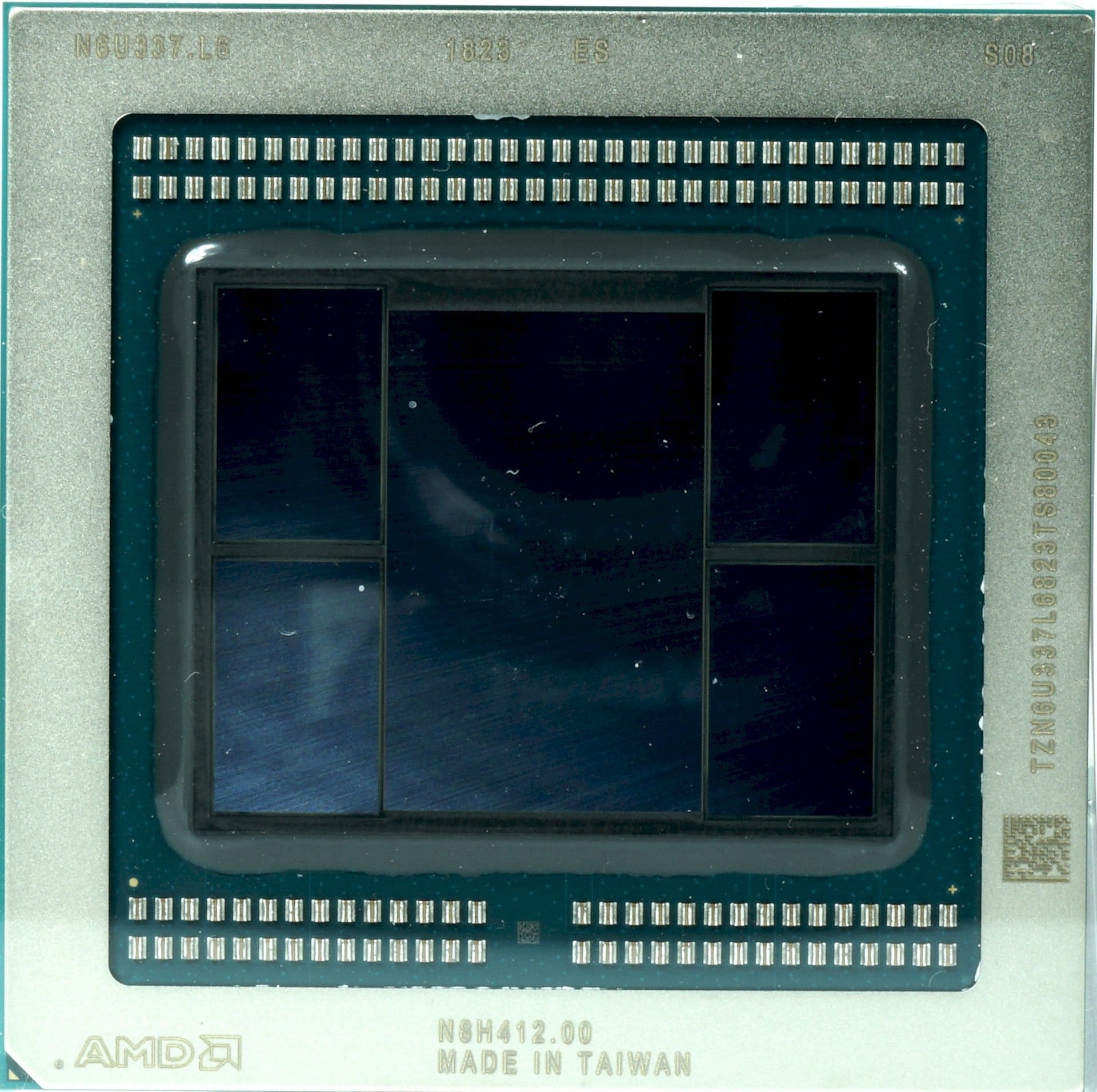

Le premier GPU gravé en 7 nm

AMD est clairement en difficulté sur le marché du GPU gaming, et NVIDIA écrase pour l’instant les performances en haut de gamme, tout en se faisant plaisir sur les prix, les joueurs exigeant le meilleur n’ayant plus vraiment le choix. Aujourd’hui, la GeForce RTX 2060 permet d’alléger la note pour le portefeuille des joueurs, mais on attend AMD pour peser sur la balance des prix. La Radeon VII, première carte graphique avec un GPU gravé en 7 nm, est annoncée comme une solution possible. Il est temps d’en avoir le coeur net.

AMD Radeon VII

733€ > AmazonCaractéristiques

La Radeon VII cible la RTX 2080 de NVIDIA. Les promesses d’AMD sont grandes, pour concurrencer le haut de gamme “modéré” de NVIDIA, pour un prix officiel de 739 euros, soit 110 euros de moins que la RTX 2080 Founders Edition. Et pour cause, sur le papier, la carte apporte presque 4 TFLOPS FP32 de plus que la 2080 FE. De quoi espérer quelque chose en pratique dans les jeux vidéo.

| Cartes | Radeon VII | GeForce RTX 2080 FE | Radeon RX Vega 64 | GeForce GTX 1080 FE |

| Architecture GPU | Vega 20 | Turing (TU104) | Vega 10 | Pascal (GP104) |

| Shaders | 3840 | 2944 | 4096 | 2560 |

| Calcul FP32 | 14,1 TFLOPS | 10,6 TFLOPS | 12,7 TFLOPS | 8,9 TFLOPS |

| Cœurs Tensor / RT | N/A | 368/46 | N/A | N/A |

| Unité de texture | 240 | 184 | 256 | 160 |

| Fréquence de base | 1400 MHz | 1515 MHz | 1247 MHz | 1607 MHz |

| Fréquence Boost | 1750 MHz | 1800 MHz | 1546 MHz | 1733 MHz |

| Capacité mémoire | 16 Go HBM2 | 8 Go GDDR6 | 8 Go HBM2 | 8 Go GDDR5X |

| Bus mémoire | 4096 bits | 256 bits | 2048 bits | 256 bits |

| Bande passante mémoire | 1 TB/s | 448 Go/s | 484 Go/s | 320 Go/s |

| ROP | 64 | 64 | 64 | 64 |

| Cache L2 | 4 Mo | 4 Mo | 4 Mo | 2 Mo |

| TDP | 300 W | 225 W | 295 W | 180 W |

| No More de transistors (milliards) | 13,2 | 13,6 | 12,5 | 7,2 |

| Surface du Die | 331 mm² | 545 mm² | 486 mm² | 314 mm² |

La carte est le corollaire de la Radeon Instinct MI50, avec quelques bridages sur le FP64 pour ne pas la concurrencer. Elle possède donc un peu moins de shaders que la Vega 64, mais fonctionne à une fréquence supérieure grâce au 7 nm, et s’arme cette fois de 16 Go de RAM HBM2 avec une bande passante record de 1 To/s.

Méthode et système de test

Le système de test et la méthodologie employée ont déjà été traités en détail. Vous pouvez tout savoir en consultant notre article sur nos nouvelles méthodes de test des cartes graphiques.

| Système | Allemagne : Intel Core i7-8700K @5 GHz MSI Z370 Gaming Pro Carbon AC 2x 8GB KFA2 HoF DDR4 4000 1x 1 To Toshiba OCZ RD400 2x 960 Go Toshiba OCZ TR150 Be Quiet Dark Power Pro 11, 850W Windows 10 Pro à jour |

|---|---|

| Refroidissement | Alphacool Eisblock XPX 5x Be Quiet! Silent Wings 3 PWM (Simulation boîtier fermé) Thermal Grizzly Kryonaut |

| Moniteur | Eizo EV3237-BK |

| Boîtier | Lian Li PC-T70 modifié (ouvert et fermé) |

| Mesures électriques | Point de mesure sans contact sur le slot PCIe, via un riser PCIe Point de mesure sans contact sur les connecteurs PCIe d’alimentation Mesure directe au niveau de l’alimentation 2x oscilloscopes Rohde & Schwarz HMO 3054 multicanaux, 500 MHz avec fonction mémoire 4x pinces ampèremétriques Rohde & Schwarz HZO50 (de 1 mA à 30 A, 100 KHz, courant continu) 4x sondes de test Rohde & Schwarz HZ355 (10:1, 500 MHz) 1x multimètre numérique Rohde & Schwarz HMC 8012, avec fonction mémoire |

| Imagerie thermique | Caméra infrarouge Optris PI640 Logiciel PI Connect |

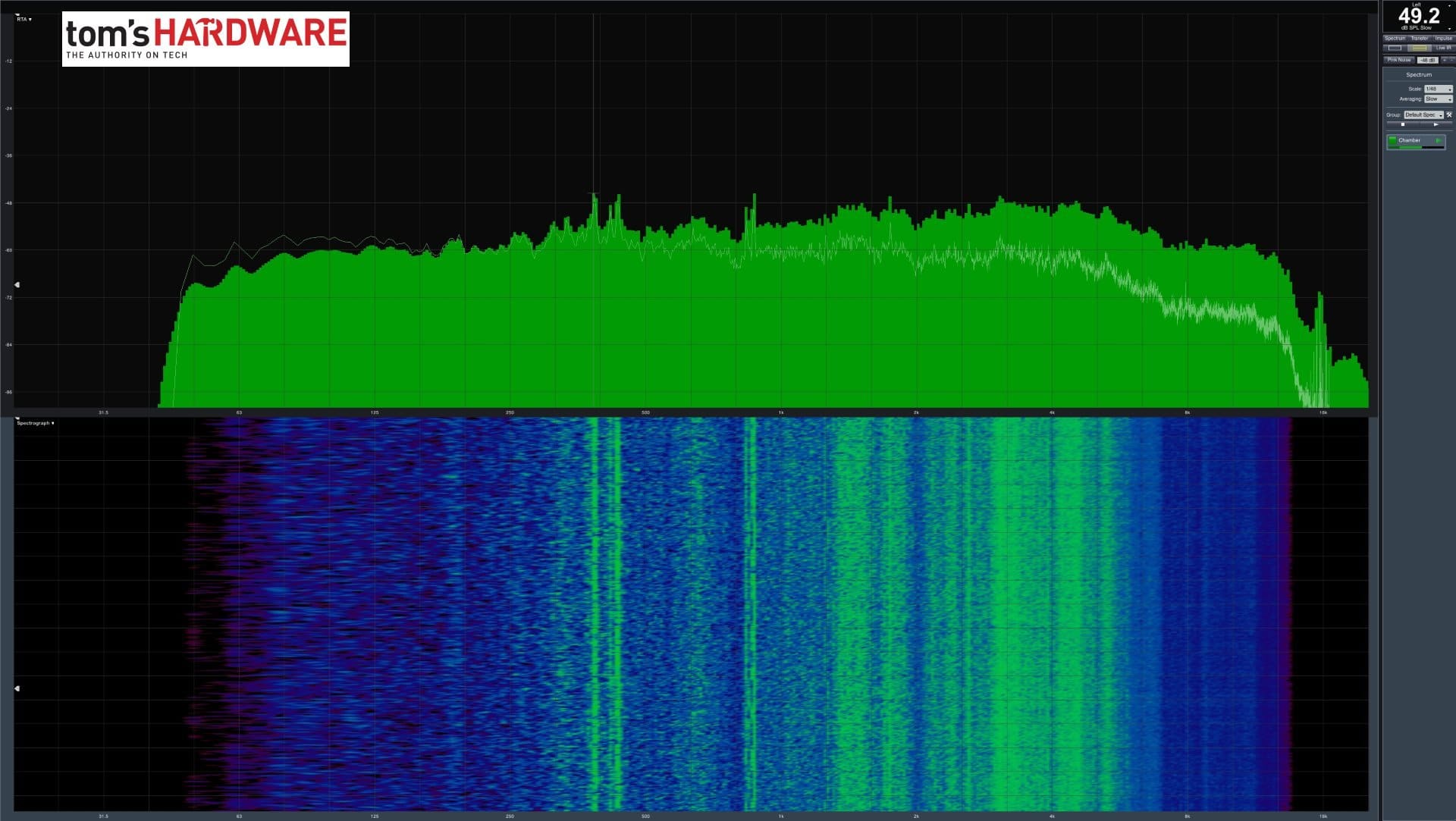

| Mesures sonores | Micro NTI Audio M2211 (avec fichier de calibration) Interface Steinberg UR12 (avec alimentation fantôme pour les microphones) Creative X7 Logiciel Smaart v.7 Chambre anéchoïque, 3,5 x 1,8 x 2,2 m (LxlxH) Mesures axiales, à la perpendiculaire du centre de(s) la source(s) sonore(s), distance de 50 cm Nuisances sonores exprimées en dBA (lent), analyse en temps réel (RTA) Spectre de fréquence représenté sous forme de graphique |

Les évolutions de Vega 20

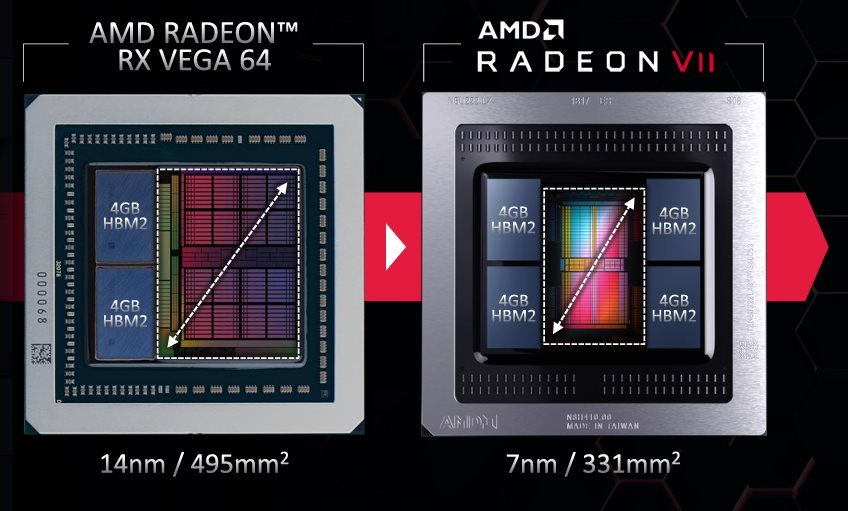

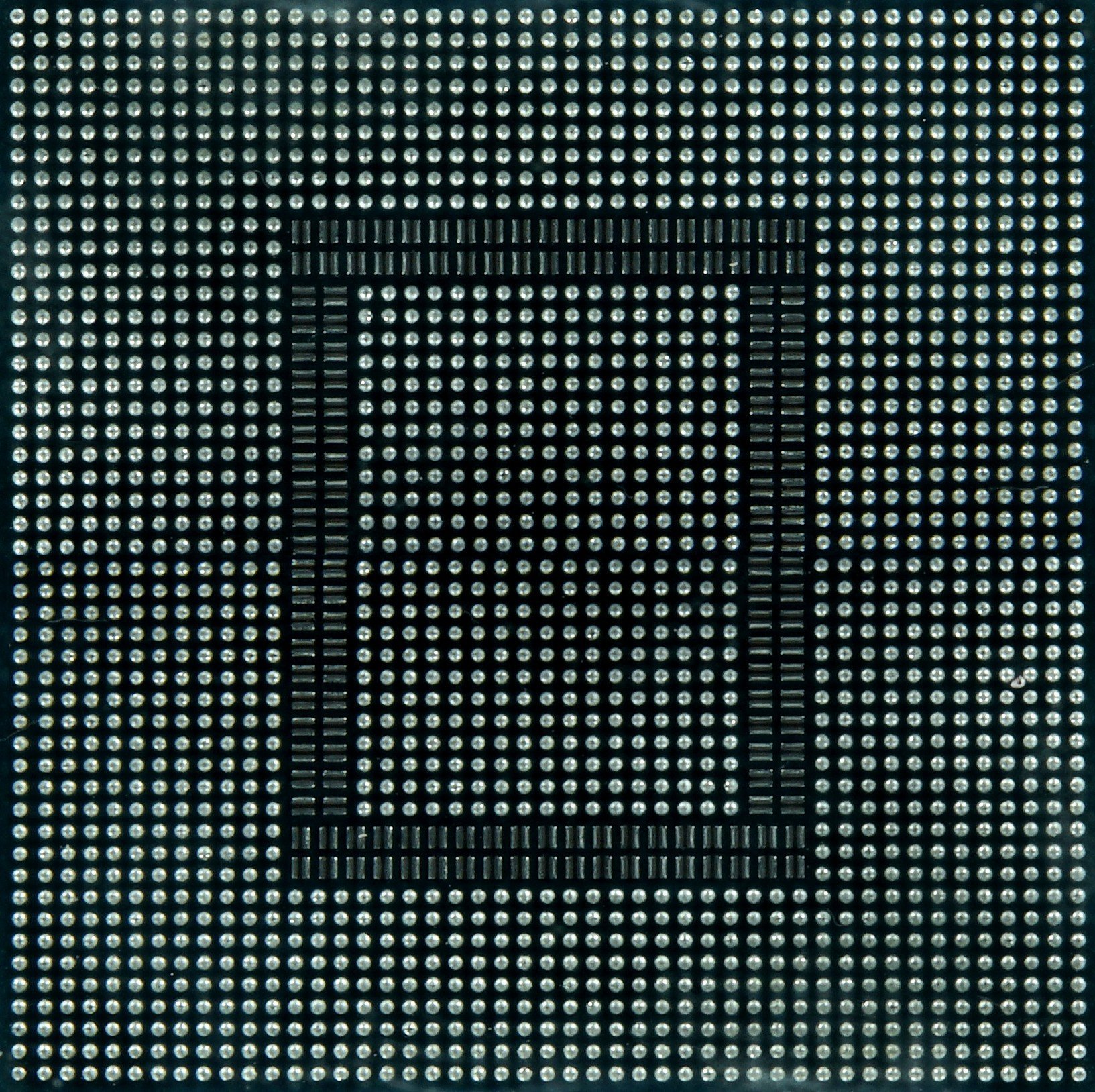

Cette fois, le GPU Vega 20 de la Radeon VII est gravé en 7 nm par TSMC, alors que le Vega 10 des Vega 56 et 64 était gravé en 14 nm chez Global Foundries. Il s’agit donc bien du tout premier GPU gravé en 7 nm, et AMD en est plutôt fier. De quoi monter considérablement les fréquences, et donc les puissances brutes de calcul, au moins sur le papier.

Notez que le débit de calcul en double précision FP64 est artificiellement limité sur cette carte, alors que la puce est physiquement capable de gérer ce niveau de précision. La bonne nouvelle, c’est que la limite devait être fixée à 1/16ème des performances en FP32, mais qu’elle est finalement à 1/4 suite à ce qu’AMD présente comme une erreur de réglage sur les cartes au lancement. Il est possible que cela reste comme tel.

En revanche, il est possible de doubler les performances à chaque palier inférieur au FP32, ce qui permettrait à la carte de gérer de l’inférence par intelligence artificielle, en INT4 ou INT8, de manière assez intéressante…

| Cartes | Radeon RX Vega 64 | Radeon VII | Radeon Instinct MI60 |

| Peak FP64 | 0.84 TFLOPS | 0.88 TFLOPS | 7.4 TFLOPS |

| Peak FP32 | 12.7 TFLOPS | 14.1 TFLOPS | 14.7 TFLOPS |

| Peak FP16 | 25.3 TFLOPS | 28.1 TFLOPS | 29.5 TFLOPS |

| Peak INT8 | 53.4 TOPS | 56.3 TOPS | 59 TOPS |

| Peak INT4 | 106.8 TOPS | 112.5 TOPS | 112.5 TOPS |

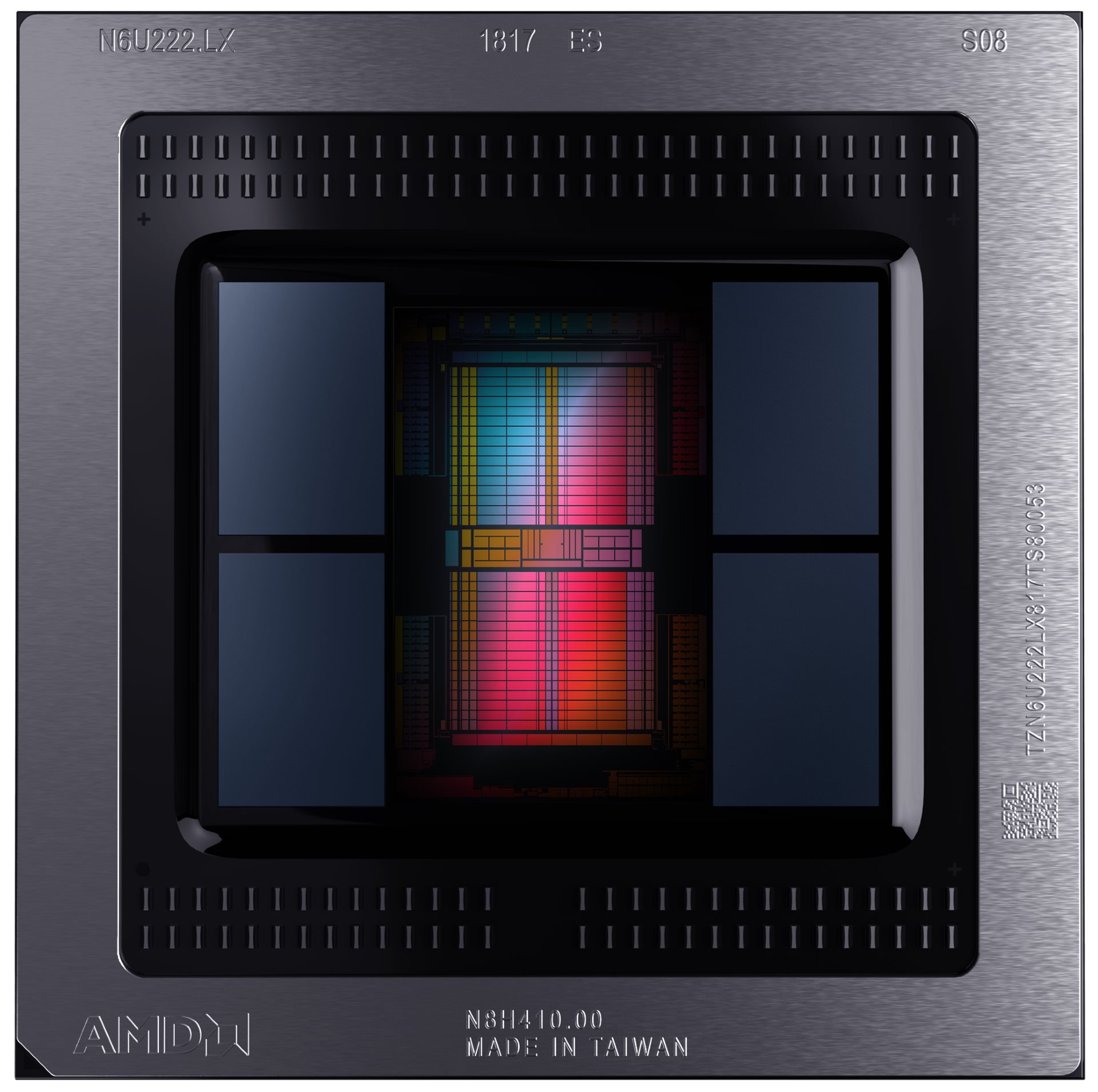

Le GPU est beaucoup plus petit que son prédécesseur, et peut alors laisser place à deux piles de RAM HBM2 supplémentaire, pour doubler sa mémoire vive, mais aussi la largeur de son bus mémoire. Cette RAM fonctionne aussi à une fréquence supérieure, ce qui permet d’offrir bande passante finale plus de deux fois supérieure.

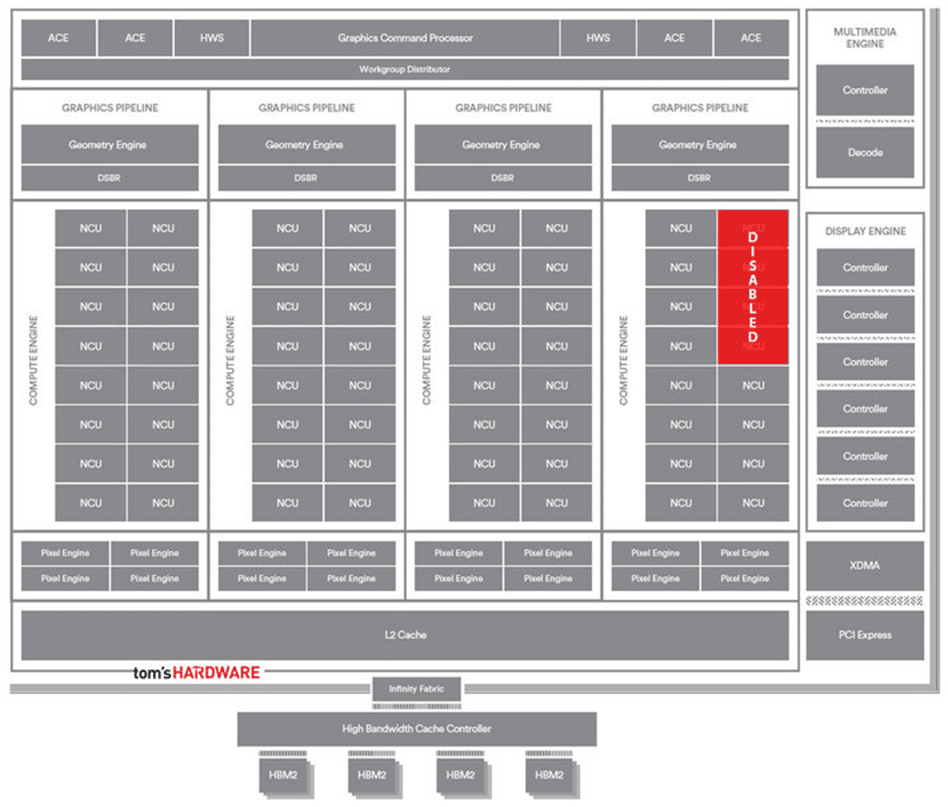

L’architecture globale de Vega 20 reste identique à Vega 10 en Graphic Core NEXT 5.0. Certains sites parlent d’un GCN 5.1, mais AMD n’y fait pas explicitement référence. Il y a donc toujours quatre shader engines. Chacun regroupe 16 Compute Units, intégrant 64 processeurs de flux et quatre unités de texture. La Radeon VII ne possède toutefois pas un Vega 20 complet, elle sacrifie quatre Compute Units, perdant alors 256 processeurs de flux et 16 unités de textures. Les fréquences en hausse devraient faire oublier cette perte et aboutir à des performances finales en hausse.

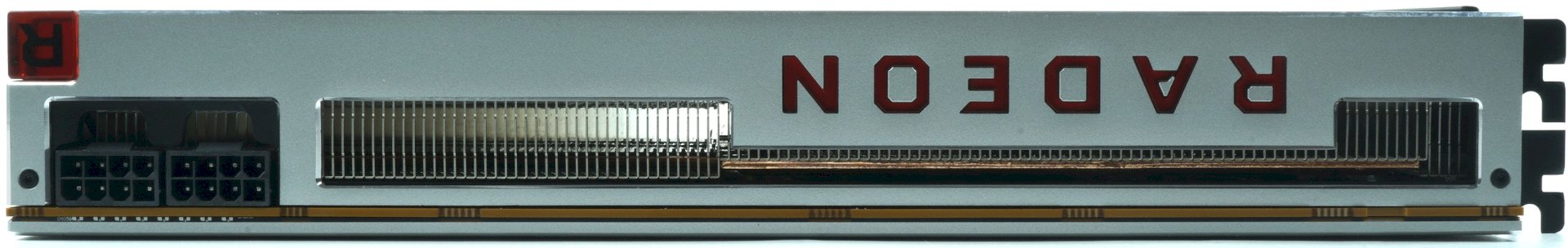

La carte ne gagne toutefois rien côté consommation. Son TDP est même en hausse de 295 à 300 W. Ce qui va d’emblée être difficile à défendre face aux 215 W de la RTX 2080… Mais c’est surtout la température qu’il va falloir discipliner, et c’est notamment pourquoi AMD a changé son dissipateur blower radial pour une ventilation axiale à triple turbines.

Du coup, la carte change un peu sa manière de gérer ses températures. La surveillance thermique interne du GPU est améliorée. Le nombre de capteurs double, de 32 à 64, chacun placé stratégiquement pour couvrir toute la surface du GPU. Désormais, ces capteurs ne servent pas seulement à déclencher le mécanisme d’extinction du GPU en cas de surchauffe : ils servent aussi à ajuster les fréquences et la vitesse des ventilateurs. De quoi offrir plus de performances et un monitoring plus raffiné. En revanche pour l’instant, seul Wattman peut exploiter ce nouveau système de surveillance, et ce logiciel nous a posé pas mal de problèmes et de bugs.

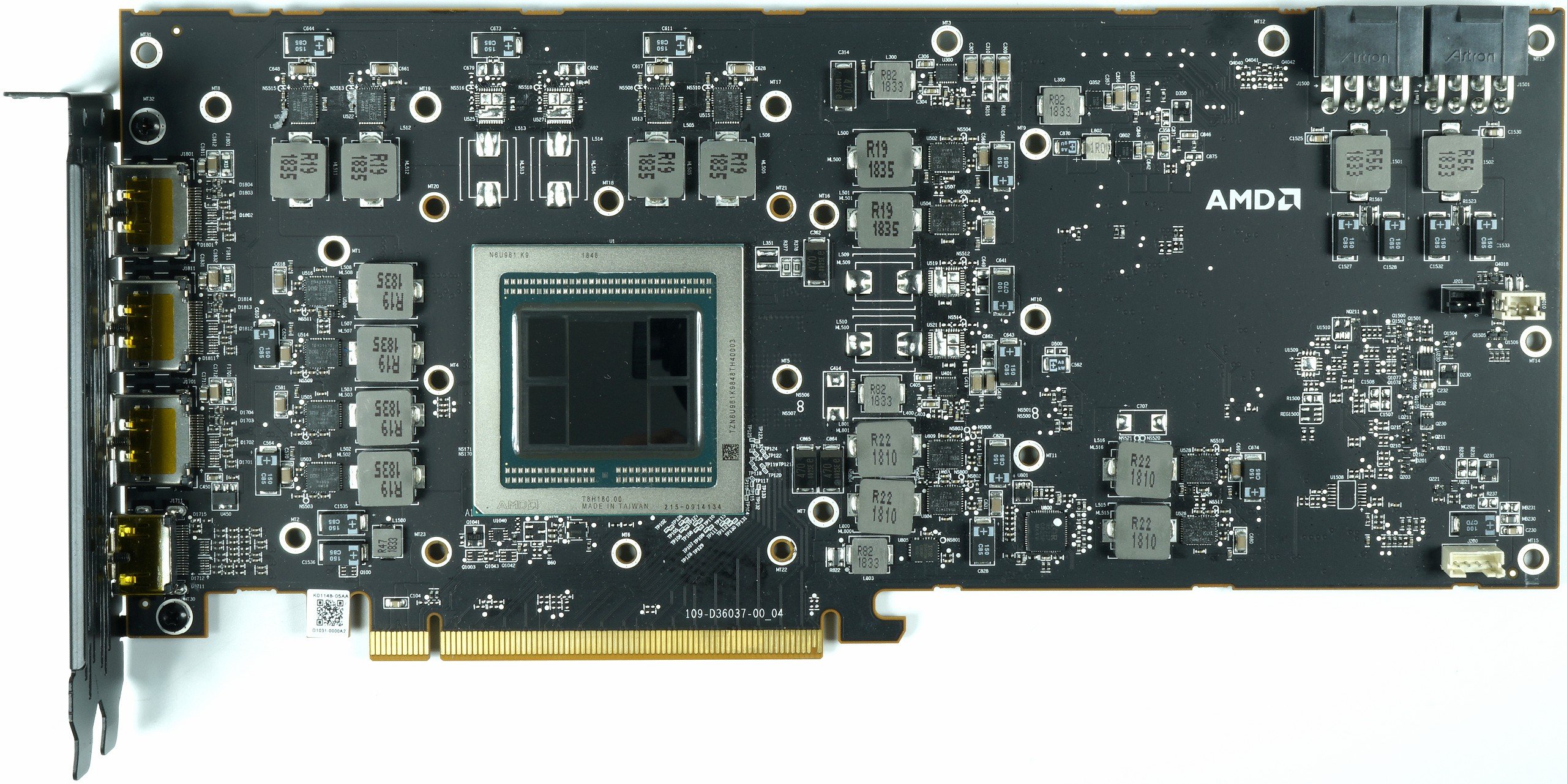

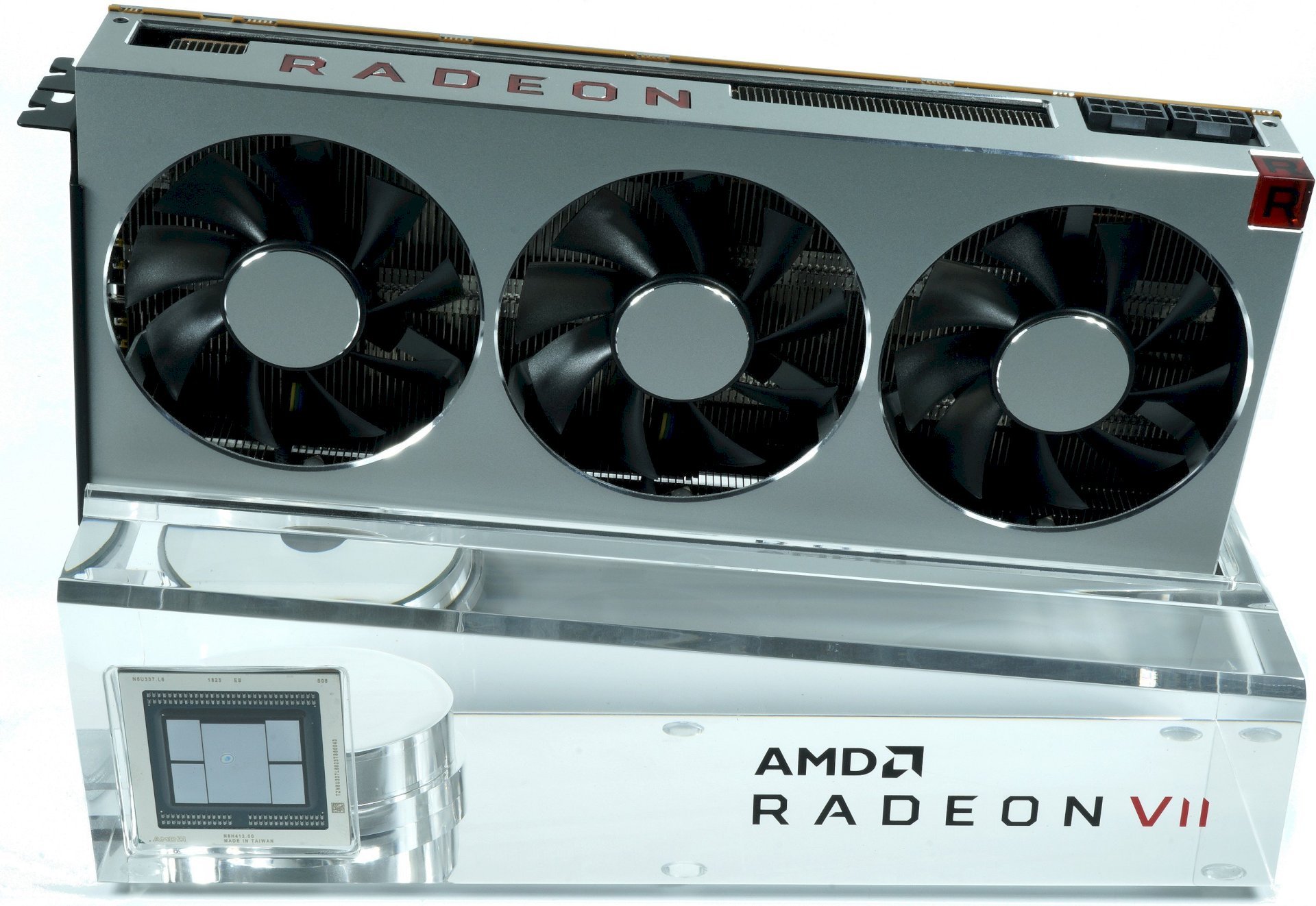

La carte en détail

Rassurez-vous, la carte ne sera pas livrée sur un socle en verre, qui est réservé pour faire sensation dans les médias. Un socle plutôt joli d’ailleurs, avec le GPU Vega 20 moulé dans le verre ! En revanche, le côté premium de la carte saute au haut grâce à son boîtier tout en aluminium, ce qui n’est pas courant dans le secteur !

La carte garde des dimensions relativement convenables, occupant deux slots, longue de 26,8 cm, large de 11,5 cm, et épaisse de 3,5 cm. Sa taille est similaire à celle d’une GeForce RTX 2080, pour un poids de 1282 grammes, similaire aussi.

PCB, alimentation, dissipateur

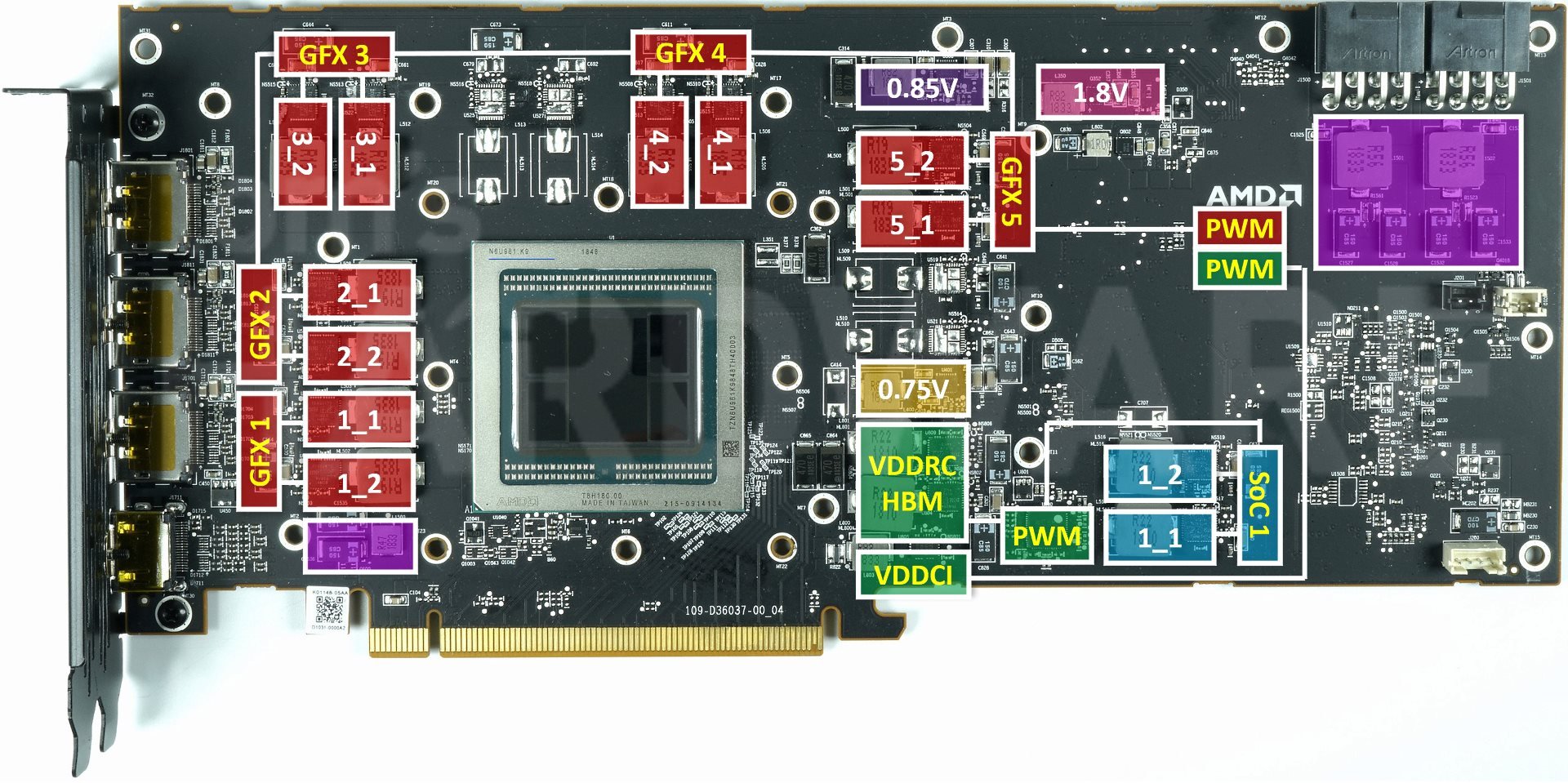

PCB et alimentation

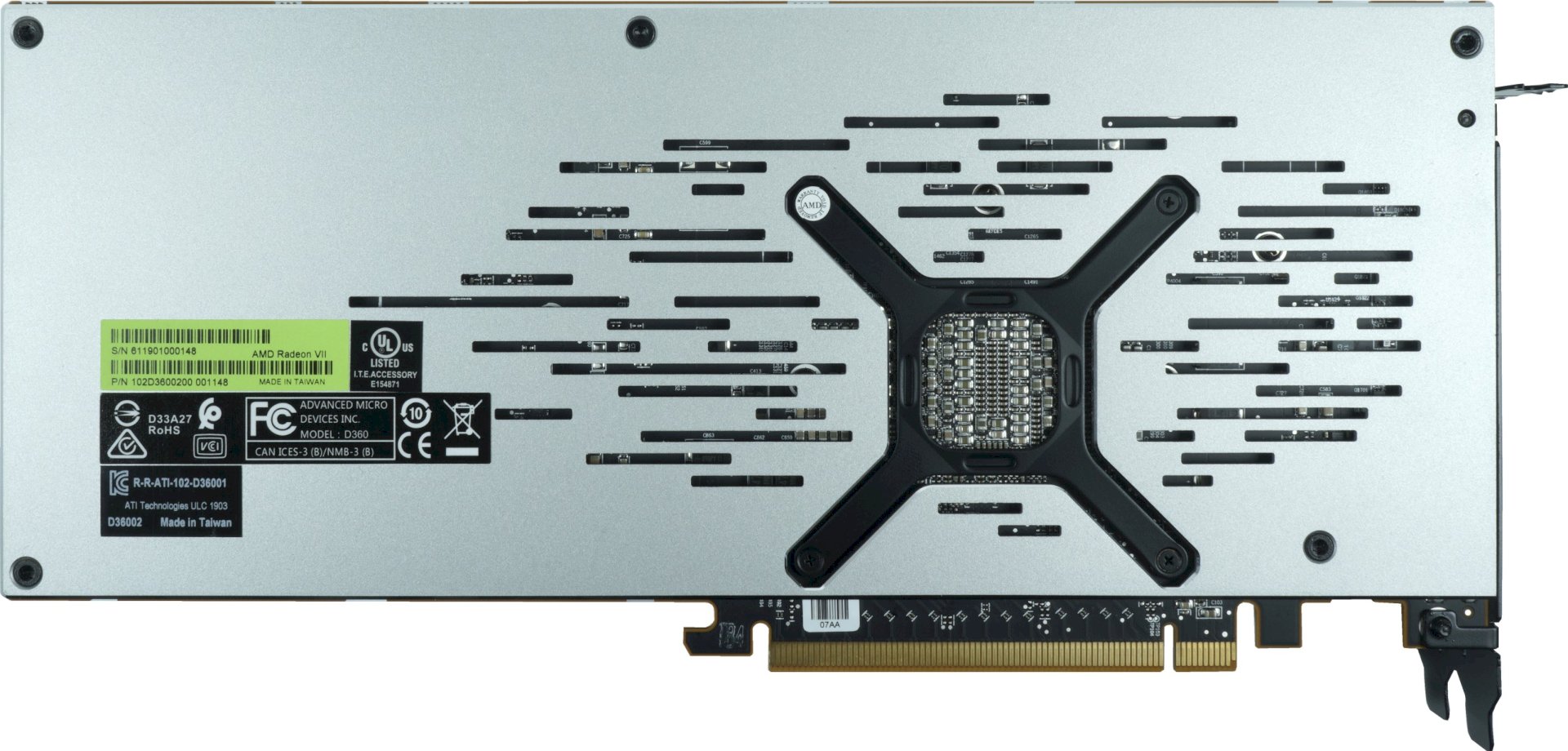

Cette Radeon VII s’arme d’un étage d’alimentation plus perfectionné que les précédentes Vega. Le GPU est alimenté par 5 phases (en rouge) contrôlées par une puce International Rectifier IR35217 située à l’arrière du PCB. Ces phases GPU sont doublées, pour offrir finalement 10 circuits de conversion de tension au GPU.

Le contrôleur des 5 phases du GPU est capable d’en gérer 6+2. Il contrôle donc aussi l’alimentation du bus mémoire entre le GPU et la RAM (VDDCI_HBM) via une phase supplémentaire. Pour la mémoire, c’est un peu plus subtil. Un second contrôleur IR35217 va gérer deux phases non doublées (VDDRC_HBM en vert) pour alimenter les quatre puces de mémoire HBM2. Ce même contrôleur va gérer aussi une phase (doublée par un IR3599) qui alimente le SoC (VDDCI_SoC en bleu). Enfin en violet, on peut voir les premiers étages de lissage du courant provenant des deux prises PCIe 8 broches, et du slot PCIe.

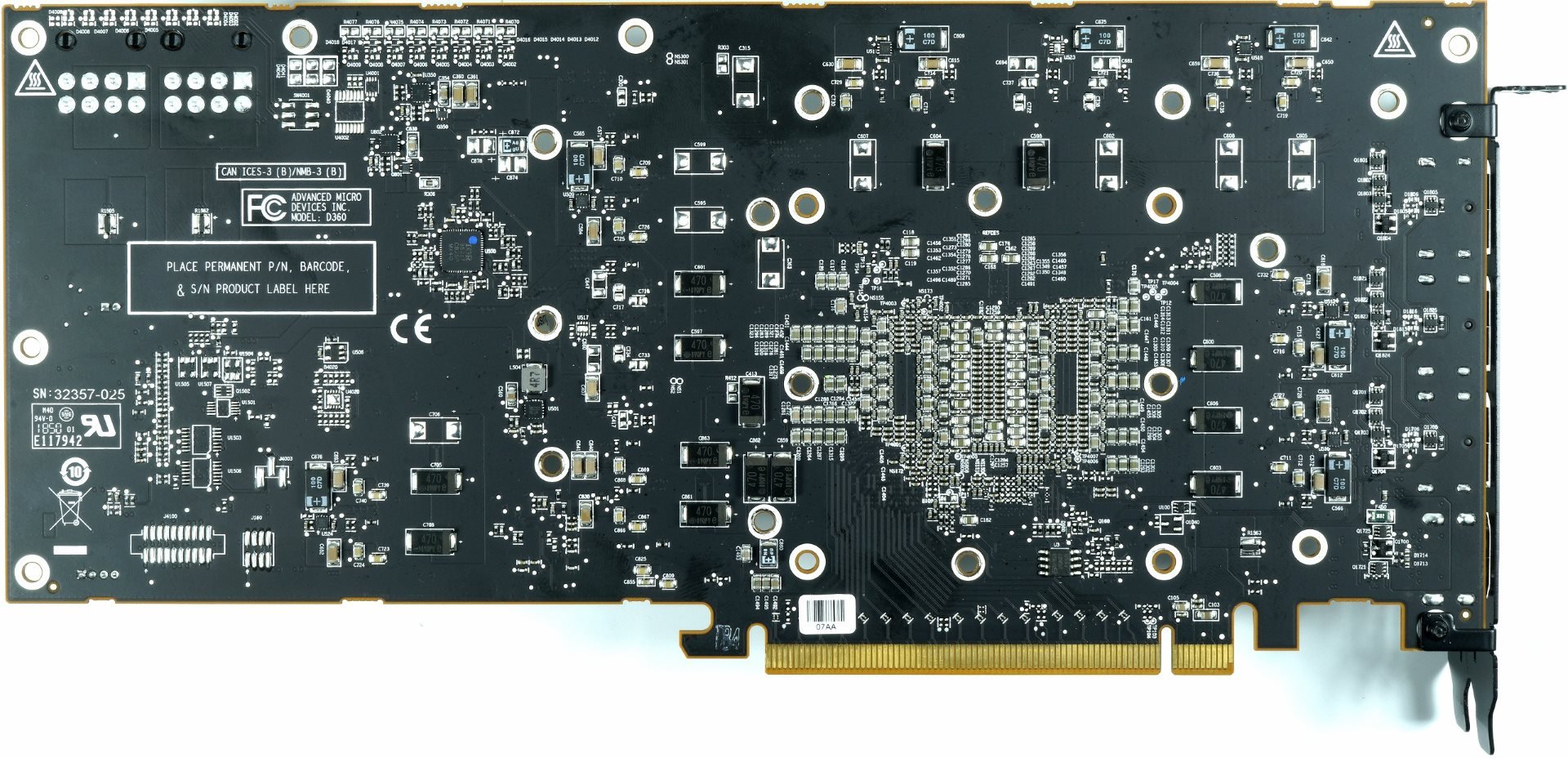

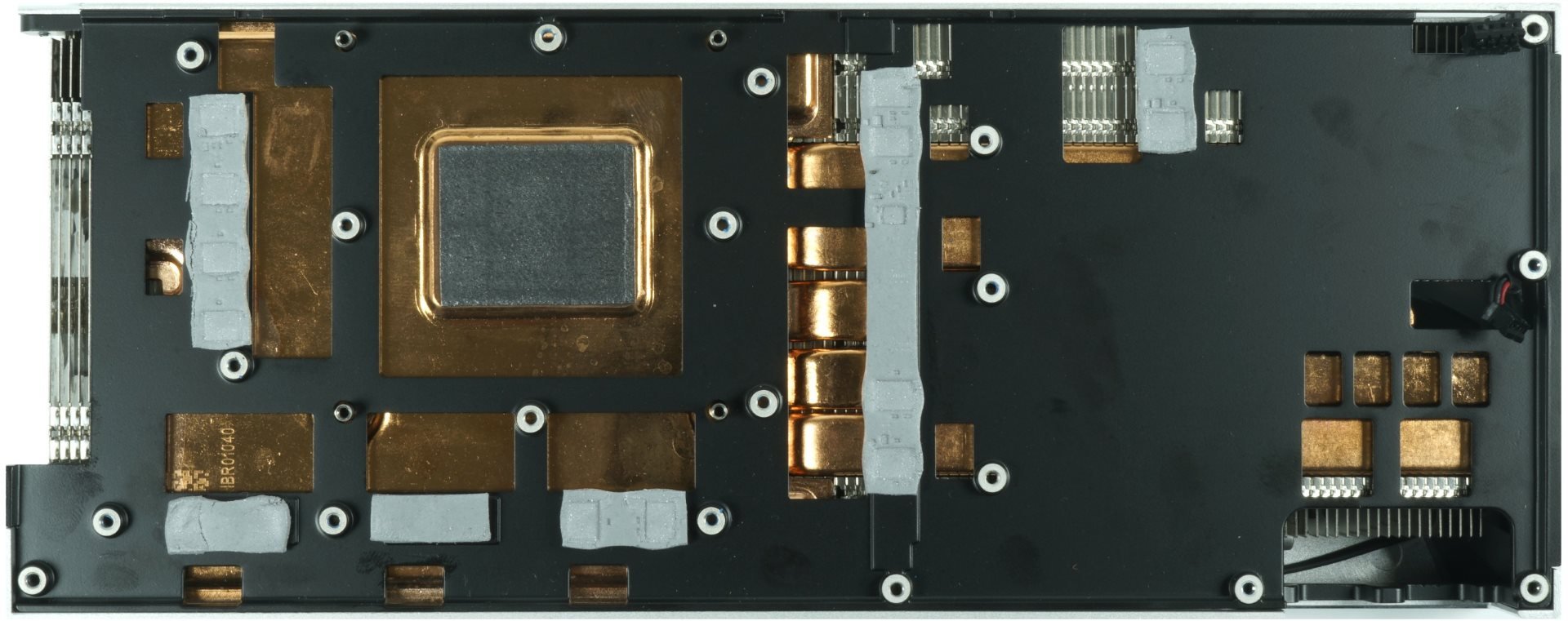

Dissipateur

Tout l’attirail de refroidissement de la Radeon VII pèse plus de 1 kg sur la balance. Comme NVIDIA, AMD utilise une chambre à vapeur de très grande taille qui entre en contact avec le GPU via un pad thermique en graphite. La Radeon Pro WX8200 utilise aussi cette solution. Et finalement, nous avons constaté que ce pad est très efficace, puisqu’il nous a fallu une très fine couche de pâte Innovation Cooling Diamond haut de gamme pour obtenir les mêmes performances.

La chaleur répartie dans la chambre à vapeur est évacuée par des ailettes de dissipation en aluminium orientées verticalement. De l’autre côté du radiateur, cinq caloducs plats de 10 mm de large profitent aussi de la dissipation de ces ailettes. En revanche, cela veut dire que toute la chaleur sera repoussée à l’intérieur du boîtier, comme pour les GeForce RTX Founders Edition. Trois ventilateurs de 7,5 cm de diamètre vont gérer la dissipation finale.

Les régulateurs de tension du GPU, de la mémoire et du SoC sont aussi refroidis par d’épais pads thermiques en contact avec une plaque de dissipation et de maintien noire, juste sous la chambre à vapeur.

Derrière la carte, la plaque arrière ne participe pas à la dissipation des composants. Elle est tenue à l’écart du PCB à l’aide de petits morceaux de caoutchouc noirs que l’on voit sur la photo.

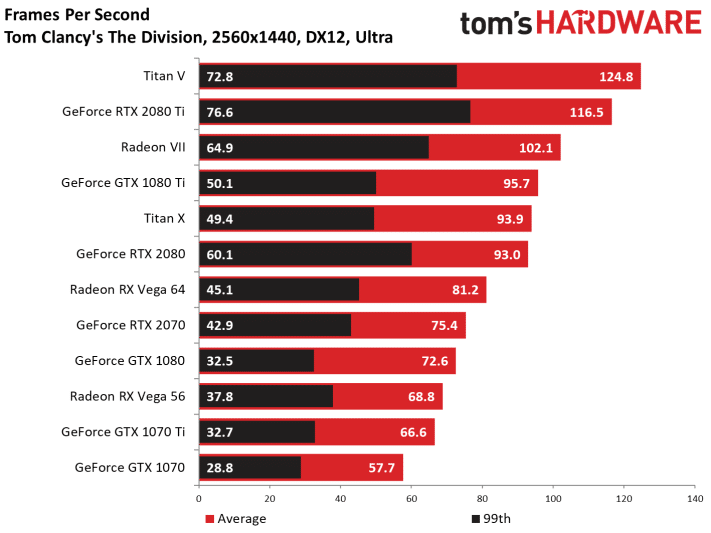

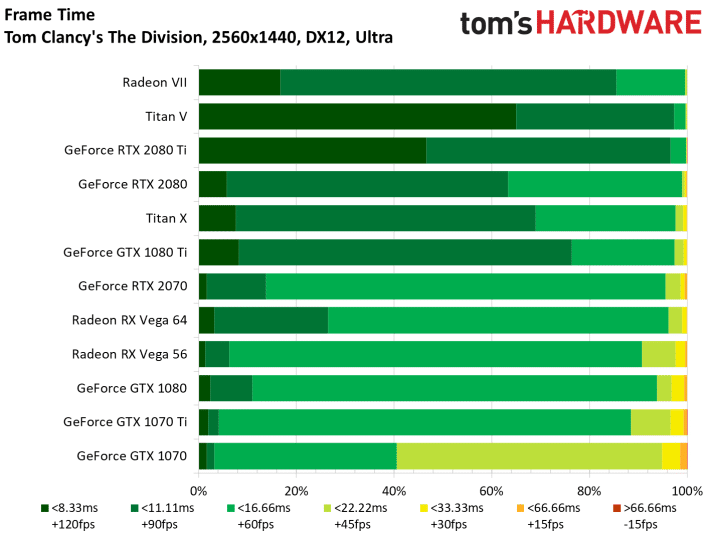

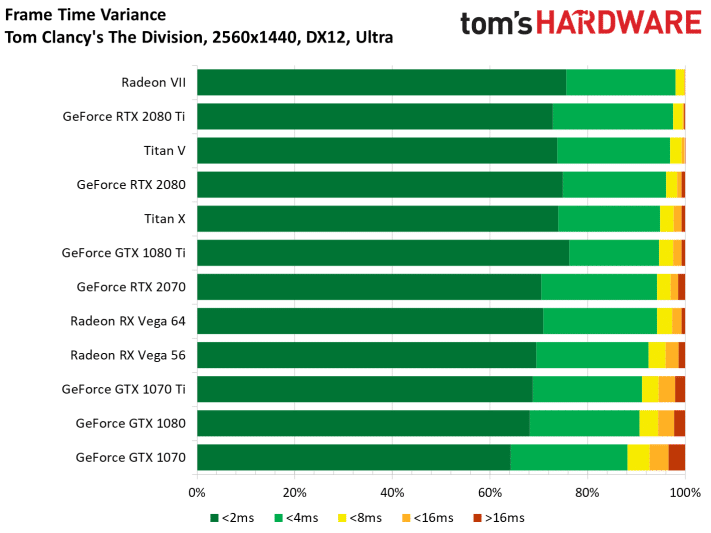

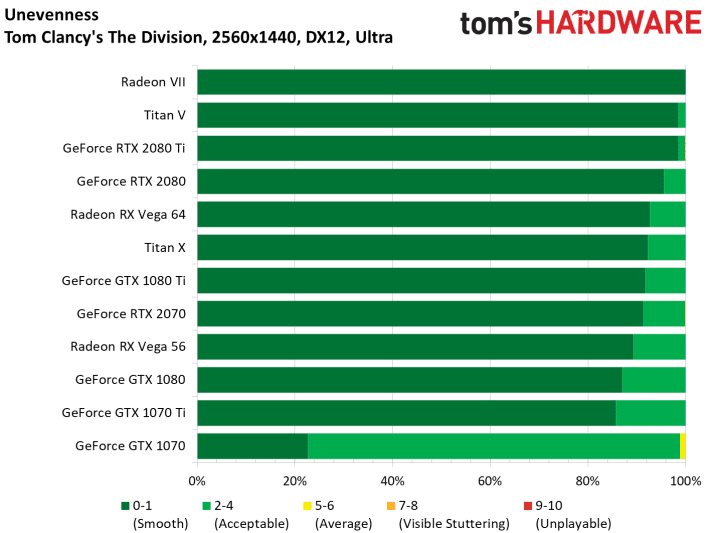

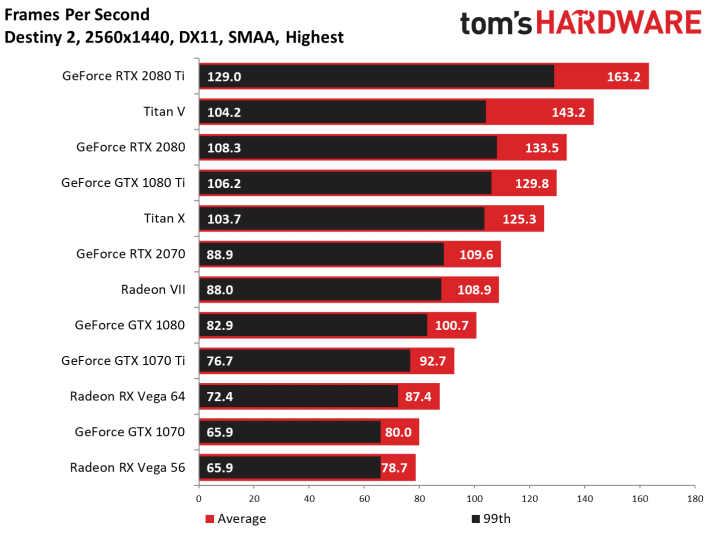

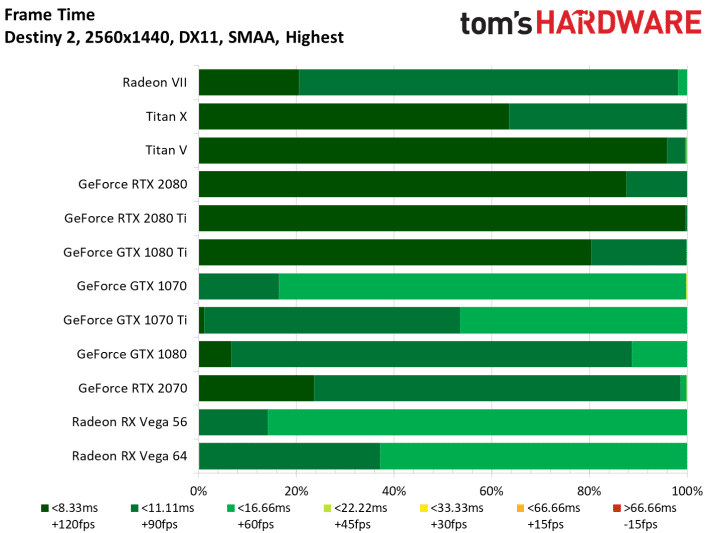

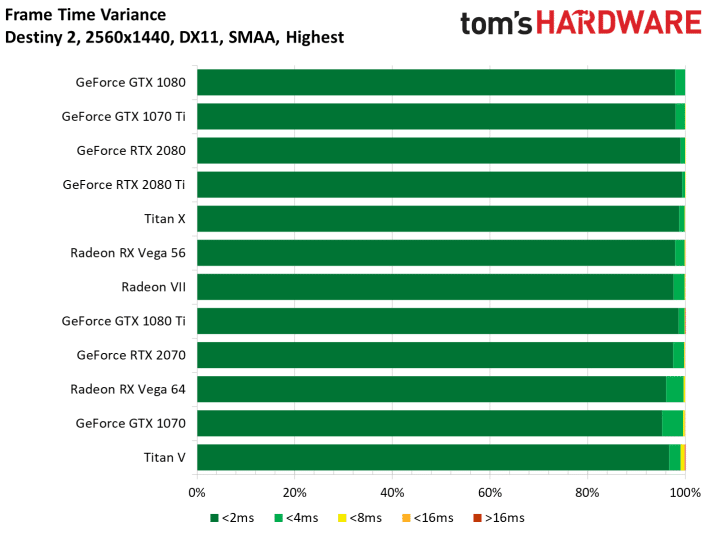

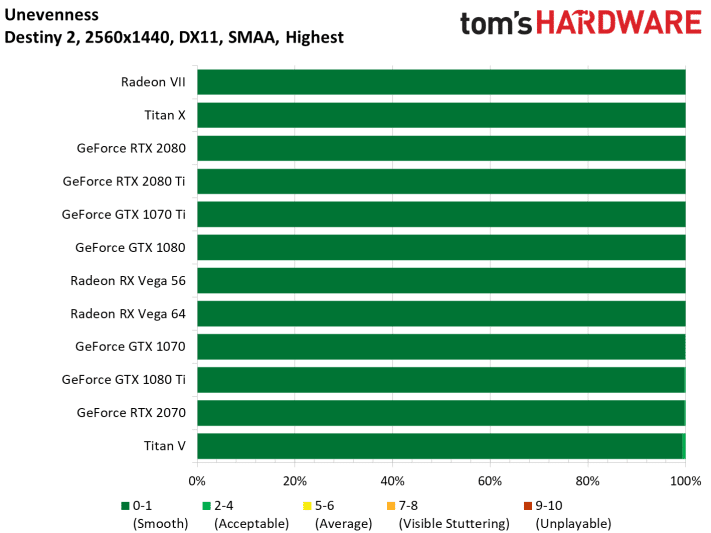

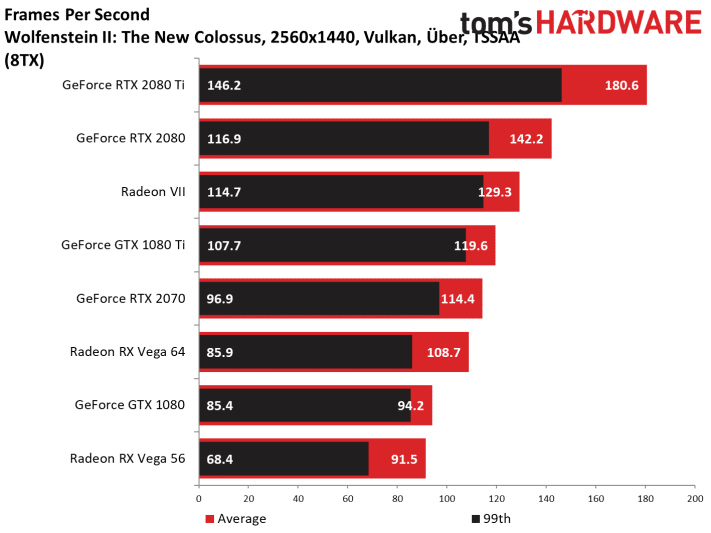

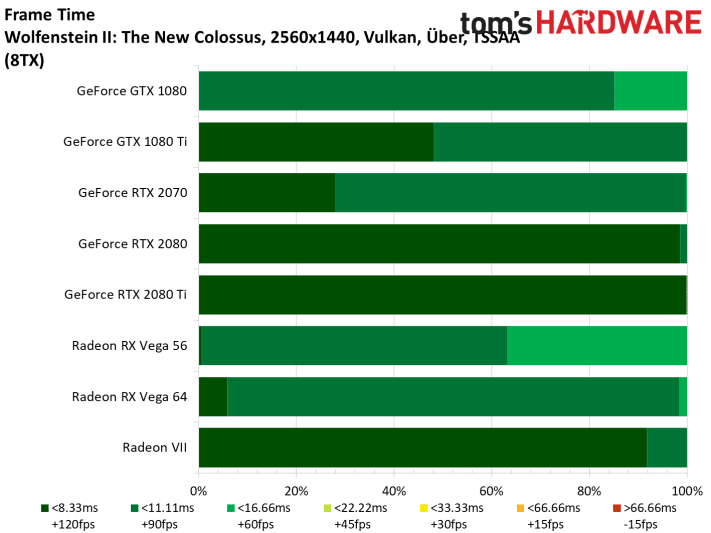

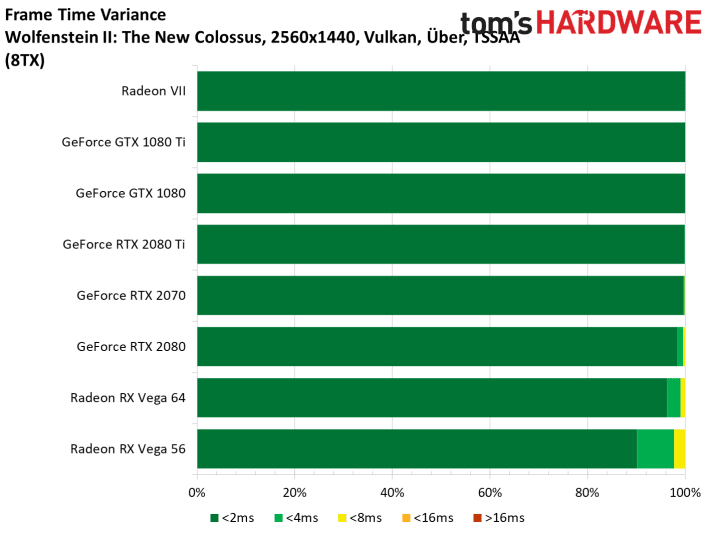

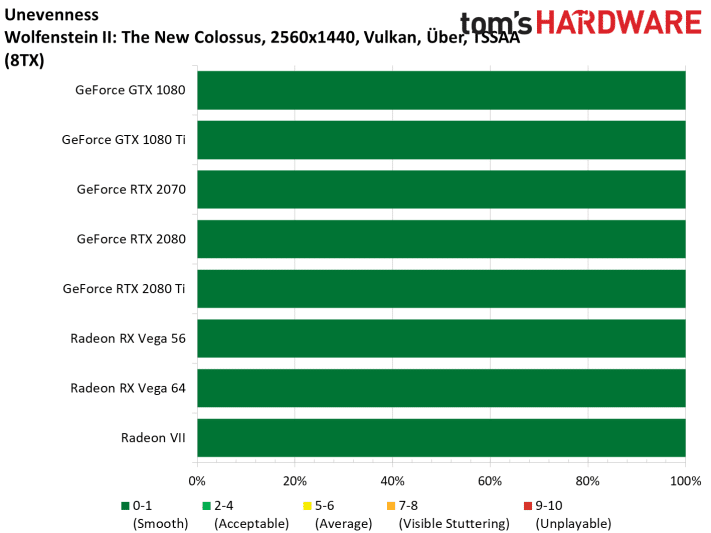

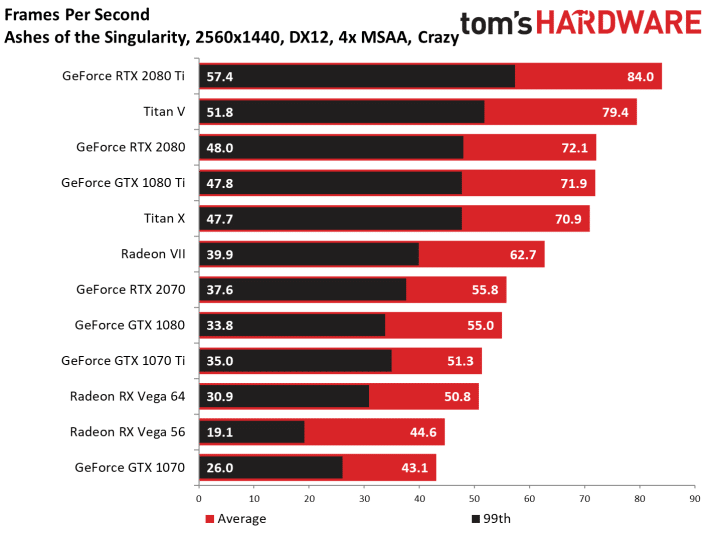

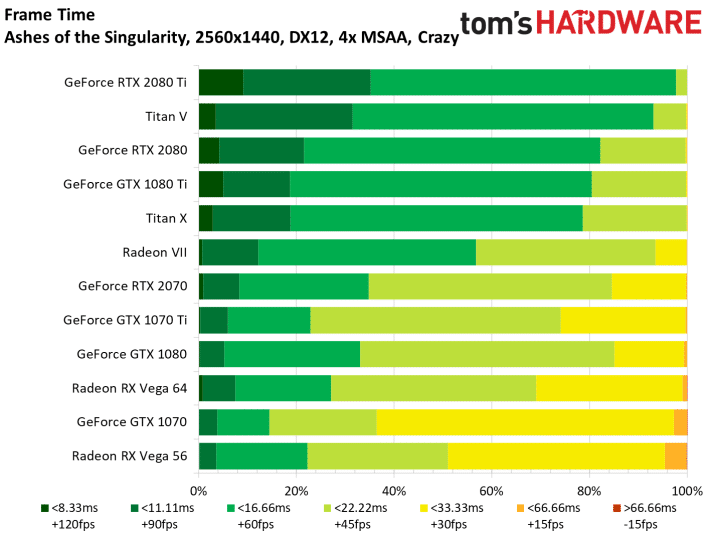

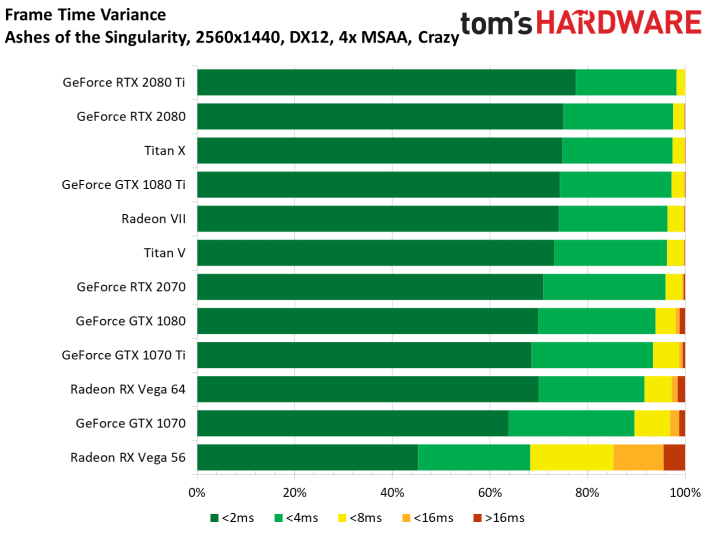

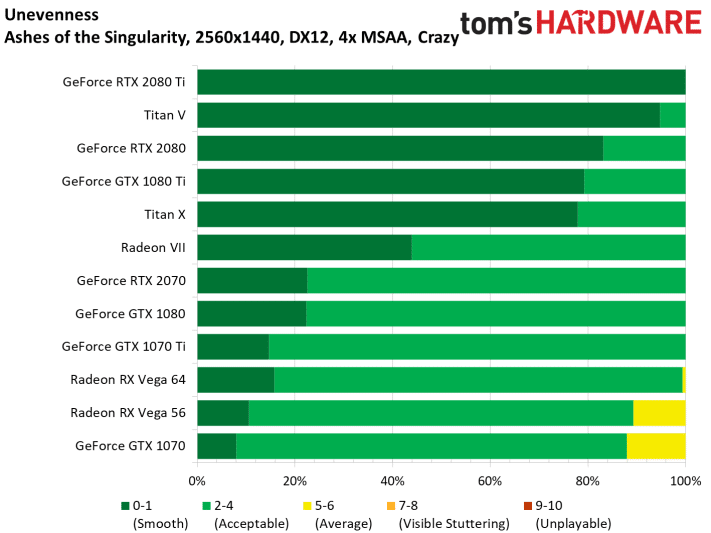

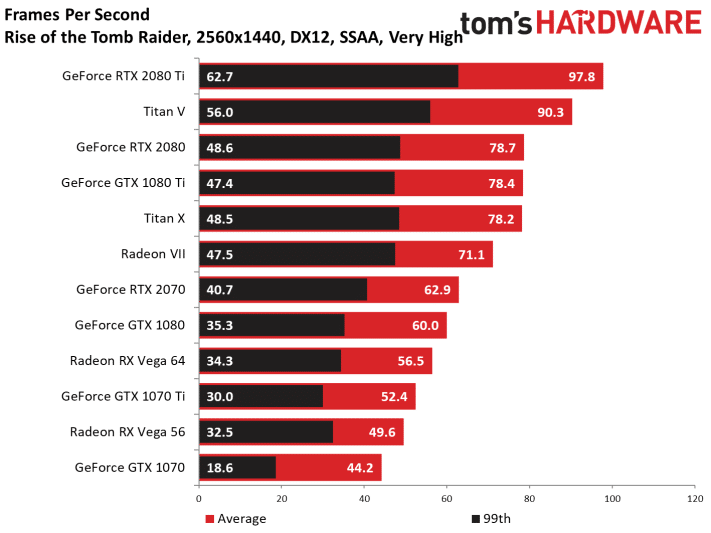

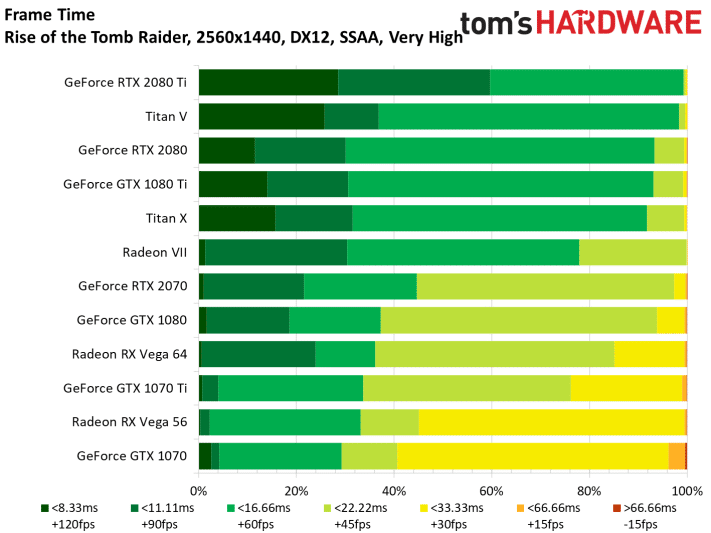

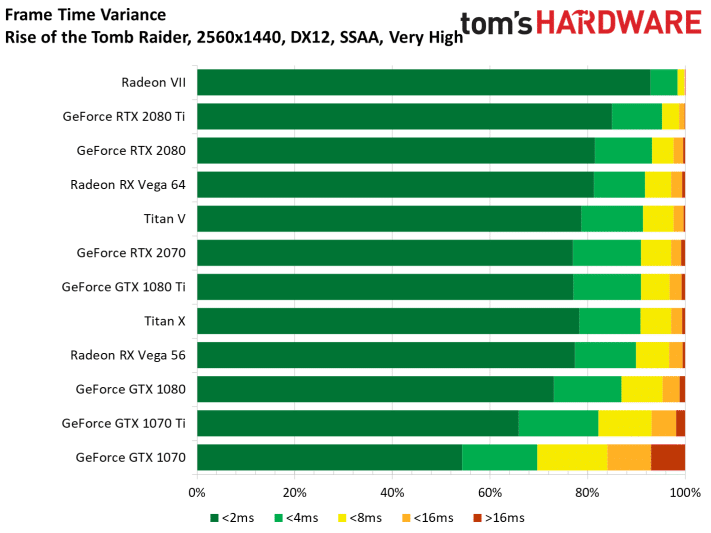

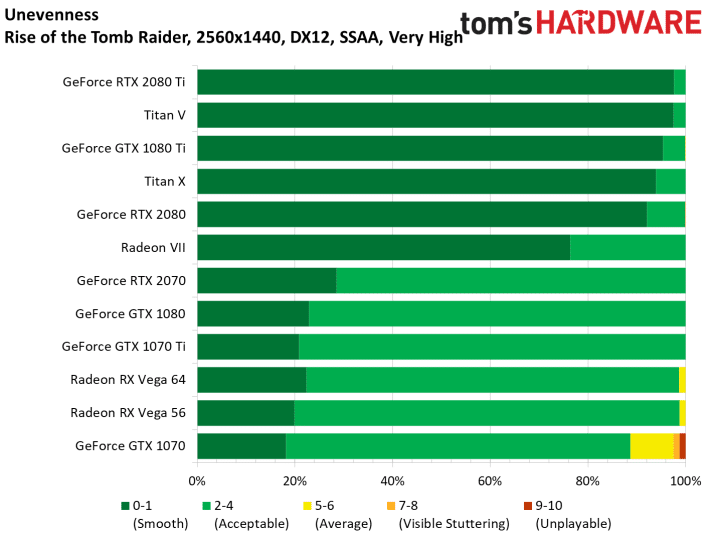

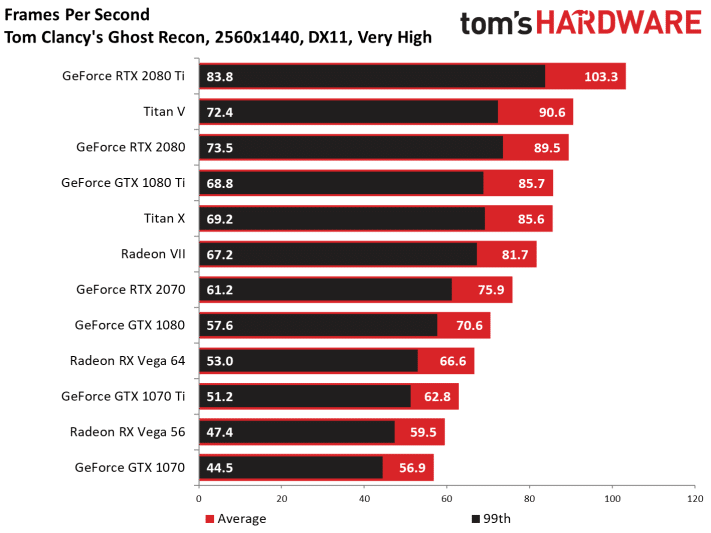

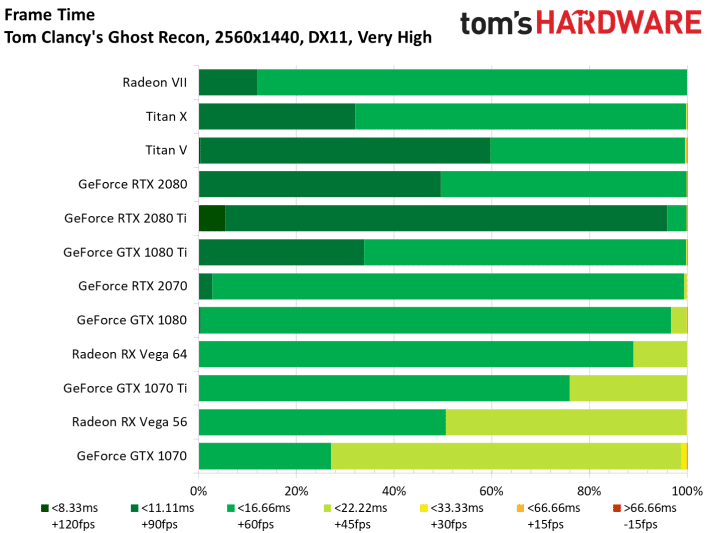

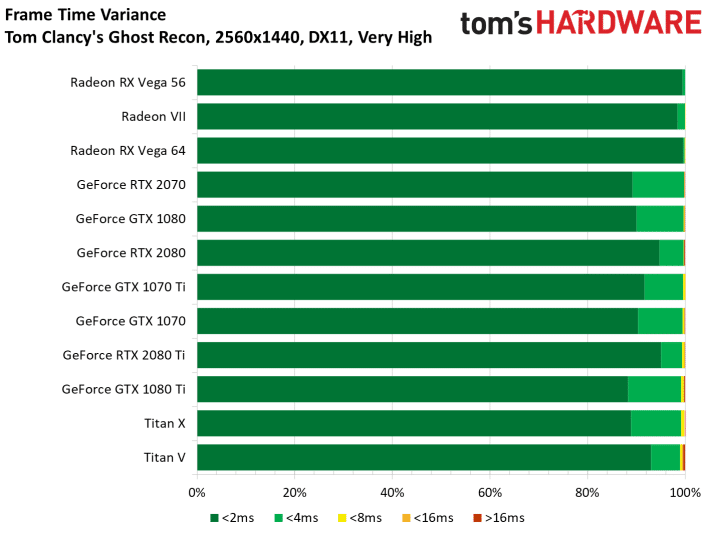

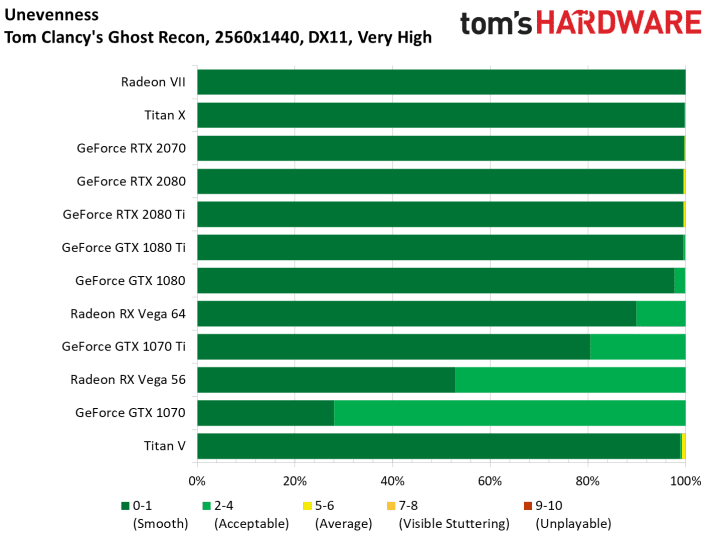

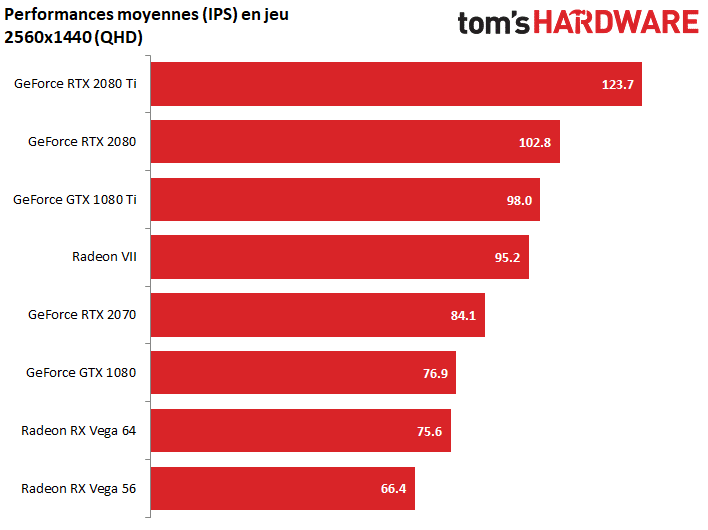

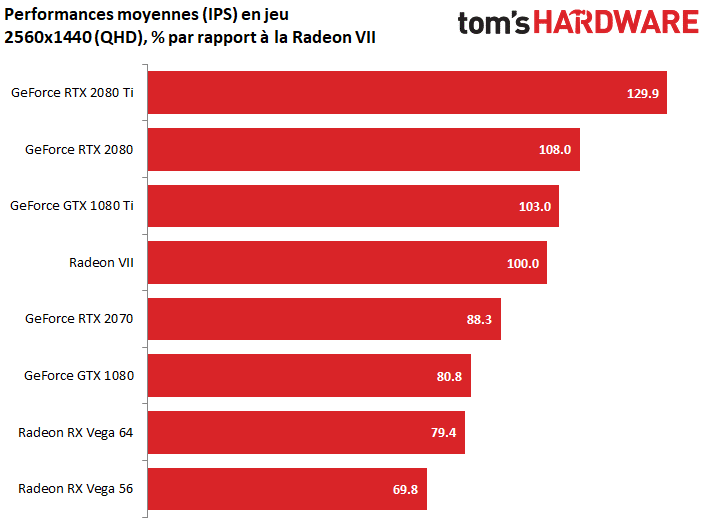

Tests en QHD (2560 x 1440)

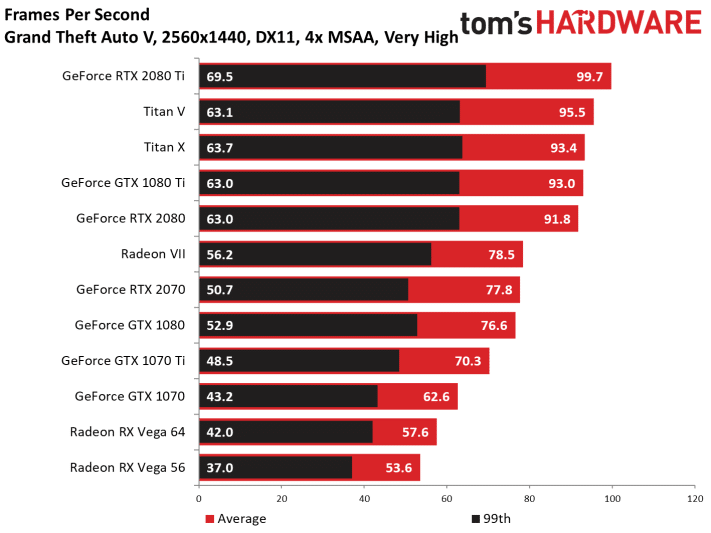

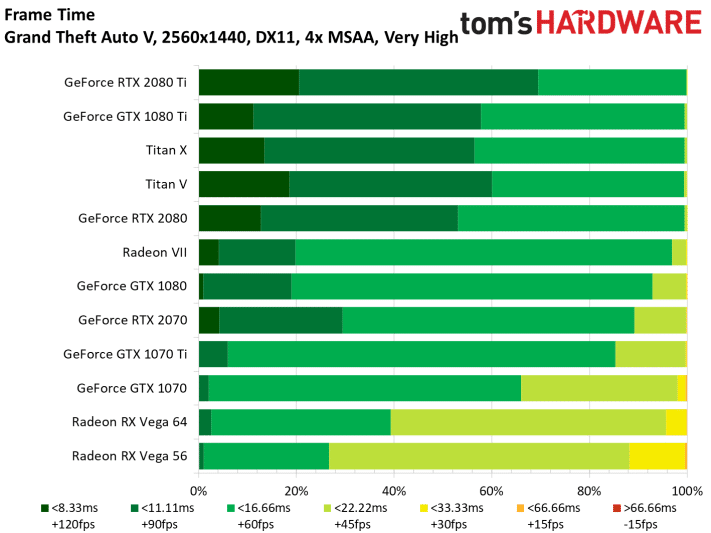

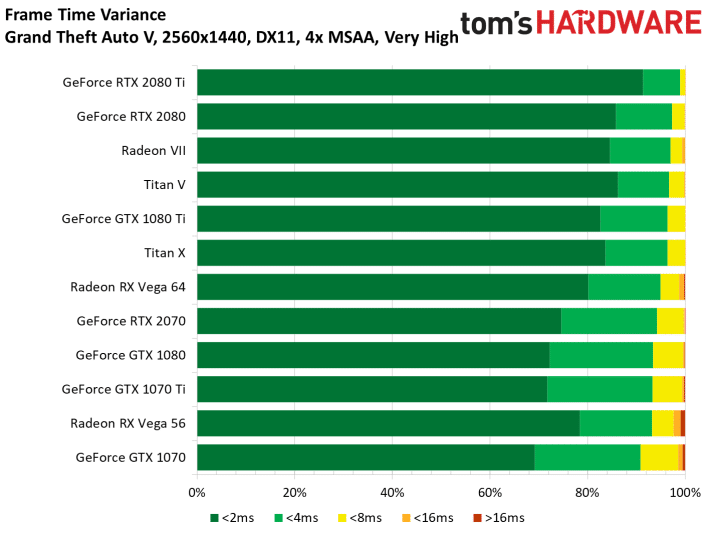

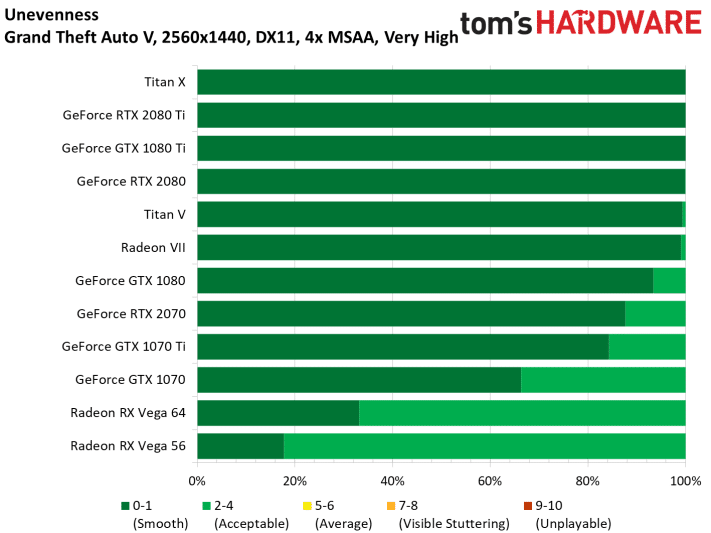

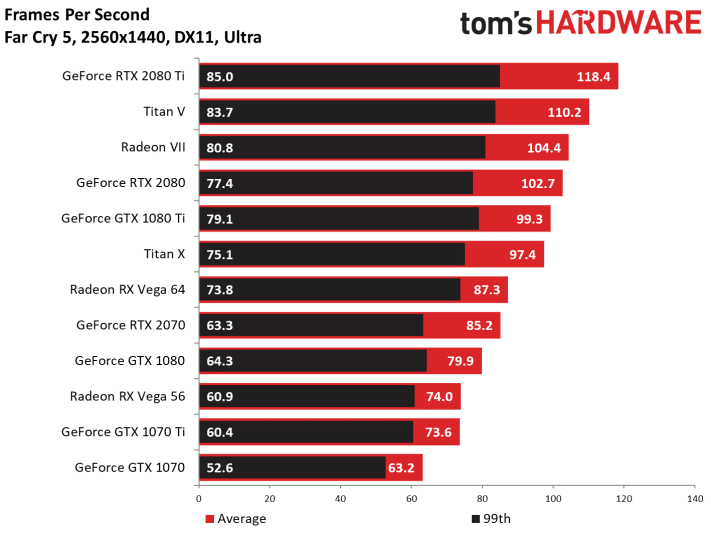

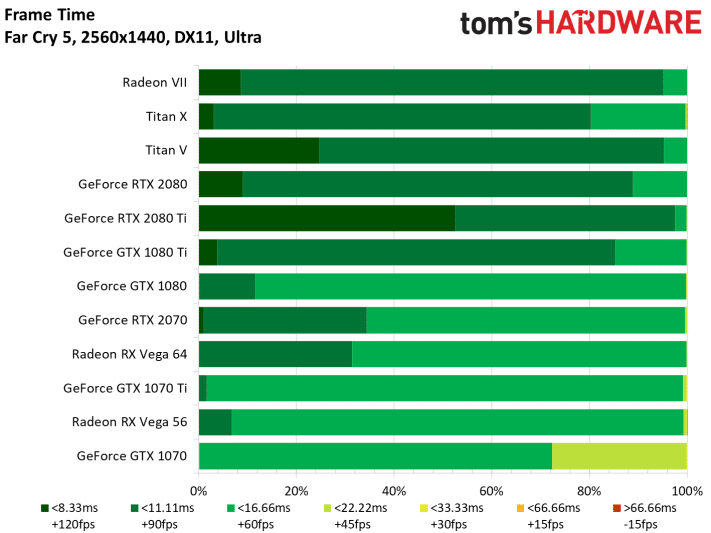

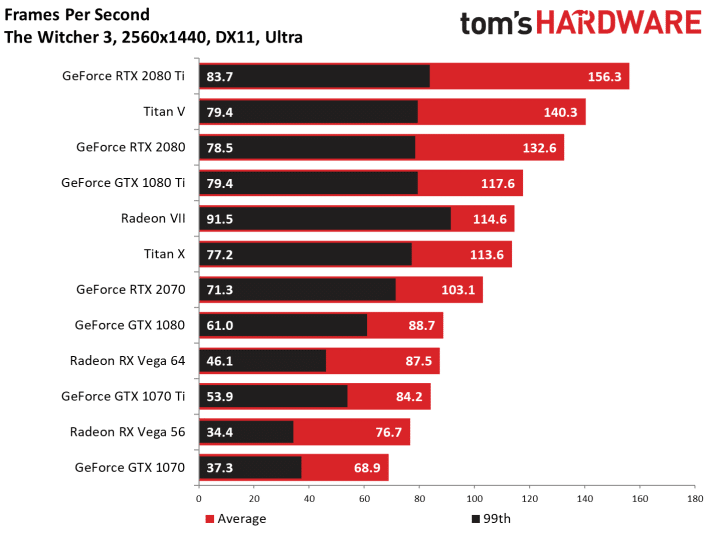

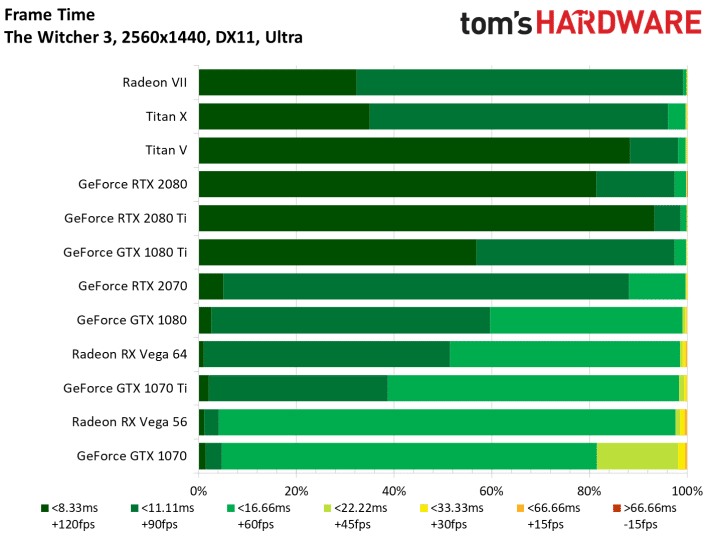

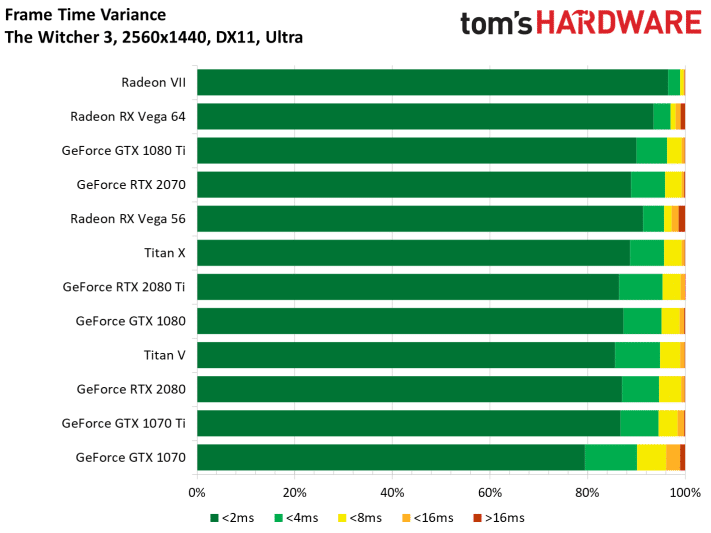

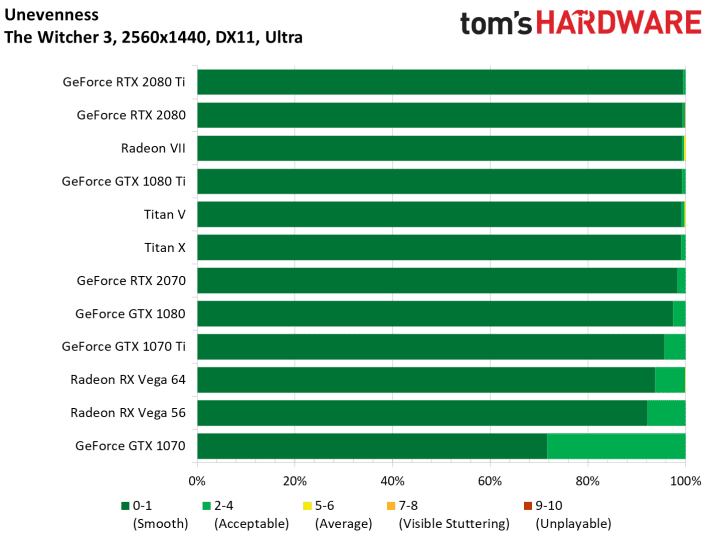

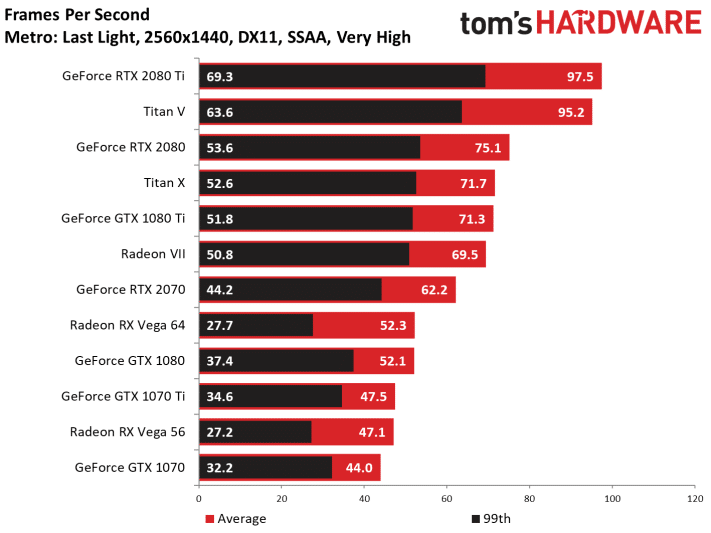

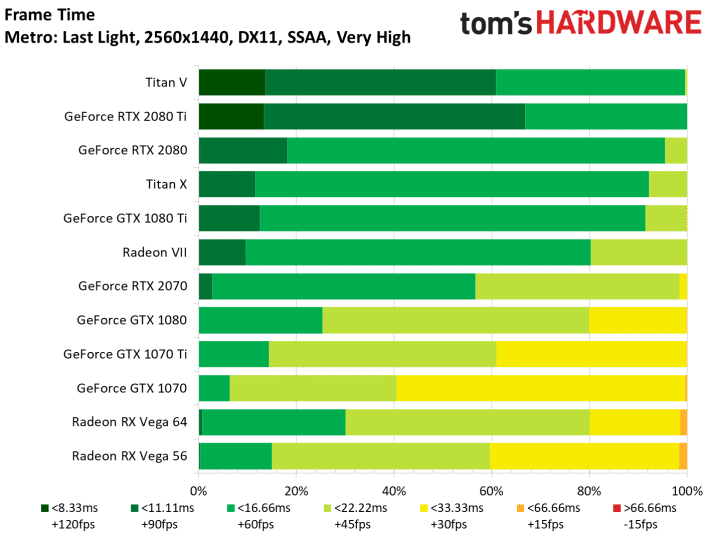

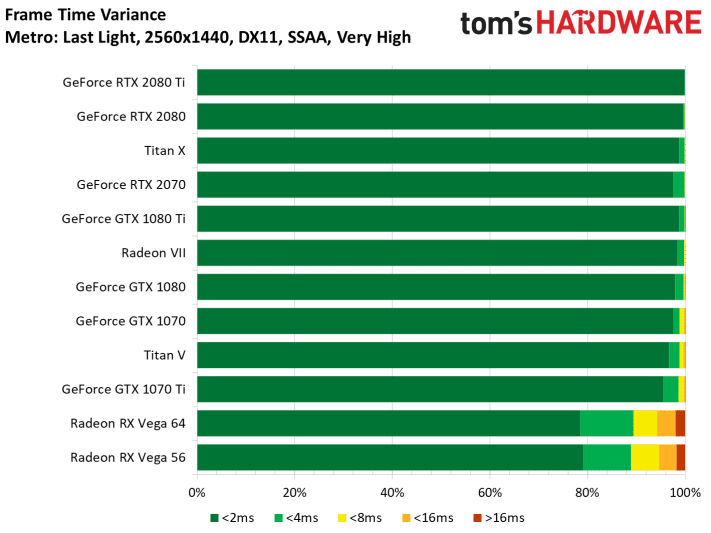

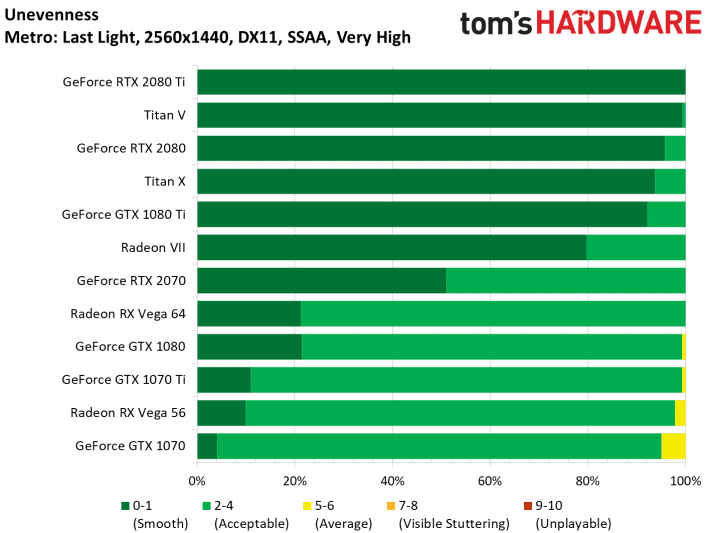

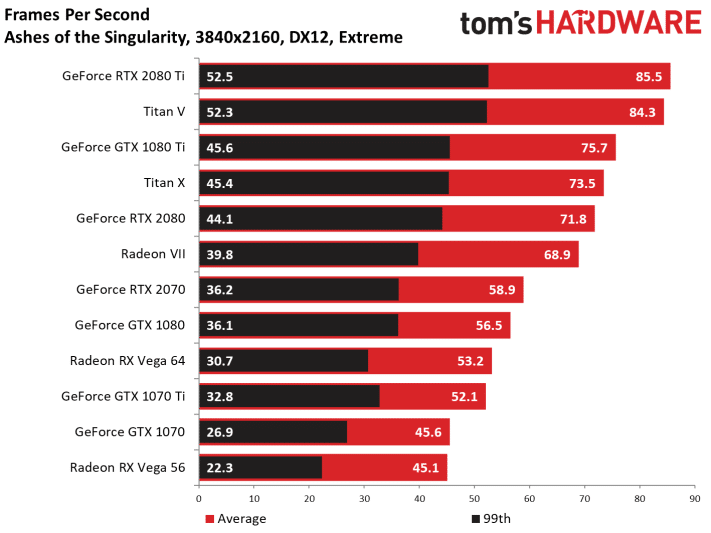

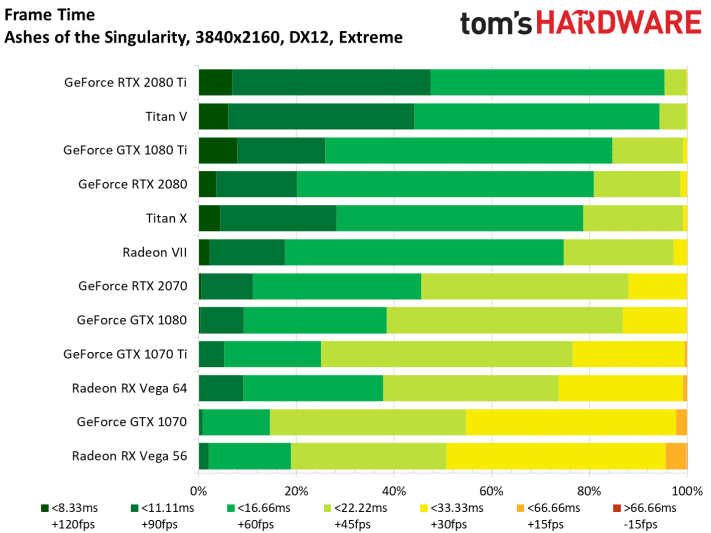

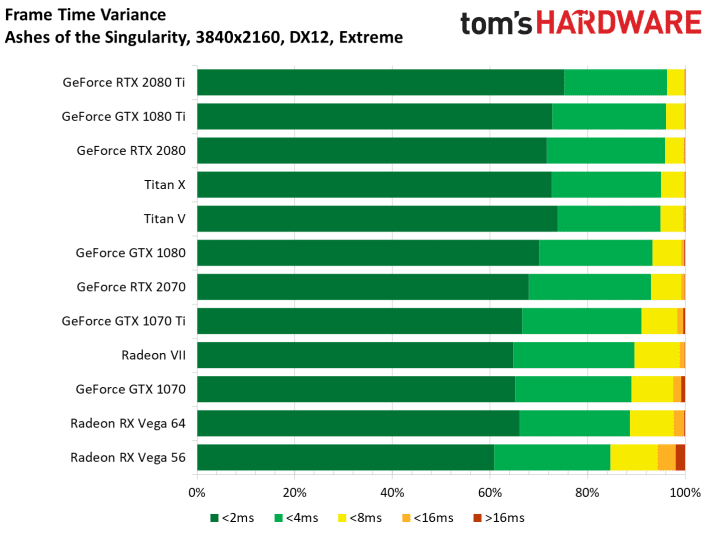

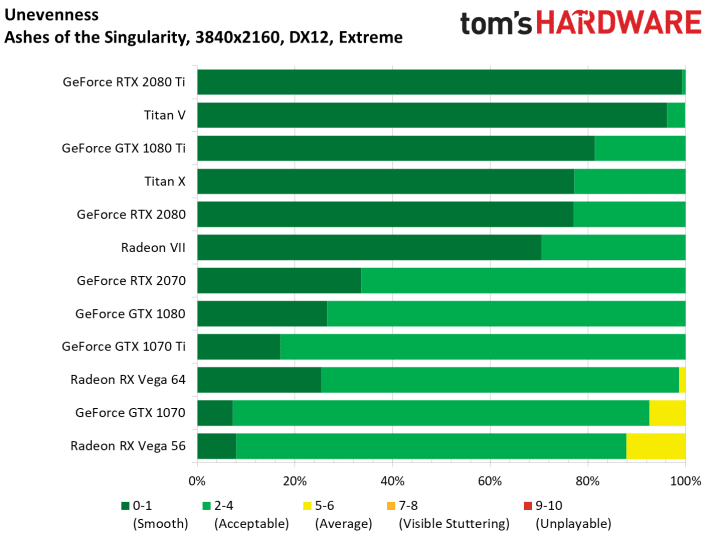

La Radeon est largement suffisante pour offrir du jeu très fluide en définition WQHD, avec des options graphiques très élevées, souvent agrémentées d’un antialiasing. En moyenne, la Radeon VII apporte 26 % de performances de plus que la Radeon RX Vega 64, ce qui est assez impressionnant pour une architecture identique et 6 CU de moins.

Face à NVIDIA, la Radeon VII affiche 92 % des performances de la RTX 2080 dans ces 11 jeux. Il est toujours possible de changer la sélection de jeux pour obtenir un résultat plus ou moins avantageux pour la Radeon, tout dépendra du nombre de titres qui répondent très bien à l’architecture GCN.

The Division (DX12)

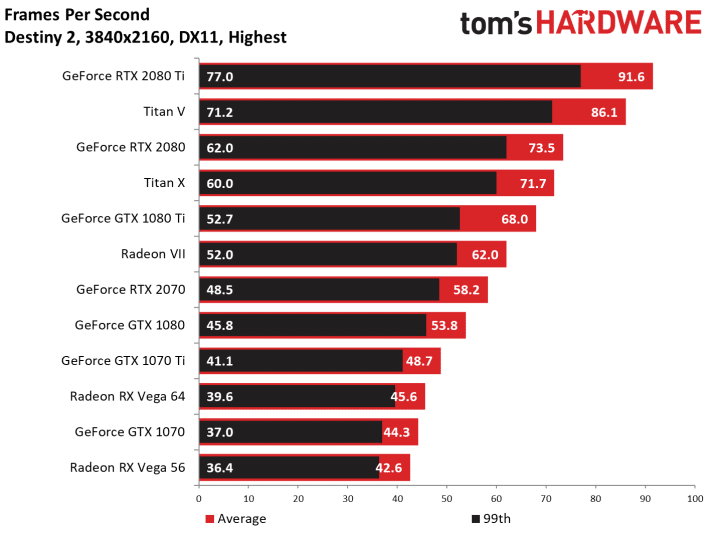

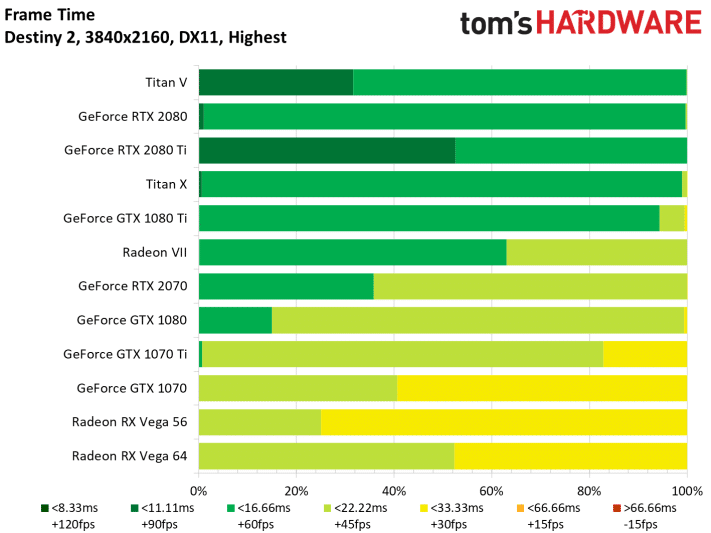

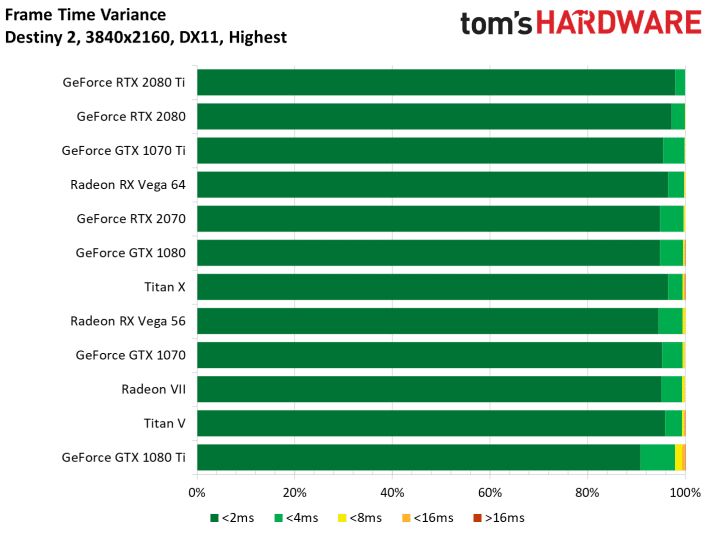

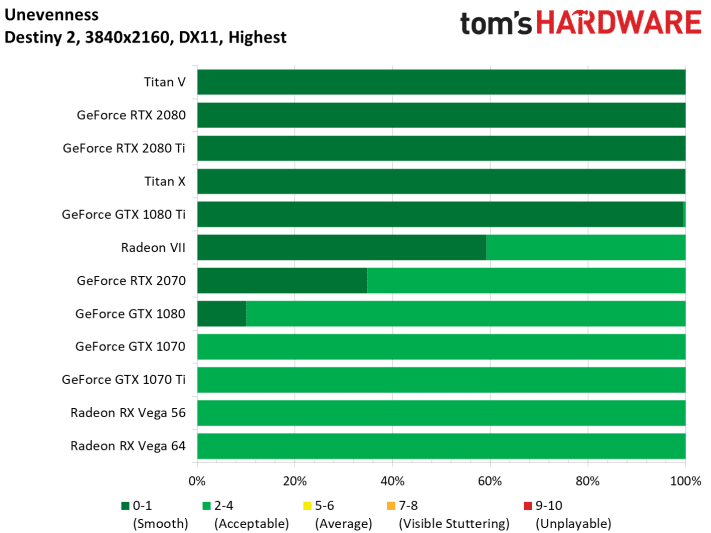

Destiny 2 (DX11)

GTA V (DX11)

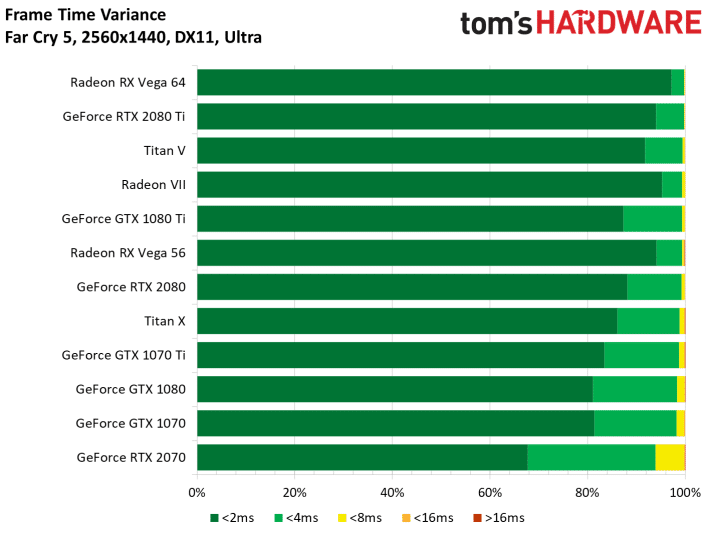

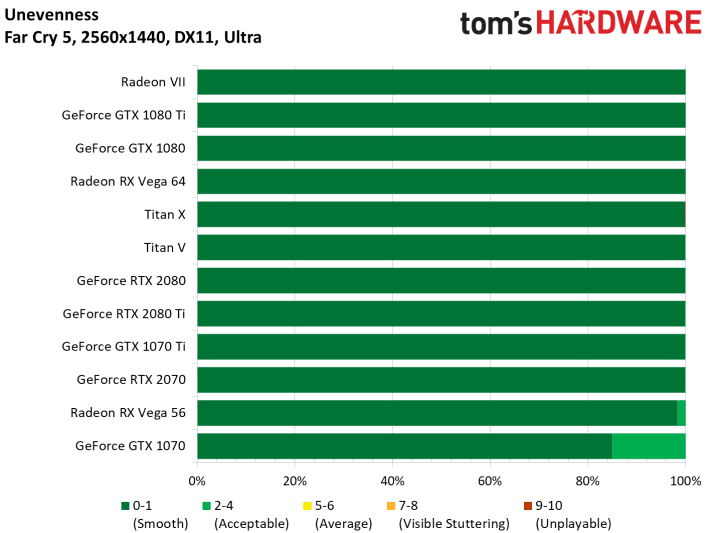

Far Cry 5 (DX11)

The Witcher (DX11)

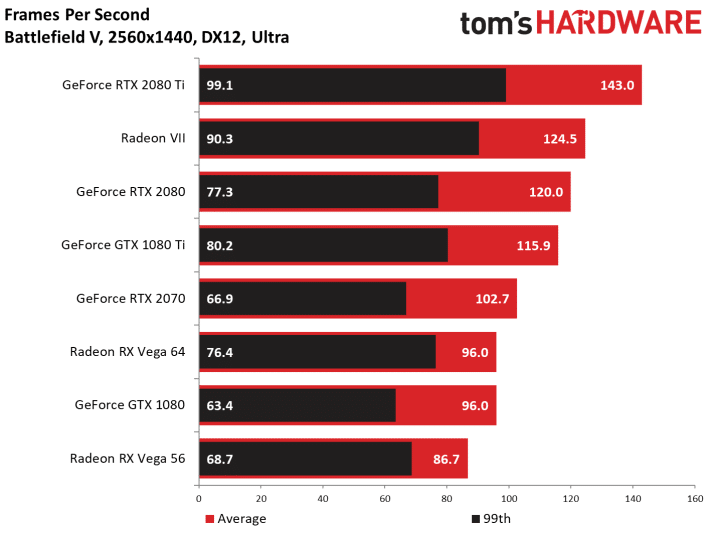

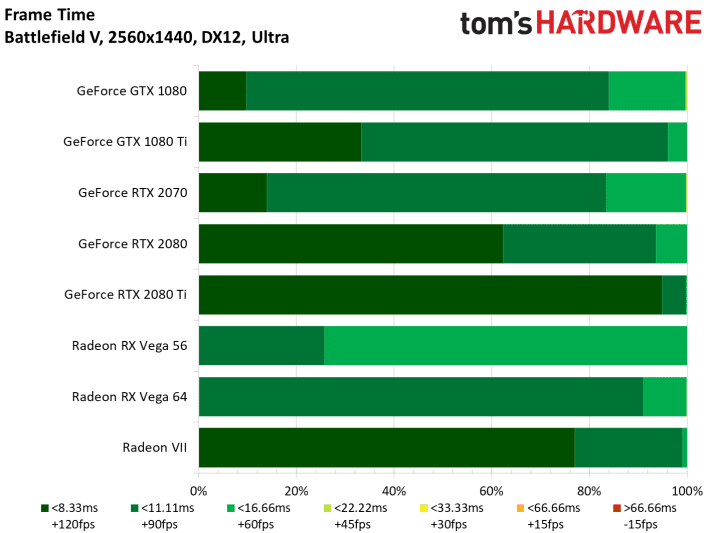

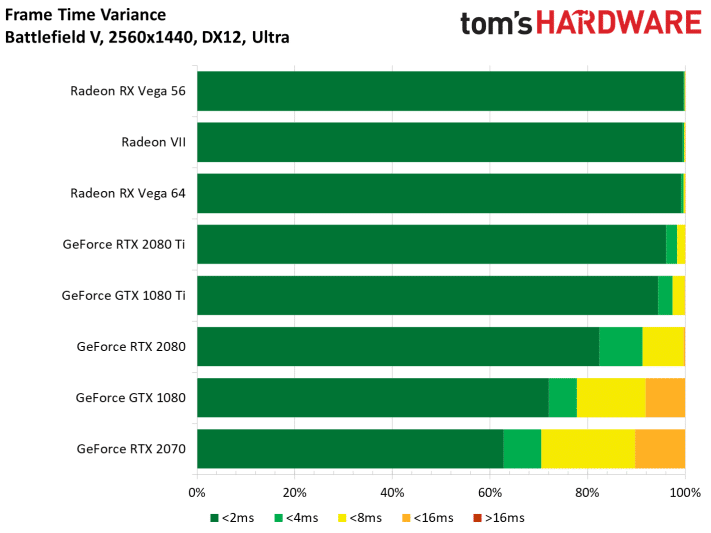

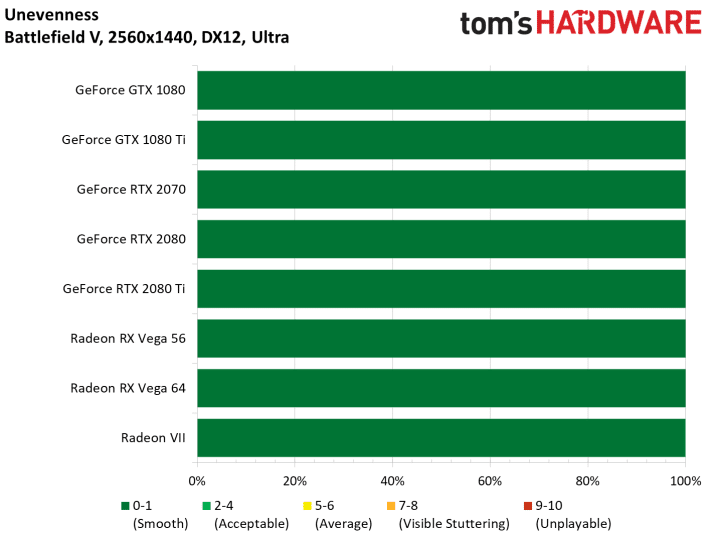

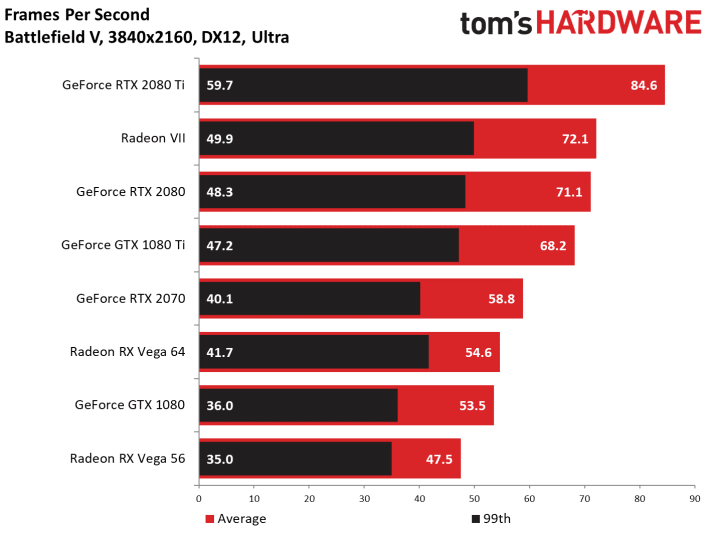

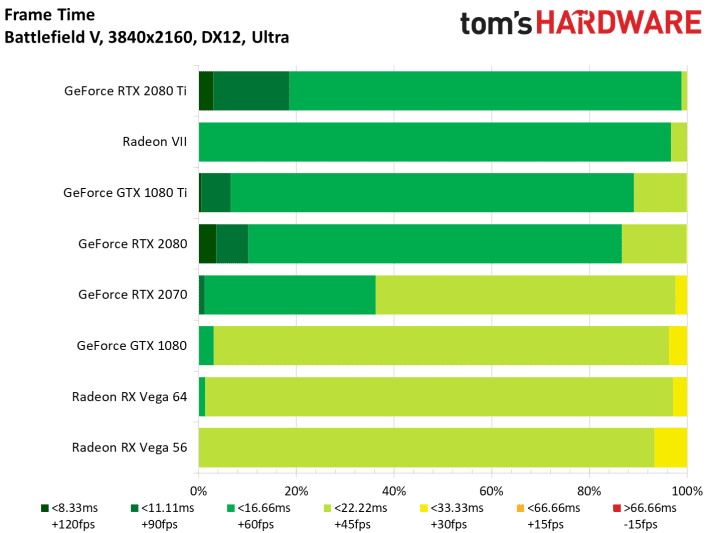

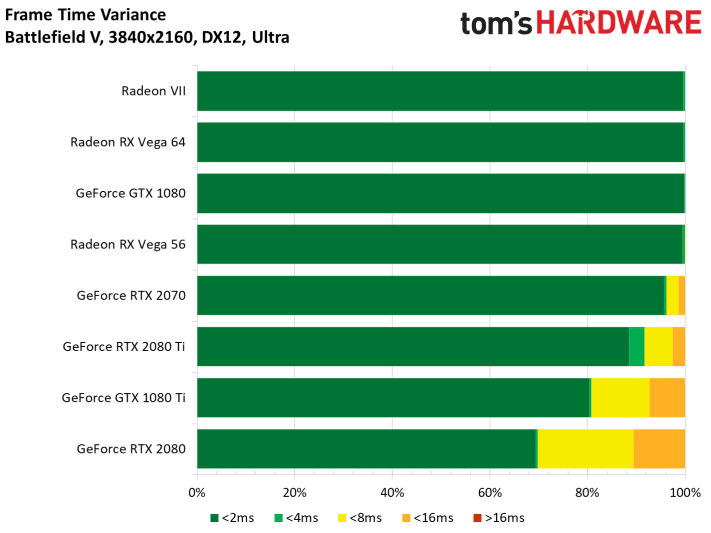

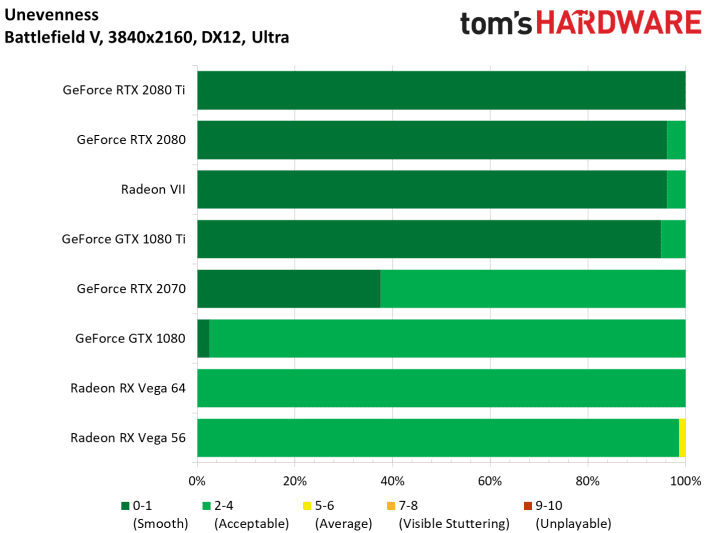

Battlefield V (DX12)

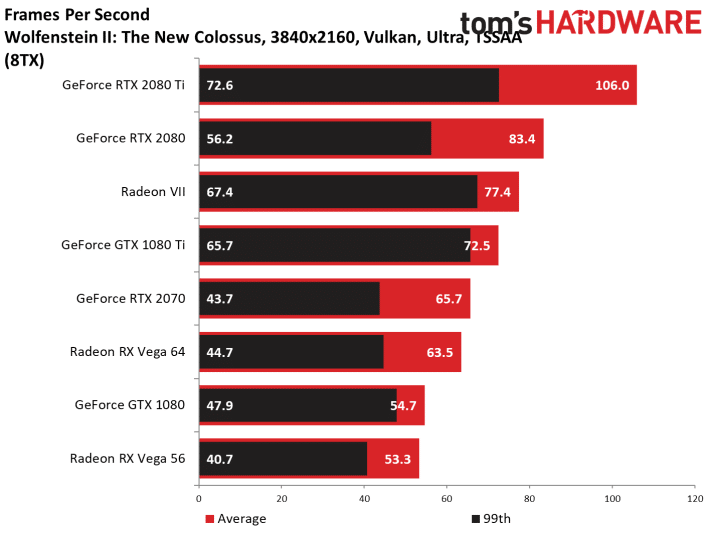

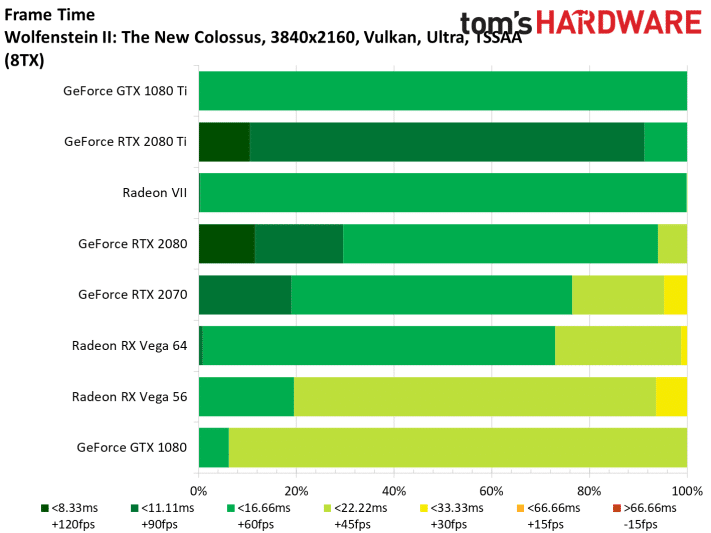

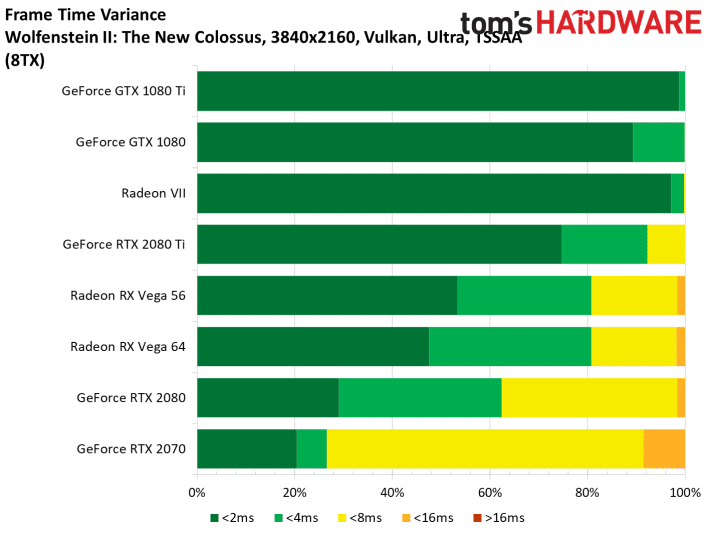

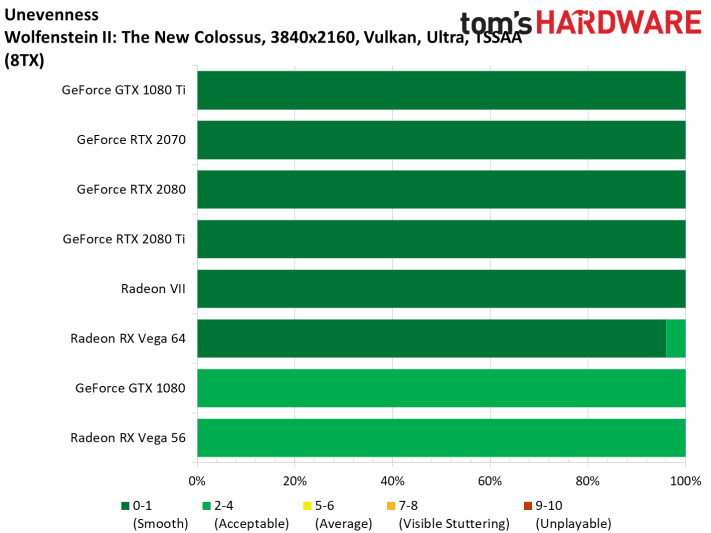

Wolfenstein II (Vulkan)

AoTS (DX12)

Rise of the Tomb Raider (DX12)

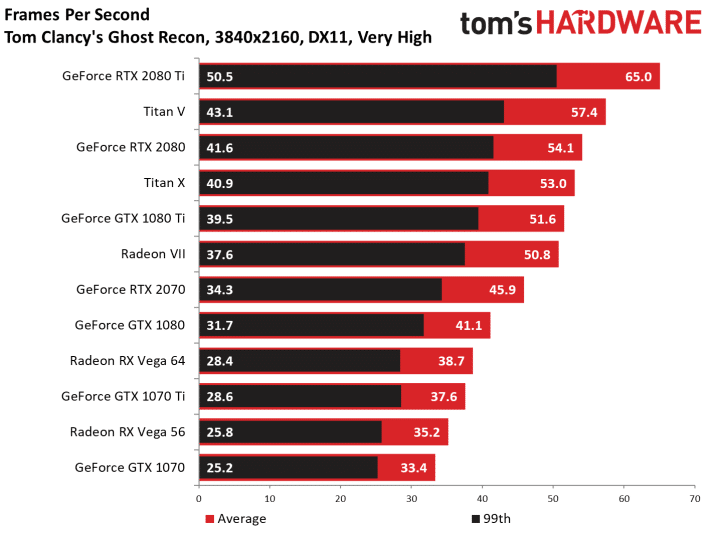

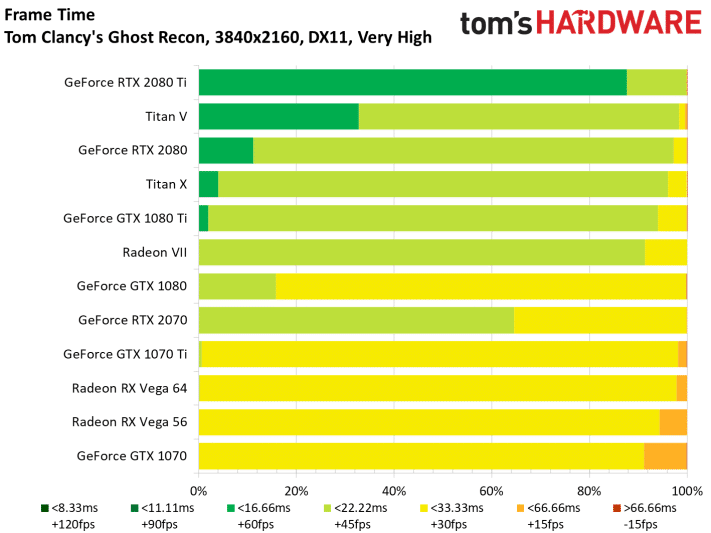

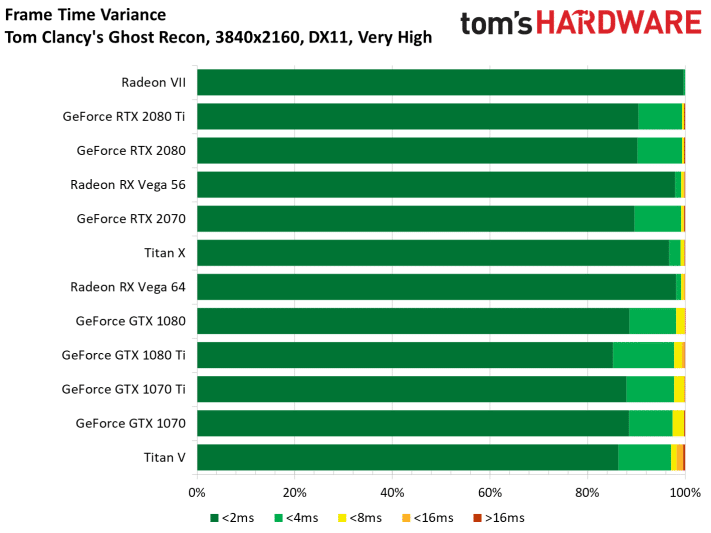

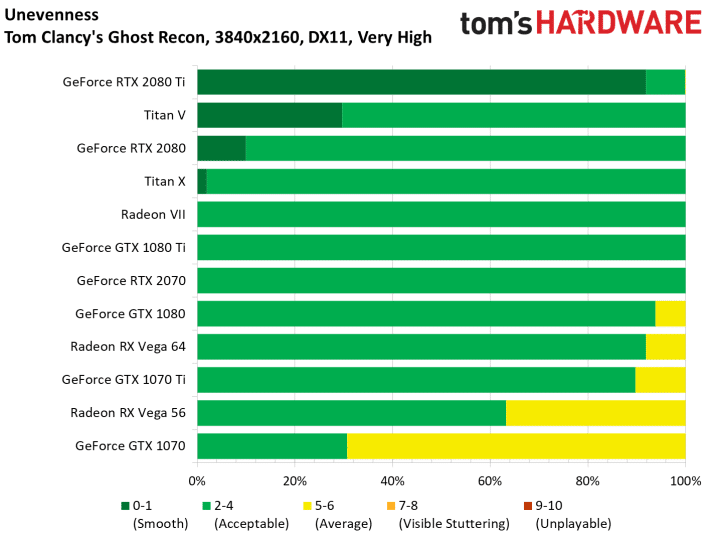

Ghost Recon (DX11)

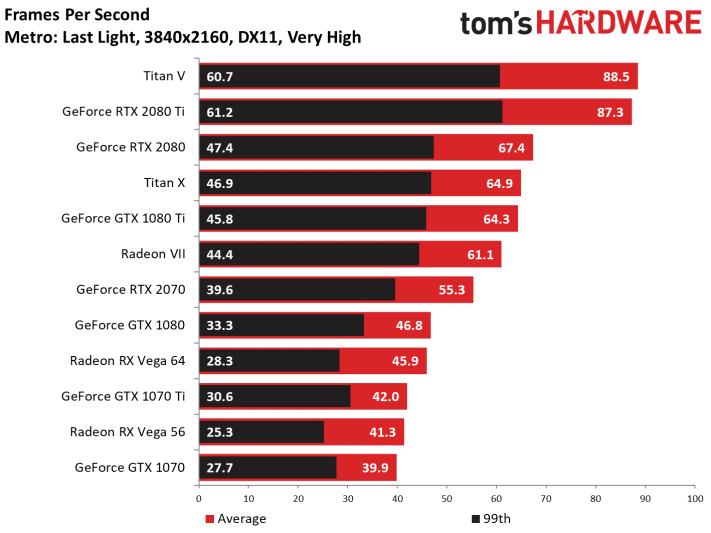

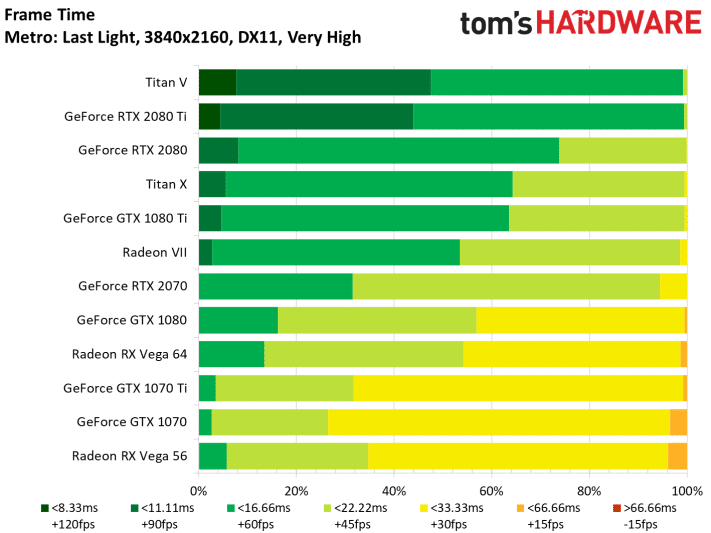

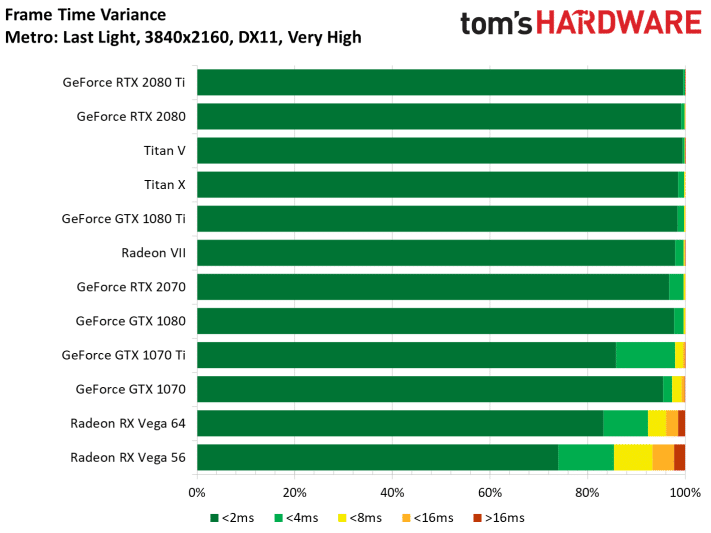

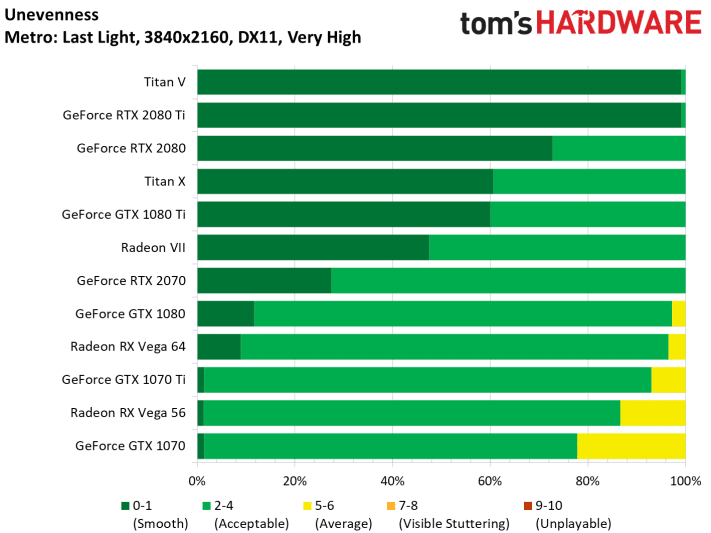

Metro Last Light (DX11)

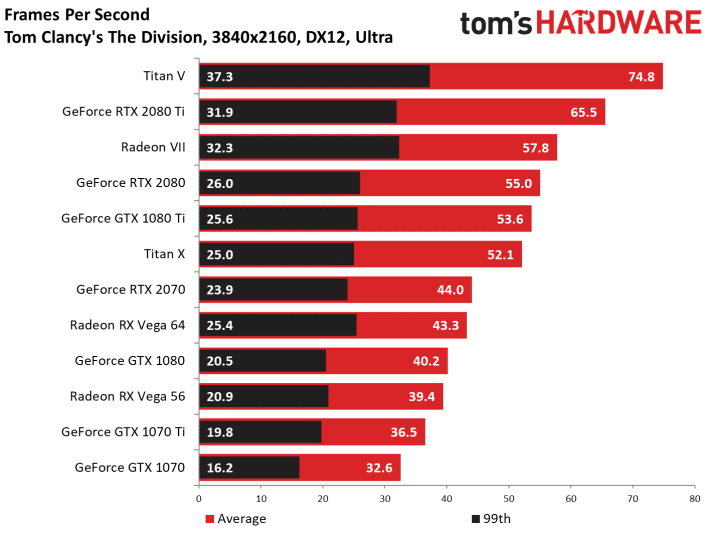

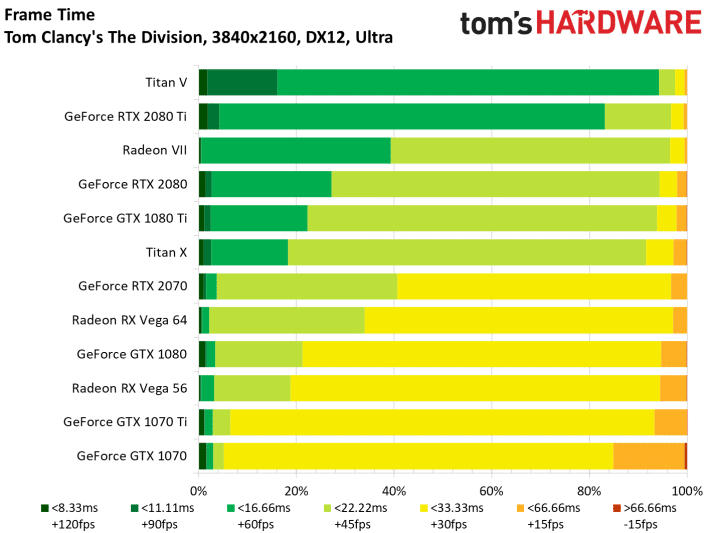

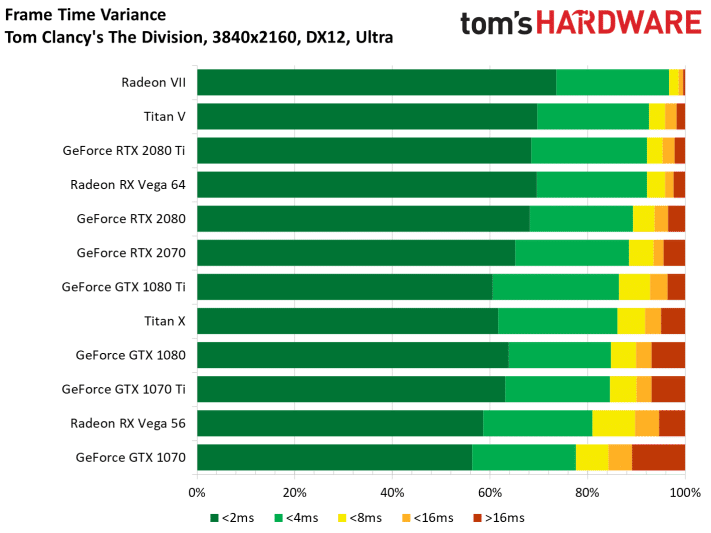

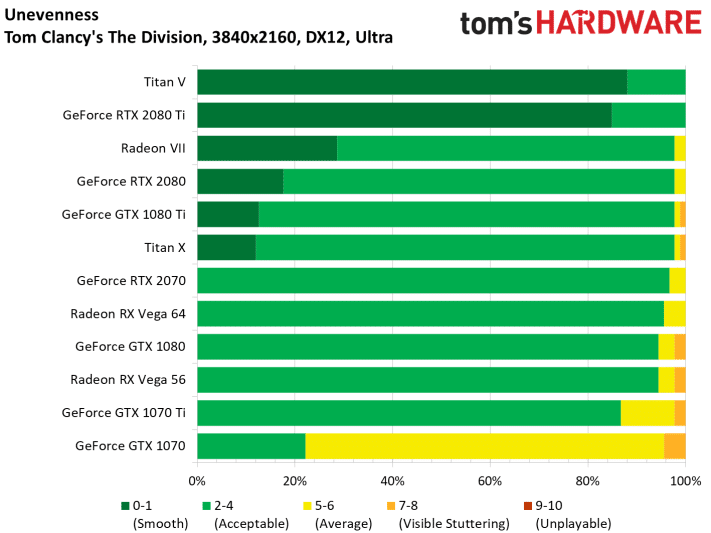

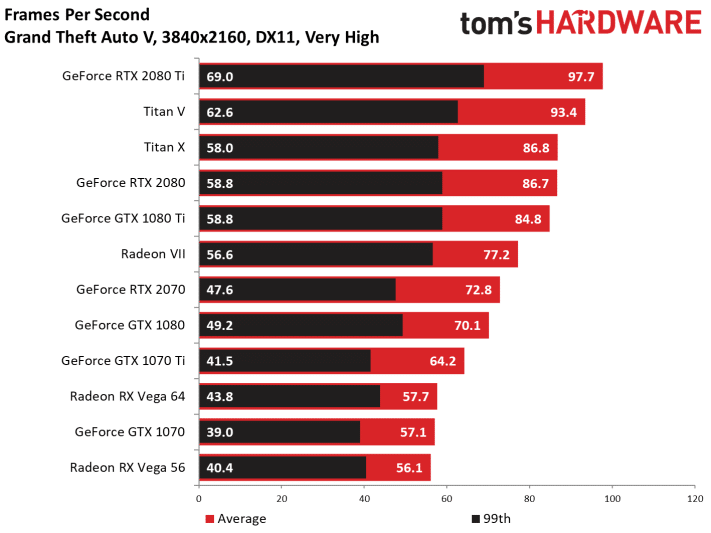

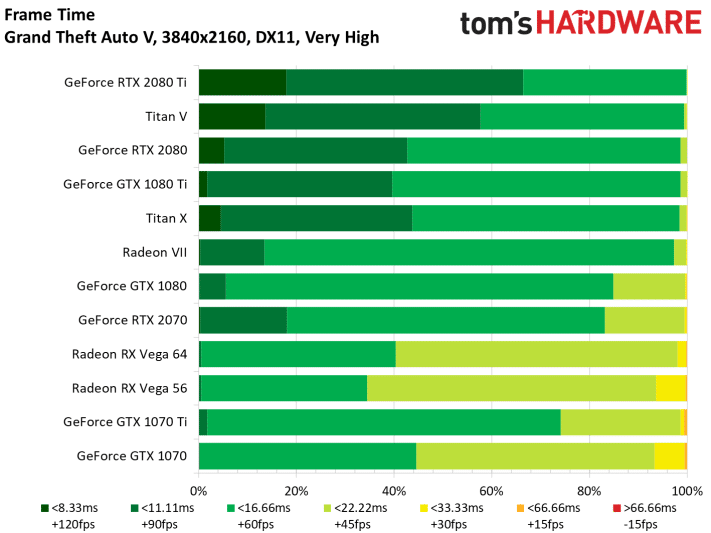

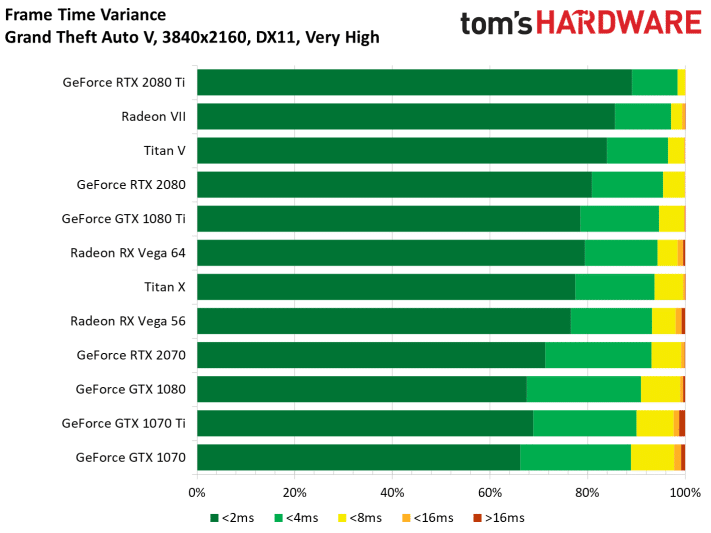

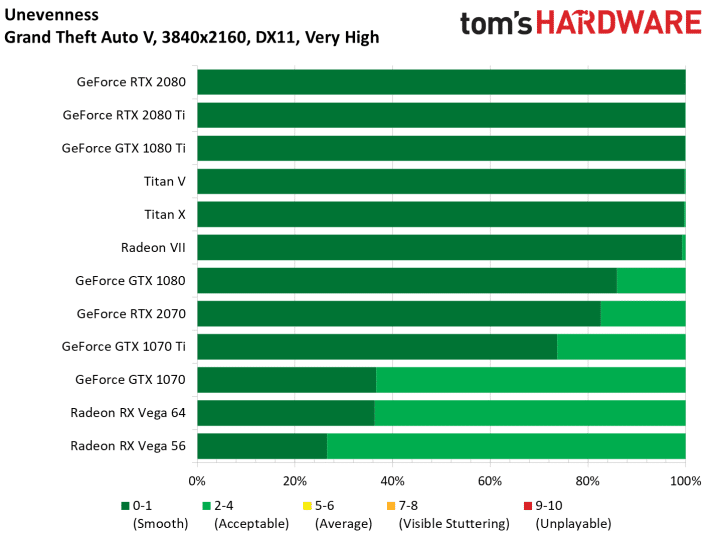

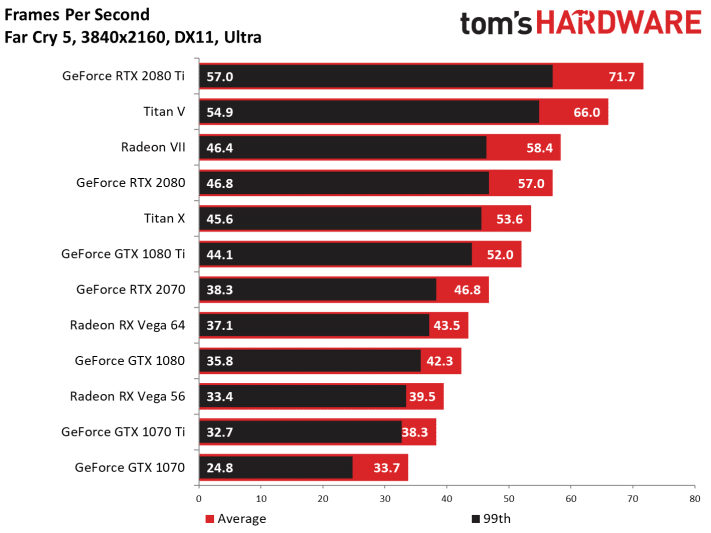

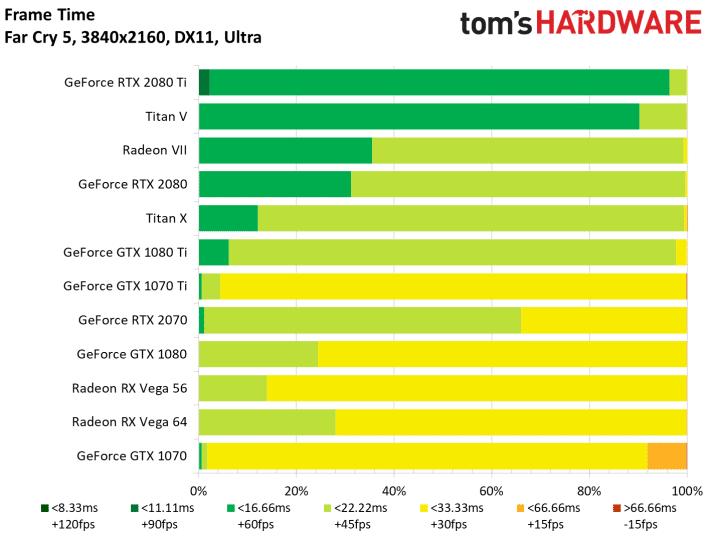

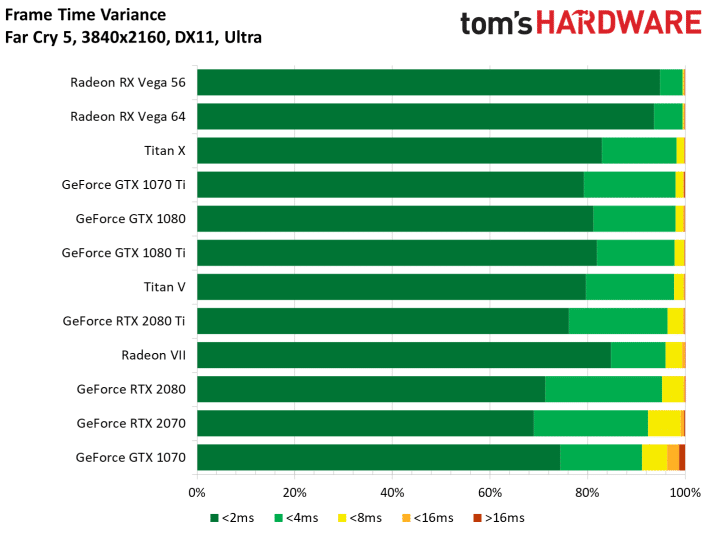

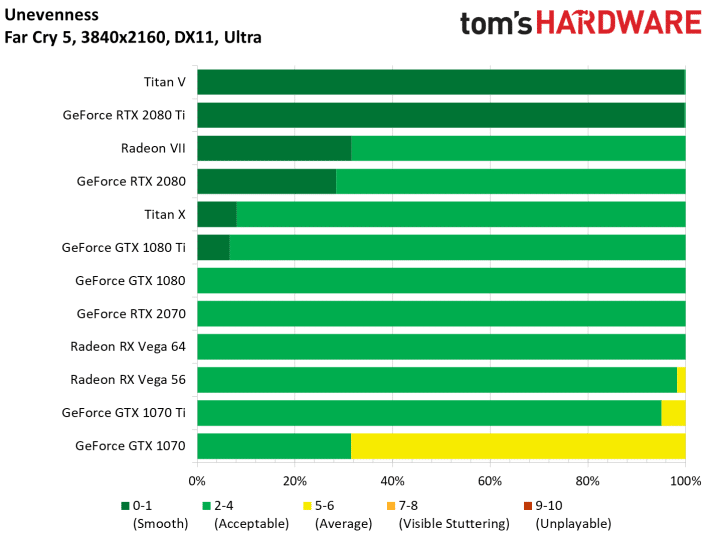

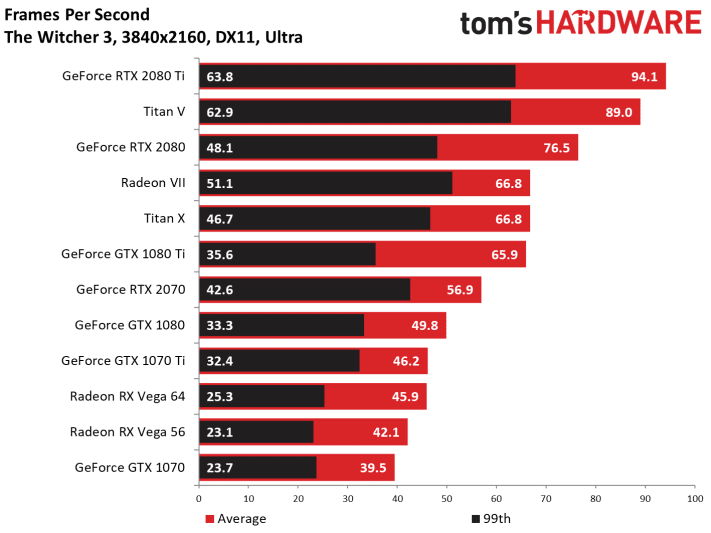

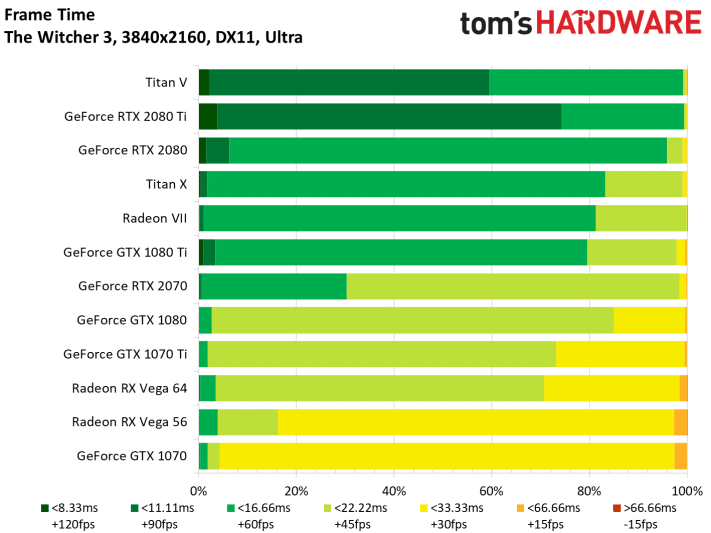

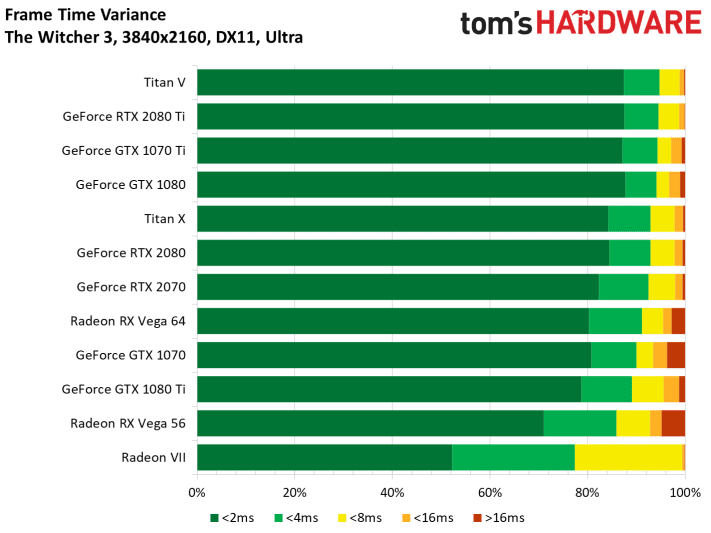

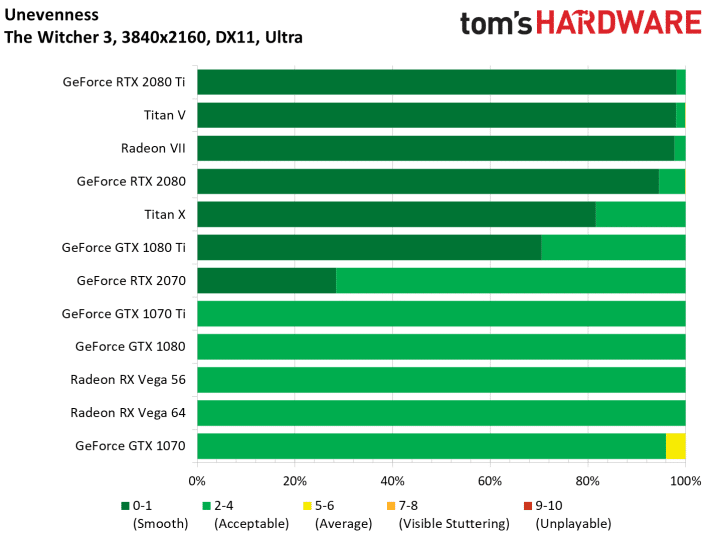

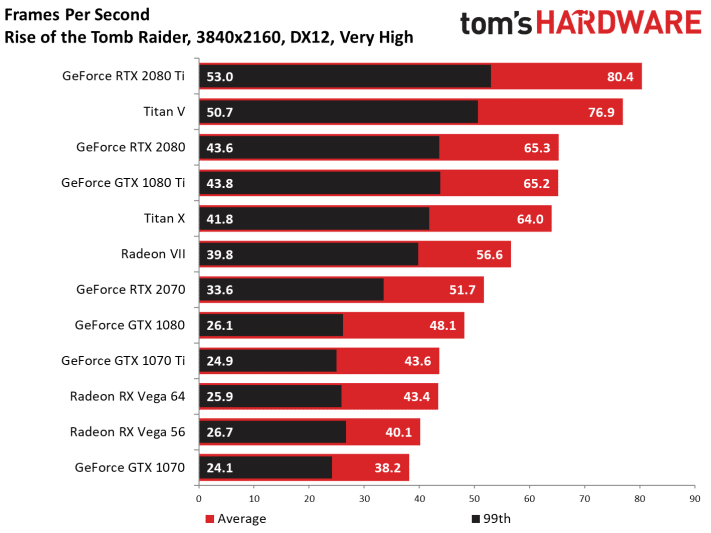

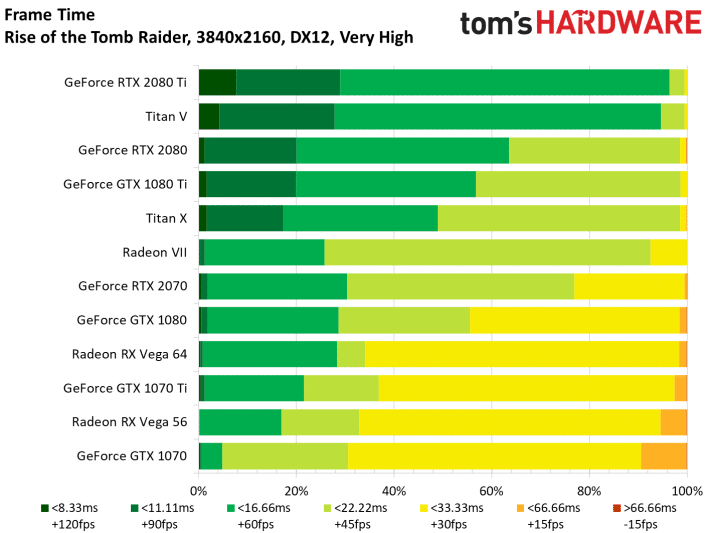

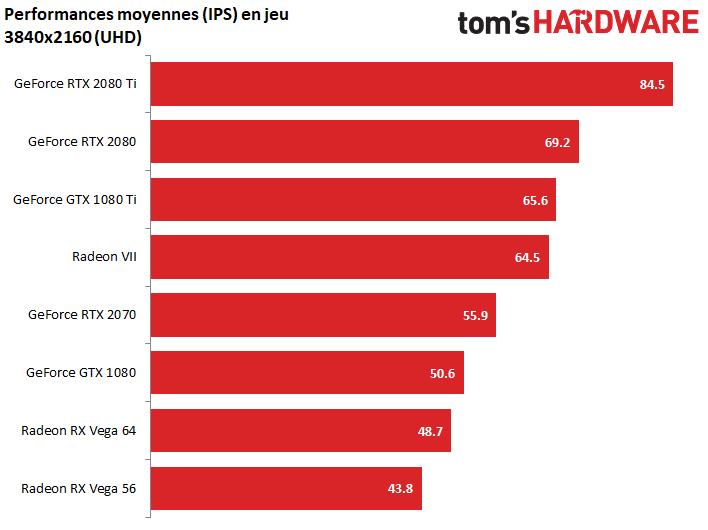

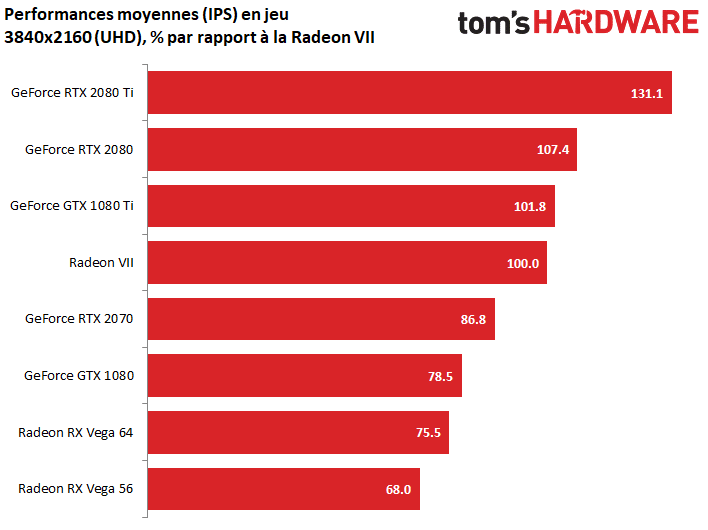

Tests en 4K / UHD

Le passage en Ultra-HD impose de baisser quelques options graphiques pour préserver une bonne fluidité en jeu avec la Radeon VII. Ici, le passage à 16 Go de RAM HBM2 et la bande passante de 1 To/s va aider la carte à améliorer ses performances : la Radeon VII creuse l’écart avec la Vega 64, avec 33 % de performances supplémentaires en moyenne, passant la barre symbolique des 60 fps.

La Radeon VII se rapproche aussi de la RTX 2080, à 93 % de ses performances. Il nous reste désormais à vérifier spécifiquement dans un prochain test les affirmations d’AMD, comme quoi la présence de 16 Go de RAM permettrait à la Radeon VII d’offrir une meilleure fluidité que les cartes à 8 et 11 Go de RAM en 4K… D’après ces premiers tests, certains jeux pourraient effectivement en tirer parti, d’autres non.

The Division (DX12)

Destiny 2 (DX11)

GTA V (DX11)

Far Cry 5 (DX11)

The Witcher (DX11)

Battlefield V (DX12)

Wolfenstein II (Vulkan)

AoTS (DX12)

Rise of the Tomb Raider (DX12)

Ghost Recon (DX11)

Metro Last Light (DX11)

Performances en calcul et rendu

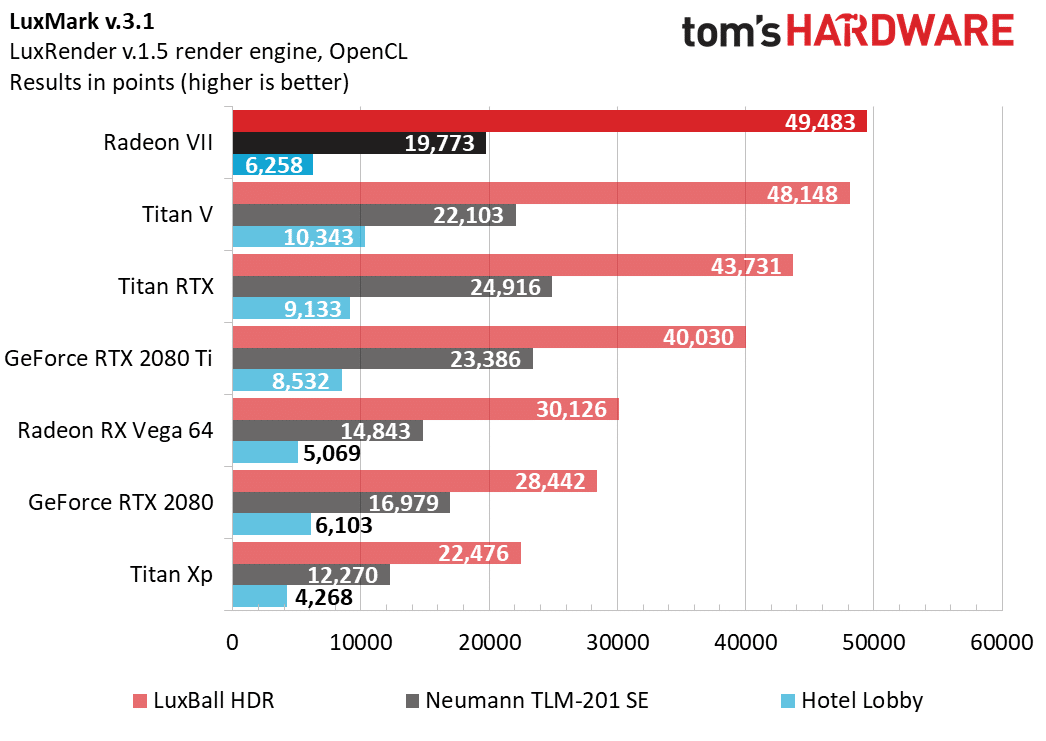

LuxMark

La dernière version de LuxMark est basée sur une mise à jour 1.5 du moteur LuxRender, ce qui nous a imposé de retester toutes les cartes. Le résultat est mitigé pour la Radeon VII, qui reste tout de même dans le haut du panier, et clairement au dessus de la RTX 2080.

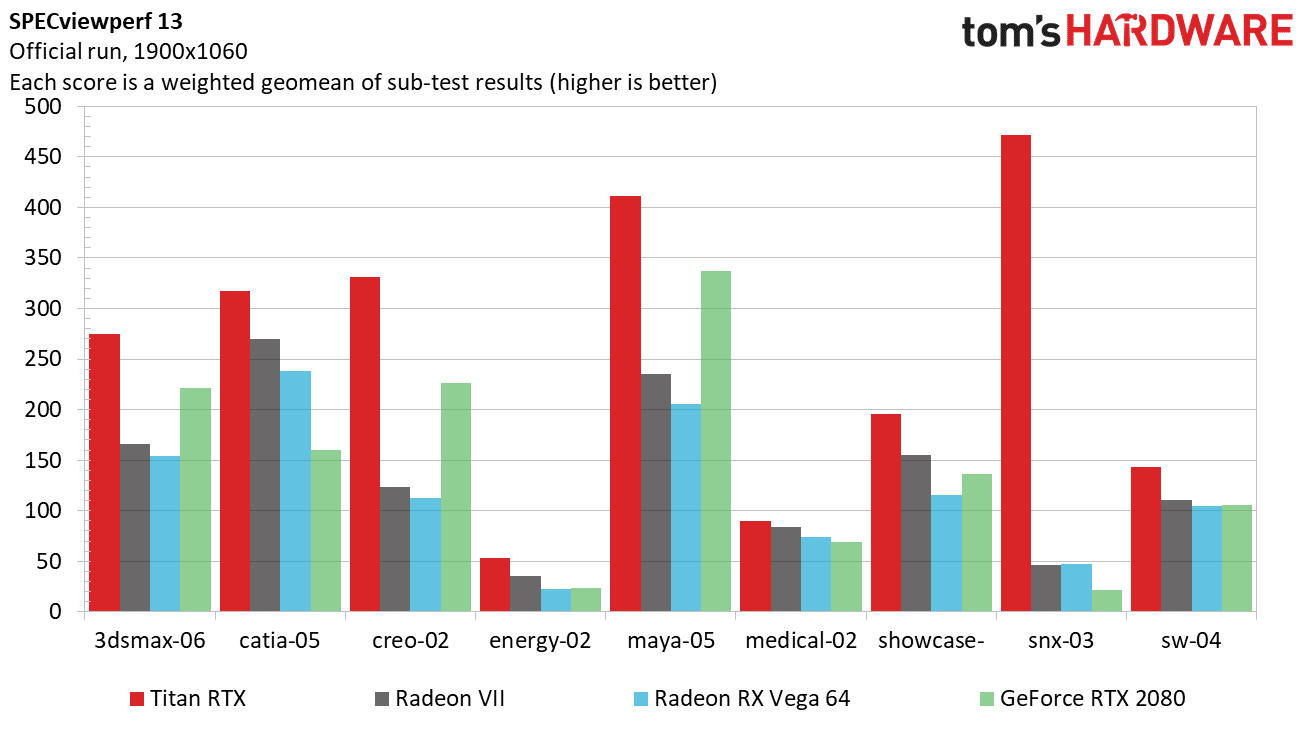

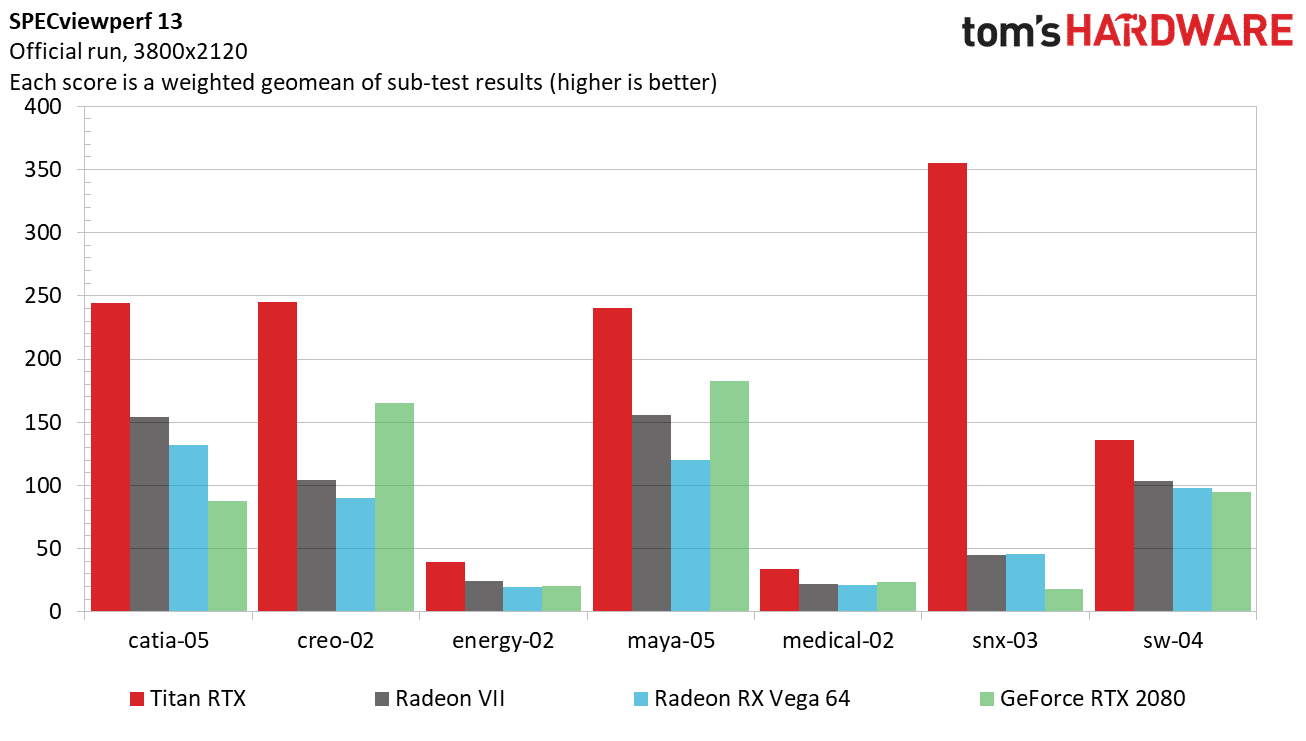

SpecViewPerf

Ce kit de test regroupe plusieurs épreuves sous les logiciels Autodesk 3ds Max, Dassault Systemes Catia, PTCCreo, Autodesk Maya, Autodesk Showcase, Siemens NX, et Dassault Systemes SolidWorks. Deux autres tests (Energy et Medical) ne sont pas basés sur des logiciels particuliers.

Ici, la Radeon VII affiche des performances de haut vol, mais la RTX 2080 reste globalement plus efficace.

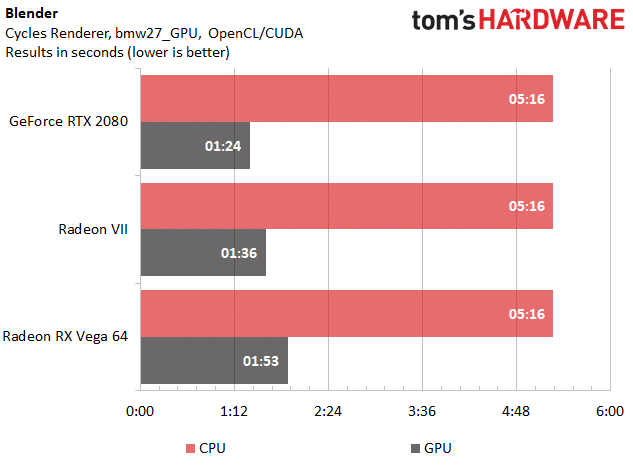

Blender

Le test de Blender donne l’avantage à la RTX 2080, mais on voit que la Radeon VII apporte encore des performances nettement supérieures à celles de la Vega 64.

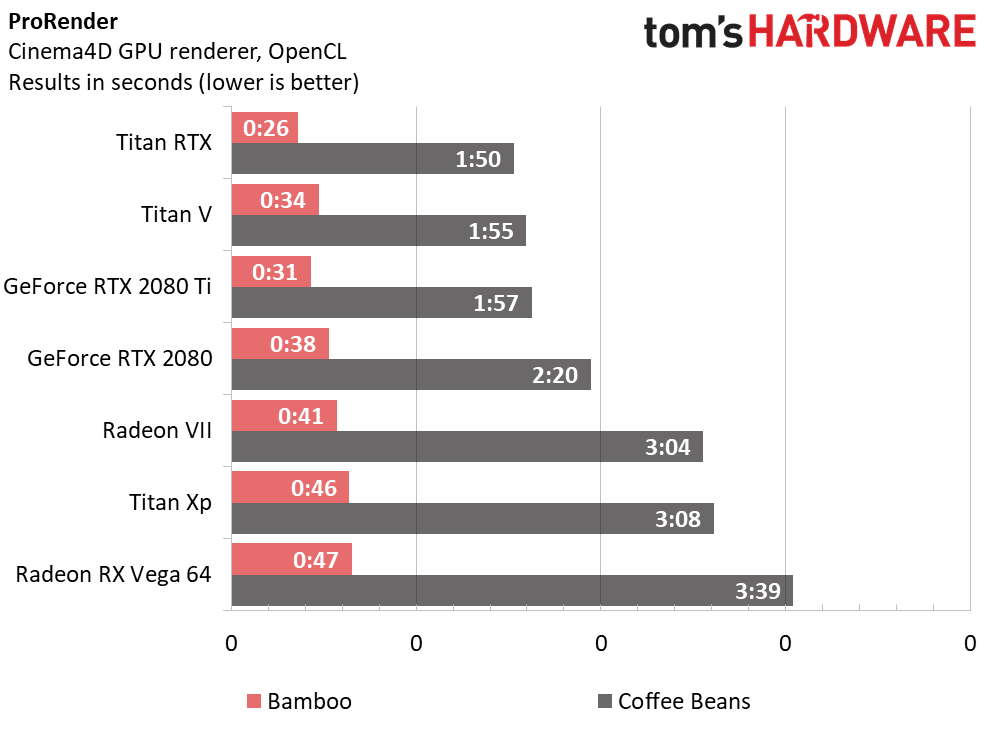

Cinema4D

ProRender est un moteur de rendu sur GPU, qui utilise OpenCL au lieu de CUDA (par rapport au moteur Arion Render). Il est plus rapide car il base ses calculs sur des estimations, et pas sur du calcul pixel par pixel.

La Radeon VII se met au niveau d’une Titan Xp, ce qui est une bonne performance, mais elle ne peut pas surpasser la dernière génération Turing de NVIDIA.

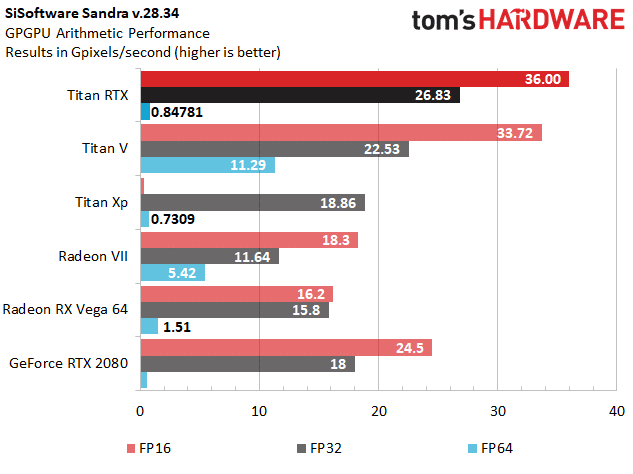

Sisoftware Sandra

Ce test synthétique est moins crucial pour notre article, mais nous le publions pour les plus curieux, afin d’avoir une estimation pratique des puissances de calcul annoncées par les fabricants.

Les résultats de la Radeon VII sont toutefois intéressants : plus puissante que prévue en FP64, en retard sur la Vega 64 en FP32. Face à la RTX 2080, elle est à la traîne en FP32 et FP16. Effectivement, AMD nous a confirmé avoir fait une erreur dans le vBIOS de la carte au lancement : les performances FP64 ne sont pas bridées à 1/16, mais à 1/4, ce qui explique la bonne surprise de ce test en double précision !

Consommation

Nous n’avons pas pu sérieusement tenter un overclocking de la Radeon VII, principalement à cause de son logiciel de contrôle Wattman (le seul compatible avec la carte pour l’instant), trop buggé pour l’instant. Sans oublier que le refroidissement est déjà poussé à ses limites, comme vous le verrez dans les pages suivantes.

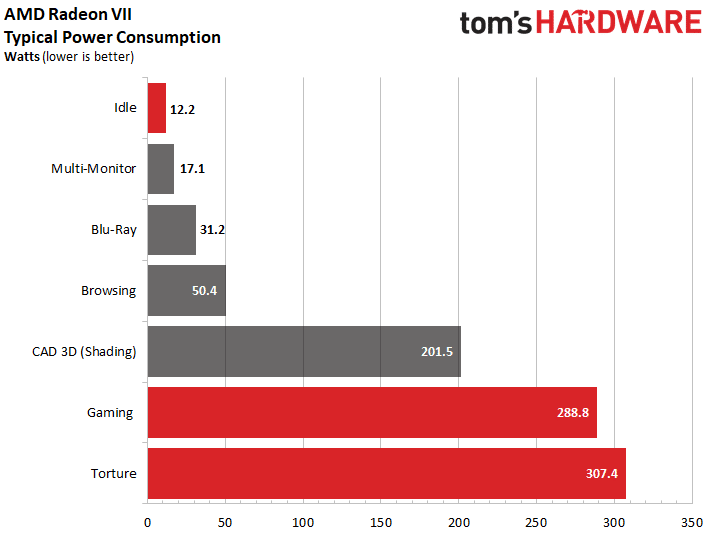

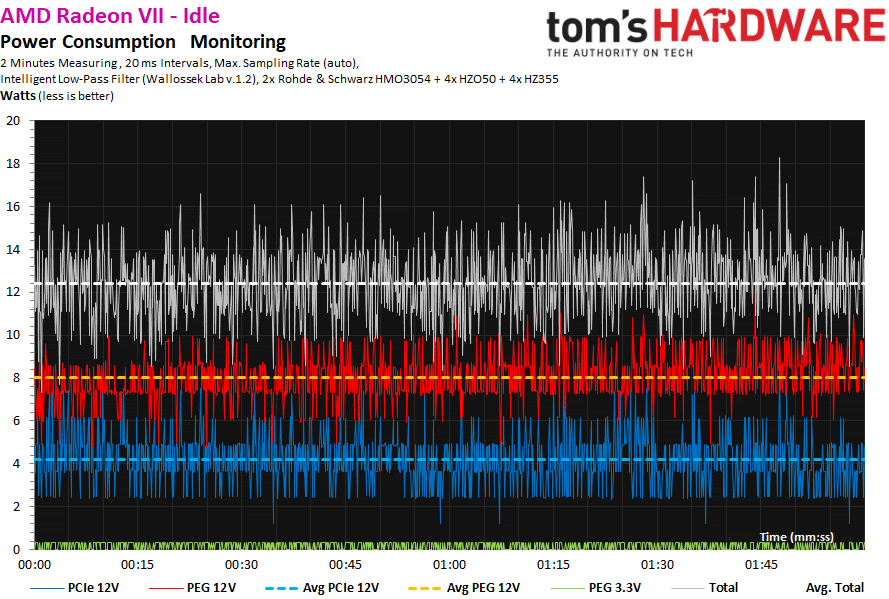

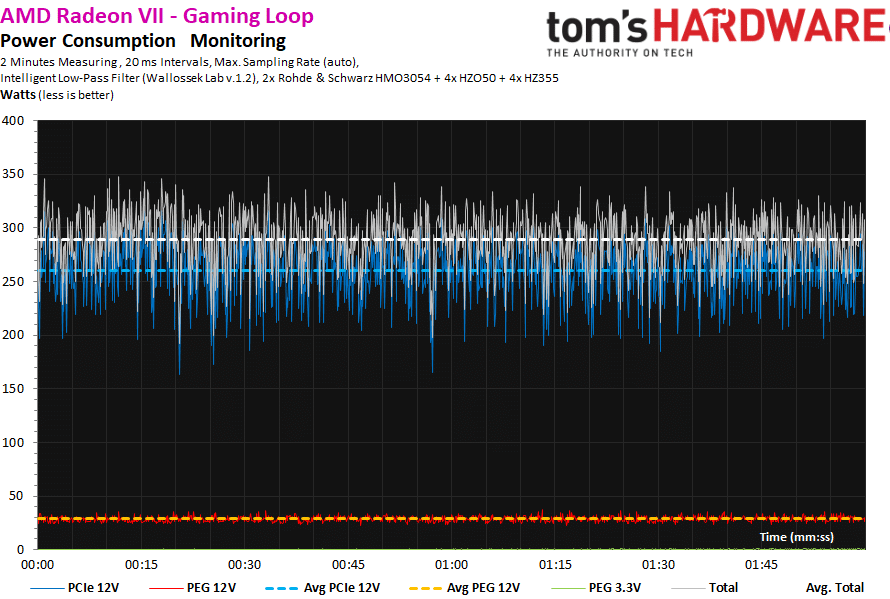

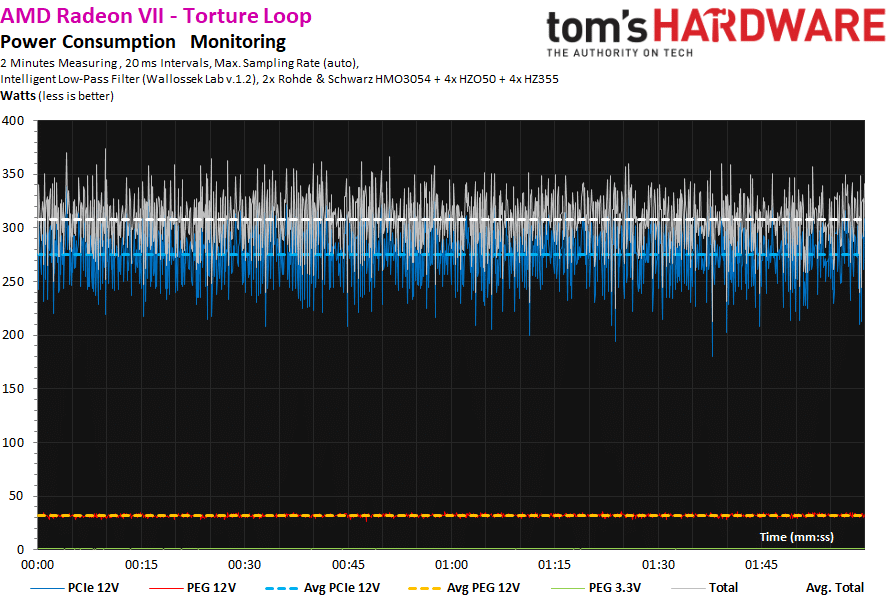

Consommations moyennes

Au repos sur un ou plusieurs moniteurs, la carte consomme moins que la RTX 2080 Founders Edition, qui monte à 17 et 20 W. En revanche, elle consomme 9 W de plus en lecture Blu-Ray et 10 W de plus en navigation Web. En gros, dès qu’on la sollicite, la consommation monte très vite. Elle dépasse même les limites de son TDP de 300 W en torture. En face, la RTX 2080 Founders Edition est à 225 W en jeu et en torture.

Côté tension du GPU, impossible de vous fournir des données fiables pour l’instant, car seul Wattman est capable de récolter les données des capteurs de la carte actuellement. Or, ce logiciel est buggé, trop lent dans ses mesures, et finalement pas fiable selon nous, avec des valeurs qui nous semblent peu vraisemblables. On attendra les logiciels tiers pour vous en dire plus.

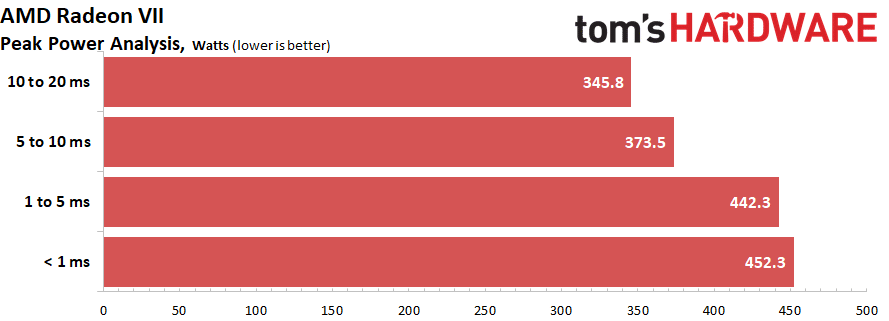

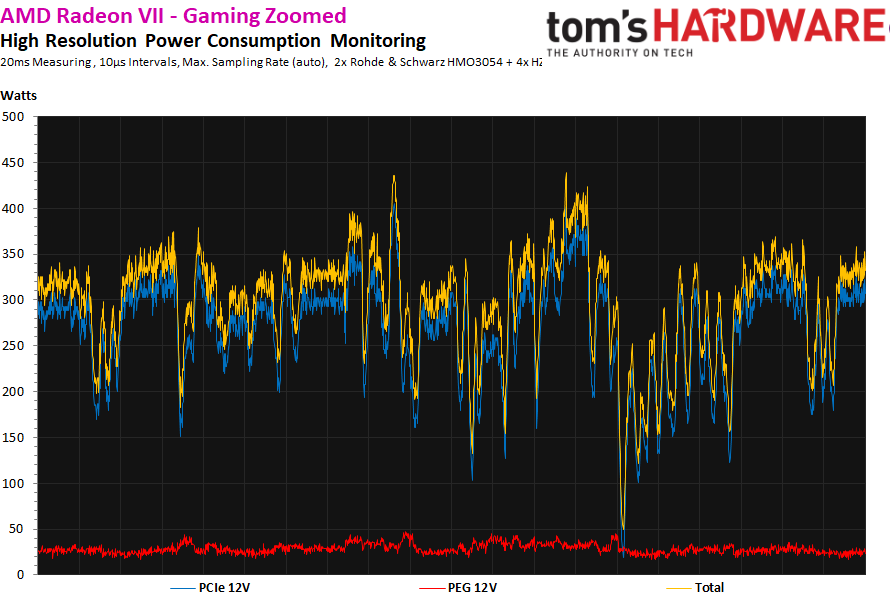

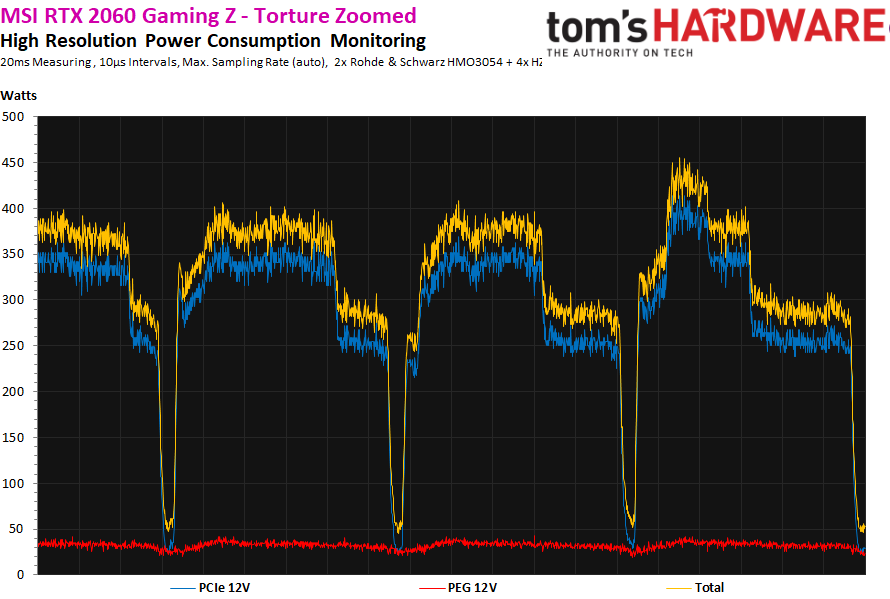

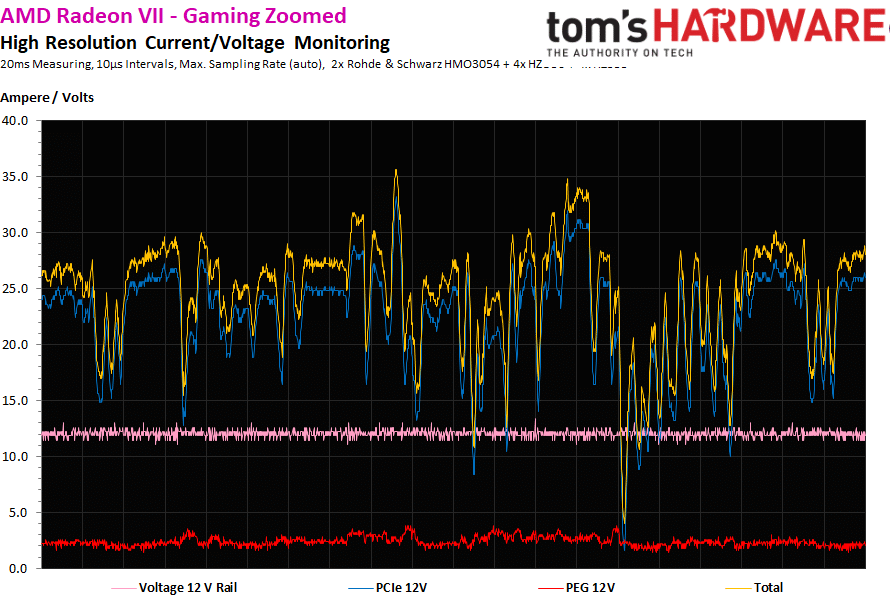

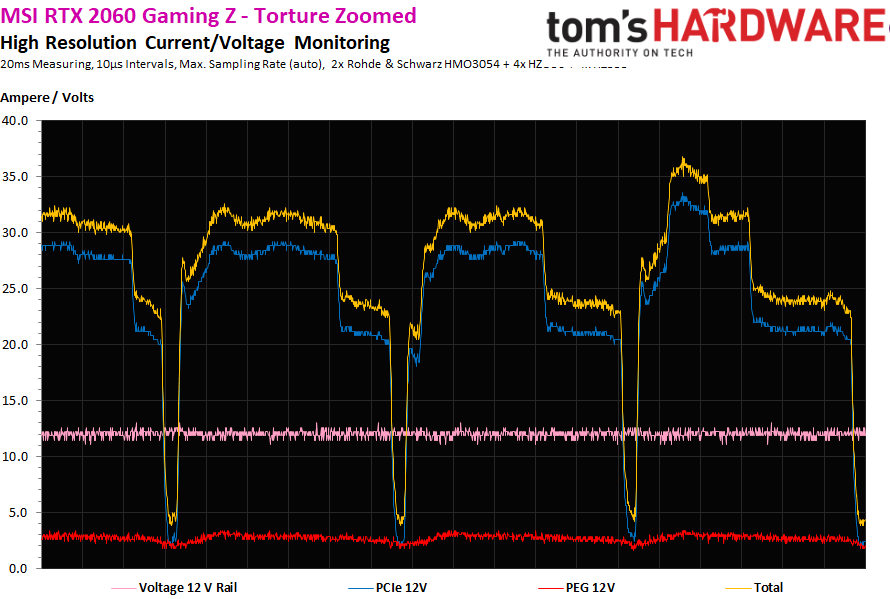

Pics de consommation

Les pics de consommation, mêmes très courts (moins de 10 ms) peuvent mener à l’extinction de sécurité du bloc d’alimentation. La carte peut tirer ici environ 450 W ponctuellement. Pour choisir votre alimentation, comptez plutôt 370 W minimum à consacrer à la Radeon VII afin d’assurer la stabilité de votre machine.

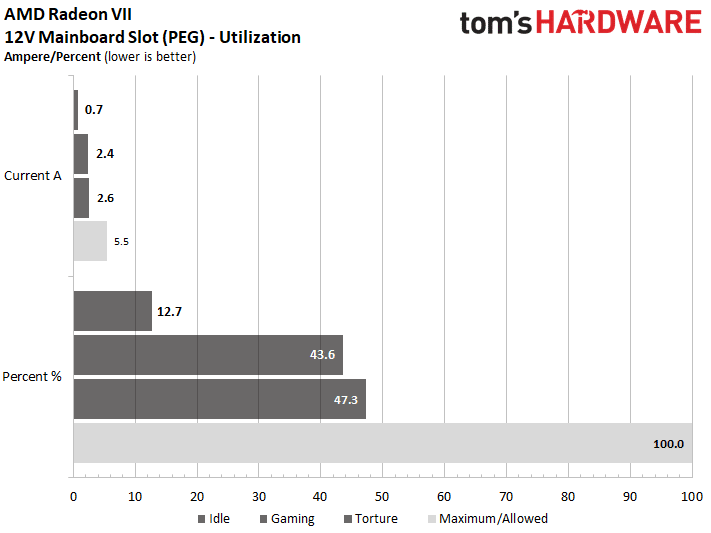

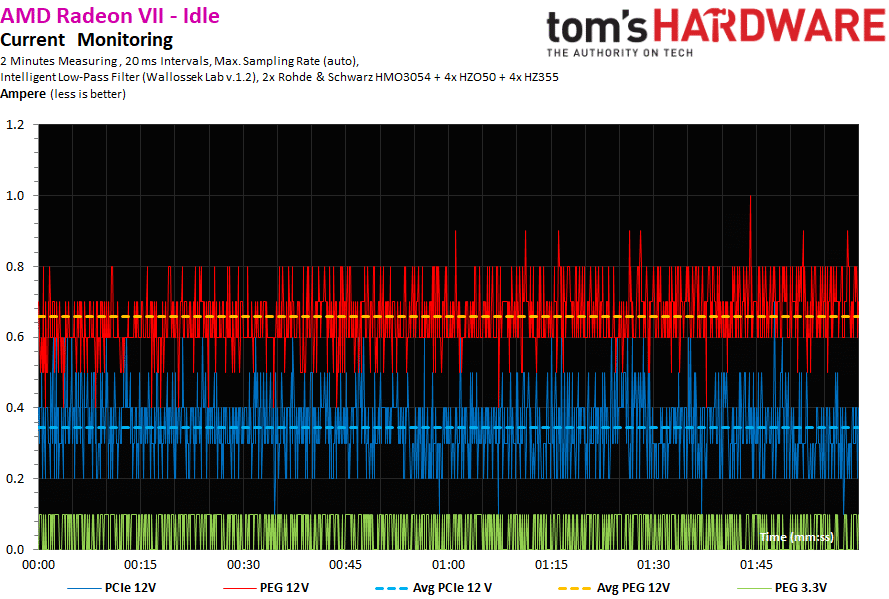

Charge sur le slot PCIe de la carte mère

Aucun problème à signaler quant à la charge qui pèse sur le slot PCIe de la carte mère. La carte tire même un Ampérage assez faible de cette source d’alimentation.

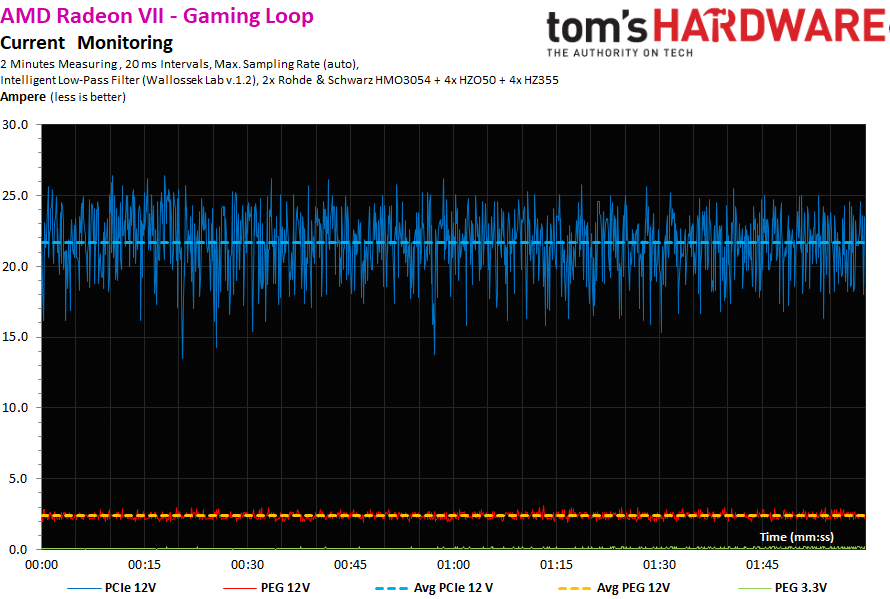

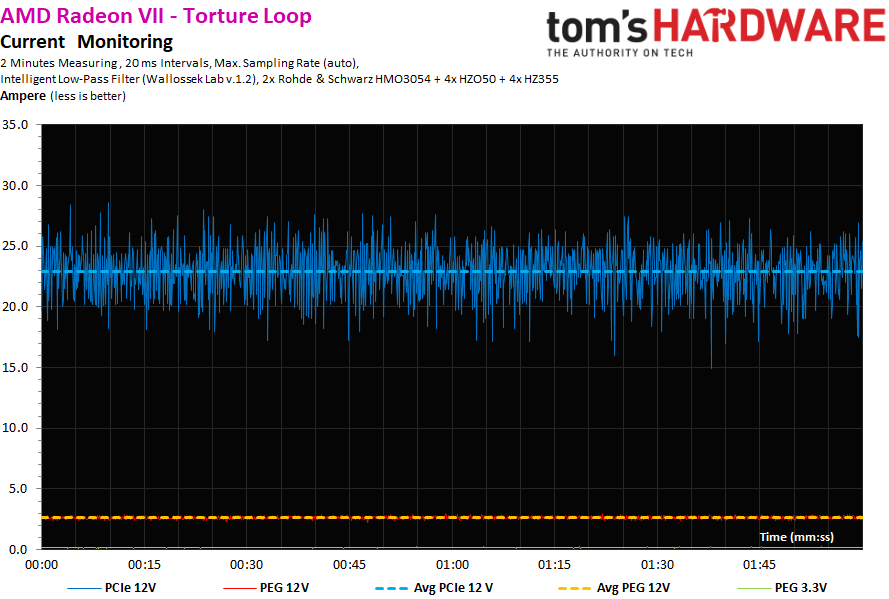

Graphiques détaillés de conso

Puissance

Intensité

Températures et fréquences

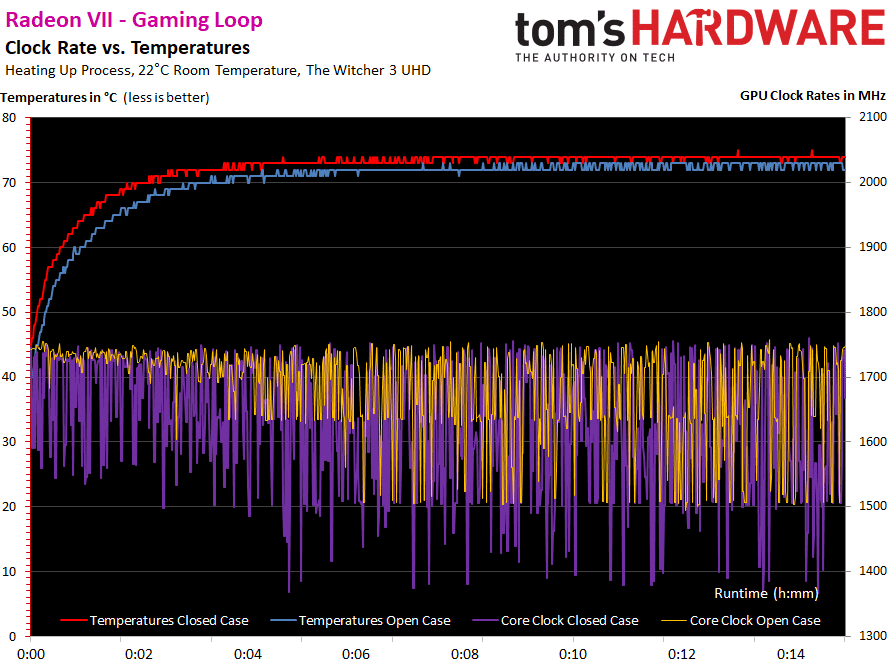

Fréquence en fonction de la température

Une fois que le GPU est à sa “température de croisière”, le comportement de sa fréquence est assez singulier. A en croire ses capteurs, la température du GPU est relativement peu élevée.

Rien à voir avec le Boost des GeForce cette fois. Le GPU oscille entre 1500 et 1740 MHz, et dans un boîtier fermé, avec seulement 2°C de plus sur le GPU, la fréquence peut baisser régulièrement à 1367 MHz. C’est la première fois que l’on constate ce type de comportement. Difficile d’en conclure une fréquence moyenne, les oscillations étant très erratiques et les mesures trop lentes par Wattman. Notez qu’en torture, Wattman n’apportait plus aucune information.

Voilà toutes les informations résumées dans un tableau :

| Cartes |

Début de test AMD Radeon VII |

Fin de test AMD Radeon VII |

Fin de test GeForce RTX 2080 FE |

| Boîtier ouvert | |||

| Température GPU | 34 °C | 73 °C | 75°C |

| Fréquence GPU | 1758 MHz | 1498 à 1741 MHz (alternance) | 1815 MHz |

| Température ambiante | 22 °C | 22 °C | 22°C |

| Boîtier fermé | |||

| Température GPU | 36 °C | 75 °C | 75°C |

| Fréquence GPU | 1755 MHz | 1367 à 1747 MHz (alternance) | 1800 MHz |

| Température ambiante | 23°C | 46°C | 43°C |

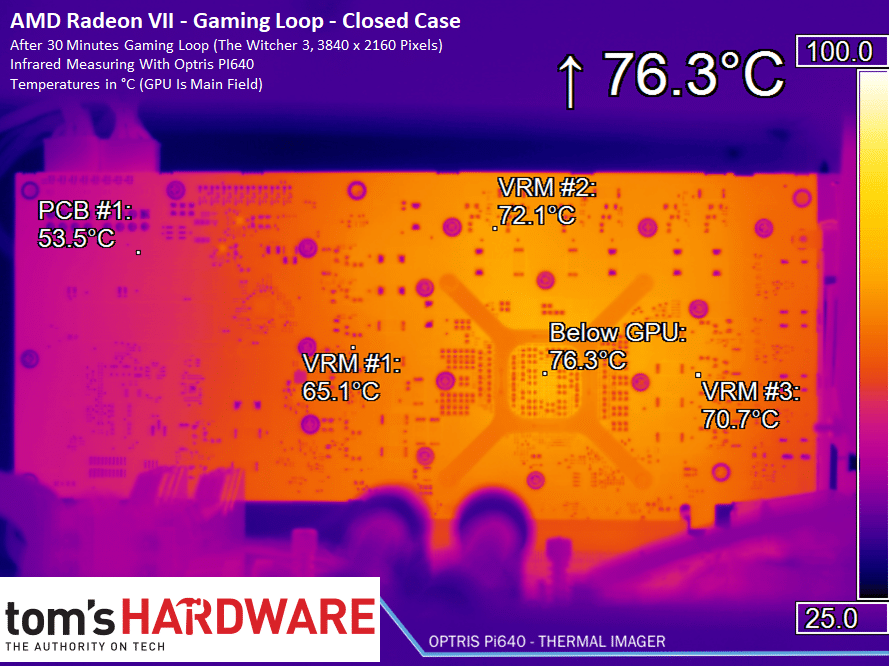

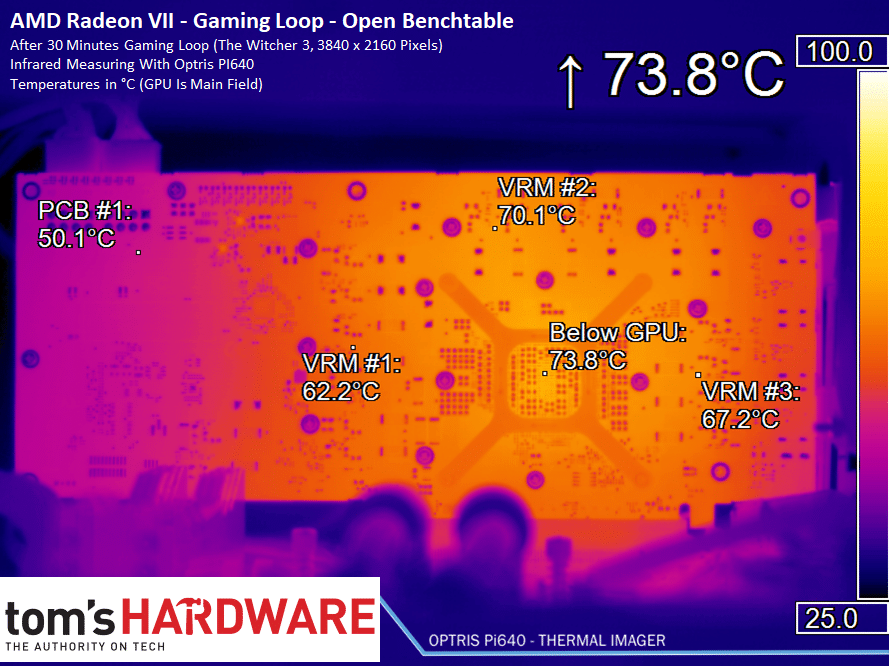

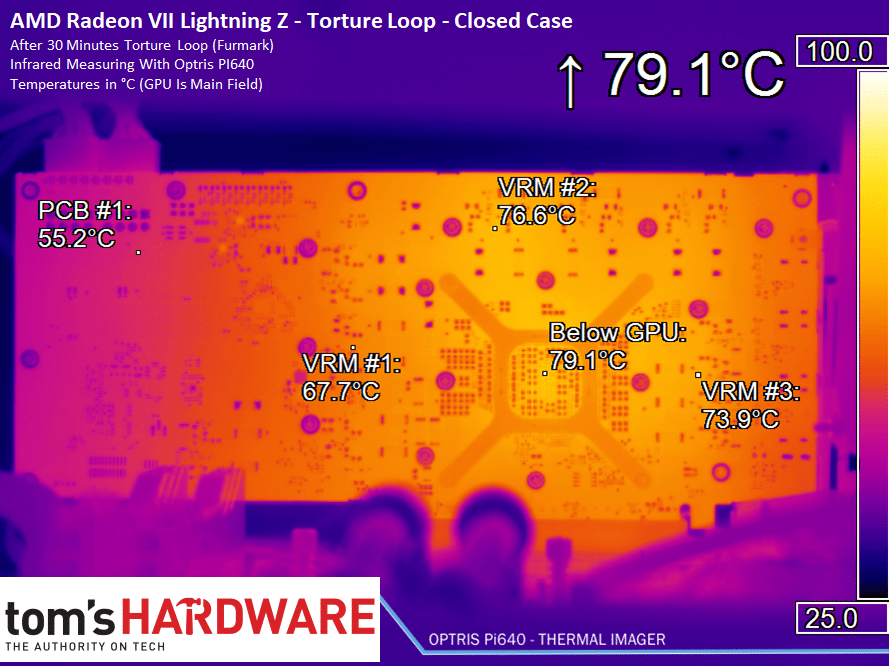

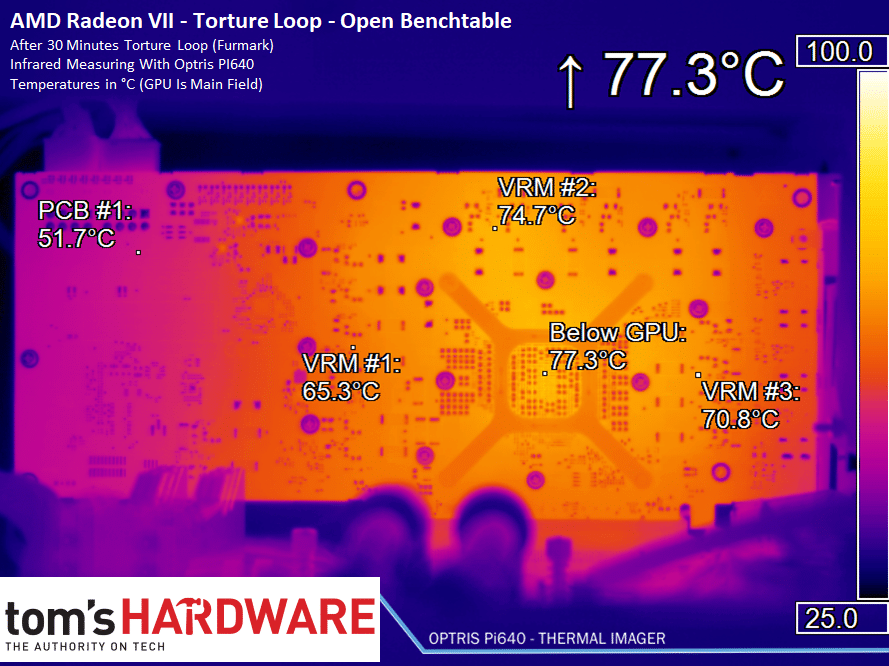

Températures via images thermiques

La carte a été traitée par une laque spéciale pour obtenir une surface avec une émissivité de 0,975, et les mesures ont été prises pile à 90° de la surface. Sachez que sans ces deux conditions, les températures relevées par une caméra thermique sont faussées (bien trop basses) et donc inutiles. Ces images nous permettent ici de contourner les difficultés posées par le logiciel Wattman.

On constate ici que le dissipateur fait plutôt bien son boulot sur tout le PCB en termes de températures, mais à quel prix côté nuisances sonores ?

Gaming

Torture

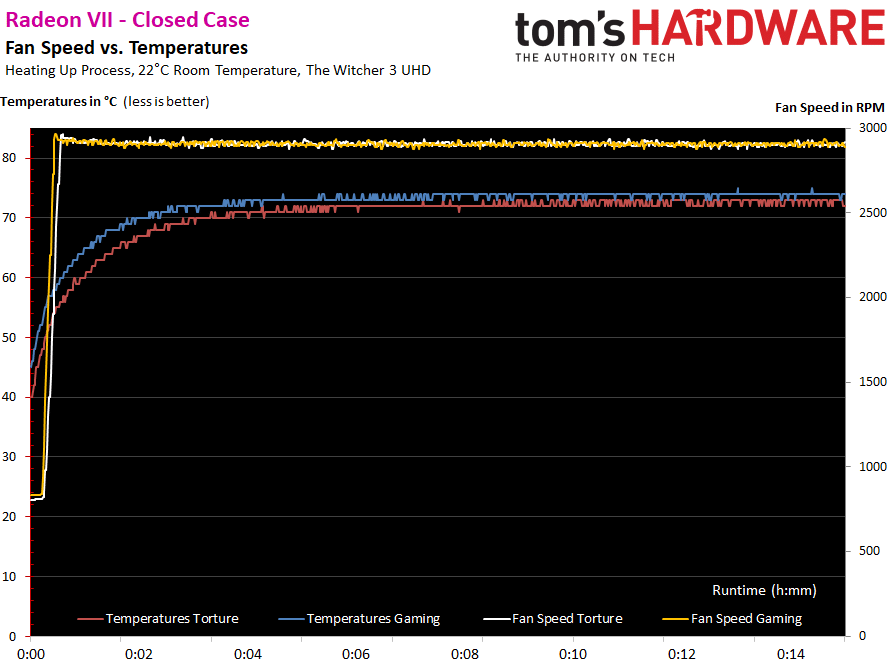

Ventilation et nuisances sonores

Il n’y a pas de mode semi passif, mais les ventilateurs au repos ne tournent qu’à 800 tpm, ce qui presque inaudible dans un boîtier. En revanche, à 54 et 55 °C, les turbines monte à 3000 tpm en moins de 3 secondes ! C’est beaucoup trop brutal, gênant à l’oreille, surtout si vous avez la malchance de faire osciller votre GPU autour de ces températures.

AMD nous explique que ce comportement est tout-à-fait normal et intentionnel (sic)… Et qu’on pourra régler le comportement des ventilateurs dans Wattman. Pourquoi pas… Toujours est-il qu’à chaud, pour conserver les performances de la carte, les chiffres seront immuables :

| Cartes | Radeon VII | GeForce RTX 2080 Founders Edition |

| Rotation à chaud, boîtier ouvert | 2911 tpm | 1887 tpm |

| Rotation à chaud, boîtier fermé | 2927 tpm | 1942 tpm |

| Bruit à chaud | 49,2 dB(A), Boîtier fermé | 39,6 dB(A), Boîtier fermé |

| Bruit au repos | 32,1 dB(A) | 31,3 dB(A) |

| Impressions auditives | Fort ronronnement, bruit de moteur | audible, peu de basses fréquences |

| Bruit électrique | Constamment audible | faible, seulement quand les FPS sont élevés, et pour les changements de charge |

Plus précisément, le spectre sonore de la carte montre une valeur globale de presque 50 dB, ce qui est beaucoup trop élevé. En face, la RTX 2080 Founders Edition est à moins de 40 dB, et on la trouvait déjà un peu bruyante ! Totalement inacceptable, selon nous : en fait, pour comparer la Radeon VII à la RTX 2080 Founders Edition, il faudrait monter les ventilateurs de la GeForce au même niveau de bruit, ce qui augmenterait aussi ses performances.

Si vous voulez écouter la bête, c’est ici :

Perfs moyennes et conclusion

L’avantage de ce test, c’est que les Radeon VII de toutes les marques ayant a priori le même design de référence, nous les avons donc toutes testées ! Nous tenterons prochainement de tester la carte sous watercooling, avec un réfrigérateur d’eau à 20°C, pour voir de quoi se chauffe le GPU Vega 20 lorsqu’il est sans limite de température !

Le problème, c’est que les Radeon VII risquent d’être très rares sur le marché. Il n’y en aurait par exemple que 20 exemplaires disponibles en France actuellement au lancement… de quoi nous évoquer un lancement papier, et surtout de quoi corser le prix de la carte chez les revendeurs à cause de sa rareté.

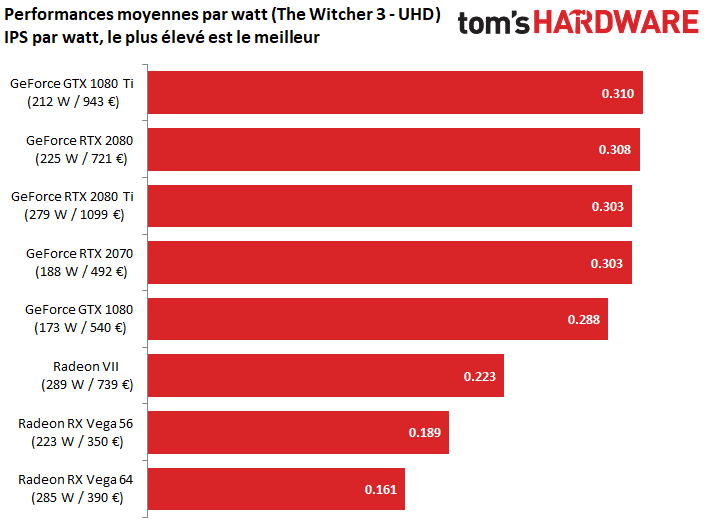

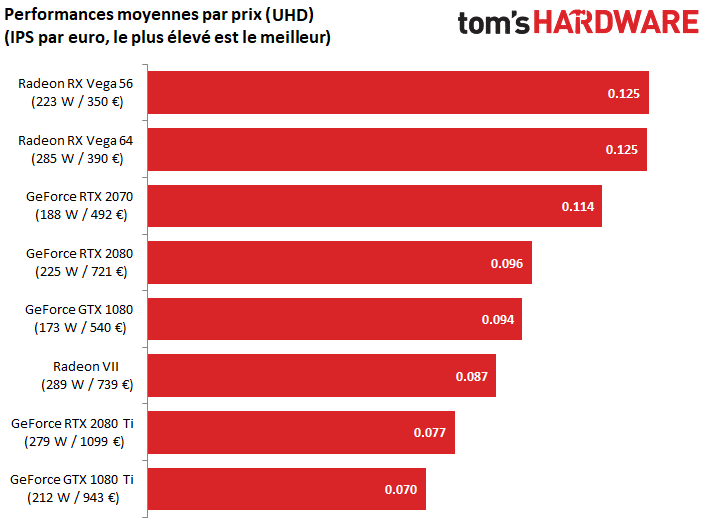

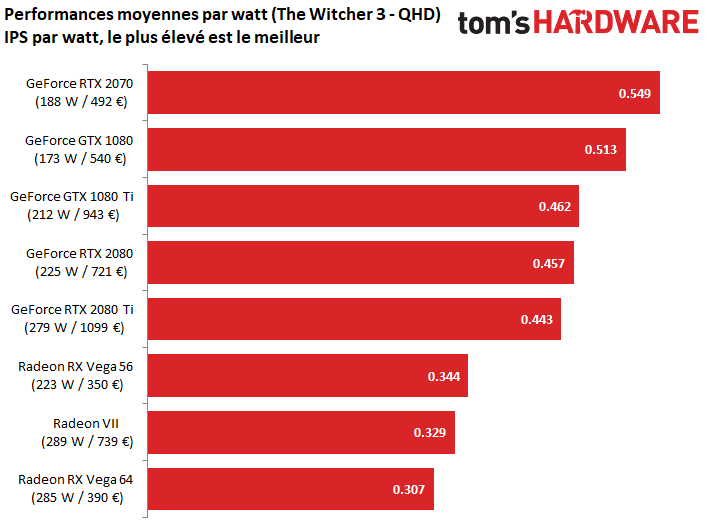

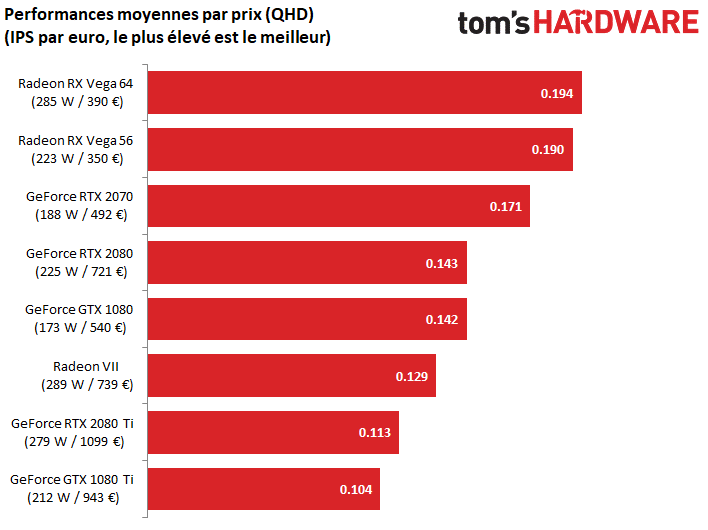

Performances / conso / prix

| Attention : les rapports ips/W sont ici artificiels, résultats de tests séparés de performances et de consommation dans The Witcher 3. Ne les prenez donc qu’à titre indicatif. Nous préparons un test plus représentatif pour évaluer ce rapport, très difficile à établir pour les jeux. Les rapports ips/euros sont basés sur les meilleurs prix de chaque carte observés sur Google Shopping en date du 6 février 2019, hors promotion spéciales. Notez toutefois que ce matin, TopAchat propose une KFA2 RTX 2080 OC pour 679 euros… |

En 4K UHD

Première remarque : aux prix auxquels nous avons trouvé les Radeon RX Vega 56 et 64 hier tout juste, ces deux dernières cartes s’imposent nettement comme meilleur rapport performances/prix du moment, en UHD et QHD ! Elles sont toutefois les pires en rapport performances/consommation.

En QHD

Mais c’est ici la Radeon VII qui nous intéresse : pour les jeux vidéo de notre test, cette carte ne parvient pas à s’imposer, ni en rapport performances/prix, et surtout pas en performances/consommation. Côté performances pures, elle est effectivement très proche de la RTX 2080, sans toutefois la surpasser.

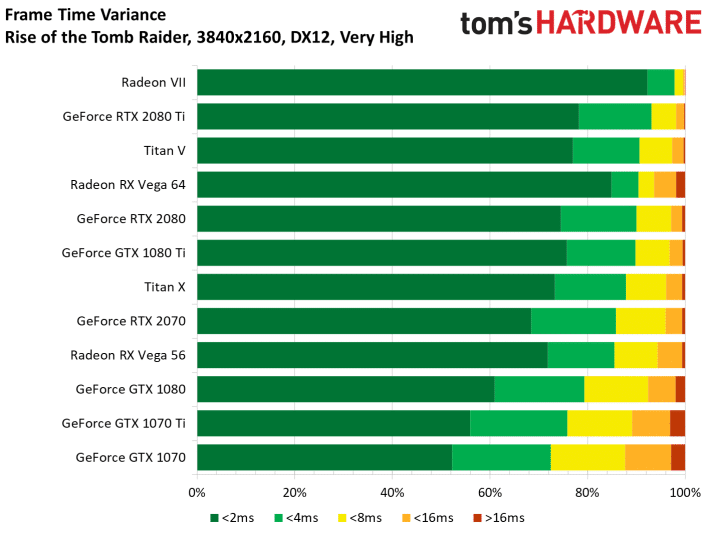

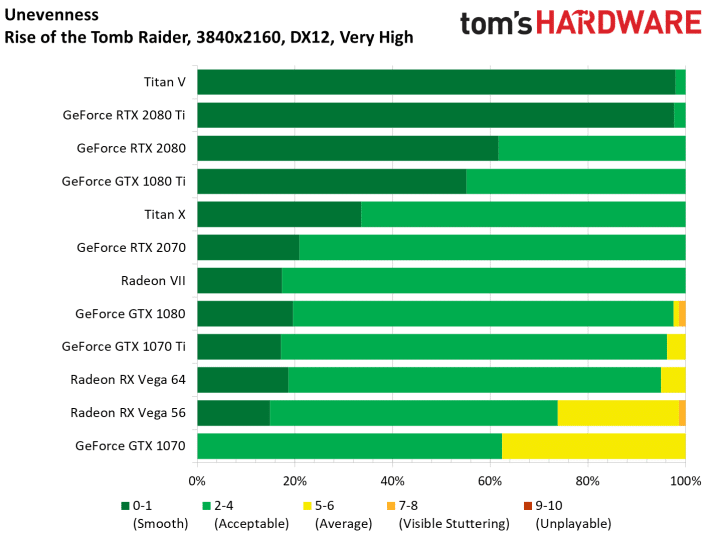

Il y a toutefois certains jeux, comme Battlefield V, dans lesquelles la Radeon VII se permet de surpasser la RTX 2080, en IPS, mais aussi avec un temps d’affichage d’image beaucoup plus régulier. Voilà de quoi donner quelque espoir pour la suite… pour ceux qui ne feront pas attention au bruit et à la consommation.

Conclusion

AMD Radeon VII

-

€

amd radeon vii990€

-

990€

- Performances en forte hausse face à la Vega 64

- Intéressante pour les créateurs de contenu

- Resident Evil 2, Devil May Cry 5, The Division 2 offerts

- Globalement plus lente que la RTX 2080

- Trop gourmande en énergie

- Beaucoup trop bruyante

- Disponibilité et prix réel des cartes ?

Soyons clair, si AMD souhaite charmer les joueurs avec cette Radeon VII, nous craignons qu’il soit absolument nécessaire de baisser son prix, surtout que les tarifs de la RTX 2080 commencent à sérieusement diminuer (déjà disponible à partir de 649 euros en Allemagne). Car, d’une manière ou d’une autre, il faudra faire accepter son appétit de Watts, et surtout le bruit très élevé de ses trois ventilateurs. Le problème, c’est que le prix de la Radeon VII risque d’augmenter chez les revendeurs, à cause de sa rareté. Bref, pour l’instant, difficile de recommander cette Radeon VII pour le gaming, malgré les jolis progrès d’AMD en termes de performances pures dans les jeux. En revanche, il est possible que cette carte se montre plus intéressante pour les créateurs de contenu, qui pourraient tirer parti du GPU Vega 20 et de ses 16 Go de RAM à très grosse bande passante, très performants dans certains logiciels de rendu. Finalement, cette Radeon VII nous fait beaucoup penser à une Frontier Edition de nouvelle génération…

Lire le test

Grand merci Radeon VII d’être venu pour faire baisser les prix des 2080 !! Mais ça va pas être possible, on ne vous prendra pas…

De toutes façon avec 20 cartes dispo…

Si tu prends pas la radeon les prix des rtx 2080 vont pas baisser

Bah ça va, avec 20 pièces (19 si on compte que celle du test est placée^^) même si je n’en prend pas, les revendeurs n’auront pas de problème de stock en France 😉

AMD utilise ce modèle pour la pub mais préfère certainement vendre le même GPU en instinct, ce qui ce comprend… une grosse puce 7nm + 16go de hbm2 pour seulement 700 balles… la marge ne doit pas être magique.

Les RTX 2080 ont déjà plus ou moins bien baisser, par rapport a leur lancement. Concernant AMD, comme dab, c’est pas suffisant leur carte ce rapproche de la 1080 Ti .. .. (génération précédente) NVIDIA peux encore ce permettre de corsé ses prix juste pour leur Ray tracing a la con .. m’enfin bref

Ray tracing et surtout DLSS qui ne semble pas impliqué dans les score de cet article…

les 2080 sont obliger de baisser de prix si elles veulent etre vendu , et tu es sur qu’elle baisse de prix ou se serait pas plutot en qualité ???

perso avec des 2080ti à 1300 euro , je peux revendre ma 1080ti au prix ou je l’ai acheté , et contrairement à ces 2080 bas de gamme , la mienne c’etait le top, malheureusement faut que je trouve un connaisseur et pas un gamin de 12 ans qui va se faire avoir avec une carte premier prix de chez lidl

Ce que je reproche à amd ce sont pas les perfs toujours un cran en dessous, mais le manque de travail design/innovation , ne prenne aucun risque sur une nouvelle architecture. En fait la base est la même depuis très longtemps les évolutions mineurs, juste optimisation ça et la , aidé par une meilleure finesse de gravure , plus de shader et de MHz. C est pas mal en soit mais se sont dés évolutions là où Nvidia nous sort tout des 3-4 génération des petites révolutions avec de net gain Conso/perf.

Les ingénieurs amd sont là, et ne sont pas moin bon que chez les conçurent vert mais je suppose bridé par leur hiérarchie qui ne prendra aucun risque. Pas assez de moyen technique et humaine pour assurer un nouveau design fiable avec les drivers qui suivent.

A quand une révolution pour boulversé les vert comme à l époque des 9700 ati ?!

Aller les rouges prenez le courage nécessaire pour innover , soyez inventif, faite démentir toutes les prédictions , la techno 7nm est la, à vous de faire le reste !

Justement c’est la prochaine génération qui va sortir, faut suivre un peu ^^

Elle arrive vraiment à petit pas!

A ce prix, la radeon vii n’est clairement pas intéressante pour le jeu. Tu trouve des 2080 au meme prix voir moin chere. Si ce nest pas pour des besoins de memoir dans certaines applications pourquoi acheter cette carte?

Apres, une flambée des prix pour cette carte… je ne pense pas.

J’espere que les prochains pilotes changeront la donne sinon faut baisser le tarif.

si t’as envie de te prendre la tete avec des drivers baclés tu peux aller chez nvidia , check les forums , ca fait des mois que c’est le bordel , à mon avis c’est comme chez apple avec eux , si t’as un matos qui rentre pas dans la case ca part dans tous les sens et ca bug a n’en plus finir les mec s’arrachent les cheveux , sur des cartes à de 2 ans maintenant achetée 900 euro !! UNE HONTE

Etonnant! Je n’ai jamais eu de problème insurmontable avec les pilotes d’Nvidia. Sauf quand c’était un montage exotique.

Erreur du dernier tableau, c’est la Radeon VII et non une “MSI RTX 2080 Gaming X Trio”

Merci ! C’est corrigé, les valeurs étaient bonnes, juste l’intitulé de la carte qui n’était pas changé.

Dommage que le prix soit si proche d’une 2080… avec quelques € en moins elle aurait pu séduire les gens qui hésite avec une 2070…

de toute façon, il me semble que les tests seront surement à refaire dans peu de temps… Il est dit que la carte supporte le PCI 4.0 hors le prochain Ryzen 3 le gère aussi donc des MB devraient suivre l’évolution sous peu.

Ainsi le test sera à refaire car avec la Rtx 2080 en PCI 3 et la radéon en PCI 4…. la différence sera peut être enfin au rendez-vous !!!

Ça m’étonnerait les tests de Pci se font svt et montrent peu de différence.

La 2080Ti sensiblement plus puissante gagnait a peine 2% entre un pci 3 x8 et x16

Pourtant la bande passante passe de 8000 MB/s a 16000.

normal les drivers nvidia sont et restent pourris j’en témoigne , ceux d’amd sont trop récent pour cette nouvelle carte

Non seulement, le prix sera à la baisse dans quelques temps, quand il y aura plus d’unités, et le fait de naviguer sur une bande plus large, en plus de pilote plus mûre, c’est deux derniers peuvent influer, effectivement sur les perfs, de même sur le choix des futurs acheteurs.

Mais à quand une vrai évolution sur la consommation?

Et le raytracing????

Haha, bien essayé 😀

Blague à part ça ne les interesse pas le raytracing?

et quoi le raytracing ? parce que nvidia rajoute ce truc tu le veux partout , alors que personne ne l’utilise vraiment ? tu veux aussi payer ta radeon 300 euro de plus pour rien ? faut reflechir un minimum quand même , on dirait des gamins les commentaires !

Les commentéreux!!!

Ah ouais, attendez que le dlss sois au point dans plusieur jeux, après ça ce sera bye bye radeon

Pas si sûr… le raytracing est encore une techno propriétaire, et il faut que les devs adhèrent. Or, à ce jour, ce n’est pas franchement la règle tant le surcoût de boulot semble important. Pire encore, les devs vont craindre, à juste titre, que leurs jeux soient trop collés à une technologie. C’est le même concept que le physx: intéressant sur le papier, bien moins dès qu’il y a eu à faire le bilan que la techno n’était que côté Nvidia…. d’où le flop relatif de ce truc. (NOTA: la même chose que le Glide sur 3DFX en son temps quoi…)

Il parle du Dlss, l’anti aliasing (on sait pas trop :), on manque d’info encore) qui est 50% plus performant que le TAA etc… ce qui change la donne sur les perfs mais ça n’a rien à voir avec le raytracing.

Le raytracing c’est plus un test de leur part je suppose.

Si, si, on sait : c’est de l’upscaling très intelligent et de qualité.

https://www.tomshardware.fr/2018/10/24/enquete-exclusive-sur-le-dlss-de-nvidia-upscaling-ou-pas/

J’étais plutôt 3DFX et à l’époque, 3DFX était largement devant.

dlss c’est testé sur des images fixes , t’es pas pres de le voir dans un jeu , tu te fais avoir par le baratin marketing

n’importe quoi encore, faut vraiment aller cultiver tes connaissances parce que là t’es en plein rêve…

AMD trouvera bien quelque chose pour contrer tout ççà! C’est comme G-sync et le Free-sync!

Pourquoi tester en DX12 ( sauf si c’est pour avantager les radeon ), c’est un secret pour personne, DX11 est plus perf chez les verts et vu le peu de succès ( et c’est un euphémisme ) du dernier api du “Géant de redmond”, je ne vois pas pourquoi Battlefield V par ex soit testé avec celui ci.

Voilà de quoi booster encore plus ma FRUSTRATION. Même si pour moi c’est un vrai charabia le jargon et les termes techniques je comprends au moins que ça me tue et me rend limite malheureux de ne pas avoir les moyens financiers de m’offrir une carte graphique, processeur et carte mère a la pointe de la technologie. C’est véritablement frustrant pour moi. Je tourne encore avec mon vieux PC, une tour d’ordinateur que j’avais monté il y a 10 ans avec des.composants que j’avais acheté sur TopAchat en plusieurs fois (4 fois) et une remise de 5% sur le prix. Et même à cette époque j’avais du m »endetter ce qui m’avait sérieusement mis dans une galère dont je me suis relève que 3 ans après. Aujourd’hui c’est pire c’est impossible d’acheter les composants derniers cris pour le refaire un PC au top du top. Je me demande d’ailleurs comment font tout ce monde pour parvenir à se payer ces carte graphiques et ces processeurs qui coûtent la peau des fesses. C’est une fortune, c’est EXORBITANT.

Pourtant je bosse un peu. Je n’ai pas de CDI malheureusement, mais je travaille en intérim ce qui me permet juste juste de payer mon loyer et mon assurance auto ainsi que mon abonnement téléphonique. J’ai même un vieux smartphone acheté en 10 fois il y a 5 ans. Cest IMPOSSIBLE d’acheter ces composants franchement comment vous faites car même avec un Smic et en faisant des economies il faudrait des années pour réunir la somme ? Aujourd’hui pour avoir un PC disons « normal » sous-entendu le top qui fasse tourner les jeux les plus récents et les plus puissants il faut compter au moins 2000 € et jusqu’à 4000 €. C’est un truc de malade. Mais comment vous faites sérieusement comment c’est possible si on est ni riche, ni avec un bon salaire ? J’en reviens toujours pas quand je vois des gamins qui ont des machines qui coûtent plus cher que la voiture je suis presque en état de choc. Mdr c’est dingue ça.

faut pas lire ces articles c’est exactement le but , de te faire acheter des trucs hors de prix , ou au moins de te faire rever, alors que c’est sans interet en vrai…, imagine si les gens ne craquaient pas et n’achetaient pas ca , les journaleux n’aurait rien a raconter .. c’est comme ces jeux a 60 euro , en général c’est vide, du vent, t’as 2 niveau qui sont des vitrines technologiques et le reste c’est baclé, … des exemple comme ca y en a a tous les niveaux , apple et son soi disant design, mais derriere c’est de l’obsolescence programmée a tout va , et des trucs pas logiques , mal pensés en terme d’electronique, nvidia qui balance des technologies qu’ils abandonnent 2 ans plus tard sans que personne n’en ai eu vraiment l’utilité , le seul interet etant de faire continuellement parler de la marque etc etc, on nous rabaches 4 pubs par jours pour des 2080 2070 2060, alors que se sont chaque fois les memes cartes dont tout le monde se fout vu qu’elles sont beaucoup trop cher pour ce qu’elles apportent … bref

en gros pour 1000 euro t’as un pc , tu met 250 euro dans la cg (une vega 56 par exemple, meme voir si tu peux en trouver d’occaz sinon) et tu peux jouer a beaucoup de chose en FHD (pas la peine de partir sur de la 4k avec des 2080/2080ti , sinon t’en sors pas et le fond qualitatif des jeux n’est pas dans leur beauté ou alors autant sortir de chez soi et admirer un peu la nature , la y a de vrais graphisme bordel et c’est gratuit plutot que de suer devant des articles bidons …, le matos trop cher c’est pour les pigeons frustré , exactement comme tu dis) … on se fait avoir une ou deux fois pour voir, mais ensuite on redescend sur terre quand on est un minimum raisonnable et pas un gamin capricieux a qui les parents disent oui a tous juste pour être au calme, y a des choses plus importantes dans la vie 🙂

“alors que c’est sans interet en vrai…, imagine si les gens ne craquaient pas et n’achetaient pas ca , les journaleux n’aurait rien a raconter .. ”

C’est vraiment n’importe quoi, vous raisonnez totalement à l’envers. On teste ce qui sort sur le marché. On ne décide pas quelle carte va sortir et à quel prix. Si les gens n’achetaient pas, les fabricants n’en feraient pas, peut-être. Nous on n’y est pour rien, on fait juste notre boulot de testeur. Et devinez quoi, pour acheter votre carte d’occasion (une bonne idée d’ailleurs), vous venez lire nos tests (gratuits) pour savoir laquelle prendre et à quel prix !

Écoutes, Ray3.0! Il n’y a pas de miracle, soi tu casses une banque, soi tu apprends à faire des économie. Et franchement, la deuxième option est préférable. Il y a beaucoup de conseils sur internet. L’économie se fait dans tout ce que tu consommes, y compris les charges fixes.

+RAY30 Tu trouveras toujours un moyen de te payer ce que tu veux perso je suis en intérim aussi bah je vie comme un roi je gagne plus qu’un CDI et je peux me permettre ce genre d’achat bah je le fais pas par ce que je sais que c’est que du markéting bidon sur des technos pas au point sorties trop vite justes pour faire chier la concurrence. Après il faut se donner les moyens tu peux faire 43 heures semaine et travailler au noir les week-ends et dans 2 mois ta un PC à 1000e et 1000e de cote.

pour ceux qui on pas encore compris , oui les drivers sont trop jeunes et on pas mal de problemes , bizzarement y a que sur les tests francais qu’on en parle pas , j’ai vu pas mal de videos de tests americains qui expliquent qu’amd aurait du sortir la carte un peu plus tard a cause justement de ces soucis de jeunesse , histoire d’eviter que certain qui n’ont toujours pas de recul sur ces technos en fasse trop facilement de la mauvaise pub…, mais apparement c’est une tres bonne carte qui devrait poutrer correctement la 2080 dans quelques semaines , apres c’est comme d’hab , suivant les jeux l’une ou l’autre aura plus 10% de fps , mais pour jouer en 4k à mon avis de toute facon c’est une bonne carte … entre celle ci et une carte bas de gamme nvidia je choisi celle ci, surtout que pour ma part c’est aussi pour bosser et que les drivers nvidia ne sont pas fais pour les gens qui bossent avec plusieurs ecran (trop de bug de mise en veille , bug multi ecran, saute de l’image , problemes rafraichissements, conso trop élevé pour rien suivant les drivers etc etc etc ceci depuis plusieurs mois des nouveaux problemes à chaque nouvelle version de driver, moi j’en ai ras le bol ) perso je suis entrain de revendre ma nvidia , je la laisse à un joueur , et je vais me prendre cette radeon 7 , venant aussi d’une 7970 et d’une 290X avant la 1080, je sais a quoi m’attendre , franchement passer des heures a trouver le driver qui fonctionne chez nvidia , merci mais j’ai d’autres choses à faire , d’ailleurs j’ose même plus installer les dernieres versions tellement c’est n’importe quoi

sur ceux , le jours ou les journaleux utiliseront le matos plutot que de faire des tests superficiels qu’ils pompent a moitié sur les autres …. (on trouve trop souvent des phrases un peu trop similaires pour que se soit pas du pompage) on en reparlera … d’ailleurs de nos jours on ne sait même pas s’ils n’appartiennent pas tous au même groupe …

N’importe quoi encore.

On explique que Wattman est buggé, pas les drivers. D’ailleurs, les tests américains disent la même chose. Oui, les drivers AMD sont de très bonne qualité en ce moment (le côté pilote GPU, pas forcément le reste). Et ils sont DEJA optimisés pour l’architecture Vega de la Radeon VII, car AMD a optimisé aux petits oignons les Vega 56 et 64 avant (avec de gros gains de performances). Le fait que la Radeon VII soit gravée en 7nm n’y change rien ! Elle profite déjà des bonnes optimisations Vega, et tout ce qui sera optimisé par la suite profitera aux trois cartes Vega actuelles.

la plupart des modifs dans la mise a jour des drivers du jour contredisent deja une partie des arguments qui critiquent la carte , cqfd … en terme de perf c’est en fonction de l’utilisation et du dev , parfois la 1080ti est devant, parfois c’est la radeon vii , je le constate , par contre c’est pas parce qu’elle a 8 fps de moins dans certains cas que ca rend la chose inutilisable , tout est dans la maniere de présenter les choses … carte pour jouer en 4k , drivers nickel et en cours d’optimisation, amd est sur la breche et sait ou se focaliser , pour moi c’est le plus important

Alors, si c’est çà, on a un souci! J’espère bien qu’il y aura des améliorations sur cette carte particulièrement; pas seulement au niveau du prix.

“le jours ou les journaleux utiliseront le matos plutot que de faire des tests superficiels qu’ils pompent a moitié sur les autres …. (on trouve trop souvent des phrases un peu trop similaires pour que se soit pas du pompage) on en reparlera … d’ailleurs de nos jours on ne sait même pas s’ils n’appartiennent pas tous au même groupe …”

N’importe quoi encore. Faut juste que t’arrêtes la parano en fait. Un gros LOL pour les tests superficiels chez nous d’ailleurs. Ils sont parmi les plus poussés du Web… Que ce soit clair : prochaine attaque gratuite contre nous, et c’est le ban.

deja c’est pas forcement une attaque contre vous mais contre les tests que j’ai lu en général , alors tu me parles de parano , faut respirer , je constate que l’on fabrique une réputation sur une carte a peine sortie dont les drivers sont tres jeunes et que en général , pour tirer des conclusions il vaut mieux avoir un peu de recul , recul qu’on peut deja tirer des cartes précédentes et qui devrait tout de meme calmer un peu la radicalité et la maniere définitive de certain propos dans les tests (et pas forcement les votres)

je précise encore une fois je parle des “tests francais” que j’ai lu, pas sur d’avoir lu le votre mais vu le titre je pense que vous êtes quand même dans la même tendance a premiere vu , sans vouloir vous condamner sans avoir lu , je le précise , apres si tu pense que c’est gratuit , c’est un peu dommage, moi aussi je trouve que certaine conclusion hativent sont gratuite aussi, je vais lire votre test maintenant

Ecoute, tu penses ce que tu veux hein, nous ne sommes pas tes parents. Tu peux dire ce que tu veux ici, la seule condition consiste à rester polis, courtois et ne pas faire d’accusation gratuite et diffamatoire.

Juste que d’un côté on me parle d’undervolting sans rien avoir testé (conso ? stabilité ?) et de bruit pas assourdissant (t’es peut-être sourd, je sais pas), de l’autre, on a des résultats de conso à la milliseconde près, et des tests de nuisance sonore en chambre sourde avec du matos à plusieurs milliers d’euros qui affichent une valeur record de 50 dB. Les lecteurs se feront leur idée entre ton témoignage et nos tests.

J’ai toujours été prudent quant au conclusion de certains journalistes du web. Pas assez ouvert.

Tu parles d’overvolting! Mais il me semble que c’est ce site qui en parle le mieux en Français, sur la Vega 56. Après, il faut tester et trouver le bon exemplaire! Car toutes les cartes ne sont pas pareilles. C’est comme tous composants électronique, leur justesse s’exprime à travers une tolérance.

Je passe du croc à l’âne! C’est le moment idéal pour acheter un GPU de dernière génération, car les prix des GPU’s pourraient augmenter lentement, du fait de la dispersion des stocks cette année.

Eh, les AMD me semblent le mieux placé au niveau perf/prix. Pourquoi acheter du 4 ou 8K, alors que le QHD est à notre porté de bourse pour la plupart?

Pas de overvolting mais “undervolting”. Désolé!

Pas la peine d’aller aussi loin, c’est un petit nouveau qui argumente. Qui provoque! Tom’sHardware est parmi les plus anciens du web, mais il ne le sait pas. Il a une vision assez jeune.

Avant qu’existe “Tomshardware.fr”, je lisais sur le site USA en “.com”

Bien parlé! Pour les pilotes, cependant, pourquoi ne pas remonter le problème jusqu’à Nvidia? Ils ont plutôt intérêt à résoudre ton problème pour leur image! Je te conseillerai d’insister et de le faire apparaitre sur la majeure partie des Forums (Nvidia forum compris). Ceci afin de les inciter à répondre rapidement!

pour ce genre de matos il vaut mieux s’informer à plusieurs sources , pas forcement francais apparement pour avoir des points de vue un peu différent , parce que des tests qui disent tous la même chose c’est un peu louche, on fait l’impasse sur beaucoup d’éléments pour comparer les concurrents et tout le monde fais les même impasses , a croire que vous avez tous la meme liste de choses à checker , c’est dingue … , j’ai vu de tres bon test allemands et americains de la carte, plus enthousiastes ces tests contrairement au ton blasé des tests francais qui ne se contentent que de chiffres sans prendre l’expérience du temps en compte… et pour ca amd est loin devant généralement, pas de raison que cela change pour cette carte … qui vivra verra

C’est clair. Je dirais même plus : quand on voit ce qu’on voit, quand on entend ce qu’on entend, quand on lit ce qu’on lit, on fait bien de penser ce qu’on pense !