Une solution possible par mise à jour.

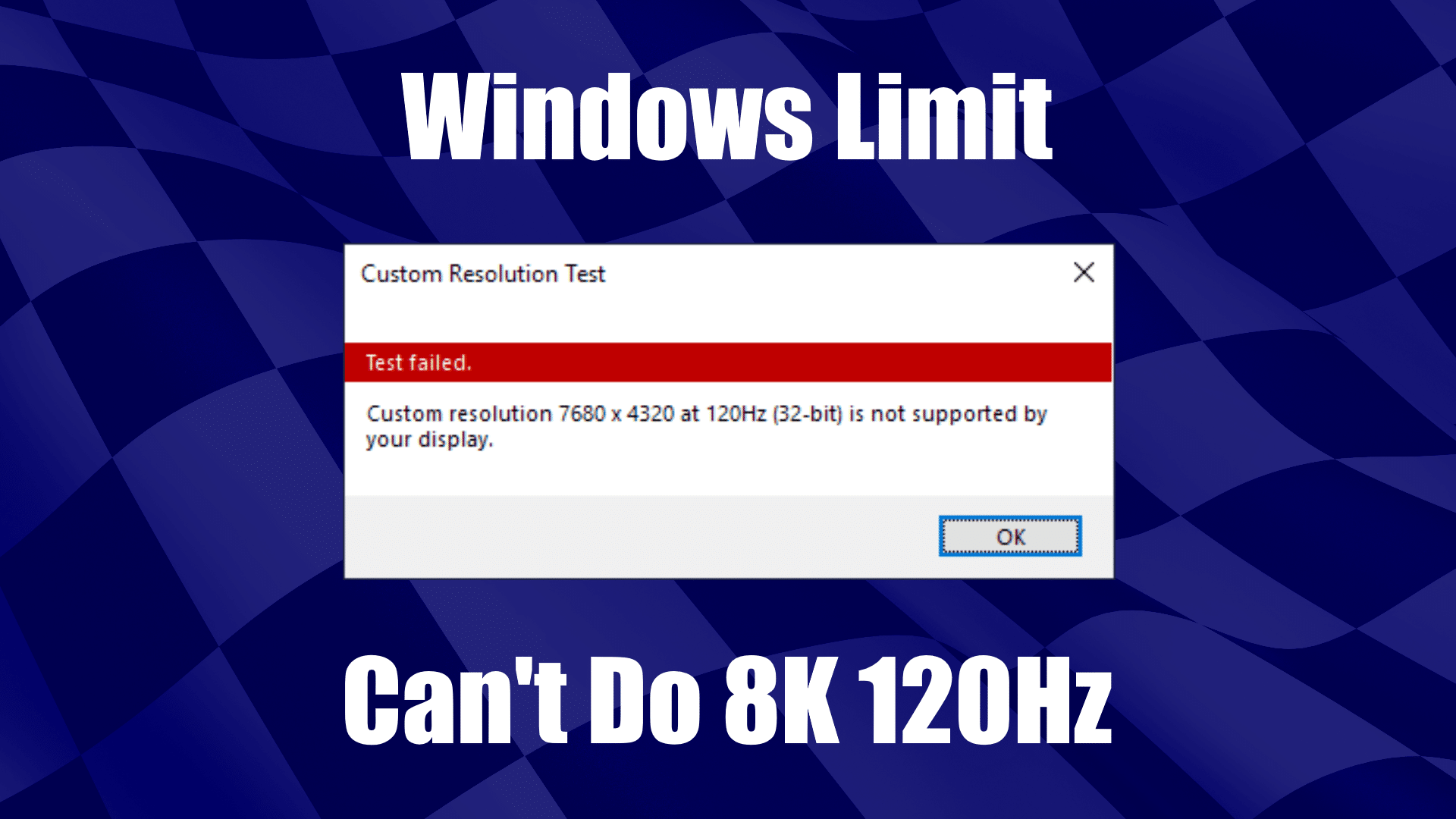

Le système Windows possède deux limites arbitrairement fixées dans son code, qui risquent de poser problème très bientôt. La première limite de deux milliards de pixels par seconde permettra d’afficher du 8K en 60 Hz, mais pas à 120 Hz (qui nécessite la génération de presque 4 milliards de pixels par seconde). Les ingénieurs sont donc actuellement obligés de tester les nouveaux écrans 8K 120 Hz sous Linux. Il semble toutefois que certains ingénieurs aient trouvé un bricolage permettant le 8K 120 Hz sous Windows.

Pas plus de 512 Hz

Autre limite arbitraire : Windows ne peut pas dépasser un taux de rafraîchissement de 512 Hz au maximum, quelle que soit la définition. Cette fois, on a le temps de voir venir, les écrans les plus rapides étant à 240 Hz. Mais il va falloir aussi y remédier dans les années qui viennent, sachant que le 480 Hz existe déjà depuis longtemps dans les labos. Notez que le 1000 Hz est aussi à portée de main, NVIDIA ayant déjà testé du 1700 Hz pour la VR, et un vidéoprojecteur DLP étant déjà capable d’assurer du 1440 Hz en noir et blanc et 500 Hz en couleurs.

Notez toutefois qu’il est parfaitement possible que Microsoft supprime ces deux limites par une mise à jour de Windows.

Y en à vraiment qui ont cru que 480Hz/1000Hz ça servait à quelque chose ? Le 8k 120Hz aussi ? Le 8k est déstiné aux professionnels qui font du design, photo ou autre surtout avec écran souvent de 21 à 27”. Mais le 120Hz pour le 8K ne sert à rien vu que t’as pas besoin d’avoir une superbe fludité pour ce genre de travail.

Ca ne sert pas encore mais dans quelques générations de casques VR avec du eye tracking ça viendra, et plus tard encore pour, pourquoi pas des lunettes/lentilles dédiées à la réalité augmentée.

Quelqu’un sait pourquoi une fréquence de balayage aussi élevée est réellement utile ?

C’est relatif à la vitesse des objets dans l’image, à la taille de l’écran et au nombre de pixel. En augmentant ces caractéristiques il faut rafraîchir l’image rapidement pour que l’objet en mouvement puisse être suivie par l’œil sans être saccadé. Ces données sont plus déterminantes en VR.

Il va falloir que certain d’entre vous se renseigne rapidement sur les capacité de l’oeil humain, en fait le centre de l’oeil permet une grande résolution mais la vitesse d’interprétation est faible 90Hz.

Il faut bien comprendre que en fait ces zones sont progressives aussi bien en résolution quand vitesse, cependant physiologiquement parlant dépasser les 120Hz n’est pas indispensable. Cela ne devient qu’un argumentaire commercial rien de plus.

Ensuite pour la VR il faudra effectivement un résolution plus importante mais focalisé sur la partie de l’image observée avec une vitesse faible tandis que la résolution pourra diminuée au profit de la vitesse mais dépasser les 200Hz devra en plus faire appel a des éléments de contraste dynamique bref répondre aux capacité des cerveaux humains pour le traitement de l’information visuelle.

Ne vous braquez par comme ça !

A mon avis cette course à la fréquence c’est surtout pour remplacer les algorithmes d’interpolation d’image qu’on trouve dans les téléviseurs depuis une 15aine d’années.

Au lieu d’images bricolées (en général, des images grises ou noires) ajoutées dans l’intervalle, ici, il pourra s’agir de vraies images natives, générées par le GPU (s’il suit la cadence… mais c’est un autre débat).

Du coup, les objets en mouvements s’afficheront de manière beaucoup plus naturelle et fluide, sans faire les horribles traînées qu’on voit à l’heure actuelle.

Evidemment, on ne parle pas de jouer à Overwatch à 1440 FPS synchronisés hein, là dessus on est tous conscient que ça ne sert à rien du tout… mais en s’affranchissant des post-traitements à la “Motion Blur”, on réduit l’input lag (puisque l’image est affichée telle qu’elle, sans modification coûteuse en temps), et on fait plaisir à Tom Cruise (https://www.theguardian.com/film/2018/dec/05/tom-cruise-motion-smoothing-interpolation)

Sinon sur les propos de l’article, moi je trouve ce nombre de 2 milliards de pixels assez évocateur…

S’il s’agit d’une variable dans le code, stockée sur 32 bits, je me pose des questions sur la faisabilité de passer au calme sur une 32 bits non signée ou une 64 bits, sans le moindre effet de bord… Je pense pas que ça puisse sauter dans une petite mise à jour pépère ce genre de trucs…

Bref, les Hz c’est bon, mangez-en 😉

Exactement (pour l’encodage sur un long integer).

Changer ce genre de choses qui traînent dans la code de Windows depuis plusieurs années, c’est très risqué. De plus, il n’y a pas que microsoft qui soit impacté, les fabricants de cartes graphiques au travers des pilotes sont également touchés. Et quand on voit comment Microsoft a imposé son éco-système, m’est avis que les pilotes graphiques ne sont pas dans la catégorie des programmes avec un code exemplaire. Il va falloir s’attendre à des effets de bord modèle géant.