Introduction

L’écran est peut-être le périphérique le plus important de votre ordinateur. Et entre les premiers écrans CRT monochromes et sans mode graphique et l’écran 11 pouces en 1080p des derniers modèles Asus, il y a évidemment un monde. Dans ce dossier, nous allons passer en revue quelques technologies, voir les évolutions des écrans et mettre en avant quelques modèles emblématiques ou atypiques.

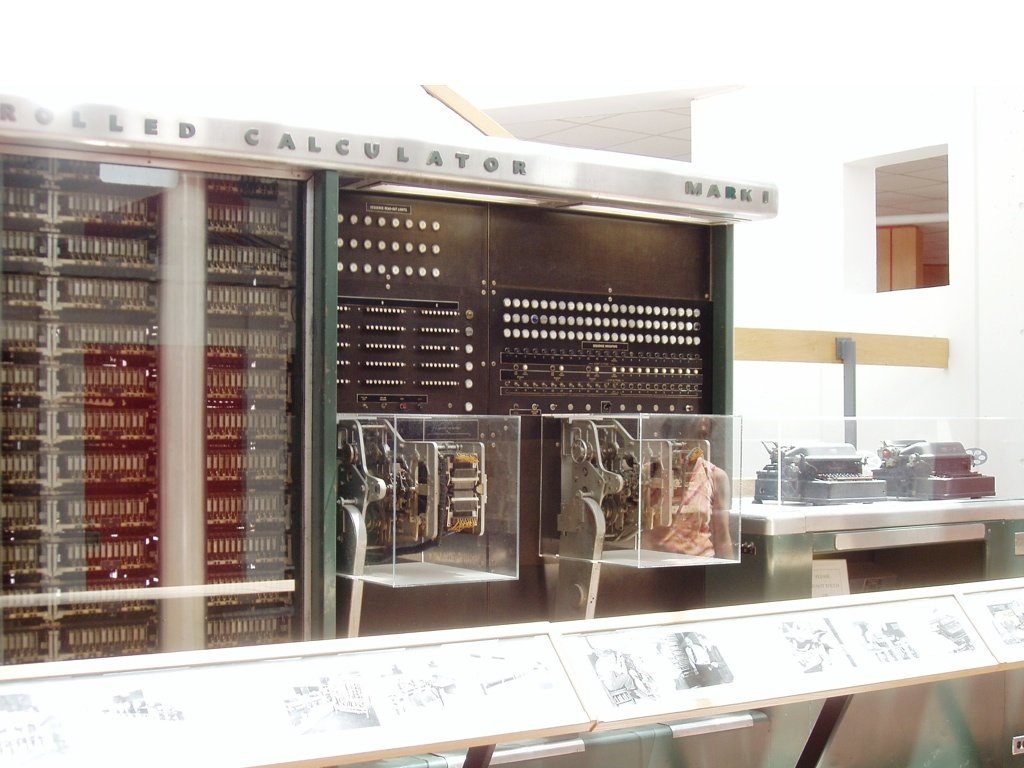

Le Harvard Mark I

1944, le premier « ordinateur » numérique est mis en fonction. Le Harvard Mark I utilise des cartes perforées en entrée et en sortie, ce qui fait au final office « d’écran ». Ce sont des bandes de papier perforées en fonction du résultat. La bande perforée a été utilisée très longtemps, car elle a un avantage : son coût.

Les écrans CRT

Le tube cathodique (CRT, Cathodic Ray Tube en anglais) a été inventé à la fin du 19e siècle et a été perfectionné au fur et à mesure au 20e siècle. Si les premiers moniteurs de télévision datent des années 1930, il a fallu attendre 1954 pour que le premier moniteur cathodique en couleur débarque. Le 15GP22 est le premier téléviseur couleur commercialisé, et il disposait d’une diagonale utile de 15 pouces (38 cm).

Les écrans LCD

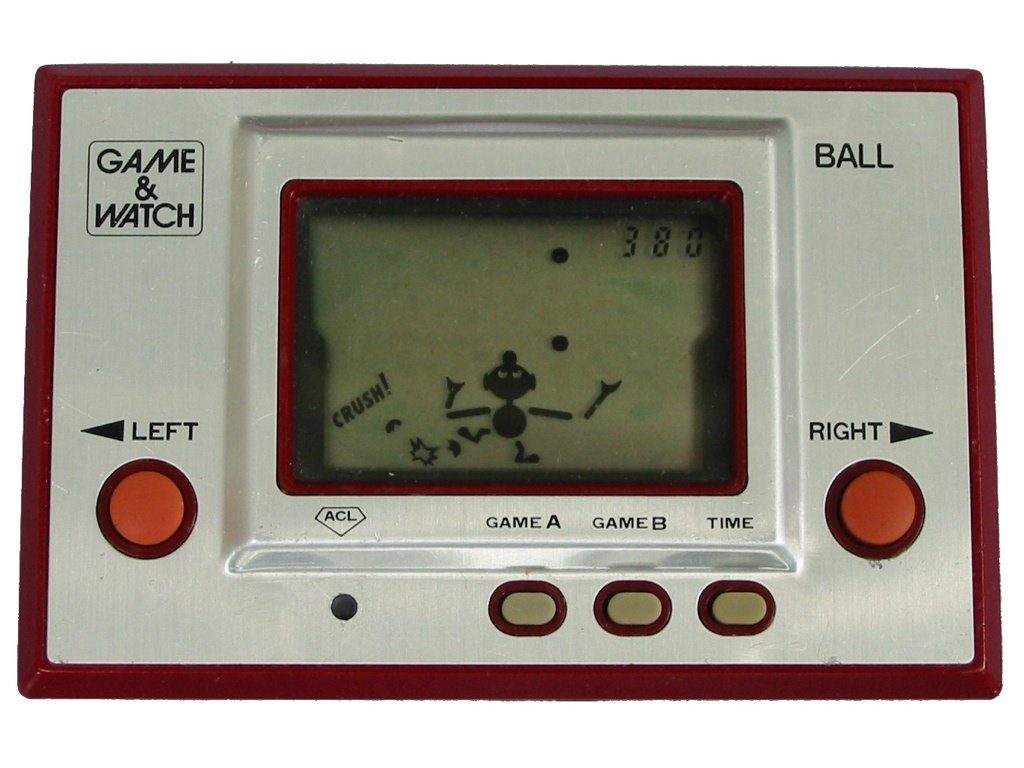

Si les cristaux liquides sont connus depuis des années (fin du 19e siècle), l’utilisation de ces derniers dans des écrans est plus récente. Le principe à l’origine de la technologie la plus utilisée actuellement, l’effet Twisted Nematic, a été découvert en 1964. Il est utilisé dans les dalles TN, très courantes dans les écrans LCD utilisés en informatique. En faisant passer un courant de faible intensité dans des cristaux liquides, il est possible d’orienter ces derniers et donc d’obtenir une image. Ce principe est aussi utilisé dans les calculatrices et dans beaucoup d’appareils nécessitant un affichage simple (montres, jeux vidéo, etc.).

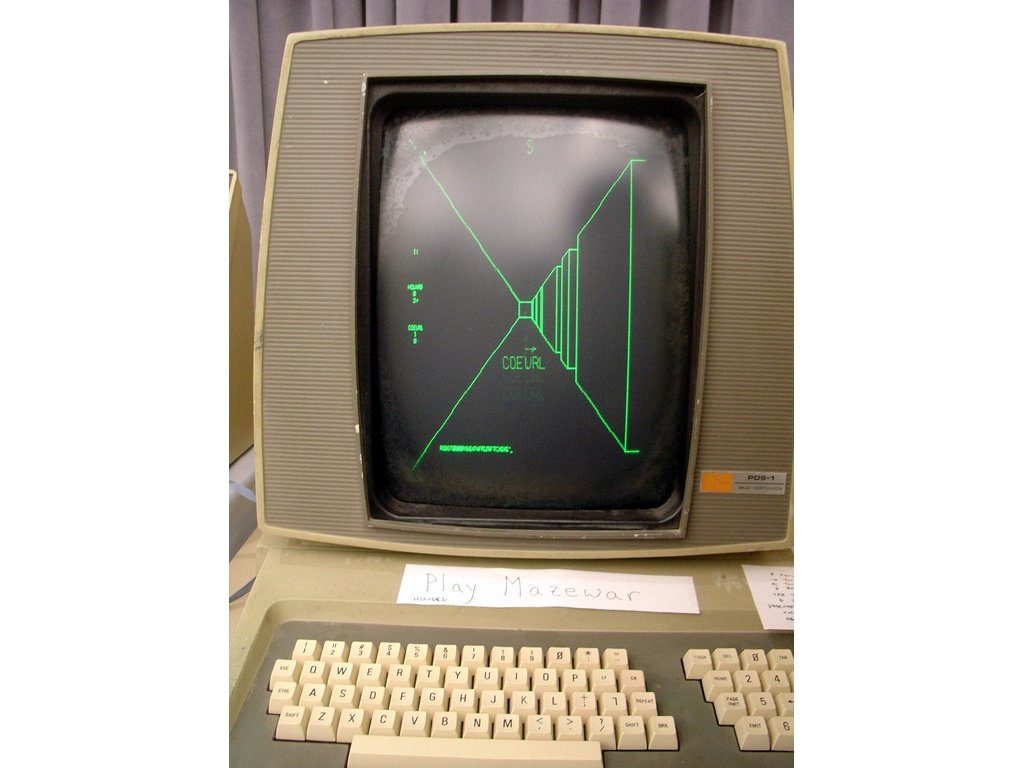

Les écrans vectoriels

Si les oscilloscopes n’ont pas été souvent utilisés dans les ordinateurs, les écrans vectoriels, eux, ont été utilisés dans les années ’70. Au lieu de balayer toute l’image et d’allumer ou d’éteindre des pixels individuellement (comme les téléviseurs et les écrans cathodiques classiques), les écrans vectoriels tracent directement des lignes entre deux points. C’est intéressant pour certains points (notamment l’utilisation mémoire très faible) mais les limites dues au déplacement du canon à électron et le fait que la majorité des systèmes étaient monochromes a sonné le glas de la technologie, qui a tout de même été utilisée dans quelques bornes d’arcade des années ’80.

L’arrivée du téléviseur

Au début des années ’80, le téléviseur est devenu un choix assez courant pour afficher les informations issues d’un ordinateur. Beaucoup moins cher qu’un écran dédié et déjà présent dans beaucoup de foyers, le téléviseur pouvait facilement âtre adapté pour être utilisé avec un ordinateur. Ces derniers intégraient en effet un convertisseur capable de fournir un signal NTSC ou PAL en sortie, même si dans beaucoup de cas un moniteur dédié offrait évidemment une meilleure image.

Les écrans textes

Avec le premier PC, IBM proposait un écran monochrome, le 5151. Cet écran de 12 pouces de diagonale offrait une définition de 720 x 350 mais ne pouvait travailler qu’en mode texte (80 caractères par ligne, sur 25 lignes) et avec une seule couleur, le vert. Cette couleur était issue du phosphore choisi par IBM pour tapisser l’intérieur de l’écran, du P39. D’autres variantes offraient des couleurs différentes, selon les marques d’écrans. Point amusant, la transmission entre l’ordinateur et l’écran était numérique.

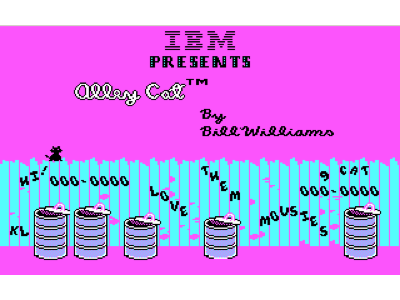

CGA et EGA

CGA (Color Graphics Adapter) et EGA (Enhanced Graphics Adapter) ont fait les beaux jours des premiers PC. La première permettait d’afficher (au mieux) 16 couleurs avec une définition (là aussi au mieux) de 640 x 200. La seconde permettait d’afficher 16 couleurs parmi 64 au mieux en 640 x 350. Dans les deux cas, la liaison entre l’ordinateur et l’écran était numérique — dans le cas de moniteurs dédiés —, même si les cartes graphiques CGA avaient aussi une sortie NTSC pour utiliser un téléviseur en lieu et place de l’IBM 5153, un moniteur coûteux. CGA et EGA ont été longtemps la norme dans les PC et dans les jeux.

Le VGA

En 1987, IBM passe… à l’analogique. Le VGA (Video Graphics Array) inaugure de nouveaux modes — 640 x 480 en 16 couleurs et 320 x 200 en 256 couleurs — mais surtout une prise, le DE15. Ce connecteur va devenir un standard et il est toujours très utilisé en 2012 dans certaines catégories de périphériques, comme les vidéoprojecteurs. La limite classique de l’interface est le 2 048 x 1 536 à 85 Hz, une définition qu’il est possible d’atteindre avec un RAMDAC (du côté de la carte graphique) à 400 MHz. Attention, beaucoup d’anciennes cartes graphiques ne peuvent pas atteindre de telles fréquences. Contrairement à ses prédécesseurs et à ses successeurs, le VGA travaille en analogique, ce qui nécessite un (dans le cas des moniteurs CRT) ou deux (dans le cas des écrans LCD) convertisseurs numériques vers analogique.

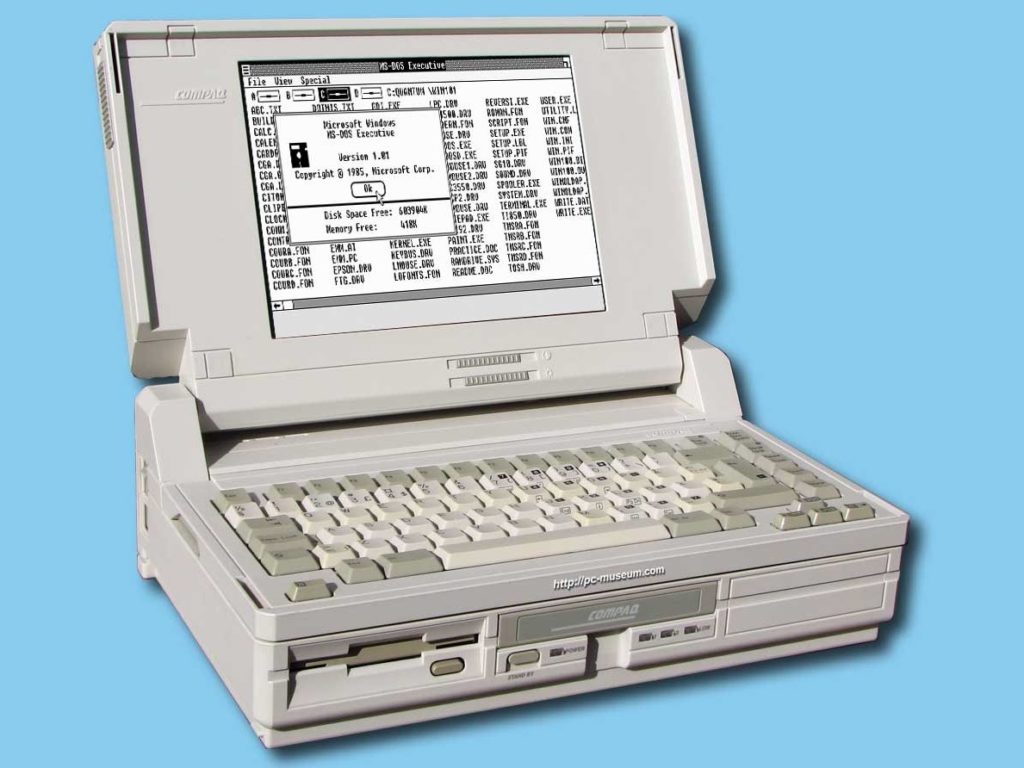

Un portable VGA

Si les ordinateurs actuels ont des écrans qui peuvent travailler en 1 920 x 1 080 sur une diagonale de 11 pouces, ça n’a pas toujours été le cas. le Compaq ST/286 de 1988 avait par exemple — une première — un écran qui travaillait en 640 x 480, sur une diagonale élevée, 10 pouces. L’écran était monochrome et l’ordinateur très lourd (6,5 kg). Le processeur était un 80286 basse consommation, à 12 MHz.

Le Thinkpad

Avec le ThinkPad 700C, en 1992, IBM propose le premier ordinateur portable doté d’un écran TFT couleur de 10,4 pouces. C’est aussi un des premiers à utiliser une matrice dite active, plus rapide, qui permet d’adresser directement chaque pixel contrairement aux anciennes matrices passives. Proposé sous Windows 3.1, le ThinkPad 700C était animé par un processeur 80486 et offrait un disque dur de 120 Mo.

L’avènement des écrans CRT

Dans les années ’90, les écrans CRT se sont démocratisés, et des coûteux écrans de 14 pouces, on est passé à des écrans de 15, 17, 19 et même 21 pouces. Dans la majorité des cas, on est resté au format 4:3 des téléviseurs, avec une entrée VGA et des définitions parfois très élevées : 1 024 x 768 sur les bons 15 pouces, 1 600 x 1 200 sur les 19 pouces et même 2 048 x 1 536 sur les modèles de 21 pouces. En 2000, Sony a sorti ce qui peut être considéré comme un des meilleurs écrans CRT : le GDM-FW900. Ce 24 pouces (22 pouces visibles) au format 16:10 intégrait un hub USB et pouvait afficher du 2 304 x 1 440 à 80 Hz, soit pratiquement la même définition que les écrans de 27 pouces haut de gamme actuels.

Le Trinitron

Pendant quelques années, les écrans CRT haut de gamme ont utilisé une technologie Sony, le Trinitron. Elle permettait un bien meilleur ajustement des canons à électrons et évitait les défauts de convergence sur les côtés des écrans. Le seul défaut des écrans Trinitron était la présence de fils horizontaux, permettant de fixer la grille. Ces derniers, spécialement sur les écrans haute définition, étaient parfois visibles sur fond clair. Le brevet étant assez ancien, la technologie tombe dans le domaine public en 1996, ce qui a permis à d’autres sociétés de proposer des technologies similaires. Le Diamondtron de Mistubishi est par exemple dérivé du Trinitron.

Les premiers LCD pour PC

Si les écrans LCD sont devenus omniprésents, ça n’a pas toujours été le cas. Un des premiers modèles prévus pour les PC et le « grand public » est le FlexScan L23 d’Eizo. En 2012, les caractéristiques font sourire : 13,8 pouces de diagonale, définition de 1 024 x 768, ~260 000 couleurs affichables (18 bits), deux entrées VGA et une consommation annoncée de 30 W. Les angles de vue étaient courts : 140° en horizontal et 110° en vertical. Des données comme la luminosité maximale ou le temps de réponse ne sont pas encore communiqués à l’époque, en 1997. Nous n’avons malheureusement pas retrouvé le prix de cet écran à sa sortie.

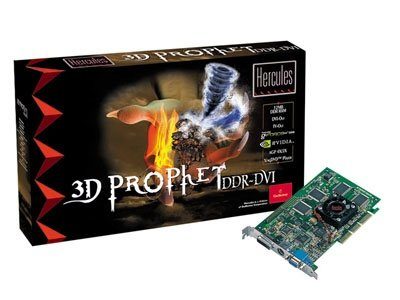

L’arrivée du DVI

Ratifiée en avril 1999, la norme DVI arrive en novembre de la même année dans les PC, avec la GeForce 256 de Guillemot. La Hercules 3D Prophet DDR-DVI est en effet la première carte grand public à proposer du DVI en plus du VGA (une seule sortie étant utilisable à un instant t). Le DVI est intéressant dans le cas des écrans LCD : il permet d’éviter les conversions. A l’époque, toutes les cartes graphiques calculaient l’image en numérique, convertissaient le signal en analogique pour l’envoyer dans la sortie VGA et l’écran recevait le signal analogique qui étaient ensuite converti en numérique pour l’affichage. Avec le DVI, le signal reste numérique de bout en bout, ce qui limite les dégradations, du moins en théorie. Notons que les écrans LCD dotés d’une entrée VGA sont toujours assez courants en 2012…

2001, le premier écran « retina »

Si on attend beaucoup des écrans en très haute définition en 2012 (« Retina »), ce n’est pas nouveau. IBM proposait déjà des modèles avec une résolution très élevée en 2001. L’IBM T220 sorti en 2001 travaillait en effet en 3 840 x 2 400 sur une diagonale de 22 pouces. Diverses évolutions verront le jour jusqu’en 2005, date de l’arrêt de la production. Le premier modèle nécessitait quatre canaux DVI, une carte graphique dédiée (Matrox G200) et deux alimentations, le tout avec un taux de rafraîchissement assez faible de 41 Hz.

Le premier ordinateur portable 17 pouces

Pendant des années, les ordinateurs portables ont utilisé des dalles de « petite » taille et des formats classiques comme le 4:3 (parfois le 3:2). En 2003, Apple lance le premier modèle doté d’un écran d’une diagonale de 17 pouces (et abandonne cette diagonale en 2012), avec une définition de 1 440 x 900. Au format 16:10 (le 16:9 suivra quelques années plus tard), le PowerBook G4 était comme toujours onéreux : 3 300 $. En 2012, les dalles de 17 pouces sont toujours appréciées, mais les appareils sont au format 16:9 et offrent généralement une définition bien plus élevée : du 1 920 x 1 080.

Le premier 30 pouces

Encore Apple, avec cette fois le premier écran de 30 pouces. La société a souvent été à la pointe dans les écrans, mais avec généralement des connecteurs propriétaires (ou rares) comme l’ADC au début des années 2000 et le Mini DisplayPort plus récemment. Pour le premier 30 pouces, en 2004, Apple utilise une connectique standard : le DVI. Vu la définition élevée (2 560 x 1 600), c’est sa version Dual Link qui est utilisée. L’écran de 30 pouces a été lancé à un prix très élevé — 3 300 $ sans compter la carte graphique à 600 $ — avant de diminuer au fur et à mesure des années. Même actuellement, les écrans de 30 pouces restent rares et chers, mais les 27 pouces au format 16:9 sont plus abordables et offrent des définitions proches (2 560 x 1 440).

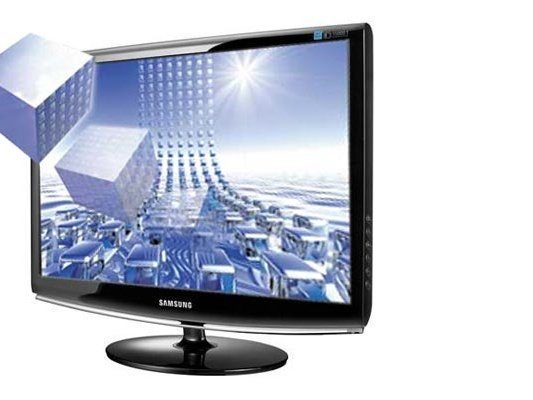

Les écrans 3D

Si la 3D « relief » existe depuis des années (Elsa a sorti des lunettes dans les années ’90), il a fallu attendre 2009 pour qu’elle soit vraiment utilisable. Et c’est avec un écran LCD Samsung, le SyncMaster 2233rz, que NVIDIA a lancé sa technologie 3D Vision. C’est le premier écran à travailler à une fréquence de rafraichissement de 120 Hz, alors que la majorité des autres écrans (encore actuellement) travaillent à 60 Hz. Très rapide, il a longtemps été une référence dans le domaine.

Un écran (très) large

Dans les écrans atypiques sortis ces dernières années, il y a celui du Vaio P. Ce pseudo-netbook — c’en était un par son format, moins par son prix — avait en effet un écran de 8 pouces avec une définition peu courante : 1 600 x 768. Ce format très large était intéressant, mais la résolution bien trop élevée (220 ppp) a empêché la machine d’avoir du succès.

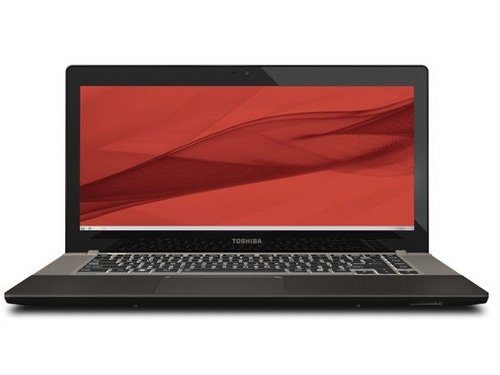

La mode est au 21:9

Si on est passé assez rapidement du 4:3 au 16:10 dans les ordinateurs portables (avec quelques formats atypiques comme le 3:2) avant que le 16:9 ne devienne la norme, le futur pourrait être au… 21:9. Toshiba a récemment présenté un modèle dans ce format, le U845W doté d’un écran de 14,4 pouces en 1 792 x 768, ce qui est assez atypique.

Retina arrive

Si les écrans à haute définition existent depuis plusieurs années, nous l’avons vu, le nouveau MacBook Pro Retina et son écran de 15,4 pouces en 2 880 x 1 800 (220 ppp) amène une nouveauté : un support par le système d’exploitation. L’écran est donc parfaitement utilisable dans un usage classique, contrairement aux autres écrans haute définition qui sont généralement illisibles sans modifier les paramètres du système d’exploitation, ce qui amène — souvent — des bugs graphiques. Windows 8 devrait amener une réponse à ce problème, différente de celle choisie par Apple.

Le futur

Et le futur ? On devrait avoir des écrans plus fins, avec des définitions plus élevées et des résolutions de plus en plus grandes. Le DisplayPort devrait se démocratiser et remplacer le DVI alors que le HDMI deviendra le nouveau « standard » universel, à la manière du VGA. La technologie LCD en rétroéclairage LED devrait être à terme enfin remplacée par l’OLED, les premiers téléviseurs à cette norme commençant à arriver dans les échoppes…

Les derniers articles