Le bond en avant qui préfigure de grandes choses.

Intro, caractéristiques et méthode de test

Dernière mise à jour du 10 juillet : après une grande période de doutes, nous avons confronté nos résultats à des tests comparables, et vérifié plusieurs de nos tests, pour finalement conclure que ce test des deux Ryzen 3700X et 3900X affiche des mesures correctes, et parmi les plus proches de la réalité actuellement. Notamment dans les jeux. Quoi qu’il en soit, les BIOS (et AGESA) n’étant toujours pas en version finale, il est probable que les performances varient encore dans les semaines qui viennent. Plus d’explications sur cette page.

C’est le moment que tout le monde attend, au point de s’abstenir massivement d’acheter avant de savoir : les Ryzen 3000 vont-ils mettre clairement fin à la domination d’Intel dans les performances des processeurs grand public ? Pour répondre à cette question, nous testons ici les deux premiers CPU qu’AMD a distribués à la presse : les Ryzen 7 3700X et Ryzen 9 3900X.

| CPU | Ryzen 9 3900X | Core i9-9900K | Ryzen 7 3700X | Core i7-9700KF | Core i5-9600K |

| Cœurs / Threads | 12 / 24 | 8 / 16 | 8 / 16 | 8 / 8 | 6 / 6 |

| Fréquence base (MHz) | 3800 | 3600 | 3600 | 3600 | 3700 |

| Fréquence Boost max (1 cœur) (MHz) | 4600 | 5000 | 4400 | 4900 | 4600 |

| Fréquence Boost sur tous les cœurs (MHz) | 4300 | 4700 | 4100 | 4600 | 4300 |

| Cache L2 (Mo) | 6 | 2 | 4 | 2 | 1,5 |

| Cache L3 (Mo) | 64 | 16 | 32 | 12 | 9 |

| Lignes PCIe | 24 | 16 | 24 | 16 | 16 |

| TDP (W) | 105 | 95 | 65 | 95 | 95 |

| Prix constatés (euros) | 514-549-589 | 510 | 343-359-389 | 420 | 258 |

Zen 2 : une énorme mise à jour d’architecture

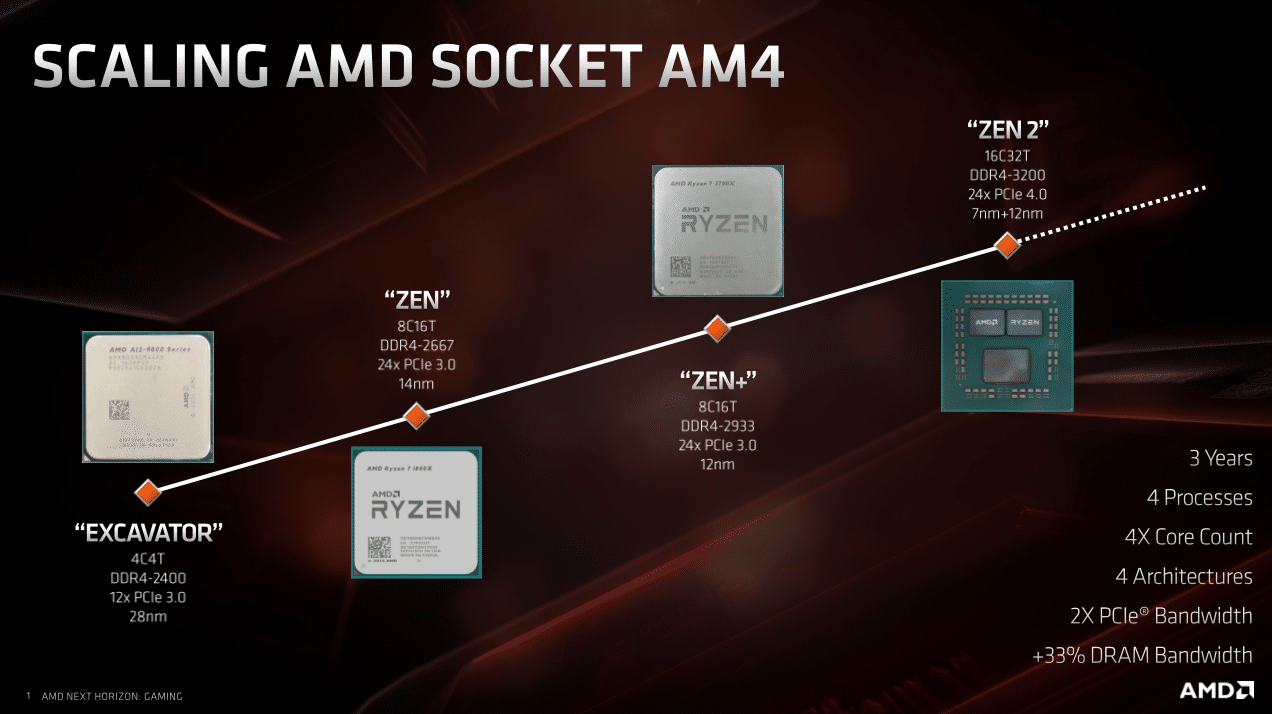

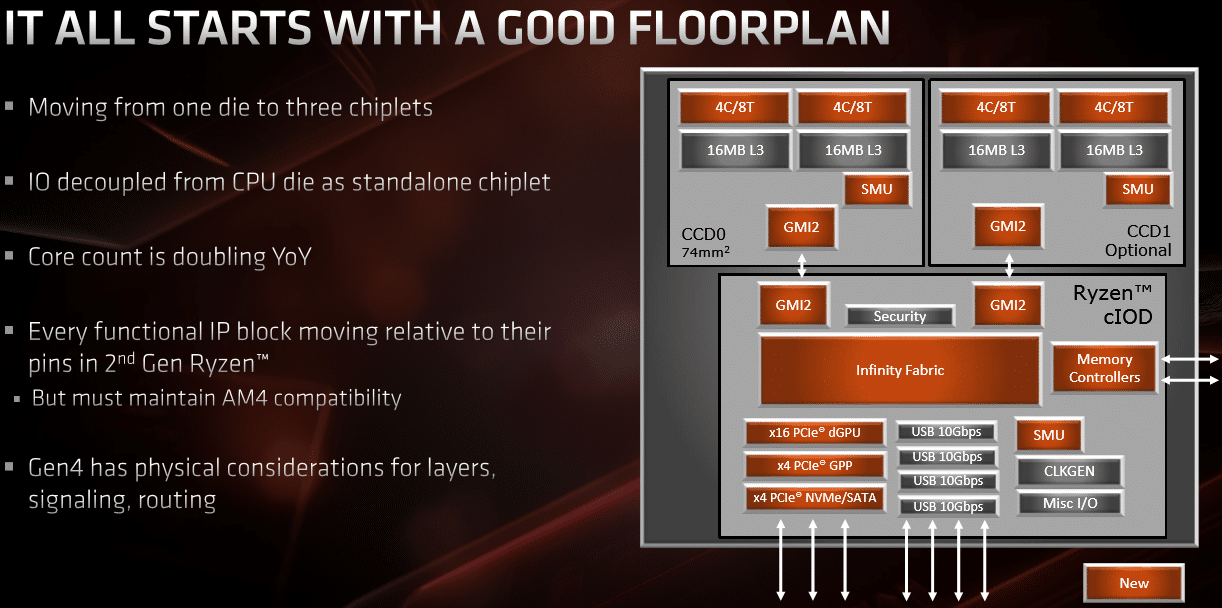

Les Ryzen 3000 profitent de plusieurs avancées majeures, à commencer par la gravure en 7 nm. Ce sont les tout premiers processeurs x86 à profiter de cette finesse, grâce au fondeur TSMC. Ces CPU subissent aussi un changement structurel majeur : ce sont aussi les premiers du genre à adopter une organisation de type “chiplet”, qui consiste à regrouper plusieurs puces sur un seul package. Ici, on pourra voir jusqu’à deux puces CPU en 7 nm, accompagnées par une troisième puce gravée en 12 nm chez GlobalFoundries pour gérer toutes les entrées-sorties (mémoire, PCIe, USB, etc.).

Du côté des changements majeurs de l’architecture Zen2 elle-même, AMD liste plusieurs améliorations de taille : augmentation de la taille du cache Micro-Op, optimisation des unités de calcul flottant (en particulier du côté des instructions AVX256) ou encore ajout d’une nouvelle AGU (unité de génération d’adresses) . Outre de nombreuses amélioration du cache à tous les niveaux, on notera surtout que le cache L3 double, à 32 Mo par puce CCD (16 Mo par CCX de quatre coeurs). De quoi réduire la latence mémoire pour améliorer notamment les performances en jeu. AMD annonce ainsi 15 % de performances IPC (instruction par cycle) en plus par rapport à Zen+, avec un gain de 75 % de performances par Watt !

| Ryzen 9 3900X Nombre de threads en charge | 1 | 2 | 3 -4 | 5 – 12 | 13 – 24 |

| Fréquence Boost (MHz) | 4600 | 4500 | 4425 | 4350 | 4300 |

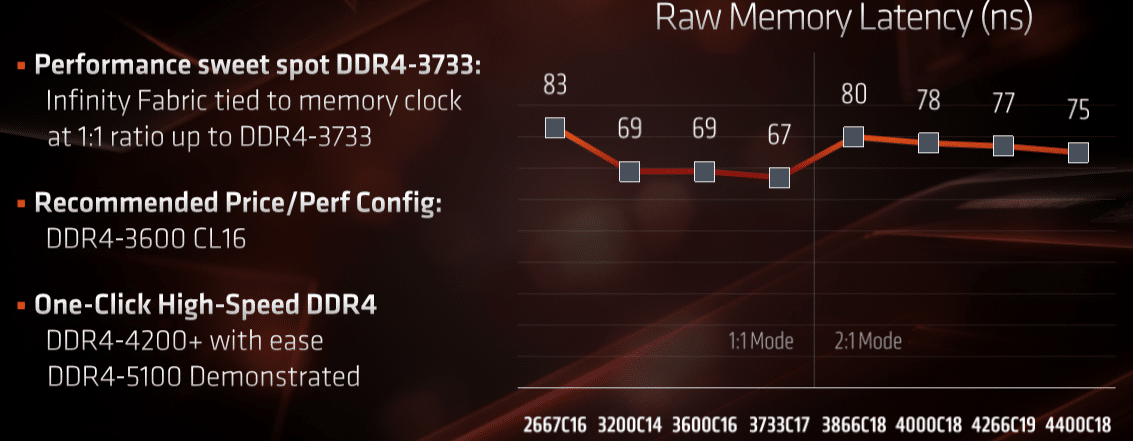

Enfin de la DRAM à haute vitesse

C’était l’un des principaux points faibles des précédents Ryzen. Les nouveaux Ryzen 3000 auront de quoi se défendre côté mémoire vive. Les processeurs seront capable de gérer la RAM en 1:1 jusqu’en DDR4-3733 (3600 dans la doc de test d’AMD), ce qui permettrait de réduire encore les latences et donc d’améliorer les performances. Il peuvent aller plus haut encore (jusqu’en DDR4-5100 en test interne), mais en découplant les fréquences. Les latences remontent alors un peu :

| Fréquences OC | Fréquence mémoire (mclk) | Fréquence contrôleur mémoire (uclk) | Fréquence Infinity Fabric (fclk) |

| Jusqu’en DDR4-3600 (ou 3733) | 1 | 1 | 1 |

| Exemple en 3400 MT/s | 1700 MHz | 1700 MHz | 1700 MHz |

| A plus de 3600 (ou 3733) MT/s | 2 | 1 | 1800 MHz fixe |

| Exemple en 4400 MT/s | 2200 MHz | 1100 MHz | 1800 MHz |

| Slots DIMM occupés | Ranks | Taux de transfert officiellement gérés |

| 2 sur 2 | Single | DDR4-3200 |

| 2 sur 4 | Single | DDR4-3200 |

| 4 sur 4 | Single | DDR4-2933 |

| 2 sur 2 | Double | DDR4-3200 |

| 2 sur 4 | Double | DDR4-3200 |

| 4 sur 4 | Double | DDR4-2667 |

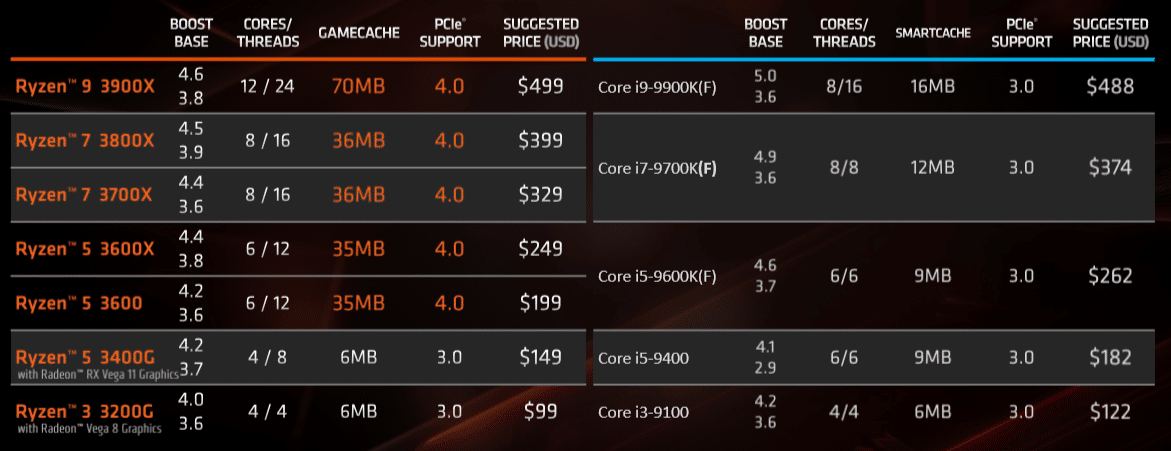

Moins chers ? Mais pas avec la carte mère

Les Ryzen 3000 ont des prix très agressifs face aux processeurs Intel, et pourraient les forcer à réduire leur tarif si leurs performances sont vraiment menaçantes. Il y a toutefois un bémol de taille : le prix des cartes mères X570 qui ne tombe pas en dessous de 200 euros !

Quand on sait qu’on peut aujourd’hui acheter une carte mère Intel Z390 pour presque 70 euros de moins, la concurrence semble un peu plus difficile sur le prix de l’ensemble de la plateforme à acheter.

Configurations de test

Un grand merci au revendeur Infomax, qui nous a prêté les différents processeurs Intel 9600K, 9700KF et 9900K le temps de ce test.

Plateforme Intel

| Carte mère | SuperMicro C9Z390-PGW |

| CPU | Intel Core i7-8700K (OC @5 GHz) Intel Core i9-9900K @Stock Intel Core i7-9700KF @Stock Intel Core i5-9600K @Stock |

| DRAM | G.skill Trident Z Royal 2x 8 Go DDR4-3600 CL16 |

| GPU | NVIDIA GeForce RTX 2080 Ti (pilotes 430.86) |

| Alimentation | Thermaltake Thougpower iRGB Plus 1050W |

| Refroidissement | AlphaCool Eisbaer 280 |

| Système d’exploitation | Microsoft Windows 10 Home 1903 (18362.207) |

Plateforme AMD

| Carte mère | Asus ROG Strix X570-E Gaming (Bios 7007 – AGESA 1.0.0.2*) |

| CPU | Ryzen 9 3900X @Stock (PBO activé*) Ryzen 7 3700X @Stock (PBO activé*) |

| DRAM | G.skill Trident Z Royal 2x 8 Go DDR4-3600 CL16 |

| GPU | NVIDIA GeForce RTX 2080 Ti (pilotes 430.86) |

| Alimentation | Thermaltake Thougpower iRGB Plus 1050W |

| Refroidissement | AlphaCool Eisbaer 280 |

| Système d’exploitation | Microsoft Windows 10 Home 1903 (18362.207) |

*Les BIOS les plus récents de nombreux constructeurs de cartes mères se basent sur la version AGESA 1.0.0.3. Or, celle-ci semble poser problème au niveau des fréquences maximales atteignables par ces nouveaux Ryzen. Nous avons donc fait le choix de rester sur un BIOS bêta avec AGESA 1.0.0.2. En conséquence, bien que le PBO soit activé, nous soupçonnons qu’il soit en réalité non fonctionnel. Un autre problème concerne la tension par défaut, trop élevée, appliquée aux processeurs.

Bande passante mémoire et cache L3

Bande passante RAM

Commençons par examiner les capacités pratiques de la nouvelle structure « chiplet » des Ryzen 3900X et 3700X. Les performances de bande passante DRAM (sous AIDA64) sont excellentes pour le 3900X, qui surpasse les CPU Intel dans tous les domaines : lecture, écriture et copie. Notez que nous avons choisi de tester tous ces CPU avec de la bonne grosse RAM DDR4-3600 CL16, vitesse indiquée comme optimale (perf/prix) par AMD.

Latence RAM (ns)

Si la bande passante mémoire des Ryzen est au niveau, voire supérieure, la latence de communication entre les CPU et sa DRAM est 50 % plus élevée que chez Intel, ce qui risque d’handicaper les Ryzen dans certains tests. C’est un peu compréhensible dans la mesure ou cette communication doit passer par le chiplet d’entrée/sortie du Ryzen, qui fait la jonction entre le chiplet CPU et la DRAM, ajoutant forcément de la latence.

SPECviewperfs 13 : Composite Scores

Les nouveaux Ryzen sont d’excellents travailleurs. AMD parvient ici à grandement réduire l’écart avec les processeurs Intel dans les tests qui dépendent beaucoup de la puissance d’un seul cœur (IPC et fréquence boost mono-cœur).

Suite aux (trop) nombreux débordements et dérapages allant jusqu’aux insultes pour certains, je ferme les commentaires. Le dossier sera mis à jour, et la section commentaires ré-ouverte, quand Asus fournira un BIOS corrigé et 100% fonctionnel. D’ici là, un peu de calme fera le plus grand bien à tous les rageux et fanboys, quelle que soit leur couleur de prédilection 🙂

Malheureusement, votre test ne répond pas à la question. Par rapport à un i5 9600k, le prix plus élevé d’un 3700x plus carte mere x570 n’est pas justifié dans le cas d’une utilisation gaming. Autant profiter des soldes et des baisses chez Intel pour avoir une très bonne plateforme de jeux Pc moins cher même si ce n’est pas de dernière génération…

Ce test ne répond pas à votre question car nous nous refusons à remplacer votre libre arbitre et votre jugement sur les prix des plateformes. Notez que nous précisons d’emblée en première page que le prix de la plateforme X570+Ryzen 3000 est difficile en concurrence face à Intel. Nous sommes ravis de voir que nos tests de performances vous permettent de tirer vos conclusions par rapport à vos envies et besoins. Remarquez toutefois que vous pouvez opter pour une carte mère X470 ou antérieure, moins chère et compatible Ryzen 3000.

Ne vous méprenez pas, merci du boulot accompli et de nous permettre, comme vous dites, de nous faire notre propre avis. Pour être honnête je m’attendais à quelque chose de tranché! Mais au final comme tout dans la vie rien n’est parfait et il faut faire son choix. Merci

Sauf que dans les scènes lourdes, le 9600k voit son fps chuter drastiquement, ce que les tests en fps moyen ne mettent pas en valeur.

Regardez bien dans la courbe de fps de Total War dans cette page : https://www.tomshardware.fr/test-ryzen-3700x-3900x-9900k-8700k-9600k-9700k-comparatif/7/

Elle montre exactement ce que vous dites 🙂

Bonjour,

Je trouve que Tom’hardware y va un peu fort en disant que le temps se gâte quand il s’agit de jouer (12% que personne ne verra), d’autant plus que demain ces tests montreront autre chose une fois que les optimisation si il y a seront faite. Les jeux sont les programmes les moins optimisés et en plus les optimisations sont pour la plupart été faites sur des core intel (4 coeurs)

Il est difficile de dire qu’AMD a loupé le coche sur les jeux tant que les jeux n’auront pas évolués. Je ne me baserait pas sur des programmes de piètre qualité pour faire des tests. Je préférerais qu’un programme soit mis au point avec toutes les optimisations possibles pour connaitre le meilleur des processeurs et c’est cela qui me gêne beaucoup actuellement.

Toutefois, c’est impressionnant de la part d’AMD d’être revenu à ce niveau de performances et vu les tarifs des processeurs, cela risque de changer enfin la politique tarifaire d’intel qui nous prend pour moutons depuis tant d’années.

Bravo aux ingénieurs d’AMD!

Pour le prix des cartes mères, je ne me fait pas beaucoup de soucis car je pense que le prix va baisser assez rapidement et que les B550 devraient aussi sortir.

Cette problématique d’optimisation des jeux vidéo (et applications), nous en parlons dans le test, et elle date des premiers Ryzen. Votre pari sur l’évolution des jeux vidéo est viable, notre test de Total War le démontre bien. Nous aussi nous félicitons les les ingénieurs d’AMD pour cette progression, cette audace dans l’innovation (chiplet, etc). Difficile pour l’instant (le premier jour !) de vous dire quoi acheter, mais au moins, ce test vous montre exactement les forces et faiblesses des Ryzen 3000.

Tout a fait d’accord, d’autant plus que les moyens d’AMD sont 10 fois inférieurs à Intel en termes de cash et personnel! Intel a dormi toutes ces années tout en nous prenaant pour des pigeons.

Bon après on critique les prix mais aujourd’hui, le 7 juillet, c’est la sortie officielle des CPUs.

On verra dans 3 mois c’est les prix se tassent un petit peu.

Globalement on reste sur des prix classiques de lancement de procs…

Le 9900k na pas pris la méchante tape sur les fesses que tout le monde lui prédis ! et finalement intel a encore du temps devant lui pour sortir un processeur abouti. je note toutefois que l’overclocking des Ryzen 3000 na pas été abordé dans l’article c’est pourtant assez important pour le consommateur final.

Côté overclocking, le PBO de Ryzen est un overclocking auto qui fait presque aussi bien que l’OC manuel. Nous les avons testés avec. Regardez les autres tests qui abordent l’OC et vous verrez que le gain est quasi-nul : car les Ryzen s’OC automatiquement à partir du moment où ils sont bien refroidis (c’était déjà le cas avec les secondes générations).

Côté 9900K et le temps qui reste à Intel, le test confirme effectivement ce que vous dites, mais il n’y a pas beaucoup de temps quand même, surtout si on espère des optimisations logicielles pour Ryzen. Suspens !

Sinon côté overclocking encore, un 9900K à 5 GHz mettra encore tout le monde d’accord, n’est-ce pas 🙂

Tout le monde sera d’accord : un excellent moyen de chauffer votre chambre en hiver…

spafaux 🙂

Sans aucun doute d’autant plus que son homologue Ryzen 7 3700X va faire chuter son prix

Bonjour, merci pour ce test, j’ai actuellement à i5-4670k et j’attendais la sortie de ces ryzen pour upgrader tout ca, mais du coup je vois que vous avez fait vos tests avec de la ram 3600Mhz CL16, est ce que c’est ce qu’il se fait de plus opti pour ce type de matériel (que ce soit intel ou AMD) ?

Ils vont ont donné combien Intel par hasard ? Nan parce que moi j’ai un 3900X depuis peu et ça déchire tous les i7 !

Fanboy alerte ? Aucuns chiffres ni argument d autant plus que le cpu vient de sortir officielement aujourd’hui petit malin ? rendors toi ou reviens avec de vrais chiffres ou arguments merci.

Vivant aux state, je connais des personnes qui l”ont eu avant, j”ai pas la chance d’en avoir un encore 🙁

Toutes les review d aujourd’hui prouvent que le 9900k restent devant en jeux pour le moment toi tu viens juste avec ton blabla de fanboy

Regarde les test en jeux plutôt par ici je ne sais pas pourquoi mais on à pas du tout les mêmes retour : https://www.cowcotland.com/articles/2755-11/test-des-processeurs-amd-ryzen-7-3700x-et-ryzen-9-3900x-intel-atomise.html

Avec une 1080 Ti…. Arrêtez un peu la parano merci.

Pourriez vous nous expliquer cette différence, et quelle est le problème avec une 1080ti en Full HD ?

Si vos tests vous retournent ces résultats je comprend votre “étonnement” mais comment cela est-il possible ? Nous voulions des tests juste, c’est à dire que les résultats collent plus ou moin de site en site. Comme nous pouvons le voir les résultats avantage trop clairement tel ou tel marque ce qui pousse le lecteur à la suspicion, chose normal il faut l’admettre.

et vous ne comprenez rien aux test CPU en gaming. une 1080 Ti n’est pas suffisante pour creuser les écarts, même en Full HD.

Désormais je vais supprimer tous vos commentaires de gros parano nous diffamant “d’être des vendus”

Et bien … merci pour la confirmation 😉

De rien !

Ah mon avis vous devriez les laissser, ça ne peux que montrer la parano de certains…

Bruno Cormier, rassurez moi vous n’êtes pas journaliste ?

C’est quoi votre façon d’être et de faire… je reprends vos commentaires:

– “Désormais je vais supprimer tous vos commentaires”

– “totalement n’importe quoi, merci pour ce commentaire ridicule”

– “LOL”

– “MDR”

… vous avez quel age ?

Si votre article est au niveau de votre répartie… je vais m’éviter une lecture 😉

Slt ASV ?

Fallait éviter le commentaire aussi du coup

Ils vous ont donné combien AMD pour votre commentaire ? (vous voyez c’est facile en fait !)

ComputerBase, dont les tests sont significativement plus poussés que les votre arrivent quand même à une conclusion radicalement différente à la fois en jeux et en applicatif. En FHD le 9900K est donné à 3% devant le 3900X et au même niveau en UHD. https://www.computerbase.de/2019-07/amd-ryzen-3000-test/3/#diagramm-test-performancerating-fuer-spiele-fps-uhd

ouai donc ce sont exactement les mêmes conclusions que les notres à quelques % près.

Et “plus poussé” ca veut dire quoi ? Ils ont testé avec 150 jeux, dont 149 n’étaient pas dépendants du CPU ? Par ailleurs, un test CPU en 4K n’a aucune valeur.

Euh aucune valeur? Si on achète une RTX 2080 Ti c’est pas pour jouer en 1080p, ni même en 1440p je pense. Mais plutôt en 2160p, non? De plus si vous voulez que votre test de jeux ai vraiment une valeur représentative de la réalité et bien il faudrait mieux prendre une RTX 2060 ou une RX 590, car c’est bien la puissance moyenne très haute dont dispose le joueur lambda à l’heure actuelle.

Faut surtout lui dire qu’il a fait son test avec un bios défectueux donné a la presse par AMD (qui underclock les 3700x et 3900x) et un driver nvidia foireux lui aussi (qui fait des erreurs WHEA qui provoquent fps drop et frameskipping).

Les résultats donnés ne devraient pas être considérés comme valides, il manque entre 5 à 15% selon ce qu’on teste.

merci de nous montrer VOS tests alors. MDR

Pas la peine puisque le Môssieur t’explique qu’AMD s’est auto-torpillé en envoyant un BIOS foireux à tout le monde 😀 😀 😀

Non, vraiment, certains semblent avoir moins bien supporté la canicule que d’autres…

(et merci pour cette bonne rigolade dès le lundi matin, ça fait du bien)

ca n’a rien à voir, l’idée consiste ici à ne pas avoir de limite GPU pour pousser le CPU dans ses retranchements. Il n’est pas question de tester des résolutions optimales pour la carte graphique, qui n’est pas testée ici. Plus vous montez en résolution, plus l’écart entre les CPU se réduit, c’est logique, mais ça ne veut rien dire.

Et bien dans ce cas là il faut aller au bout de la logique et tester les jeux en 800*600 pour n’avoir strictement aucune limite GPU quelque soit le GPU. Pourquoi vous le faites pas? La réponse est que c’est absurde et que cela ne correspond à aucun usage réel. Une RTX 2080 Ti c’est fait pour jouer en 4K et pas en 2K à 150 ou 200 fps. CQFD.

On a hésité à tester en 320 x 240. La prochaine fois on le fait rien que pour vous.

on va dire cqfd oui lol

Bon après c’est un vieux débat mais faire un test CPU qui en vaux 400€ avec un GPU qui vaut plus de 1000€ dans une résolution non optimale pour ce genre de matériel (test jeux tous à plus de 100 fps, ce qui est une aberration), c’est un peu du grand n’importe quoi non? La réalité c’est que le joueur moyen qui va acheter un 3700X va lui coller une RX 2060 (ou équivalent) et que vous lui dite qu’en jeu un 9900K fera un peu mieux, ce qui est profondément faux.

Il a fait son test avec un bios défectueux de base (ainsi que des drivers nvidia défectueux aussi), cherche même pas plus loin, tous, littéralement tous les résultats donnés dans le test sont erronnés.

totalement n’importe quoi, merci pour ce commentaire ridicule.

Et pourtant il se pourrait qu’il y ait un soucis avec les drivers Nvidia : https://www.reddit.com/r/AMD_Insights/comments/cachuz/it_appears_that_the_issue_is_with_nvidia_cards/

Votre ton condescendant en prend quand même un petit coup là ….

On est en AGESA 1.0.0.2 sur une carte mère Asus (pas de bug de fréquences) et il n’y avait pas d’erreurs WHEA relevées par HwInfo64 ou autre. Mais vous semblez en savoir plus que nous au sujet de nos propres protocoles de tests, vous deviez probablement être cachés dans notre labo pendant les benchs ?

Disons que quand il y a 4 rédactions qui prennent la décision de refaire leurs tests (dont anandtech) et qu’il n’y a aucune transparence sur le bios utilisé on peut remettre légitimement en doute votre test.

“With this information, I decided to flash BIOS, the first BIOS released for the X570 AORUS MASTER board and surprise, the boost frequencies were working as they should, even beyond the processor at 4.65 GHz. The WHEA error problem in the PCI Express was still going on, so I kept pressing and trying if the problem was maybe the chipset driver”

Le bios AGESA 1002 résoud le problème de fréquences mais pas le problème du WHEA error et ce qui est curieux c’est que vous semblez être les seuls à ne pas avoir eu ça, alors que les retours sur reddit disent que ça impacte toutes les CM en x570 + nvidia. C’est pour le moins… curieux.

Autres précisions : vous parlez de la conso sur vos tests, mais pas de l’o/c automatique. Il semblerait également qu’il soit défectueux (en lien avec le bios) et qu’il balance une tension de 1,5V alors que la safe limit est de 1,375V. Y’a déjà deux CPU qui ont cramé (un 3700x et un 3900x) avec respectivement une tension de 1,45 et 1,5V en o/c automatique chez des reviewers.

Sur ce point là également, le test n’a pas été fait rigoureusement. Quand on voit certains reviewers balancer du 1,5V tranquilou sur les screens, c’est un miracle que leurs cpu n’aient pas cramé directement.

Autre élément (très technique) mais qui concerne directement les CM Asus : un peu de lecture. Retour pareil, les tests doivent être considérés au mieux comme “très suspicieux”, au pire comme invalides.

https://www.overclock.net/forum/10-amd-cpus/1728758-strictly-technical-matisse-not-really.html

La carte mère que nous avons utilisé ne fait pas partie des quatre modèles fournis par AMD. Marrant, n’est-ce pas ?

Désolé de ne pas avoir eu de bug. C’est peut-être qu’on n’est pas assez compétent pour ça.

Mais non… Pas dans le cas d’un test CPU. Vous ne comprenez pas la notion de limitation GPU.

Je comprends parfaitement votre démarche. Cela dit faire un test avec une RTX 2070, en WQHD, cela permet de montrer au néophyte qu’il y a aucune différence notable entre CPU vu que dans 99% des cas, c’est le gpu qui est limited. Sur ce point je suis d’accord, sur le fait qu’il manque qqch, peut être d’inutile mais d’important pour une personne n’étant pas un expert du fonctionnement des PC.

Mettez vous à la place d’une personne qui veut monter son PC gamer soit même, il voit votre test car il hésite entre Intel et AMD, il peut se dire que Intel c’est nettement mieux pour son utilisation alors que concrètement, il ne verra aucune différence avec un ryzen, tout en ayant plus de marges à l’avenir, ou les moteurs de jeux gèreront mieux les coeurs que maintenant.

Il s’agit d’un test CPU, pas d’un tuto sur comment monter une config équilibrée !

On aurait fait le test avec une config comme vous dites, tout le monde nous aurait traité de “vendus à AMD”

Le but n’était pas de faire un test uniquement en WQHD, mais les 2, avec aussi un test en 1080P, et la pour le coup on aurait pas pu vous traiter de vendus pour aucune des 2 marques !

On a pas la même notion de test alors, à quoi ça sert un test si c’est pas pour s’aider à choisir quelle processeur acheter ? (donc pour faire une config ?)

Le fait de mettre les 2 aurait justement permis de montrer le potentiel gaming actuel avec le 1080P tout en montrant que la différence est inutile. Voilà ce que j’appelle, un test intelligent, vous contentez tout le monde et y a de l’information intéressante pour tout le monde,m que ce soit les gros connaisseurs ou les néophytes.

Je tiens à préciser que je ne vous traite pas de vendus, je trouve votre test très bon ! C’est juste ce point qui me chagrine chez vous et de nombreux confrères. Pour ma part la complémentarité d’informations ne nuit pas aux tests.

Ce test nous a pris plusieurs dizaines d’heures, voir plus d’une centaine. On bosse non stop depuis une semaine (n’oubliez pas qu’on a testé aussi les Radeon et les RTX Super). Les journées n’ont que 24h, et il faut faire des choix, la priorité étant de montrer le vrai potentiel d’un CPU.

“un test CPU en 4K n’a aucune valeur.” => Je comprends bien pourquoi techniquement vous dites cela, mais d’un autre côté, votre machine de test est clairement calibrée pour du gaming 4K. Pour du FHD un bon vieux 2500K ou 2700K OC avec une GTX1080 fait bien le job, je doute que l’oeil humain soit capable de voir une différence significative entre 80 et 160FPS (hors effet placebo).

Du coup oui, je pense qu’il y a une réelle pertinence à tester ce type de config en conditions réelles, donc en 4K, non pour faire ressortir artificiellement des écarts, mais justement pour que l’on se rende compte le cas échéant qu’il n’y a aucun écart significatif en situation réelle.

En fait ma remarque rejoint vos propres commentaires sur les bench 3Dmark : ils sont à prendre avec des pincettes car ils ne reflètent pas les performances réelles en jeu. Et bien de la même manière, les tests de jeux en FHD sur une telle config doivent être pris avec des pincettes, il serait dommage de choisir un processeur sur la base de résultats dans une résolution qui ne sera jamais utilisée.

Vous ne comprenez pas. Il s’agit ici de tester un CPU, incroyable quand même. Un test en 4K ne révèle d’aucune manière la puissance potentielle du CPU, le test n’aurait servi à RIEN. D’autre part, si je dois pousser le bouchon un peu plus loin : en réel, si les gens préfèrent jouer en FHD à 120 Hz que 4K à 40 fps, il faudrait un CPU qui tienne la route pour suivre le GPU.

mais qu’importe, ce test mesure la puissance du CPU, une énorme 2080 Ti en Full HD est le seul moyen de le faire correctement. Point;

Certe non, il suffit de prendre une petite RTX 2060 et de jouer en 800*600 pour n’avoir aucune limite GPU. Je suis même à peu près certain que les écarts entre les CPU seraient encore plus grand. Le problème c’est que cela ne correspond strictement à aucune utilisation réelle, comme de jouer à 150 fps avec une RTX 2080 Ti en 1080p ou 1440p. Après faut pas s’enerver, j’ai juste l’esprit de contradiction. C’est juste que des tests avec une RTX 2080 Ti en 1080p/1440p qui ne doit représenter que 1% des volumes de ventes de GPU de Nvidia, ça me fait quand même un peu marrer.

Non mais j’ai bien compris l’idée, mais comme ça a été dit par d’autres plus haut, si on veut aller encore plus loin dans ce sens, on peut aussi descendre en dessous du FHD, les écarts seront encore plus nets et suivant votre logique vous testerez encore mieux le CPU. Bref, je ne dis pas de ne pas mettre de test en FHD, mais il faudrait aussi mettre en test en 4K ne serait-ce que pour arriver justement à la conclusion qu’in game, en usage réel en 4K avec ce type de matos, le choix AMD / Intel sur ce point est indifférent. Sur ce point, votre titre “gros travailleurs, petits joueurs” est un peu trompeur en ce sens qu’une personne qui ne s’y connaît pas trop mais qui se monte un gros PC gamer 4K pourrait aller sur un 9900K en pensant obtenir un vrai plus, alors qu’au final il aurait mieux fait d’économiser sur le CPU et de rediriger ce budget économisé sur le GPU.

Ou comme je le mentionnait, faire le test en FHD mais avec tous les réglages gpu uniquement sur low, ainsi le cpu serait fortement sollicité et une 1080ti ferait très largement l’affaire pour 120fps et +.

Nous n’avons pas forcement tous rédigé des articles sur le sujet mais cela ne veux pas dire que nous somme forcement des débutants dans le secteur 🙂

Bah justement : le test que vous avez mené sur les jeux ne sert strictement à RIEN non plus.

Puisque le coeur d’usage du CPU n’est pas le jeu, et qu’à partir du moment où on met un budget suffisant sur le GPU aucun CPU récent ne va l’affecter suffisamment pour que ça se ressente à l’usage.

Je sais bien que les analogies automobiles sont toujours très foireuses, mais ça revient presque à dire qu’on compare deux moteurs de F1 dans une fourgonnette de commerçant pour voir combien de volume ça peut transporter : baaah, on s’en fout en fait, clairement les deux fourniront largement assez de puissance pour tous les usages normaux de ladite fourgonnette.

Ou, mettons, dans une citadine compacte : peu importe qu’un moteur donne un peu plus de pêche que l’autre, les deux seront également surdimensionnés pour faire du 0-40 en ville et des tenus à 120 sur autoroute…

Du coup, si en fait le test a un propos, que vous ne mettez malheureusement pas en valeur : “aujourd’hui peu importe le CPU si vous avez un bon GPU”.

Et, en capacité de projection que vous devriez normalement avoir en tant que journalistes : “demain, la majorité des jeux et applications seront conçues de manière lourdement multithreadée, donc un proco 8 coeurs ‘vieillira’ mieux qu’un 6 coeurs.

Alors ça c’est marrant, parce que c’est juste notre conclusion : “ce qui donne au final des produits intéressants, tournés vers l’avenir. Et c’est peut-être là la cerise qui manque sur le gâteau : ces processeurs grand public ont besoin d’applications massivement parallélisées pour donner le meilleur d’eux-même, ce qui n’est hélas le cas que d’un nombre encore trop faible de jeux vidéo.”

Ceci dit, ma phrase de conclusion était peut-être trop complexe et pas assez claire. Si c’est effectivement le cas, j’en suis désolé.

“je doute que l’oeil humain soit capable de voir une différence significative entre 80 et 160FPS (hors effet placebo).”

la encore, vous avez tout faux

J’ai pourtant quelques pdf scientifiques qui le montre pourtant en double blind test. Surtout si on utilise un dispositif avec variable adaptatif framerate. En gros ce que disent ces papiers scientifiques c’est qu’au délà de 60 fps, l’augmentation du framerate est perçu comme une augmentation de la résolution et non plus comme une augmentation de la fluidité. Et que le gain ressenti est inférieur à une augmentation réelle de la résolution. En gros cela signifie qu’il vaut mieux jouer en 3840*2160*60 qu’en 1920*1080*240. C’est d’ailleurs dans ce sens que s’oriente l’industrie du jeu: la cible c’est bien le 4K60 et pas le 2K240. Après p’tête que eux aussi ont tout faux, mais là j’ai quand même un léger doute.

Marrant, parce que l’industrie s’oriente aussi vers des écrans à 240 Hz. Saleté d’industriels qui n’arrivent pas à se décider !

“La persistance positive, qui dure peu de temps, environ 50 millisecondes ; la couleur de l’image persiste, paupières fermées. L’œil est donc théoriquement capable de capter 20 images par seconde, au-dessus de ce seuil, il ne verra pas le clignotement des images, en dessous la succession d’images est perceptible.” https://fr.wikipedia.org/wiki/Persistance_r%C3%A9tinienne

On peut discuter du seuil limite, mais clairement à partir d’un certain stade c’est de l’effet placebo et du marketing, il ne faut pas se leurrer. C’est exactement comme les discussions sur les forums de passionnés audiophiles. Au bout d’un moment les gars sont persuadés d’entendre des différences bien au-delà des capacités humaines. Mais les tests scientifiques sérieux, en double aveugle etc, montrent qu’il s’agit en réalité d’effet placebo.

Se baser uniquement et exclusivement sur la persistance rétinienne pour justifier un framerate à partir duquel un mouvement apparait fluide est totalement foireux. C’est un peu comme si j’expliquais que l’œil humain étant capable de distinguer le flash d’un appareil photo qui durerait 1/1000ième de seconde, il faudrait obligatoirement monter au delà de 1000 FPS pour qu’une séquence d’images fixes (la nuance est importante) apparaisse fluide. C’est aussi foireux que votre raisonnement. Et de toute façon je ne vois pas le rapport avec mon commentaire précédent. La bise.

Oui l’explication plus haute est foireuse. La limite de perception de la fluidité est plutôt dans les seuils de 60 à 80 fps. Ensuite d’autres mécanismes HVS entrent en jeux. Les écrans hautes fréquences, à l’origine, ce n’est pas pour avoir une meilleure fluidité, c’est fait pour lutter contre la problématique de synchronisation de l’affichage entre GPU (VFR) et Dalle (CFR). Aujourd’hui ce problème n’existe plus avec GSync et Freesync. Les Gogo qui prétendent que c’est mieux de jouer à Fortnite en 1080p à 240 fps plutôt qu’en 2160p à 60 fps me font bien rigoler.

C’est faux encore, désolé.

J’ai bien précisé “On peut discuter du seuil limite” et je n’ai jamais défendu l’idée que cela ne servait à rien d’avoir plus de 20FPS cela va de soi. Mais l’impression de fluidité a quand même beaucoup à voir avec la persistance rétinienne et très clairement les retours sont décroissants. Je ne suis pas du tout convaincu que je serais capable de déceler facilement une différence entre une scène à 50FPS et la même à 60FPS. Peut être des yeux experts (les vôtres) voient une différence entre 60FPS et 80FPS. Mais on ne me fera pas croire que je suis bigleux au point que des humains voient deux fois plus de FPS que moi. Par ailleurs si on peut voir un flash de 1/1000e de seconde ou moins c’est parce que son intensité est énorme et imprime très fort les photorécepteurs de la rétine. Cela fait essentiellement le même effet que de recevoir un flash un peu moins puissant mais un peu plus prolongé. Notre système nerveux n’en tire pas plus d’information. Bref, vous avez beau dire que tout cela est faux, dans ce cas je lirais avec le plus grand intérêt un article de votre part traitant ce sujet en détail, avec sans doute quelques liens vers des sources d’articles scientifiques montrant qu’en double aveugle, l’oeil humain peut déceler une différence de fluidité jusqu’à tel ordre de grandeur de FPS. Cela pourrait sincèrement être un sujet intéressant à traiter par THFR. Ce serait fun de concevoir un FRAPS truqué indiquant 120FPS sur un jeu à 60FPS et sur un autre un FRAPS indiquant 60FPS sur la même scène en 120FPS. Mais dans cette attente je reste sur mon avis qu’il y a beaucoup d’effet placebo.

Bonjour,

j’aime beaucoup vos réactions.

En vrac…

1. Le coup du “ouin les cartes mères sont trop chères” c’est risible : déjà parce qu’il serait utile de rappeler que pour le moment et au moins jusqu’en 2022, le surplus fonctionnel du chipset x570 est inutile pour le commun des mortels (et celui qui serait prêt à payer à prix d’or les premiers périphériques en PCIE4 ou BT5 a donc largement les moyens de se payer un 570).

Ensuite parce qu’ont déjà été annoncées des cartes mères basées sur du 570 en dessous de 200 euros.

2a. On peut tout autant arguer que le test en full HD n’a aucune valeur si on va par là : après tout, les gamers sont préjugés acheter de grosses cartes graphiques, donc des cartes qui gèreraient très largement le FullHD quelque soit le processeur derrière tant qu’il s’agit d’un processeur de moins de 2 ans.

Le test de vos confrères allemands illustre d’ailleurs très bien le fait que pour un gamer, il vaut mieux réserver la part du lion du budget pour la carte graphique plutôt que le CPU : les CPUs ne font aucune différence réelle, c’est la carte graphique qui patine (à des vitesses plus que raisonnables, certes) en 4k.

2b. Ou alors, on considère le fait que le FullHD est intéressant à évaluer parce qu’il s’agit toujours de la définition la plus pratiquée aujourd’hui et pour les 3-4 ans à venir, et dans ce cas il faut à minima…

– préciser que la différence de vitesse n’a absolument AUCUNE espèce d’importance puisqu’on reste dans tous les cas à un niveau de FPS complètement overkill pour le joueur moyen, et suffisamment sur-performant même pour les rares à avoir des moniteurs à 120 ips.

– faire la mesure de consommation totale des pcs en jeu pour chaque jeu afin d’avoir une mesure réelle dans un cas d’usage concret.

– faire la moyenne performance / consommation / prix d’achat de la plate-forme (carte mère comprise, sachant que les processeurs et cartes mères peuvent se garder un bon paquet d’années) tous composants égaux par ailleurs (RAM/boîtier/alim etc), ce qui permettrait de constater le montant que l’on économise sur l’achat du socle CPU/CM qui peut être répercuté immédiatement dans du confort (ventilateurs/capacité de RAM ou disque) ou de la montée en gamme (meilleur GPU, RAM plus rapide).

3. En l’occurence, le test suslié de vos confrères allemands n’apporte absolument pas “exactement les mêmes conclusions que les notres à quelques % près.”

Au-delà du fait que les valeurs sont en moyenne inférieures pour tous les jeux “communs” (ce qui me laisse penser qu’ils mettent un réglage plus poussé de rendu à moins qu’ils n’aient pas pris la même CG) ils illustrent le fait qu’il existe déjà un certain nombre de jeux pour lesquels AMD prend déjà la tête.

En gros, dès qu’un jeu exploite un minimum le multi-threading, AMD a de grandes chances d’être meilleur.

OR, TOUTES LES CONSOLES À VENIR seront basées sur des CPU ayant AU MOINS 4 coeurs (PS5 a déjà annoncé 8).

Côté IT, le mouvement de réécriture de bon nombre d’applications standard ou spécialisées pour tirer parti du multicoeur est en vitesse de croisière.

Autrement dit, que l’on parle du jeu ou du travail, avoir plus de coeurs pour le même prix est plus rentable à moyen terme qu’une meilleure fréquence.

Bref, il n’y a réellement aucune bonne raison de recommander autre chose que du AMD aujourd’hui à moins de vouloir acheter une machine juste pour les 12/24 mois à venir.

Oh merci pour le lien c’est excatement ce que je cherchais 😉

Quant à l’encodage H265, je suis un peu spécialiste du domaine. Un 8C/16T va déjà saturer l’encodeur et vous ne serez pas en charge complète CPU à 100%. De plus l’encodeur x265 qui est utilisé est particulièrement bien optimisé AVX2 et ce n’est pas les SIMD AVX qui sont comparables entre Intel et AMD qui feront la différence mais bien les SIMD AVX2. Si vous voulez faire un test vidéo en CPU à charge 100%, il faudra utiliser le codec x264, de préférence avec une source 4K. Je peux, si vous voulez, vous finir un test en ligne de commande qui évitera les biais sur le décodage software qui sont loin d’être négligeable surtout si vous utilisez une source H265 4K à fort débit avec un encodage x264/265 en mode rapide. https://forum.doom9.org/showthread.php?t=174393

Pour finir je note que le 3700X n’est pas le plus rapide des 8C/16T d’AMD et même très loin de là. Le 3800X avec un TDP beaucoup moins contraint que le 3700X (105W vs 65W) fera sans doute beaucoup mieux dans les appli massivement multithread. Et mieux en jeux aussi avec des fréquences qui montent plus haut. Il aurait peut-être été bien de tester un 3700X en simulant les fréquences maximum d’un 3800X et en modifiant le TDP cible, si c’est possible à réaliser.

La très faible conso enfonce le clou pour moi, j’achèterai un Zen 2.

Clair, sur ce point y a de quoi mettre tout le monde d’accord.

Dites m’sieur Cormier, j’ai fait un petit post mais je sais pas s’il a été censuré ou pas. Vous êtes au courant que le bios sur lequel vous avez effectué les tests est “foireux” et que les tests effectués ne devraient pas être considérés comme valables ? Sur chaque test, avec le bios donné a la presse par AMD, il manque entre 100mhz à 400mhz sur chaque core, sur les 3700x et 3900x

Par ailleurs il y a un pb de drivers nvidia qui provoque des erreurs WHEA (hardware errors) qui fausse les résultats de benchs des jeux ! (fps drops et frameskipping)

et nous n’avons eu aucun problème d’erreur WHEA avec les pilotes nvidia.

Intel est devenu une blague, leurs Cpu ne servent plus qu’à jouer

https://www.cowcotland.com/news/68014/test-des-processeurs-amd-ryzen-7-3700x-et-ryzen-9-3900x-intel-atomise.html

Expliquez moi comment vous pouvez avoir autant de différence en jeux que les test Cowcotland ?

de plus les test sur ne net trouvez montre que le ryzen est meme meilleur que le plus gros intel a partie du 1440p

on en parle sur le forum HFR, le bios qu’AMD a donné a la presse est défectueux, et invalide tous les résultats. Il manque entre 100 à 400mhz sur chaque core, l’o/c (ou boost) automatique ne fonctionne pas comme il devrait.

Par ailleurs il y a un problème de drivers défectueux de nvidia (avec les ryzen 3000) qui fausse tous les résultats en jeux ce qui explique pourquoi il y a autant de différences entre tous les tests effectués.

Littéralement, tous les benchs de la presse sont a refaire et toutes les valeurs qui ont été données sont erronnées. Il manque entre 5 à 15% sur les benchs en fonction de ce qu’on teste.

oui les forumers de HFR ont eu les produits et les ont testés eux-même bien sûr… Nos fréquences sont correctes avec les deux CPU pour notre part.

Arrêtez vos affirmations dans le vide.

avec une GTX 1080 Ti qui met déjà un 2600X au niveau d’un 9600K ? 🙂

techpowerup obtient les mêmes résultats que nous pour info

https://www.techpowerup.com/review/amd-ryzen-7-3700x/15.html

et les boost clock sont parfaitement normaux et même bien élevés : https://www.techpowerup.com/review/amd-ryzen-7-3700x/20.html

merci pour les rumeurs 🙂

d’autre part, plein de site expliquent que le PBO d’AMD est un OC auto et qu’il n’est donc pas vraiment possible de faire mieux en manuel.

Du coup je sais pas d’où vous hallucinez ces histoires d’erreur WHEA et de BIOS foireux, à partir d’un seul site.

et poutrant : https://www.reddit.com/r/AMD_Insights/comments/cachuz/it_appears_that_the_issue_is_with_nvidia_cards/

Un bon test dans l’ensemble!

Il manque certaines informations moins grand public comme le temps de compilation d’applications lourdes, ou encore l’aspect sécurité et encryptions.

Mais bon monsieur tout le monde ne s’intéresse pas vraiment à ça donc je peux comprendre que ce ne soit pas inclut… Bien que le test Blender donne un assez bon aperçu.

Peut être un test plus axé plateforme de travail plus tard ?

Moi ce que je trouve bizarre c’est sur d’autres sites les résultats des tests sur les derniers ryzen ne correspondent en rien à ce qui est indiqué ici.

où quand comment svp

Sur Intel.com.

ici par exemple : https://www.cowcotland.com/articles/2755/test-des-processeurs-amd-ryzen-7-3700x-et-ryzen-9-3900x-intel-atomise.html et ici : http://www.comptoir-hardware.com/articles/cpu-mobo-ram/39273-test-amd-zen-2-x570-a-ryzen-7-3700x-ryzen-9-3900x.html

Nous faisons confiance à nos tests, et si vous étudiez bien les autres tests (config, GPU, jeux identiques), vous verrez que c pas comparable, ou que les résultats sont similaires. Par ailleurs, nous aussi, on peut vous donner plein de liens de tests qui CONFIRMENT les notres. Donc bon…

Moi ce que je trouve bizarre, c’est qu’on doit surement avoir la plus grande concentration d’architectes processeurs au monde parmi nos lecteurs, vu les commentaires 😀

Ou alors c’est juste la Saint-Je-Sais-Tout aujourd’hui…

Nous ont se demandent si vous n’auriez pas reçut un chèque … étant donné que vous avez besoin de lecteurs pour vos articles, j’imagine qu’il serait bon (pour vous) d’éviter ce genre de remarque.

vous êtes un gros parano.

Diffamation : “allégation ou imputation d’un fait qui porte atteinte à l’honneur ou à la considération de la personne ou du corps auquel le fait est imputé”.

Je suppose que ça ne vous dérange pas que je screen votre commentaire ?

Bien sûr il n’y à aucune affirmation. Screen le même 2 fois si cela te rend heureux 🙂

Ceci dit tu ferais mieux de te demander pourquoi la majorité des lecteurs ont cette réaction…

Je ne suis pas un Fanboy mais il est légitime de demander pourquoi les résultats de tests (de manière général) sont-ils si différent d’un site à l’autre. Votre devoir à vous est de nous apporter l’info la plus juste et pourquoi pas d’expliquer clairement selon vous les différences décrié de manière pédagogique ?

Protocol de test, drivers, version logiciel, il y à de la matière car ne l’oubliez pas sans nous vous n’êtes plus rien 🙂

“La forme dubitative, ironique ou interrogative n’est pas exclusive d’un fait précis, il est donc inutile de déguiser les propos sous des insinuations, de se servir du conditionnel ou d’émettre des doutes”.

C’est juste fatiguant d’être continuellement mis en cause par des fanboys alors qu’on fait tout pour être parfaitement impartial, surtout que la supposée marque qui nous paierait change chaque jour de la semaine (AMD le lundi, Intel le mardi, Nvidia le mercredi, VIA le jeudi, Cyrix le vendredi, …), et qu’on explique régulièrement nos protocoles de tests. Donc oui, j’en ai “marre” que les gens pensent qu’Internet est une zone de non-droit. Et oui, la diffamation publique s’applique dans ce cas précis. N’en déplaise à une minorité de lecteurs.

Voila enfin un commentaire appréciable 🙂 les “vous êtes des paranos” ect … franchement ce n’est pas terrible.

Au risque de me répéter je ne suis pas un Fanboy donc cela ne s’applique pas à moi, ce qui veux dire que beaucoup de monde a partir de maintenant vas venir vous en parler.

J’imagine que vous-même avez dans ce cas du être surpris des autres résultats et ce que moi (et les lecteurs) aimerions connaitre, c’est votre opinion à ce sujet.

Sans toi (on se tutoie apparemment), t’inquiète pas, on est encore quelque chose.

Ah zut, effectivement, j’ai oublié de lui faire la bise à la fin. My bad.

Pas de soucis, je n’était de toute façon pas venu commenter pour vous énerver mais réellement dans le but de comprendre.

Bise Vances1

Tu devrais très sincèrement laisser Yannick s’exprimer à ta place quand il s’agit de commenter le forum.

Rhoo, j’ai trop INpacté tes sentiments anonymes ?

Du tout et puis comme tu le dit si bien “Ce que je dis ici n’engage que moi.”

Inpact … c’est l’époque ou j’ai été le premier mondial à réussir une décapsulation sur core2duo quand tout les sites spécialisés se cassait les dents ainsi que les cores ^^. Je ne me sens pas si anonyme que tu le pense, d’ailleurs tu à ma boite mail et mon IP 🙂

J’ai lu sur ginjfo qui reprenait un site américain selon lequel Intel en interne demande d’encourager les tests ne mettant pas en avant les forces d’amd mais plutôt ou Intel domine, est-ce que tom’s s’arrime déjà aux propos d’intel ?

Est-ce que tom’s s’arrime déjà aux propos d’intel ? => déjà cette phrase ne veut rien dire, mais je devine l’esprit (on est vendu etc.)

Nous n’avons AUCUNE relation avec Intel en fait. A tel point qu’on a du demander les CPU Intel à un revendeur (c’est écrit dans notre test).

Donc stop la parano svp ?

Merci pour le test

Est-ce qu’il est prévu de tester l’impact des fréquences mémoire ?

Sur X470 et X570 ?

Ca pourrait être intéressant de savoir quelle RAM acheter

Merci

oui, nous sommes en train de faire les tests 🙂

Moi en tout cas ce que je ne trouve pas bizzare c’est que comme partout sur le net y aura toujorus des rageux qui sauront toujours mieux que vous ce qu’il se passe et ce que vous auriez du faire et comment il aurait fallu le faire et a quel heure vous auriez due allé pisser ….

Merci Tom’s hardware pour l’actu, moi je lis bcp de site , je compare , j’analyse, je réfléchie, les autres arrétez de croire que vous savez tout tout le temps mieux que tout monde , ça crée un débat improductif et c’est relou a lire

Merci. Et oui, vous avez raison de lire plusieurs tests pour vous faire votre idée, il faut bien faire la différence entre les configurations utilisés, les jeux et les méthodes de test, nombre de jeux notamment (ce qui influe énormément sur les moyennes). Nous ne disons pas que nos tests sont supérieurs aux autres. Nous affirmons toutefois que nos résultats sont exacts.

Merci pour le test et désolé si je t’est froissé mais c’est bien d’avoir le cœur net

Wahou, le débat déchaînes les passions…et les suspicions lol

Bravo pour vos tests et le temps que vous y avez passé les gars, et vu les actualités que je vois défiler, j’imagine que vous ne devez pas vous ennuyer en ce moment chez TH…

Je ne voudrais pas remettre une pièce dans la machine, mais j’avoue que, bien que je comprenne l’existence de différences entre les protocoles de test et le choix des jeux (optimisés ou non), moi aussi j’aurais bien aimé que vos test et ceux de cowcotland se recoupent. Quoiqu’il en soit, j’ai déjà mis le bras dans l’engrenage en investissant dans une cm x570, donc j’ai décidé d’avoir la foi lol

J’ai toujours été adepte d’intel, depuis la fin des année 90, suite à de gros problèmes de compatibilité des tout premiers athlons (j’ai la rancœur tenace), mais cette fois, après avoir suivi régulièrement les news et les premiers tests non officiels de la série 3000, j’ai décidé de tenter le coup à nouveau avec amd. Je n’ai pas les moyen de me payer une config de ouf, je mise plutôt sur l’évolutivité. Même si les perfs de mon futur 3700x seront 15% inférieures aux intel, je disposerai déjà du PCIE 4.0, et comme ni les intel de la série I, ni même ceux de la série X ne l’exploitent, amd aura un peu de répit pour nous pondre de nouveau ryzen bien plus rapides que le 3950X. Couplés avec les nouvelles cartes graphiques et des SSD M2 en version 4.0, cela devrait nous permettre d’attendre sereinement les futurs proc intel…

En tout cas, une chose reste intéressante pour moi dans vos tests, c’est que pour la partie travail, le ryzen s’avère un bon choix, parce qu’après 9 ans de bons et loyaux services, mon portable asus g74s était vraiment limité pour faire un peu de montage sous da vinci resolve…Je vais enfin pouvoir imaginer de créer quelques animations dans mes vidéo, cool !

En tout cas, j’espère que le débat va s’apaiser un peu

Bonne continuation à tout le monde

Wow ça castagne par ici, rarement vu ça sur TH.

mon analyse:

Pour du jeu: 9700k en haut de gamme (tellement proche du 9900k, vraiment difficile de justifier ce dernier), Ryzen 5 3600 sinon.

En productivité: 3900x.

Le 3700x en bon All-rounder …

Le 9600k, le 9400f et les autres CPU Intel, n’ont par contre plus aucune raison d’être à leur prix actuel …

N.B. à leur prix planché les 2600 et 2700 ont encore de beau reste également.

Merci du test je vais prendre le 3700x au lieu du 3900x pour le peut de différence

@merlim pour du jeu ?

Autant partir sur un 3600 alors.

En production par contre la différence entre le 2900x et le 3700x est quand même assez colossale.

Tu veux dire 3900x sinon j’ai pas encore vu de test pour le 3600 car j’ai déjà un 2700x sur ma config et oui c’est pour du gamer

Non 2600, presque aucune différence avec un 3700x … (tester sur computerbase.de)

Mais en venant d’un 2700x, je ferais l’impasse sur cette gen Ryzen, ça vaut pas vraiment le coup.

3600, pas 2600 my bad …

les tests de comptoir-hardware.com sont intéressant, car leurs résultats sont utilisé avec des logiciels parfois différents.

http://www.comptoir-hardware.com/articles/cpu-mobo-ram/39273-test-amd-zen-2-x570-a-ryzen-7-3700x-ryzen-9-3900x.html?start=15

Pour l’applicatif, ils ont utilisé : Aida 64 / 7-zip (mais le benchmark, vos test de compression/décompressioon semble alors plus pertinent) / VeraCrypt / asmFish / Tensorflow / After Effects / blender (chez eux le 3700 x est 11% plus rapide que le 9900K, mais chez vous c’est le 9900 k qui est plus rapide : protocole de test différent je suppose) / Vegas Pro / Lightroom Classic / DxO PhotoLab / HandBrake (h.264 & h.265) / Cinebench R20 / V-RAY Next / Visual Studio 2019 / Compilation GCC 8.2 / compilation linux /

[Cela donne le ryzen 7 3700x a 100% , le core i9-9900K à 84% et le i7-9700k à 69%]

Je ne remet pas en cause la pertinence du choix des logiciels que vous avez fait, par contre mon estimation est du coup influencer d’une autre manière évidemment ! Les points de vues se complète donc. Vos conclusions en applicatif se rejoignent : les Ryzen sont bons ! Mais l’écart, avec vos logiciels, n’est pas du tout le même qu’avec les leurs.

Pour le ludique, avec une 2080Ti OC, avec les jeux suivants : Far Cry New Dawn / Grand Theft Auto V / Hitman 2 / Metro Exodus / Project CARS 2 /The Division 2 / The Witcher III / Total War : Three Kingdoms / World War Z / X-Plane 11

les jeux sont patchés à priori.

[Cela donne le ryzen 7 3700x a 100% , le core i9-9900K à 103% et le i7-9700k à 102%]

Comme il s’agit, quoi qu’il en soit, de test théoriques et qu’un utilisateur à 99% de chances (j’exagére?), avec [ces] CPU, qu’il soit GPU limited pour le nombre d’image par seconde qu’il obtiendra, certe intel est devant mais c’est somme toute purement théorique et non pratique.

Vos test, avec un poil moins de jeux, donne ces résultats là : [Ryzen 100%; i9-9900k 114.418% , i7-9700k 112.31% ]

Sois 11 et 10% de plus que leurs tests à eux. C’est assez conséquent ! Spécialement car vous avez laisser le PBO (qui est un boost de fréquence automatique, donc) sur les Ryzen, là où comptoir-hardware affirme avoir désactivé toute optimisation et oc par défauts sur les cm utilisés. Pourtant l’écart est très faible chez eux et bien plus grand chez vous ! Certains des jeux en test ont alors donné des résultats significativement différents, malgré l’usage d’une 2080ti pour chacun d’entre vous.

Par exemple :

Farcry 5 / Chez eux : 3700x = 109 ips / 9900k = 125 ips- Chez vous : 3700x= 120.8 ips / 9900k = 159.8 ips

vous utilisé aussi le build 1903 de windows, surement du 1080p pour chacun … bref ! Mystère !

Merci pour votre tests en tout cas, je regroupe des informations ici et là pour me faire une opinion plus proche de la réalité et donc votre test à le mérite de nourrir cette réflexion !

Faut voir les proportions de jeux cpu bounded ou pas dans la moyenne des jeux. ca change tout et explique les differences.

pour far cry 5 c pas le même test : new dawn d’un côté et farcry 5 de l’autre.

etc. bref, les deux tests sont valables hein, mais oui faut vous faire une idée en lisant plusieurs tests.

cela serait bien qu’un jour vous fassiez un article sur ses jeux mal codés. Et sur l’Unreal Engine (Fortnite, PUBG) qui favorise les Gpu Nvidia. Quand on voit que des personnes se battent parce qu’il faut passer par plusieurs stores pour jouer mais qui ne se plaignent pas qu’il faille tel ou tel matériel pour jouer dans de meilleures conditions.

C’est comme si un éditeur de film nous obligerait d’acheter telle marque de lecteur Blu-Ray pour pouvoir voir leurs films dans de bonne condition ….

Edit ces numéro de bios sont erronés, le gars d’anandtech le dit lui même sur reddit, il s’agit de V11 et de V12 , pas de V10 et V11 .. voila voila

Tous les testeurs n’ont pas utilisé une carte mère msi…

Oui mais ce sont tous les bios qui sont plantés par AGESA, Amd a décidément bien foiré le lancement, la ou le 3900X ne dépassais jamais 4.5 , il est revenu à du 4,65 Ghz sans oc, juste avec le PBO , ce qui est apréciable et ce qui est le résultat normal en fait,

en gros toutes les reviews sont fausses, les fabricants de carte mères vont régler le problème et on auras des meilleures performances que ce qu’on vois actuellement.

La nouvelle version D’AGESA sera la version 1.0.0.3AB comparé à l’actuelle version 1.0.0.3

Gigabyte à par exemple déja sortis ce bios https://www.reddit.com/r/Amd/comments/c9vmw9/new_agesa_1003ab_released/

Possible que le 1.0.0.3 soit buggé, effectivement. Mais cela expliquerait pourquoi notre bios Asus en 1.0.0.2 ne soit pas touché par ce problème de fréquences.

Et le bios sur lequel vous avez votre test (vous ne parlez jamais des fréquences cpu…des pros) est un bios encore en beta si vous remarquez bien.

Quand on regarde les test de Gamers nexus ou tout simplement Der8auer on se rend bien compte qu’il y a un problème de fréquence cpu , enfin bref tout ça vas sortir très bientot et sera réglé dans le mois.

Quand on regarde certains autres tests, on voit des cartes mères Gigabyte ou MSI en AGESA 1.0.0.3 si vous remarquez bien. Dommage, ce n’est pas notre cas, il faut apprendre à lire.

Et désolé d’utiliser les BIOS bêta fournis à l’instant T par les constructeurs. Mais votre commentaire est constructif et permet de nous améliorer : désormais, je prendrai un soin tout particulier à bien expliquer que nous n’avons pas nos propres équipes d’ingénieurs cachés chez tous les constructeurs de cartes mères. La bise.

Rien n’est encore certain, donc du calme avant de tout généraliser. Nos fréquences sont bonnes (plus de 4,5 GHz monocoeur sur Bios Asus en AGESA 1.0.0.2, et PBO actif)

En effet, sur votre msi en AGESA 1.0.0.2 il semblerais que tout fonctionne comme il faut, sur mon premier lien Reddit le gars explique qu’il a du revenir en 1.0.0.2 pour que cela fonctionne, Donc en effet c’est bien la version 1.0.0.3 qui créer ces problèmes, dans ce post on peux avoir un résumé de toutes les review des cpu

https://www.reddit.com/r/Amd/comments/c9ncvh/3rd_generation_ryzen_reviews_megathread/

et on peux remarquer que yen a pleins qui n’ont jamais atteints les 4.5 ghz, avec le 3900x , certains n’ont pas dépassé les 4.3 ghz, pour les 3700X c’est pareil, certains ne dépassent pas 4,25 ghz … bref ça vas creer la confusion et j’admet que votre test fonctionne sur la bonne version donc vous avez quelque chose de juste, après des “petits joueurs” … pour avoir 10 % de performances en moins en m’évitant 250 € de frais, sans compter le ventilateur à 70 balles pour soutenir un 9900k , ainsi qu’une carte mère couteuse, sans compter si je veux mettre en route le MCE ^^

c’est une victoire pour AMD , et je sais lire, j’ai juste pas trop lu votre test parcqu’il n’est pas intéressant, 3 graphiques qui se battent en duels , aucune analyse en profondeur, désolé les gars mais c’est pas pour être méchant mais c’est ultra simplet comme test.

…Asus…

donc tes commentaires ne servaient à rien, t’avais tort et t’es monté sur tes grands chevaux.

et t’as pas lu notre test.

donc t’aurais jamais dû commenter.

La boucle est bouclée. Vu ton niveau, il faut effectivement que t’ailles voir des tests beaucoup moins simplets avec plein de graphs partout PaRCe qUe cA FAit pRo.

Haha oui Asus pardon, après je peux pas vous reprocher de pas faire des test de 25 pages, vous êtes une presse grand publique, je peux comprendre que le lecteur moyen décroche après quelques minutes de lecture et qu’il se fou d’aller dans des détails techniques.. mon niveau ? je suis ceinture noire en critique de testeurs info ^^

😀

Quel dan ^^ ?

oula, au moins 20 ans d’expérience sur l’informatique ^^ désolé j’étais un peut agressif, dans ma tête vous êtes juste une antenne du site américain et les news & test proviennent de la maison mère, la bise !

Ok, donc on est loin du noob de base, tant mieux 😉

Bah non justement, on est totalement indépendant des US. Les tests, c’est moi, avec mes petites mains, qui m’en suis occupé. Du coup c’est encore plus rageant de recevoir toute cette agressivité injustifiée en pleine tête 😀

😮 ah, vraiment navré dans ce cas xD

La section commentaires m’a donné mal à la tête.. Et surtout n’amène rien de plus, ça bitch sur les résolutions et les résultats jeux de CPU qui franchement sont presque sans intérêt, ça se joue toujours à une dizaine de frame dans des conditions optimale..

alors qu’il me semble (et je peux me tromper étant pas vraiment un mordu de hardware, juste un gars lambda qui bosse sur son pc) que l’intérêt du cou c’est bien la partie boulot/application

et là on a certes l’encodage et des apps 3d mais les app autres les plus utilisé comme photoshop light room, final cut da Vinci première et j’en passe on a rien.. Je prêche peut-être pour ma paroisse mais du coup je suis pas plus avancé avec ce test.

tout comme le problème des cartes mère qui d’ailleurs était la raison de ma visite, savoir si les nouveaux chipset valent leur prix ou si c’est pour de la branlette d’OC ou de mecs qui montent des pc gamers à 4000€… Est ce que ça bottleneck ou pas etc..

bref juste mon humble avis hormis les commentaires sur vendu pas vendu, fanboy ou pas dont on a rien à faire pour être honnête, ça donne beaucoup d’infos sur le test, avec des termes desfois incompréhensible pour le grand publique mais qui ne répond pas vraiment à certaines questions simple de la personne lambda

Cordialement

On fait apparaître le nivellement avec du 1080p justement, pas du 2160p.

Mais bien sûr, quand les moules auront des glands… Et vous imaginez un acheteur de 3900X jouer et travailler en 1080p ? 60Hz peut-être même ? Wake up, on est en 2019…

La question que je me pose, j’ai envie de monter en perf sur le gaming j’ai un 2700x. Est-ce qu’il vaut mieux que je revende ma RTX2080 pour une 2080 SUPER, ou est-il mieux d’upgrade le 2700x vers le 3700x ? Sachant que pour l’instant les perf de la 2080 Super sont inconnu…

@Moadib En 1080p je serais plutôt tenté de prendre le 3700x

Je suis en 2560/1080, de plus j’aime bien rester à niveau et j’ai la possibilité de limiter la casse en faisant reprendre mon 2700x avec 16 des 32 Go de RAM 2666 que j’ai dans ma tour. Du coup je pèse le pour et le contre entre mettre un billet sur la reprise de la 2080 ou un biller pour upgrade le CPU.. Certes c’est un peu un problème de riche, mais c’est dès la sortie d’une nouveauté qu’il vaut mieux se séparer de la version précédente carte ou cpu…