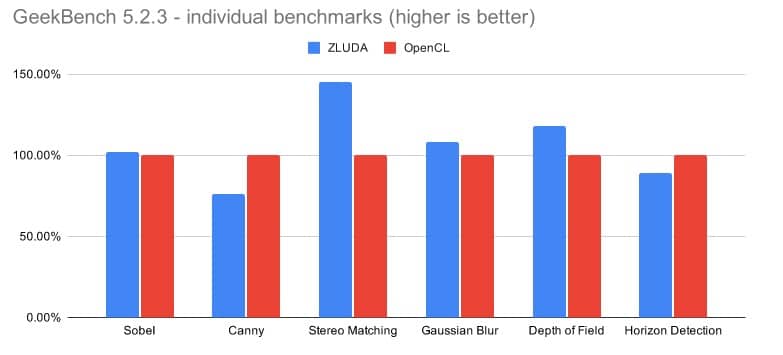

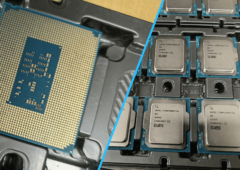

Quelques résultats de l’iGPU d’un Core i7-8700K sur Geekbench 5 avec ZLUDA.

La technologie CUDA (Compute Unified Device Architecture), introduite en 2007, avait déjà servi de source d’inspiration à VUDA, une bibliothèque pour l’API Vulkan. Voici maintenant ZLUDA, décrit sur GitHub comme “un remplaçant de CUDA sur GPU Intel”.

Plus précisément, “ZLUDA permet d’exécuter des applications CUDA non modifiées à l’aide de GPU Intel avec des performances quasi-natives. Il fonctionne avec les GPU Intel UHD intégrés actuels et fonctionnera avec les futurs GPU Intel Xe”. Ce projet, indépendant, n’émane pas d’Intel (et encore moins de NVIDIA, cela va de soi !) et reste à un stade préliminaire : pour le moment, ZLUDA ne fonctionne qu’avec Geekbench 5. Néanmoins, contrairement aux outils de conversion HIP d’AMD ou DPC++ d’Intel qui transforment du code CUDA en C++, ZLUDA permet de faire tourner des applications CUDA directement sur un GPU Intel.

Course à l’exaflops : NVIDIA optimise CUDA pour la plateforme ARM

Pas compatible avec les GPU AMD pour l’instant

Pour illustrer les performances de son ZLUDA, l’auteur donne des résultats obtenus par l’iGPU UHD Graphics 630 d’un Core i7-8700K sur GeekBenck 5.2.3 avec un OpenCL et avec ZLUDA ; dans ce dernier cas, GeekBench considère que l’iGPU du Core i7 est un GPU NVIDIA peu performant.

Globalement, ZLUDA offre des performances supérieures à OpenCL. En l’état, ZLUDA ne prend pas en charge les GPU AMD. Il se borne aux iGPU Intel Gen9 et prochainement, comme mentionné ci-dessus, aux GPU Xe. L’auteur précise qu’une compatibilité avec les GPU d’AMD est “techniquement faisable”. Maintenant, il est probable que NVIDIA ne voit pas tout ceci d’un très bon œil.

Source : Tom’s Hardware US

Et Nvidia de s’écrier : “Zludalor !” LOL

Pourquoi Nvidia ne verrait pas cela d’un bon oeil ? Ils sont crétins ou bien ?

CUDA est un langage développé par et pour les GPU NVidia, qui avantage donc outrageusement ces derniers, et sur lequel ils ont le contrôle pour continuer à optimiser l’adéquation avec les générations futures de GPU, et ils ne voudraient pas que ce langage devienne plus universel ?

Ou bien ils ont réellement peur que leurs GPU ne soient plus assez intéressants pour faire tourner du CUDA et que les utilisateurs se contentent du CPU ? … Mais alors, quel aurait été l’intérêt de le développer en CUDA pour commencer ?

Bref, absurde. (mais pas improbable)

CUDA est une plateforme propriétaire de Nvidia, gare aux violations de droits sur leurs technologies… ça risquerais de déclencher quelques procès surtout si cela profite à leurs concurrents de toujours, qui eux ne font aucuns cadeaux à Nvidia !!