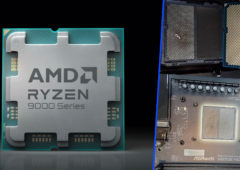

Les 8 puces mémoire Micron de 1 Go remplacées par 8 puces mémoire Samsung de 2 Go.

La RTX 2070 reste une carte graphique tout à fait décente même pour les jeux récents, mais certains considèrent que ses 8 Go de mémoire GDDR6 sont insuffisants. C’est le cas d’un certain VIK-on, qui a bricolé sa carte graphique NVIDIA GeForce RTX 2070 de marque Palit pour lui octroyer deux fois plus de VRAM, 16 Go.

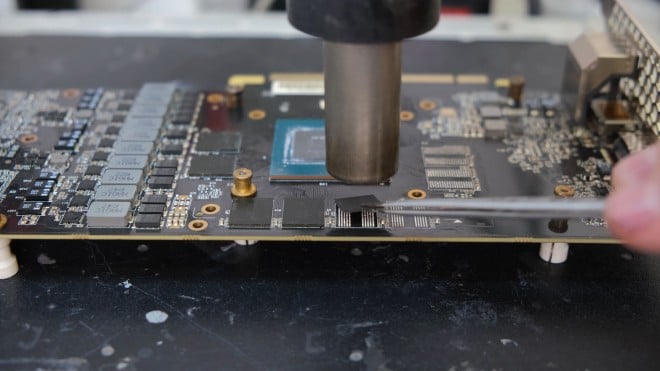

Les RTX 2070 commercialisées embarquent 8 Go de VRAM. Cela se matérialise par 8 puces Micron de 1 Go, installées sur les 8 emplacements mémoire disponibles. Il n’y en a donc aucun vacant. Par conséquent, augmenter la quantité de VRAM impose de retirer les anciennes puces pour en installer des nouvelles. Outre les solutions de Micron, la RTX 2070 est compatible avec des puces GDDR6 Samsung de 1 Go et de 2 Go ; VIK-on a opté pour ces dernières. Il a acheté 8 puces Samsung de 2 Go pour un montant total d’environ 200 dollars.

Vidéo : ils sacrifient deux RTX 2080 Super pour fabriquer une RTX 2080 Ti Super !

La carte boote mais finit par planter

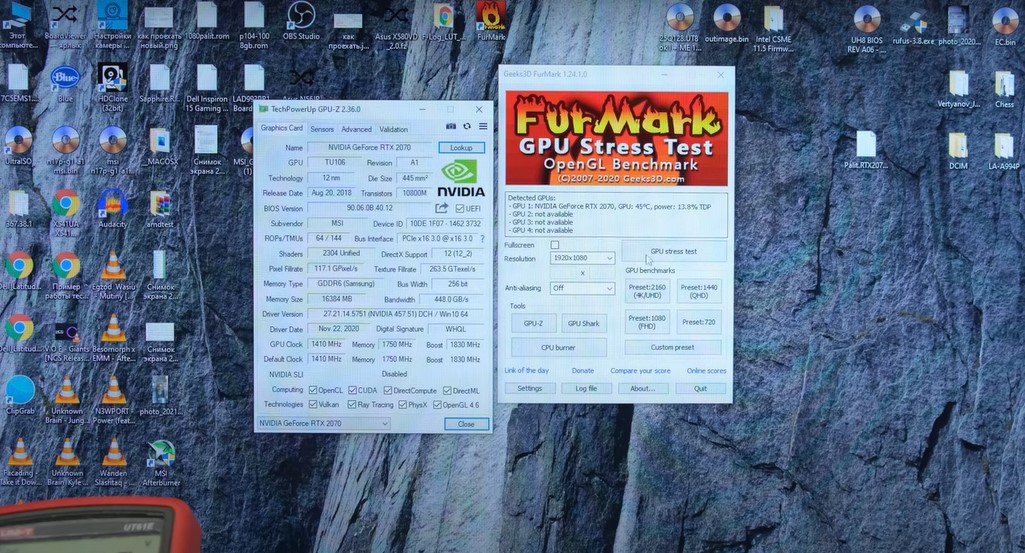

Après avoir retiré les anciennes puces, ajouté les nouvelles, et déplacé les résistances à l’arrière du PCB, VIK-on a testé sa création sur GPU-Z. La carte démarre ; et comme en atteste les captures d’écran, le logiciel la détecte bien avec 16 Go de VRAM. Malheureusement, il y a quelques plantages lorsqu’elle est trop sollicitée, sans que l’on sache s’ils sont causés par des problèmes matériels (mauvaise soudure) ou logiciels.

Il ne manque sans doute pas grand-chose à cette RTX 2070 avec 16 Go de GDDR6 pour fonctionner sans accroc ; peut-être lors d’une prochaine tentative ?

Source : Tom’s Hardware US

Sans un firmware adapté, il n’est pas étonnant que sa carte plante…

Ça reste une manip compliquée et risquée. Il faut le bon matos, la doc technique ad hoc et les compétences. Le gars est bien équipé et semble savoir ce qu’il fait donc chapeau pour ça. Mais sans examiner le code du firmware et faire les modifs nécessaires, j’ai peur que la fiabilité ne soit pas au rdv, ce qui semble être le cas d’ailleurs. Ça n’enlève rien à la compétence et à la curiosité technique du gars.

Il faut bosser dans le firmware car la carte reconnaît officiellement 8 gigas et doit déconner avec 16 gigas même si elle reconnaît pas officiellement.

“lorsqu’elle est trop sollicitée” serait-ce lorsque plus de 1GB de vram sont utilisés?