Introduction

L’architecture du Core i7 d’Intel, connu auparavant sous le nom de code Bloomfield, est très novatrice. Trop peut-être. Et elle a soulevé une montagne de questions et d’angoisses chez les passionnés de jeux vidéo. Disparu le cache de niveau 2 super rapide qui donnait un tel avantage aux processeurs Core 2 par rapport aux Phenom d’AMD dans la majorité des jeux. À la place, un cache L2 tout petit, un gros cache L3, un lien processeur-à-processeur de type HyperTransport, un contrôleur mémoire intégré et l’HyperThreading qui renaît de ses cendres. Sans plus d’indices, on pourrait croire qu’Intel a tourné casaque et vise un marché totalement différent.

Et ce ne serait pas totalement faux. Nos tests ont montré que les nouveaux Core i7 étaient imbattables dans les applications à vocation professionnelle, notamment dans le domaine de la vidéo, mais pas si rapides qu’on aurait pu l’espérer dans des tests plus communs ou dans les jeux. En résumé, la micro-architecture Nehalem incorpore beaucoup d’améliorations technologiques, mais n’est pas beaucoup plus performante dans les jeux, à cause des compromis faits par les ingénieurs d’Intel pour que Nehalem regagne des parts de marché dans les entreprises.

C’est la plateforme qui compte maintenant

Alors, inintéressants les Core i7 pour la majorité d’entre nous ? Non, car ils sont accompagnés du chipset X58, qui est le premier à être compatible avec la technologie multi-GPU SLi de NVIDIA. Et il garde par ailleurs la compatibilité avec le CrossFireX d’AMD. Alors, un Core i7, trois Geforce ou quatre Radeon, le paradis du joueur moderne ?

NVIDIA fait sa révolution

Du SLi 0 % NVIDIA

Les premières rumeurs voulaient que le X58 apporte le support du CrossFireX, la technologie de rendu multicarte graphique d’AMD. Un certain nombre de chipsets Intel offrent déjà cette possibilité donc ce n’était pas vraiment une surprise qu’une puce armée de deux liens PCI-Express 2.0 16x continuerait dans la même voie.

La question des licences

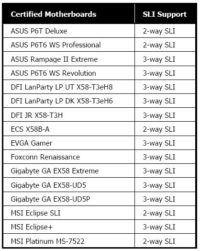

La présence d’un chipset X58 ne signifie pas forcément la compatibilité SLi. Pour qu’une carte mère supporte le SLi, elle doit d’abord être certifiée par NVIDIA, un processus qui implique qu’elle passe des tests de stabilité, de puissance, d’agencement physique et de compatibilité. Si elle passe ces quatre tests, la carte est techniquement compatible SLi.

Nous ignorons le prix que demande NVIDIA pour une licence SLi, mais ce cout est très certainement répercuté sur les fabricants de cartes mères. Cependant, comme les prix des cartes mères X58 seront supérieurs à 250 €, la différence de tarif entre les cartes compatibles SLi (toutes) et les autres (celles vendues par Intel) sera minime.

Il est probable que ce parcours du combattant soit similaire à celui qu’impose AMD aux cartes certifiées CrossFireX. Mais il est intéressant de le noter, puisque NVIDIA n’a ouvert sa technologie sous licence que très récemment, alors que la compatibilité CrossFireX est répandue depuis longtemps sur les chipsets Intel.

Bien sûr, si la compatibilité SLi est un de vos critères d’achat, faites bien attention à ce que cette caractéristique soit présente. Il faut souligner que la propre carte d’Intel, la DX58SO ne supporte pas le SLi. Intel justifie la chose par l’impossibilité de trouver un accord mutuel avec NVIDIA pour la certification de la carte.

L’art de ranger ses slots PCI-Express

Avoir ses slots en bon ordre

Les fabricants de cartes mères ont le choix parmi non moins que six configurations possibles pour ajouter le support SLi à leurs modèles. Sur les 6, 4 sont considérées “natives”, c’est-à-dire qu’elles ne font appel qu’au chipset X58. Les deux autres font appel au contrôleur additionnel NVIDIA nForce 200.

La configuration la plus simple du X58 utilise deux slots PCI-Express 16x, chacun câblé en 16x. Au maximum, ce type de cartes accueillera deux Geforce GTX 280. Et même si cela représente déjà une puissance respectable, la plupart des cartes mères que nous avons vues jusque-là sont plus ambitieuses. Notons par parenthèse que ce genre de cartes mères à deux slots pourra aussi recevoir une paire de Radeon HD4870 X2. On n’est donc pas réellement limité en puissance.

Une configuration trois slots native est encore plus attirante, et reste à la portée du seul X58. Un slot PCIe 16x reste alors câblé via 16 lignes, mais le deuxième et le troisième se partagent les 16 lignes restantes. Selon NVIDIA, c’est moins bien, car ces deux derniers slots n’offrent pas la même bande passante que le premier 16x. Mais on parle de PCI-Express 2.0 ici : nous n’avons encore jamais constaté d’indice que les cartes graphiques d’aujourd’hui ont besoin de plus de bande passante que ce qu’un port PCIe 2.0 8x (équivalent à un PCIe 1.1 16x) peut offrir. Nous préparons tout de même un dossier à ce sujet, afin de vérifier l’influence de la bande passante PCIe.

Nous n’avons pas encore vu une carte mère basée sur ce modèle, mais NVIDIA précise qu’une configuration quatre slots est possible en divisant chaque lien PCIe 16x du chipset X58 en deux. Cela serait utile par exemple pour utiliser un tri-SLi accompagné d’une quatrième Geforce dédiée aux calculs PhysX. Tempérons cet enthousiasme : nous avons eu déjà suffisamment de mal avec un simple tri-SLi. La chaleur n’est pas l’amie de ce genre de système, et la simple régulation des ventilateurs ne peut cacher le fait que trois Geforce émettent une sacrée dose de calories. Ajouter un quatrième GPU ressemble à un aller simple vers les problèmes.

La cinquième possibilité implique un nForce 200 en plus du X58. Le Tylersburg (nom de code du X58) conserve un de ces liens en 16x. L’autre est branché au nForce 200, qui le transforme en deux liens PCIe 2.0 16x. NVIDIA prétend que cette topographie a un avantage grâce à des communications directes entre les deux cartes branchées sur le nForce 200. Elle n’est pourtant pas réellement différente du cas précédent : deux cartes se retrouvent à partager un même lien PCIe 2.0 16x. Les fabricants de cartes mères avec lesquels nous avons pu discuter n’ont pas non plus semblé très enthousiastes à propos de ce montage.

Pilotes et soucis rencontrés

Le chipset Intel X58 nous donne une opportunité jamais vue auparavant de réaliser des comparaisons directes entre CrossFireX et SLi. Nous étions par conséquent très impatients de tester cela, et nous imaginions déjà passer d’une configuration à une autre, du monde du caméléon à celui d’AMD en échangeant simplement les cartes, et désinstallant/réinstallant les pilotes. Malheureusement, nous avions idéalisé un peu trop la situation.

La première chose à avoir en tête lorsque l’on manipule un grand nombre de composants dernier cri, c’est qu’ils dégagent une étonnante quantité de chaleur – suffisamment pour qu’il devienne nécessaire de laisser les machines reposer quelques minutes avant d’y remettre la main, histoire d’éviter les brûlures.

Le problème ne se pose pas avec une seule Radeon HD4870 ou Geforce GTX 280 : le ventilateur intégré et thermorégulé gère la situation, même sous une application exigeante en 3D. De même pour une Radeon HD 4870 X2, ou même pour deux Geforce GTX 280 en SLi, le connecteur SLi rigide garantissant qu’il y ait l’espace de deux slots entre les deux cartes. Mais lorsque l’on monte au Tri-SLi, avec les trois cartes coincées les unes contre les autres, ou au Quad CorossFireX, avec deux Radeon HD4870 X2 collées l’une à l’autre, les températures s’envolent rapidement hors de contrôle et génèrent des problèmes de stabilité. La solution que nous avons trouvée est de passer par RivaTuner ou les pilotes Catalyst 8.10 pour régler manuellement la vitesse des ventilateurs. La contre-partie est une hausse malheureuse du bruit. Mais c’est le prix à payer pour jouer.

Noyé sous les pilotes

Ensuite, il y a les problèmes des pilotes et des jeux récents. À en croire AMD, si nous avions eu accès à une plateforme Core i7-X58 dès juillet, nous aurions pu utiliser nos Radeon HD 4800 en CrossFireX sans souci. Le support de la plateforme était déjà là, fin prêt. Pourtant, durant les deux dernières semaines, nous avons reçu pas moins de trois mises à jour officielles visant à améliorer les performances. AMD nous assure qu’il ne s’agit pas de mises à jour frénétiques pour corriger des bugs dans le support de la plateforme Core i7, mais nous avons tout de même dû tester et re-tester frénétiquement pour faire face à l’afflux constant de pilotes “plus rapides” optimisés pour quelques jeux dont les performances n’étaient pas aussi bonnes que ce que AMD espérait.

Côté NVIDIA, la situation fut nettement plus confortable. Mais là aussi le planning de sortie des pilotes est un peu à la traîne. D’abord, la société a publié une version bêta de ses pilotes Geforce 180.42, qui apportait le support du SLi sur X58. À ce jour, ces pilotes ne comprennent pas toutes les fonctionnalités qui seront incluses dans la version finale des Geforce 180, comme le SLi multimoniteur ou la possibilité de dédier un GPU aux seuls calculs PhysX. Ces fonctionnalités devraient être disponibles le 17 novembre pour le lancement commercial du Core i7.

Gardez cet état d’inachevé en tête lorsque vous regarderez les benchmarks. Dans un certain nombre de cas, il manque clairement quelque chose ; nous prendrons soin de souligner les résultats les plus étranges.

Intel douche les espoirs

Au précédent IDF, Intel a réuni de petits groupes de journalistes et partenaires pour leur montrer des résultats préliminaires des tests du Core i7, ainsi que pour présenter le planning du lancement. Nous savions alors que le plus rapide serait cadencé à 3,2 GHz. Nous savions aussi que la propre carte mère d’Intel, la DX58SO offrirait un support bancal de la mémoire triple canal, sur quatre slots seulement (ce dont les représentants de la marque ne sont pas spécialement satisfaits, comme nous). Et nous avions déjà une bonne idée des points forts et des points faibles de l’architecture.

Le problème voyez-vous, est que l’architecture Core 2 emploie un large cache de niveau 2 partagé – les Penryn dual core haut de gamme comprennent deux coeurs qui accèdent ainsi dynamiquement à 6 Mo de mémoire très rapide. Le Core i7 donne au contraire à chacun de ses quatre coeurs 256 ko de cache de niveau 2, et un cache de niveau 3 beaucoup plus gros (et plus lent) de 8 Mo, partagé entre les coeurs. La conséquence de cette nouvelle architecture de cache (et de la réintroduction de l’HyperThreading) est que le Core i7 dévore les tâches d’encodage à une vitesse encore jamais vue. Mais ces améliorations n’ont pas le même effet sur les jeux. Intel nous avait avertis de cela à l’IDF, nous disant qu’il ne fallait pas en attendre trop de Nehalem, les gains de vitesse dans les jeux étant principalement dus à la fonction Turbo Boost d’overclocking automatique.

Des configurations de rêve

Si vous êtes un amateur de configurations haut de gamme, de cartes graphiques de folie, et de températures équatoriales, vous allez adorer les plateformes que nous avons utilisées pour ce test

Nous avons aligné les trois processeurs de bureau les plus rapides actuellement disponibles : Intel Core i7 965 Extreme, Intel Core 2 Extreme QX9770, et AMD Phenom X4 9950. On l’a dit, le chipset X58 des Core i7 supporte le CrossFireX et le SLi, donc une seule carte mère suffit à tester les deux configurations. Pour le Core 2 Extreme, nous avons utilisé un chipset X48 pour le CrossFireX et un nForce 790i pour le SLi. Enfin, le système Phenom X4 n’était compatible qu’avec les cartes en CrossFireX, à cause de son chipset AMD 790FX/SB750.

Sur ces plateformes, nous avons installé les sous-systèmes graphiques suivants :

- X58 (Core i7 Extreme) : mono-/bi-/tri-SLI de GeForce GTX 280 et mono-/bi-/quadri-CrossFireX de Radeon HD 4870 ou Radeon HD4870 X2

- X48 (Core 2 Extreme) : mono-/bi-/quadri-CrossFireX de Radeon HD 4870 ou Radeon HD4870 X2

- 790i SLI Ultra (Core 2 Extreme) : mono-/bi-/tri-SLI de GeForce GTX 280

- 790FX (Phenom X4) : mono-/bi-/quadri-CrossFireX de Radeon HD 4870 ou Radeon HD4870 X2

| Plateforme | Core i7 965 Extreme | Core 2 Extreme QX9770 | Phenom X4 9950 |

| Chipset | Intel X58 | Intel X48/Nvidia nForce 790i SLI Ultra | AMD 790FX/SB750 |

| Carte mère | ASUS Rampage II Extreme/Gigabyte EX58-Extreme | Intel DX48BT2/EVGA nForce 790i SLI Ultra | ASUS M3A79-T Deluxe |

| Mémoire | 6 Go DDR3-1333 7-7-7 (triple-channel) | 4 Go DDR3-1600 7-7-7 (dual-channel) | 4 Go DDR2-1066 5-5-5 (dual-channel) |

| Stockage | Intel SSDSA2MH080G1GN 80Go SSD | Intel SSDSA2MH080G1GN 80Go SSD | Intel SSDSA2MH080G1GN 80Go SSD |

| Lecteur optique | Lite-On DH-4O1S BD-ROM | Lite-On DH-4O1S BD-ROM | Lite-On DH-4O1S BD-ROM |

| Alimentation | Cooler Master UCP 1100W | Cooler Master UCP 1100W | Cooler Master UCP 1100W |

| Plateforme | Core i7 965 Extreme | Core 2 Extreme QX9770 | Phenom X4 9950 |

| Système d’exploitation | Windows Vista x64 with Service Pack 1 | Windows Vista x64 with Service Pack 1 | Windows Vista x64 with Service Pack 1 |

| Pilotes graphiques | AMD : 8.551 / Nvidia : GeForce 180.42 | AMD : 8.551 / Nvidia : GeForce 180.43 | AMD : 8.541 |

| Pilotes systèmes | Intel : 9.1.0 Build 1005 | Intel : 8.3.1 / Nvidia : nForce 15.23 | AMD : Catalyst 8.10 |

Il nous faut remercier un certain nombre de constructeurs, qui n’apparaissent pas directement dans ces tests, mais qui nous ont permis de réunir la montagne de matériel nécessaire à ce comparatif.

- Zotac nous a fourni trois GeForce GTX 280 non overclockées

- Sapphire nous a fourni trois Radeon HD 4870 X2 non overclockées

- ASUS nous a fourni ses cartes mères Rampage II Extreme et P6T Deluxe

- Gigabyte nous a fourni sa carte mère EX58-Extreme

- Cooler Master nous a fourni la UCP 1100W

- OCZ nous a fourni 6 Go de DDR3-1333 (OCZ3P1333LV6GK)

- Corsair nous a fourni 6 Go de DDR3-1600 (TR3X6G1600C8D)

| Benchmark | Configuration |

|---|---|

| World in Conflict | Very High Quality Settings, No AA / No AF, vsync off, 1920×1200 / 2560×1600, Patch 1009, DirectX 10 |

| Very High Quality Settings, 4x AA / 16x AF, vsync off, 1920×1200 / 2560×1600, Patch 1009, DirectX 10 | |

| Supreme Commander : Forged Alliance | High Quality Settings, No AA / No AF, vsync off, 1920×1200 / 2560×1600, Patch 1.5.3599, DirectX 9, Fraps 2.9.4 |

| High Quality Settings, 8x AA / No AF, vsync off, 1920×1200 / 2560×1600, Patch 1.5.3599, DirectX 9, Fraps 2.9.4 | |

| Crysis | Very High Quality Settings, No AA / No AF, vsync off, 1900×1200 / 2560×1600, Patch 1.2.1, DirectX 10, 64-bit Executable |

| Very High Quality Settings, 8x AA / No AF, vsync off, 1900×1200 / 2560×1600, Patch 1.2.1, DirectX 10, 64-bit Executable | |

| Crysis : Warhead | Enthusiast Quality Settings, No AA / No AF, vsync off, 1920×1200 / 2560×1600, DirectX 10, Steam Version |

| Enthusiast Quality Settings, 8x AA / No AF, vsync off, 1920×1200 / 2560×1600, DirectX 10, Steam Version | |

| Company of Heroes | High Quality Settings, No AA / No AF, vsync off, 1920×1200 / 2560×1600, DirectX 10, Steam Version |

| High Quality Settings, 8x AA / No AF, vsync off, 1920×1200 / 2560×1600, DirectX 10, Steam Version | |

| Unreal Tournament 3 | 5/5 Quality Settings, No AA / No AF, vsync off, 1920×1200 / 2560×1600, DirectX 10, Patch 1.2 |

| 5/5 Quality Settings, 8x AA / 16x AF, vsync off, 1920×1200 / 2560×1600, DirectX 10, Patch 1.2 | |

| Far Cry 2 | Very High Quality Settings, No AA / No AF, vsync off, 1920×1600 / 2560×1600, DirectX 10, Steam Version |

| Very High Quality Settings, 8x AA / No AF, vsync off, 1920×1600 / 2560×1600, DirectX 10, Steam Version | |

| 3DMark Vantage | Performance Default |

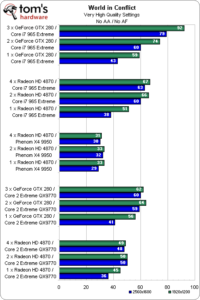

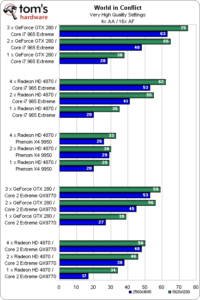

World in Conflict

Chacun de ses graphiques possède de nombreuses barres, puisque nous comparons cinq plateformes différentes, avec trois configurations graphiques et sous deux résolutions. Regardons en détail les performances du Core i7 face au Core 2 Extreme et au Phenom X4 dans les jeux les plus gourmands.

Le résultat le plus saisissant est peut-être que la plateforme Phenom ne monte pas en puissance. C’est une tendance que nous allons retrouver dans presque tous les benchmarks suivants donc arrêtons-nous un instant et analysons là plutôt que de nous répéter. Le Phenom X4 n’est pas si mauvais que ça en tant que tel, mais il bride totalement ces configurations graphiques ultra haut de gamme.

Ensuite, nous ne pouvons nous empêcher de remarquer que, bien qu’Intel nous ait prévenus de ne pas attendre de gains sous les jeux avec le Core i7, on constate une excellente progression des performances graphiques en passant d’une à deux puis trois Geforce GTX sur cette plateforme. Pour dire les choses clairement, par rapport au Core 2 Extreme QX 9770, le Core i965 est la bouffée d’air frais qu’attendaient les systèmes multi-GPU NVIDIA.

De la même façon, les Radeon HD 4870 d’AMD gagnent un bon cran de performances en passant d’une plateforme X48 à une plateforme X58. Il est intéressant de noter que trois Geforce GTX 280 battent quatre Radeon HD 4870. Mais, fans d’AMD, ne vous inquiétez pas, les unes comme les autres survolent notre suite de test, et il y a des moments où les Radeon dament le pion aux Geforce aussi.

Même topo ici une fois l’antialiasing et le filtrage anisotropique activés. Les cartes NVIDIA sont globalement devant les AMD. Et encore une fois, le Core i7 permet une bonne progression des performances lorsqu’on augmente le nombre de cartes graphiques, que ce soit les Geforce ou les Radeon. Il apparaît clairement que le Core 2 Extreme QX9770 bride le potentiel de ces configurations graphiques par rapport au dernier CPU Intel.

Supreme Commander

Nos précédents tests l’ont montré, Supreme Commander Forged Alliance est un véritable défi pour les cartes graphiques – en voilà encore la preuve.

Le Phenom X4 9950 se fait remarquer dans cette comparaison, car malgré le handicap du processeur face aux puces Intel, la présence de quatre Radeon HD 4870 lui permet de dépasser les configurations X58 et X48 équipées de Geforce GTX 280. Plus précisément, les quatre Radeon HD 4870 sur le Phenom battent les trois Geforce sur n’importe laquelle des plateformes Intel. Bien sûr, si vous montez les Radeon sur les plateformes Intel, vous obtenez des scores encore plus hauts.

Les Geforce GTX 280 progressent significativement en passant d’une carte à deux, mais ajouter une troisième carte ne donne strictement aucun résultat. C’est même plutôt le contraire. Ce problème n’est probablement pas dû à une mauvaise optimisation des pilotes puisque Supreme Commander répond très favorablement à l’addition de capacités graphiques dans les autres situations.

Le Core i7 avec une, deux ou trois GTX 280 n’est pas beau à voir. Il n’y a plus rien à gagner dès qu’on active l’anticrénelage dans ce jeu. Avec le Core 2 Extreme, on note une progression, mais trop légère. À moins que NVIDIA n’optimise sérieusement ces pilotes pour Forged Alliance, il n’y a aucune raison d’acheter une deuxième ou troisième carte.

Le Phenom X4 se montre aussi rapide que le Core i965 Extreme. Mais si vous souhaitez jouer à ce jeu avec l’AA 8x activé, vous allez devoir investir dans quatre Radeon HD 4870 et un Core 2 Extreme QX 9770, et encore, sans dépasser le 1920 x 1200. Cette configuration est plus de 20 % plus rapide que les deux autres à cette résolution.

Crysis 64 bits

L’essai de la version 64 bits de Crysis nous a donné des résultats étonnants.

La clé ici est la résolution. Les Geforce GTX 280 montrent une progression grâce au multi GPU excellente, en 1920 x 1200, sur les deux systèmes Intel Core 2 Extreme et Core i7. Le Core i7 montre même des gains de performances impressionnants dans un test que nous attendions limité par le GPU. Néanmoins, passer à deux ou trois Geforce apporte de réels gains. En 2560 x 1600 par contre, c’est une tout autre histoire. On pourrait même dire que la différence entre les deux résolutions est un désastre. Un, deux ou trois GPU : aucune différence. Dans tous les cas, le jeu est injouable.

Le Phenom X4 trouve sa limite avec une seule Radeon HD 4870 en 1920 x 1200. À plus haute résolution, ajouter des GPU ne change rien.

Le Core i7 965 Extreme et le Core 2 Extreme QX9770 se comportent de manière très similaire avec les Radeon. Comprendre qu’ils sont tous deux aussi mauvais et ne gagnent rien à passer de deux à quatre RV770. Même à 1920 x 1200, nous ne qualifierons pas le framerate obtenu avec quatre GPU de jouable. Et ne parlons pas de l’activation de l’anticrénelage.

Pour la première fois dans notre test, nous voyons nos machines de folie clouées au sol.

Là encore, regardons la résolution. Le SLi de Geforce GTX 280 de NVIDIA progresse de manière presque parfaite, trois GPU nous faisant même profiter de framerates quasi-jouables en 1920 x 1200.

Le Core i7 est aussi intéressant. Comme nous l’avons souligné dans notre analyse de l’architecture Nehalem (cf. Intel Core i7 (Nehalem) : une architecture signée AMD ?), le Core i7 supporte la fusion des macro-ops en mode 64 bits, et c’est probablement ce qui explique le gain non négligeable de performance dans ce cas.

Mais lorsqu’on monte en 2560 x 1600, le score ne fait pas que diminuer, il baisse à mesure que l’on ajoute des cartes graphiques. Sur le Core 2 Extreme, le test est même impossible.

Les Radeon HD 4870 d’AMD s’en tirent globalement mieux. Malheureusement, elles ne sont jamais assez rapides pour délivrer un framerate suffisant. Le point le plus remarquable est sans doute le cas de la Radeon HD 4870 512 Mo. Cette “faible” quantité de mémoire l’empêche d’assurer un framerate à deux chiffres. Passer à la Radeon HD4870 X2 ajoute non seulement un deuxième GPU, mais aussi 1 Go de GDDR5 par processeur, ce qui multiplie les performances par quatre.

Crysis Warhead

Au moins, la majorité des tests sous Crysis évoluent dans la bonne direction lorsqu’on augmente le nombre de cartes graphiques. Sans hésitation, les Geforce GTX 280 dominent ce titre, assurant d’excellents framerate en tri-SLi sur le Core i965 Extreme.

Malheureusement, toutes les configurations AMD ou NVIDIA trébuchent en 2560 x1600, et une fois encore les montages à trois ou quatre cartes n’apportent rien ou presque par rapport aux systèmes bi-GPU. À cette résolution, aucune configuration ne rend le jeu jouable. Descendre en 1920 x 1200 ouvre de nouveaux horizons.

On aurait pu s’en douter, mais devinez quoi ? L’anti-aliasing n’améliore pas les performances d’un système qui peinait déjà sans.

Les Geforce GTX 280 continuent à bien se comporter sur les systèmes Intel Core 2 Extreme et Core i965 Extreme, et approchent des vitesses jouables lorsqu’on les monte par trois. En 2560 x 1600, ces mêmes cartes luttent pour atteindre un score à deux chiffres. La combinaison Tri-SLi + Core 2 Extreme QX 9770 est même un échec total.

Les Radeon ne s’en sortent pas vraiment mieux. En 1920 x 1200, aucune combinaison n’est capable de dépasser 30 fps. Et en 2560 x 1600 l’unique Radeon HD 4870 512 Mo est tout simplement incapable de faire face à la charge qui lui est imposée. Ajouter un second GPU et doubler la mémoire aide un peu, mais c’est loin d’être assez, pour ne serait-ce qu’envisager de jouer à cette résolution.

Prenons la peine de noter que les GTX 280 offrent de meilleures performances sur le Core i7 que sur le Core 2, alors que les Radeon perdent à migrer sur l’architecture Nehalem. AMD semble bel et bien avoir encore du travail d’optimisation de ses pilotes.

Company of Heroes

Pas de contestation ici, NVIDIA écrase AMD : les performances d’une seule GeForce GTX 280 en 2560×1600 enterrent celles d’un quad-crossfire en 1920×1200.

Peu importe que l’on choisisse Core i7 ou Core 2 Extreme tant les plateformes à base de GTX 280 dominent. Le Core i7 965 Extreme permet tout de même une fois encore un léger gain de performances par rapport au Core 2.

Ceci ne veut pas dire que les Radeon buggent d’une manière ou d’une autre dans Company of Heroes, puisque l’on voit une augmentation des performances en passant d’un à deux puis quatre GPU. Mais la progression est nettement moins prononcée par rapport aux GTX 280, d’où les graphiques peu à leur avantage. Bonne nouvelle à souligner, une seule Radeon HD 4870 suffit à jouer en 1920×1200 sur notre plateforme AMD. Cela s’explique par le fait que les performances sont limitées par le GPU ici, comme le montre la capacité du Phenom à concurrencer les processeurs nettement plus puissants d’Intel

Les résultats avec AA 8x sont une copie presque conforme des précédents : les GeForce 280 GTX maintiennent une domination sans partage. On pourrait même dire que ce réglage ne coute rien en performance. Lorsqu’on opte pour une grappe de trois cartes NVIDIA — au prix d’une consommation gargantuesque, il est vrai —, l’impact de l’AA est minimal. En fait, c’est même pire que ça : avec une plateforme Core i7 les performances augmentent.

Une fois encore, les Radeon HD 4870 plafonnent autour de 57 images/seconde. Et, oui, la vsync était désactivée via les pilotes. Il y a cependant encore plus surprenant que ces piètres performances : l’activation de l’anti-aliasing 8x a pour effet d’augmenter les performances, exception faite du 2560×1600 avec une seule carte à 512 Mo de mémoire. Quelque chose ne tourne donc vraiment pas rond avec les derniers Catalyst étant donné que ces problèmes étaient manifestes avec les 8.10 (790 FX) ainsi que la toute dernière version bêta hotfix visant à optimiser les performances sur X58.

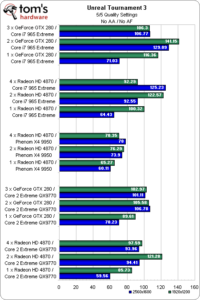

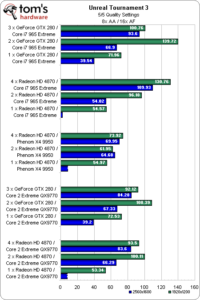

Unreal Tournament 3

Bien qu’UT3 soit peu reproductible et nécessite de s’y reprendre cinq à six fois avant de pouvoir dégager une tendance nette, son moteur Unreal Engine 3 est la clef de voûte de nombreux jeux, et nécessite donc une attention particulière.

Quelques constats s’imposent d’emblée : tout d’abord, on voit très nettement ce qu’il en coûte de jouer avec une carte graphique 512 Mo de nos jours. Jusqu’en 1920 x 1200, pas de problème, mais il faut voir plus loin lorsque l’on s’attaque aux écrans 30 pouces en 2560 x 1600.

Il n’y a pas de quoi se livrer à une surenchère pour autant. Deux cartes suffisent à atteindre l’équilibre idéal, puisque l’on voit à plusieurs reprises les configurations tri-SLI et quad-crossfire offrir de moins bonnes performances.

Le combat rapproché entre AMD et NVIDIA continue sous UT3 avec des réglages plus lourds. Les résultats de la Radeon HD 4870 en 2560 x 1600 donnent clairement envie d’opter pour une carte graphique munie d’au moins 1 Go de mémoire. Globalement, une paire de cartes semble être encore le bon choix.

Far Cry 2

Il était difficile de faire abstraction de Far Cry 2 même si l’on se serait bien passé de la valse des pilotes et correctifs pour ce jeu. Cette frénésie est cependant inévitable étant donné l’aura de Far Cry 2 et le nombre de joueurs qui choisiront leur carte graphique en fonction de ses performances sous ce simple jeu.

Le Core i7 965 Extreme permet une progression des performances en SLi admirable, avec une, deux, ou trois cartes, permettant ainsi de dépasser les 100 images/seconde en pointe même avec une résolution de 2560 x 1600. Les résultats sont nettement moins séduisants avec le Core 2 Extreme, mais permettent tout de même une bonne expérience de jeu en 2560 x 1600 avec une seule GeForce GTX 280.

La situation n’est pas aussi rose avec les Radeon HD 4870. Dans tous les tests effectués en 2560 x 1600, l’ajout de cartes supplémentaires diminue les performances. Il en va de même en 1920 x 1200 à une exception près. Nous essayons de voir avec AMD l’origine du problème curieux qui ne se manifeste pas sous Crysis ou Crysis : Warhead.

Ah ! Un peu d’anti-aliasing et hop, le problème disparaît et les performances de la plateforme AMD deviennent un peu plus prévisibles. Il n’en demeure pas moins que nombre de tests effectués avec les benchmarks intégrés à Far Cry 2 sont infaisables. D’une façon générale, la progression liée au multi-GPU est très bonne en 1920 x 1200 avec anti-aliasing 8x ce qui donne envie d’acheter au moins une Radeon HD 4870 X2. On constate encore un gain appréciable avec une deuxième, et ce, quel que soit le processeur utilisé.

La mauvaise nouvelle, c’est qu’il n’est pas possible de jouer en 2560 x 1600, au moins jusqu’à ce qu’AMD optimise un peu plus ses pilotes pour ce cas de figure. Il n’empêche que dans l’immédiat, le simple fait de voir deux Radeon HD 4870 X2 arriver à suivre trois GeForce GTX 280 en 1920 x 1200 suffit à notre bonheur.

Vu que Far Cry 2 fait partie du programme NVIDIA TWIMTBP (The Way It’s Meant To Be Played), il n’y a rien de surprenant à ce que les pilotes de la firme au caméléon soient déjà bien optimisés. A contrario, la différence entre Core i7 965 Extreme et Core 2 Extreme en SLI et en tri-SLI est étonnante. Il y a un saut véritable entre les deux plateformes.

Il aura fallu batailler ferme pour maintenir la température générée par trois GeForce GTX 280 à un niveau acceptable, mais on en est récompensé par les performances de NVIDIA : le gain apporté par le passage d’une à trois cartes en 1920 x 1200 et en 2560 x 1600 est réellement impressionnant.

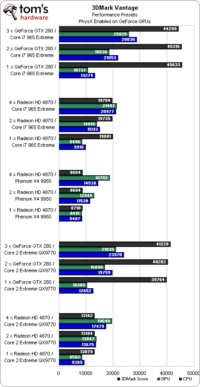

3DMark Vantage

Les résultats qui suivent sont à prendre avec des pincettes : il est nécessaire de dissocier les performances AMD et NVIDIA du fait que le PhysX gonfle artificiellement les scores (sans même parler du biais naturellement introduit par ce benchmark entre AMD et NVIDIA). Le terme artificiel n’est pas excessif dans la mesure où le PhysX ne concerne que peu de jeux, un seul de notre panel de test par exemple. Néanmoins, 3DMark Vantage fait la part belle à l’accélération physique matérielle – en noir sur les graphiques. Le jour où l’on nous montrera que les gains dans les jeux sont aussi importants, nous changerons de refrain.

Au niveau des scores globaux ou CPU, les GeForce GTX 280 témoignent d’une hausse significative de performance en passant du Core 2 Extreme au Core i7 Extreme. On soupçonne même les pilotes NVIDIA de ne pas encore être optimisés, puisque le score GPU chute ; à moins que la configuration des ports PCIe en 16x/8x/8x ne soit vraiment nuisible aux performances graphiques. S’il se confirmait que le débit des ports PCI Express était le facteur limitant, les fabricants de cartes mères s’empresseraient d’adopter le nForce 200, leurs cartes mères à configurations X58 “natives” étant déjà prêtes au lancement.

Les Radeon HD 4870 se comportent de la même manière que les Geforce : quelque soit leur nombre (1,2 et 4), le passage du Core 2 au Core i7 se traduit par des performances en hausse. Le score GPU augmente : il est difficile d’expliquer cela par les pilotes, c’est plus probablement l’effet de l’architecture de la plateforme Intel. Enfin, le score global évolue également, reflétant ainsi un très bon niveau de performances.

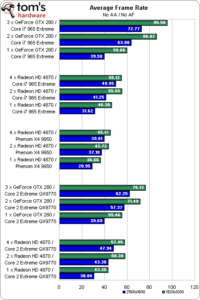

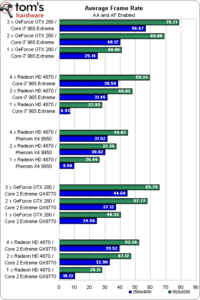

Récapitulatif des performances

Au cours de ce test du Core i7 dans les jeux, comprenant pas moins de 500 benchs consécutifs, nous avons rencontré un nombre anormalement élevé de scores médiocres. Certains sont tout à fait explicables, mais d’autres restent un mystère et méritent une analyse par AMD ou NVIDIA.

A cause de ces anomalies ponctuelles, afin de mieux rendre compte de la performance globale de chaque plateforme, nous avons calculées les moyennes du nombre d’images par seconde obtenu sur nos sept jeux. Ces moyennes ne prennent donc pas en compte les résultats obtenus sous 3DMark Vantage.

Penchons-nous d’abord sur le combat Core i7 965 Extreme Vs. Core 2 Extreme. Si l’on utilise une unique Geforce GTX 280 ou n’importe quelle combinaisons de Radeon HD 4870, on constate un gain modéré à l’avantage du Core i7 malgré ces très hautes résolutions. Mais il suffit toutefois d’ajouter une ou deux autres Geforce GTX 280 pour que le tableau change et que le Core I7 prenne un très gros avantage.

La poussière de cet affrontement retombée, on voit aussi que le Phenom X4 9950 d’AMD ne se débrouille pas si mal, face aux deux autres systèmes à base de Radeon, surtout lorsqu’on prend en compte la différence de prix entre ces plateformes. Soyons francs, 2560 x 1600 ne sera pas une résolution envisageable dans la plupart des cas, mais en 1920 x 1200, cette plateforme beaucoup plus abordable financièrement saura s’en tirer, pour peu qu’on lui associe au minimum deux GPU. Et ce bien que le prix de ces GPU amoindrit en partie l’économie réalisée grâce à la plateforme AMD. Rappelons en effet que le Phenom 9950 seul se négocie 160 €, contre 1000 € pour chacun des processeurs Intel !

Pousser le curseur de qualité d’image à fond à droite permet aux machines Core i7 + Geforce GTX 280 de se détacher loin devant celles en Core 2 Extreme ; surtout dans le cas du tri-SLi. Chez AMD, le passage de deux à quatre GPU est assez proche de celui obtenu par NVIDIA, mais les scores restent toujours nettement inférieurs dans l’absolu, et il faut d’autre part passer de 2 à 4 GPUs pour retrouver le gain observé chez NVIDIA lors du passage de 2 à “seulement” 3 GPUs. Reste qu’il suffit aujourd’hui de 2 cartes haut de gamme pour disposer de 4 GPUs chez AMD, contre 3 pour 3 GPUs chez NVIDIA.

Conclusion

Incontournable Core i7

Il fait bon être riche en ce moment, ça ne fait aucun doute. Les fans de jeux vidéo qui pourront s’offrir les cartes graphiques les plus haut de gamme cèderont sans doute au charme du Core i7 965 Extreme malgré ses 1000 €. Malgré les craintes d’Intel, ce nouveau CPU apporte réellement des gains significatifs dans les jeux, sans parler du véritable effet turbo constaté dans les applications professionnelles et notamment audio/vidéo (pour plus d’informations à ce sujet lire notre test Intel Core i7 : la puissance, l’overclocking en moins).

Ceci posé, jouer sur un Core i7 est loin du paradis, même si Intel n’a pas ménagé sa peine en important les palmiers (les cartes graphiques ultra rapides), les plages de sable blanc (le support CrossFireX) et les jus de fruits exotiques (la technologie NVIDIA SLI supportée par un chipset non-NVIDIA pour la première fois – oublions Skulltrail).

AMD ou NVIDIA ? Qu’importe : on a le choix !

Ce dossier ne concerne pas que le Core i7, il permet aussi de comparer les mérites des solutions multi-GPU d’AMD et NVIDIA. Même si les Radeon HD 4870 décrochent d’excellents scores dans nos tests, le CrossFireX ne fait pas gagner beaucoup, surtout là où on en aurait le plus besoin : en 2560 x 1600 ou avec antialiasing activé. Bien sûr, il n’y a pas encore beaucoup de joueurs équipés d’écrans 30 pouces. Mais quelqu’un capable de mettre 1000 € dans un CPU, 1000 € dans deux ou trois cartes graphiques et 300 € dans une carte mère, ne rechignera sans doute pas à rajouter 1500 € dans un écran surdimensionné. Nous sommes en train d’analyser avec AMD certains des étranges résultats que nous avons relevés, mais jusqu’à preuve du contraire, nous pensons qu’il reste beaucoup d’optimisations à faire.

Le véritable vainqueur de cette confrontation Core i7/SLI/CrossFire est la plateforme Intel X58, et les amateurs qui ont maintenant la possibilité de choisir entre SLI ou CrossFireX. Merci à NVIDIA d’accorder enfin des licences d’utilisation de la technologie SLI. Dorénavant, si la balance penche en faveur d’un ou de l’autre fournisseur de GPU, on pourra adopter la carte graphique la plus rapide, sans changer toute sa configuration.