GeForce GTX 690 4 Go : montre-nous ton magnésium !

La Bugatti Veyron Super Sport, l’Aston Martin One-77, la Lamborghini Reventon sont toutes des voitures à plusieurs millions d’euros que nous admirons en photo mais ne verrons sans doute jamais sur la route et ne posséderons pas. Et pourtant elles sont sexy.

Nous pourrions nous laisser aller à comparer des composants ultra haut de gamme à des voitures de sport, pourtant, dans les faits, ces comparaisons n’ont pas lieu d’être. Pour le prix de quatre pneus d’une Veyron, on peut s’acheter… 35 Core i7 3960X ! Certes, mettre 1000 € dans un processeur paraît ridicule, mais par rapport à d’autres luxes, l’informatique est en fait très accessible.

Nous pourrions donc filer la métaphore automobile en parlant de la GeForce GTX690 comme de la Bugatti Veyron des joueurs, mais en réalité, quiconque avec 1000 € de côté pourra se l’offrir. Bien sûr, pour faire bonne mesure, il faudra l’associer à un écran de 27″ ou 30″, mais nous ne pouvons pas la tester comme si elle était dans une autre ligue que les GeForce GTX 680 ou Radeon HD 7970. Non, la GeForce GTX 690 doit faire ses preuves comme n’importe quelle autre carte.

Si vous avez l’actualité que nous avons publiée dimanche dernier (La GeForce GTX 690 arrive le 3 mai 2012), vous connaissez déjà à peu près toutes les caractéristiques de la GeForce GTX 690. Nous allons rapidement revenir dessus en les explorant un peu plus en détail, puis nous passerons aux benchmarks, en 1920 x 1200, 2560 x 1600 et 5760 x 1080.

Sous le capot de la GeForce GTX 690 4 Go

La GeForce GTX 690 est une carte à deux GPU GK104. Ces GPU ne sont pas bridés, la GTX 690 possède donc un total de 3072 CUDA cores, 256 unités de texture et 64 ROPs.

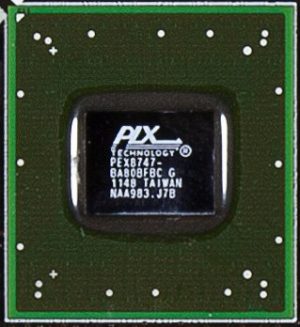

Le pont NF200 qu’utilisait Nvidia sur la GeForce GTX 590 a disparu. Il est limité au PCI-Express 2.0 est aurait donc étouffé les deux GK104. À sa place, Nvidia a choisi une puce PLX PEX 8747, qui gère 48 lignes PCI-Express 3.0.

Cette puce communique avec chaque GPU sur un bus à 16 lignes puis crée une interface à 16 lignes vers le chipset de la carte mère ou du CPU. Développé tout exprès pour ce genre d’utilisation, le PEX 8747 n’induit qu’une latence de 126 ns, son insertion ne devrait donc pas avoir un effet négatif sur les performances. Par ailleurs, les fonctionnalités particulières du NF200 (comme le multicast) sont présentes sur le PEX 8747.

Chaque processeur graphique a son propre bis mémoire à 256 bits, sur lequel Nvidia branche 2 Go de GDDR5. Le fabricant assure que la mémoire est aussi rapide que sur les GTX 680 ( 6 GT/s) et la bande passante aussi large (192 Go/s par GPU).

Les fréquences des GK104 sont légèrement inférieures : 915 MHz sur la GeForce GTX 690 contre 1006 MHz. Cette concession était nécessaire pour maintenir le TDP de la carte sous les 300 W. Cependant, la technologie GPU Boost est toujours présente et peut pousser les GPU à 1019 MHz tant que le TDP n’est pas dépassé (les GeForce GTX 680 peuvent aller jusqu’à 1058 MHz).

La puissance est une des caractéristiques clés de la GeForce GTX 690. Son prédécesseur, la GeForce GTX 590 affichait un TDP de 365 W, dangereusement proche du maximum fournit par le port PCI-Express et les deux connecteurs d’alimentation à 8 broches. La GeForce GTX 690 n’affiche qu’un TDP de 300 W et possède pourtant les mêmes connecteurs, ce qui laisse de la marge aux overclockers les plus fous.

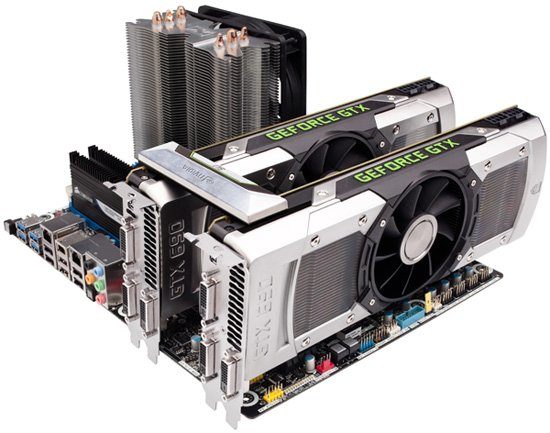

La GeForce GTX 690 est aussi un témoignage des efforts réalisés par les ingénieurs de Nvidia pour construire une carte qui reste silencieuse, dissipe efficacement la chaleur et soit jolie à regarder. La coque est faite d’aluminium chromé, et non de plastique comme sur la plupart des autres cartes graphiques. Le châssis du ventilateur est construit en un alliage de magnésium, qui est censé aider l’évacuation de la chaleur et minimise la propagation des vibrations.

Chaque GPU est recouvert d’un dissipateur à chambre à vapeur, comme sur toutes les Radeon ou GeForce récente. Nvidia a même ajouté une LED sur le dessus pouvant être contrôlée par logiciel, changeant de couleur selon la charge par exemple. Pour le moment, toutefois, cette LED se contente de s’allumer en même temps que la carte.

Comme sur les cartes bi-GPU précédentes, Nvidia utilise un ventilateur axial monté au milieu des deux GPU. Le défaut de cette configuration est que la chaleur du GPU arrière est recyclée à l’intérieur du boîtier. Mais puisque Nvidia et AMD l’ont choisie pour leurs dernières cartes bi-GPU, nous ne pouvons que supposer qu’il s’agit de la moins mauvaise option.

Pourtant, dans un PC où serait installé deux GeForce GTX 690 en SLI, c’est l’air chaud issu de deux GeForce GTX 680 qui se trouve ainsi renvoyé dans le boîtier plutôt qu’évacué dehors. Un détail à ne pas négliger.

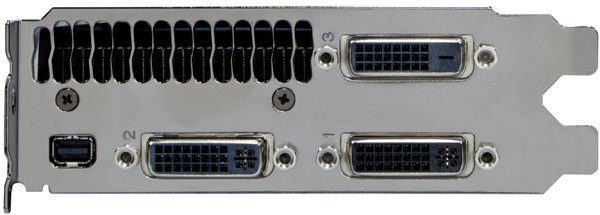

Les GeForce GTX 690 offrent quatre sorties vidéo : trois DVI dual-link et un mini-DisplayPort. Elles sont utilisables en même temps, sur quatre écrans différents. Ici la carte bi-GPU facilite vraiment les choses. Avec deux GeForce GTX 680, connecter trois écrans peut-être un vrai casse-tête : bien que chacune possède quatre sorties, tout n’est pas possible selon que les écrans utilisent du DVI, du HDMI ou du DisplayPort. Avec trois DVI, tout est plus simple.

Overclocking et Tessellation

Overclocking

En plus d’avoir conçu un dissipateur plus efficace, Nvidia prétend sélectionner à la main les GPU GK104 les mieux gravés afin de minimiser la dissipation thermique de la GeForce GTX 690. Ce processus aurait une autre conséquence : les représentants de la marque nous ont assuré que la carte possédait une grande marge d’overclocking.

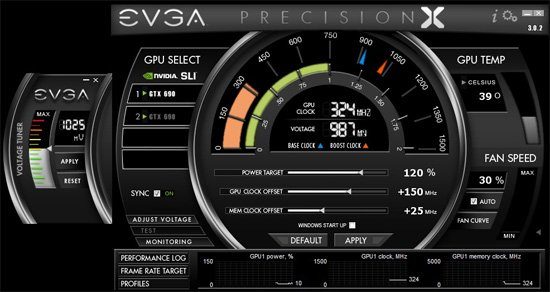

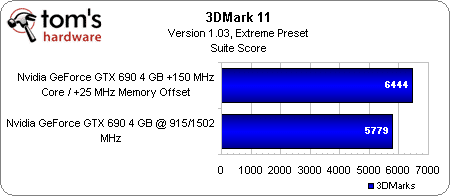

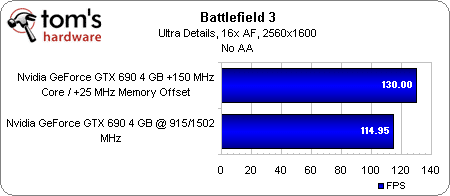

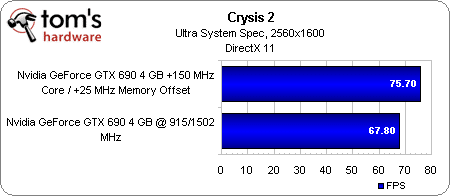

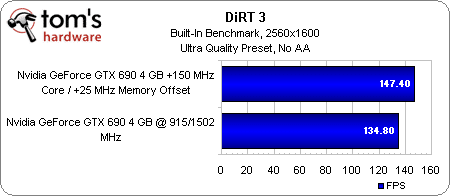

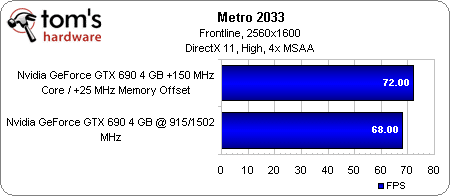

Grâce au très bon utilitaire d’EVGA – Precision X Tool – nous avons réussi à pousser la fréquence GPU de 150 MHz et celle de la mémoire de 25 MHz, en augmentant simplement le TDP maximum autorisé de 20 %. La carte n’était malheureusement pas totalement stable avec ces réglages, mais diminuer la tension de 1,025 V à 0,988 V suffit à supprimer tous les plantages.

Les gains résultant sont satisfaisants, allant de + 13 % dans Battlefield 3 à + 5 % dans Metro 2033 en 2560 x 1600.

Tessellation

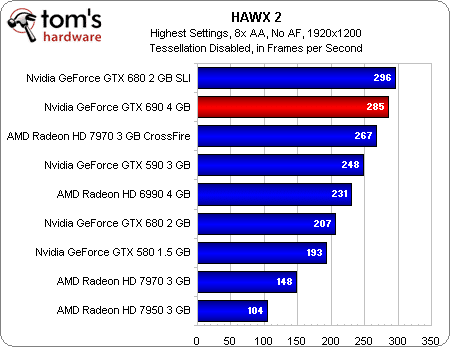

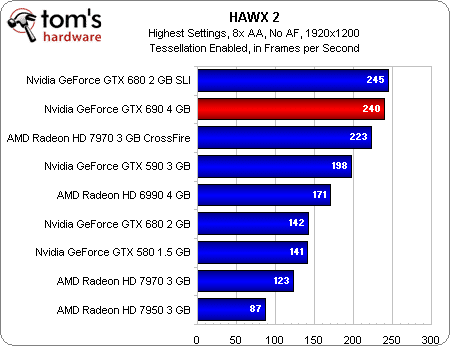

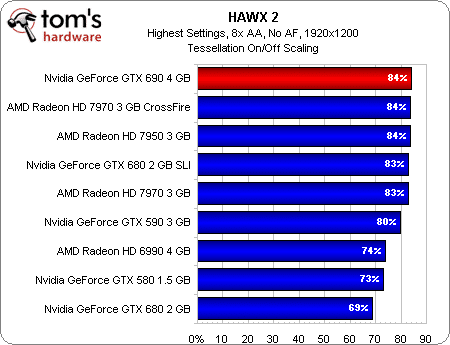

Comme d’habitude nous utilisons HAWX 2 pour tester l’influence de la tesselation sur les performances des cartes AMD et Nvidia.

La seule conclusion que l’on puisse tirer de cet exercice est que la GeForce GTX 690 fait aussi bien que deux GeForce GTX 680 en SLI, qui s’en sortent elles-mêmes mieux qu’une seule GTX 680. Nous ne savons pas exactement pourquoi la 680 souffre autant lorsqu’on active la tesselation, mais il y a clairement un goulet d’étranglement bloquant le framerate plus que la géométrie.

PCI Express 3.0 et rumeur d’un GK110

Le PCI Express 3.0 chez Intel

Il faut que nous parlions du support du PCI-Express 3.0 chez Nvidia sur les plateformes Intel X79. Commençons par un rappel historique.

À l’époque où nous avons publié le test d’un prototype de Sandy Bridge-E (voire Preview : Intel Core i7-3960X (Sandy Bridge-E) et X79), toutes nos sources nous assuraient que le contrôleur PCI-Express intégré à ces processeurs ne serait PAS certifié en PCI-Express 3.0 à 8 GT/s. Il devait être limité au PCI-Express 2.0 à 5 GT/s. Puis, d’un coup, le vent tourna et le contrôleur fut dit compatible 8 GT/s, même si aucune mention n’était fait du standard PCI-Express 3.0.

Lorsque AMD lança ses Radeon HD 7000, nous fûmes capables de les faire fonctionner en PCI-Express 3.0. Un peu plus tard, Nvidia lança sa GeForce GTX 680 avec un pilote “presse” bridé à 5 GT/s. Nvidia nous fit parvenir une deuxième version débridée en nous affirmant que les GTX 680 fonctionneraient bien en PCI-Express 3.0 sur les plateformes Ivy Bridge – ce que nous avons pu confirmer depuis.

Alors pourquoi ne pas présenter la carte comme une PCI-Express 3.0 dès le départ ? Il y a une raison, mais nous attendons d’avoir plus d’éléments avant de vous en parler.

Reprenons les points que nous venons d’évoquer, néanmoins :

- le X79 et les Sandy Bridge-E devaient à l’origine être limités au PCI-Express 2.0.

- la GeForce GTX 680, une carte qui profite beaucoup du SLI, fonctionne à 5 GT/s sur les processeurs Sandy Bridge-E et à 8 GT/s sur les processeurs Ivy Bridge.

- la GeForce GTX 690 fonctionne à 8 GT/s à la fois sur les processeurs Sandy Bridge-E et sur les processeurs Ivy Bridge.

Le problème ne semble donc pas venir de Nvidia, de son GK104 ou de ses pilotes, mais plutôt du fait que le contrôleur PCI-Express des Sandy Bridge-E n’est pas totalement validé pour le PCI-Express 3.0.

Verra-t-on mieux en 2012 ?

Beaucoup de lecteurs de notre test de la GeForce GTX 680 (GeForce GTX 680 : Kepler envoie Tahiti à la retraite) nous ont indiqué en commentaire qu’ils préféraient attendre que Nvidia présente le vrai visage de Kepler, le GK110, qui pourrait posséder 7 milliards de transistors.

Au nom de ces lecteurs, nous avons harcelé Nvidia pour obtenir des informations sur une éventuelle GeForce GTX 685 ou 695. Les porte-paroles de la marque sont restés délibérément vagues au sujet de l’existence d’un autre GPU, mais ont clairement indiqué que la GeForce GTX 690 ne sera pas dépassé de si tôt.

Il nous semble peu probable qu’un GPU plus puissant que le GK104 sorte avant Q4. Et quand bien même, il n’est pas sûr qu’il dépassera deux GK104. Après tout, deux GF104 enterrait sans peine un seul GF110 (voire …). Le GK110 sera probablement une puce plus équilibrée, aussi performante dans les jeux que dans les applications de calcul GPGPU.

Configuration de test et des benchmarks

| Test Hardware | |

|---|---|

| Processors | Intel Core i7-3960X (Sandy Bridge-E) 3.3 GHz at 4.2 GHz (42 * 100 MHz), LGA 2011, 15 MB Shared L3, Hyper-Threading enabled, Power-savings enabled |

| Motherboard | Gigabyte X79-UD5 (LGA 2011) X79 Express Chipset, BIOS F10 |

| Memory | G.Skill 16 GB (4 x 4 GB) DDR3-1600, F3-12800CL9Q2-32GBZL @ 9-9-9-24 and 1.5 V |

| Hard Drive | Intel SSDSC2MH250A2 250 GB SATA 6Gb/s |

| Graphics | Nvidia GeForce GTX 690 4 GB |

| 2 x Nvidia GeForce GTX 680 2 GB | |

| 2 x AMD Radeon HD 7970 3 GB | |

| AMD Radeon HD 7950 3 GB | |

| AMD Radeon HD 6990 4 GB | |

| Nvidia GeForce GTX 590 3 GB | |

| Nvidia GeForce GTX 580 1.5 GB | |

| Power Supply | Cooler Master UCP-1000 W |

| System Software And Drivers | |

| Operating System | Windows 7 Ultimate 64-bit |

| DirectX | DirectX 11 |

| Graphics Driver | Nvidia GeForce Release 301.33 (For GTX 690) |

| Nvidia GeForce Release 300.99 and 301.10 (For GTX 680) | |

| Nvidia GeForce Release 296.10 (For GTX 580 and 590) | |

| AMD Catalyst 12.2 (For HD 7950 and HD 6990) | |

| AMD Catalyst 12.4 (For HD 7970) | |

Nous nous fixons comme règle de toujours utiliser les derniers pilotes disponibles au début de chacun de nos tests, afin que chaque composant donne le meilleur de lui-même.

Pour cet article cependant, nous n’avons pas eu ce luxe. La GeForce GTX 690 fut testée avec les pilotes 301.33 fournis par Nvidia. Nous avons ensuite vérifié les performance de la GeForce GTX 680 seule ou en SLI avec la dernière version publiquement disponible, la 301.10. Nous avons fait de même enfin avec les Radeon HD 7970 seules ou CrossFire avec les Catalyst 12.4.

| mes | |

|---|---|

| Battlefield 3 | Ultra Quality Settings, No AA / 16x AF, 4x MSAA / 16x AF, v-sync off, 1920×1080 / 2560×1600 / 5760×1080, DirectX 11, Going Hunting, 90-second playback, Fraps |

| Crysis 2 | DirectX 9 / DirectX 11, Ultra System Spec, v-sync off, 1920×1080 / 2560×1600 / 5760×1080, No AA / No AF, Central Park, High-Resolution Textures: On |

| Metro 2033 | High Quality Settings, AAA / 4x AF, 4x MSAA / 16x AF, 1920×1080 / 2560×1600 / 5760×1080, Built-in Benchmark, Depth of Field filter Disabled, Steam version |

| DiRT 3 | Ultra High Settings, No AA / No AF, 8x AA / No AF, 1920×1080 / 2560×1600 / 5760×1080, Steam version, Built-In Benchmark Sequence, DX 11 |

| The Elder Scrolls V: Skyrim | High Quality (8x AA / 8x AF) / Ultra Quality (8x AA, 16x AF) Settings, FXAA enabled, vsync off, 1920×1080 / 2560×1600 / 5760×1080, 25-second playback, Fraps |

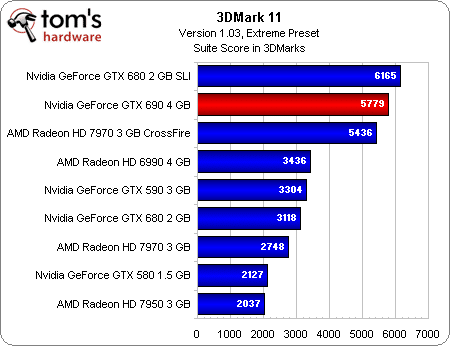

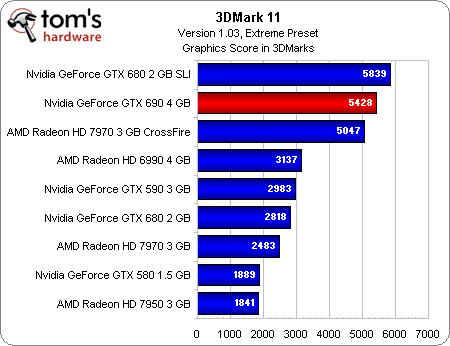

| 3DMark 11 | Version 1.03, Extreme Preset |

| HAWX 2 | Highest Quality Settings, 8x AA, 1920×1200, Retail Version, Built-in Benchmark, Tessellation on/off |

| World of Warcraft: Cataclysm | Ultra Quality Settings, No AA / 16x AF, 8x AA / 16x AF, From Crushblow to The Krazzworks, 1920×1080 / 2560×1600 / 5760×1080, Fraps, DirectX 11 Rendering, x64 Client |

| SiSoftware Sandra 2012 | Sandra Tech Support (Engineer) 2012.SP4, GP Processing and GP Bandwidth Modules |

| LuxMark 2.0 | 64-bit Binary, Version 1.0, Room Scene |

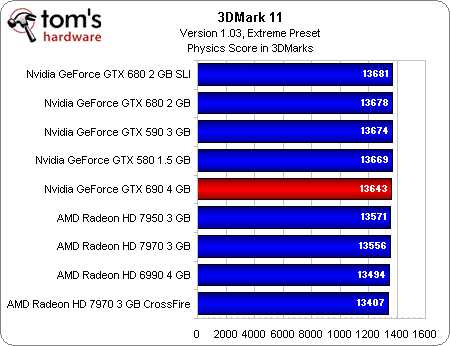

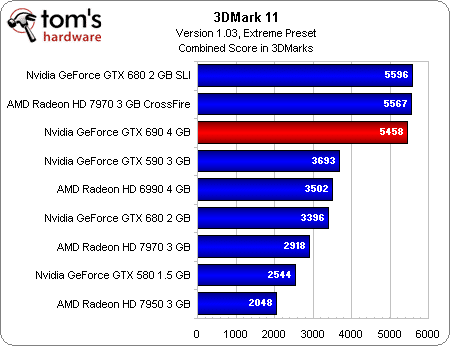

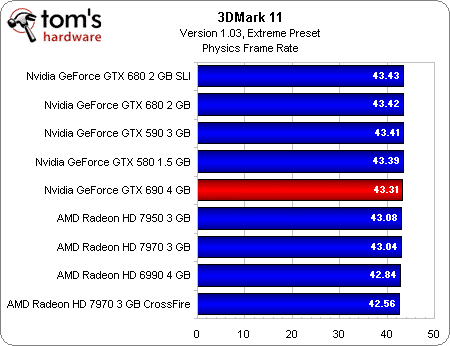

Benchmark : 3DMark 11 (DX 11)

Comme nous nous y attendions, la GeForce GTX 690 4 Go se place juste derrière deux GeForce GTX 680 en SLI. Le Crossfire de Radeon HD 7970 termine troisième.

Les championnes de la génération précédente, Radeon HD 6990 et GeForce GTX 590 se retrouvent dépassées de manière presque incroyable.

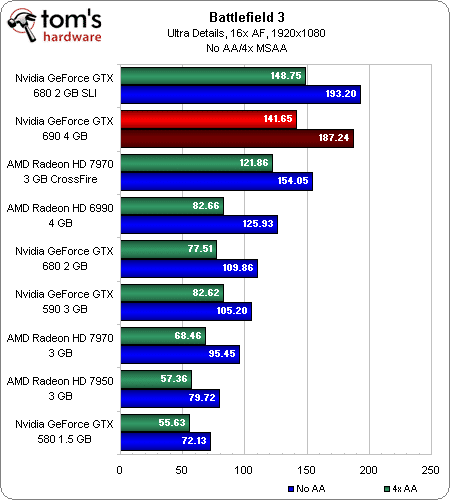

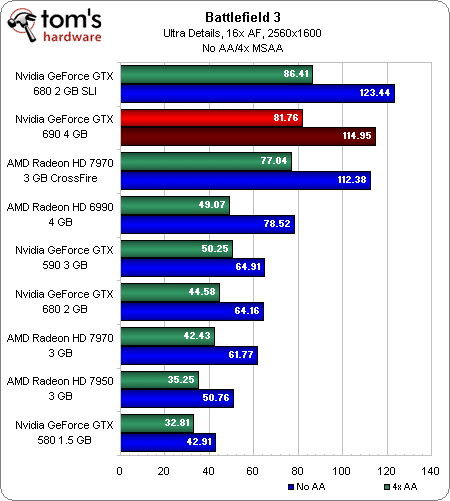

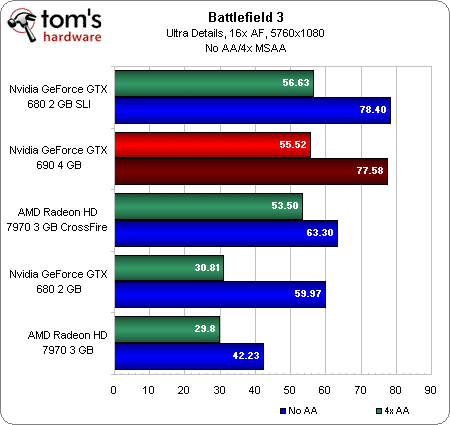

Benchmark : Battlefield 3 (DX 11)

Là encore, la GeForce GTX 690 se place là où nous l’attendions, un peu en dessous de deux GeForce GTX 680. Mais il ne faut pas s’arrêter à ça. Un mois après leur lancement, les 680 sont toujours en rupture de stocks dans la plupart des magasins. Selon toute vraisemblance, les 690 seront donc fabuleusement difficiles à trouver. En face, vous avez le CrossFire de Radeon HD 7970. Vous investissez au total 120 € de moins dans des cartes réellement disponibles, qui donnent en outre une assez grande marge d’overclocking. Nous étions sévère avec AMD quand les 7970 étaient à plus de 500 €, mais aujourd’hui, la balance ne penche plus autant en faveur de Nvidia.

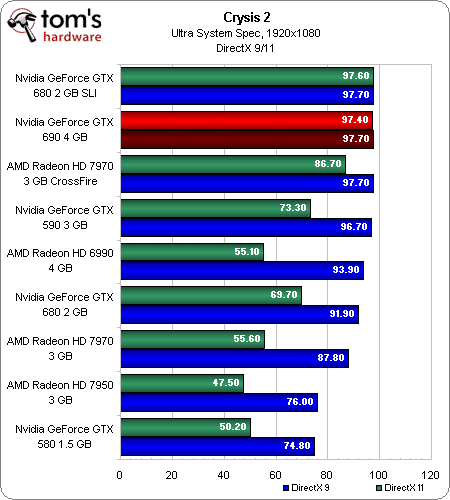

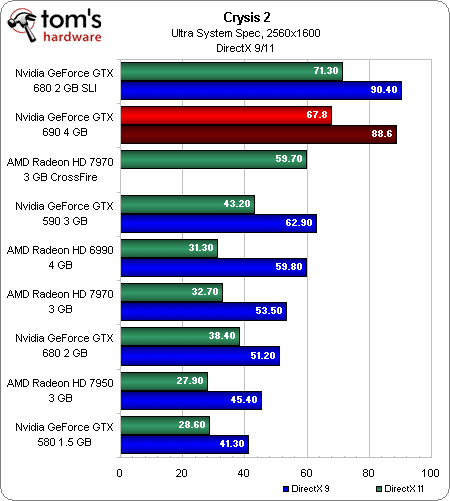

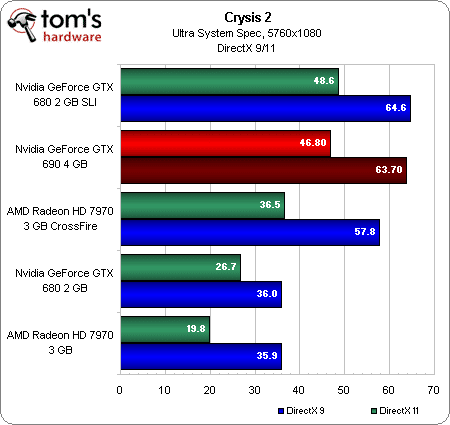

Benchmark : Crysis 2 (DX 9 et DX 11)

Crysis 2 place la GeForce GTX 690 aussi proche que possible des deux GTX 680. Cela devrait rassurer ceux qui s’inquiétaient de la perte de quelques mégahertz. Le CrossFire de Radeon HD 7970 font très bonne figure en Full HD ou en 5760 x 1080. Cependant, même avec les récents Catalyst 12.4, un crash dérangeant et reproductible persiste en 2560 x 1600 dans le mode DirectX 9.

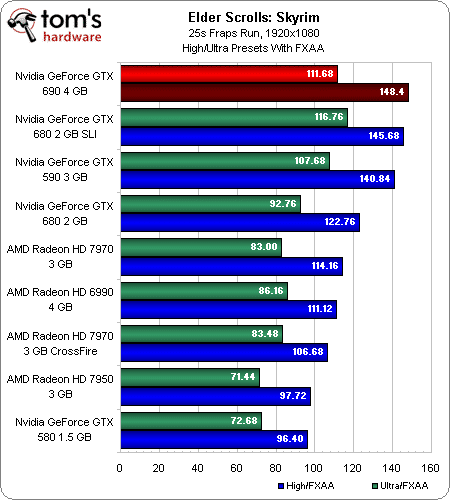

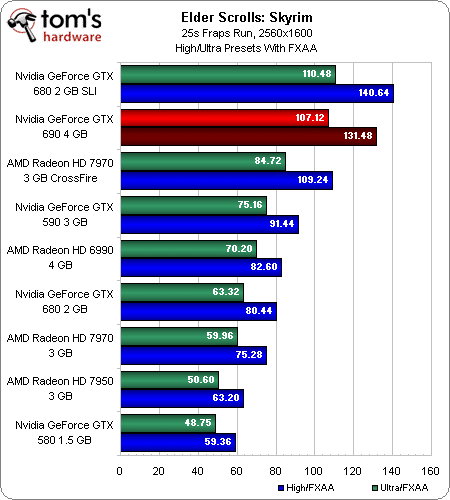

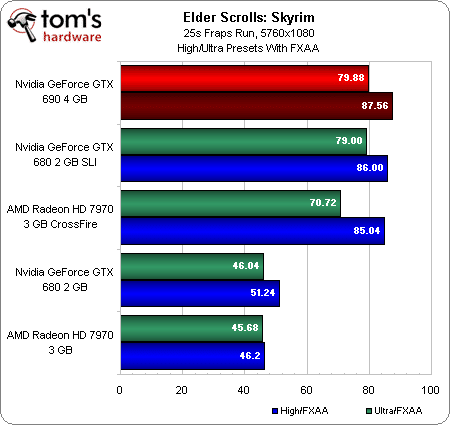

Benchmark : The Elder Scrolls V : Skyrim (DX 9)

La GeForce GTX 690 et le SLI de GTX 680 font jeu égal dans Skyrim. Bien que le CrossFire de Radeon HD 7970 souffre en 1920 x 1080, il est très compétitif en 5760 x 1080.

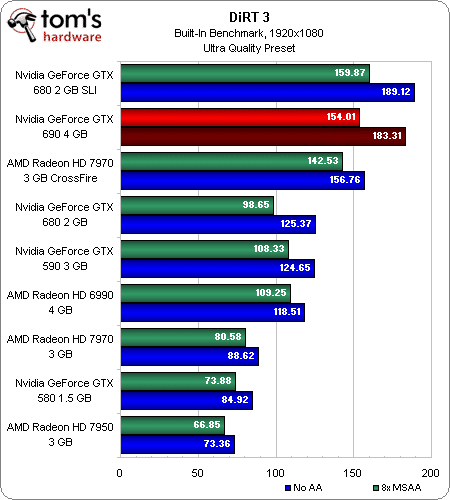

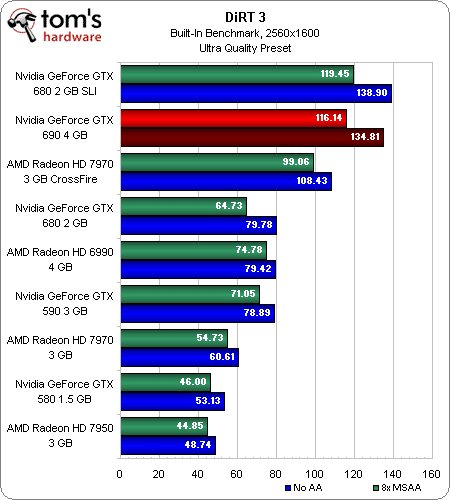

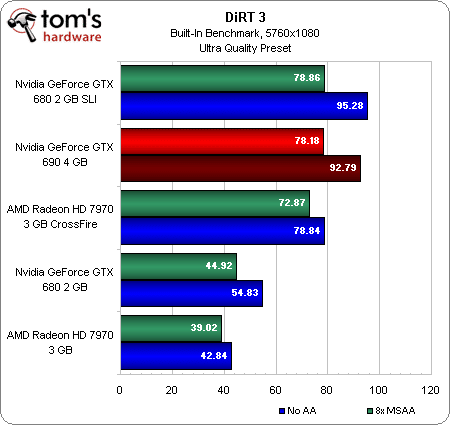

Benchmark : DiRT 3 (DX 11)

Le tableau ne change pas dans DiRT 3 : la GTX 690 est deuxième derrière le SLI de GTX 680 quelque soit la résolution, les Radeon HD 7970 ne sont pas très loin derrière et assurent un framerate convenable jusqu’en 5760×1080 avec anticrénelage MSAA 8x.

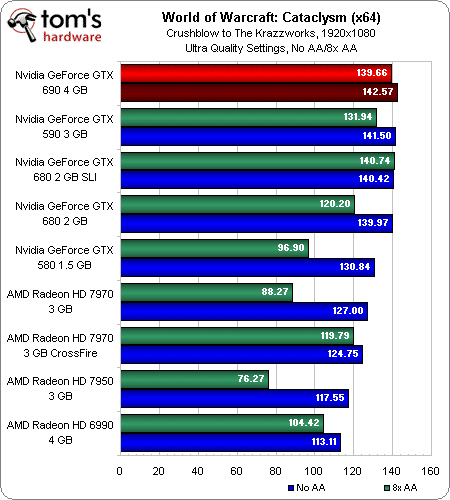

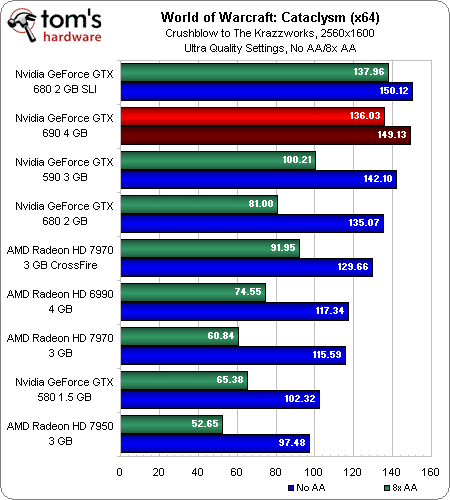

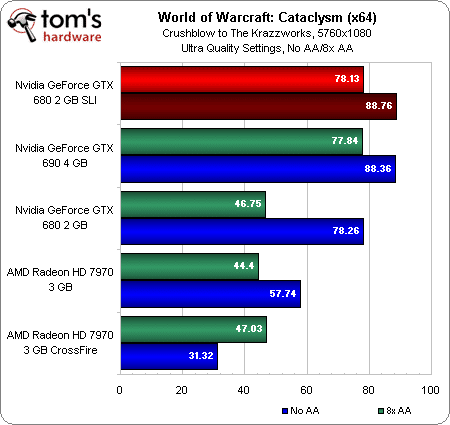

Benchmark : World of Warcraft : Cataclysm (DX 11)

WoW est si limité par le CPU que la vieille GTX 590 se voit propulsée dans le peloton de tête 1920 x 1080. Dans cette résolution, nous l’avons constaté à plusieurs reprises, les cartes AMD sont réellement en difficulté.

La GeForce GTX 690 et le SLI de GTX 680 ne se distinguent pas en 2560 x 1600. C’est seulement en 5760 x 1080 avec AA 8x que nous voyions les GTX 680 en SLI et la GTX 690 prendre une réelle avance sur une seule GTX 680.

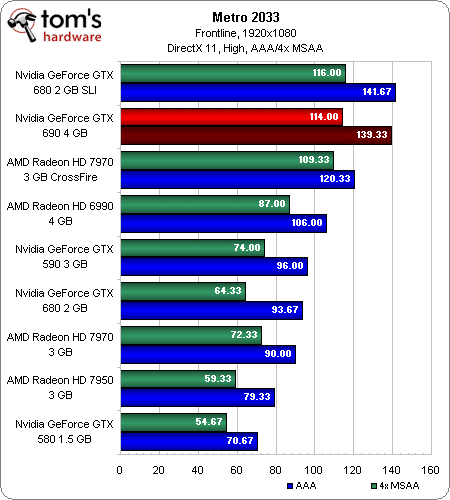

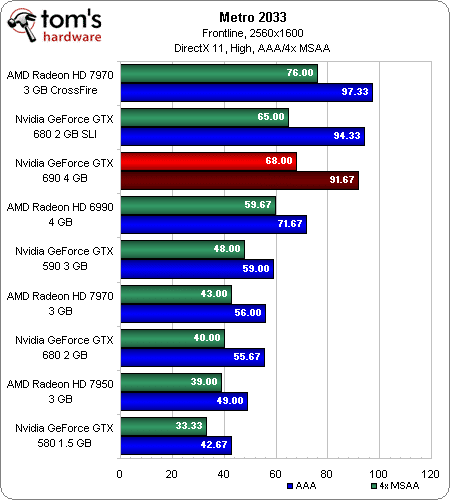

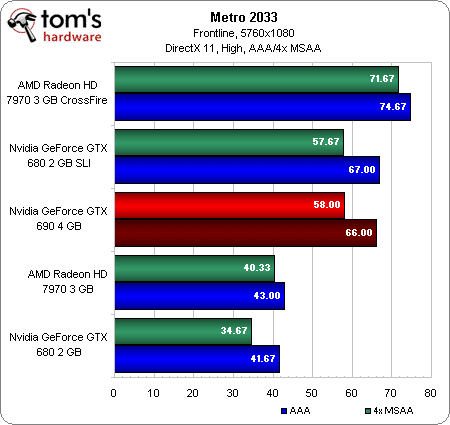

Benchmark : Metro 2033 (DX 11)

Les GeForce sont à la fête en Full HD dans Metro 2033, mais le CrossFire de Radeon remontent la pente en 2560 x 1600 puis 5760 x 1080, surtout une fois un filtre AA 4x appliqué. Pendant ce temps, les GTX 690 et 680 en SLI restent dans un mouchoir – une preuve supplémentaire qu’on n’a pas beaucoup à perdre de la très légère diminution de fréquence des GPU.

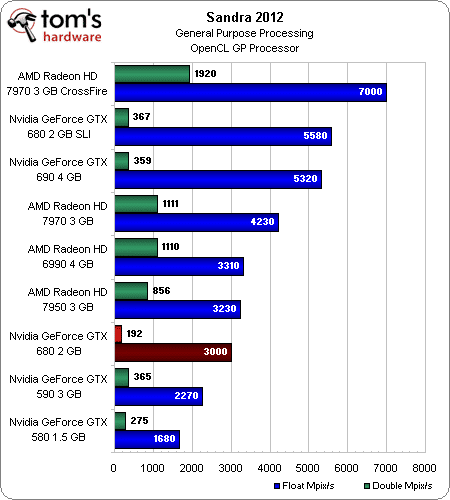

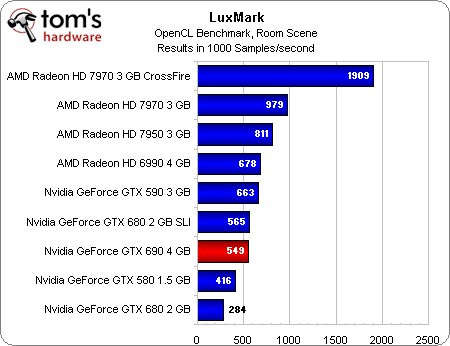

Benchmark : Sandra 2012 et LuxMark 2.0

Sans surprise, la performance de la GeForce GTX 690 en simple précision (FP32) est respectable. En double précision (FP64) toutefois, artificiellement bridée, elle fait pâle figure face à une seule Radeon HD 7970. Par ailleurs, malheureusement pour nous, les pilotes GeForce 301.33 rendent inopérants les test OpenCL de bande passante GPGPU et cryptographie. Cela n’empêche pas de voir la segmentation très claire que Nvidia applique dans sa gamme de GPU, en bridant les cartes pour joueurs afin de promouvoir les cartes GPGPU. C’est finalement une bonne nouvelle pour AMD, dont les puces d’architecture GCN sont à l’aise à la fois en 3D et en calcul pur.

Démonstration avec LuxMark 2.0 : les cartes Nvidia sont en retrait derrière toutes les Radeon de génération actuelle ou précédente.

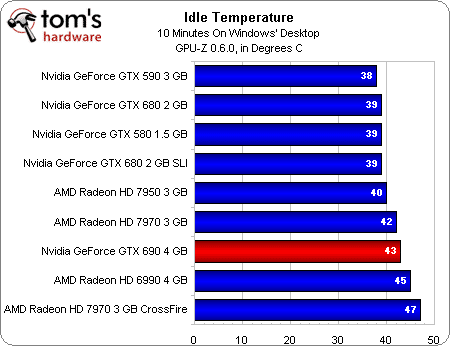

Bruit et températures

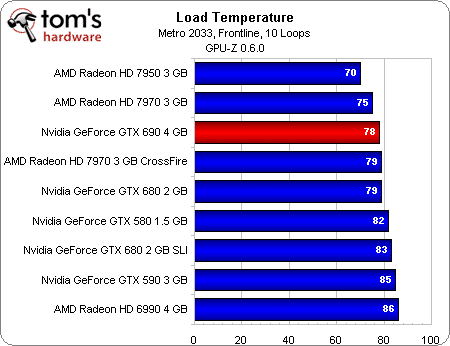

En charge, le plus chaud des deux GPU de la GeForce GTX 690 n’a pas dépassé 78 °C. C’est très impressionnant puisque une GeForce GTX 680 installée seule peut atteindre 79 °C. En SLI, la plus chaude des deux GTX 680 est même montée à 83 °C.

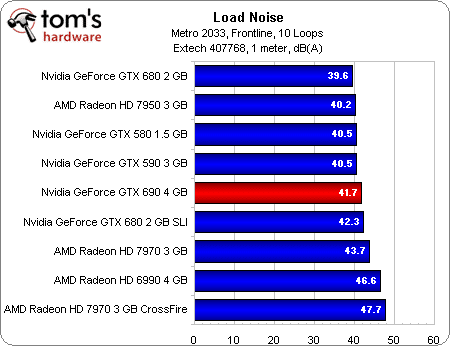

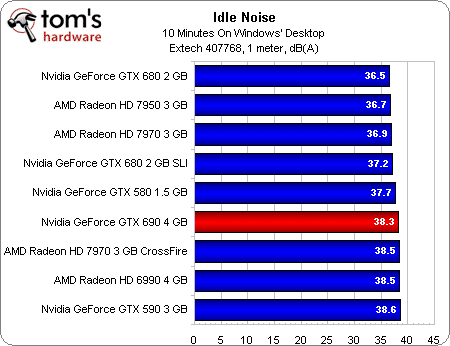

En outre, la GeForce GTX 690 maintient cette température avec discrétion. Nvidia l’avait promis : son fer de lance fait moins de bruit qu’une paire de GTX 680 en SLI. La GTX 690 est tout de même un peu plus bruyante que la GTX 590.

Les GeForce sont toutes bien plus discrètes qu’une seule Radeon HD 7970 – ne parlons pas de deux en CrossFire. Heureusement pour AMD, ses partenaires abandonnent en masse le dissipateur de référence pour des modèles plus silencieux.

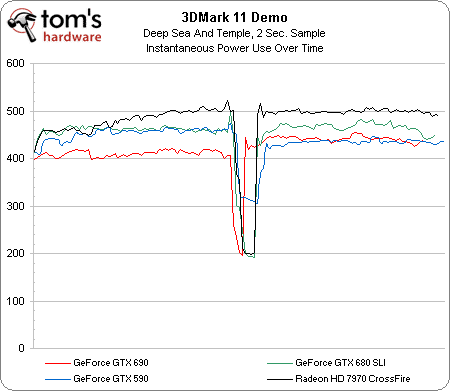

Consommation

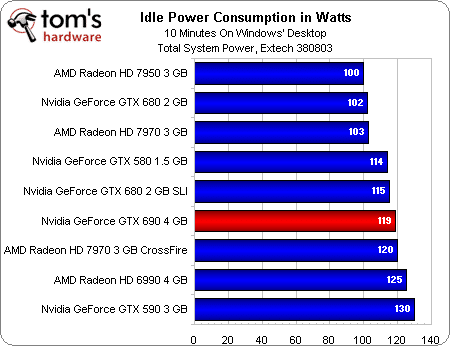

Il n’y a pas de meilleure démonstration de l’efficacité des technologies mises au point par AMD et Nvidia pour réduire la consommation de leurs cartes haut de gamme que ce graphique, dominé par les GPU de dernière génération.

La GeForce GTX 690 n’est pas très efficace dans l’absolu, mais c’est la deuxième carte bi-GPU la plus économe, juste derrière les deux GeForce GTX 680 en SLI.

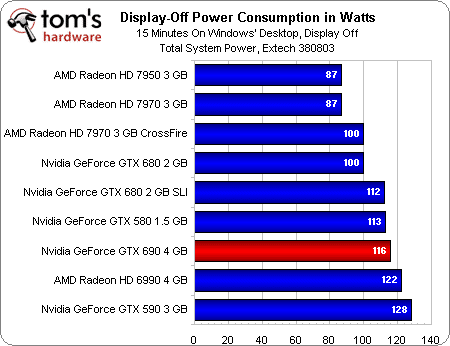

AMD domine vraiment le débat lorsque l’écran (ou les écrans) se mettent en veille. Sa technologie ZeroCore permet aux Radeon HD 7970 de demander aussi peu qu’une seule GeForce GTX 680. Lorsque les écrans s’éteignent, le duo AMD diminue sa consommation de 20 W. Par comparaison, la consommation de la GeForce GTX 690 ne baisse que de 3 W.

Chaque GeForce GTX 680 a un TDP de 195 W. Chaque Radeon HD 7970, un TDP de 250 W. La GeForce GTX 690, un TDP de 300 W. Il est donc logique que la cette dernière consomme moins en charge que ses concurrentes. Les deux Radeon sont vraiment des gouffres à watts. La GeForce GTX 590 se montre également plus gourmande que la 690 (rien d’étonnant non plus vu son TDP de 365 W).

Ce chapitre est vraiment celui où l’architecture Kepler brille. Nvidia pourrait facilement remporter toutes les manches du match en optimisant la consommation de ses cartes au repos, en copiant ZeroCore. Les économies réalisées en charge sont impressionnantes, mais finalement, nos PC passent beaucoup de plus de temps à ne pas jouer.

Conclusion : une beauté inaccessible

Tester la GeForce GTX 690 n’était presque pas nécessaire. Nvidia nous avait donné une indication suffisamment précise de ses performances en nous disant que son Étoile Noire serait pleinement opérationnelle, autrement dit que les deux GPU auraient toutes leurs unités de calcul fonctionnelles. Une petite baisse de fréquence suggérait que les performances seraient un cheveu en dessous de celles de deux GeForce GTX 680, certainement pas assez pour faire une différence notable en jeu.

Dès lors que l’on considère 500 € un prix raisonnable pour une GeForce GTX 680, 1000 € pour une GeForce GTX 690 est également acceptable. Mais est-ce mieux ou doit-on préférer une paire de GTX 680 ? La réponse dépend de vos priorités.

En pratique, deux GTX 680 restent un peu plus rapides, évacuent mieux leur chaleur. Elles laissent aussi la possibilité d’une évolution future, en rajoutant une troisième GTX 680, pour peu que l’on ait encore 500 € à débourser et une carte mère adaptée.

Mais une GeForce GTX 690 est notablement plus silencieuse (même sur les cartes mères où les GTX 680 sont séparées par deux slots vides, comme notre Gigabyte X79-UD5). Elle est aussi préférable si on envisage le Quad-SLI, mais dans ce cas, il faudra porter une attention toute particulière à l’évacuation de la chaleur des deux GPU “internes”, recyclées dans le boitier par le ventilateur axial. Overclocker le CPU devient beaucoup plus délicat dans une atmosphère surchauffée par deux GK104.

Enfin, la GTX 690 a un truc en plus, difficilement quantifiable. Elle est un mélange de métal, polycarbonate, silicium et lumière certainement plus attirant qu’une banale GTX 680. Cela suffit-il à emporter la décision ? Si vous êtes un esthète de la carte graphique, oui, évidemment.

Supposons donc que vous souhaitiez en acheter une (ou deux pour du quad SLI). Les GeForce GTX 680 étant déjà difficiles à trouver, vous aurez sans doute beaucoup de peine à mettre la main sur une GTX 690. Nvidia nous dit que sa carte sera disponible sera en quantités limitées, comme la GTX 590. Quelques unes devraient être là aujourd’hui, un peu plus seront livrées le 7 mai. Les intégrateurs auxquels nous avons demandé combien ils espéraient en recevoir nous ont spontanément ri au nez. Vous ne verrez donc sans doute jamais mieux une GeForce GTX 690 que sur les photos de cet article.

Et nous bouclons ainsi la boucle : le nouveau fer de lance de Nvidia possède de nombreux points en commun avec les voitures de sports. Elle est attirante, exclusive et pas très pratique. Mais si vous l’attendiez, il y a de grandes chances que vous sachiez déjà cela et l’acceptiez.