Parler d’écrans de jeu à l’heure actuelle sans évoquer les technologies de rafraichissement variable, c’est comme préparer une pizza sans olive ! Avec leur arrivée sur les dernières consoles de salon et les téléviseurs grâce à l’HDMI 2.1, ces technologies de synchronisation entre l’écran et la carte graphique touchent un plus large panel de joueurs qu’auparavant. V-Sync, Adaptive Sync, VRR, QMS VRR, FreeSync, G-Sync, ELMB-Sync … on vous décrypte ces termes barbares !

Deux axes majeurs continuent de conditionner le développement des jeux vidéo comme du hardware qui permet de les faire tourner. D’un côté les studios réalisent des jeux toujours plus travaillés en matière de graphisme, intégrant des technologies qui viennent renforcer le sentiment d’immersion et offrir des rendus graphiques (et même sonore) toujours plus réalistes comme c’est le cas avec le ray tracing et bien entendu avec l’HDR.

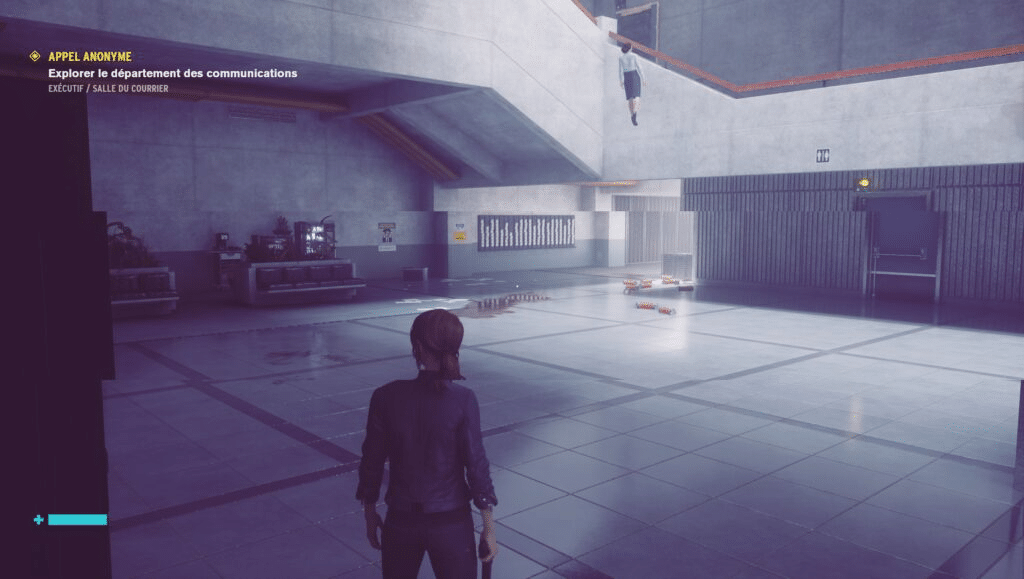

D’un autre côté, l’industrie vidéoludique n’a cessé de se pencher sur la question des performances afin d’impacter positivement la jouabilité. C’est vrai pour les jeux compétitifs, on pense notamment aux jeux multijoueurs en ligne où la fluidité et la latence sont des facteurs décisifs, mais ça l’est également devenu avec les titres solos et contemplatifs afin de répondre aux besoins demandés pour un jeu AAA, potentiellement joué en 4K et HDR.

A lire > OLED, QLED, IPS… : quelle est la meilleure technologie d’écran pour jouer ou travailler ?

Le Variable Refresh Rate (VRR) et les technologies qui en dépendent sont donc là pour améliorer l’expérience de jeu sur des points précis. Il s’agit en effet d’agir et de réduire l’input lag, tout en éliminant du mieux possible tout problème de tearing et de stuttering. Tout est histoire de synchronisation entre le rendu graphique généré par le GPU et la capacité de l’écran à afficher ces images. L’absence de synchronisation entre ces deux éléments produits des artefacts très désagréables.

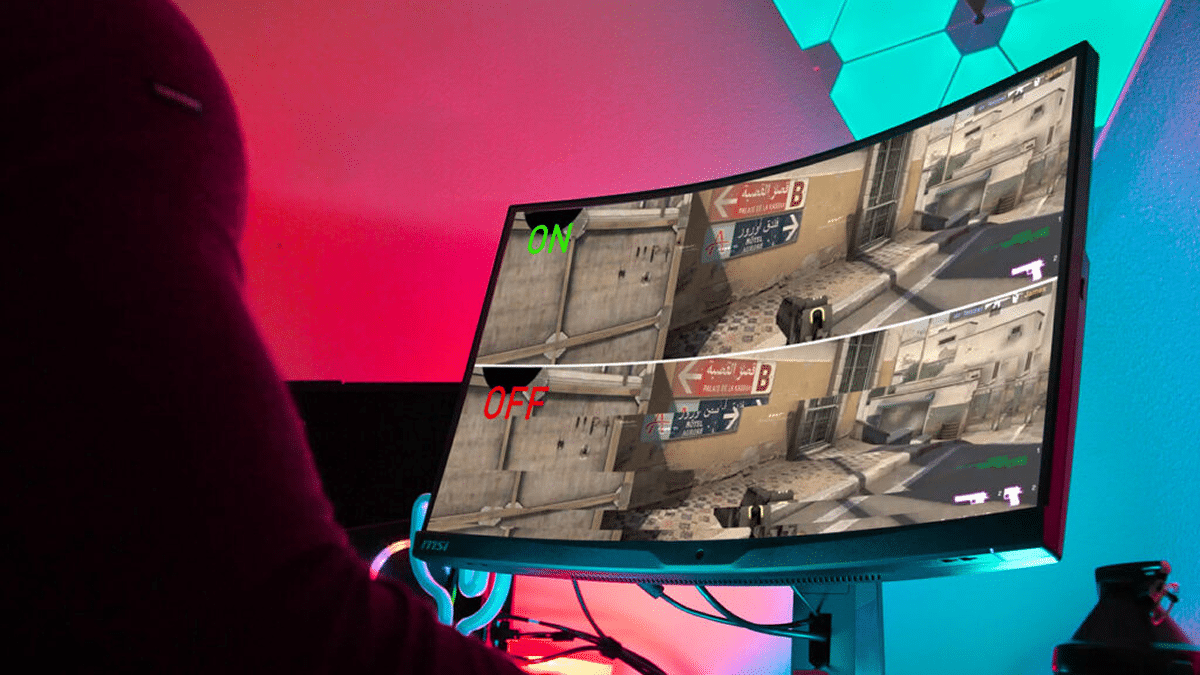

Le tearing d’abord, n’est autre que le phénomène de déchirement d’image ; celui-ci se produit lorsque le temps de calcul du GPU varie trop fortement sur une courte période, l’écran balaye toujours avec la même fréquence, mais le pipeline de rendu du GPU génère un nombre d’images par seconde trop instable pour être correctement affiché à l’écran. Le stuttering se produit quant à lui lorsque la carte graphique peine à générer suffisamment d’images par seconde par rapport à la fréquence de balayage de l’écran ; il consiste en des saccades plus ou moins marquées, ce pourquoi on peut le traduire par « bégaiement ».

A lire > Guide d’achat : les meilleurs PC portables gaming

V-Sync : un pansement sur une jambe de bois

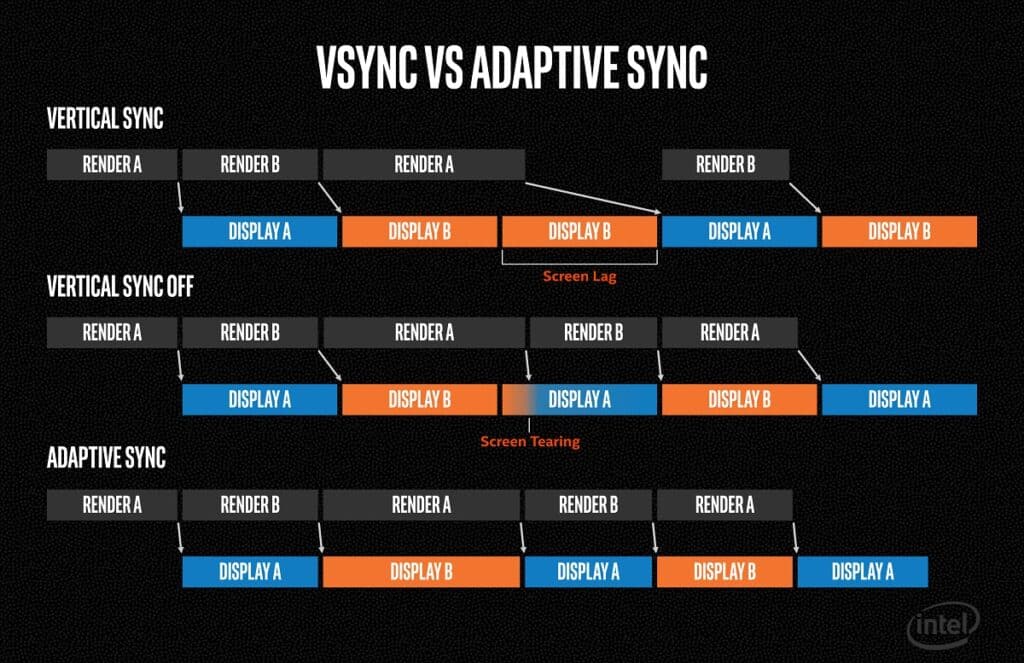

L’idée derrière le VRR est donc d’accorder, de synchroniser, la fréquence de rafraichissement de l’écran en temps réel par rapport au nombre d’images par seconde générée par le GPU. Cependant, la première parade des ingénieurs a été de s’attaquer au problème dans l’autre sens grâce à la synchronisation verticale, ou V-Sync pour les intimes.

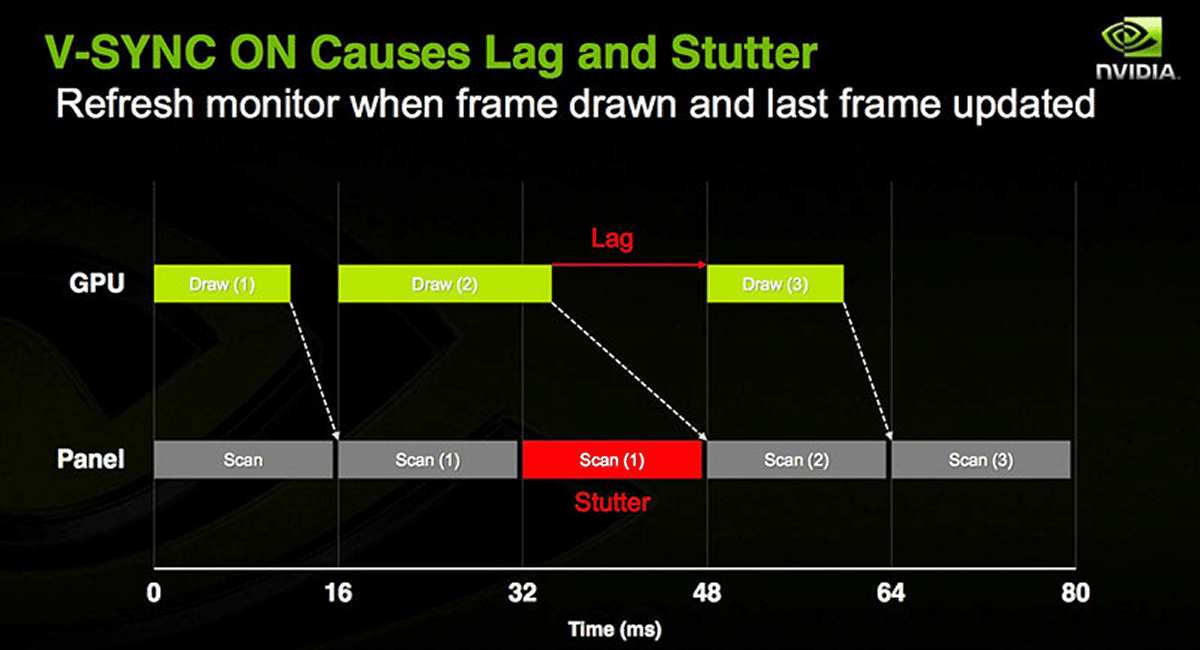

La V-Sync permet de limiter le pipeline de rendu en ne lui faisant pas produire plus d’images que l’écran n’est capable d’en afficher sur une seconde. Pour un écran de 144 Hz, cela signifie que la carte graphique ne génèrera pas plus de 144 images par seconde. Cette limitation des FPS permet d’éviter le tearing : le GPU patiente en attendant le signal vblank de l’écran pour envoyer la série d’images suivante. Cette solution est malgré tout très loin d’être parfaite. Pour cause, elle agit uniquement sur l’instabilité du GPU à générer trop d’images par rapport au balayage de l’écran. Dans le cas contraire, à savoir un rendu graphique plus lent que le taux de rafraichissement de l’écran, le stuterring est garanti ! Idem au niveau de l’input lag : le temps d’attente entre deux séries d’images augmente la latence du système.

A lire > Les meilleurs jeux et franchises d’action-aventure de tous les temps

La technologie V-Sync a été maintes fois améliorée par AMD comme chez Nvidia. Les deux géants ont notamment développé l’Adaptive V-Sync, l’Enhanced Sync, ou encore la FastSync. Si ces différentes technologies ont permis de gommer certaines faiblesses de la V-Sync, en ajustant automatiquement son utilisation en fonction de différents paramètres ou en l’associant à la triple mémoire tampon, leurs résultats n’ont jamais été à la hauteur des attentes.

FreeSync, G-Sync : la naissance du VRR

Après quelques années de développement et des résultats en demi-teinte, Nvidia comme AMD ont décidé de passer à autre chose en abandonnant simplement le V-Sync. Plutôt que de tenter d’adapter le rendu graphique afin de se conformer au balayage de l’écran, c’est désormais l’écran qui adaptera sa fréquence de rafraichissement de manière dynamique et automatique à ce que la carte graphique produit en temps réel.

A lire > Les meilleurs jeux de stratégie (RTS) de l’histoire

Le VRR est donc né, sous l’impulsion d’AMD et de Nvidia, mais si les deux technologies arrivent à des résultats similaires, elles ont toutefois un fonctionnement bien différent avec une solution logicielle ouverte et accessible d’un côté et un système propriétaire matériel et fermé de l’autre.

AMD a en effet eu recours à un standard déjà existant sur le marché depuis 2009 : l’Adaptive Sync. Il s’agit d’une norme VESA qui, au départ, a été créée afin de réduire la fréquence d’affichage d’un écran dans un souci d’économie d’énergie. Il a suffi à AMD de rendre ses cartes graphiques Radeon compatibles avec ce standard et aussi bien supporté par les interfaces HDMI que DisplayPort, une technologie que l’on retrouve sous l’appellation FreeSync.

Nvidia a quant à lui opté pour une solution plus délicate et couteuse pour le consommateur au départ. L’équipe au caméléon a en effet choisi de passer par un module hardware qui doit impérativement être intégré à l’écran pour profiter du VRR avec les cartes graphiques du fabricant, et seulement supporté par l’interface DisplayPort. Nommé G-Sync, ce module sous licence demandait un investissement supplémentaire d’environ 30 % pour les joueurs par rapport à un écran classique certifié FreeSync. Nvidia a longtemps insisté sur le fait qu’une solution hardware permettait d’offrir un traitement plus qualitatif et performant, avant d’enfin s’ouvrir à l’Adaptive Sync en 2019, nous allons y revenir.

Il est vrai que le module G-Sync a souvent été vu comme supérieur à la solution logicielle d’AMD, notamment car il permettait de réduire le flou de mouvement (ghosting) tout en gérant beaucoup mieux les chutes de FPS. À ses débuts, le FreeSync supportait des plages de rafraichissement trop étroites, la V-Sync prenait alors le relai et il n’était alors pas rare que l’écran repasse à un taux de rafraichissement fixe. L’annonce du support de la technologie LFC (Low Frame Compensation) a néanmoins permis à AMD de proposer quelque chose de beaucoup plus qualitatif en gommant ces faiblesses.

Pour résumer, nous avions d’un côté une technologie propriétaire performante et couteuse pour laquelle Nvidia demandait toute une batterie de tests pour les écrans susceptibles d’intégrer le module G-Sync, par conséquent peu de références étaient disponibles et les tarifs limitaient forcément leur accessibilité. De l’autre une solution logicielle ouverte qui a peiné quelque temps avant d’offrir une véritable alternative au V-Sync, mais que l’on retrouvait sur beaucoup d’écrans à des tarifs tout à fait raisonnables.

Adaptive Sync : le dénouement

Heureusement, Nvidia n’en est pas resté là et a annoncé en 2019 l’adoption du standard VESA Adaptive Sync. Une aubaine et un soulagement pour beaucoup de joueurs puisqu’il allait désormais être possible de trouver un écran G-Sync Compatible à un tarif abordable, mais aussi et surtout profiter du G-Sync sur un écran FreeSync et vice-versa. Les nomenclatures ont également évolué avec le temps, avec trois certifications différentes d’un côté comme de l’autre.

A lire > Les meilleurs jeux de rôle (RPG et MMORPG) de tous les temps

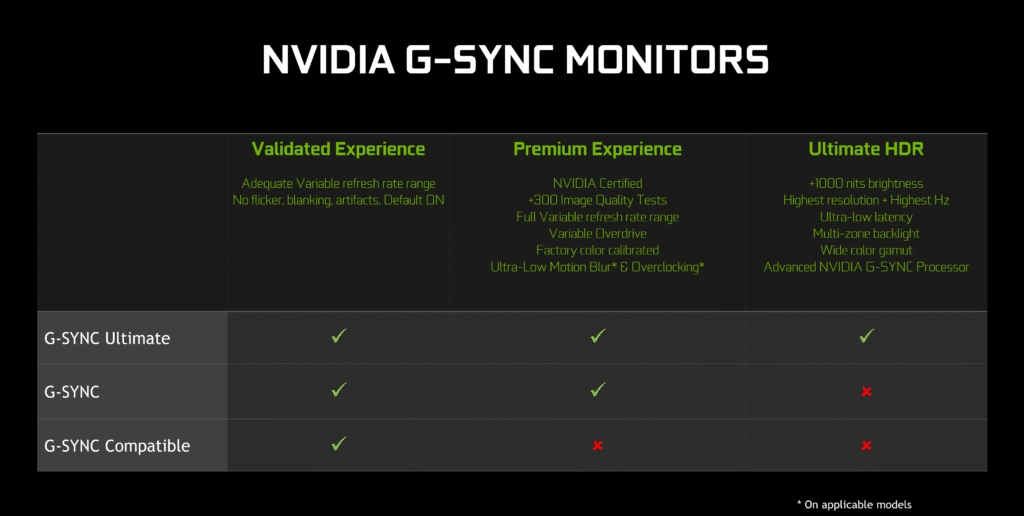

En bref, chez Nvidia l’appellation G-Sync Compatible regroupe des écrans sur lesquels VRR peut fonctionner via HDMI comme DisplayPort. C’est l’Adaptive Sync façon Nvidia. L’HDR n’est pas un prérequis, mais les écrans G-Sync Compatible doivent toutefois passer une série de tests afin d’obtenir la certification. Dans les faits le VRR fonctionne sur n’importe quel écran intégrant un port HDMI ou un DisplayPort suffisamment récent, simplement ils ne porteront pas la mention G-Sync Compatible si Nvidia n’a pas jugé leurs performances suffisantes pour l’obtenir.

Les écrans dotés des appellations G-Sync et G-Sync Ultimate, que l’on retrouve moins souvent, sont quant à eux équipés du processeur Nvidia. La catégorie Ultimate ajoute des critères d’exigences relativement élevés ; il s’agit en somme de moniteurs haut de gamme qui proposent un rendu certifié VESA Display HDR 1000, avec une dalle capable d’offrir une couverture colorimétrique élargie, une très faible latence, ou encore un rétroéclairage avec zones de gradation locale. Forcément, ces deux types d’écrans sont plus couteux puisqu’il intègre à leur tarif la licence Nvidia pour utiliser le module propriétaire.

Chez AMD, les critères de certifications sont plus souples, avec une plage VRR qui débute à 30 Hz, même pour le FreeSync Premium et Premium Pro, là où G-Sync et G-Sync Ultimate abaissent la plage VRR à partir de 1 Hz.

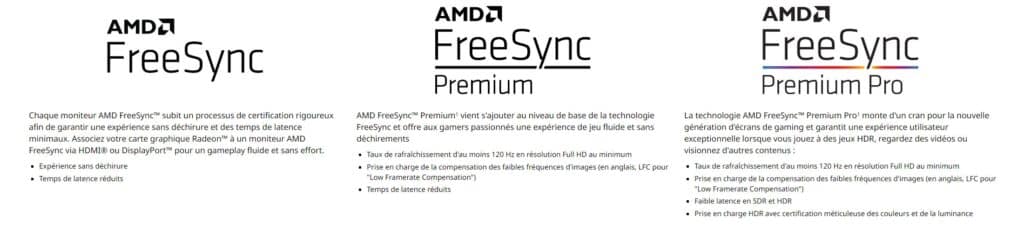

En bref, AMD demande simplement à ce que les écrans certifiés FreeSync assurent une latence minimale et un gameplay sans déchirure, mais le stuttering (les saccades) est toujours probable puisque cette certification ne rend pas obligatoire la présence de la technologie LFC. Par conséquent, les écrans FreeSync s’appuient toujours sur la V-Sync en dehors de leur plage VRR. Il faut passer au FreeSync Premium pour profiter du LFC, cette certification est par ailleurs présente sur des écrans HFR (High Frame Rate) avec un taux de rafraichissement d’au moins 120 Hz et une définition minimale en Full HD.

Le FreeSync Premium Pro est lui aussi moins exigeant, se contentant d’écrans certifiés VESA Display HDR 400, souvent trop léger pour profiter d’un rendu HDR digne de ce nom. Il ajoute, en plus des critères déjà cités, un input lag réduit aussi bien en SDR qu’avec les signaux HDR.

ELMB-Sync : insertion d’images noires et rafraichissement variable

Concomitamment au développement du G-Sync, Nvidia a également travaillé sur une technologie de réduction du flou de mouvement, nommé ULMB pour Ultra Low Motion Blur. Il est encore une fois question de synchronisation, mais cette fois-ci de l’extinction du rétroéclairage par rapport au taux de rafraichissement (fixe) de l’écran. L’idée derrière cette technologie est de tromper la persistance rétienne de l’œil humain afin de lutter contre la rémanence, autrement dit le flou de mouvement.

Hélas, cette technologie se voit relativement peu utilisée, pour cause : elle ne peut l’être conjointement au G-Sync. C’était du moins le cas avant que Nvidia ne propose sa certification G-Sync Compatible, reposant non plus sur un système hardware propriétaire, mais sur la norme Adaptive-Sync. Une aubaine pour Asus qui n’a pas tardé à présenter sa technologie ELMB-Sync (Extreme Low Motion Blur), qui permet de profiter du VRR grâce à l’Adaptative Sync (G-Sync Compatible ou FreeSync) tout en réduisant le flou de mouvement grâce au backlight strobbing, l’extinction et l’allumage du rétroéclairage au même rythme que la fréquence de rafraichissement de l’écran, variable pour le coup !

À l’heure actuelle, seul Asus s’est avancé à proposer une telle fonctionnalité, notamment grâce à une puce intégrée dans chaque écran et dédiée à cette tâche. Couplé à des taux de rafraichissement de plus en plus élevé et au VRR, les écrans ELMB-Sync parviennent à offrir aux compétiteurs un gameplay extrêmement fluide pour se rapprocher un peu plus de la victoire !

A lire > Les meilleurs FPS (jeux et franchises) de tous les temps

QMS VRR : quand Apple s’en mêle

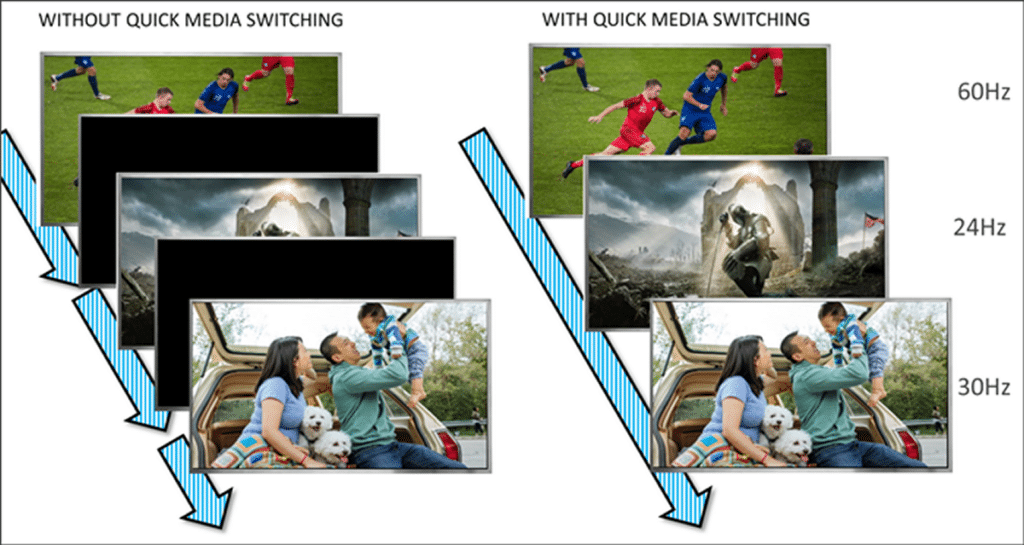

Dernier acronyme barbare en date, le QMS VRR pour Quick Media Switching Variable Refresh Rate. Pour faire simple, il s’agit d’une nouvelle fonctionnalité intégrée à l’Apple TV 4K 2022, le boitier multimédia du fabricant à la pomme. L’objectif du QMS VRR, disponible via l’interface HDMI 2.1, est d’éliminer les écrans noirs visibles lorsque l’on bascule entre deux contenus qui ne sont pas diffusés sur la même fréquence d’image, un comportement que l’on retrouve évidemment sur la plupart des téléviseurs, quand bien même certaines références gèrent mieux le passage d’un signal à 24 Hz à un signal à 60 Hz, par exemple.

Plusieurs cas de figure peuvent résulter sur un écran noir lors du basculement, notamment d’un changement de définition entre deux contenus, par exemple du Full HD à la 4K, ou le passage d’un signal SDR à un signal HDR. À l’heure actuelle, le QMS VRR est capable d’éliminer les écrans noirs lors d’un changement de fréquence de rafraichissement, tout simplement en forçant le recours à une fréquence variable plutôt que fixe.

En bref, il s’agit d’une fonctionnalité de confort qui ne supprime pour le moment pas tous les écrans noirs que l’on peut rencontrer, mais seulement ceux liés à un décalage entre la fréquence de rafraichissement de deux signaux différents. LG a d’ores et déjà annoncé que sa gamme de téléviseurs 2023 (ceux équipés en HDMI 2.1) est compatible avec le QMS VRR.

VRR et écrans : un choix moins complexe, toujours dépendant du budget

Comme nous l’avons vu au travers de cet article, le choix d’un écran de jeu s’avérait parfois compliqué avant 2019 et l’annonce de Nvidia de s’ouvrir au standard Adative-Sync. Avant cette date, la grande majorité des joueurs s’équipaient d’écrans certifiés FreeSync, alors même que bon nombre d’entre eux disposaient d’une carte graphique Nvidia GeForce. Les écrans G-Sync arrivaient sur le marché au compte-goutte, mais surtout avec des tarifs bien supérieurs aux moniteurs FreeSync. Une situation qui a sans doute profité à AMD pour écouler ses cartes graphiques Radeon prenant en charge le FreeSync sur un large panel d’écrans.

La situation est bien différente aujourd’hui, et forcément le choix d’un écran est beaucoup moins casse-tête qu’auparavant. Nvidia a en effet anticipé la sortie des consoles de nouvelles générations et l’arrivée de l’HDMI 2.1 qui permet de jouer en 4K à 120 Hz tout en ayant recours à l’HDR et au VRR. Acheter un écran G-Sync Compatible signifie aujourd’hui qu’il est possible de l’utiliser et profiter du VRR avec un PC équipé d’une Radeon comme d’une GeForce, ou d’une console de jeux. Cette nouvelle certification a également permis aux verts d’accoler leur nom à des téléviseurs 4K de nouvelle génération, chose qui n’aurait pas été possible sans l’Adaptive Sync.

Alors que le choix est devenu moins complexe pour le consommateur, et c’est tant mieux, il y a néanmoins toujours une certaine disparité sur le marché et parfois de l’incompréhension en raison des différentes nomenclatures chez AMD comme chez Nvidia. Ce qu’il faut retenir, c’est avant tout que Nvidia a souhaité conserver son système propriétaire pour des écrans qui doivent au préalable passer par une batterie de tests avant d’être certifiés G-Sync ou G-Sync Ultimate. Ces écrans sont toujours plus onéreux, mais le prix du module G-Sync et de la licence sont dilués dans des tarifs qui, même sans G-Sync, seraient tout de même très élevés. On parle en effet d’écrans haut de gamme, une poignée pour le G-Sync Ultimate avec des moniteurs MiniLED comme l’Acer Predator X32, et même des écrans OLED à l’instar du fameux Alienware AW3423DW qui a recours à la dalle QD-OLED développée par Samsung Display.

- À lire aussi : Guide d’achat : quel est le meilleur écran gamer du marché ?

Aujourd’hui la situation peut se résumer au petit adage « peu importe le flacon pourvu qu’on ait l’ivresse ». Les optimisations et les technologies en présence aussi bien du côté des écrans que des téléviseurs, également de celui des cartes graphiques que des consoles de jeu, débouchent sur un gameplay fluide quasiment en toutes circonstances. Il est intéressant de regarder l’implémentation du VRR avec un peu plus d’exigences lorsque les besoins sont plus élevés ; on pense bien sûr aux joueurs compétitifs qui ne lésineront pas sur les moyens pour se dégoter un écran G-Sync avec HFR et même, pourquoi pas, le Reflex Latency Analyser développé par Nvidia et intégré au module G-Sync. Pour les autres, les critères de qualité d’image revêtent une plus grande importance afin de renforcer et favoriser le sentiment d’immersion. Il est alors pertinent d’abord de scruter le type de dalle utilisé, son système de rétroéclairage (ou pas si vous optez pour de l’OLED), sa définition, et ses capacités en matière de rendu HDR. Quoiqu’il arrive, un tel écran sera au minimum certifié FreeSync Premium ou G-Sync s’il répond aux exigences de Nvidia.

“Qu’importe le flacon pourvu qu’on ait l’ivresse” n’est pas un adage, mais un vers de Baudelaire, bravo pour montrer l’étendue de votre ignorance.

Tiens, moi qui pensais qu’il s’agissait d’une formule d’Alfred de Musset … J’ignorais également qu’un vers, une formule, ou un proverbe ne pouvaient être des adages. La paille, la poutre, l’hôpital, la charité, bon weekend.

Merci, j’ai rigolu, du coup je ne modère pas et je laisse son message pour confirmer l’étendue de son ignorance 😀