NVIDIA vient de présenter officiellement sa nouvelle génération de GPU Blackwell devant alimenter les modèles d’intelligence artificielle. Selon l’entreprise, celle-ci représente une avancée significative, notamment en ce qui concerne la capacité de calcul et d’apprentissage des grands modèles de langage (LLM).

Les avancées dans le domaine de l’intelligence artificielle nécessitent une évolution de la technologie qui l’alimente. Pour qu’un LLM comme Chat GPT progresse ou soit plus performant, il a besoin de toujours plus de puissance de calcul.

Ces chatbots ont donc besoin de puces plus performantes. Heureusement, NVIDIA l’a bien compris et vient de présenter le successeur de son chipset H100. Celui-ci prend la forme de la nouvelle génération de GPU Blackwell.

Cette nouvelle architecture, déjà découverte suite à un vol des données de NVIDIA, serait selon l’entreprise les meilleures puces consacrées à l’IA. Toujours d’après le constructeur, cette génération pourrait offrir des performances cinq fois supérieures à celles des GPU Hopper H100.

C’est donc devant une assemblée d’une dizaine de milliers de personnes que NVIDIA a officiellement dévoilé la puce B200 ainsi que la “superpuce” GB200. Toutes deux conçues pour accélérer les calculs de l’intelligence artificielle.

Quelles améliorations sont apportées par le GPU B200 ?

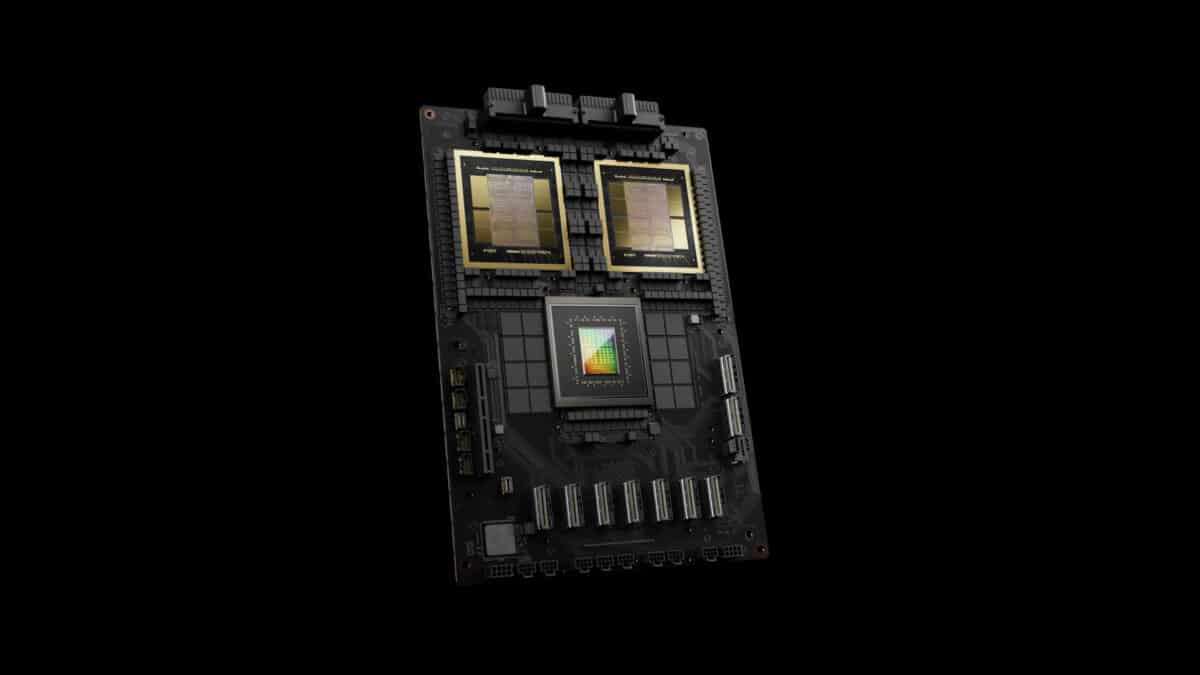

Les chipsets Blackwell devraient représenter une avancée significative, notamment grâce à leur conception. Par exemple, l’intégration du nœud de gravure TSMC N4P personnalisé devrait améliorer l’efficacité énergétique des puces. De plus elle devrait réduire la complexité du processus de gravure.

Le GPU B200 serait, d’après NVIDIA, 25 fois moins énergivore que la génération H100. À titre d’exemple, l’entreprise suggère que l’entraînement d’un LLM de 1,8 million de paramètres ne nécessiterait que 2000 GPU Blackwell et 4 mégawatts d’énergie contre 8000 Hopper et 15 mégawatts.

Encore selon NVIDIA, cette génération est la plus puissante actuellement et dispose d’améliorations technologiques lui permettant de surpasser la concurrence. Parmi elles, le constructeur évoque ses 208 milliards de transistors ainsi que l’utilisation de deux die GPU connectés entre eux à 10 To/s.

Cela permet, par exemple, aux puces B200 d’offrir 20 pétaflops de puissance FP4. La GB200, devrait permettre une augmentation des performances des calculs d’inférence jusqu’à 30 fois supérieures.

| NVIDIA B200 | NVIDIA H200 (SXM5) | NVIDIA H100 (SMX5) | NVIDIA H100 (PCIe) | |

|---|---|---|---|---|

| GPU | B200 | H200 (Hopper) | H100 (Hopper) | H100 (Hopper) |

| Nœud de gravure | 4nm | 4nm | 4nm | 4nm |

| Transistors | 208 milliards | 80 milliards | 80 milliards | 80 milliards |

| Interface mémoire | 8192-bit HBM4 | 5120-bit HBM3e | 5120-bit HBM3 | 5120-bit HBM2e |

| Taille de la mémoire | Jusqu’à 192 Go HBM3 @ 8.0 Go/s | Jusqu’à 141 Go HBM3e @ 6.5 Go/s | Jusqu’à 80 Go HBM3 @ 5.2 Go/s | Jusqu’à 94 Go HBM2e @ 5.1 Go/s |

| Puissance maximale | 700W | 700W | 700W | 350W |

L’IA va-t-elle progresser trop rapidement ?

Alors que le domaine de l’intelligence artificielle est en plein essor, l’apparition des GPU Blackwell devrait accélérer encore plus son évolution. Actuellement, l’IA est capable de prouesses impressionnantes, l’amélioration de leur capacité pourrait être inquiétante pour certains.

Cette nouvelle génération de puce est sans nul doute une belle avancée. Malheureusement, l’intelligence artificielle est un domaine encore mal maîtrisé. L’augmentation exponentielle de leur capacité pourrait amener à des dérives plus préoccupantes encore.

Entre les problèmes de propagande liés à l’IA et sa propension à créer du contenu hasardeux, l’augmentation de leur capacité de réflexion pourrait être à double tranchant. Les GPU Blackwell vont certainement permettre aux LLM de réfléchir et d’apprendre plus vite. Cependant, ils pourraient également accentuer les errances de cette technologie naissante.

- NVIDIA vient de présenter officiellement sa génération de GPU Blackwell dédiée à l’intelligence artificielle.

- L’entreprise a dévoilé les chipsets B200 et GB200, toutes deux censées représenter une amélioration des performances en IA.

- La puce B200 dispose de 208 milliards de transistors et devrait permettre des calculs d’inférence jusqu’à 30 fois supérieurs.

Huang cherche le moyen de transférer sa conscience dans un ordinateur, ces riches qui veulent devenir immortel en devenant des androides

La déshumanisation ultime de ces gens de toute façon déjà hors sol dans leur bulle spéculative qui vive grâce à un argent toujours plus décorélé du monde réel (ça spécule en bourse des bien imaginaire, des stock de matière première qui n existe basé sur des projections d extraction de minerais ou de culture de plante, élevage de bétail… Qui n ont pas encore eu lieu en niant le désastre climat et la surpopulation car bien sûr un humain n’est qu un client donc plus d humain pour eux = plus de clients… Pas un besoin de pouvoir les nourrir, les loger, …)