La GeForce RTX 4080 va-t-elle rester la reine de l’efficacité énergétique dans les jeux ?

Le 15 novembre dernier, AMD a mené son premier assaut frontal à l’encontre des GeForce RTX 4000 de NVIDIA. L’entreprise a orchestré son offensive sur divers fronts, notamment le format des cartes graphiques, l’alimentation, la connectique, etc. En revanche, elle s’est gardée de toute confrontation directe sur deux terrains pourtant clefs : les performances dans les jeux et la consommation. Comme l’a toutefois remarqué la rédaction de ComputeBaser, AMD avait visiblement envisagé d’inclure une première comparaison avec la NVIDIA GeForce RTX 4090 : une note de bas de page “RX-841” décrit les conditions de cette opposition, qui portait à l’évidence sur l’efficacité énergétique.

C’est un angle d’attaque apprécié par AMD pour la précédente génération. Au cours des derniers mois, des membres de l’entreprise ont souvent publié des tableaux comparant les rapports IPS / dollars mais aussi IPS / watts des Radeon RX 6000 et des GeForce RTX 3000. Fin octobre, la société en remettait une couche en affirmant que sa Radeon RX 6700 est jusqu’à 33 % plus efficace qu’une GeForce RTX 3060 Ti OC.

Des GeForce RTX 4000 à l’efficacité énergétique redoutable dans les jeux

La donne pourrait toutefois changer avec la génération actuelle de cartes graphiques. Avant l’officialisation des GeForce RTX 4000 et des Radeon RX 7000, AMD a communiqué à plusieurs reprises sur l’appétit accru de ses GPU RDNA 3, mais en dénonçant implicitement NVIDIA, accusée de se livrer à une surenchère de watts.

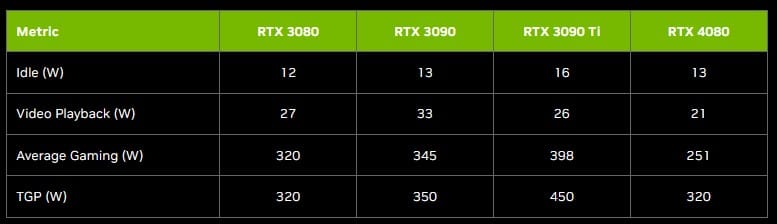

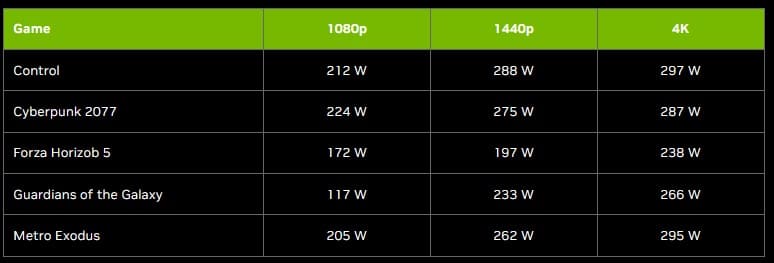

Qu’en est-il réellement ? Les GeForce RTX 4090 et RTX 4080 ont effectivement des TGP assez élevés, de respectivement 420 W et 320 W. Seulement dans les faits, dans les jeux, ces cartes graphiques consomment rarement autant. NVIDIA rapporte, dans un article A Deeper Look at Power Consumption: GeForce RTX 4080 Power Is About More Than TGP publié le 15 novembre, une valeur moyenne dans les jeux de 251 W pour la GeForce RTX 4080 par exemple (en 1440p) ; une consommation inférieure à celles des GeForce RTX 3080, GeForce RTX 3090 et GeForce RTX 3090 Ti à en croire l’entreprise, qui engloutissent respectivement, et en moyenne, 320 W, 345 W et 398 W, toujours d’après les mesures de NVIDIA.

Dans nos propres tests, nous avons mesuré une consommation moyenne de 321,3 W pour la GeForce RTX 4090 et de 252,8 W pour la GeForce RTX 4080 dans cette même définition. Concrètement, les GeForce RTX 4090 et RTX 4080 sont actuellement les championnes de l’efficacité énergétique, avec une avance confortable sur les cartes de précédente génération, en 1440p comme en 2160p.

Quid de l’efficacité énergétique des GPU RDNA 3 ?

Bien sûr, nous ne sommes pas vraiment inquiets pour AMD, dont les Radeon RX 6800 notamment excellent dans ce domaine. Nous nous attendons à ce que les GPU RDNA 3 soient aussi très efficaces et capables de rivaliser avec les GeForce RTX 4000 de NVIDIA sur ce plan.

Néanmoins, le retrait de cette diapositive signifie peut-être qu’AMD n’a pas jugé l’écart suffisant pour être mis en évidence. Ou alors, comme se plaît à le rappeler l’entreprise, ses Radeon RX 7900 XTX / XT se positionnant face à la GeForce RTX 4080 plutôt qu’à la GeForce RTX 4090, principalement pour des raisons budgétaires, ses équipes ont peut-être finalement jugé cette comparaison impertinente (au sens premier du terme).

Sources : ComputerBase, NVIDIA

Pourquoi nous pondre un nouveau connecteur si les cartes consomment moins que la génération précédente? Ils ont anticipé une grosse conso pour les fan de cryptomonnaie?

c’est parce que les cartes sont limités par le cpu dans les jeux que la conso n’est pas a fond.

Même pas, c’est surtout quelle sont complémentent sur dimensionnées dans les Jeux

Pour les éditeurs de jeux, le but c’est de vendre un maximum d’exemplaire de leur jeux, leur cible c’est pas du tout ce type de carte