Non, ce n’est pas une erreur de titre : dans une publication censée vous expliquer pourquoi il est temps d’acheter une Radeon, AMD saborde ses propres cartes graphiques RDNA 3. À croire qu’il est plutôt temps d’acheter une Radeon RX 6000 !

NVIDIA et AMD usent parfois de stratégies surprenantes pour vanter les performances de leurs cartes graphiques. Nous nous souvenons par exemple d’une diapositive de NVIDIA révélant à quel point la GeForce RTX 3050 surclasse les malheureuses GTX 1650 et 1050 en matière de ray tracing. Du côté d’AMD, la tactique de ces derniers mois consistait à démontrer la supériorité des Radeon RX 6000 sur les GeForce RTX 3000, en insistant sur les rapports prix / watt et prix / IPS exposés dans des tableaux Why Radeon. Désormais, avec les nouvelles générations Ada Lovelace et RDNA 3, AMD ne se risque plus à attaquer les GeForce RTX 4000 sur leur efficacité énergétique. De fait, les offensives d’AMD ciblant les cartes de NVIDIA sont plus timorées qu’autrefois. Et il semblerait que l’entreprise ait finalement décidé de s’en prendre à ses propres GPU…

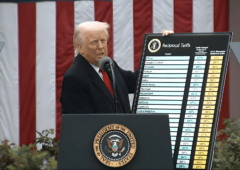

Dans un récent article de blog titré Never a Better Time to Upgrade with Radeon Graphics, AMD tente de nous convaincre de cette proposition. Avec une approche très étonnante : saboter ses Radeon RX 7000.

Le tableau de gauche met en évidence la supériorité des Radeon RX 7900 XTX / XT en 2160p en matière de fréquences d’images. Au passage, précisons qu’il y a peu de moniteurs UHD proposant une fréquence de rafraîchissement supérieure à 144 Hz. La véritable anomalie se trouve toutefois dans le tableau de droite. AMD met en évidence qu’en 1080p, les Radeon RX 7900 XTX et XT offrent les pires rapports prix / IPS. Alors certes, ces deux cartes graphiques ne ciblent pas cette définition, mais cette communication n’est clairement pas la plus habile.

More Power Tool ne supportera pas les GPU RDNA 3 des Radeon 7000

Les conditions de test

Précisons que les six jeux utilisés pour obtenir ces résultats sont Call of Duty: Modern Warfare 2, The Callisto Protocol, Grand Theft Auto V, Apex Legends, Valorant, et Overwatch 2. En outre, les Radeon RX 6700 XT et GPU supérieurs sont associés à un Ryzen 9 7900X ; les Radeon RX 6650 XT et GPU inférieurs à un Ryzen 5 7600X.

AMD promeut ses pilotes graphiques

Un autre terrain sur lequel NVIDIA et AMD se livrent souvent bataille est celui des pilotes graphiques et plus globalement de leur support logiciel. AMD avait déjà expliqué en quoi ses pilotes étaient meilleurs que ceux des concurrents en juillet dernier. Dans l’article, l’argumentaire n’a pas changé : l’entreprise met en avant des « tests rigoureux » englobant plus de 6000 configurations ou encore un taux de réussite de 100 % aux tests Microsoft WHQL en 2022 pour ses pilotes. Concernant les fonctionnalités, la société cite notamment la prise en charge de l’encodage AV1 pour ses GPU Radeon RX 7000 ou encore son AMD Noise Suppression, un logiciel de suppression du bruit.

Enfin, AMD revient aussi sur les améliorations des performances apportées par les pilotes dans les jeux ces derniers mois, en rappelant les 30 % de gains dans les titres DirectX 11, ou encore ceux obtenus sous OpenGL.

NVIDIA persiste et signe : en matière de pilotes graphiques, l’entreprise surclasse ses concurrents

Source : AMD

Combien êtes vous payé par nvidia ? En étant neutre a vous lire entre les news de l’un et de l’autre il est évident que des chèques sont perçu venant des verts.

Vous pouvez nous faire un beau scoop sur nvidia et leur câble qui fondent 4080 comprise et bien enfoncé.

Car les dernières news c’est la faute aux utilisateurs qui les enfoncent mal mai sont quand même pris en garantie.

Heureusement que la plupart des gens on un brin de réflexion, a bon entendeur.

Bonjour,

Tout d’abord, cet article se base uniquement sur des données communiquées par AMD, et relate une grosse maladresse de la part de l’entreprise.

Ensuite, concernant votre accusation de dépréciation d’AMD, je vous invite simplement à lire nos dernières actus traitant des produits de la société : une concluant que la Radeon Pro V420 aurait certainement fait une excellente carte graphique, une relayant l’offre promotionnelle sur les Ryzen 7000, une vantant la supériorité de l’EPYC 9564 sur ses concurrents ou encore une mettant en avant les performances de l’Instinct MI250X par rapport à la NVIDIA A100. Il me semble qu’il y a pire comme parti pris 😉

Enfin, à propos de la fonte des adaptateurs et des problèmes de surchauffe des Radeon RX 7900 XTX auxquels vous faites peut-être implicitement référence, nous avons souligné dans le premier cas que les industriels devaient en toute circonstance s’assurer qu’ils commercialisent des produits sans risque pour le consommateur, et avons également consacré un article à une plainte déposée contre NVIDIA ; dans le second, que la faute n’incombait pas à AMD.

Il parle surtout de la fonte des cables moddés de cablemod.. un cable gainé avec une sécurité qui se clipse en faisant un bruit donc aucune chance de “mal l’enfoncé”

Lien random: https://www.generation-nt.com/actualites/rtx-40-cable-12vhpwr-fond-2032698

Là c’est clairement une malfaçon dangereuse coutant 2000€ et plus..

Donc à mon avis il veut que vous vous bougiez pour “enquêter” là-dessus vu que vous devez avoir des contacts non ?

Et pour ce qui est d’AMD vs Nvidia personnellement je règle le problème par nvidia = gagnant et AMD = gagnant et acheteur = perdant + pigeon en 2022 / 2023

C’est l’égalité la plus probable à mon avis et c’est frustrant vu que l’on ne peut rien y faire :/

Pour amd ce n’est pas une maladresse. C’est surtout le rapport perf/puissance/ et Energie vis a vis de la concurrence qu’il visait. Faite la même chose entre les cartes Nvidia de cette gen et de l’ancienne on aura plus ou moins la même chose. Pour moi ce n’est pas une maladresse quand on vise la concurrence new gen vs new gen. La le sujet relevé et d’un autre contexte sa reste interne a leurs propres cartes.

Je pense qu’on est d’accord la dessus ?

il n’y pas photo c’est plus intéressant cette année d’allez chez les rouges. Personnellement sa fait depuis la 9800 pro ATI que j’ai basculé chez nvidia. Je ne suis pro personne. J’achète ce qui se fait de plus intéressant sur le moment. Sur le moment sa reste ATI, amd excusez moi ( nostalgie ).

Pour les chambres a vapeur cela relève malheureusement d’un défaut de la chaine de production, même si sa ne devrais pas arriver concernant les rouges ou autre.

Pour les verts, je suis de métier électrotechnicien. Et le phénomène que vous avez c’est un sous dimensionnement du câble. Le point de chauffe concerné c’est bien un sous dimensionnement du câble, c’est un effet joule extrêmes, important sur les connectiques, cosses. La on ne parle plus du même problème de défaut de conception en chaine de production, mai d’un défaut de sous dimensionnement en ingénieries. Problème perpétuel !

Le problème de ce connecteur avec les puissances sous tiré et une bombe a retardement ce n’est que le début. Autour de moi 3 qui ont fondus, la garantie fonctionne vous savez pourquoi ? Parce ce que ce n’est pas la faute aux utilisateurs. On vous renvoie la même carte, le problème resurgira tôt ou tard.

Mon problème avec tout sa, c’est qu’on trompe l’utilisateur en lui rejetant la faute alors que le problème et bien plus grave. 2300 balle pour une 4090 je peu me la payer sans faire un 10 fois sans frais hein, mai je suis pas assez bête pour acheter sa avec ces problèmes la et a se prix la ! Alors que vous avez la 7900xtx qui fait 1000 balle de moins avec des perf un petit en dessous de la 4090 et consommant me semble t’il un poil moins.

Si j’ai tord, j’attend vos avis 🙂

Les spécifications PCI-SIG définissent que chaque broche peut gérer jusqu’à 9,2 A, ce qui signifie un total de 55,2 A à 12 V. Cela donne une puissance maximale théorique de 662 W.

9,2A par broche semble réalisable avec des sections de fils AWG20 ou 21 (0,5mm2).

Le soucis est comment garantir l’équilibrage de charge de chaqu’une des broche à tout moment ?

La moindre hausse de résistance au niveau du connecteur et les électrons iront tout seuls vers le passage le moins résistant avec un risque de dépasser la limite acceptable par le câble.

Ce connecteur devrait être retiré du marché immédiatement par simple principe de précaution car un jour ou l’autre un incendie sera déclenché.

Ils auraient dû plutôt utiliser un gros connecteur compatible 60A, ou alors passer à une alim 36V par exemple et ainsi réduire les A.

“Pour amd ce n’est pas une maladresse. C’est surtout le rapport perf/puissance/ et Energie vis a vis de la concurrence qu’il visait.” D’accord ; dans ce cas, pourquoi ne pas inclure les résultats de la concurrence ? D’autant plus qu’ils ont déjà des données pour les RTX 3000 / RX 6000.

C’est une énorme maladresse de communication, n’en déplaise aux fanboys de la marque.

Les RX 7900 XT et XTX, on le meilleur rapport prix/FPS, comparé au 4000 NVIDIA.

La majorité des youtubeurs on fait des vidéos test sur le sujet !

Vôtre article est mensonges total.

Pot de vins assuré comme j’ai vue dans un commentaire.

[Edit de la modération : insultes retirées, ça serait dommage de tomber sous le coup de l’article 33 de la Loi du 29 juillet 1881 sur la liberté de la presse…]

“Les RX 7900 XT et XTX, on le meilleur rapport prix/FPS, comparé au 4000 NVIDIA” ; probablement, je ne prétends pas le contraire dans l’actu (je plaide coupable pour le titre, j’aurais dû écrire “AMD démontre que ses Radeon RX 7900 XTX et XT ont un rapport prix / IPS inférieur aux Radeon RX 6000, dans six jeux, en 1080p, lorsqu’elles sont associées à un Ryzen 9 et d’autres cartes à un Ryzen 5”) ; enfin, rien n’empêchait AMD d’inclure les GeForce RTX 4000 à sa comparaison.

J’imagine qu’amd a envie d’écouler les stocks de ses anciens gpu avant d’être obligé à réellement les brader…nvidia préfère attendre sans rien dire, mais ils seront bien obligés de les brader aussi sous la pression des actionnaires qui vont finir par leur rappeler que le but du jeux, c’est de les vendre leurs anciennes cartes, pas d’en faire une collec…

Plus le niveau de performances est élevé, plus le ratio performance/prix diminue, c’est aussi observable sur les CPU Intel ou les GPU nVidia: rien que de très normal en fait!