Disponibles depuis le 18 novembre, les Radeon RX 6800 et 6800XT introduisent l’architecture RDNA2 dans le monde PC, après avoir alimenté les consoles next-gen, la PS5 et la Xbox Series X. En particulier, ce sont les premières cartes d’AMD à prendre en charge l’accélération matérielle du ray tracing. Que valent-elles face à la récente génération Ampere de Nvidia ?

À moins de vivre dans une grotte, vous le savez : ça y est, les cartes sont définitivement rebattues. Courant septembre, Nvidia a présenté sa nouvelle génération de cartes graphiques GeForce Ampere, à travers des RTX 3080, 3090 et 3070 qui hissent d’un ou deux rangs les performances de la gamme précédente, tout en redynamisant les rendus en ray-tracing et les calculs parallèles. Et de l’autre, AMD avance ses Radeon RX 6800 Series, qui introduisent l’architecture RDNA2 (alias “Big Navi”). Figurant déjà dans la partie graphique de l’APU qui équipe les PS5 et Xbox Series X/S, elle soutient en particulier, pour la première fois dans l’arsenal du constructeur, l’accélération matérielle du ray tracing.

C’est désormais sur PC qu’AMD avance ses armes, dans une sortie globale visant à préparer le monde du jeu vidéo à une nouvelle phase, qui plébiscite les rendus en Ultra Haute Définition à une haute fréquence d’affichage, à grands renforts de FPS et d’effets visuels avancés. Et une chose est sûre, quelle que soit l’écurie sur laquelle vous miserez en cette fin 2020 : jamais nos jeux n’auront promis d’être aussi beaux, fluides et riches sur le plan visuel. Plus que jamais, la balle est dans le camp des développeurs pour tirer parti de cette puissance nouvelle acquise, sur PC ou dans l’écosystème des consoles.

Le 18 novembre, AMD lève le voile sur les deux premiers modèles de cette nouvelle gamme : les Radeon RX 6800 (590 €) et RX 6800 XT (660 €). Il faudra attendre le 8 décembre prochain pour enficher dans nos boîtiers les dizaines de milliards de transistors du plus puissant rejeton promis de la famille, la Radeon RX 6900 XT. Nous y reviendrons en temps voulu.

| Radeon RX 6800 | Radeon RX 6800 XT | Radeon RX 6900 XT | |

|---|---|---|---|

| Compute Units | 60 | 72 | 80 |

| Fréquence (base/game) | 1815 MHz | 2015 MHz | 2015 MHz |

| Fréquence (boost) | 2015 MHz | 2250 MHz | 2250 MHz |

| Infinity Cache | 128 Mo | 128 Mo | 128 Mo |

| Mémoire | 16 Go GDDR6 (16 Gbps) | 16 Go GDDR6 (16 Gbps) | 16 Go GDDR6 (16 Gbps) |

| TBP | 250 W | 300 W | 300 W |

| Date de lancement | 18 novembre 2020 | 18 novembre 2020 | 8 décembre 2020 |

| Prix | 590 € | 660 € | NC |

RDNA2 : Ray Accelerator, Infinity Cache et Smart Access Memory

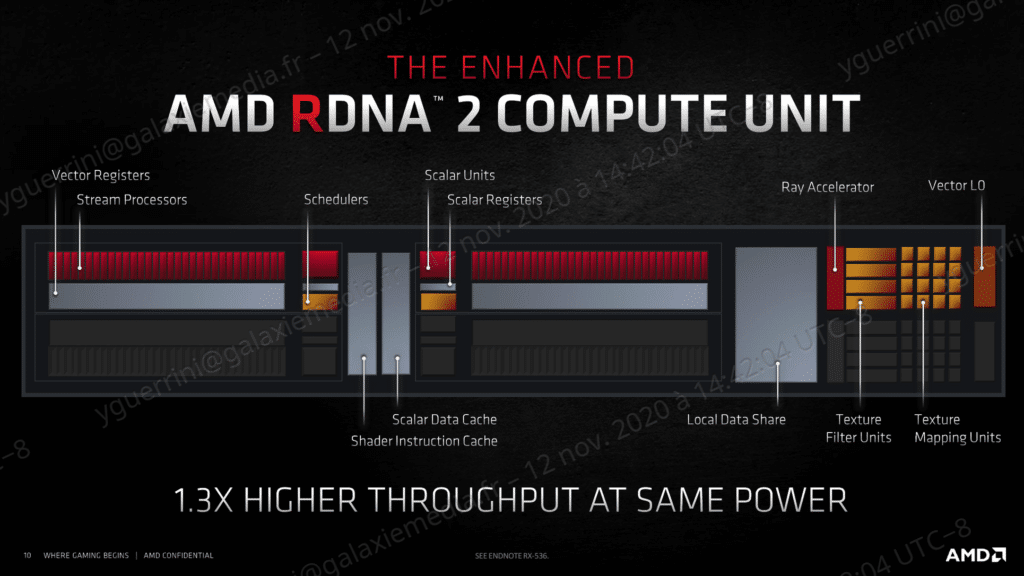

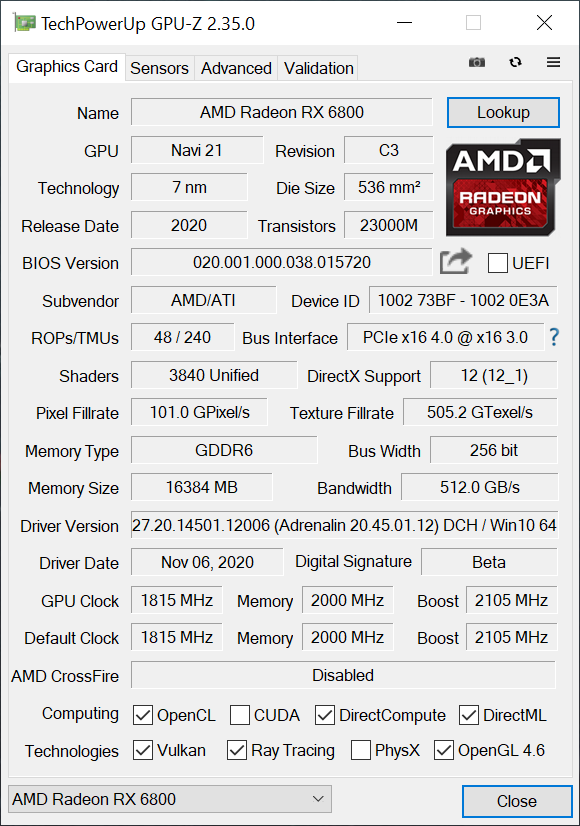

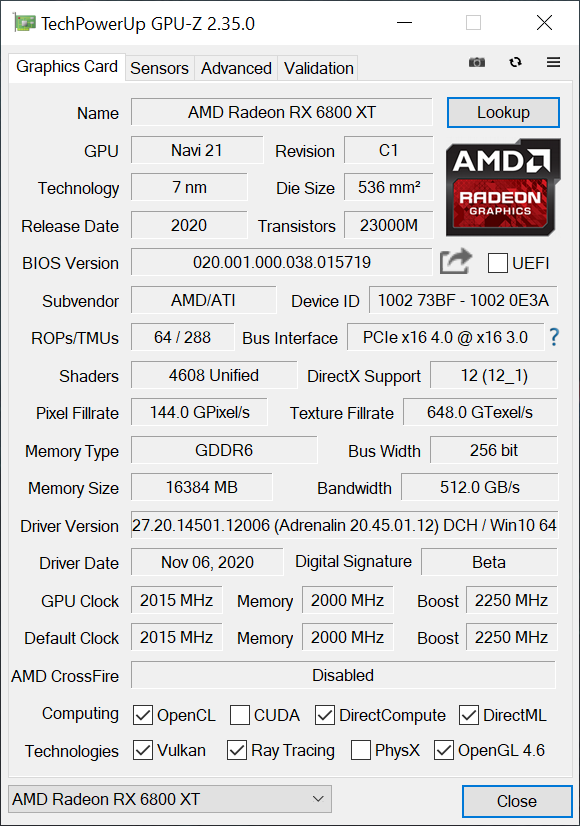

Toujours gravé en 7 nm, le GPU des nouvelles Radeon bénéficie tout de même de son lot d’innovations, directement glanées du travail du constructeur sur ses récents processeurs Ryzen. S’il ne gagne donc pas en finesse, il soutiendrait toutefois des performances 1,3 fois supérieures, à consommation électrique équivalente, par rapport à la génération précédente des Radeon RX 5000, à en croire le constructeur.

À l’image des modules CCX de Nvidia, la puce graphique du modèle le plus complet des Radeon RX 6000 Series comprend le plus grand nombre d’unités de calcul, “bridé” dans les déclinaisons qui nous intéressent aujourd’hui. Ainsi, la Radeon RX 6900 XT embarque quatre shader engines, avec 10 double unités de calcul chacun – soit 80 unités de calcul (CU) au total, et 5120 Stream Processors. Les Radeon RX 6800 et RX 6800 XT se contenteront, respectivement, de 60 et 72 CU, avec 3840 et 4608 Stream Processors.

Sur chaque unité de calcul, on retrouve une unité d’accélération matérielle dédiée au ray tracing, le Ray Accelerator. Capable de traiter individuellement quatre intersections ray/box ou une intersection ray/triangle par cycle, elle offrirait des performances dix fois plus élevées qu’un calcul logiciel classique, selon AMD. C’est l’équivalent des RT Core de Nvidia, qui signent déjà leur seconde implémentation, dans la génération Ampere.

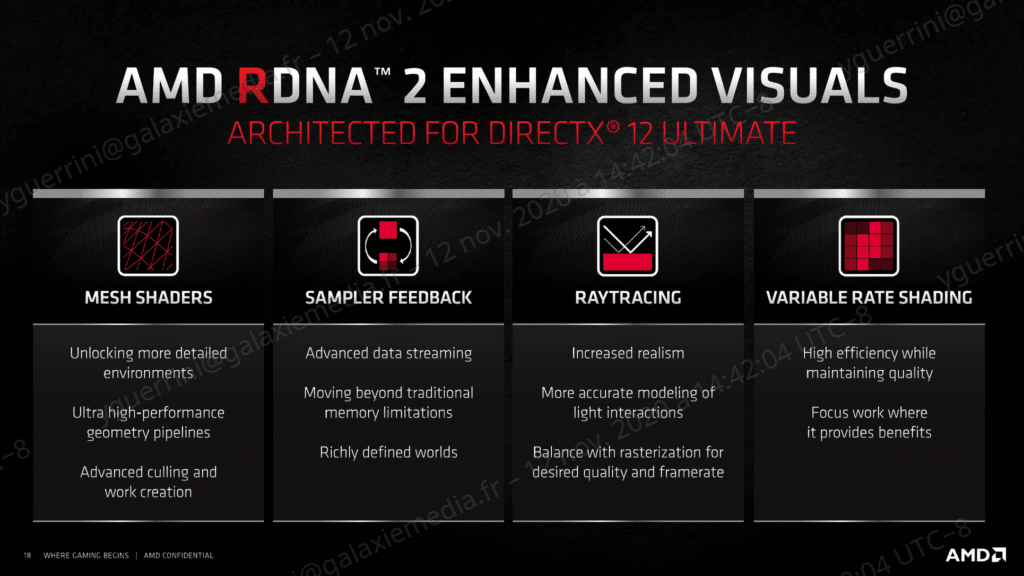

La compatibilité avec DirectX 12 Ultimate est évidemment de la partie, avec ses quatre fonctionnalités de base : les Mesh Shaders, le Sampler Feedback, le Variable Rate Shading et, donc, le Ray Tracing. À la clé ? Une plus grande efficacité dans le calcul des rendus tout en tirant la qualité vers le haut, et globalement une meilleure gestion des échanges de données au sein du GPU.

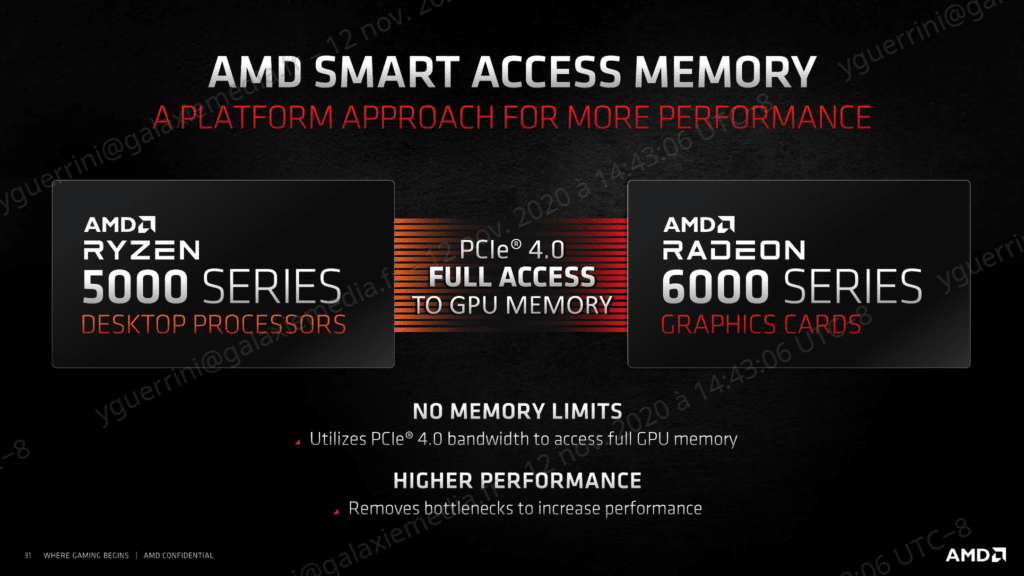

Ce transfert des données est, du reste, au centre de nouveaux enjeux. Les Radeon RX 6000 Series introduisent ainsi la technologie Smart Access Memory (SAM), une amélioration de l’accès à la mémoire graphique par le processeur central. Concrètement, il s’agit de redimensionner l’adressage des ressources, à travers l’exploitation d’une caractéristique du standard PCI-Express. Le canal CPU-GPU peut ainsi accéder directement à la totalité de la mémoire graphique, sans passer par des solutions logicielles et sans se heurter à la limite précédente de 256 Mo. Attention toutefois : pour l’heure, cette fonctionnalité sera limitée aux seuls chipsets 500 Series avec des processeurs Ryzen 5000. Nvidia a d’ores et déjà répondu dans la foulée, promettant de plus grandes largesses et une meilleure universalité : un procédé identique serait accessible aux GeForce RTX 3000 avec les CPU Intel comme AMD, y compris via PCIe 3.0. Retenez toutefois qu’en l’état, AMD promeut son écosystème dernier cri, avec un bonus qu’il estime de 11% pour les possesseurs d’un CPU Ryzen et d’un GPU Radeon, tous deux de dernière génération.

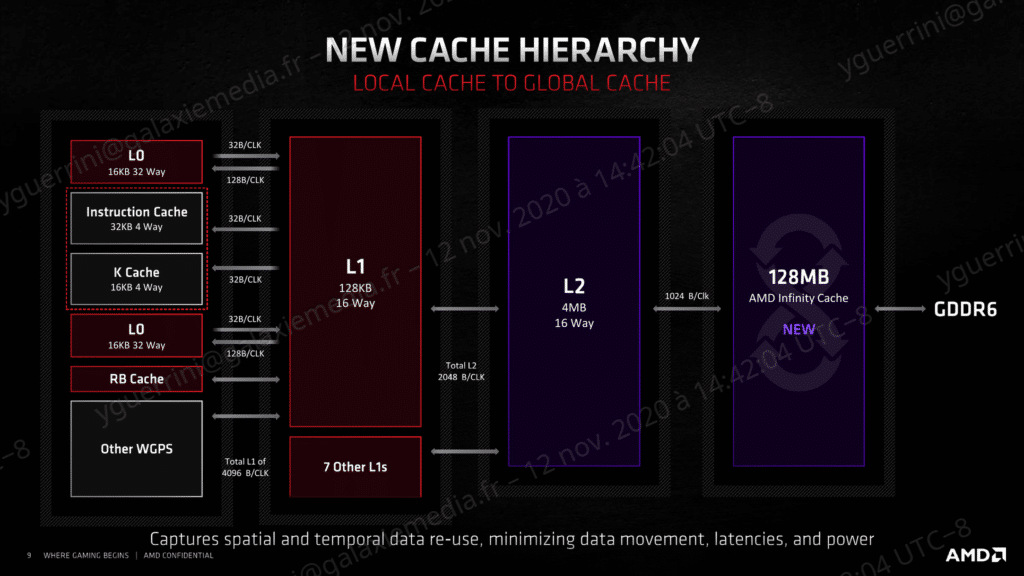

L’autre nouveauté majeure de l’architecture RDNA2 tient à la gestion des caches mémoires. Pour chaque unité de calcul, AMD préserve les 32 Ko de cache réservées aux instructions, les 16 Ko de cache pour les données et le cache L0 de 16 Ko, comme sur l’architecture RDNA précédente. La gestion des caches L1 et L2 demeure elle aussi inchangée. On retrouve ainsi deux groupes de 128 Ko pour chaque shader engine, soit un total de 1 Mo de cache L1 et de 4 Mo de cache L2 par GPU.

En revanche, le constructeur introduit un quatrième niveau de cache baptisé Infinity Cache. 128 Mo de mémoire supplémentaire sont ainsi proposés, et devraient trouver un retentissement pertinent dans la gestion du ray tracing, en particulier.

Le choix d’un design tri-axial

Exit le système de refroidissement de type « blower » des Radeon RX 5700 et RX 5700 XT : avec les Radeon RX 6800 et RX 6800 XT, AMD revient à un dissipateur à air autour d’un design tri-axial. Pour justifier son choix, le constructeur met notamment en avant des nuisances sonores revues à la baisse par rapport à la génération précédente, avec même l’arrêt des trois ventilateurs lorsque la charge GPU se réduit. Si c’est résolument une bonne nouvelle, il faudra toutefois prévoir une bonne circulation de l’air au sein du boîtier, pour ne pas voir les cartes s’échauffer prématurément.

Du côté des dimensions, AMD évolue là aussi dans des gabarits plus classiques. Les Radeon RX 6800 et RX 6800 XT mesurent 267 mm de long et 120 mm de large, en occupant respectivement 2 slots et 2,5 slots d’extension. Pourtant (futur) fer de lance de la gamme, la Radeon RX 6900 XT devrait elle aussi emprunter ces mêmes dimensions. Les cartes sont donc plus courtes que les GeForce RTX 3090 (313 mm) et RTX 3080 (285 mm), même si ces dernières sont aussi plus étroites (112 mm).

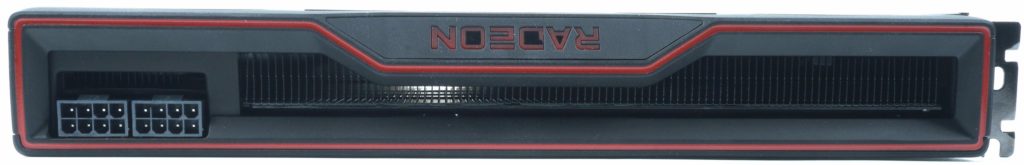

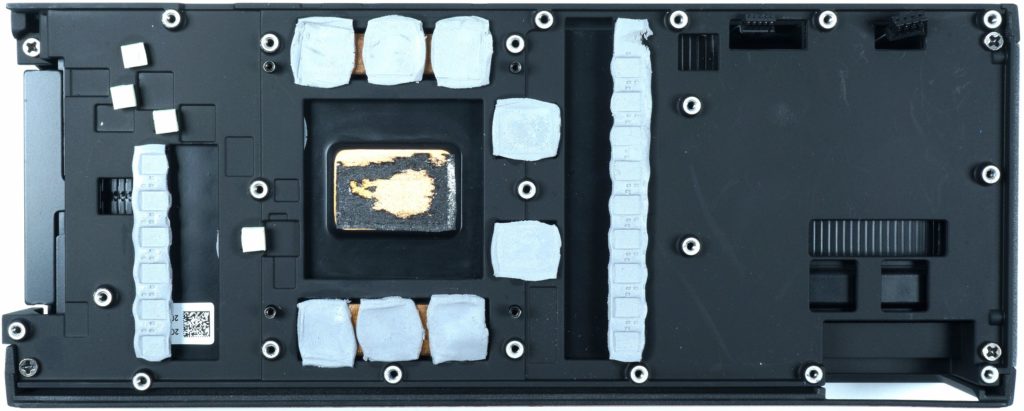

Le radiateur est en contact direct avec le chipset graphique et les huit puces de mémoire GDDR6, ainsi qu’avec les différents composants de l’étage d’alimentation à l’aide de pads thermiques. Avec un TBP respectif de 250 watts et 300 watts pour les Radeon RX 6800 et RX 6800 XT, les deux cartes disposent de deux connecteurs d’alimentation 8 broches. Ils sont positionnés en bout de carte, contrairement aux modèles de Nvidia qui les place au milieu – les plus méticuleux aficionados du cable management pousseront un ouf de soulagement.

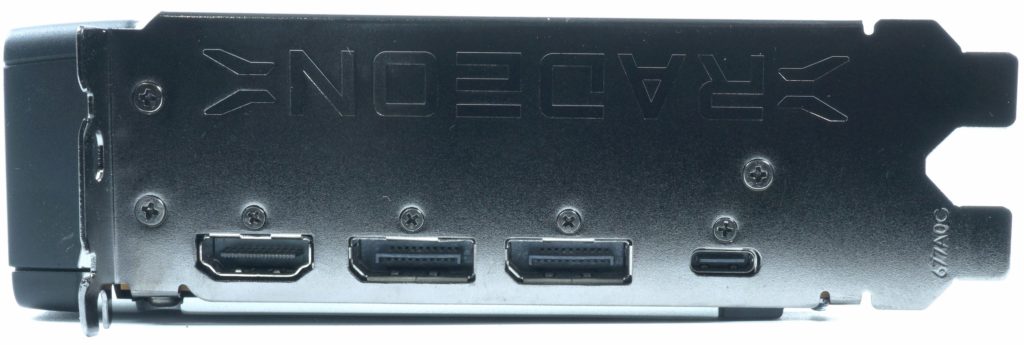

Du côté de la connectique, on retrouve le même lot de ports sur les deux modèles : un port HDMI 2.1 avec VRR et FRL (compatible 8K à 120 Hz), deux connecteurs DisplayPort 1.4 et un port USB Type-C avec Power Delivery pour l’affichage sur les moniteurs compatibles. Contrairement aux modèles de Nvidia, les sorties sont directement incrustées dans la plaque de métal sans grille ni alvéoles – l’air chaud ne s’expulse donc pas du boîtier par son biais.

Les performances à la loupe

Comme pour nos tests des GeForce RTX Ampere, nous avons mesuré les performances des Radeon RX 6800 et RX 6800 XT en partenariat avec Igor Wallossek, du site Igor’s Lab. Pour tester en particulier l’apport de la technologie SAM, la plate-forme de référence s’articule autour d’un processeur AMD Ryzen 9 5900X, couplé à une carte mère MSI MEG X570 Godlike, avec deux barrettes de 16 Go de mémoire DDR4-4000 Corsair Vengeance RGB Pro (CL18-22-22-42), un SSD Gigabyte Aorus NVMe Gen4 de 2 To, un second SSD Toshiba R500 de 1 To et une alimentation Be Quiet! Dark Power Pro 12 1200 W, dans un boîtier Raijintek Paean. Du côté du refroidissement, nous avons fait appel à un système de watercooling composé d’un Alphacool Eisworlf et d’un Eisblock XPX Pro.

Notre panel de test viendra évidemment opposer les Radeon RX 6800 et RX 6800 XT aux récentes GeForce RTX 3070, RTX 3080 et RTX 3090, mais aussi à des cartes issues de la génération précédente d’AMD, à savoir les Radeon VII et Radeon RX 5700XT. Nous testons les deux nouvelles Radeon RX 6000 Series avec et sans la technologie SAM, afin d’en mesurer l’impact, sur dix jeux récents : six en DirectX 12, un en DirectX 11 et trois reposant sur l’API Vulkan. Les tests ont été réalisés dans les définitions WQHD et UHD, avec les réglages les plus élevés possibles.

Il est possible que les graphiques ci-dessous n’apparaissent pas si vous visitez la version AMP de cette page. Si tel est le cas, nous vous invitons à recharger la page.

En QHD et en rasterization pure, la Radeon RX 6800 (590 €) est en moyenne 6% plus performante que la GeForce RTX 3070 Founders Edition (519 €). Avec la technologie SAM activée, on gagne encore quelques FPS en moyenne et l’écart s’établit à 11% environ. Dans la même définition, la Radeon RX 6800 XT (660 €) tutoie les performances de la GeForce RTX 3080 Founders Edition (719 €) et cède 2% de terrain en moyenne. Mais avec SAM activé, le boost est plus conséquent et la nouvelle carte d’AMD ravit la seconde place du classement : elle est 8% inférieure à la GeForce RTX 3090 Founders Edition (1549 €) et dépasse cette fois la RTX 3080 de 2% environ.

De bons résultats, qui se confirment lorsque l’on monte en définition. En UHD, avec ou sans SAM, la Radeon RX 6800 dépasse même plus franchement la GeForce RTX 3070 (+8% sans, +11% avec). Un bénéfice qui profite toutefois un peu moins à la Radeon RX 6800 XT, ici systématiquement derrière la GeForce RTX 3080 : dans cette définition, elle présente des performances inférieures de 5% sans SAM, et de 2% avec la fonctionnalité activée.

Les performances en Full HD et ray tracing

Mais l’autre atout des nouvelles Radeon RX 6000 tient à l’accélération matérielle du ray tracing, une nouveauté du côté d’AMD tandis que le procédé connaît ici sa seconde implémentation chez Nvidia. Pour tester le rendu, nous avons fait tourner trois jeux compatibles DXR : Control, Metro Exodus et Watch Dogs Legion. Les performances sont ici mesurées en Full HD, avec les réglages graphique en Ultra.

Et à ce petit jeu, les dernières Radeon RX 6000 ont encore du retard à rattraper. Avec ou sans SAM activé, elles cèdent considérablement du terrain face à l’offre Nvidia. La Radeon RX 6800 XT est ainsi 17% à 22% inférieure à la GeForce RTX 3080 FE (respectivement, avec et sans SAM). Avec cette technologie activée, elle se montre toutefois 7% plus efficace que la RTX 3070, une carte qui ne joue pas directement dans les mêmes eaux tarifaires.

Même constat avec la Radeon RX 6800 : elle affiche ainsi des performances 5% à 13% inférieures à celles de la GeForce RTX 3070 FE, en fonction de l’activation ou non de la technologie SAM.

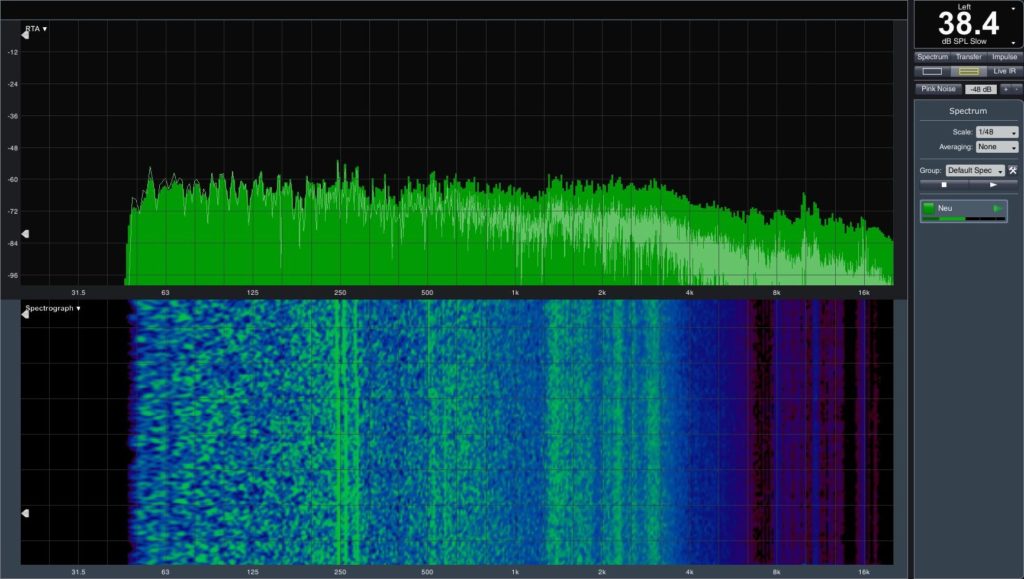

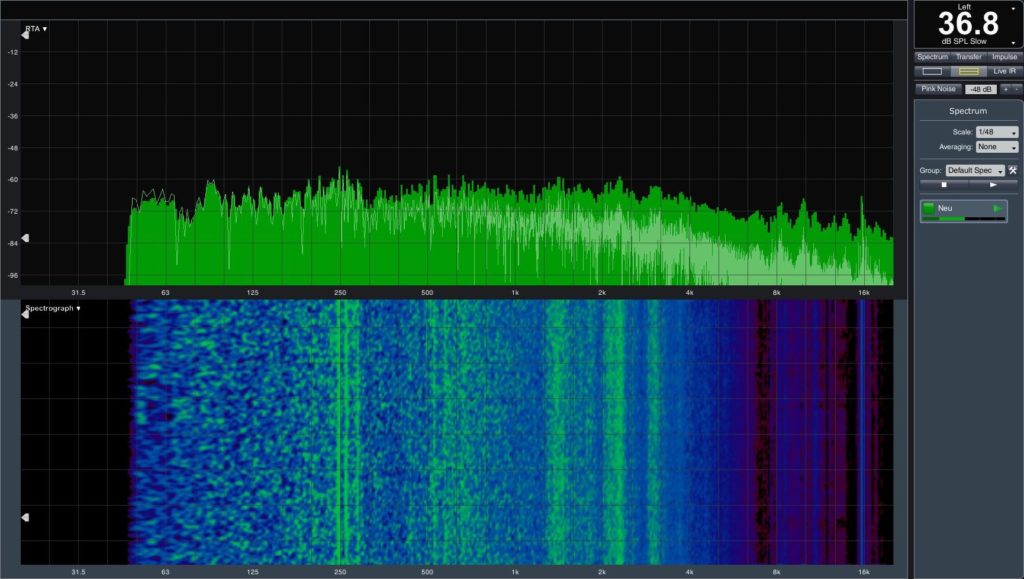

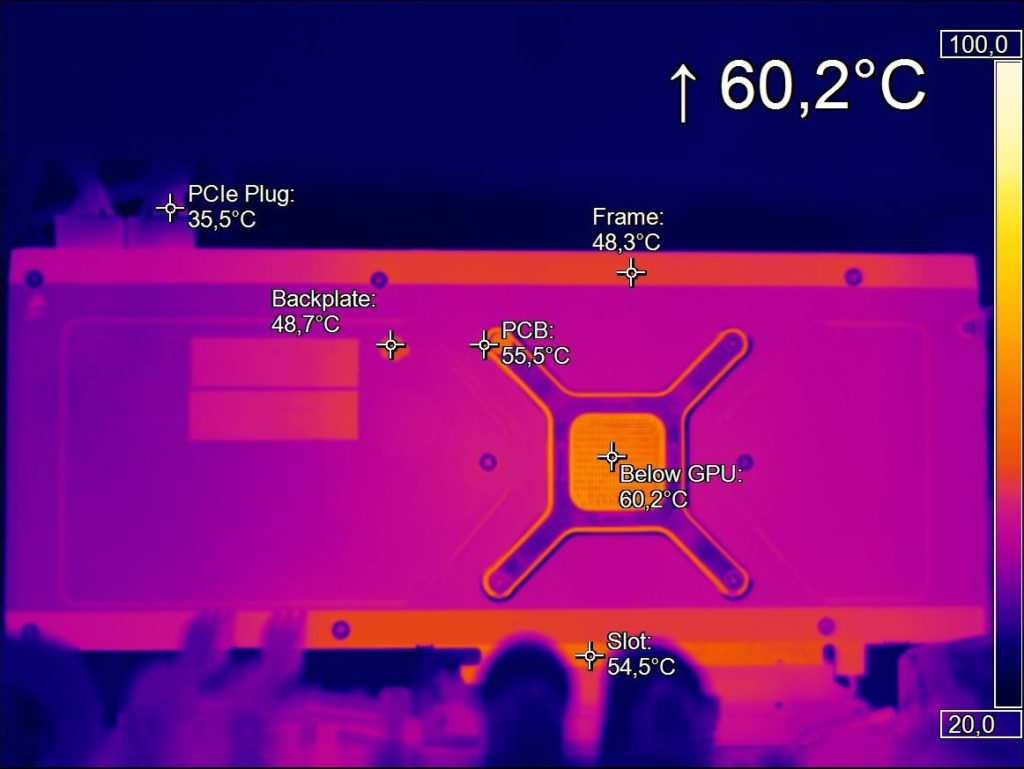

La chauffe et les nuisances sonores

Nous avons relevé les nuisances sonores en laboratoire, lors d’une session avec The Witcher 3 en UHD. Les résultats sont plutôt satisfaisants : 38,4 dB(A) pour la RX 6800 contre 36,8 dB(A) pour la RX 6800 XT. C’est nettement mieux qu’une GeForce RTX 2080 Ti de génération précédente (41,9 dB(A)), et au niveau de la GeForce RTX 3080 (38,8 dB(A)). Mais dans la génération Ampere de Nvidia, la RTX 3070 détient toujours le record en matière de silence : 34,5 dB(A) dans les mêmes conditions.

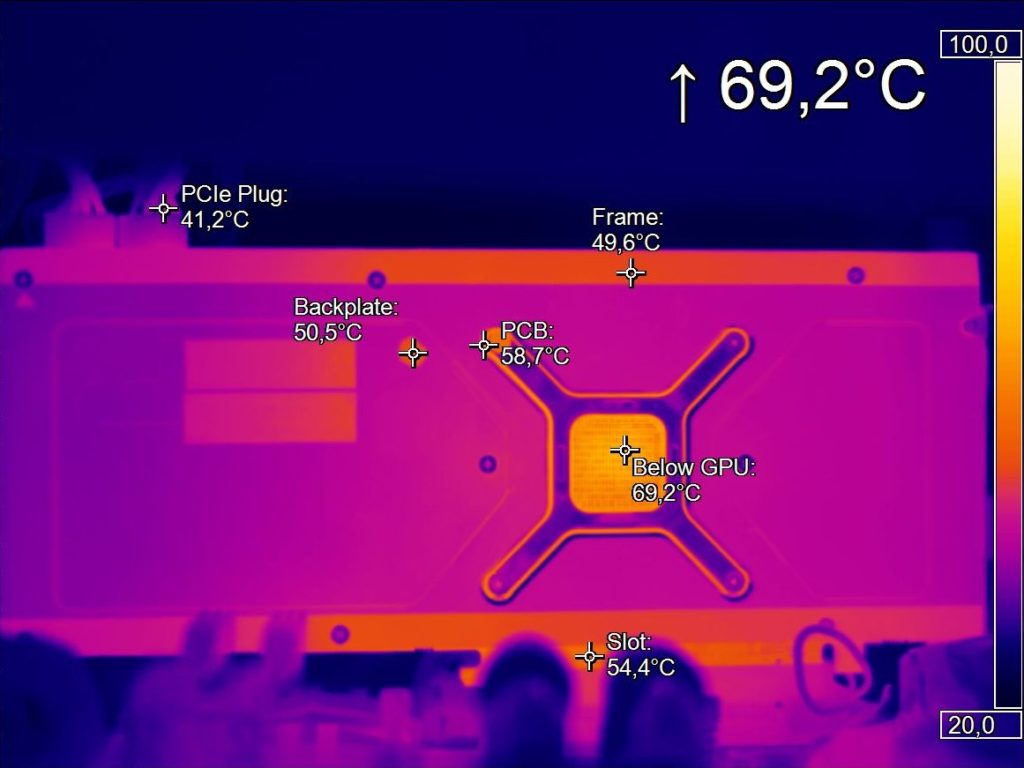

Du côté de la température, on évolue là aussi dans des eaux très raisonnables : toujours sous The Witcher 3 en UHD, le GPU de la RX 6800 XT monte à 69°C et celui de la RX 6800 à 60°C. Dans les mêmes conditions, on avait relevé 70°C avec la RTX 3080 et 66° pour la RTX 3070.

La consommation et l’efficacité énergétique

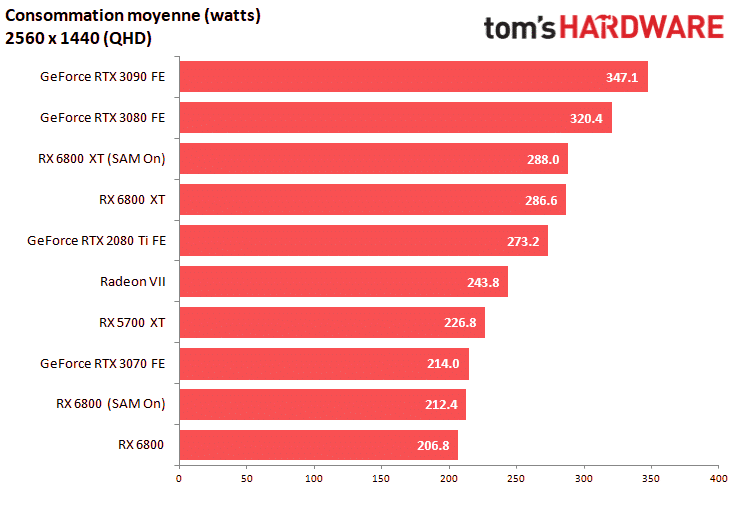

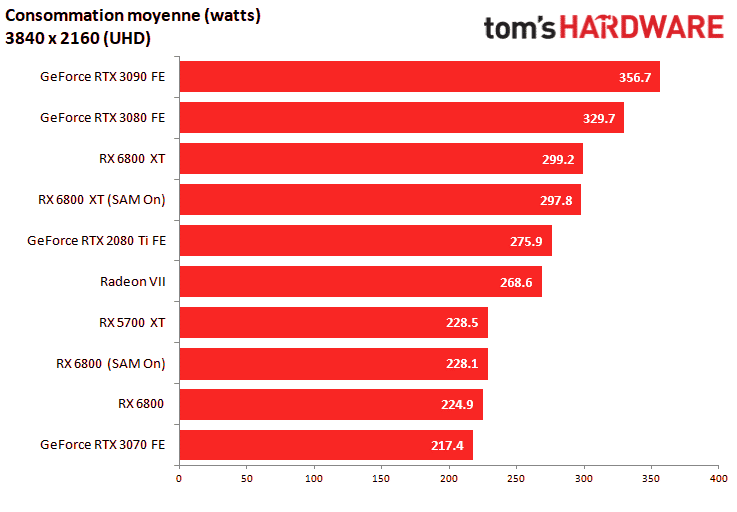

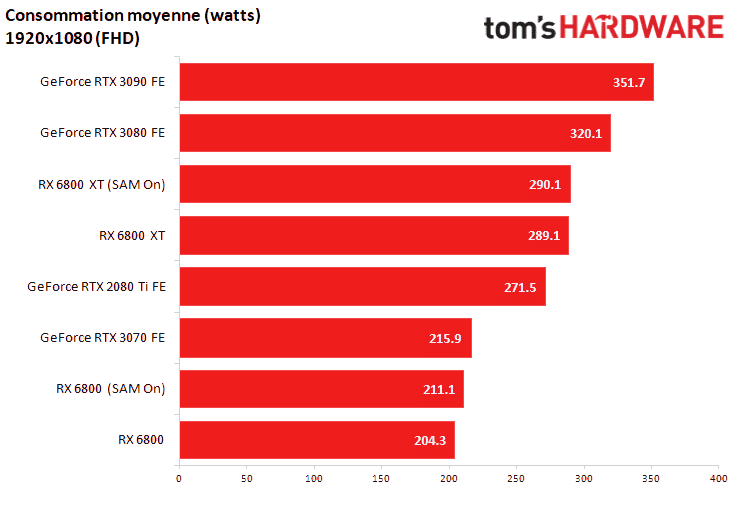

Affichant respectivement un TBP de 250 et 300 watts, les Radeon RX 6800 et 6800 XT présentent toutefois une efficacité énergétique très séduisante par rapport à l’offre concurrente. En QHD, la Radeon RX 6800 présente ainsi une consommation brute moyenne de 206,8 watts (sans SAM) et de 212,4 watts (avec SAM), des valeurs toutes deux inférieures de 3% à 5% par rapport à celles de la GeForce RTX 3070. L’écart est évidemment bien plus important face à la GeForce RTX 3080 (+ 50%). En montant en définition, l’ordre s’inverse légèrement et la Radeon RX 6800 engloutit systématiquement sept à huit watts de plus que la RTX 3070. En revanche, elle fait systématiquement mieux que la génération précédente d’AMD.

L’écart est sensiblement plus intéressant pour la Radeon RX 6800 XT. En QHD comme en UHD, elle consomme 30 à 40 watts de moins qu’une GeForce RTX 3080, que l’on active ou non la technologie SAM. Dans tous les cas, on reste en-dessous des valeurs annoncées par AMD.

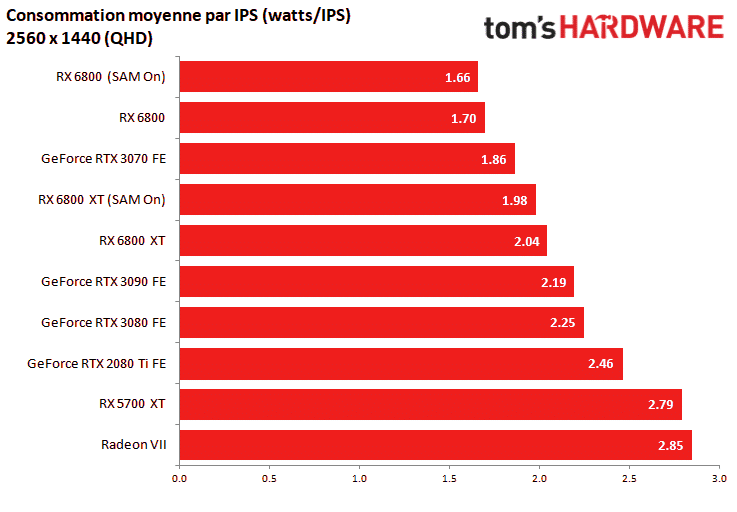

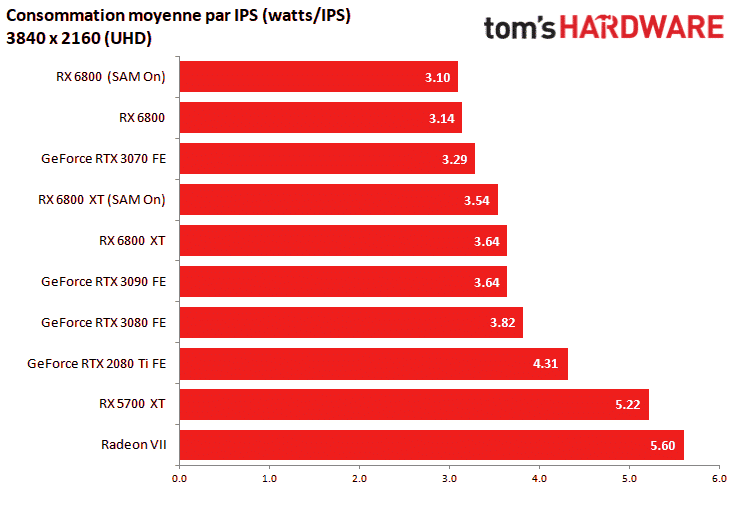

Mais c’est en confrontant à notre panel de cartes l’efficacité énergétique des deux nouvelles Radeon, c’est-à-dire le rapport entre le nombre de watts consommés avec le nombre d’images par seconde, que la mesure prend tout son sens. Les Radeon RX 6800 et RX 6800 XT se montrent toutes les deux particulièrement efficaces, la première venant même ravir la plus haute marche du podium, aussi bien en QHD qu’en UHD. La Radeon RX 6800 est ainsi en moyenne 12% plus efficace que la RTX 3070 et 35% que la RTX 3080, tandis que la RX 6800 XT se montre 8 à 10% plus efficace que la RTX 3080.

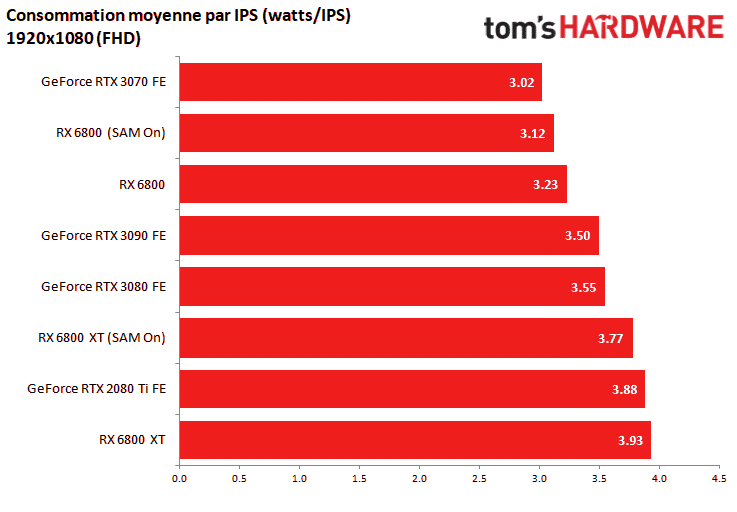

Si l’on se penche sur la consommation moyenne et l’efficacité énergétique en Full HD avec ray tracing, le classement n’évolue pas vraiment. La Radeon RX 6800 est ainsi moins gourmande que la RTX 3070, et la Radeon RX 6800 XT moins que la RTX 3080. La palme de l’efficacité énergétique revient toutefois à la RTX 3070 dans ces conditions, la RX 6800 cédant ici 3% de terrain. Mais dans ce mode de calcul (le plus significatif !), la RX 6800 XT dégringole et tutoie les performances d’une GeForce RTX 2080 Ti de génération précédente.

En conclusion

C’est donc une bien bonne nouvelle : du côté d’AMD comme de Nvidia, en cette fin d’année 2020, le jeu vidéo n’aura jamais été servi par des GPU aussi performants, aussi bien tempérés et silencieux, avec une efficacité énergétique globalement mieux maîtrisée que la génération précédente. En rasterization, la Radeon RX 6800 parvient ainsi à se montrer plus rapide qu’une GeForce RTX 3070 (+6 à +11% en QHD et UHD), et avec une meilleure efficacité énergétique, pour 80 euros de plus environ. La Radeon RX 6800 XT tutoie quant à elle les performances d’une GeForce RTX 3080 (-2 à -5%, en QHD et UHD), pour 60 euros de moins.

Les choses se corsent toutefois du côté du ray tracing, où l’offre de Nvidia reste systématiquement devant - il faut dire que la firme au caméléon en est déjà à la seconde génération de ses unités de calcul matériel, là où AMD étrenne seulement son premier tour de piste en la matière. Il manque également à l’offre d’AMD une technologie similaire au DLSS, pour hisser les performances grâce à l’IA - un manquement qui devrait toutefois être comblé par le Super Res, même si date de sortie est encore incertaine.

On le sait, l’offre de Nvidia brille toutefois par le manque de disponibilité de ses modèles Ampere. Une faille sur laquelle pouvait miser AMD, pour griller à la barbe de son rival le choix des acquéreurs les moins patients. Et pourtant, on le constate déjà quelques heures après leur lancement : les Radeon RX 6800 et RX 6800 XT sont déjà globalement difficiles à trouver dans les étals des revendeurs, avec des modèles custom souvent en rupture de stock … et qui caracolent pourtant à des tarifs nettement plus élevés que les prix officiels des modèles de référence.

Pas de stock …

Super toutes ces nouveaux matériels ! Je voudrais un proc dernière gen AMD (pas disponible) avec une RTX 30xx (pas disponible) ou une Radeon (pas disponible). Je sens que je vais l’attendre longtemps ma nouvelle config :/

Mouais ca rien de base sur Nvidia, mais a coups de bidouille. Et comme prévu c’est ala ramasse en RT et le DLSS n’existe pas chez AMD, car aucune com dessus de puis l’annonce.

Et ca valait de coups de se moquer de Nvidia pour son lancement, quand on fait pire apres ! Pas le moindre stock et des prix en pire que la concurrence pour du vent, deja que leur CPU c’est n’importe quoi niveau prix actuellement, merci AMD

@ Yorda

“Mouais ca rien de base sur Nvidia, mais a coups de bidouille. Et comme prévu c’est a la ramasse en RT et le DLSS n’existe pas chez AMD, car aucune com dessus de puis l’annonce.

Et ca valait de coups de se moquer de Nvidia pour son lancement, quand on fait pire apres ! Pas le moindre stock et des prix en pire que la concurrence pour du vent, deja que leur CPU c’est n’importe quoi niveau prix actuellement, merci AMD”

Tiens un mec qui pretent s’y connaitre plus en hardware que l’ensemble des reviewers de la planete qui disent clairement qu’AMD est au moins revenu au niveau de la 3080 en attendant la sortie de la 6900xt qui sera certainemnt au niveau de la 3090.

1) “a coup de bidouille”, ca veut dire quoi ca au juste? La puissance rasterisation, c’est la base pour une carte graphique. C’est ce qui est a l’origine de 99% des effets graphiques. Et en utilisant un infinity cache, AMD a simplement simplifie toute l’architecture de sa CG en la rendant moins complexe et moins chere a produire. Il est quasi-certain que NVidia cherchera a faire la meme chose avec sa prochaine generation de GPU. Avoir un gros cache ultra rapide c’est un principe de base pour les CPU a l’heure actuelle pour avoir de la perf et c’est simplement ce qu’a fait AMD avec son GPU. Cela permet aussi a AMD de proposer 16 GB de GDDR6, bien plus futur proof que les 10 GB en GDDR6X de la 3080 ou les 8 GB de la 3070 qui seront sans doute tres insuffisant en 2160p et meme 1440p sur le long terme.

2) “la ramasse en RT”, Ben tout de meme au dessus d’une 2080 Ti. Et le RT, ce n’est meme pas 1% des effets visuels visibles a l’ecran. Perdre 30% de puissance en rasterisation, sur un seul effet, c’est tout simplement ridicule. A tel point que la tres grande majorite des joueurs en RTX n’activent meme pas cette option. Sinon je crains fort que tu ne doive t’habituer a la facon dont AMD use du Ray Traicing car il sera developpe en prio pour fonctionner sur des consoles avec des APU AMD en RDNA2, si jamais les developpeurs s’interessent a cette option a court terme. Ce qui n’est pas certain, quand on voit ce que cela a donne avec PhysicX, qui etaient le saint Graal, mais dont plus personne ne parle et qui a fini aux oubliettes.

3) Le DLSS est du pur marketing et c’est un specialiste du traitement de l’image qui te le dit. On ne peut pas comparer du 2160p natif a du 1440p upscale vers du 2160p meme avec du DLSS. C’est juste un upscaling un peu ameliore. A options graphiques egales, cela ne vaudra jamais la qualite en resolution native. Cela n’a jamais ete le cas, ce n’est pas le cas et cela ne sera jamais le cas. Et c’est pas un debat. C’est de la theorie du signal et cela se demontre mathematiquement. Il sera donc assez facile pour AMD de sortir une option a peu pres equivalente qui fournira a peu pres la meme qualite. Et AMD pourra claironner, “nous aussi on a notre DLSS”. Car c’est juste du marketing a l’adresse de geeks qui n’y connaissent pas grand chose.

4) “leur CPU c’est n’importe quoi niveau prix actuellement” Ben le meilleur pour finir. Et bien un petit 5600x est tout simplement equivalent en jeux a un 10900K et pour largement moins cher. Et sinon en applicatif un 5600x va etre au niveau d’un 10700K pour moins cher, un 5800X sera au niveau d’un 10900K pour moins cher, et les 5900x et 5950x sont simplement sans coucurrence chez Intel ou alors il faudra aller voir du cote des xeons qui coutent 2 fois plus cher. Et sinon, si tu veux jouer en 4K avec une 3080, et bien un 3700x ou meme un 3600x te donnera le meme framerate que les 10900K, 10700K et 10600K pour largement moins chers. AMD ecrase simplement Intel dans tous les compartiments, en prix et performance, et aucun reviewer serieux ne te dira le contraire.

@ yvesl

“et des prix stratosphérique, quoi en dessous de 300€, et je ne parles pas de sous les 200€? Bref sans moi”

Euh Intel et Nvidia sont donc reconnu pour proposer des prix attractifs? Elle est bien bonne celle-la. Les 3090, 3080 et 3070 sont a moins de 300 euros? Les 10900K, 10700K et 10600K sont a moins de 200 euros?

Dans toutes les reviews que j’ai vu, en GPU et CPU, il est clairement montre qu’AMD propose soit les memes perf pour moins cher, soit des perfs superieures pour le meme prix. La seule exception etant pour la RX 3070 chez Nvidia.

Si tu veux un CPU tres performant en jeux pour pas cher, le meilleur choix, et de loin, est le 3600 que l’on peut trouver a moins de 200 euros.

@Sagittaire, étrange pour un spécialiste de l’image de dire que le deep learning est un upscaling amélioré…

Je suis curieux de savoir pourquoi vous dites cela

Après personnellement, je trouve au contraire cette approche sympathique et c’est aussi pour cela qu’AMD travaille dessus.

Cela permet d’avoir une image dans la définition native d’un écran avec un calcul en résolution inférieure et puis cela permet une pérennité plus importante de la carte graphique

Concernant la taille de la mémoire, je vous rejoins.

Je trouve étrange que NVIDIA n’ait pas mis 16 GB si ce n’est le prix

Ça me rappelle où on avait des cartes bas de gamme avec plus de mémoire que les modèles supérieurs…useless mais ça permettait de mettre sur la boîte un plus gros chiffre…

“@Sagittaire, étrange pour un spécialiste de l’image de dire que le deep learning est un upscaling amélioré…”

Ben parce que c’est le cas. Un pixel perdu est un pixel perdu et c’est pas un upscaling haute qualite, avec du sharpening puis ensuite un deep learning predictif qui le recuperera.

Le probleme avec le 4K DLSS, c’est qu’il y a une sorte d’effet placebo. Certain testeurs vont meme jusqu’a dire que le 4 DLSS est plus agreable que le 4K natif, a meme frequence d’image, ce qui est totalement abherant d’un point de vue theorique. Cet upscaling particulier rajoute des filtres de sharpening qui flattent l’image. Et c’est un procede connu depuis des decenies. Le probleme c’est que le 2160p dlss est fait a partir d’une image qui est deja d’une tres haute qualite en 1440p et qu’un upscalling seul de haute qualite rendra difficilement dicernable le 1440p upscale en 2160p face au 2160p natif, meme par un professionnel. Pour le mettre en evidence, il faudra souvent faire un arret sur image et zoomer dans l’image.

Et d’ailleurs pour mettre cette problematique en evidence, il suffit d’activer le DLSS a des resolutions inferieures: ce qu’il semble en apparence reussir en passant du 1440p au 2160p DLSS ne fonctionne plus en passant par exemple du 720p au 1080p DLSS. A l’oeil on voit tres bien cette fois que le 1080p DLSS est tres loin qualitativement du 1080p natif pour une meme frequece d’image et il n’y a aucune raison theorique pour que le DLSS echoue ici. Et la raison en est simple: il est beaucoup plus facile pour un oeil humain de voir les differenceS de detail entre un 1080p natif et un 720p upscale vers du 1080p. Dans ce cas le DLSS ne peut plus faire illusion.

Quel est encore l’ huluberlu qui a inventé cette idée de génie de watts/ips ? Encore une invention de “journaleux” . Il pourrait suffire d’ être très ” f performant s ” dans un jeu et d’ être à la ramasse sur les autres pour pouvoir l’ emporter en watts/ips, un peu comme le hasard ici avec la 3070 . Le mec qui a inventé ça, il doit avoir trop de jours/travail .

Ah oui, intel et nvidia sont les spécialistes de l’ entubage des consommateurs, l’ un a inspiré tellement l’ autre que ce dernier se croit obligé d’ inventé des tas d’ artifices logiciels pour faire croire aux consommateurs qu’ ils ont de meilleurs produits, ça déteint parfois même sur AMD,à cause des con sommateurs qui suivent .

@Sagittaire, oui et non sur votre raisonnement.

Effectivement un pixel perdu est un pixel perdu mais cela ne s’applique que lorsqu’on réduit une image.

Ici, il s’agit de rendu donc d’absence de calcul de pixels.

De plus, le dlss s’est beaucoup plus compliqué car il s’agit d’algorithmes et d’apprentissage de rendu.

Il est possible d’avoir une image native versus upscalée via dl qui soit identique d’un point de vue visuelle mais bien différente en zoomant.

Donc sur le rendu, on est très dépendant de l’apprentissage et des algos.

C’est un peu comme la compression, il y a des compressions destructives et d’autres dites sans perte.

Pour le cas du dlss de nvidia, il y aura des cas où la différence sera perceptive et d’autres non.

Et je vous rejoins sur le fait que ce type d’upscale sera + visible sur des petites résolutions que sur des grandes car plus l’image est grande, plus il y a d’informations et plus le lissage sera facile.

Après au niveau des tests, c’est bien qu’il y ait une évaluation des perfs avec et sans cette technologie mais il serait intéressant d’indiquer si la perte de qualité est perceptible.

Car faire un test en qualité crazy puis mettre en dlss si on se retrouve avec une qualité du type high… Cela biaise le test (ce n’est que mon avis ^^)

J’ai vu des informations comme quoi le dlss permettait un gain de plusieurs dizaines de % mais aucune information sur la qualité d’image… C’est bien dommage

@Sagittaire

Quand on s’emporte, c’est pas mal de ne pas dire n’importe quoi juste pour avoir raison :

“l’ensemble des reviewers de la planete”

Vous les avez tous donc vus ? Trop fort, Incroyable !

“le RT, ce n’est même pas 1% des effets visuels visibles a l’ecran”

N’importe quoi. Source ?

“la très grande majorité des joueurs en RTX n’activent même pas cette option”

N’importe quoi. Source ?

“Le DLSS est du pur marketing… C’est juste un upscaling amélioré”

Donc, ce n’est pas du pur marketing. Par ailleurs vous semblez ne rien capter au DLSS, déso.

“(DLSS)A options graphiques egales, cela ne vaudra jamais la qualite en resolution native.”

Affirmation facile, puisque personne ne dit ça O:

“Il sera donc assez facile pour AMD de sortir une option a peu pres equivalente”

Du “pur marketing” aussi chez AMD donc ?…

“Car c’est juste du marketing a l’adresse de geeks qui n’y connaissent pas grand chose.”

Ce sont justement les geeks qui s’y connaissent plus que la moyenne de la population en tech en général o-o

1) « l’ensemble des reviewers de la planete »

“Vous les avez tous donc vus ? Trop fort, Incroyable !”

Euh oui justement:

https://videocardz.com/newz/amd-radeon-rx-6800-series-review-roundup

J’ai pas toujours tout lu intégralement mais je suis allé voir la plupart des conclusions, qui sont toutes convergentes.

2) « le RT, ce n’est même pas 1% des effets visuels visibles a l’ecran »

“N’importe quoi. Source ?”

Ben ce sont des effets de lumières qui représentes en effet de l’ordre de 1% des effets visuels visibles à l’écran. Et la plupart du temps le rendu avec RT Off est très similaire au RT On

3) « la très grande majorité des joueurs en RTX n’activent même pas cette option »

“N’importe quoi. Source ?”

Ben déjà simplement parce que les jeux qui supportent cette option sont ultra-minoritaires. Et la très grande majorité des joueurs actuels en RTX possèdent de fait des 2060-2070-2080 pour lesquels les performances s’écroulent littéralement. Et qu’enfin, et ça vaut ce que ça vaut, la plupart des joueurs en RTX qui interviennent sur les forums préfèrent avoir une meilleure fluidité qu’un framerate qui s’écroule pour avoir une augmentation de la qualité visuelle qui, est de l’avis d’une très large majorité de reviewers, loin d’être considérable.

4) « Le DLSS est du pur marketing… C’est juste un upscaling amélioré »

“Donc, ce n’est pas du pur marketing. Par ailleurs vous semblez ne rien capter au DLSS, déso.”

Ben si la techno de base c’est un upscaling suivi d’un sharpening (méthode connue depuis des décennies en vidéo) et de toute façon j’ai pas besoin de capter non plus. Un pixel perdu est perdu. Et c’est pas un deep learning predictif qui le récupérera. Encore une fois ceci n’est pas un débat. C’est de la théorie du signal et ça se démontre mathématiquement. Une image 4K native sera toujours qualitativement supérieure à une image 4K DLSS. Et donc comparer un framerate 4K natif à un framerate 4K DlSS n’a strictement aucun sens.

5) « Il sera donc assez facile pour AMD de sortir une option a peu pres equivalente »

“Du « pur marketing » aussi chez AMD donc ?…”

Ben oui. Et c’est le côté pervers du marketing. Ca me rappelle les débats autour de PhysicX. Aujourd’hui plus personne n’en parle du PhysicX. Et quand la mode sera passée ou qu’AMD aura sorti une option plus ou moins équivalente, plus personne ne parlera du DLSS. Et d’ailleurs AMD n’aura pas un gros R&D à faire car ils ont déjà une solution qui s’appelle le RIS qu’il suffira juste de marketer avec un pseudo deep learning pour que ça passe. Cela sera sans doute un peu moins qualitatif dans les faits que la solution de NVidia qui est plus avancée, mais 99% des utilisateurs seront incapables de voir la différence “In Game”.

https://www.tomshardware.fr/test-comparatif-visuel-radeon-sharpening-nvidia-dlss/

@Kats

19 jeux sur le site de nvidia, le ray tracing c’est pas 1%, c’est 0.00001%

https://www.nvidia.com/fr-be/geforce/rtx/

le DLSS c’est bien de l’upscaling amélioré

https://www.nvidia.com/en-us/geforce/news/nvidia-dlss-2-0-a-big-leap-in-ai-rendering/

(savoir lire l’anglais, sinon apprendre)

le 4k Natif est meilleur que le 4K DLSS, personne ne dit le contraire (sauf vous, ca pose des questions)

avant de vouloir invalider les dire de quelqu’un, je ne peux que vous suggérer de vous informer un minimum

@bejito81

1/ Je ne vous parlais pas, mais à Sagittaire, qui m’a répondu de façon civilisée, lui. (Même si je ne suis toujours pas tout à fait d’accord : le DLSS n’est pas qu’un upscaling + resharp, loin de là. Ça, effectivement, on sait le faire depuis belle lurette. Et le RT ce n’est pas que les reflets dans l’eau ou une vitre, contrairement à ce que laisse penser la com actuelle, ça gère l’ensemble des sources lumineuses, ce qui peut difficilement être considéré comme anecdotique)

2/ “personne ne dit le contraire (sauf vous, ca pose des questions)”

Non, je n’ai pas dit le contraire.

3/ Merci je suis informé, et non je n’ai pas besoin d’apprendre l’anglais, ça va bien de ce côté.

4/ Ne vous posez pas en chevalier blanc des autres, ils se débrouillent bien mieux sans vous.

Oui pas de stock…

On aura des prix plutôt correct dès qu’il y aura du stock par rapport à l’ancienne gamme car il y aura de la concurrence, il faut juste être patient. (mis à part les RX 6900XT/RTX 3090 bien sure…)

Par contre je trouve que les meilleurs perf/prix sont sur la RTX 3070 et la RX 6800 XT.

J’hésite en tout cas entre les 2 (la RX 6800 étant trop cher par rapport à la RTX 3070 et la RTX 3080 étant trop cher

par rapport à la RX 6800 XT)