L’architecture RDNA 4 mettra l’accent sur l’intelligence artificielle. Mais contrairement à NVIDIA, AMD ne souhaite pas utiliser les accélérateurs IA pour soutenir des technologies d’upscaling type DLSS ; la société voit, pour ces accélérateurs, d’autres usages plus pertinents.

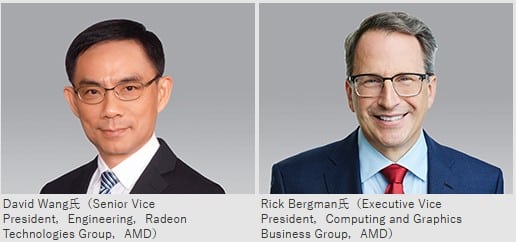

Au cours d’un entretien accordé au média japonais 4Gamer, David Wang et Rick Bergman d’AMD ont esquissé les contours de la stratégie de l’entreprise pour sa prochaine architecture graphique, RDNA 4. Celle-ci mettra l’accent sur le Mesh shading, en poursuivant la voie du MDIA (Multi-Draw Indirect Accelerator), ainsi que sur l’intelligence artificielle, mais dans une optique différente de celle de NVIDIA.

Au sujet du MDIA, il a pour fonction de traiter le MDI (Multi Draw Indirect). L’implémentation de cet accélérateur matériel a permis de booster les performances des GPU RDNA 3 par un facteur de 2,3 par rapport aux GPU RDNA 2. Cet accélérateur doit permettre de contourner la technique de rendu LOD (Level of Detail) selon AMD. La société espère le promouvoir davantage dans son modèle de programmation GPU RDNA 4.

L’IA ne doit pas se borner à des technologies d’upscaling

Concernant l’IA, comme celles d’Intel et de NVIDIA, l’architecture RDNA 3 propose également de l’accélération matérielle spécifique à ce genre de tâches par le biais des WMMA (Wave Matrix Multiply-Accumulate). Pour simplifier, WMMA est l’équivalent des cœurs Tensor (également appelés AI Cores) de NVIDIA et des moteurs XMX (Xe Matrix Extensions) d’Intel. Reste qu’en matière de calculs FP16, la Radeon RX 7900 XTX plafonne à 123 TFLOPS environ. Pour la comparaison, la GeForce RTX 4090 délivre environ 330 TFLOPS et l’Arc A770, 138 TFLOPS.

AMD a donc un peu de retard en la matière, mais David Wang le justifie par le fait que le traitement de l’IA est principalement effectué par le CPU, avec un ordre de grandeur de 95 %. L’apprentissage se concentre en revanche bien au niveau du GPU.

Pour le vice-président senior de l’ingénierie du Radeon Technologies Group, l’accélération IA matérielle d’un GPU est ainsi une décision commerciale plus que technique. En outre, il estime qu’elle ne doit pas se limiter à des technologies de mise à l’échelle type DLSS, XeSSS ou FSR. D’ailleurs, David Wang considère qu’AMD a, avec son FSR, apporté la preuve que l’upscaling n’a nullement besoin d’une accélération IA : le Fidelity FX Super Resolution ferait aussi bien que le DLSS sans un tel prérequis.

Enfin, David Wang suggère que les accélérateurs d’IA au sein des GPU pourraient avoir d’autres applications plus adaptées. En matière de jeu vidéo, il donne l’exemple du comportement des PNJs notamment.

‘Artefacts disgracieux’, ‘textures floues’ : NVIDIA dézingue le FSR d’AMD !

Propos de David Wang

Voici ses propos (la traduction n’est pas idéale, le texte de base est en japonais) :

Nous pensons que ce qui devrait être fait avec l’accélérateur d’inférence installé dans le GPU ne devrait pas se limiter à une “utilisation centrée sur le traitement des images” représentée par le “DLSS” de NVIDIA. Jetez un coup d’œil à FidelityFX SuperResolution (FSR), l’un des produits de la série FidelityFX. L’anti-crénelage et le traitement super-résolution de FSR, réalisés sans utiliser d’accélérateur d’inférence, offrent des performances et une qualité qui peuvent rivaliser avec le DLSS de NVIDIA.

La raison pour laquelle NVIDIA essaie activement d’utiliser la technologie d’IA même pour des applications qui peuvent être réalisées sans utiliser la technologie d’IA est que NVIDIA a installé un accélérateur d’inférence à grande échelle dans le GPU. Afin de l’utiliser efficacement, il semble qu’ils travaillent sur un axe qui nécessite de mobiliser de nombreux accélérateurs d’inférence. C’est leur stratégie en matière de GPU, ce qui est très bien, mais je ne pense pas que nous devions avoir la même stratégie. Nous nous concentrons sur l’inclusion des spécifications que les utilisateurs veulent et dont ils ont besoin au sein de GPU grand public. Sinon, les utilisateurs paient pour des fonctionnalités qu’ils n’utilisent jamais. Nous pensons que les accélérateurs d’inférence qui devraient être implémentés dans les GPU des joueurs devraient être utilisés pour rendre les jeux plus avancés et plus amusants.

Par exemple, le mouvement et le comportement des personnages ennemis et des PNJ sont probablement les exemples les plus évidents.

De même, même si l’IA est utilisée pour le traitement des images, elle devrait être chargée de traitements plus avancés. Plus précisément, un thème tel que “les graphiques neuronaux”, qui prend actuellement de l’ampleur dans l’industrie des graphiques 3D, pourrait être approprié.

Des GPU pas seulement destinés aux PC

Enfin, Rick Bergman, qui est vice-président exécutif du Computing & Graphics Business Group d’AMD, a rappelé que l’entreprise concevait des GPU pour une grande variété de plates-formes, tels que les smartphones, les consoles et les automobiles, et qu’elle continuerait dans cette voie de la diversification. Bien que le SoC Exynos 2200 ne soit pas une franche réussite, les systèmes d’info-divertissement de certaines Tesla sont bien plus convaincants : ils ont permis le support de nombreux jeux Steam.

Source : 4Gamer via VideoCardz

bah c’est complètement biaisé comme approche sachant que d’un univers à l’autre on veut surement que notre ia réagisse différemment. De plus déporté encore des calculs supplémentaire sur la CG ou les pilotes n’est clairement pas une bonne idée. Puis zut à la fin, en tant que joueur on veut continuer à pester sur les IA débiles plutot que d’avoir un truc “qui émule un humain”. De plus par exemple l’UE5 gère déjà la générations d’animation des modèles 3D, pourquoi vouloir déporter ça sur le gpu qui a autre chose à faire (la majorité des conf actuelle sont GPU limited)

Par contre l’affirmation que le fidelity fx donne les mêmes résultats que le dlss, il est sur son petit nuage le SVP d’amd. Clairement la techno dlss s’est fortement améliorée avec le temps et délivre une qualité d’image supérieure à mon sens pour avoir comparé les 2 sur qql jeux récents.