Grâce à DirectX 12, il y a du mieux pour l’optimisation CPU ; en revanche, pour la partie GPU, c’est pire qu’avant.

Le jeu Assassin’s Creed Valhalla d’Ubisoft sort aujourd’hui. Un titre très attendu, puisque le dernier opus majeur, Assassin’s Creed Odyssey, remonte à 2018. Sur PC, c’est le premier à utiliser l’API DirectX 12. Hier, on a toutefois été un peu inquiets en constatant qu’un GPU aussi puissant que la RTX 3090 avait quelques difficultés en 4K/Ultra. Plusieurs sites proposent désormais une analyse des performances, et nos craintes sont confirmées : le jeu est très gourmand en ressources GPU.

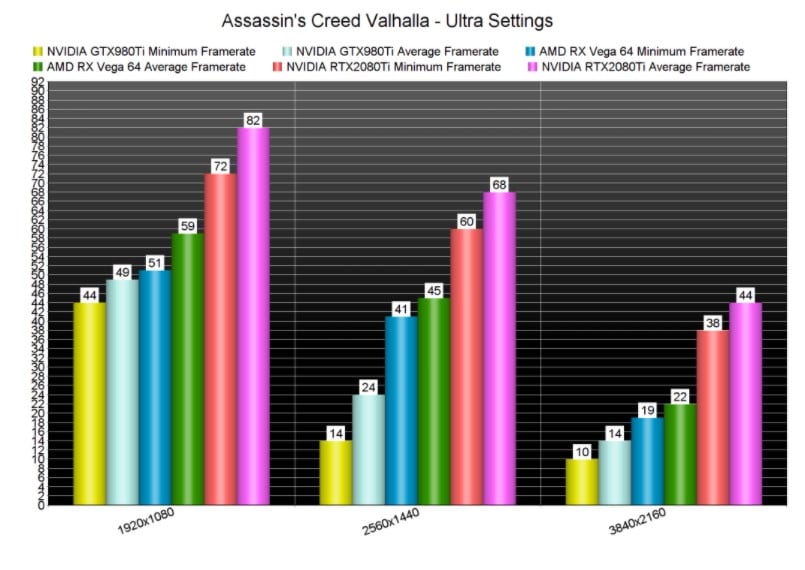

C’est aussi ce qui transparait dans le test réalisé par DSOGaming. John Papadopoulos a expérimenté plusieurs configurations, jusqu’à la RTX 2080 Ti de NVIDIA ; une carte qui offre un niveau de prestations à peu près similaire à la récente RTX 3070. Rappelons qu’Ubisoft préconise une RTX 2080 pour du 4K/Ultra ; par ailleurs, pour profiter du soft sur PC, il faut une carte graphique avec 4 Go de VRAM minimum.

Diablo III, Battlefield Bad Company 2 ou encore COD Modern Warfare en 8K grâce à une RTX 3090

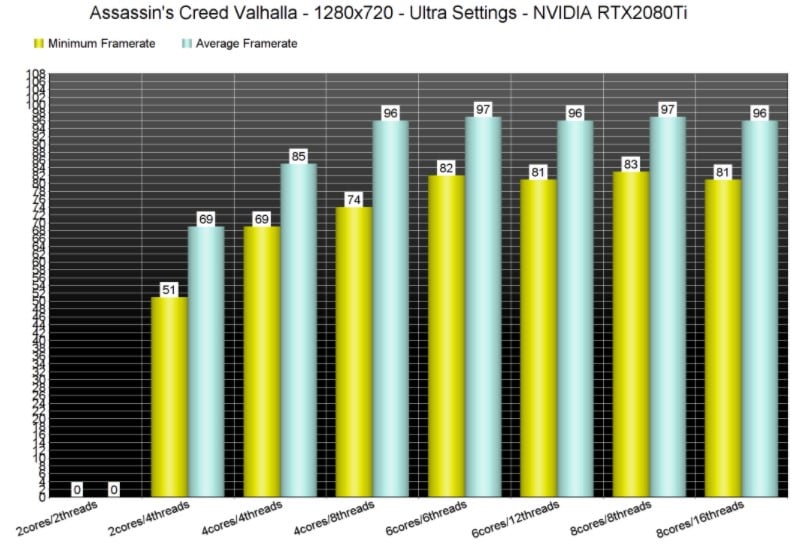

Un CPU avec au moins 6 cœurs / 6 threads pour éviter le stuttering

On commence par les bonnes nouvelles. Ubisoft propose pléthore de paramètres graphiques, y compris pour ajuster le FOV et limiter le nombre d’images par seconde.

Surtout, l’utilisation de DirectX 12 apaise, un peu, la gloutonnerie des jeux de la franchise en matière de ressources CPU. En effet, selon John Papadopoulos, son Intel Core i7-4930K est moins mis à mal par Assassin’s Creed Valhalla que par Assassin’s Creed Odyssey. Néanmoins, dans l’absolu, il faut idéalement un processeur 6 cœurs / 6 threads ou mieux doté ; les processeurs à 2 ou 4 cœurs causent du stuttering.

Un GPU haut de gamme même pour du 1080p

Par contre, pour les GPU, la situation s’est aggravée. En l’état, seule la RTX 2080 Ti (et donc les RTX 3000 de NVIDIA) est en mesure de faire tourner le jeu en 1080p/Ultra. Dans des définitions plus élevées, la carte ne tient pas les 60 ips. À l’évidence, l’absence de DLSS 2.0, salvateur sur Watch Dogs Legion, se fait cruellement sentir. Notez également qu’à partir du 1440p/Ultra, le jeu requiert plus de 6 Go de VRAM ; cela met donc hors course des cartes comme la GTX 980 Ti ou la GTX 1060, qui reste malgré son âge la carte la plus populaire selon les statistiques Steam.

Bien sûr, le paramètre Ultra exige souvent un net surplus de puissance, pas toujours justifié à l’écran. Seulement ici, entre le Very High et l’Ultra, il n’y a que 3 ips d’écart ; entre le Very High et le High, 2 ips. Le gain intervient surtout avec les réglages en Moyen ; mais dans ce cas, le jeu n’est plus vraiment au niveau des meilleures productions actuelles sur PC. En outre, opter pour du 720p plutôt que du 1080p n’accorde que 10-14 ips supplémentaires.

Le bilan du test de notre confrère n’est pas très glorieux : cet Assassin’s Creed Valhalla est mal optimisé ; même en 1080p, le jeu impose un GPU haut de gamme et mettra bon nombre de machines actuelles au tapis. Sur PC, sans être particulièrement plus beaux que d’autres jeux en monde ouvert, il serait l’un des plus mal optimisé. Toujours selon John Papadopoulos, un Horizon Zero Dawn, dont le portage a pourtant été aussi beaucoup critiqué, jouit d’une esthétique plus flatteuse et tourne mieux que la production d’Ubisoft.

c’est pas pour rien qu’il sort aujourd’hui en lineup des consoles next gen. Tout est fait pour pousser à l’adoption d’une nouvelle console (en simili 4k) plutôt que d’opti pour PC.

Bonjour,

Je ne suis pas concerné, j’ai un 12 cores, mais par curiosité.

Vous évoquez les 6 cores/6 threads, comme étant idéales et dites que les 2 et 4 cores causeraient du stuttering.

“Surtout, l’utilisation de DirectX 12 apaise, un peu, la gloutonnerie des jeux de la franchise en matière de ressources CPU. En effet, selon John Papadopoulos, son Intel Core i7-4930K est moins mis à mal par Assassin’s Creed Valhalla que par Assassin’s Creed Odyssey. Néanmoins, dans l’absolu, il faut idéalement un processeur 6 cœurs / 6 threads ou mieux doté ; les processeurs à 2 ou 4 cœurs causent du stuttering.”

Les nombreux pocesseurs de vieux I5 (4 cores/4 threads) devront surement changer de CPU.

Mais comment se comportent les anciens I7 (4 cores/8 threads) ?

Bonjour,

Selon la source, tous les processeurs sous les 6 cœurs / 6 threads causent du stuttering, y compris les 4 cœurs / 8 threads.

Surcharge GPU ? … les devs ont codé à la truelle.

Même dans l’info professionnelle, on se tape plein d’applications codées on sait pas comment avec les soucis de prod’ et la maintenance pour barbus.

C’est la maladie du siècle en développement : on code par rapport aux middlewares et aux frameworks. L’algorithme n’est plus au cœur des programmes. Les développeurs ne savent plus comment un ordinateur fonctionne, le noyau est une boîte noire, le réseau est une boîte noire, la base de donnée est une boîte noire, l’architecture des frameworks sont des boîtes noires … et après on s’étonne que ça fonctionne mal !?

“Rémi Bouvet”

Merci

Finalement, les gas de chez Ubi sont des dieux de la programmation, comparé à ceux de chez CD Projekt.