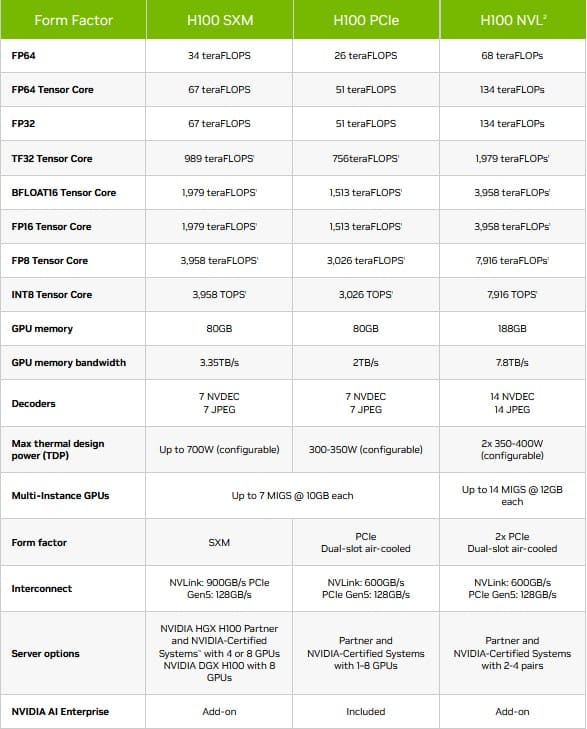

NVIDIA décline son GPU H100 dans une troisième version, la NVL, après les SXM et PCIe. La H100 NVL est une solution pour les systèmes LLM : elle délivre une passante mémoire de 7,8 To/s, contre “seulement” 3,35 To/s pour la H100 SXM.

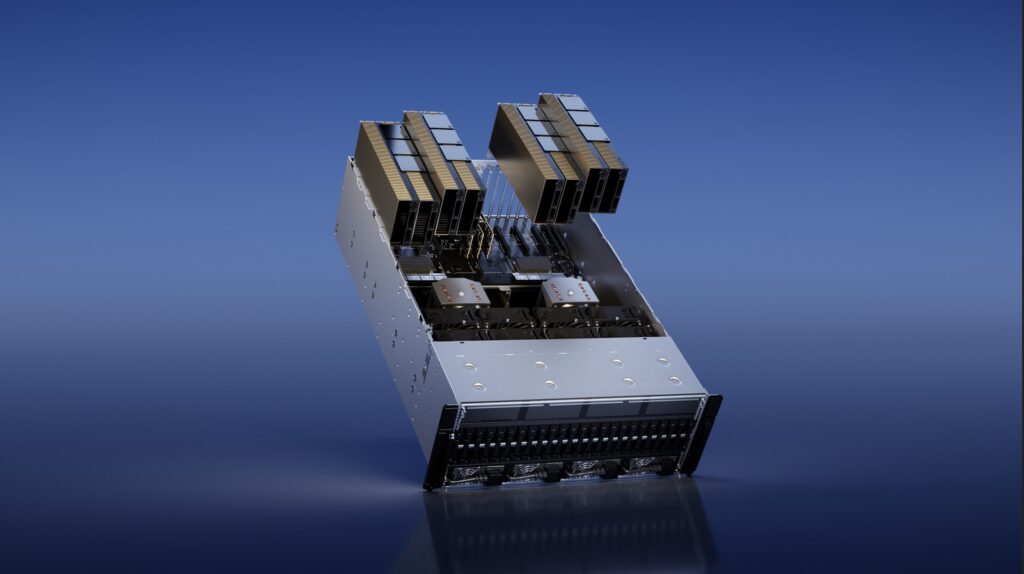

Lors de la GTC, NVIDIA a annoncé plusieurs nouveaux produits, dont des cartes graphiques RTX, mais aussi un dual-GPU, le H100 NVL. Comme son nom l’indique, c’est une paire de GPU H100 reliée par des connecteurs NVLink (trois connecteurs selon les images d’illustration). Notez que les deux cartes utilisent deux emplacements PCIe distincts.

A lire aussi, les actualités les plus récentes au sujet de NVIDIA et ses technologies :

- Nvidia sauve la mise avec un nouveau driver qui corrige les problèmes des RTX 5090

- Le prix des cartes graphiques risque d’augmenter drastiquement, merci Trump

- Les RTX 5060 et 5060 Ti repoussées, voici leur nouvelle date de sortie

- Vous voulez une RTX 5080/90 FE à bon prix ? Nvidia vous dit comment faire

Cette solution ne marque pas le retour du SLI dans nos PC maison, mais seulement dans les centres de données à fortes charges de travail IA – notamment ceux qui ne supportent pas le SXM – grâce à une grosse bande passante. Le H100 NVL dispose de 94 Go de HBM3 par GPU, soit de 188 Go de HBM3 au total. L’interface mémoire complète de 6144 bits (1024 bits pour chaque pile HBM3) et la vitesse mémoire allant jusqu’à 5,1 Gbit/s aboutissent à un débit maximal de 7,8 To/s, soit plus de deux fois celui de la H100 SXM.

Par ailleurs, la puissance est légèrement supérieure à celle de la H100 PCIe, avec une augmentation de 50 W : 350-400 watts par GPU (configurable) au lieu de 300-350 W.

Une carte NVIDIA H100 PCIe avec 120 Go de mémoire repérée

Plusieurs dizaines de milliers de dollars

NVIDIA met en avant plusieurs éléments pour vanter cette solution. Par exemple, que la H100 NVL est idéale pour déployer à grande échelle des LLM (Large Language Models) tels que ChatGPT. Selon l’entreprise, la nouvelle NVL H100 avec 94 Go de mémoire et l’accélération Transformer Engine offre des performances d’inférence jusqu’à 12 fois plus rapides à GPT-3 par rapport à la génération précédente A100 à l’échelle du centre de données.

« L’essor de l’IA générative nécessite des plates-formes informatiques d’inférence plus puissantes. Le nombre d’applications de l’IA générative est infini et n’est limité que par l’imagination humaine. Armer les développeurs avec la plate-forme informatique d’inférence la plus puissante et la plus flexible accélérera la création de nouveaux services qui amélioreront nos vies d’une manière encore inimaginable », estime Jensen Huang, PDG de NVIDIA.

NVIDIA n’a pas communiqué le prix des H100 NVL. Sachant qu’une carte H100 PCIe coûte environ 28 000 dollars, nous vous laissons envisager le prix d’une paire de ces GPU au sein d’une solution H100 NVL.

Source : NVIDIA