Un seul système CS-2 est capable de gérer une couche d’un réseau neuronal à 120 billions de paramètres.

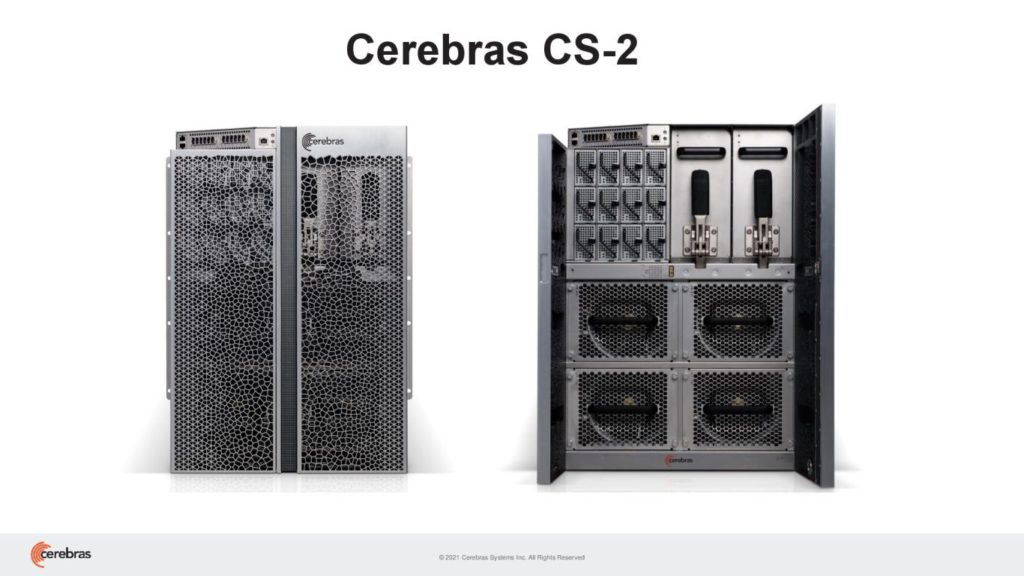

En avril dernier, Cerebras avait présenté son Wafer Scale Engine 2 (WSE2). Ce processeur gravé en 7 nm embarque 850 000 cœurs qualifiés de “Sparse Linear Algebra Compute Cores” et 2,6 billions de transistors. Il a un die d’une surface de 46 225 mm2, soit un carré de 21,5 cm de côté environ. Selon l’entreprise, ce WSE2 est 56 fois plus grand que le plus grand des GPU. Cerebras intègre ses WSE2 au sein de systèmes CS-2. Ces solutions embarquent 40 Go de SRAM. Elles offrent une bande passante mémoire de 20 Po/s et bénéficient d’une interconnexion de 220 Pb/s. Les E/S comprennent 12 ports GbE, soit une bande passante de 1,2 Tb/s. Un seul système engloutit jusqu’à 23 kW.

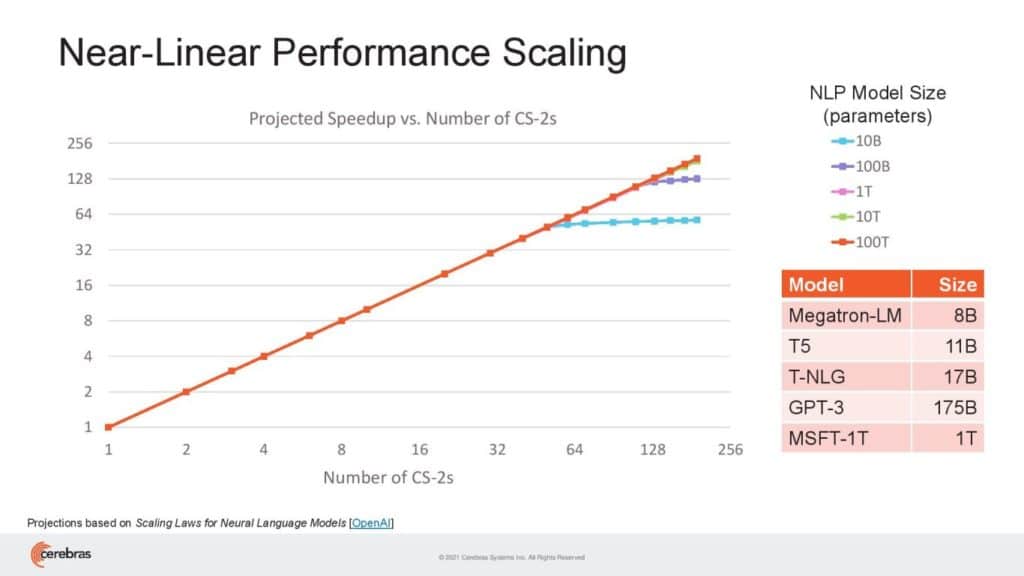

Selon Cerebras, un unique système CS-2 suffit à une couche d’un réseau neuronal à 120 billions de paramètres ; pour la comparaison, aux dires de notre confrère de Tom’s Hardware US, la plupart des dispositifs actuels se limitent à un billion de paramètres. Toutefois, selon Cerebras, il est possible, grâce à sa technologie d’interconnexion maison, de combiner 192 CS-2 ; autrement dit, 163 millions de cœurs.

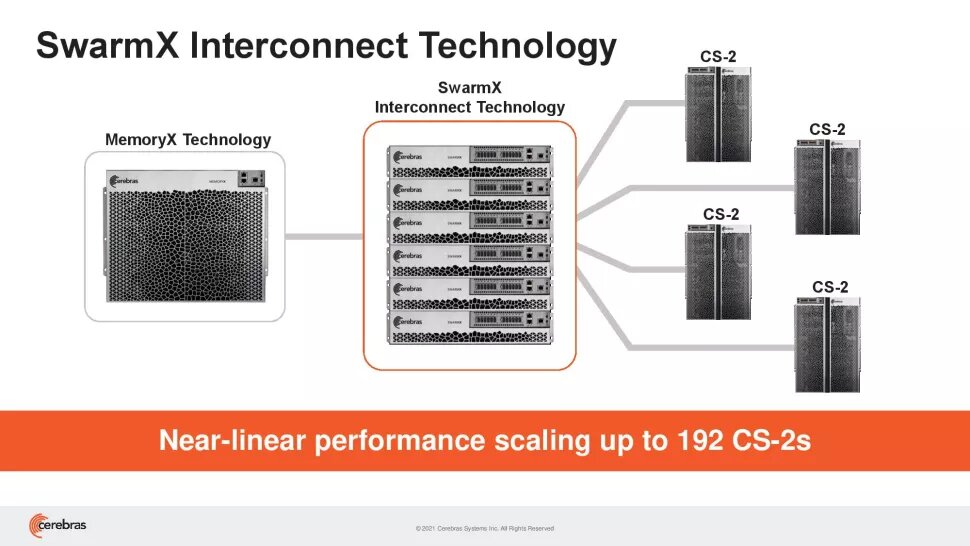

Mémoire MemoryX, commutateurs SwarmX et systèmes CS-2

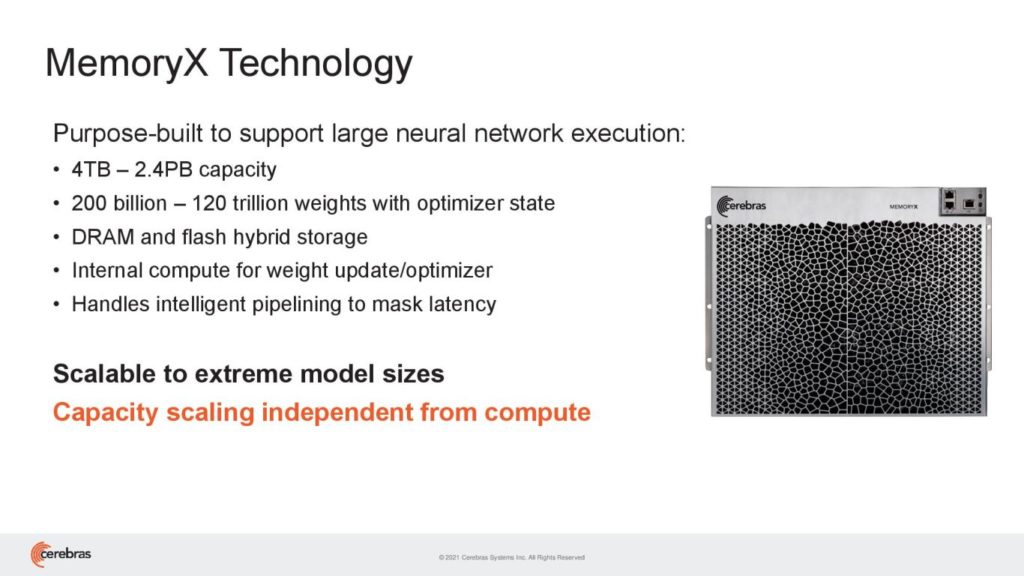

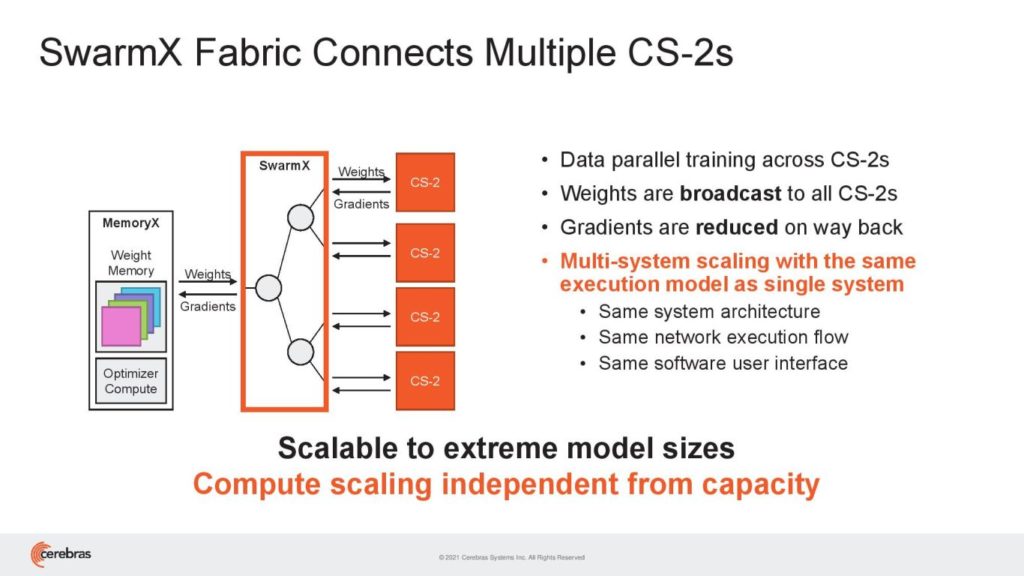

Pour relever les défis de cette mise en réseau, Cerebras a bâti un système de parallélisme par distribution de données. Celui-ci offrirait une mise à l’échelle des performances linéaire. La stratégie consiste à stocker les paramètres du modèle dans des blocs MemoryX. Ces dispositifs embarquent de la mémoire hybride mélangeant mémoire flash NAND et DRAM (ratio non communiqué) pour une capacité allant de 4 To à 2,4 Po ainsi que des processeurs x86. Ensuite, des commutateurs, les SwarmX, font le lien entre les CS-2 et les MemoryX. Chaque commutateur SwarmX prend en charge jusqu’à 32 systèmes CS-2.

Cerebras présente cette solution comme “un système d’IA à l’échelle du cerveau” en référence aux 100 billions de synapses présentes dans le cerveau humain.

Rick Stevens, directeur associé de l’Argonne National Laboratory, l’un des rares clients connus de Cerebras, déclare : “Les dernières années nous ont montré que, pour les modèles NLP (Natural Language Processing), les résultats sont directement proportionnels aux paramètres – plus il y a de paramètres, meilleurs sont les résultats. Les inventions de Cerebras, qui permettront de multiplier par 100 le nombre de paramètres, pourraient avoir le potentiel de transformer l’industrie. Pour la première fois, nous serons en mesure d’explorer des modèles de la taille du cerveau, ce qui ouvrira de vastes voies de recherche et de compréhension.”

Source : Tom’s Hardware US, Cerebras 1, Cerebras 2