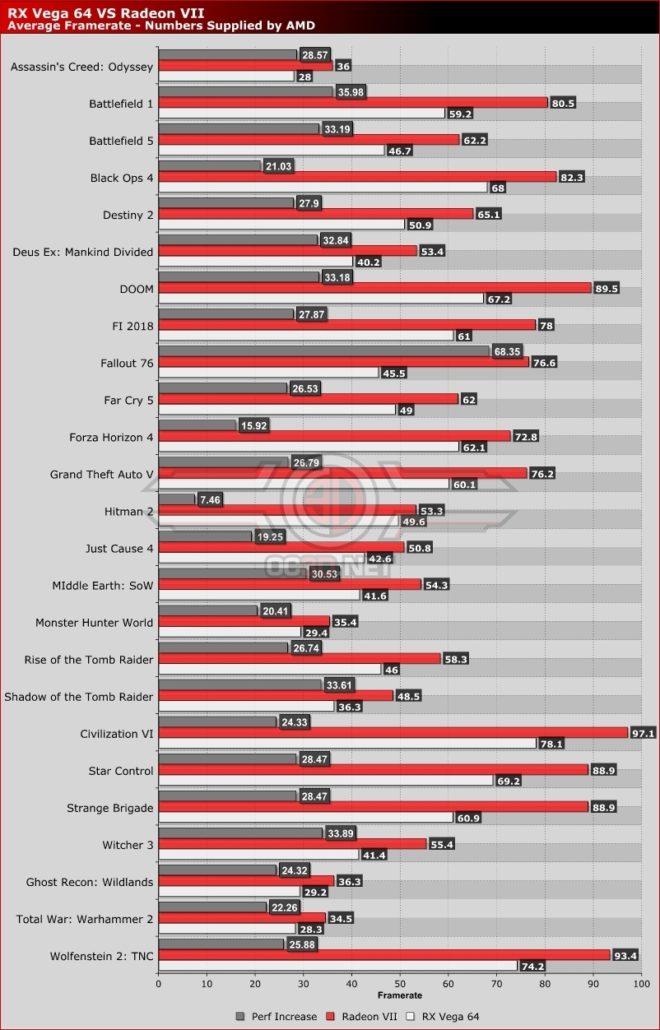

Jusqu’à 68% plus rapide que la Radeon RX Vega 64.

AMD donne plus de détails sur sa carte graphique Radeon VII, révélée hier. Le fabricant communique des données techniques et des performances sur plusieurs jeux. La carte peut se montrer jusqu’à 68% plus rapide que la Radeon RX Vega 64 dans certaines conditions, et environ 30% plus rapide en moyenne. Pour rappel, la Radeon Vega VII bénéficie du 7 nm de TSMC. Elle dispose d’un bus mémoire de 4096 bits et la bande passante atteint 1024 Go/s. La fréquence de base est maintenue à 1450 MHz, mais atteint les 1800 MHz en boost (il faut dire que le dissipateur est largement plus gros…). De quoi fournir 13,8 TFLOP FP32.

| Carte graphique | AMD Radeon R9 Fury X | AMD Radeon Vega 64 | AMD Radeon Vega VII |

| GPU | Fidji XT | Vega 10 | Vega 20 |

| Gravure | 28 nm | 14nm | 7 nm |

| Unités de calcul | 64 | 64 | 60 |

| Processeurs de flux | 4096 | 4096 | 3840 |

| RO | 64 | 64 | 128 |

| Unités de mappage de texture | 256 | 256 | 240 |

| Fréquence (Boost) | 1050 MHz | 1677 MHz (liquide) | 1800 MHz |

| FP32 Compute | 8.6 TFLOPs | 13.7 TFLOPs (Liquide) | 13.8 TFLOPs |

| Mémoire (VRAM) | 4 Go HBM | 8 Go HBM2 | 16 Go HBM2 |

| Taille bus mémoire | 4096 bits | 2048 bits | 4096 bits |

| Bande passante mémoire | 512 Go / s | 484 Go / s | 1 To / s |

| TDP | 275W | 350W (liquide) | 300W |

| Connecteur | Double 8 broches | Double 8 broches | Double 8 broches |

| Prix | 649 $ US | 699 $ US | 699 $ US |

| Lancement | 2015 | 2017 | 2019 |

Les performances dans les jeux

Dans de nombreux titres, la carte présente une amélioration moyenne des performances d’environ 25% par rapport à son ainée, la Radeon Vega, et jusqu’à 64.68% dans Fallout 76. AMD n’a pas divulgué tous les paramètres de tests, seulement que les jeux ont été testés en 4K.

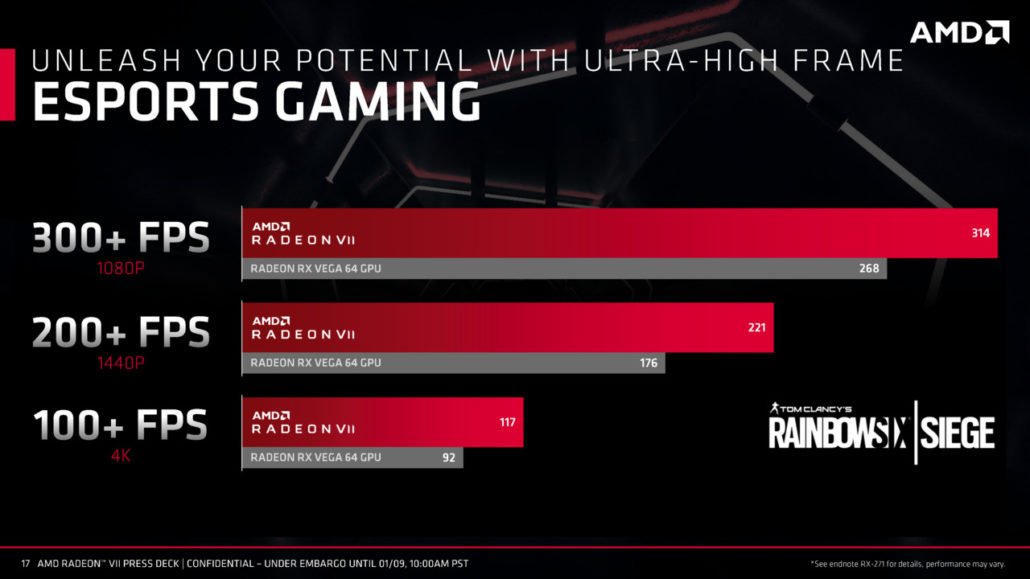

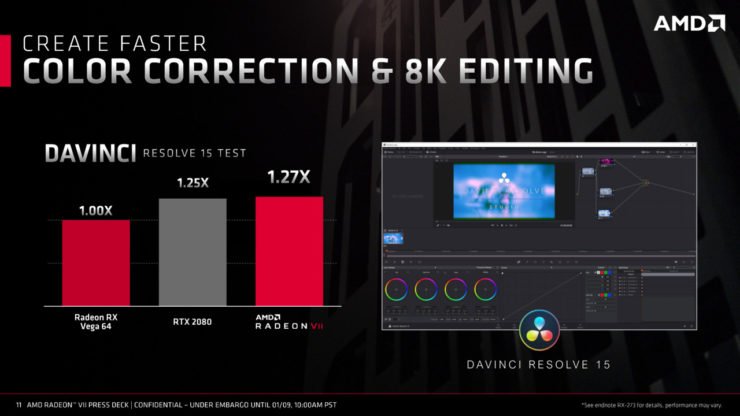

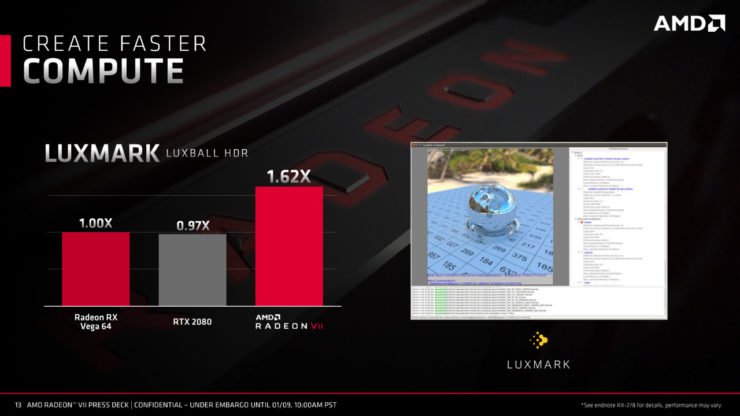

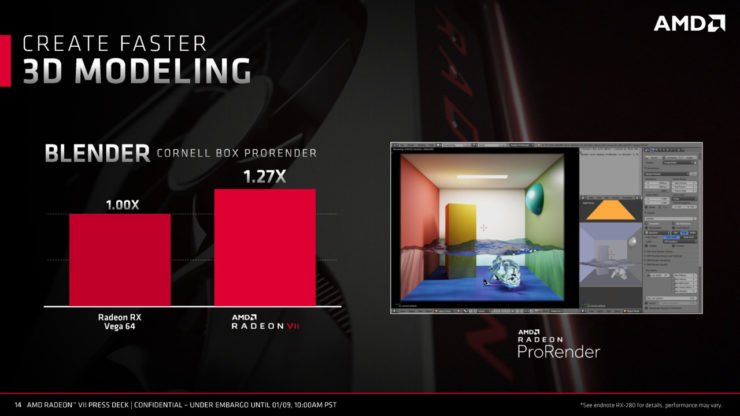

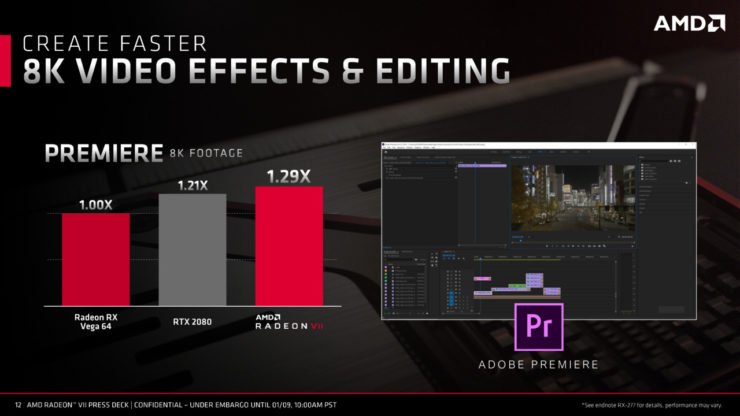

Les rouges ont également fourni divers tableaux comparatifs dans des logiciels de production tels que la modélisation 3D, HDR Luxmark, Adobe Premier et DaVinci Resolve. Vous pouvez retrouver tous les résultats ci-dessous.

La carte graphique AMD Radeon Vega VII sera disponible en février 2019 au prix de 699 dollars.

sauf qu’au-de là de 30fps c’est invisible à l’oeil nu donc 300fps je doute que ça soit utile

pour jouer correctement il faut tourner entre 60 et 100fps pas besoin de carte a 800€

ces cartes ultra haut de gamme sont juste des vitrines technologiques

encore quelqu’un qui a jamais joué sur un ecran 144hz pour sortir ce genre de chose. oui l’oeil ne voie plus les frames à partir de 24image seconde et pas 30; c’est d’ailleurs pour ça que le cinema est en 24ips.

Mais avoir plus de façon stable c’est surtout un gage de fluidité. car c’est pas parce que tu a indiqué 30fps que le jeu est fluide. c’est une moyenne, donc tu peut très bien avoir 15 45 qui change en permanence, l’ecran indiquera 30fps mais ton jeu ne sera pas fluide. ensuite le 144hz en plus de donner un rendu plus fluide donne aussi aux joueurs plus de réactivité car tu y gagne en immersion et donc concentration sans compter que tu aura moins d’input lag et de motion blur et donc forcement tu joue mieux

“tu as ” et non pas”tu a” et “tu peux” et “tu y gagnes “et tu “auras”et “tu joues” bon en informatique mais nul en conjugaison !

C’est juste faux, en 24fps, même en 30 (et même beaucoup plus en fait, même si la vision est un flux continu et ne fonctionne pas par frames), on se rend bien compte que ce n’est absolument pas fluide, sauf a rajouter du flou pour masquer cela. C’est pas par hasard que dans les films (et les jeux) ils rajoutent une tonne de flou de mouvement, sans ça on percevrait très nettement les saccades (voir les plan larges avec mouvement de caméra horizontal au ciné, y a tellement de flou pour masquer que c’est pas fluide que lorsque on met sur pause on se rend compte que c’est vraiment dégueulasse).

Pas pour rien non plus que sur pc il y a généralement une option pour régler la quantité de flou de mouvement sur les portages.

Pas pour rien non plus que Peter Jackson veut (voulait?) imposer les 48 fps pour les films pour avoir une image plus nette, le problème étant que les gens sont tellement habitués au flou qu’un film avec une image plus nette semble trop réaliste et pas assez cinématique.

Un exemple parlant: https://www.geeksaresexy.net/2015/06/10/15fps-vs-30fps-vs-60fps-animated-gif/

Ah et si le ciné est en 24 fps c’est parce que c’était le minimum absolu requis pour avoir une impression de fluidité (avec du flou), et qu’ils ont pris ce minimum pour des raisons techniques et de coûts (la pellicule ça coûtait cher au début, et c’est plus pratique a stocker et manipuler d’avoir des bobines plus petites/moins nombreuses)

c’est pour ca que le seul indicateur utile est le frame minimum, et pas le frame maximum.

savoir qu’au mqx on est a 200 ips n’a aucune importance , alors que savoir si le minimum est bien >25 ips est lui primordial

Je suis surhumain alors ? Car la différence entre 30 et 60 FPS me saute à la gueule. C’est pour cette raison que jouer sur console, c’est une épreuve pour moi. Heureusement, quelques jeux vont au-delà des 30 FPS…

Sans parler des casques de réalité virtuel qui ont besoin de 90 FPS pour éviter que tu dégueules au-delà de la minute…

Je sais pas si c’est du troll ou non mais un oeil c’est pas un écran, ça marche pas en frame, ensuite l’intérêt d’avoir 300fps c’est que si tu drop 3 frames ton jeu est 1% moins fluide, tu drop 3 frame à 30fps et le jeu est 10% moins fluide, avoir le maximum de frame possible permet d’avoir une expérience plus régulière, très utile en milieu compétitif.

J’aurai dis du troll tellement c’est connu depuis des années que ce qu’il a dit est totalement faux mais j’ai la fâcheuse tendance de surestimer les gens du net…

Bon en plus il a précisé “qu’il doutait” donc du coup il se pourrait qu’il était honnête. Oh mon dieu ….

En bref pour ceux qui pensent que l’oeil humain est limité à voir le monde de façon simpliste en FPS pensez juste aux lumières stroboscopiques appliqué à un écoulement d’eau tu vois largement la différence entre du 0.4 ( 25Hz) ou du 0.002 (500Hz)

Même des évènements qui dure 0,001seconde l’oeil peut carrément les voir comme des flashs de lumières… Enfin bon la connaissance est là pour tous certains préfèrent continuer à rien apprendre et diffuser leurs ignorances 🙂

faut pas tout confondre entre la perception de l’œil et celui du cerveau… l’œil percevra autant d’image qu’il sera soumis à la fréquence de la lumière (la lumière naturel, c’est 25Thz il me semble, une ampoule basique c’est 50hz). Notre cerveau nous fais percevoir 72 i/s (plus ou moins selon l’acuité des gens), mais nous commençons à percevoir une animations dans des images fixe successive à partir de 18 i/s, 24 étant une animation ayant un compromis coût/confort d’animation acceptable c’est pourquoi le cinéma l’utilise. mais une animation parfaite pour l’œil humain c’est 72 hz. Ce n’est pas pour rien qu’il est proposé dans les fréquences de rafraîchissement d’un écran en dessous de 75. Le 144hz c’était surtout pour la 3D stéréoscopie active pour justement avoir 72 hz (144/2) pour chaque œil.

elle me fait de l’oeil sérieusement, j’ai une 1080ti largement suffisante mais j suis limité à 4 écran , en plus de mon tri screen et de mon écran 3440×1440 j’aimerais remettre mon vidéo projecteur sur mon PC et seul les CG AMD sont capable de gérer autant d’écrans, avec cette CG enfin capable d’être assez puissante pour mes besoins je serai combler 🙂 ma 1080ti ne sera pas perdue car elle irais par la suite sur mon 2 ième PC de simu de course