Grâce à ses équipes de recherche, Meta développe une nouvelle méthode pour analyser et reproduire ce que notre cerveau perçoit. Une découverte qui pourrait avoir un fort impact dans le domaine médical. En attendant une arrivée dans nos casques VR ?

Enjeu majeur de ces dernières années, le domaine de l’IA continue d’évoluer à une vitesse folle. Alors que Microsoft a récemment annoncé la fusion de Chat GPT et Dall-E, c’est au tour de Meta de nous faire part de ses nouveautés en la matière.

La société de Mark Zuckerberg, qui vient de lancer son nouveau casque VR Meta Quest 3, a publié un article de recherche autour de l’IA et du cerveau. Véritable objet de fascination pour les scientifiques, le cerveau fait partie des organes les plus complexes du corps humain. Ce dernier renferme encore de nombreux secrets, en particulier lorsqu’il s’agit de comprendre comment il décode les stimuli sensoriels de notre environnement.

Pour essayer de répondre à cette question, les scientifiques de Meta ont décidé de tenter une nouvelle approche, qui mixe IA et magnétoencéphalographie. Le but ? Comprendre comment notre cerveau analyse les images que nos yeux perçoivent, pour ensuite reproduire le procédé via l’intelligence artificielle.

A lire aussi : Meta présente RSC, le supercalculateur IA ‘le plus puissant au monde’

Meta utilise l’IA pour décortiquer le cerveau

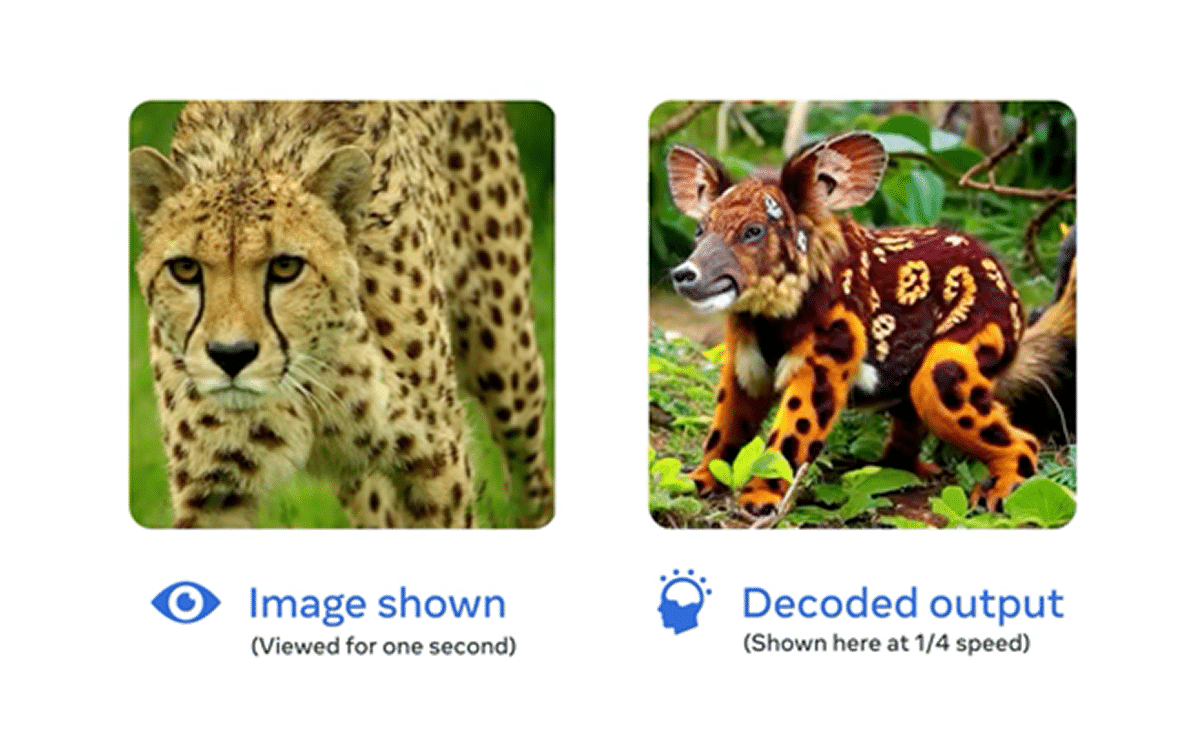

Également connue sous le nom de MEG, la magnétoencéphalographie est une technique d’imagerie cérébrale non-invasive, qui permet d’enregistrer, à la seconde, plusieurs milliers de mesures liées à l’activité de notre cerveau. Grâce à ces données, les chercheurs de Meta ont réussi à développer une intelligence artificielle capable d’analyser et de retranscrire avec précision la manière dont notre cerveau perçoit une image.

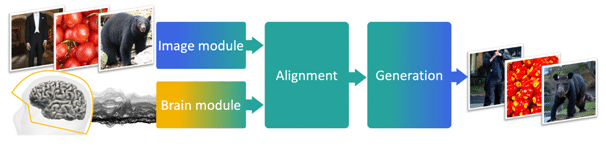

Pour parvenir à cet exploit, les équipes scientifiques se sont appuyées sur leurs précédents travaux, centrés autour de l’analyse de la voix par le cerveau. Ces derniers ont ainsi entraîné leur IA afin de développer un processus découpé en trois parties.

Dans un premier temps, un encodeur d’images compile et analyse, indépendamment du cerveau, une multitude de visuels (voitures, animaux, vêtements…). Suite à cela, un encodeur cérébral apprend à aligner les résultats du MEG sur ceux du premier encodeur. Cela permet au dernier module, le décodeur d’images, de sélectionner des images qui sont théoriquement similaires aux représentations du cerveau étudié.

Des résultats encourageants

Grâce à une base de données publique, Meta a pu entraîner son IA avec des milliers d’images d’objets issus du quotidien. Ainsi, les chercheurs ont constaté que les IA capables d’analyser des images, sans l’aide d’un humain, tendent à représenter une image de manière naturelle. En somme, les réseaux neuronaux de l’IA sont activés de la même façon que ceux du cerveau, lorsqu’ils sont exposés à la même image.

Si pour l’instant, les résultats sont très encourageants, il reste encore un peu de chemin à parcourir avant d’arriver à lire avec exactitude les pensées de notre cerveau. En effet, comme le montrent les visuels de l’article, grâce au MEG, l’IA parvient à générer des images qui sont très proches du résultat initial, mais qui ne correspondent pas forcément.

Comme le souligne l’article, l’imagerie cérébrale fonctionnelle (fMRI) permet d’obtenir des résultats bien plus précis. Toutefois, la solution développée par Meta s’avère plus efficace lorsqu’il s’agit de traiter un grand nombre d’informations en continu. Un point important, en particulier pour pouvoir créer des solutions technologiques dédiées au quotidien.

À ce sujet, les scientifiques de Meta précise que cette avancée devrait permettre de développer des interfaces cerveau-ordinateur afin de venir en aide aux personnes qui ont des problèmes pour parler, suite à des lésions au cerveau. Reste à savoir si ces avancées trouveront également leur salut dans les casques de VR de Meta. Qui sait, d’ici quelques années, ces derniers pourront lire nos pensées, pour le meilleur ou pour le pire.

Source : Blog Meta, things-initiative.org