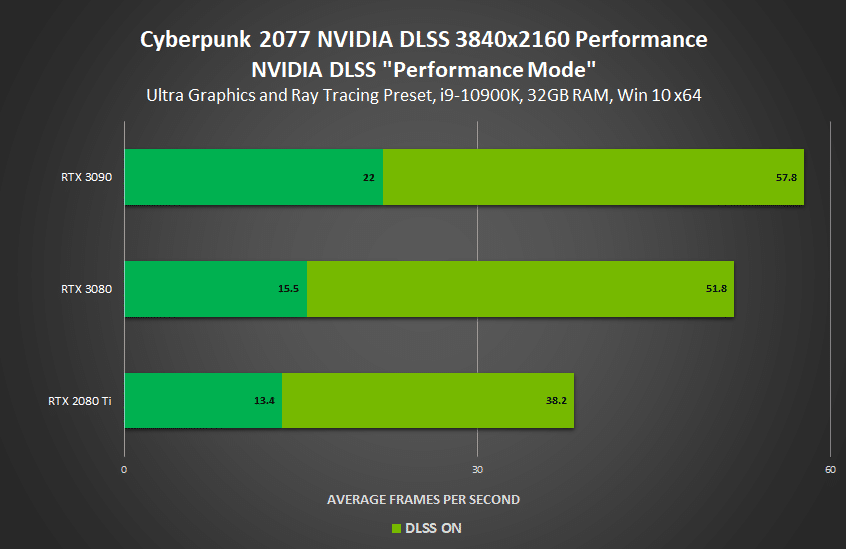

Heureusement, elle permet d’approcher les 60 ips avec le DLSS réglé sur le mode performance.

C’est le grand jour ; après moult reports et plusieurs mois de retard sur la date initialement prévue, Cyberpunk 2077 est disponible. Pour les joueurs PC, NVIDIA a dégainé son pilote Game Ready pour le titre de CD Projekt Red. L’entreprise fournit aussi quelques benchmarks pour ses cartes graphiques RTX. Le jeu bénéficie du DLSS ; et de nouveau, celui-ci va s’avérer indispensable.

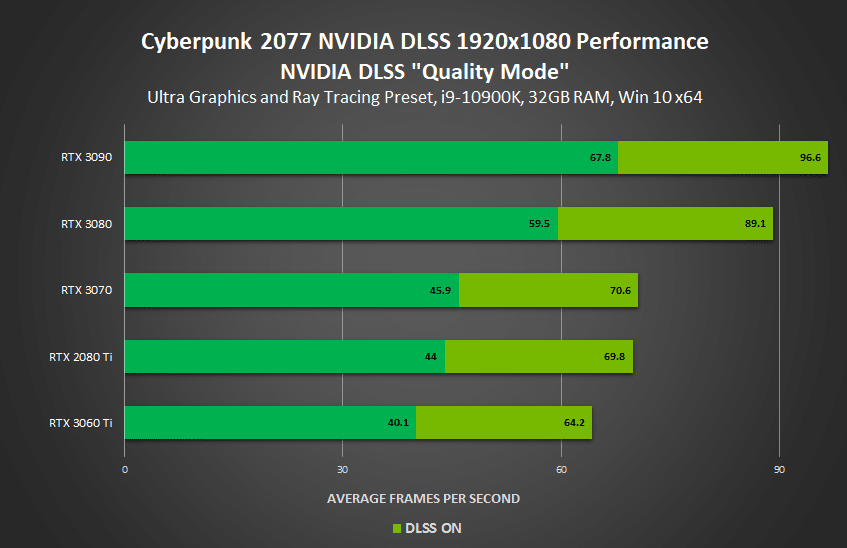

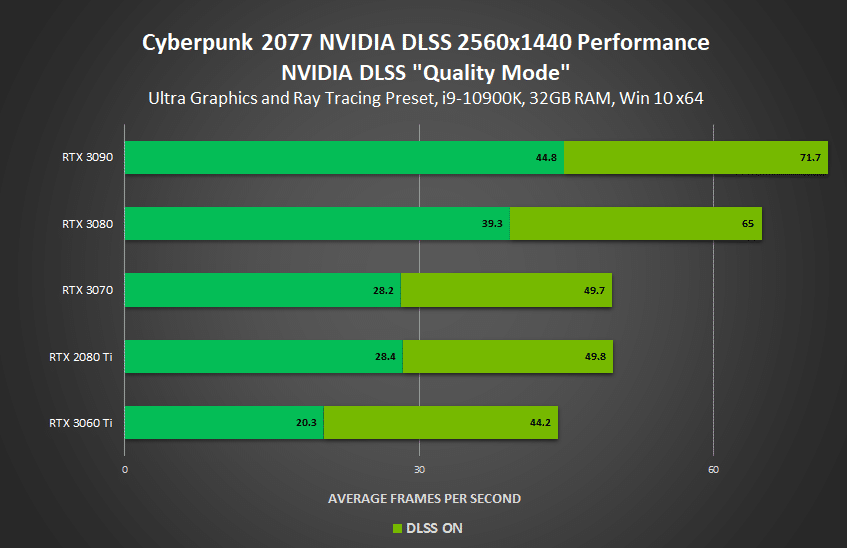

La machine de test de NVIDIA embarque un processeur Intel Core i9-10900K (10 cœurs / 20 threads) et 32 Go de RAM. Elle ne tient pas les 60 images par seconde avec une RTX 3080 en Full HD / Ultra sans l’aide du DLSS. Ne parlons pas de la 4K, où sans DLSS, la RTX 3090 dépasse à peine les 20 images par seconde. De fait, il faudra faire quelques concessions au niveau des réglages si vous souhaitez profiter du titre en 4K. En effet, même avec le DLSS en mode performance, la porte-étendard des RTX 3000 ne parvient pas à délivrer 60 images par seconde.

CD Projekt met en jeu une unique RTX 3080 Cyberpunk 2077 Edition

Les PS4 et Xbox One en difficulté

À l’heure où nous écrivons ces lignes, il y a toujours un embargo sur les benchmarks indépendants. Mais soyez prévenus : les configurations préconisées par le studio polonais seraient assez optimistes. Nos confrères de Tom’s Hardware US avaient publié toute une série de benchmarks ; hélas, ils ont dû les retirer à la demande de CD Projekt, sous prétexte qu’ils n’étaient pas “représentatifs de l’expérience vécue par le consommateur” une fois le patch “Day Zero” appliqué. Dans le dossier, on apprend qu’une GTX 1060 avec 6 Go de VRAM, la carte pourtant recommandée pour du “1080p High”, permet de jouer à environ 40 images par seconde en Full HD.

Par ailleurs, pour ceux qui possèdent une console d’ancienne génération, Xbox One et PS4 “classiques”, les premiers retours sont assez alarmants. Un journaliste d’un célèbre site français de jeu vidéo a notamment mis en garde les détenteurs de ces machines ; en effet, selon lui, ils hériteraient carrément de “versions sacrifiées”.

“Ne parlons pas de la 4K, où sans DLSS, la RTX 3090 dépasse à peine les 20 images par seconde. De fait, il faudra faire quelques concessions au niveau des réglages si vous souhaitez profiter du titre en 4K. ”

Des concessions comme désactiver le Raytracing ptet…

Vous avez pas remarqué mais tous les benchs ont été réalisés en Ultra + Raytracing. Donc normal qu’on ait des framerate aussi limite même avec le DLSS perf qui + est.

Pas la peine de la 4K… la 2K suffit largement.

Pour les PS4 et XBox One, rien de surprenant… Il faut bien se rappeler que ces consoles sont architecturées autour d’un processeur de génération Bulldozer (qui est juste, dans un Pc, un truc vraiment pourri ^^) et une carte graphique pas franchement meilleure.

Les performances de ces consoles ne devaient leurs bon scores qu’à une optimisation logicielle impossible à atteindre sur un Windows qui doit savoir gérer autant de configuration, presque, qu’il existe de Pc.

Hors sur XBox Series et PS5, là, on est sur des architecture Ryzen et des carte graphique de génération Radeon 6xxx, et là, la donne et la puissance sous le capot n’est absolument pas la même…

Vue les prix des cartes graphiques, c’est quand-même scandaleux, ça manque sûrement d’optimisation côté jeu et carte graphique….

Faut arreter de voir le mal partout. Cyberpunk c’est un très bon jeu. Peut etre qu’il aurait pu être mieux optimiser mais je ne pense pas que le repousser encore de plusieurs mois était possible commercialement parlant.

Et même en l’état le jeux est très bien.

Ok, les version FAT sont moyenne mais CD Projekt ca cible les joueurs PC avec des portage vers console.

Ok, une 3090 sans DLSS ne le fait tourner qu’a 20IPS, mais faut se souvenir des Crysis et autres GTA V.

Quand ils sont sorties sur PC, il fallait un trucs qui tienne la route (voir plus) pour y jouer graphisme a fond !

JE trouve que Cyberpunk 2077 est un très bon, il est immersif et je prend plaisir à y jouer.

Ça va 5 minutes le lavage de cerveau voulant nous pousser à acheter des écrans UHD et des GPU à 1500 euros (indisponibles en plus) censés apporter les perfs nécessaires pour cela. A chaque nouvelle génération de GPU (depuis quelques années) on nous bassine avec les GPU HDG qui devraient enfin permettre de se vautrer en UHD toutes les options sur Ultra. Mais c’est comme le gag à la Charlie Chaplin, celui du gars qui avance pour tenter de ramasser son chapeau sauf qu’à chaque pas il fout un coup de pied dedans ce qui l’oblige à avancer et remettre encore un coup de pied dans son chapeau ce qui génère un cercle vicieux.

C’est pareil avec les jeux vidéo, on nous sort des GPU certes plus puissants à chaque nouvelle génération mais en même temps on y rajoute des options ultra gourmandes, parfois des définitions plus larges et les jeux eux-mêmes sont soit mal optimisés soit hyper gourmands ; de temps en temps à juste titre par rapport à ce qu’ils affichent.

Par contre en 1080p et 2K ça passe souvent beaucoup mieux mais à croire que les médias du monde vidéoludique ont oublié que le matos extrême ne concerne qu’une extrême minorité.

Le DLSS sert bien à générer une image de petite définition, et l’agrandir à une plus grande si je me trompe pas. Ici il est clair que la CG ne peut pas produire de la 4K natif pour l’afficher. Dès lors, pourquoi vouloir absolument jouer en 4K ?

J’ai toujours préféré une image propre et nette en définition plus faible, qu’une image plus “flou” ou moins précise dans une définition plus grande.

Bref, pour moi la 4K c’est l’argument “à la con” des constructeurs pour vendre des CG à 1500€…. alors qu’au final, en restant en FHD on garde une qualité tip top pour 50% du prix..

rien à battre 😀 😀 😀

comme tous les jeux, je l’achèterai dans 5-6 ans, à moins de 10€, sur une machine qui le fera tourner sans pb et qui m’aura coûté moitié moins cher que ce qui se fait de mieux actuellement

Le Ray Tracing est beaucoup trop gourmand, pour les configuration actuelle, il faudrat attendre 10 ans pour avoir quelque chose de cohérent.