Toutes les qualités dans une seule mémoire ? On verra bien !

Des chercheurs de l’Université de Lancaster auraient élaboré une mémoire électronique universelle. Celle-ci permettrait de remplacer à la fois la DRAM et la mémoire flash. Manus Hayne, professeur de physique, explique : “la mémoire universelle, qui possède des données stockées de manière sécurisée et facilement modifiables, est largement considérée comme irréalisable, voire impossible. Mais notre appareil démontre ces propriétés contradictoires”.

| À lire aussi : Mémoire flash NAND 3D : 140 couches d’ici l’année 2021 |

La consommation électrique, un enjeu majeur de ces prochaines décennies

En termes pratiques, cette mémoire pourrait supprimer la nécessité d’un démarrage pour les ordinateurs, ou encore les faire passer en mode veille dans un laps de temps très court de manière transparente, par exemple entre deux frappes sur un clavier. Cela entrainerait une importante baisse de la consommation. Une propriété essentielle selon les chercheurs à l’origine de cette découverte, pour qui les ordinateurs et autres appareils connectés ont complètement annihilé les efforts en matière d’économie d’énergie. Ils estiment que d’ici 2025, ces derniers consommeront 20 % de l’électricité produite dans le monde. Leur mémoire universelle réduirait instantanément d’un cinquième cette consommation.

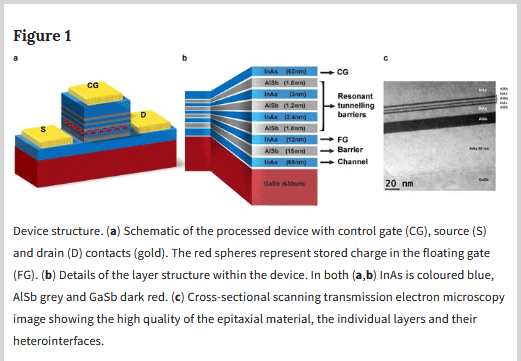

Les chercheurs ont fait appel à des concepts issus de la mécanique quantique pour élaborer cette mémoire. Manus Hayne précise : “notre appareil a une durée de stockage de données intrinsèque qui devrait dépasser l’âge de l’Univers, mais il peut enregistrer ou supprimer des données en utilisant 100 fois moins d’énergie que la DRAM”.

Tous les brevets assortis sont en cours de dépôt. Il faudra toutefois attendre quelques années avant qu’un tel bouleversement ne se concrétise. Les personnes intéressées peuvent trouver toutes les informations complémentaires ici, sous réserve d’avoir de solides connaissances en physique !

Et la marmotte emballe le chocolat.

il paraitrait même que c’est dans du papier alu.

Et à part cela, quels sont vos arguments ?

Ah, vous êtes ingénieurs dans le domaine? Intéressant.

Encore un article qui annonce un truc révolutionnaire alors que dans la réalité ce n’est pas le cas. C’est intéressant pour la recherche, mais c’est tout.

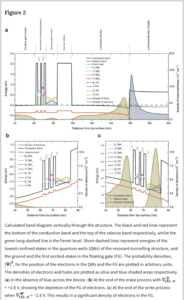

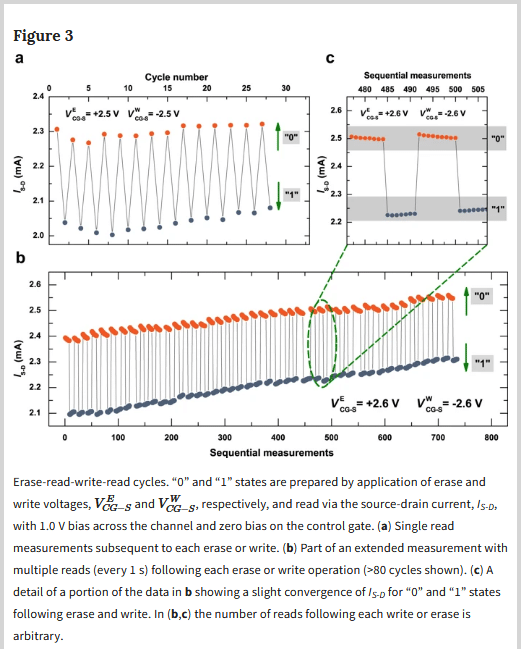

Le temps de rétention de l’information (avant de lui redonner un boost d’énergie comme pour la DRAM) est de 10000s (2.8 h).

Quant à la vitesse de commutation elle est très très lente : 1 s l’écriture et 10ms la lecture …

Je ne suis pas expert mais le dessin montre à peu près les consommations d’un bit 0-1 par seconde par cycle de lecture, d’écriture et d’effacement de la donnée et certaines variantes non constantes de pertes de données comme montre le zoom entre 480 et 500 séquences de cycles qui démontre le risque de perte de données lorsque les cycles de lecture, écriture et d’effacement augmentent

L’intensité en mA (milliampère) et la tension en V (Volt).

Sur la description complète des essais l’objectif était de maintenir la densités d’électrons à l’équilibre et sous polarisation afin de ne pas obtenir de volatilité (pertes de données) et ce à très basse tension pour commencer ≤ 2,6 V à température ambiante.

Pour simplifer pour les novices on va dire que votre mémoire Ram, SDRAM, Flash il y a des électrons stocké dedans avec différentes couches qui permettent de les garder qui leur permettent de se déplacer pour transmettre l’information (le bit 0-1) lors d’une impulsion électrique (Volt) à une certaine intensité le temps d’un cycles mais qui se dégradent au fil du temps et par nombre de cycles ou qui ne peut se maintenir constamment en mémoire

Le protocole du test effectué est qu’avec ces électrons ils ont réussi grasse à différentes barrières à stimuler les électrons afin que ceux-ci transmettent l’information sans volatilité avec un système de triples tunnels et de pouvoir utiliser ces électrons au besoin.

Pour les novices ce qui ne comprennent pas l’efficacité de ce test s’est l’ouverture à de nouveaux types de mémoire à très basse tension et à très basse intensité pour l’IA intelligence artificielle, la vidéo, la transmission des données…

Le fait d’arriver à ce résultat va permettre d’arriver ensuite au second stade à maîtriser la technologie photonique qui viendra remplacer l’électron et une fois cette particule de lumière maîtrisée d’ici 30-50 ans arrivera que bien plus tard le quark qui prendra le relais.

Désolé d’avance pour les erreurs grossières orthographe ou de grammaire vu l’heure 🙁

L’essentiel j’espère est que l’on m’ai compris 🙂

réponse intéressante pour la partie technique. Néanmoins il ne faut pas oublier un gros soucis qui freine ce type d’avancer technologique depuis des années, le sacro saint monopole de l’argent et de la rentabilité qui ralenti voir bloque toute avancée majeure.

Cette techno est très prometteuse mais l’implémentation réelle est une autre paire de manche.

Quand on voit le marché actuel, il y a très peu d’entreprises qui sont à jour en terme de technologie et qui travail avec du matériel récent (moins de 2 ans) qui apportent déjà des avancées en terme de consommation/perfs par rapport à il y a 10-15 ans.

Restons tout de même optimiste pour l’avenir.

Le probleme c’est aussi betement la degradation chimique et atomique … Mais bon cela avance disons que c’est encore de la theorie et on est loin de la phase de production … a voir