Grâce aux dernières avancées en matière de path tracing et d’IA générative, Intel envisage de gérer cette technologie à partir d’iGPU. La GeForce RTX 4090 prochainement ratatinée par une solution UHD ?…

Ce n’est pas une énorme révélation, le ray tracing, et a plus forte raison ce que NVIDIA appelle dorénavant le path tracing – la technologie simulant intégralement la physique de la lumière, disponible sur deux titres, Portal avec RTX et Cyberpunk 2077 RT Overdrive – est très gourmand en ressources GPU. Les ingénieurs logiciels d’Intel ambitionnent d’améliorer drastiquement l’efficacité des algorithmes de rendu et d’IA générative. Leur objectif est de parvenir à simuler le path tracing sur… des iGPU.

Les chercheurs décrivent ce travail d’optimisation du path tracing dans un document en vue d’un exposé au SIGGRAPH 2023 (un événement professionnel consacré au graphisme digital, au design graphique et aux technologies interactives ; l’édition de 2023 se déroulera aux États-Unis, plus précisément au Centre de conventions de Los Angeles, du 6 au 10 août) intitulé Path Tracing a Trillion Triangles.

Trois axes pour améliorer la simulation du path tracing…

Les auteurs précisent :

« Tout au long du processus de path tracing, les recherches présentées dans ces articles démontrent des améliorations de l’efficacité des principaux éléments constitutifs, à savoir le lancer de rayon [ray tracing], l’ombrage et l’échantillonnage. Il s’agit d’aspects importants pour rendre le rendu photoréaliste avec le path tracing disponible sur des GPU plus abordables, tels que les GPU Intel Arc, et d’une étape vers sa mise en œuvre en temps réel sur les GPU intégrés ».

Notez que l’article évoque les solutions intégrées d’Intel, mais que les auteurs prévoient bien une solution open source.

Globalement, l’idée est donc de trouver le moyen de réduire le nombre de calculs nécessaires pour simuler le path tracing.

Le document décrit trois axes. Déjà, pour commencer, il rappelle le principe de base de cette technologie : au moment où un photon touche une surface, il doit être ombré et sa diffusion sur la surface doit être simulée selon le type de matériau de l’objet.

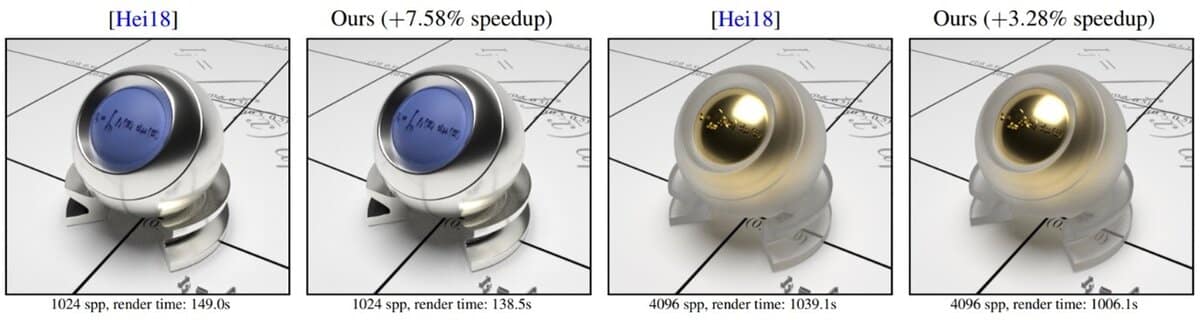

Le premier article présente une nouvelle méthode, plus efficace, pour calculer la réflexion d’une surface à microfacettes GGX – le modèle de matériau standard utilisé dans l’industrie du jeu, de l’animation et des effets visuels. Grossièrement, les matériaux sont réduits à un miroir hémisphérique bien plus simple à simuler.

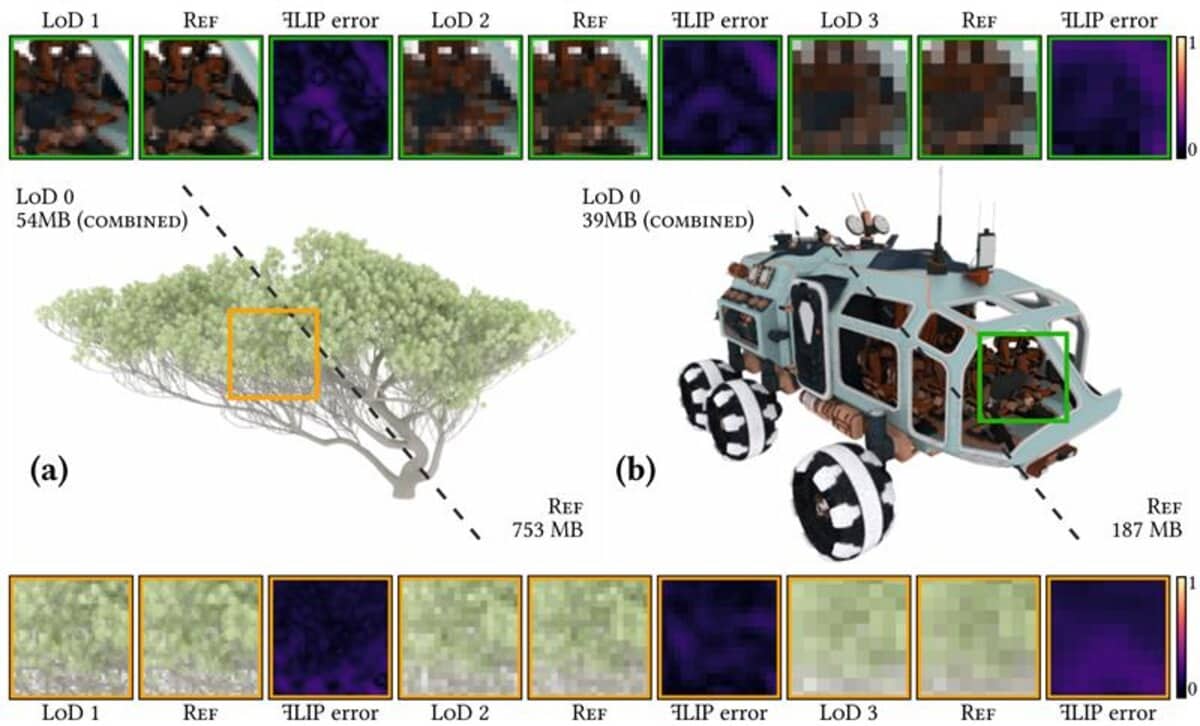

Le second article propose une méthode plus rapide et plus stable pour rendre les surfaces scintillantes. Afin de réduire la charge de travail GPU, la méthode consiste à définir à l’avance le nombre moyen de pixels visibles à l’œil.

Le dernier article, excessivement technique, détaille une méthode optimisée de simulation dans différents scénarios d’éclairage, connue sous le nom de Markov Chain Mixture Models for Real-Time Direct Illumination.

… à grand renfort d’IA générative

Enfin, les autres aspects sur lesquels travaillent les équipes d’Intel sont l’IA générative via des dispositifs neuronaux (toujours pour le path tracing en temps réel). Selon la publication, la nouvelle représentation neuronale du niveau de détail permet d’obtenir une compression de 70 à 95 % par rapport au path tracing « classique ».

Les auteurs de l’article le concluent en ces termes :

« […] dans cet exposé, intitulé Path Tracing a Trillion Triangles, nous démontrons qu’avec des algorithmes efficaces, le path tracing en temps réel nécessite un GPU beaucoup moins puissant, et peut être pratique même sur des GPU de milieu de gamme et intégrés à l’avenir. Dans l’esprit de l’écosystème logiciel ouvert d’Intel, nous rendrons ce cadre multi-fournisseurs open source en tant qu’échantillon et banc d’essai pour les développeurs et les praticiens ».

Du path tracing sur iGPU, un vœu pieux ?

« Démocratisé » depuis 2018 avec le lancement des cartes graphiques GeForce RTX 2000 (Turing), le ray tracing reste à ce jour une technologie nécessitant une énorme puissance de traitement, d’autant plus à mesure que les définitions augmentent. Même la carte graphique la plus performante en matière, la GeForce RTX 4090, ne parvient pas systématiquement à maintenir 60 images par seconde dans les jeux récents avec ray tracing.

Pour parvenir à proposer du ray tracing dans des définitions élevées à un framerate décent, AMD comme NVIDIA misent essentiellement sur leurs technologies de mise à l’échelle, le FSR (FidelityFX SuperResolution) et le DLSS (Deep Learning Super Sampling). Dans le cas de la dernière version du DLSS (DLSS 3) la méthode consiste à ne « véritablement » calculer qu’une infime partie des pixels (jusqu’à 1/8e) et à rendre les autres grâce à l’IA et aux Tensor Core, donc de façon simulée.

Sur PC, gérer du ray tracing à partir d’un iGPU, disons dans une définition au moins Full HD, n’est donc clairement pas encore l’ordre du jour. Certes, les concepteurs de SoC pour smartphones ont commencé à proposer une accélération matérielle du ray tracing (Exynos 2200 par Samsung et AMD ; Snapdragon 8 Gen 2 chez Qualcomm ; Dimensity 9200 chez MediaTek) ; mais cela fait dans des définitions bien plus faibles ; en outre, nous n’avons pas de connaissance de jeux mobiles exploitant cette technologie, laquelle reste pour l’instant cantonnée à des benchmarks.

À mesure que les algorithmes de simulation du path tracing, les technologies de mise à l’échelle et plus prosaïquement la composante hardware vont s’améliorer, le ray tracing sur iGPU deviendra peut-être une réalité. Reste que pour les productions récentes en ray tracing, l’optimisation est souvent très discutable.

Source : Intel