Introduction

Depuis le début 2007, on assiste avec plaisir à une évolution en profondeur de l’informatique personnelle : l’avènement des écrans tactiles. Avec l’iPhone d’Apple d’abord, puis avec Surface de Microsoft, le public a découvert qu’il est aujourd’hui possible de commander un ordinateur au(x) doigt(s), et d’interagir avec la machine de façon beaucoup plus humaine qu’au travers d’une souris et d’un clavier.

Depuis le début 2007, on assiste avec plaisir à une évolution en profondeur de l’informatique personnelle : l’avènement des écrans tactiles. Avec l’iPhone d’Apple d’abord, puis avec Surface de Microsoft, le public a découvert qu’il est aujourd’hui possible de commander un ordinateur au(x) doigt(s), et d’interagir avec la machine de façon beaucoup plus humaine qu’au travers d’une souris et d’un clavier.

Pourtant, les écrans tactiles sont très loin d’être une technologie “nouvelle” ou inédite. Les premiers prototypes ont vu le jour dans les années 1970. Et personne ne s’étonne plus depuis une dizaine d’années d’avoir sur son PC portable un “trackpad”, ou de pouvoir commander ses billets de train en touchant l’écran d’une borne automatique. Alors pourquoi l’iPhone et Surface ont-t-ils semblé à ce point révolutionnaires ? Et que peut-on attendre des prochaines années ?

Bref historique

Interagir avec la machine de manière plus “humaine” a toujours été un des buts des chercheurs en informatique. À voir la persistance de notre préhistorique clavier AZERTY, on se dit qu’il n’ont pas eu beaucoup de succès dans leurs recherches. Et pourtant. Dès 1972, IBM a jeté un énorme pavé dans la mare, en présentant son PLATO IV. Cet ordinateur en avance sur son temps utilisait un écran plasma, et un système de reconnaissance du toucher par infrarouge. Système dont des déclinaisons sont toujours employées et commercialisées aujourd’hui.

Des technologies vieilles de 30 ans

Oui mais me direz-vous ce système était monopoint, alors qu’aujourd’hui l’iPhone est multitouch, capable de prendre en compte l’action de plusieurs doigts simultanément. Certes, mais les premiers systèmes multitouch datent eux aussi. Par exemple, en 1984, les laboratoires Bell ont ainsi mis au point un écran CRT (forcément) recouvert d’une surface tactile capacitive capable de suivre plusieurs doigts.

Bref, les écrans tactiles sont de l’histoire plutôt ancienne. Alors pourquoi tous les PC n’en sont-ils pas encore équipés ? L’une des raisons est qu’on n’a pas encore trouvé la technologie idéale, adaptée à toutes les machines, et exempte de défaut. Pour le comprendre, voici un petit panorama des techniques existantes.

Les écrans résistifs

Commençons par la technologie la plus économique : les écrans résistifs. Dans un écran résistif, la surface de verre de l’écran CRT ou LCD est recouverte d’une couche tactile souple. La détection du toucher se fait par la pression exercée.

Comment ça marche ?

Avantages

Cette technologie est très bon marché. Par ailleurs elle sensible à toutes formes de toucher, que ce soit avec le doigt, ou avec un stylet. Elle n’est pas non plus affectée par la présence de poussière, ou de gras ou d’eau à la surface de l’écran. De plus sa précision et suffisamment bonne pour un très grand nombre d’usages. Cependant, elle possède également un certain nombre de défauts.

Inconvénients

En premier lieu, l’ensemble des couches tactiles est assez peu transparent. Elles consomment en général 20 à 25 % de la luminosité de l’écran. Qui plus est l’accumulation de couches d’indices de réfraction différents peut générer des reflets, et nuit aux angles de vision de l’écran.En outre, du fait de leur souplesse, ces couches sont assez fragiles. Elles sont notamment sensibles aux griffures voire même aux entailles créées par des objets pointus.

Résistants malgré tout

Les écrans capacitifs

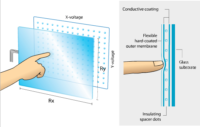

Les écrans capacitifs forment la deuxième classe la plus répandue d’écrans tactiles. Leur conception diffère fortement de celles des écrans résistifs, mais les deux possèdent des similitudes. Comme précédemment, cette technologie repose sur l’utilisation d’une couche tactile, déposée à la surface de l’écran.

Comment ça marche ?

Ici, la surface en verre de l’écran est recouverte d’un dépôt conducteur, généralement de l’ITO (Indium Tin Oxide, oxyde d’étain et indium). Ce matériau est en effet transparent lorsqu’en très faible épaisseur. Cette couche est reliée à des électrodes déposées sur les bords de l’écran. Ainsi, on crée un champ électrique uniforme à la surface de l’écran, autrement dit cette surface est uniformément chargée. L’approche d’un doigt perturbe le champ électrique : une certaine quantité de charges est transférée vers le doigt. Cette perturbation est là encore relevée par l’électronique de contrôle.

Dans les premiers écrans capacitifs, la couche d’ITO était exposée à l’extérieur. Elle s’érodait donc assez rapidement, limitant la durée de vie du produit. Aujourd’hui, les algorithmes de détection ont suffisamment progressé pour que la couche d’ITO puisse être éloignée du doigt pointeur. Du coup, la surface de l’écran est simplement constituée de verre vierge. Il n’y a donc plus de problèmes d’usure.

Pas la panacée

Les écrans capacitifs ont comme principal avantage de diminuer beaucoup moins la luminosité de l’écran. La faible épaisseur du dépôt garantit une très bonne transparence (plus de 90 %). D’autre part, ils présentent une excellente résolution. Le module de contrôle est en outre compact.

Mais ils restent nettement plus chers que les résistifs. En outre, ils sont sensibles uniquement à la présence de corps conducteurs. Un doigt nu est idéal, mais un stylet est inopérant, tout comme un doigt ganté. Ils sont aussi sensibles à la présence d’eau ou d’humidité à la surface de l’écran.

Incontournables

Au bilan, les avantages des écrans capacitifs l’emportent sur leurs inconvénients pour de nombreuses applications. Citons notamment l’incontournable iPhone d’Apple. Dans ce cas précis, afin de rendre l’écran “multitouch”, il a fallu qu’Apple découpe l’écran en différentes zones, créant une grille d’électrodes disposées sous l’écran. Citons également les trackpads ou touchpads de 99 % des PC portables du marché, même si dans ce cas particulier, il ne s’agit pas d’écrans.

Wacom, N-Trig et les Tablet PC

La niche des tablettes graphiques

Restons encore sur les technologies purement électroniques. Un cas très intéressant est celui des tablettes graphiques Wacom. La technologie Wacom est similaire à celle des écrans capacitifs. Sauf qu’ici c’est la perturbation du champ magnétique qui est détectée. La tablette cache dans ses entrailles des bobines électriques. Une autre bobine est insérée dans le corps du stylet. En fonctionnement, un courant alternatif circulant dans les bobines de la tablette génère un champ magnétique. Ce champ excite la bobine présente dans le stylet, et y créé un courant. C’est le phénomène d’induction.

Le stylet se trouve donc alimenté par la tablette, et peut donc posséder des boutons indépendants. Cette technologie est très précise et particulièrement bien adaptée aux tablettes graphiques. Par contre, elle n’est pas à proprement parler “tactile” puisque le pointage au doigt est impossible : il faut utiliser le stylet spécifique.

Élargissement aux Tablet PC

Au-delà des tablettes graphiques, la technologie EMR de Wacom a trouvé un autre débouché dans les Tablet PC, les plus luxueuses. Dans ce cas, la technologie Wacom a un avantage décisif puisqu’elle peut conserver sa précision tout en étant dissimulée sous la dalle TFT LCD, ce qui préserve intégralement la luminosité de l’écran. Par ailleurs, la technologie EMR Wacom peut aussi être combinée à un classique écran tactile résistif pour bénéficier à la fois du pointage au stylet et du pointage au doigt. Mais ce n’est pas une solution idéale puisqu’on retrouve les inconvénients des écrans résistifs.

Pour ne pas rater le coche des écrans tactiles, Wacom a développé une autre technologie, dévoilée tout récemment : la RRFC pour Reversing Ramped Field Capacitive. Il s’agit d’une variante des classiques écrans capacitifs. Ici, au lieu d’appliquer un unique champ électrique uniforme sur la surface de l’écran, Wacom établit quatre champs différents, d’amplitude augmentant progressivement. La multiplication des champs électriques permet d’augmenter la précision de la détection, et sa fiabilité notamment lorsque la source d’alimentation de la machine est une batterie.

Là encore, cette technologie “Touch” peut être combinée à l’EMR, pour offrir un écran à la fois sensible au doigt ou au stylet.

N-Trig, le même, multipoint

Reste que Wacom ne propose pour l’instant encore aucune technologie “multitouch”, un manque curieux pour une société si présente sur le marché des écrans tactiles. Du coup, pour son premier Tablet PC – le Latitude XT – Dell a boudé Wacom et a préféré une start-up israélienne : N-Trig. En plus d’être multipoint, la technolgie de N-trig est hybride, et permet donc l’utilisation au doigt ou au stylet. N-trig est pour l’instant la seule société sur le marché à proposer une telle combinaison, et le Latitude XT est donc un PC unique en son genre.

Et pourtant, les bases techniques semblent très proches de celles de Wacom : un stylet à induction, couplé à un écran capacitif pour le toucher au doigt. Gageons que Wacom et d’autres rejoindront bientôt le trublion israélien sur ce marché prometteur.

Voilà pour les technologies, électroniques. Mais il y a d’autres moyens de rendre un écran, ou une surface, tactile, qui reposent sur une détection optique.

La FTIR de Jeff Han

FTIR : Frustrated Total Internal Reflection ou en français réflexion interne totale contrariée. Cette technologie repose sur un phénomène optique bien connu et exploité par exemple dans la fibre optique : la réflexion totale. Lorsque la lumière se propage d’un matériau à un autre sa direction est modifiée à chaque interface, car tous les matériaux n’ont pas le même indice de réfraction. Mais pour chaque interface, il existe un angle d’incidence sous lequel le flux lumineux est totalement réfléchi. En émettant le faisceau lumineux précisément sous cet angle, il donc possible de le piéger à l’intérieur d’un matériau.

Le Magic Wall

Dans un écran tactile FTIR, une rangée de LED émet donc un faisceau lumineux infrarouge dans l’épaisseur de la dalle en verre de l’écran. Et lorsqu’on pose un doigt sur l’écran, on brise localement le phénomène de réflexion totale, le doigt réfléchissant la lumière infrarouge d’une manière différente que l’air ambiant. Cette perturbation est détectée par une caméra disposée derrière l’écran. Cette technologie a beaucoup d’avantages : elle est facile à mettre en oeuvre, peu chère et facilement adaptable à des écrans de très grande taille, sensible à n’importe quel type de “toucher”, peu sujette à l’usure. Par contre, l’état de surface de l’écran doit rester suffisamment bon pour maintenir la réflexion.

La FTIR n’est encore pas utilisée dans des produits commerciaux. En tout cas pas grand public. Les industriels et grandes entreprises commencent par contre à employer des écrans géants dotés de cette technologie. Par exemple, CNN y a eu recours pour illustrer les résultats des élections primaires aux présidentielles Américaines depuis le début de l’année.

Ce qui est rare est cher

Ce type d’écran est notamment vendu par Jeff Han, et sa société Perceptive Pixel. Ce chercheur de l’université de New York, rendu célèbre par les vidéos où on le voit utiliser ses écrans tactiles FTIR pour manipuler des cartes, des images par une gestuelle rappelant Minority Report. Grâce à cela, et à la qualité de ces écrans, Han est devenu un gourou du tactile. Il a participé dernièrement au salon NVISION aux côtés de Jen Hsun Huang.

Pour l’anecdote, si vous mourez d’envie d’installer un écran similaire dans votre salon, sachez que vous pouvez le commander à Neiman Marcus, pour la modique somme de… 100 000 $. Heureusement, on trouve presque aussi bien, pour nettement moins cher.

L’infrarouge : Albatron et HP

Une autre technique est celle employée sur l’écran tactile 22 pouces présenté par Albatron au dernier Computex, ou encore sur le PC TouchSmart d’HP.

Le tactile du pauvre

Dans ce cas de figure, des diodes infrarouges disposées autour de l’écran génèrent un faisceau de lumière très mince à la surface de l’écran. Des capteurs disposés eux aussi autour de l’écran détectent la coupure du “tapis” infrarouge recouvrant l’écran.

Cette technique présente à peu près les mêmes avantages que la FTIR : possibilité d’utiliser son doigt ou tout autre objet opaque, cout faible, pas de dégradation de la qualité d’affichage, facilement adaptable à des dalles de grande taille, peu sujet à l’usure. Par contre, cette technologie possède une précision plus faible. En effet, le toucher est détecté un peu avant que le doigt n’atteigne vraiment la surface de l’écran, ce qui reste perturbant.

Microsoft Surface et Touchwall

Une autre technique très prometteuse est le suivi vidéo. Le principe est proche de ceux que nous venons d’évoquer. Mais pas tout à fait. Prenons l’exemple de Surface de Microsoft.

Cette table est composée d’une épaisse feuille d’acrylique servant de surface de projection. L’image est formée dessus par un classique vidéoprojecteur utilisant la technologie DLP. Jusque-là, rien de bien différent d’une installation home cinema classique. Pour rendre ce bête écran intelligent, Microsoft a rajouté une source de lumière infrarouge, et de multiples caméras infrarouges. La source IR projette sa lumière sur toute la surface de l’écran. Lorsqu’un objet ou un doigt s’approche, il forme une ombre, qui est vue par les caméras. Un traitement d’image se charge ensuite de déterminer la position, et le mouvement.

Les doigts, les objets aussi

Plus intéressant, grâce à cette technique, l’écran peut reconnaître des objets, et interagir avec eux. Par exemple, Surface sait reconnaitre un appareil photo posé à sa surface, et active alors des fonctions supplémentaires comme l’échange de photos. De même avec un téléphone mobile. Dès lors, les possibilités d’utilisation sont décuplées et on découvre un tout autre pan de ce que peuvent apporter les écrans tactiles à l’informatique.

Un mur moins cher qu’une table

Mais ce concept de table interactive est assez déroutant alors que l’on est habitué à des écrans verticaux face à soi. Microsoft a donc décliné la même technologie tactile dans un format plus habituel : TouchWall. Le principe ? Un vidéoprojecteur illumine un écran dépoli vertical par l’arrière, un jeu de trois lasers forme un tapis de lumière d’infrarouge sur la surface avant de l’écran et une caméra infrarouge détecte l’irruption de tout objet.

TouchWall est donc un mélange de la technologie de Surface et celle des écrans Albatron et HP. L’avantage de TouchWall est qu’il aurait un cout de fabrication nettement inférieur à Surface. Microsoft a parlé de quelques centaines de dollars, alors que la table tactile est commercialisée à environ 10 000 $ l’unité.

Et l’Open Source dans tout ça ?

A nouvelle technologie, nouvel enjeu

Pourquoi l’iPhone a-t-il connu un tel succès ? Pourquoi les vidéos de Jeff Han utilisant les écrans géants de son invention, ou de Surface impressionnent-elles autant ? Parce que ce sont des écrans tactiles, et multipoints ? Non, ces technologies existent depuis de nombreuses années. Parce qu’Apple et Perceptive Pixel ont mis au point des interfaces logicielles excellentes, laissant l’utilisateur réellement profiter de la puissance du matériel ? Bingo ! Et cela montre tout l’enjeu, le défi qui se pose aux développeurs et aux ergonomes.

Il est temps pour eux d’oublier la souris, et le clavier, les menus déroulants et les icônes illisibles. L’avenir d’une bonne partie de l’informatique sera tactile, et il faut donc adapter les interfaces à ce nouveau mode d’interaction avec la machine. Apple et Microsoft ont ouvert la voie, avec dans chaque cas une conséquence fâcheuse : le prix et l’exclusivité. Il y a donc un risque que les interfaces tactiles restent réservées aux riches clients de quelques grosses firmes.

Deux kits de développement

Pour éviter cela, pour mettre au point de nouvelles interfaces, réfléchir à de nouveaux usages des ordinateurs personnels, il faut que les développeurs indépendants puissent expérimenter eux-mêmes ces nouveaux matériels, à un coût raisonnable. La solution trouvée fut de réaliser un équivalent en kit à monter soi-même de Surface. Et c’est ainsi que sont nés CUBIT et TouchKit. Petite différence toutefois, ces prototypes utilisent la technologie FTIR. Le Touchkit vendu 1600 $ comprend donc :

- un écran

- les émetteurs IR

- la caméra IR

- les logiciels nécessaires : (API, étalonnage de l’écran, reconnaissance optique des touchers)

Ne reste que plus qu’à ajouter un vidéo projecteur standard, et de relier le tout à un PC. Le projet a rencontré un certain succès. Aujourd’hui, 200 kits ont été vendus, et la communauté de développeurs compte entre 500 et 1000 membres. Mais aucune réalisation complète digne de Surface n’a encore fait parler d’elle.

Un écran multitouch géant pour 50 €

Si les 1600 $ du TouchKit sont encore trop pour vous, sachez que vous pouvez vous transformer votre propre écran en une surface tactile multipoint pour la modique somme de 50 €. Par quel miracle ? Tout simplement en recyclant votre Wiimote.

La télécommande de la console de Nintendo cache en effet en son sein une caméra infrarouge et les circuits de détection des mouvements nécessaires au suivi de quatre points. Ce constat a donné une idée à Johnny Chung Lee, un étudiant de l’université Carnegie Mellon travaillant sur les écrans tactiles. Voici sa recette :

- Prenez un Wiimote (bien fraîche), un vidéoprojecteur, deux ou trois stylos billes, un PC pas encore grillé, et des LED infrarouges

- Reliez le vidéoprojecteur au PC, allumez, laissez reposer dans un coin

- Récortiquez soigneusement les sytos billes, jetez les viscères, pardon, les cartouches, et ne conservez que les corps

- Insérez une LED IR dans chaque coquille de stylo. Reliez à une source de courant quelconque, par exemple une pile glissée elle aussi dans le corps du stylo.

- Installez la Wiimote face à l’image formée par le vidéoprojecteur, de sorte qu’elle puisse voir l’image dans son ensemble (une Wiimote en bonne santé a un angle de vision inférieur à 45°)

- Téléchargez et installez le programme écrit par Chung Lee permettant au PC de reconnaître les informations en provenance de la Wiimote comme des mouvements de la souris.

- Allumez les stylos, et admirez votre chef-d’oeuvre !

Pour des explications plus imagées, vous pouvez jeter un oeil à la vidéo ci-dessous.

Conclusion

Nous sommes très loin d’avoir fait un tour d’horizon complet du paysage des écrans tactiles aujourd’hui. Il existe encore bien d’autres technologies, n’ayant jamais percé, ou encore embryonnaires. Citons par exemple LucidTouch, développé par Mitsubishi et Microsoft, qui permet de simuler un écran transparent. On peut pointer par derrière l’écran et on voit “ses mains” en ombre chinoise sur l’écran. Ceci permet de pallier l’un des inconvénients des écrans tactiles, qui est que l’on cache nettement plus par ses doigts ce que l’on veut montrer.

Mais ce que nous vous avons exposé ici permet de se rendre compte de deux choses. La première est que les technologies qui apparaissent aujourd’hui sur des prototypes, et que l’on croirait sorties de films d’anticipation (qui a parlé de Minority Report ?) ont en réalité été pour la plupart inventées il y a vingt ou trente ans. Mais ces technologies étaient en avance sur leur temps : trop chères, trop complexes à implémenter dans des PC qui découvraient tout juste les interfaces graphiques. Aujourd’hui la donne a changé, et ces obstacles ne sont plus. Les succès de Jeff Han, de Microsoft et d’Apple ont donc donné le top départ d’une nouvelle course pour l’informatique moderne : la course au toucher.

Dans cette course, les trois premiers semblent avoir une longueur d’avance, mais en réalité, de très nombreuses sociétés ont déjà des prototypes dans leurs laboratoires. Mais si le champ reste très ouvert du point de vue matériel, du côté logiciel les choses risquent bien de se figer rapidement. Apple comme Microsoft ne font guère mystère de leur volonté d’ajouter la “tactilité” aux interfaces des prochaines versions de leurs systèmes d’exploitation respectifs. Monsieur Tout-le-Monde et Madame Michu devraient donc pouvoir en profiter très bientôt. Mais quelle place ce nouveau sens prendra-t-il dans l’utilisation quotidienne des PC ? Certains vont jusqu’à prédire la disparition des souris d’ici cinq ans. À voir. En tout cas, comme on dit dans ces cas-là : vivement demain !