La 4K est énormément gourmande en puissance, et énergivore, pour un bénéfice négligeable, mais le marketing l’ignore…

Dans un éclair de franchise, Dino Patti, développeur de jeux vidéo, explique que les créateurs de jeu n’ont que faire de la 4K, mais que le marketing des fabricants de consoles et de TV poussent cette définition en dépit du bon sens. Nous sommes totalement d’accord.

Et ce n’est pas terminé, puisque dans leur fuite en avant, les fabricants de TV lancent déjà des écrans 8K, encore plus inutiles, surtout en l’absence de contenu. “Les fabricants ne respectent pas l’évolution naturelle des jeux et imposent les technologies” expliquent Patti.

Trop gourmand, trop tôt, et inutile

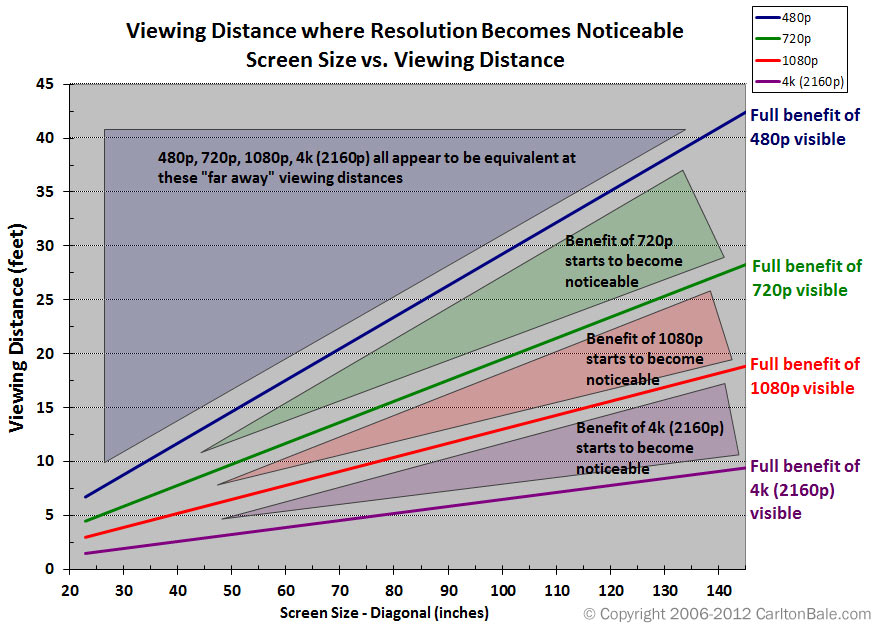

La 4K est beaucoup trop gourmande en ressources graphiques, nécessitant des GPU ultra-puissants pour taquiner les 60 ips. Le bénéfice est très faible pour l’utilisateur, qui ne verra pas vraiment la différence à 3 mètres de son téléviseur 55 pouces, à moins d’avoir des yeux de lynx.

Un graphique un peu exagéré, mais c’est l’idée…

Nous pensons que les joueurs préfèrent pousser le nombre d’images par seconde, quitte à rester en Full HD (la définition encore la plus répandue sur PC), voire QHD (que nous pensons être la définition parfaite sur un 27 pouces). Le bénéfice de profiter d’un jeu à 120 images secondes sur un écran 120 Hz (et plus !) est largement plus appréciable que de faire galérer sa machine en 4K en achetant du matériel hors de prix.

“Concernant les graphismes, si vous êtes vraiment mordu d’un jeu, vous diminuez habituellement les options graphiques pour obtenir des performances maximales. Donc je ne me soucis guère des graphismes. En fin de compte, le gameplay est toujours l’élément clé” renchérit Guðmundur Hallgrímsson, co-fondateur de Klang Games, lors du même événement Reboot Develop au Canada. Difficile de le contredire.

Pourquoi diminue t’on les options graphiques ?

Perso, je diminue surtout les filtres alacon car ils n’apportent pas grand chose sur mon 28″ (DPI élevé).

Résultat des courses, Rise of the tomb raider en 4K : 45 à 70 ips avec une Radeon RX580 (sous GNU/Linux, noyau 5.3, MESA 1.19 stable)

pourquoi retirer des effets pour monter en résolution ? Drôle d’idée selon moi mais why not.

Pour être passer du 1080p au 1440p il y a un peu plus d’1 an, je vois une net différence sur la finesse de rendue. Par contre du 1440p au 2160p, la diff sur un taille de dalle inférieur à 60″ m’apparaît négligeable comparée à la puissance nécessaire pour faire tourner le contenu 3D temps réel à un framerate confortable.

Clairement le marché pousse vers l’adoption de résolution tjs plus élevées mais au détriment du reste (puissance nécessaire, consommation en forte hausse, impacte écologique, etc….)

Sur un 24 pouces a 50cm ou un 40 pouces a 3m on voit nettement la différence entre le 1440p et la 4k suffit de faire le test.

J avais plein de potes comme vous. Je leur ai fait la demo du 1440 vs 2160 et tous sans exception on vu la différence

On voit légèrement la différence mais c’est pas worth du tout imo. Clairement les résolutions a considérer sont 1080p ou 1440p, ou alors 2160p si vous avec le budget pour racheter du thdg type 2080 Ti tous les deux ans.

Je suis d’accord avec toi

Enfin on ose parler de ce sujet !

Personnellement j’ai un 27″ en 1440p et je vois la différence avec mon ancien écran 21.5″ en 1080p.

Mais la 4k ne m’apporterait rien mon écran est trop petit.

Dino Patti dit que le problème vient des fabricants.

Sans doute mais ils ne sont pas les seuls à pousser vers la 4k.

La plupart des benchmarkings et des tests sur le matériel portent sur les rendus en 1080p et en 4k.

Très rares sont ceux qui parlent du 1440p…

Ce qui personnellement me force toujours à extrapoler les résultats et c’est bien dommage…

C’est complétement idiot ce raisonnement de dire que la 4K serait inutile sur un 27 pouces vu que cette diagonale n’y est pas adaptée.. Tout comme le 1440p est inadapté à votre 21,5″ en fait et l’affirmer est aussi pertinent que d’affirmer que le feu ça brule.

Quand on monte en résolution c’est évident que l’intérêt vient du fait d’augmenter la diagonale de son écran en maintenant la distance ou sinon réduire la distance en maintenant la diagonale.

Bien-sûr c’est encore + intéressant d’augmenter la diagonale tout en diminuant la distance mais attention les yeux.

Plus la diagonale est élevée plus on se recule du coup ça change rien. A mon humble avis , 1440p est suffisant, jusqu’à ce que le coût au niveau du GPU devienne suffisamment faible, auquel cas la 4k aura enfin du sens. Actuellement les sacrifices sont trop importants pour un gain assez faible. A voir le cas particulier de la VR cela dit, mais c’est une autre histoire.

« Plus la diagonale est élevée plus on se recule »

L’intérêt c’est l’immersion, aucun intérêt d’avoir une grande diagonale pour s’y mettre plus loin…

Tiens il reste des neurones quelque part finalement sur le WEB ?

Je suis d’accord avec ce sujet !!

Sauf sur un point : la VR

Dans ce cas la 4k peut avoir un intérêt vu que l’écran est très proche des yeux.

Je joue sur un écran 22″ en 1080 et c’est largement suffisant

Ma TV est une 50″ 1080 et là aussi suffisant.

Je ne verrai de différence qu’à partir de 60/65″ je pense, et encore …

Ya des gens à qui la suffisance leurs suffit ?

De toute façon 1440p a 120 mhz demande la même confirmation que 4k à 60 mhz alors attention au piège, si non le 4k est mal développé pour les jeux alors que ça pourrait faire une réelle différence, j’ai eu toute les résolutions et je suis sur du 4k 28 pouce, je reconnais que sur certains jeux mal développé pour le 4k je fais difficilement la différence avec du 1440 mais certains jeux sont mieux optimisé pour du 4k et ça ce voit quand même. Après j’ai horreur des filtres baveux et j’aime la définition propre du 4k natif sans filtre à la c.n.

Mouais… si on les écoute les devs, il ne faudrait rien faire. Et c’est valable pour beaucoup. Le multicore/thread? trop compliqué et fatiguant (dixit Newel Gable). Je dirais aussi maintenant : optimiser un jeu? oula non, débugger un jeu avant de le vendre? oula surtout pas.

Enfaite plus les devs ont d’outils pour les aider et moins ils en font et surtout font encore plus des produits mal finis.

Cependant n’oublions pas non plus le consommateur qui oublie l’essentiel d’un jeu. Les clients critiquaient Steam a sa sortie et maintenant le defendent contre EGS, alors que c’est la même chose.

Donc si, le 4k est utile MAIS pas encore exploitable pour divers raison, dont l’une vient des gens qui font le contenu. Si l’évolution ne se faisait pas, on serait encore en monochrome a 320*240.

Tout à fait d’accord ! Les jeux sont de plus en plus gourmands pour de multiples raisons soit. Mais quand on y pense bien on arrivait à faire des merveilles en 64bit parce que qu’on extorquait jusqu’à la dernière goutte d’optimisation possible. On avait pas le choix les machines ne pouvait pas faire plus et pourtant la concurrence etait rude. Aujourd’hui beaucoup de devs/studio se repose sur leurs acquis puisque si le jeu ne tourne pas au maximum de son potentiel on a cas attendre la prochaine génération de moteur graphique…. X)

Alors, pour jouer en 4k sur un 43″, à moins d’un mètre de l’écran (histoire d’avoir un bon remplissage de mon champ de vision), la 4k, c’est la vie.

Après oui, c’est pas pour tout le monde, c’est énergivore et tout le reste (et complètement con pour des petits écrans), mais le gain de détail dans des conditions d’utilisation comme les miennes, ça vaut le coup.

Au passage, à moins de toujours tout mettre en ultra sans réfléchir, on peut obtenir des performances correctes, et si ça se trouve sur une conso proche de ceux qui vont tourner en 2k ou 1080p à 120+ips).

Et je pense que même dans des cas d’utilisation type un 40-50″ dans un petit appartement, ça se justifie aussi. Je pense notamment à un ami chez qui on joue, et oui la finesse apportée par la 4k serait bienvenue pour les jeux 3D. Pour les personnages ou quoi, la différence n’est pas folle, mais pour tout ce qui est distance de vue et détail du monde, c’est génial.

Surtout qu’au pire, avec un bon écran 4k, tu peux jouer en 2k et profiter de l’upscale (ou passer par les suites logicielles Nvidia et AMD mais je les trouve un poil moins performantes sur mon peu d’expérience).

Alors là je ne suis absolument pas d’accord avec le dev, évidemment sur une TV 40 pouces le 4k ne sert absolument à rien vu avec 3 ou 4 mètres de distance, mais avec un écran 65 à 3 / 4 m de distance la différence est bien présente, et je ne cherche pas la performance à tout prix, je préfère pouvoir jouer en 2160p / 60hz ultra qu’en 1080p / 144hz low, le 144hz est surtout agréable pour les jeux style FPS ou BR.

En revanche pour les écrans PC et les dalles genre 27″ l’idéal c’est le 1440p / 144hz.

Mais les gens wake up 4k = minimum 55″ arrêtez de parler de vos petits écrans informez-vous bon sang. ???

Il faudrait revenir à la physiologie de l’œil…

Les 25 fps sont très suffisantes

Et sur des images en mouvement la profondeur de couleurs et les détails hors des mouvements n’ont pas besoin d’etre énorme.

Steve Jobs avait dit que la densité maximum sur les téléphones portables pour lire était de l’ordre de 300 pixels par pouce, regardez les derniers produit Apple comme ils vont au delà…

Partout c’est la bêtise du marketing.

Pour les images des jeux, il ne faut qu’ajouter du flou et non augmenter les fps… Comment le marketing pourrait il dire que l’on appauvri l’image pour rendre les mouvements plus réalistes…

25fps suffisantes … ça doit être un troll mais répondons pour les autres.

25 fps c’est “suffisant” quand l’image est travaillée par l’intermédiaire d’ajout de flou de mouvement…. En fait même 18 fps serait suffisant avec l’ajout de flou.

Avec des images non travaillées à 25 fps ça vous piquerait les yeux de regarder un film d’action.

Bon vous êtes sur internet c’est pas compliqué d’aller se renseigner sur le sujet hein blabla persistence rétinienne oui tout le monde le sait ça, mais vous savez aussi que l’oeil est capable de discerner des flashs de lumières d’1/2000 millième de secondes… physiologiquement l’oeil ne voit en pas fps.

Pour PPI sur téléphone je suis plutôt d’accord, en revanche pour le 25 fps suffisant et cette histoire de physiologie de l’œil, l’oeil ne perçoit pas en terme d’images par seconde pour commencer et tout le monde a des capacités différentes et surtout tout dépend de si l’on est passif (comme pour un film) ou actif (comme pour un jeu vidéo) l’oeil perçoit parfaitement la différence entre 25 / 60 et même jusqu’à au moins 100 fps, surtout quand l’on est actif et même passif pour un film il suffit de prendre une scène en mouvement ou un traveling d’un film traditionnelle en 23,976 fps on perçoit très clairement le manque d’images par seconde pour avoir une véritable fluidité d’où le rajout d’effet de flou pour que ce ne soit pas trop flagrant, car il ne faut pas l’oublier le standard des 23,976 fps pour les films etc a été adopté avec l’arrivée de la télévision et ce n’était absolument pour une concordance quelconque avec la perception humaine, mais une histoire de coup, pour avoir le bon compromis entre assez fluide et pas trop cher, car qui dit plus de fps dit plus de pellicules donc des coups plus élevés.

Les 25fps sur des jeux comme cs go je pense que tu trouverai ca injouable ce sont des legende que l’eoil voit a 24 ips merci

Ceux qui disent qu’ils ne verraient pas de différence à moins de x mètres ou x diagonale d’écran n’ont clairement jamais essayer.

La différence entre 1080p et 2160p est FLAGRANTE même sur un petit écran.

Habituez vous à la 4k sur un petit 27 pouces et repassez en full hd, vous allez voir si la différence est minime!

Personnellement j’attends fin 2020 avec impatience pour voir ce que la 8k pourra nous offrir avec l’arrivée des prochaines consoles de salon.

Désolé mais tu te trompes de sujet. Ce que tu dis est vrai, mon bureau windows est beaucoup plus joli en 4k qu’en Full HD… mais c’est une image FIXE !!! Pour les films, l’oeil se satisfait du 24 Hz car on a une succession d’images floues (faites un arrêt sur image pendant une scène en mouvement pour vous en convaincre) Mais pour le jeu video le circuit graphique génère une succession d’images fixes (je vais éluder le motion blur, tout le monde sera d’accord…) Aussi, à choisir entre une grande résolution (4K vs FHD) et une grande fluidité (50 Hz vs 30 Hz) tout gamer choisira la fluidité.

La plupart des personnes qui trouvent ça inutile ou “imperceptible” n’ont soit jamais essayé la 4K, soit n’ont pas le matériel nécessaire pour faire tourner leur jeux dans cette résolution, soit ont besoin d’un tour chez l’ophtalmo. Il est évident qu’on voit la différence mais c’est sûr qu’on la verra pas sur un écran 21 pouces… La 4K apporte une finesse et une netteté que la fhd ne possède pas. Il n’y a qu’à voir les jeux comme assassin’s creed odyssey, bf5 ou dernièrement Red dead redemption 2 qui sont très beau en 1080p mais magnifique en 4K. Avec cette mentalité on en serait encore au 720p sur les jeux et le blu-ray 4K n’aurai jamais existé. Oui ce n’est pas accessible pour tout le monde mais c’est normal et ça a toujours été comme ça jusqu’à que les prix baissent comme pour les TV oled qui coûtait un bras il y’a 5 ans et qu’on peut trouver pour moins de 1000 euros aujourd’hui. Je ne comprends pas en quoi cela peut déranger vu que l’utilisateur pourra choisir de jouer en 4K 60 fps, en 1080p 120fps ou même en 720p 240fps si il en a l’envie. Donc non, que les développeurs continuent de travailler en 4K car je pense que ce sera la résolution de l’avenir du jeux vidéo et c’est très bien comme ça. Et ceux qui n’en veulent pas, ne vous inquiétez pas vous pourrez toujours jouer en 1080p 480fps…

Oui, actuellement en 32 pouces en 4k je vois bien la différence! C’est sur si l’écran et à 50m c’est pas utiles mais dans ce cas le 1080p c’est aussi trop. l’important c’est pas le nombre de pixel, c’est la distance Vs taille écran Vs Résolution, pour avoir un champ de vision de 30 à 40°. Perso je vais pas acheter un écran de 65 pouces à 3m de mon bureau pour pouvoir jouer …

J’ai un écran 27″ 4K et un 32″ 1440p.

Et je suis à 80cm de l’écran.

Je peux vous dire que les jeux sont bien + fins sur le 27″ 4K (sur The Witcher 3 c’est flagrant).

Sur le 32″ 1440p l’image est + floue, surtout la végétation.

Pas du tout d accord pour etre passer a la 4k y a deja 5 ans et avoir tester le 120hz. Je prefere être 4k et de loin.

Ce mec a sa preference moi aussi, et je suis développeur aussi.

Tous mes contacts qui sont passés a la 4k ont le meme ressenti que moi.

En plus sur un smartphone on voit clairement la différence entre un vieux en 480*640 et du 1080*1920 et ceux meme a 1m sur du 4.5pouces alors le coup du tu vois plus la diff a partir de x metre c’est de la connerie complète ! Surtout quand on fait l essai au lieu du juste reporter les dires des autres !!!

Je ne partage pas du tout l’avis de ce développeur. Étant un utilisateur d’une TV 4K de 55 pouces a 1.5m, je peux vous garantir que la différence entre du 1080p et du 4K se fait sentir. Évidemment qu’il faut avoir un très bon matériel pour pouvoir se permettre de faire tourner du 4K à 60 images par secondes, mais le jeu en vaut la chandelle.

Avec une mentalité telle que celle de ce développeur, on ne progressera jamais. Il n’y a rien de mieux que la recherche continue de perfectionnement de l’image pour l’immersion du joueur. Je joue depuis maintenant 2 ans en 4K et jamais je ne reviendrai à une résolution inférieure. Après, si votre objectif vidéo ludique est de pouvoir jouer avec une vieille résolution de 1080p, soit, mais ne venez pas critiquer ceux qui essaient de faire bouger les choses et qui travaillent dur pour offrir aux joueurs exigeants la qualité qu’ils méritent.

Le seul element le plus important qui est pas aborder. C est le support du hdr et avoir des moniteurs qui peuvent gerer plus de 16 millions de couleurs. Et ainsi avoir deq couleurs chaudes. c’est la seul innovation de ces dernières années.

De toute façon tout les progrès sont toujours inutile jusqu a ce qu ils se généralisent et qu ensuite plus personne ne veuille revenir en arrière… C est une mentalité de suiveur.

Quand à affirmer qu’on ne voit pas la différence entre la FHD et la 4K… Quoi dire de plus… Il n’y a rien d honteux à aller voir un ophtalmo et on trouve des lunettes à tout les prix.

Enfin et ç est le plus triste: le matériel évolue pour s adapter aux titres, et pas l inverse, le jour où les développeur cesseront de repousser les limites (par feneantise, ou à cause de contraintes budgétaires) le jeu vidéo sera mort, on jouera tous à des freeplay cheap et rempli de pub

grosse connerie cet article !

LG sort le 1er televiseur 4k 120hz oled 65/75 pouces compatible g-sync !

Tout depend de la diagonale;apres niveaux techno il faut tabler sur du SLI…. au zut Nvidia a arreter ce support !!!

Clairement 4k +144hz+g-sync(ou freesync) ça deboite !

Libre à toi de claquer tout ton blé pour ta passion, la 4K à 144 ips (tu nous tiens au courant quand tu atteins ces perfs dans un ou deux ans ?)

Pour le reste, j’espère que tu aimes les gratins de pâtes !

En tant que possesseur des Valve index cet article me fait bien rire lol. Du 1080p c’est un peu de la bouillasse de pixels dans les casques ^^ comme quoi il y a bien un intérêt.

Et il a développé quoi ce monsieur ? Encorecomme l’autre bouffon sui avait sorti que les mods so.t inutiles pour les jeux? Ahbah oui il fait des jeux pour smartphone…. credibilite zero

On sent la discussion de bistrot qui se transforme en article…

“Puisque je te dis que le fps c’est la vie !”

Le plus fascinant c’est que la majorité des commentateurs n’a pas lu l’article, comme d’habitude 🙂

Pour le reste, sur 70K lectures, seulement 25 rageux assez motivés pour commenter bien violemment derrière leur clavier, c’est une proportion assez satisfaisante 🙂

De la connerie si tu as la config pour faire tourner un jeu en 144 Hz 4K avec le RTX tu dira pas que ça ne sert à rien alors oui pour certaines bourse le 4K ne sera pas utile car cela limitera tes FPS mais si tu as la config le confort visuel n’en sera que meilleur

C’est plutôt cet article qui est complètement inutile.. c’est comme si on disait qu’une technologie est inutile car elle n’a pas encore de fonctions pratique.. C’est comme ça que fonctionne les technologies lol on invente puis on voit après pour les fonctions pratique..

Le contenu en 8k finira par venir et les jeux aussi.

Ce n’est pas parce que vous n’avez pas les moyens de l’acheter que c’est inutile.

Ce serait cool que les devs arrêtent de penser à la place du joueur.

Je suis d’accord avec le fait de dire qu’une telle débauche de puissance n’en vaut pas forcement la chandelle. En revanche, dire qu’on ne voit pas la différence, c’est quand même de la malhonnêteté. C’est juste qu’elle justifie pas un tel investissement pour le moment. Pour ma part, j’ai eu un 4K 60 hz et ça mettait régulièrement à genou ma 1080ti. J’ai revendu cet écran et je suis repassé sur un 1440p sur lequel ma CG est bien plus à l’aise et je regrette pas. Je vois clairement pas trop la différence, du moins en terme de définition sur un 27 pouces (vs 28 pouces pour le 4K). Après, pour vraiment comparer, il faut des écrans dont c’est la définition native. Parce que mettre une image 1440p sur un écran qui est 4K natif, ça fait bien dégueulasse par rapport à la même image sur un 1440p natif.

L’eternel débat haha. Les deux profils existent depuis l’avènement des multiples résolutions : certains privilégient le rafraîchissement, d’autres la résolution. Et bien sûr certains veulent les 2. Mais balancer une généralité comme ca, “le gaming en 4K totalement inutile”, ça n’a aucun sens. Peu pertinent pour certains jeux ou certains usages ? Trop mis en avant au détriment des solutions d’antialiasing et filtres ? Marketing poussant à la consommation? Vraisemblablement. Mais certainement pas “totalement inutile”. C’est quand même un sacré bond qualitatif.

Pourtant on ne voit vraiment pas la différence en usage concret. Vous faites la comparaison sur des images fixes. C’est comme pour le traçage de rayon. Encore heureux qu’on voie la différence dans ces conditions. Mettez des images en mouvement quand ça pète de partout et là c’est plus la même. Votre cerveau aura autre chose à traiter que la qualité de l’image (par contre votre CG elle non…).

Regardez ce test c’est toujours bon à prendre: https://www.youtube.com/watch?v=ehvz3iN8pp4

Ouai mais du coup la vidéo confirme un peu ce qui se dit ici : sur des diagonales de moniteurs, la 4K à un meilleur visuel (normal?) mais l’expérience de jeu semble, d’après les personnes qui donnent leurs ressenti, moins plaisante que de joueur en 1440p/120 ou 144 hz.

Maintenant sur des TV de salon, avec des diagonales de 55 pouces et plus, ce n’est pas forcément la même histoire : l’expérience visuel cette fois-ci est bien plus impressionnantes. Et d’autres part, le test est en jeu dans la vidéo est fait avec un FPS (doom). Sur un RPG, serait-ce la même réponse ? C’est justement ce que dis Linus en prenant l’exemple de RDR2 ou GT5 qui sont plus ” contemplatif ” que doom.

Bref, moi je retient une chose : je ne fait pas 100% de jeu compétitifs sur mon ordi. Je regarde des films aussi. Et là, c’est tout vu : un grand écran en 4k est loin devant les autres, même si c’est une dalle en 60 hz. Pareil pour la navigation et le traitement de textes : les petits moniteurs n’offre pas autant d’ergonomie ni de confort visuel.

Les commentaires ici sont affligeants… Je rejoins totalement ce qui est dit dans l’article. La 4K c’est pour ceux qui ont de l’argent a foutre en l’air parce qu’aujourd’hui la majorité des GPUs dans des jeux exigeants et récents ne sont pas capables de faire tourner le jeu a 60fps avec toutes les options graphiques a fond.

Ceux qui criaient au scandale parce que les derniers cartes de NVIDIA avec cette obscure option Ray Tracing qui ne sert a rien selon eux parce que je cite “osef du ray tracing, ou est la 4k 120 FPS !?”, ces personnes dont des utopistes. La réalité c’est que pour tous les jeux aux graphismes exigeants, type AAA, la 4K 120fps n’est pas a l’ordre du jour et n’est pas près de l’être (du moins au moment de la sortie du jeu). Et il est beaucoup plus important de faire avancer les methodes de rendus que la résolution. NVIDIA ont raison sur ce point et les haters ont tout faux mais comme ils n’ont aucune ouverture d’esprit ils ne s’en rendent pas compte.

Sauf que les jeux exigeants et récents, c’est … rare. Faut être honnête, parmis les milliers de jeux disponibles c’est toujours les mêmes que tu vois en benchmark.

Quand à la 4k, si tu fait abstraction de ces jeux ” benchmark” (qui reste d’ailleurs tout à fait satisfaisant à jouer et jouable en 60 fps pour peu que tu ne veuille pas uniquement y jouer en ultra), ce qui limite c’est pas nécessairement la puissance de la carte (puisque tu diminuera les options et que ça rend les choses bien plus facile tout en conservant l’avantage d’une résolution supérieur) : c’est la mémoire vidéo disponible. Et là, pas de chances pour Nvidia, ils sous-dimensionne systématiquement par rapport à AMD. Une vidéo de linus tech explique bien le truc : https://www.youtube.com/watch?v=Utv144XeHag

Entre 1080p et 2160p, la quantité de mémoire nécessaire à stocker chaque image est multiplié … par 4. Rajoute à ça ce qui est inhérent aux jeux et consomme également de la mémoire vidéo, et tu comprend pourquoi ça rame. AMD , à l’inverse, n’est pas spécialement radin sur la mémoire vidéo mais c’est plutôt la puissance brute qui laisse à désirer.

Donc au lieu de foutre du hardware pour faire du ray tracing… de la mémoire vidéo pour jouer de manière fluide serait bien plus appréciable. Mais bon, buseness is buseness, n’est-ce pas?

Vous dites “à 3 mètres de l’écran on voit pas la différence” moi je joue à a peine 1m de mon écran voire une 50aine de de Cm quand je suis sur mon bureau et la différence est bien visible. Quand à celui qui dit que le cerveau a autre chose à traiter que la résolution… pardon? Tu es diplômé de quelque chose en ce qui concerne ceci et quand bien même tu y prétendrai on en saurai rien, ton information est bidon donc, ah oui et la 1080 fait tourner battlefield 5 en 4k ne me croyez pas sur parole vérifiez par vous-même. En résumé soit on a l’argent et on en profite soit on l’a pas et de toute façon on s’en fiche ou alors on attend que le prix des technologie diminue

Même sur mon 32 pouces ça reste plus appréciable de jouer en 1080p qu’en 4k (intel I7 8700 + GTX 1070ti)

Pour les films la 4k est chouette, mais pour les jeux la fluidité reste primordiale. Donc 1080p avec toutes les options à fond et l’image est merveilleuse 🙂

le manque d’argent c’est bien triste

On se doute bien qu’en fonction du budget de certain, avoir du matos qui fait de la 4k (pour Pc ou console, je ne veux pas de débat pour qui est pro pc ou console 😀 ) peut s’avérer vraiment onéreux. Pour ma part j’ai fait parti des “idiots” qui ont acheter la Xbox one x pour pouvoir tester les graphismes en 4k, eh bien: c’est magnifique, on voit clairement la différence (écran TCL 48″ full 4k pour 680€ en promotion chez Auchan). Maintenant est-ce que c’était du 120 FPS, NON ! On est dans du 60 fps sur one x. Mais bon je m’en fous car je joue à des jeux dans lequel on peut admirer le paysage, les textures et j’en passe… Et je préfère ! Tout cela n’est qu’une question de goûts pas d’argents car si on veut faire des efforts pour mettre de l’argent de côté pour s’acheter la dernière technologie sortie, on y arrive toujours, avis à la populace ?.

PS: cela fait maintenant 2 ans que je suis toujours sur la one x avec l’écran TCL et c’est toujours aussi beau…

Après ce que vous dites est totalement subjectif. Ça dépend des goût et des bourse de tout le monde !

Que les développeurs apprennent déjà à faire des jeux sans bugs après ils pourront parler

Bonjour à titre informatif et par expérience je me suis monté un PC à 5500 € ecran 4k 60h inclus ( à base de i9, 64 Go de RAM et RTX 2080 TI)

Au final j’ai revendu mon écran 4K car dans la plupart de mes jeux préférés je n’arrivais pas à maintenir les 60 fps et quand ça descend d’un coup à 40 fps je peux vous dire que c’est pas joli et c’est très gênant pour jouer en ligne.

Sur GTA V par exemple en 4K ultra c’est impossible de jouer en ligne je me fais buter direct car ça rame trop. Sauf si je m’amuse à trifouiller les réglages pendant 30 minutes là je peux à peu près avoir du 60 fps constant mais je pensais qu’avec un investissement aussi important je pouvais au moins avoir du 60 fps constant en ultra. Je vous parle même pas du dernier Final Fantasy ou de Red Dead Redemption 2 où là c’est carrément la catastrophe en ultra 4k.

Pour un matos dernier cri à ce prix-là je peux affirmer qui l est impossible de jouer en de bonnes conditions en 4K ultra sur PC.

du coup je me suis rabattu sur un écran 21/9 1440p et là c’est effectivement ce que j’attendais en termes de performance.

Donc pour jouer en 4K en mettant toute les options en Ultra je pense qu’il faudra attendre la prochaine génération de RTX voir celle d’après pour fleurer avec les 60 voir 80 FPS constant.

par contre j’ai bien vu la différence de finesse en 4K c’est beaucoup plus fin et plus jolies. Mais je peux vous assurer que quand vous passez de 60 à 40 fps ça devient dégueulasse même avec gsync comparer a un écran 1440p 144 FPS constant sur tout les jeu en ultra.

Pour finir je suis très déçu de ne pas pouvoir passer les jeu en 4K correctement mais bon c’est pas grave j’attendrai deux générations suivantes et là je pense qu’on sera bon. Après sur console je pense que c’est quand même différent car c’est directement optimisé pour et bien souvent c’est pas de la 4K natif et ce n’est pas non plus en Ultra donc pas comparable pour moi. la 8k on en parle même pas

Alors ça depends beaucoup.

Quand on joue pour les graphismes, on met le top du top SI le processeur et la carte graphique le permette , et SI on as surtout des grands écran, un 24′ il va pas mettre la 4k ça sert à rien du tout, par contre mettre du 1920 sur un ecran en 32′, même si il est en 1920 et pas de 4K, tu auras une sorte d’aliasing moche et du coupe une image pas fine, et il faudra augmenter la résolution pour avoir une belle image.

Donc pour pas avoir ce probleme ne prennez pas d’écran plus grand que 27′ et vous serez au pire cantonner a mettre le 1440p, si vous mettez plus grand pour avoir une image nette et très jolie il faudra passer minimum en 1440p, et le top en 4k.

Perso je joue en 1080 sur un 60″ à environ 3m, c’est plutôt propre je trouve, la 4K s’adresse plus à la VR ou des écran d’au moins 70″