Introduction

Dans les ordinateurs modernes, le support de stockage représente le dernier véritable goulot d’étranglement ; raison pour laquelle les SSD peuvent réellement multiplier les performances de vos machines : mettez-en un dans un simple netbook et vous améliorerez plus ses performances que si vous aviez doublé sa capacité de mémoire ou son processeur.

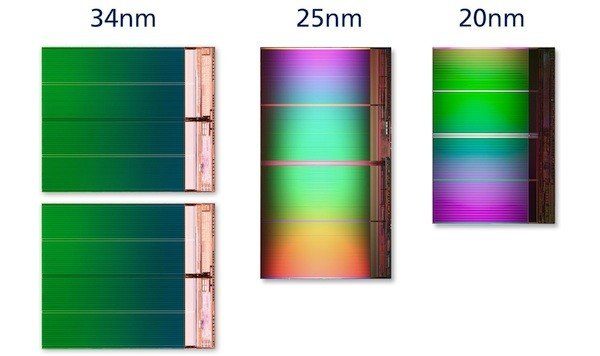

Ceci étant dit, les performances ne font pas tout. À l’heure actuelle, la grande question en matière de SSD concerne moins leur rapidité que leur fiabilité, une question d’autant plus pressante que les fabricants sont en passe d’abandonner la mémoire flash NAND gravée en 34 nm au profit de celle gravée en 25 nm. Nous avons déjà discuté à plusieurs reprises avec les meilleurs ingénieurs d’Intel, et c’est toujours le même sujet qui revient sur la table : il est plus difficile de résoudre les problèmes posés par la gravure en 25 nm qu’en 34 nm, mais pas au point de les empêcher d’offrir aux clients des performances et une fiabilité accrue par rapport aux produits de génération précédente. En bref, le problème que représente le faible nombre de cycles d’écriture/effacement supportés par la mémoire NAND finement gravée serait exagéré.

| Cycles d’E/E | Volume total écrit (formule JEDEC) | Nombre d’années avant épuisement (10 Go/jour, usure moyenne = 1,75) | |

|---|---|---|---|

| SSD 25 nm de 80 Go | 3000 | 68,5 To | 18,7 ans |

| SSD 25 nm de 160 Go | 3000 | 137,1 To | 37,5 ans |

| SSD 34 nm de 80 Go | 5000 | 114,2 To | 31,3 ans |

| SSD 34 nm de 160 Go | 5000 | 228,5 To | 62,6 ans |

Bref, au vu de ces chiffres, on se dit qu’il n’y a pas de raisons de se préoccuper du nombre de cycles d’écriture/effacement que peut supporter un SSD. Les modèles grand public de génération précédente contenaient de la NAND MLC gravée en 34 nm (ou une valeur proche) et étaient généralement validés pour 5000 cycles ; il était donc possible d’écrire puis effacer les données 5000 fois avant que les cellules de mémoire ne commencent à perdre leur capacité à conserver les données. Sur un modèle de 80 Go, cela se traduisait par un volume total écrit de 114 To avant que l’on ne commence à ressentir les effets de l’épuisement des cycles d’écriture ; sachant qu’un ordinateur de bureau normal écrit en moyenne 10 Go par jour, il aurait fallu environ 31 ans avant que cela ne se produise. Avec la NAND gravée en 25 nm, ce chiffre retombe à 18 ans. Bien entendu, nous simplifions à outrance un calcul particulièrement complexe : l’amplification des écritures, la compression et la garbage collection ont toutes une influence sur les estimations mais, dans l’ensemble et pour une utilisation classique, il reste inutile de se soucier du nombre de cycles d’effacement/écriture qu’a déjà effectués un SSD.

Bien évidemment, les SSD tombent en panne. Il suffit pour s’en convaincre de parcourir les pages « Avis des consommateurs » de la plupart des sites de vente en ligne ; le problème n’est toutefois généralement pas l’épuisement des cycles d’écriture, mais le firmware. Selon la manière dont celui-ci écrit les données sur le SSD, il peut en effet exister un risque de « confusion » pour le support, confusion dont celui-ci ne se remet généralement pas ; lorsque cela se produit, certaines fonctions comme la garbage collection cessent de fonctionner et le lecteur finit alors par ne plus pouvoir lire ni écrire. Il existe aussi d’autres types de pannes moins élégantes, comme un condensateur qui brûle, mais le résultat final est toujours le même : le SSD meurt. Techniquement, n’importe quel composant, qu’il soit électrique ou mécanique, est toujours susceptible de s’user et de tomber en panne. Mais l’absence de pièces mobiles entraîne-t-elle une meilleure fiabilité ? Les données enregistrées sur votre SSD sont-elles plus en sécurité que si elles se trouvaient sur un disque dur ?

La fiabilité constituant aujourd’hui une donnée plus variable que jamais, il ne fait aucun doute que vous ayez envie de connaître la réponse à ces questions avant d’aller acheter un SSD. Aujourd’hui, nous passons en revue la fiabilité des SSD et disques durs et distinguons la réalité de la fiction.

Le point sur la fiabilité des disques durs

Les SSD étant des produits relativement neufs, du moins par rapport aux disques durs (qui ont près de 60 ans), on comprend aisément que l’on veuille les comparer aux technologies éprouvées.Mais en fait, que savons-nous vraiment des disques durs ?Deux études importantes nous apportent des éléments de réponse.En 2007, Google a publié une étude portant sur la fiabilité des 100 000 disques durs PATA et SATA grand public de son centre de données ; parallèlement, le Dr Bianca Schroeder et le Dr Garth Gibson ont calculé le taux de remplacement de plus de 100 000 disques durs utilisés dans les plus grands laboratoires américains. À la différence de la première, cette étude porte également sur des disques durs professionnels SCSI, SATA et FC.

Si vous n’avez lu aucun de ces deux documents, nous vous recommandons chaudement de parcourir au moins le deuxième : il a reçu le prix de la meilleure soumission lors de la conférence File and Storage Technologies (FAST ’07). Pour ceux que les documents académiques rebutent, nous allons tenter de résumer.

MTTF, MTBF, AFR et ARR

Vous vous souvenez de ce que signifie l’abréviation MTBF ? Non ? Si l’anglais ne vous rebute pas, allez voir dans cet article comment on le calcule. Prenons comme exemple un Seagate Barracuda 7200.7.Son MTBF annoncé est de 600 000 heures, ce qui signifie que, si l’on en prend une population statistiquement significative, la moitié des disques durs tomberont en panne au cours de 600 000 premières heures de fonctionnement.Si ces pannes étaient réparties de manière égale, un disque tomberait en panne toutes les heures, ce que l’on peut convertir en un taux de panne annualisé (annualized failure rate ou AFR) de 1,44 %.Malheureusement, ce n’est pas ce que Google et le Dr Schroeder ont constaté dans la pratique.Avant de continuer, notons qu’une panne n’entraîne pas nécessairement le remplacement du disque dur, raison pour laquelle le Dr Schroeder a mesuré le taux de remplacement annualisé (annualized replacement rate ou ARR). Elle a pour ce faire consulté les journaux de maintenance pour y trouver le nombre de disques réellement remplacés.

Alors que les AFR annoncés par les fabricants sont compris entre 0,58 et 0,88 %, les ARR observés vont de 0,5 à 13,5 %. En fonction des données et du type de disque observé, ils sont donc jusqu’à 15 fois plus élevés que les taux de pannes annoncés !

Les fabricants de disques durs n’ont pas la même définition du mot « panne » que les chercheurs ; et bien entendu, leur définition a tendance à surestimer la fiabilité de leurs produits.De manière générale, le MTBF annoncé est calculé en fonction d’un test en cycle de vie accéléré, des données disponibles en matière de retours et d’essais effectués sur un panel de disques durs.Les chiffres de retours utilisés par les fabricants n’en restent pas moins hautement suspects : comme l’indique Google, « nous avons observé […] des situations où le testeur de disque durs donne systématiquement le feu vert à un produit qui tombe invariablement en panne en situation réelle ».

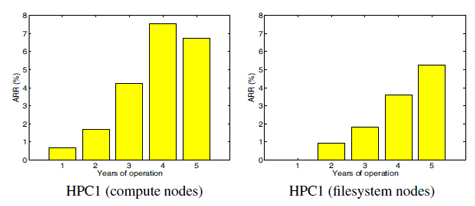

Évolution du taux de pannes dans le temps

La plupart des gens croient que le taux de panne des disques durs a la forme d’une courbe en baignoire : beaucoup de pannes au début en raison d’un phénomène de « mortalité infantile », puis une baisse du taux de panne et, enfin, une brusque hausse à l’autre extrémité due à l’usure des disques. Pourtant, aucune des deux études n’a permis de vérifier cette hypothèse : au contraire, dans l’ensemble, le nombre de pannes augmente progressivement avec le temps.

La fiabilité des disques durs professionnels

Lorsqu’on compare les deux études, on se rend rapidement compte, par exemple, qu’un disque dur Cheetah ayant sur papier un MTBF d’un million d’heures est en réalité nettement plus proche des 300 000 heures. Cela signifie que les disques durs dit « professionnels » et les modèles grand public ont en fait un taux de panne annualisé pratiquement identique ; cela vaut d’autant plus quand on compare des disques de capacité identique. Selon Val Bercovici, directeur de la stratégie technique chez NetApp (le fournisseur de stockage affichant la plus forte croissance du moment), « ce qui perpétue le mythe selon lequel les disques durs plus chers sont plus fiables, c’est la manière dont les grappes de stockage gèrent les pannes. L’un des secrets les mieux gardés des fabricants de supports de stockage est le fait que la plupart des disques durs professionnels et grand public contiennent pour l’essentiel les mêmes composants. Par contre, leur interface avec l’extérieur (FC ; SCSI, SAS ou SATA) et surtout les priorités et objectifs de leurs firmware jouent un rôle énorme dans leur comportement et donc dans leur positionnement marketing. »

RAID et sécurité des données

L’étude du Dr Schroeder couvre également des disques faisant partie d’énormes grappes RAID utilisées dans certains des plus grands laboratoires d’informatique de performance au monde. On croit généralement que les données sont plus en sécurité lorsque les disques durs sont configurés en grappes RAID prévues à cet effet, et pourtant, les conclusions de l’étude sont des plus surprenantes.

La distribution temporelle des remplacements de disques fait montre d’une diminution progressive des taux de pannes ; c’est-à-dire que la durée prévue avant le prochain remplacement augmente avec la durée écoulée depuis le dernier remplacement.

En d’autres termes, la panne d’un disque dur dans une grappe augmente la probabilité qu’un autre disque de la même grappe tombe en panne également, et plus il s’écoule de temps depuis la première panne, plus il s’en écoulera d’ici la prochaine. Cela a évidemment des implications cruciales sur le processus de reconstruction de la grappe RAID ! Après la première panne, vous avez quatre fois plus de chances d’avoir une deuxième panne dans l’heure qui suit ; après dix heures, cette probabilité n’est plus que deux fois supérieure à la normale.

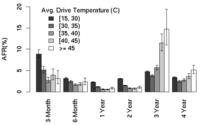

Température

L’une des conclusions les plus étranges se trouve dans le document publié par Google : les chercheurs ont analysé les mesures de température récoltées par le système de surveillance SMART (Self-Monitoring, Analysis, and Reporting Technology) intégré à la plupart des disques durs et se sont rendu compte qu’il n’y avait aucune corrélation entre l’augmentation de la température de fonctionnement et le taux de panne. La température semble tout au plus affecter les disques durs les plus vieux, mais même cet effet apparaît comme mineur.

Le SMART est-il efficace ?

En pratique, le système SMART semble bien peu fiable : conçu pour détecter les défaillances suffisamment tôt pour permettre à l’utilisateur de sauvegarder ses données, il n’a émis aucune alerte dans plus d’un tiers des pannes constatées par Google. Pour bon nombre d’experts du secteur, cela n’a pas grand-chose de surprenant et cela fait même des années qu’ils le suspectent : le système SMART est en effet optimisé pour détecter les pannes matérielles, mais les disques durs sont en grande partie électroniques, ce qui explique pourquoi le SMART est incapable de remarquer les problèmes de type comportemental ou situationnel comme les pannes de courant, mais révèle les problèmes d’intégrité des données. Bref, si vous comptez sur le SMART pour vous prévenir des défaillances, prévoyez d’autres couches de redondance sous peine de perdre des données…

Voyons maintenant si les SSD font mieux que les disques durs.

Petit aperçu de la fiabilité des SSD

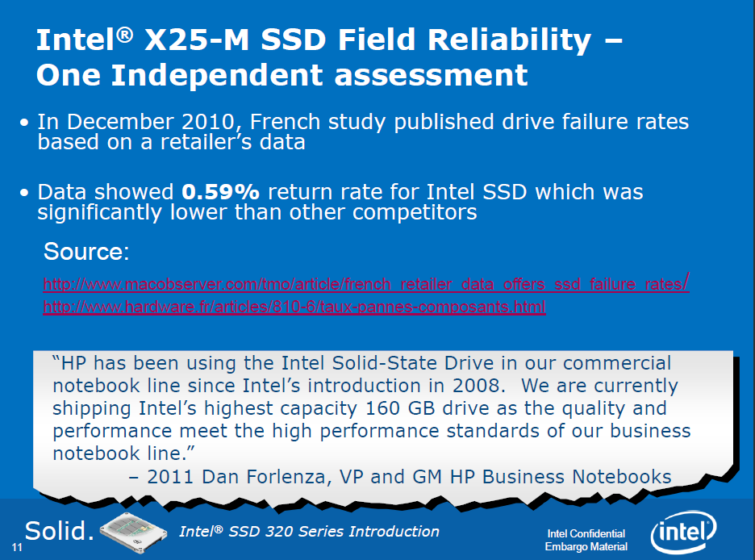

Malheureusement, aucun fabricant de disque dur ne communique ses chiffres de retours ; cela vaut également pour les fabricants de SSD. Toutefois, en décembre 2010, Hardware.fr a publié, sur la base des données collectées par sa société-mère LDLC, un article consacré au « taux de panne » des SSD.

Le site indique avoir effectué ses calculs de la manière suivante : Les taux de retour avancés concerne des produits vendus entre le 1er octobre 2009 et le 1er avril 2010 et renvoyés avant le 1er octobre 2010, c’est-à-dire après 6 mois à un an d’utilisation. Les statistiques par fabricant reposent sur des échantillons minimaux de 500 ventes, celles par modèles sur des échantillons d’au moins 100 ventes.

Comme vous pouvez le voir, le titre de l’article est quelque peu trompeur : il s’agit en effet de taux de retour revendeur et non de taux de panne.

| Ventes entre le 1/10/2009 et le 1/04/2010, retours effectués avant le 1/10/2010 | |||||

|---|---|---|---|---|---|

| Disques durs 1 To | Taux de retour | Disques durs 2 To | Taux de retour | SSD | Taux de retour |

| Hitachi Deskstar 7K1000.B | 5,76 % | WD Caviar Black WD2001FASS | 9,71 % | Intel | 0,59 % |

| Hitachi Deskstar 7K1000.C | 5,20 % | Hitachi Deskstar 7K2000 | 6,87 % | Corsair | 2,17 % |

| Seagate Barracuda 7200.11 | 3,68 % | WD Caviar Green WD20EARS | 4,83 % | Crucial | 2,25 % |

| Samsung SpinPoint F1 | 3,37 % | Seagate Barracuda LP | 4,35 % | Kingston | 2,39 % |

| Seagate Barracuda 7200.12 | 2,51 % | Samsung EcoGreen F3 | 4,17 % | OCZ | 2,93 % |

| WD Caviar Green WD10EARS | 2,37 % | WD Caviar Green WD20EADS | 2,90 % | ||

| Seagate Barracuda LP | 2,10 % | ||||

| Samsung SpinPoint F3 | 1,57 % | ||||

| WD Caviar Green WD10EADS | 1,55 % | ||||

| WD Caviar Black WD1001FALS | 1,35 % | ||||

| Maxtor DiamondMax 23 | 1,24 % | ||||

| Ventes entre le 1/04/2010 et le 1/10/2010, retours effectués avant le 1/04/2011 | |||||

|---|---|---|---|---|---|

| Disques durs 1 To | Taux de retour | Disques durs 2 To | Taux de retour | SSD | Taux de retour |

| Samsung SpinPoint F1 | 5,2 % | Hitachi Deskstar 7K2000 | 5,7 % | Intel | 0,3 % |

| WD Caviar Green (WD10EADS) | 4,8 % | WD Caviar Green WD20EADS | 3,7 % | Kingston | 1,2 % |

| Hitachi Deskstar 7K1000.C | 4,4 % | Seagate Barracuda LP | 3,7 % | Crucial | 1,9 % |

| Seagate Barracuda LP | 4,1 % | WD Caviar Black WD2001FALS | 3,0 % | Corsair | 2,7 % |

| WD Caviar RE3 WD1002FBYS | 2,9 % | WD Caviar Green WD20EARS | 2,6 % | OCZ | 3,5 % |

| Seagate Barracuda 7200.12 | 2,2 % | WD Caviar RE4-GP WD2002FYPS | 1,6 % | ||

| WD Caviar Black WD1002FAEX | 1,5 % | Samsung EcoGreen F3 | 1,4 % | ||

| Samsung SpinPoint F3 | 1,4 % | ||||

| WD Caviar Black WD1001FALS | 1,3 % | ||||

| WD Caviar Blue WD10EALS | 1,3 % | ||||

| WD Caviar Green WD10EARS | 1,2 % | ||||

N’oublions pas qu’il existe une différence fondamentale entre taux de panne et taux de retour : les clients ne renvoient pas nécessairement leur disque parce que celui-ci ne fonctionne plus. En l’état, nous n’avons malheureusement pas d’informations supplémentaires sur la raison du retour : peut-être le disque ne fonctionnait-il pas dès l’arrivée, peut-être a-t-il cessé de fonctionner après un certain temps… ou peut-être était-il tout simplement incompatible, pour une raison ou l’autre, avec le matériel du client.

| Ventes entre le 1/10/2009 et le 1/04/2010, retours effectués avant le 1/10/2010 | |||||

|---|---|---|---|---|---|

| Top 3 des SSD les plus renvoyés | Taux de retour | Top 3 des disques durs les plus renvoyés | Taux de retour | ||

| OCZ Vertex 2 90 Go | 2,8 % | Seagate Barracuda 7200.11 160 Go | 8,62 % | ||

| OCZ Agility 2 120 Go | 2,66 % | Samsung SpinPoint F1 1 To | 4,48 % | ||

| OCZ Agility 2 90 Go | 1,83 % | Hitachi Deskstar 7K2000 | 3,41 % | ||

| Ventes entre le 1/04/2010 et le 1/10/2010, retours effectués avant le 1/04/2011 | |||||

|---|---|---|---|---|---|

| Top 3 des SSD les plus renvoyés | Taux de retour | Top 3 des disques durs les plus renvoyés | |||

| OCZ Agility 2 120 Go | 6,7 % | Seagate Barracuda 7200.11 160 Go | 16,0 % | ||

| OCZ Agility 2 60 Go | 3,7 % | Hitachi Deskstar 7K2000 2 To | 4,2 % | ||

| OCZ Agility 2 40 Go | 3,6 % | WD Caviar Black WD2001FASS | 4,0 % | ||

Au vu des tableaux ci-dessus, on peut se poser quelques questions supplémentaires : si les ventes en ligne comptent pour l’essentiel des statistiques présentées, la qualité du packaging et les problèmes de manipulation lors du transport peuvent avoir une réelle influence sur le taux de retour. Il faut également noter que nous n’avons aucune information sur l’utilisation qu’ont fait les clients de leurs lecteurs. Les plages de variation selon la période considérée ne font que souligner le problème : à titre d’exemple, le Seagate Barracuda LP passe de 2,1 à 4,1 % entre le premier et le deuxième tableau, tandis que le Western Digital Caviar Green WD10EARS passe de 2,4 à 1,2 %.

Au final, ces données ne nous en apprennent donc pas beaucoup plus sur la fiabilité des produits ; certes, il semblerait que les clients de LDLC soient plus satisfaits des SSD Intel que des autres marques, mais si l’indice de satisfaction est une donnée intéressante, elle est en pratique loin d’être aussi utile que le taux de panne.

MAJ : Hardware.fr nous précise qu’il n’a comptabilisé dans son article que les retours qui sont effectivement des pannes.

Études de cas : centres de données

Le prix au gigaoctet reste l’élément empêchant même les plus grandes institutions de s’acheter des SSD par milliers. Mais ce n’est pas parce que nous n’avons pas accès à des centres de données de très grande taille que nous ne pouvons glaner aucune information sur la fiabilité des SSD. Nous avons contacté plusieurs de nos confrères actifs dans le domaine du stockage et de l’hébergement et avons obtenu de certains d’entre eux des données plutôt intéressantes.

NoSupportLinuxHosting.com

No Support Linux Hosting ne nous a pas indiqué combien de SSD ils possédaient exactement, mais nous savons que ce nombre s’élève à moins de 100, répartis de la manière suivante :

- Des X25-V de 40 Go utilisés comme volumes de démarrage en miroir dans des serveurs lames et des serveurs ZFS ;

- Des X25-M de 160 Go utilisés comme cache (L2ARC) dans des serveurs ZFS ;

- Des X25-E de 32 Go utilisés comme volumes ZIL en miroir dans des serveurs ZFS.

Tous les lecteurs sont utilisés depuis au moins un an, certains près de deux ; la société n’a encore enregistré aucune panne.

Lorsque nous leur avons demandé quels avantages les SSD leur apportaient par rapport au stockage mécanique, les représentants de la société nous ont répondu : « Avec le ZFS et le stockage hybride, les SSD nous permettent d’obtenir des gains de performances énormes par rapport aux disques durs classiques. Nous continuons à utiliser ces derniers pour le stockage pur pour des raisons de coût, mais nous avons l’intention, un jour, de ne plus avoir que des SSD dans nos SAN. En 2011, par contre, nous nous contentons du ZFS sur stockage hybride ».

InterServer.net

InterServer n’emploie que des SSD dans ses serveurs de bases de données (plus spécifiquement, des Intel X25-E (SSDSA2SH032G1GN) dans des machines à base de Xeon), ce qui lui permet d’obtenir des débits extrêmement élevés : en moyenne 4514 requêtes MySQL par seconde. À titre de comparaison, un vieux Xeon équipé de disques durs IDE ne monte qu’à 200-300 requêtes par seconde. Les SSD en question sont en place depuis 2009 et aucun n’est encore tombé en panne jusqu’à présent.

InterServer ne tarit pas d’éloge concernant les SSD Intel :

Les SSD Intel, c’est le jour et la nuit par rapport aux autres marques. D’après notre expérience, les modèles SuperTalent FTM32GL25H, FTM32G225H et FTM32GX25H, par exemple, ont un taux de panne extrêmement élevé : selon nos estimations, près des deux tiers de ceux que nous avons mis en service sont tombés en panne ; et nous parlons de pannes totales, avec des volumes illisibles et des données irrécupérables. Les disques durs, au moins, tombent en panne de manière plus ‘élégante’ et autorisent plus facilement la récupération des données. Pour l’instant, nous n’avons pas de point de comparaison avec les SSD Intel car aucun de ceux que nous possédons n’est encore tombé en panne.

Steadfast Networks : plus de 100 SSD

Steadfast Networks utilise environ 150 SSD Intel, soit un peu plus que les deux entreprises précédentes. Son inventaire comprend essentiellement des X25-E (32 et 64 Go) et des X25-M (80 et 160 Go) et, dans une moindre mesure, des X25-V de 40 Go ; certains des clients de la société ont par ailleurs spécifiquement demandé des lecteurs OCZ Vertex 2, SuperTalent ou MTron Pro. Quelque soit la marque, les SSD ne sont déployés que dans des serveurs de base de données ou comme lecteurs cache.

En deux ans, l’entreprise a connu deux incidents ayant nécessité le remplacement du SSD ; les responsables se sont rapidement rendu compte que la récupération des données était étroitement liée à l’interaction entre le contrôleur et le firmware. Apparemment, l’expérience enregistrée par InterServer (en page précédente) avec les SSD SuperTalent apparaît comme un scénario catastrophe, aucune donnée n’ayant pu être récupérée ; les techniciens de Steadfast Networks, de leur côté, sont toujours parvenus à récupérer les données stockées sur les SSD Intel.

| Nombre de lecteurs | AFR moyen | Utilisés depuis … années | |

|---|---|---|---|

| SSD | ~150 | 1,6 % | 2+ |

| Disques durs | ~2800 | 5 % | 6+ |

Le nombre de SSD étant plus important, nous voyons enfin apparaître des pannes ; celles-ci restent toutefois nettement plus rares qu’avec les disques durs. Selon Karl Zimmerman, président de Steadfast Networks, ce n’est toutefois pas le principal intérêt des SSD :

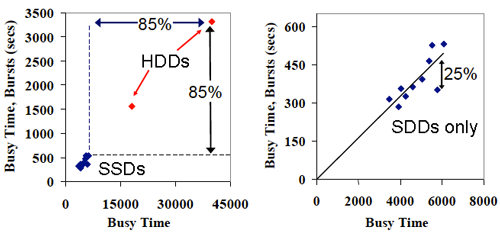

Les SSD nous permettent d’atteindre des performances en E/S considérablement supérieures pour moins cher que si nous prenions des disques durs. Beaucoup de nos clients ont besoin de plus d’IOPS que ne peuvent en fournir 4 disques SAS à 15 000 tr/min en RAID 10 ; pour mettre à jour une telle configuration, il faudrait changer de serveur, de carte RAID, etc. Nous avons eu des cas où il fallait 16 disques durs 15 000 tr/min, voire plus, pour obtenir les performances requises. À titre de comparaison, nous y parvenons maintenant avec un simple SSD (ou parfois deux SSD en RAID), ce qui rend les configurations nettement plus simples et moins onéreuses. Sans oublier qu’en moyenne, un seul SSD remplace généralement quatre disques durs ; le taux de panne annualisé passe alors d’environ 20 % à 1,6 %.

Softlayer : environ 5000 SSD !

Softlayer est la plus grande société d’hébergement web au monde : autant dire qu’ils s’y connaissent en stockage. Avec un parc de près de 5000 SSD, ils nous donnent également accès à un jeu de données nettement plus représentatif.

| Lecteurs | Nombre de lecteurs | AFR moyen | Utilisés depuis … années |

|---|---|---|---|

| Intel X25-E (SLC) 64 Go | 3586 | 2,19 % | 2 |

| Intel X25-E (SLC) 32 Go | 1340 | 1,28 % | 2 |

| Intel X25-M (MLC) 160 Go | 11 | 0 % | moins de 1 |

| Disques durs | 117 989 | Voir étude du Dr Schroeder | – |

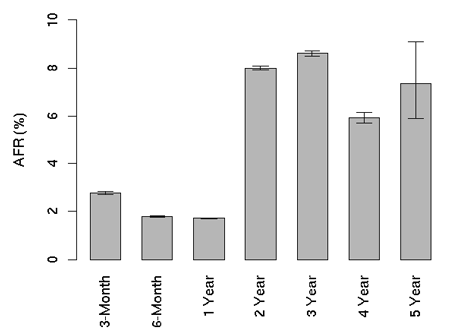

Pour les disques durs SAS et SATA, l’entreprise fait état de taux de panne similaires à ceux cités dans les études de Google et du Dr Schroeder, et indique également que le nombre de pannes augmente avec l’âge : l’AFR est de 0,5 à 1 % lors de la première année, mais il évolue progressivement jusqu’à atteindre 5 à 7 % au cours de la cinquième.

Pas de surprise côté disques durs, donc. Par contre, Softlayer nous confie que ses SSD se comportent de la même manière ! Bien entendu, ils n’ont que deux ans au plus et il faudra donc encore attendre quelques années pour être certains des résultats, mais pour l’instant, les SSD affichent des taux de panne semblables aux disques durs.

Pour des raisons d’endurance en écriture, Softlayer ne déploie pratiquement que des SSD à base de mémoire SLC. Au vu de l’utilisation que fait l’entreprise de ses supports de stockage, il n’est guère étonnant de constater qu’aucune des pannes enregistrées n’est due à un épuisement des cycles d’écritures ; par contre, et c’est nettement plus alarmant, presque aucun SSD n’a déclenché d’alerte SMART avant de mourir. Cela confirme les dires des autres centres de données ; comme le signalait déjà InterServer, les disques durs conventionnels ont tendance à tomber en panne avec plus de « grâce ». Les SSD, quant à eux, meurent souvent de manière très abrupte, peut-être en raison d’erreurs de gestion de la part du firmware. En matière des récupération des données, Softlayer a eu des expériences mitigées, certains SSD étant restés lisibles après la panne et d’autres non. Notons qu’aucun des X25-M de l’entreprise n’est encore tombé en panne, mais l’échantillon est trop faible (11 exemplaires en tout et pour tout) et trop récent (mise en service en juin 2010) pour être représentatif.

Fiabilité ou performances ?

Bien que les SSD à base de mémoire SLC ne représentent qu’une petite fraction du marché de la mémoire NAND, nous disposons de bien plus d’informations sur ceux-ci que sur les SSD faisant appel à la technologie MLC. Certes, notre échantillon ne représente qu’un vingtième de celui des études de Google et du Dr Schroeder, mais notre analyse semble indiquer que les SSD SLC ne sont pas plus fiables que les disques durs SAS ou SATA ; s’ils sont réellement la crème de la crème, il y a de fortes chances pour que les SSD MLC affichent un taux de panne supérieur aux disques durs.

Pour un particulier, ce constat a des implications majeures : les fabricants de SSD axent en effet leur communication sur deux avantages supposés des SSD, à savoir les performances et la fiabilité. Mais si vos données ne sont pas plus en sécurité sur un SSD que sur un disque dur, la seule véritable raison d’abandonner le stockage mécanique réside dans la vitesse.

Loin de nous l’idée d’affirmer que les performances n’ont aucune importance, mais il faut savoir que sur ce plan, la plupart des SSD actuels se tiennent dans un mouchoir de poche ; en termes de vitesse, les SSD d’entrée de gamme sont en général 85 % plus rapides que les disques durs, alors que les SSD haut de gamme ne sont que 88 % plus performants. Pas de quoi en faire un fromage…

C’est pour cette raison qu’Intel clame haut et fort que ses SSD sont les plus fiables du marché (dernier exemple en date : la conférence consacrée au lancement du SSD 320). Cette stratégie marketing semble porter ses fruits : ironiquement, c’est en raison de la réputation d’Intel que nous disposons d’autant d’informations sur ses SSD. Et pourtant, les chiffres de fiabilité mesurés en pratique ne correspondent pas à ceux annoncés par la firme de Santa Clara.

Une chose est sûre : les performances des SSD ne vont faire que s’améliorer tandis que leurs prix vont baisser ; c’est la nature même de toute nouvelle technologie. Cela signifie toutefois que les fabricants vont devoir trouver d’autres terrains pour différencier leurs produits de la concurrence ; il s’agit d’une stratégie que nous commençons à voir se profiler dès aujourd’hui : les écarts de performances entre produits s’amenuisant de plus en plus, la fiabilité va prendre une importance croissance.

Bilan

Notre étude porte presque exclusivement sur les taux de panne des SSD fabriqués par Intel, étant donné qu’il s’agit des produits que la plupart des grandes entreprises emploient le plus à l’heure actuelle. La stratégie marketing de la firme semble fonctionner à merveille ; cela ne signifie pas pour autant que les autres marques ne sont pas fiable, juste que les clients font confiance à Intel. Notons toutefois que pour les disques durs, comme le précise l’étude publiée par Google, « il est bien connu qu’il existe une forte corrélation entre les taux de panne et les fabricants, les modèles et les années de fabrication. Nos résultats ne le contredise pas : la plupart des résultats liés à l’âge sont influencés par l’année de fabrication ».

Les expériences relatées par les différents centres de données que nous avons interrogés indiquent que ce constat vaut également pour les SSD.Un représentant nous a ainsi confié que si OCZ proposait des prix intéressants, les Vertex 2 affichaient une fiabilité consternante : il y a deux mois, sa société avait reçu une caisse de 200 Vertex 2 Pro… dont une vingtaine n’on jamais fonctionné.Un autre centre de données nous a également affirmé devoir régulièrement réinitialiser les serveurs équipés d’OCZ Vertex 2.

Qu’est-ce que cela signifie en pratique ?

Résumons ce que nous savons à présent. Voici ce que les deux études précitées nous ont appris sur les disques durs :

- Le MTBF n’apporte aucune information pertinente en termes de fiabilité

- Le taux de panne annualisé (AFR) est plusieurs fois supérieur à celui annoncé par les fabricants

- Les disques durs n’ont pas tendance à tomber en panne la première année : le taux de panne augmente de manière linéaire avec l’âge

- La technologie SMART ne constitue pas un système fiable en matière de détection précoce des pannes

- Les taux de panne des disques durs « grand public » et « professionnels » sont pour ainsi dire identiques

- La panne d’un disque dur dans une grappe augmente la probabilité qu’un autre disque de la même grappe tombe également en panne

- La température n’a qu’une incidence négligeable sur le taux de panne

Grâce à Softlayer, nous savons que les quatre premiers points s’appliquent également aux SSD. N’oublions pas que la différence entre disque durs professionnels et grand public réside surtout dans le contrôleur, le firmware et l’interface (SAS contre SATA). En matière de SSD, cette différence se limite surtout au contrôleur et au firmware. Si la qualité de production de la mémoire NAND MLC est identique à celle de la SLC, les SSD professionnels ne sont pas plus fiables que leurs équivalents grand public (n’oublions pas que l’épuisement des cycles d’écriture n’a rien à voir avec les pannes aléatoires).

Conclusion

Malheureusement, tout cela ne s’applique qu’aux professionnels de l’informatique. Pour les particuliers, notre conseil est le suivant : ne faites pas plus confiance à votre SSD qu’à un disque dur. Un composant électrique reste un composant électrique, qu’il soit en mouvement ou non. Les données que nous a communiquées Softlayer le confirment d’ailleurs : les SSD Intel X25-E de plus grande capacité ont un taux de panne plus élevé que les modèles plus petits, car ils contiennent plus de puces de mémoire. Certes, nous ne possédons pour l’instant aucune information allant au-delà de deux ans, mais pour l’immédiat, mieux vaut prévenir que guérir.

Le plus énervant dans cette histoire provient du fait que nous ne devrions pas à avoir à compiler les données nous-mêmes. Après tout, les fabricants connaissent parfaitement les chiffres de fiabilité de leurs produits : des millions de SSD sortent de leurs usines chaque année (11 millions de SSD ont été produits en 2009 selon IDC) et sont au courant de tous les retours. Si les SSD SLC d’Intel sont effectivement ce qui se fait de mieux, il semblerait que les meilleurs SSD ne valent pas mieux que les meilleurs disques durs. Cela signifie-t-il que les pires SSD sont au même niveau de fiabilité que les pires disques durs ?

Au final, nous ne pouvons qu’inviter Intel, OCZ, Micron, Crucial, Kingston, Corsair, Mushkin, SandForce et Marvell a fournir des informations concrètes sur la fiabilité de leurs produits ou, à tout le moins, à publier la liste de leurs gros clients afin que nous puissions les contacter et procéder à une enquête plus approfondie.