Introduction

Il serait naïf de croire que Nvidia ait pu être satisfait du lancement de la GeForce GTX 480. Personne ne conçoit un GPU doté de 512 shaders pour en désactiver une partie, en faire une carte « haut de gamme » et annoncer avec un grand sourire « c’est exactement ce que nous voulions faire ». Il n’empêche que, même estropié comme il l’était, le GF100 était suffisamment puissant pour ramener la Radeon HD 5870 d’AMD au rang de deuxième carte mono-GPU la plus rapide du marché. Dans l’ensemble, les performances de la GeForce GTX 480 étaient franchement bonnes.

La quantité de chaleur dégagée par le processeur graphique, par contre, relevait plutôt du consternant, de même que le bruit généré par le ventilateur qui tentait désespérément de le refroidir. En SLI, les deux GTX 480 devaient être espacées de trois emplacements pour que la circulation de l’air soit suffisante. La situation s’est avérée si grave que Nvidia n’a pas eu d’autre choix que de publier une liste de boîtiers et cartes-mères recommandés (comprendre : capables de faire face aux « qualités » franchement uniques de la carte). C’est ainsi que la carte mono-GPU la plus rapide au monde est devenue une sorte de paria. Pas dans la même mesure que la vieille GeForce FX 5800, mais suffisamment pour inspirer son lot de vidéos satiriques.

L’histoire n’en reste toutefois pas là. Très peu de gens le savaient à l’époque, mais au moment du lancement de la GTX 480, en mars, Nvidia travaillait déjà sur sa remplaçante, une puce du nom de GF110. Celle-ci devait être annoncée deux mois plus tard, en mai. On peut si l’on veut la qualifier de GF100 débuggé et lancé dans le seul but de ravir la vedette au futur Cayman d’AMD ; pour les joueurs, cela ne fera toutefois aucune différence, ce n’est pas ce qui importe.

Mais qu’est-ce qui importe, dans ce cas ? Les performances. Le prix. Les fonctionnalités. La disponibilité. Et la concurrence.

Bien sûr, nous aborderons les performances dans les prochaines pages. Côté prix, Nvidia nous a confié viser un lancement aux alentours des 500 $ (500 € chez nous). Sur le plan des fonctionnalités, il n’y a pas grand-chose à dire : la GTX 580 est extrêmement proche de son aïeule. Et pour ce qui est de la disponibilité, plusieurs fabricants nous ont affirmé avoir reçu nettement plus de GeForce GTX 580 qu’ils n’avaient de 480 : là où ils s’étaient fait livrer 70 ou 80 cartes la dernière fois, ils en ont maintenant des centaines. Bref, si le haut de gamme vous tente, vous devriez cette fois en trouver.

Quid de la concurrence ? Chez AMD, on trouve des Radeon HD 5870 à moins de 290 € et des HD 5970 aux environs de 500 €, et nous savons tous que les modèles Cayman et Antilles sont sur le point d’être lancés ; le fondeur reste toutefois muet sur ces cartes, leurs performances et leur disponibilité, ce qui empêche toute comparaison. Nous savons juste qu’elles sont en chemin… Par conséquent, les Radeon HD 5870 et 5970 nous servirons aujourd’hui d’étalons.

La nouvelle carte du fabricant devrait creuser l’écart avec la concurrence mais parviendra-t-elle à surpasser l’AMD Radeon HD 5970 ?

GF110 : le Fermi relifté

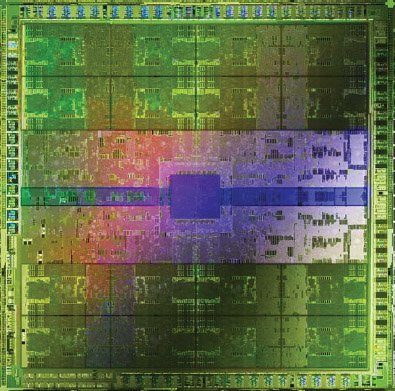

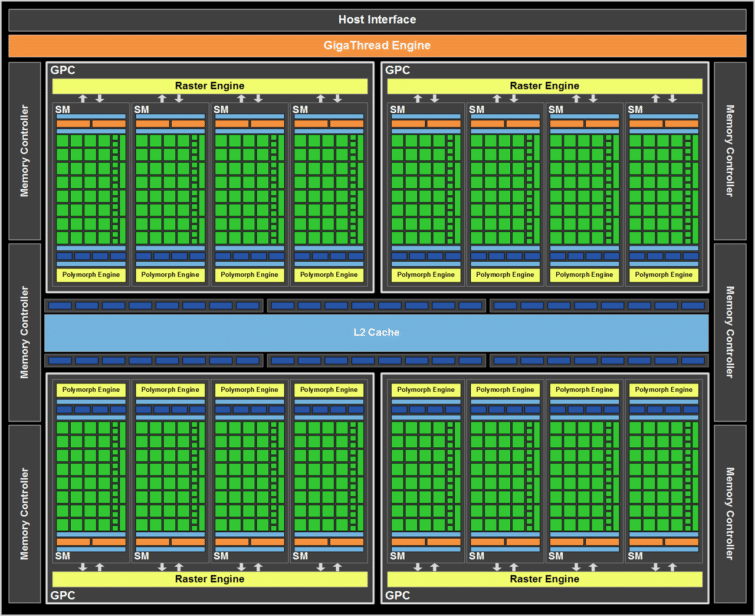

Le GF110 est plus une évolution qu’une révolution ; Nvidia n’étant pas vraiment retourné à la planche à dessin, ce processeur se base fortement sur le GF100 (voir notre analyse détaillée) et les différences avec celui-ci sont minimes. Globalement, cela reste une puce gravée en 40 nm et composée d’environ trois milliards de transistors.

Dans les grandes lignes, le GPU proprement dit est identique. Contrairement au GF104, qui faisait l’impasse sur quelques shaders pour se concentrer sur le traitement des textures à un prix plus serré, le GF110 fait la part belle au traitement pur et dur, ce qui se traduit en pratique par deux changements : le filtrage FP16 à pleine vitesse et une amélioration de l’efficacité du z-culling (traitement de la profondeur).

Le GF110 peut filtrer les textures FP16 en un cycle (comme le GF104) alors que le GF100 en avait besoin de deux. Dans les applications où les textures sont le facteur limitant, cela peut se traduire par un gain de performances. L’amélioration du z-culling, quant à elle, donne au GF110 un avantage dans les titres souffrant beaucoup d’overdraw, car elle permet de maximiser la bande passante disponible. D’après Nvidia, à fréquence égale, ces aménagements ont une incidence positive d’environ 14 % sur les performances.

| GeForce GTX 580 | GeForce GTX 480 | GeForce GTX 470 | |

|---|---|---|---|

| Graphics Processing Clusters (GPC) | 4 | 4 | 4 |

| Streaming Multiprocessors (SM) | 16 | 15 | 14 |

| Cores CUDA | 512 | 480 | 448 |

| Unités de textures | 64 | 60 | 56 |

| Unités ROP | 48 | 48 | 40 |

| Fréquence GPU | 772 MHz | 700 MHz | 607 MHz |

| Fréquence shaders | 1544 MHz | 1401 MHz | 1215 MHz |

| Fréquence mémoire (débit) | 1002 MHz (4008 MT/s) | 924 MHz (3696 MT/s) | 837 MHz (3348 MT/s) |

| Capacité mémoire | 1,5 Go de GDDR5 | 1,5 Go de GDDR5 | 1,5 Go de GDDR5 |

| Bus mémoire | 384 bits | 384 bits | 320 bits |

| Bande passante mémoire | 192,4 Go/s | 177,4 Go/s | 133,9 Go/s |

| Fillrate | 49,4 GTexels/s | 42,0 GTexels/s | 34,0 GTexels/s |

| Finesse de gravure | 40 nm TSMC | 40 nm TSMC | 40 nm TSMC |

| Format | Deux emplacements | Deux emplacements | Deux emplacements |

| Sorties vidéo | 2 x DL-DVI, 1 x mini-HDMI | 2 x DL-DVI, 1 x mini-HDMI | 2 x DL-DVI, 1 x mini-HDMI |

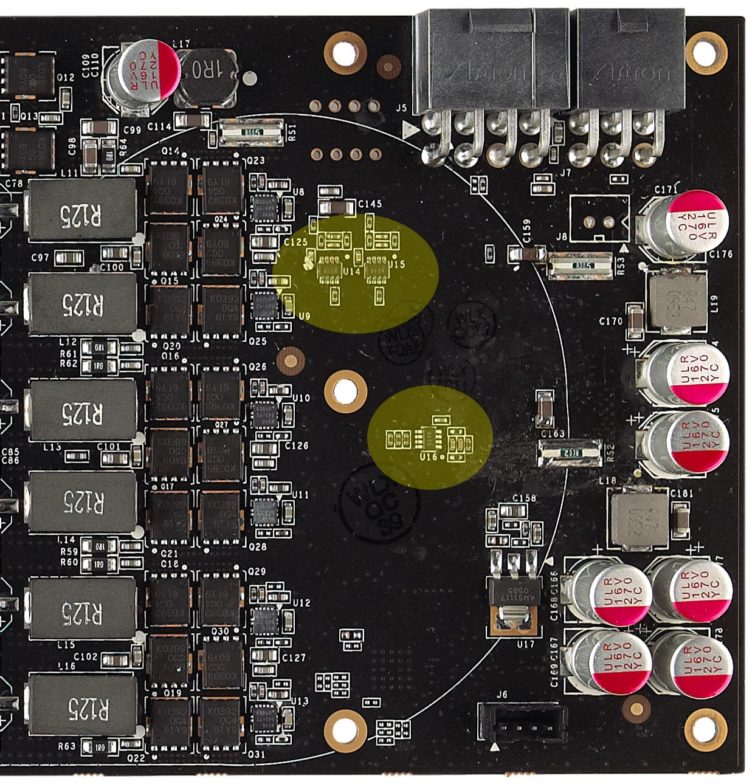

Le passage du GF100 au GF110 implique également un remaniement de la puce. Pour concevoir un circuit intégré, il est possible d’utiliser différents types de transistors selon les propriétés que l’on désire obtenir au final. Les ingénieurs de Nvidia ont modifié l’architecture du GF100 en faisant appel à des transistors plus lents mais occasionnant moins de fuites sur les chemins où le timing est moins essentiel et des transistors plus rapides sur les autres.

Cette modification induit une baisse de consommation appréciable permettant non seulement d’activer le 16e Shader Multiprocessor (désactivé sur le GF100 et ajoutant 32 cœurs CUDA, 4 unités de texture et un moteur de géométrie PolyMorph), mais également d’augmenter les fréquences : alors que la GeForce GTX 480 affichait des fréquences core/shaders/mémoire de 700/1401/924 MHz respectivement, la GTX 580 est dotée d’une fréquence de 772 MHz sur le core, de 1544 MHz sur les shaders et de 1002 MHz sur la mémoire (ce qui se traduit par un débit de 4008 MT/s). Les spécifications techniques du GF110 sont donc plus proches de ce que nous attendions en mars : 512 cores CUDA fonctionnels, 64 unités de textures et 16 moteurs PolyMorph.

Les portions indépendantes, quant à elles, semblent inchangées d’après le diagramme fourni par Nvidia, à l’exception de la fréquence plus élevée : nous avons donc toujours six partitions ROP associées à des bus de 64 bits (pour un total de 384 bits) et capables de générer huit pixels de 32 bits, ce qui donne un total de 48 pixels par cycle.

Tesselation

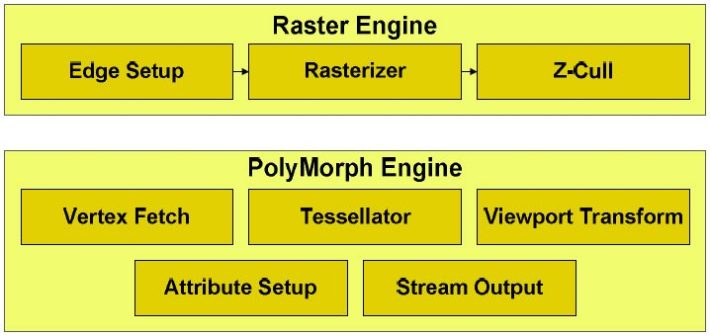

La géométrie semble connaître un soudain regain d’intérêt. Lorsque Nvidia nous a présenté son architecture Fermi et ce qu’elle allait apporter dans les jeux, deux éléments n’ont cessé de revenir : DirectX 11 et la tesselation. Le fait que la firme au caméléon ait intégré un de ses moteurs PolyMorph dans chacun de ses Shader Multiprocessors (donc 16 au total sur la GF110) était supposé faire une énorme différence dans les titres faisant un usage abondant de la tesselation en vue d’accroître leur réalisme. Le problème, bien entendu, était qu’il n’existait à l’époque aucun jeu capable de démontrer cette affirmation. Certes, il y avait bien DiRT 2 et Aliens vs. Predator, mais ces deux jeux DX11 de première génération ne font qu’un usage extrêmement limité de la géométrie et ne sont jamais parvenus à soutenir la thèse de Nvidia : « la géométrie est l’avenir du jeu ».

Depuis, il y a HAWX 2. Enfin, disons plutôt « il y aura » : le jeu n’est toujours pas sorti. Nous en avons toutefois reçu une copie il y a quelques jours, et nous avons l’intention de l’intégrer à notre batterie de test, où il remplacera HAWX premier du nom. Ce titre fait clairement controverse, dans la mesure où AMD estime qu’il emploie un facteur de tesselation nettement trop élevé et non optimisé, ce qui handicape ses cartes graphiques (plus que celles du caméléon). Le fabricant a déclaré faire pression sur l’éditeur pour que celui-ci sorte un correctif qui permettrait de régler le niveau d’utilisation de la géométrie. Quoi qu’il en soit, lorsque le jeu sortira, avec ou sans correctif, l’expérience de jeu sera ce qu’elle sera ; nous en ferons état sans prendre partie.

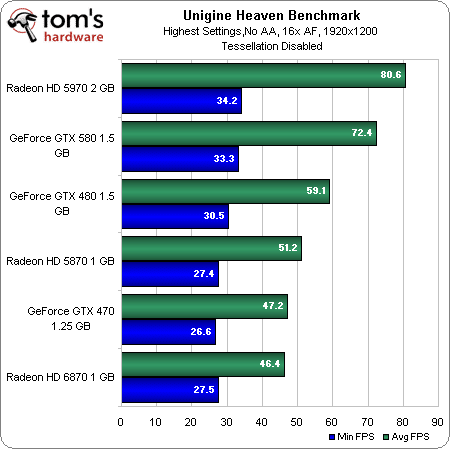

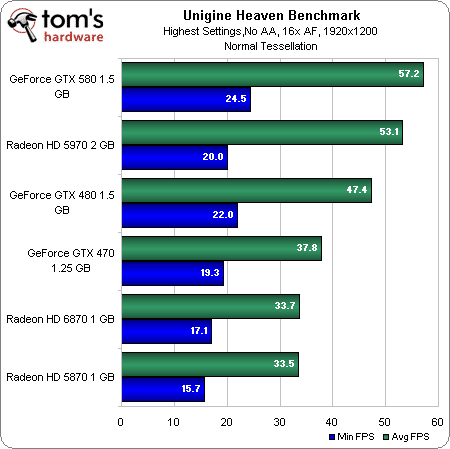

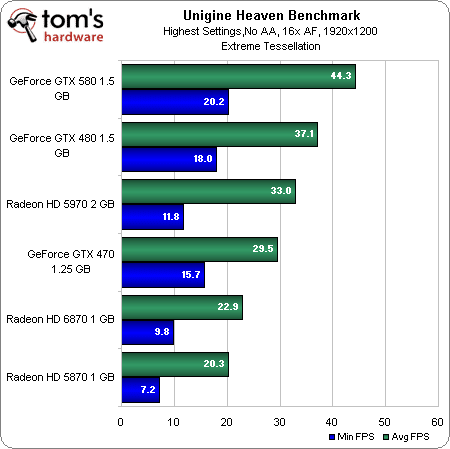

Pour l’instant, nous mesurons les performances en géométrie de chaque architecture à l’aide d’Unigine.

Tesselation normale

Tesselation extrême

Comme on le voit, bien qu’AMD affirme que son approche de la tesselation soit la bonne, il apparaît assez clairement que lorsque la complexité augmente, celle de Nvidia parvient mieux à maintenir les performances. Les SM supplémentaires de la GeForce GTX 580, couplés à ses moteurs PolyMorph et à ses fréquences plus élevées, semblent lui donner un avantage assez net par rapport à la GTX 480 en mode « Extreme » ; à titre de comparaison, la Radeon HD 5870 n’arrive même pas au niveau de la GeForce GTX 470 dès que la complexité atteint un certain niveau.

Il est également intéressant de noter que la Radeon HD 6870 fait mieux dans ce test que la HD 5870, pourtant mieux équipée techniquement. AMD a déclaré avoir travaillé sur les performances en tesselation pour ses GPU Barts ; de fait, malgré son manque de shaders, la nouvelle carte fait mieux que l’ancienne (et bénéficie en outre d’un framerate minimal plus élevé).

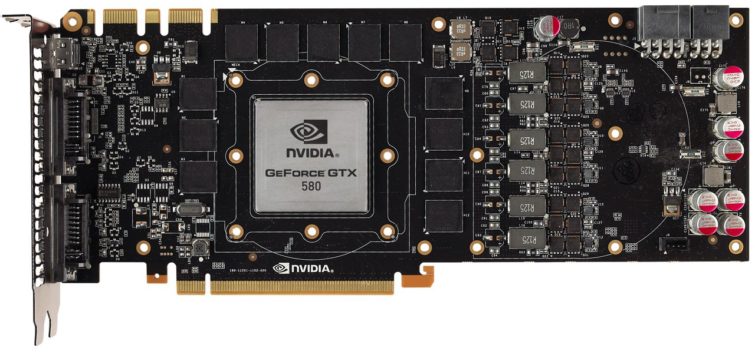

GeForce GTX 580 : nouveau design

Étant donné que Nvidia est parvenu à améliorer le rendement thermique de sa nouvelle architecture afin d’augmenter les performances de sa puce (plus de shaders, fréquences plus élevées), la GeForce GTX 580 possède un TDP légèrement inférieur à celui de la GTX 480 : 244 watts contre 250. A priori, nous devrions donc rencontrer les mêmes problèmes de chauffe et de bruit qu’auparavant ; fort heureusement, pendant qu’une équipe d’ingénieurs s’attelait à optimiser le GPU, une autre s’est chargée de gommer les principaux défauts du reste de la carte graphique.

Fini donc le gros radiateur nu, les caloducs dépassant de partout et le ventilateur ultra-bruyant.

Au lieu de cela, la nouvelle carte est équipée d’un dissipateur à chambre de vaporisation ; fabriqué en cuivre, celui-ci dispose de son propre cycle d’évaporation/condensation afin de transférer plus efficacement la chaleur vers les ailettes, ce qui remplace donc les caloducs. Nvidia emploie toujours un ventilateur poussant l’air à travers le dissipateur vers l’extérieur du boîtier, mais celui-ci est renforcé afin de moins monter dans les aigües. Il est de plus contrôlé directement par le GPU, ce qui lui permet de réagir plus finement (et plus discrètement) à l’activité de celui-ci.

Le résultat final est une carte entièrement fermée qui reste chaude, mais qui fait nettement moins mal lorsqu’on la touche après une série de tests ! Elle est remarquablement silencieuse au repos et bien moins déplaisante en charge. Bref, répétons cela pour être parfaitement clairs : le problème du bruit, qui constituait l’une des principales raisons d’éviter la GeForce GTX 480, est en pratique réglé sur la GTX 580.

Malgré ces évolutions physiques importantes, la GeForce GTX 580 reste aussi longue que la 480 (26,7 cm) ; elle nécessite toujours un connecteur à huit broches et un autre à six broches en plus du port PCI Express (Nvidia recommande en outre une alimentation d’au moins 600 watts).

Comme son aînée, elle est toujours limitée à deux sorties vidéo simultanées, via deux connecteurs DVI dual-link et/ou un port mini-HDMI. Sachant qu’AMD permet maintenant de gérer quatre écrans en même temps via DisplayPort, DVI et HDMI (sur ses cartes milieu de gamme ; certaines cartes haut de gamme pouvant aller plus loin encore), il est vraiment plus que temps pour Nvidia de faire sauter cette limitation. Il s’agit là d’un argument de vente imparable pour AMD, à moins d’acheter deux GeForce. Et n’oublions pas que la GTX 580 occupe déjà deux emplacements.

Suivi de la consommation

Les circuits de protection antisurtension nous ont obligé à modifier la manière dont nous, les testeurs, mesurons la consommation, la température et les nuisances sonores.

Lorsqu’AMD a lancé ses processeurs graphiques Cypress, il les a assorti d’un mécanisme chargé de contrôler l’état du régulateur de tension de la carte graphique ; en cas de surtension (même sans surchauffe du GPU), ce mécanisme diminue la fréquence de la puce afin de réduire la consommation. Tout cela en plus du système de protection thermique qui sert à éviter que la puce ne chauffe trop. Il est donc d’un coup devenu possible d’exécuter un logiciel appliquant une charge constante sur la carte (par exemple FurMark) et d’obtenir des chiffres des consommation anormalement bas sans pour autant être témoin de températures élevées indiquant un problème. Heureusement, dans l’intérêt des tests, nous sommes tout de même parvenus à trouver une combinaison de paramètres permettant de mettre la pression sur le GPU sans déclencher ces deux systèmes de sécurité made in AMD.

Nvidia aura mis du temps à rattraper le coche, mais met enfin en œuvre quelque chose de similaire sur la GeForce GTX 580. La société affirme que ses GPU sont équipés d’un dispositif de surveillance thermique depuis plusieurs années (mais dans ce cas, nous nous expliquons mal pourquoi, il y a quelques mois, le pilote 196.xx a envoyé au cimetière une série de cartes graphiques à base de G92) ; maintenant, la puissance et la tension de tous les rails 12 V fait également l’objet d’un suivi : s’ils s’écartent des marges spécifiées, le driver limiterait automatiquement ses performances. Nous reviendrons sur ce sujet à la page consacrée à la consommation.

Configuration de test et benchmarks

| Configuration de test | |

|---|---|

| Processeurs | Intel Core i7-980X (Gulftown) 3,33 GHz overclocké à 3,73 GHz (28 x 133 MHz), LGA 1366, QPI 6,4 GT/s, 12 Mo de cache L3 partagé, Hyper-Threading activé, fonctions d’économie d’énergie activées |

| Carte-mère | Gigabyte X58A-UD5 (LGA 1366) Intel X58/ICH10R, BIOS FB |

| Mémoire | 6 Go (3 x 2 Go) de DDR3-2000 Kingston, KHX2000C8D3T1K3/6GX @ 8-8-8-24 et 1,65 V |

| Disque dur | Intel SSDSA2M160G2GC 160 Go SATA 3 Gbit/s |

| Cartes graphiques | Gigabyte GV-N580D5-15I GeForce GTX 580 1,5 Go |

| Nvidia GeForce GTX 480 1,5 Go | |

| Nvidia GeForce GTX 470 1,25 Go | |

| AMD Radeon HD 5970 2 Go | |

| AMD Radeon HD 5870 1 Go | |

| AMD Radeon HD 6870 1 Go | |

| Alimentation | Cooler Master UCP-1000 watts |

| Logiciels et pilotes | |

| OS | Windows 7 Édition Intégrale 64 bits |

| DirectX | DirectX 11 |

| Pilotes graphiques | AMD Catalyst 10.10 |

| Nvidia GeForce 260.99 (pour les GTX 480 et 470) | |

| Nvidia GeForce 262.99 (pour la GTX 580) | |

Outre notre banc d’essai ouvert, qui convient parfaitement à la collecte des données de performances mais s’avère inadapté lorsqu’il s’agit de mesurer les performances thermiques ou sonores des cartes (et surtout des configurations SLI et CrossFire), nous avons eu recours à un ordinateur qui nous a été envoyé par Falcon Northwest, un prototype de Mach V dans un boîtier Icon 2. Les plus attentifs d’entre vous lui reconnaîtront sûrement un look très proche de celui des produits SilverStone ; quoi de plus normal quand on sait que l’Icon 2 est en chantier depuis 2002 et que c’est cette société qui a été chargée de sa fabrication ? Apparemment, SilverStone a repris certains éléments du design pour les intégrer à ses produits.

Ce boîtier ne devrait pas être disponible avant un bon mois, mais si vous prévoyez d’acheter un système haut de gamme après les fêtes, il constituera sans le moindre doute un candidat tout à fait valide. Il offre la particularité d’être compartimenté afin d’améliorer le refroidissement, ce qui signifie que les cartes graphiques sont isolées du reste de la configuration (dans notre cas, un Core i7-980X overclocké à 4,2 GHz refroidi par un système de poussée/extraction Asetek 570LC.

Le Mach V démontre clairement à quel point la différence entre la GeForce GTX 480 et la 580 est importante ; pendant que le ventilateur de la 480 tournait à fond et faisait un bruit de tondeuse à gazon, la GTX 580 était plus silencieuse que le ventilateur Scythe de 120 mm qui orne la face arrière de l’ordinateur, et ce, même en charge.

| Jeux | |

|---|---|

| Lost Planet 2 | Paramètres de qualité maximum, AA désactivé / AF 16x, vsync off, 1680×1050 / 1920×1200 / 2560×1600, DirectX 11, version Steam |

| Just Cause 2 | Paramètres de qualité maximum, AA désactivé / AF 16x, vsync off, 1680×1050 / 1920×1200 / 2560×1600, filtre Bokeh et eau GPU désactivés (pour les cartes Nvidia), benchmark Concrete Jungle |

| Metro 2033 | Paramètres de qualité moyens, AAA / AF 16x, 1680×1050 / 1920×1200 / 2560×1600, benchmark intégré, version Steam |

| DiRT 2 | Paramètres de qualité Ultra High, AA 4x / AF désactivé, 1680×1050 / 1920×1200 / 2560×1600, version Steam, benchmark scripté personnalisé, rendu DirectX 11 |

| Benchmark Aliens vs. Predator | Paramètres de qualité maximum, SSAO, AA désactivé / AF 16x, vsync off, 1680×1050 / 1920×1200 / 2560×1600 |

| Battlefield: Bad Company 2 | Paramètres de qualité personnalisés (maximum), MSAA 8x / AF 16x, 1680×1050 / 1920×1200 / 2560×1600, cinématique d’introduction, séquence de 145 secondes, FRAPS |

| 3DMark Vantage | Performance Default, PPU désactivé |

| Civilization 5 | Paramètres de qualité maximum, AA désactivé, 1920×1080, version démo, benchmark Leader, test d’affichage de la carte (zoom avant et arrière) |

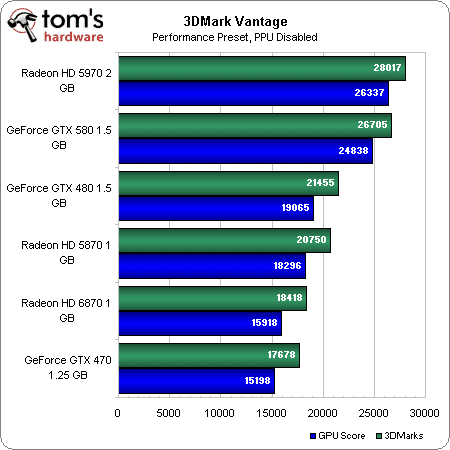

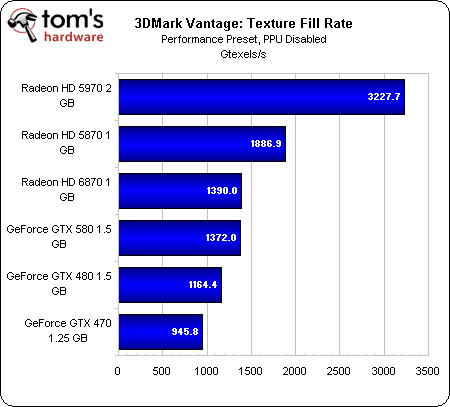

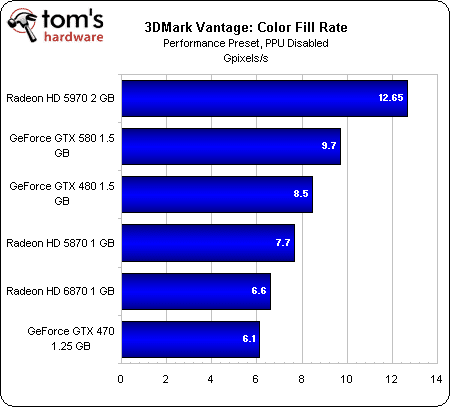

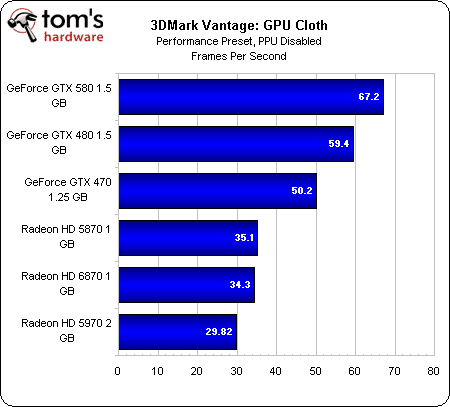

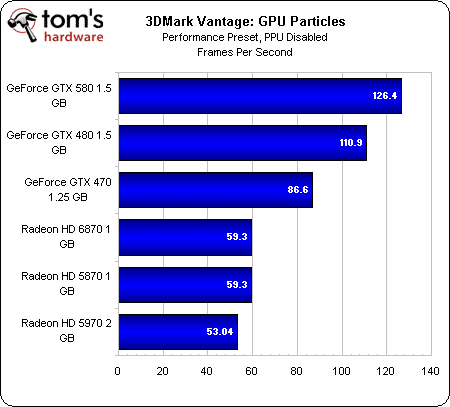

3DMark Vantage

Pour commencer et pour les inconditionnels, nous soumettons toutes les cartes à un test sous 3DMark Vantage, ce qui nous permet de nous faire une idée globale des performances dont elles sont capables et de les situer par rapport aux modèles précédents (du moins, marque par marque et non entre elles).

Vous vous ferez une meilleure idée des domaines dans lesquels les différentes cartes excellent en examinant les graphiques ci-dessous ; de manière générale, les cartes AMD ont un fillrate de textures exceptionnel tandis que Nvidia domine les tests spécifiques et très gourmands à l’instar des particules.

Fillrate textures

Fillrate couleurs

Pixel Shader complexe

Pixel Shader mathématique

Tissu

Particules

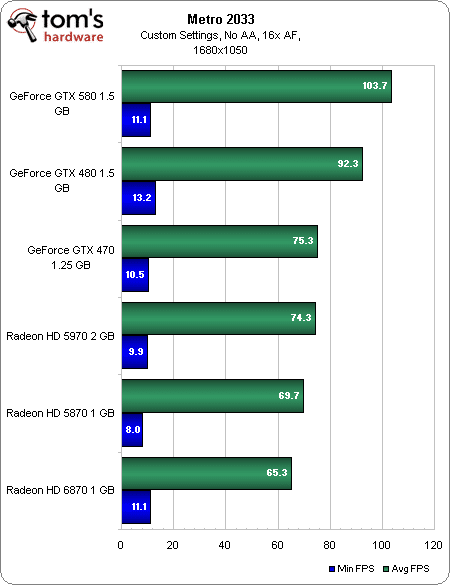

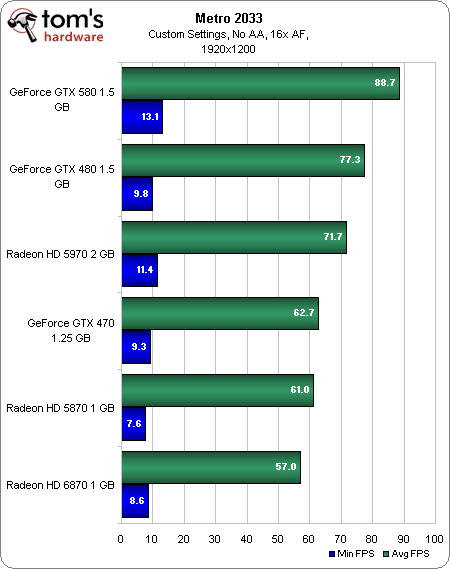

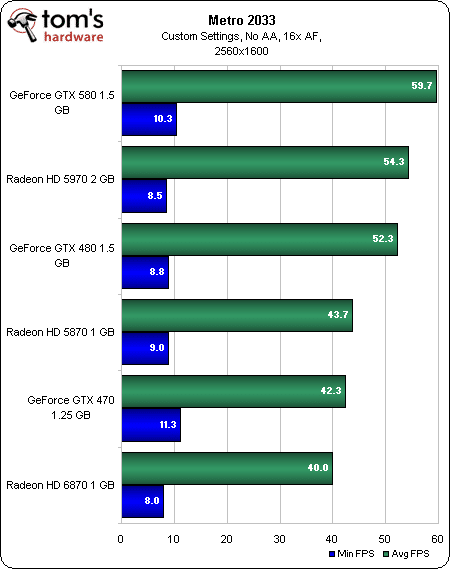

Metro 2033 (DX11)

1680 x 1050

1920 x 1200

2560 x 1600

Ceux qui ont lu notre test de la GeForce GTX 480 se souviendront peut être que Metro 2033 favorisait clairement les cartes Nvidia. Rien d’étonnant à cela : le titre fait appel aux optimisation PhysX et appartient au programme The Way It’s Meant To Be Played. Si vous voulez vraiment faire plier tous les GPU, activez l’effet de profondeur de champ en post-traitement. Basé sur DirectCompute, il divise le framerate par deux, quelle que soit la carte.

Les performances des Radeon sont clairement meilleures que jadis, mais les GeForce dominent toujours globalement : les GTX 580 et 480 parviennent toutes les deux à surpasser la Radeon HD 5970, sauf en 2560*1600 pour la GTX 480. A l’inverse, la Radeon HD 6870 finit dernière dans toutes les situations.

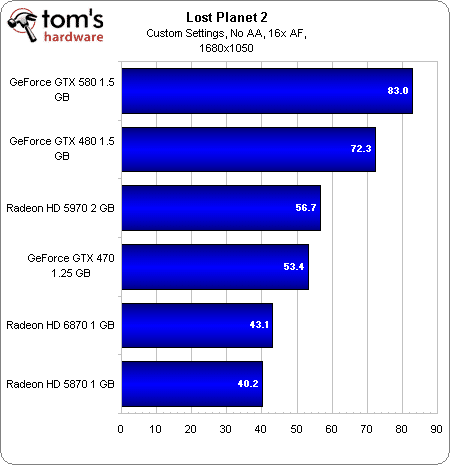

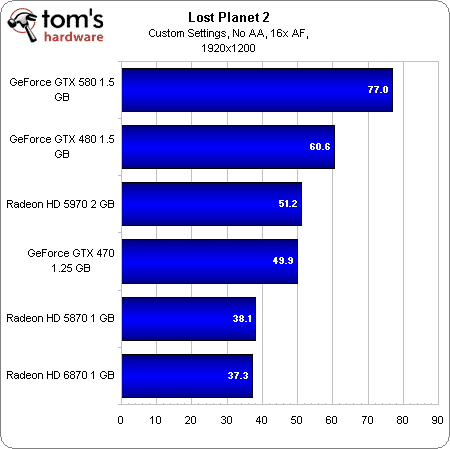

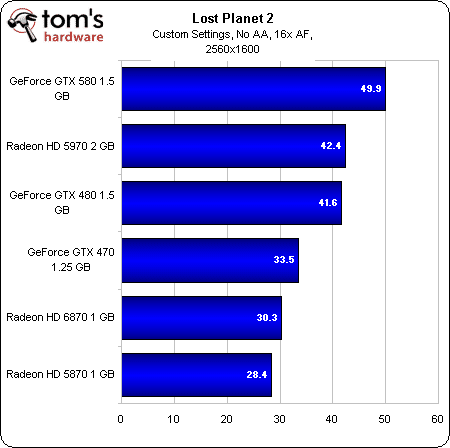

Lost Planet 2 (DX11)

1680 x 1050

1920 x 1200

2560 x 1600

L’AMD Radeon HD 5970 résorbe peu à peu son retard sur la GeForce GTX 480 au fur et à mesure que l’on monte en résolution dans Lost Planet 2 pour finalement la dépasser en 2560×1600. La GeForce GTX 580, cependant, reste en première place dans tous les cas.

Nous notons toutefois avec intérêt que la nouvelle Radeon HD 6870 parvient à faire mieux que la HD 5870 en 1680×1050 et en 2560×1600. En 1920×1200, les deux cartes sont à moins d’une image/seconde d’écart.

Comment expliquer un tel écart de performances ?

Nvidia affirme que l’architecture de ses nouvelles cartes est plus adaptée aux derniers jeux DirectX 11, mais il est difficile de dire avec certitude si les performances qu’elles affichent dans Lost Planet 2 (ainsi que dans Metro 2033) ont plus à voir avec le fait qu’il s’agit d’un titre TWIMTBP ou avec celui qu’il fasse tellement appel aux graphismes next-gen. Très franchement, au vu de leurs performances dans certains autres jeux DX11, nous aurions tendance à opter pour la première solution. Non que cela change quoi que ce soit pour qui veut jouer à Lost Planet 2 aujourd’hui : Nvidia offre un framerate supérieur, et c’est tout ce qui compte.

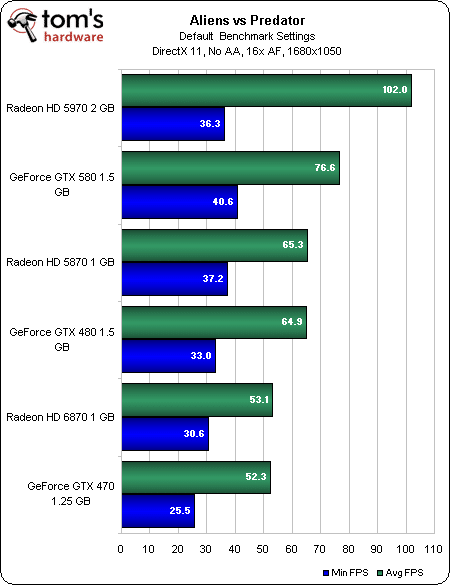

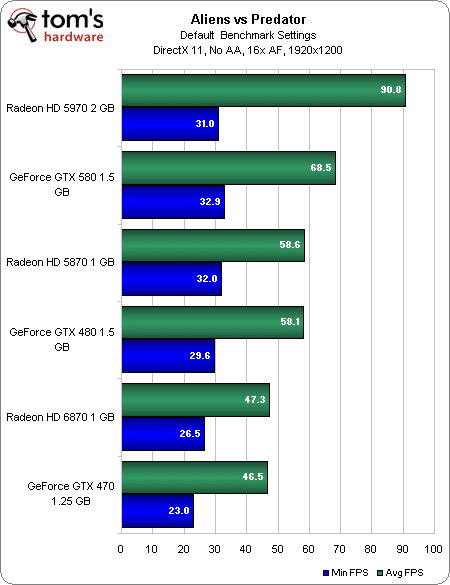

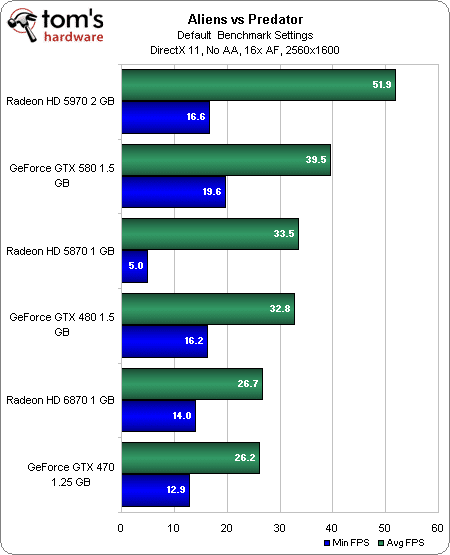

Aliens vs. Predator (DX11)

1680 x 1050

1920 x 1200

2560 x 1600

Comme pour confirmer ce que nous disons à la page précédente, Aliens vs. Predator n’est pas un titre TWIMTBP, et les cartes AMD s’en tirent nettement mieux. La Radeon HD 5970 se place nettement en tête, suivie de la GeForce GTX 580, et la Radeon HD 5870 arrive en troisième position, devant la GTX 480.

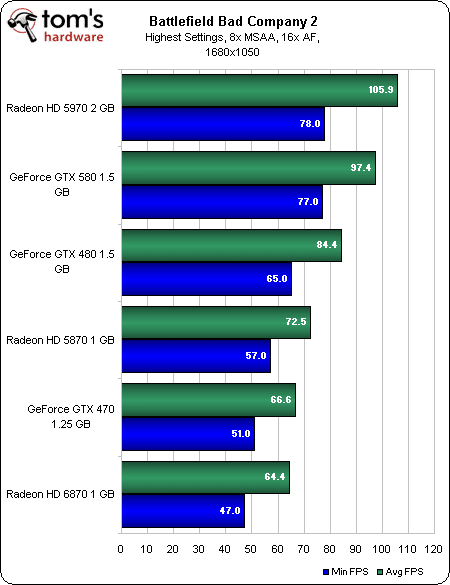

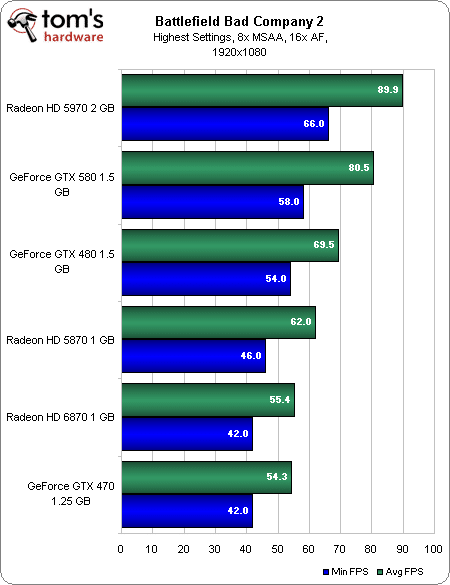

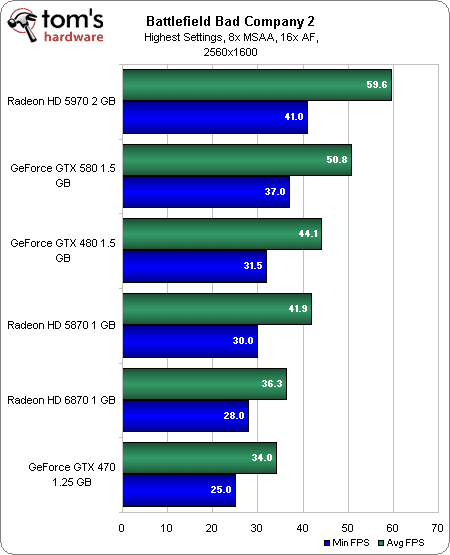

Battlefield: Bad Company 2 (DX11)

1680 x 1050

1920 x 1200

2560 x 1600

La Radeon HD 5970 d’AMD règne une fois encore en maître sur un titre non-TWIMTBP. Présenté comme l’un des premiers jeux DX11 (même s’il n’y fait pratiquement pas appel), Bad Company 2 est sorti avant que Nvidia ne dispose d’une architecture compatible avec la dernière version de l’API de Microsoft.

Cela n’empêche pas la GeForce GTX 580 d’arriver en deuxième place au finish et de se placer devant la GTX 480 dans les trois résolutions (avec entre 15 % et 17 % d’avance en 2560*1600). Peut-être plus significatif encore, elle creuse l’écart avec la Radeon HD 5870. Celle-ci rattrape cependant presque la GeForce GTX 480 en 2560×1600 (tout en étant nettement moins coûteuse).

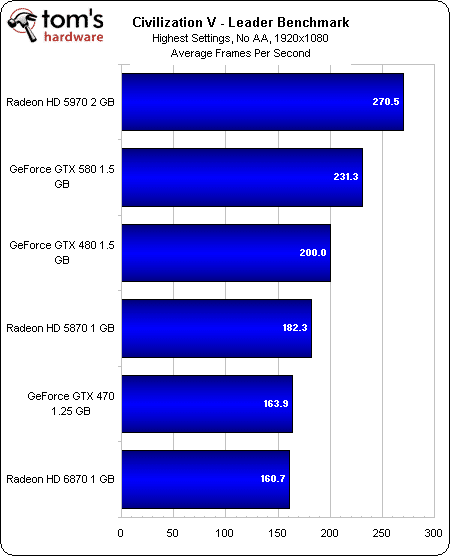

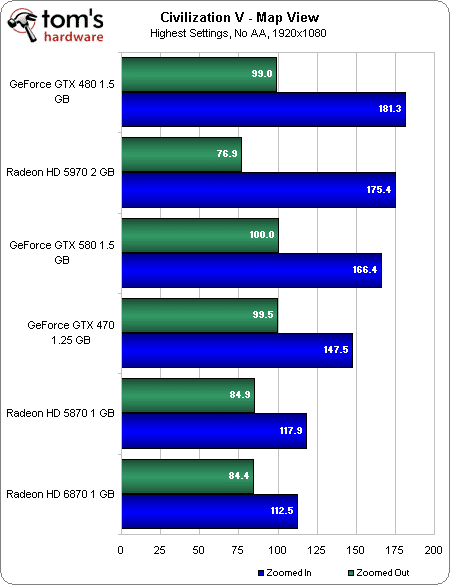

Civilization V (DX11)

Benchmark « Leader »

Affichage de la carte

Civilization V est un titre difficile à benchmarker, mais nous tenions tout de même à l’inclure afin de faire contrepoids avec tous les FPS de notre batterie de test. Point très intéressant : alors que la plupart des développeurs font appel à DirectX 11 pour améliorer la qualité visuelle de leurs jeux, Firaxis emploie la tesselation pour augmenter les performances.

Conséquence directe : nous obtenons ici des framerate absolument incroyables. La carte la plus rapide affiche les unités de commandement du jeu à près de 300 images/s ! Le classement reste plus ou moins conforme à nos attentes, mais les chiffres sont impressionnants.

Le test d’affichage de la carte consiste à mesurer les performances en zoom avant et arrière sur la carte du monde. Les framerates sont un peu moins cohérents, mais les résultats obtenus restent plus que jouables, et ce, même avec tous les détails poussés au maximum.

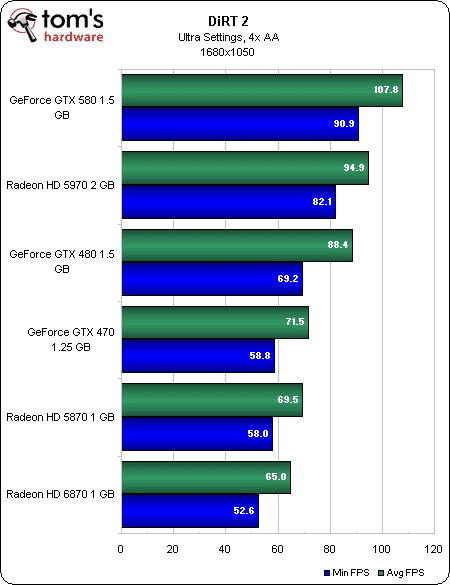

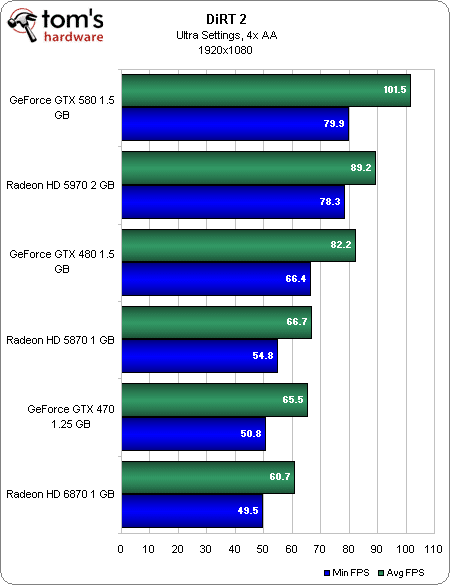

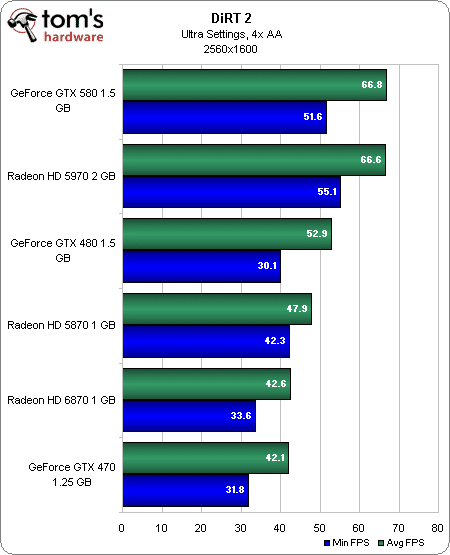

DiRT 2 (DX11)

1680 x 1050

1920 x 1200

2560 x 1600

Malgré un match presque nul en 2560×1600, la GeForce GTX 580 coiffe au poteau la Radeon HD 5970 dans les trois résolutions testées sous DiRT 2, l’un des premiers jeux compatibles DirectX 11 et anciennement considéré comme un « titre AMD ». La HD 5970 arrive en deuxième place dans tous les cas, suivie de la GeForce GTX 480 et de la Raden HD 5870.

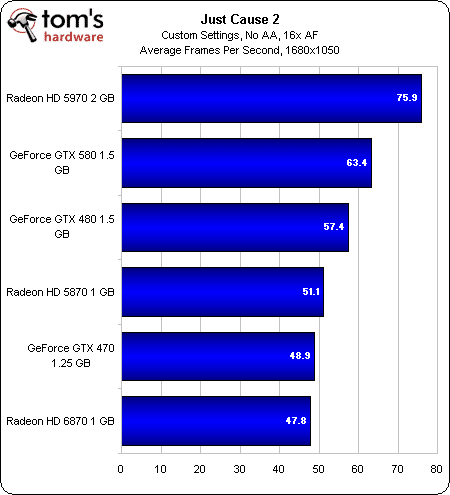

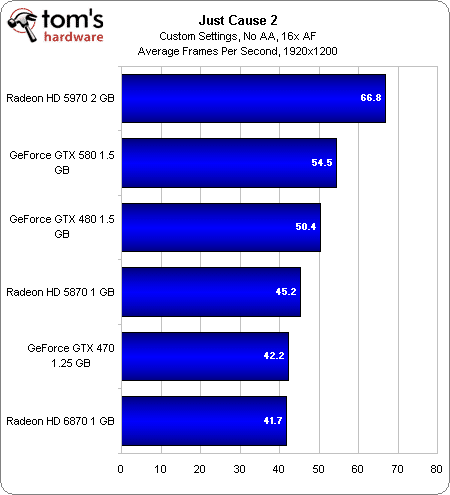

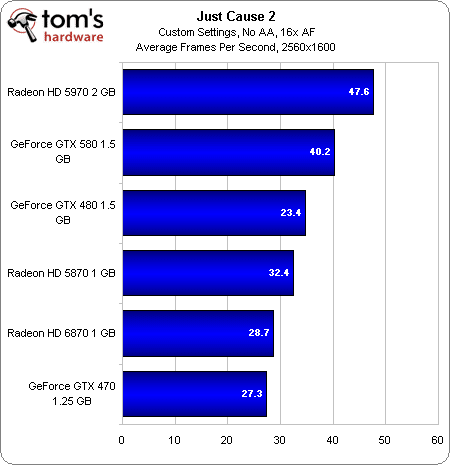

Just Cause 2 (DX11)

1680 x 1050

1920 x 1200

2560 x 1600

Dans Just Cause 2, la Radeon HD 5970 arrive en première place quelle que soit la résolution, suivie de la GeForce GTX 580. Celle-ci s’avère jusqu’à 20 % plus performante que la GTX 480 qui se place en troisième position, avec la Radeon HD 5870 sur les talons.

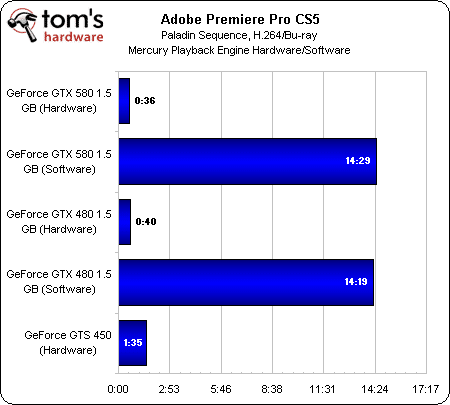

Adobe Premiere Pro CS5

Rendu matériel vs rendu logiciel

Cela faisait un moment que nous cherchions une application non vidéoludique à inclure dans nos tests de cartes graphiques ; le logiciel Adobe Premiere Pro CS5 est suffisamment populaire auprès des professionnels et des utilisateurs avancés pour tenir ce rôle et faire la démonstration de ce que peut apporter le calcul sur GPU, une technologie qu’il prend maintenant en charge de manière native.

Rappelons que le Mercury Playback Engine d’Adobe n’est compatible qu’avec un nombre limité de cartes graphiques CUDA. Malheureusement, ni la GeForce GTX 480 ni la 580 ne sont sur la liste alors que, paradoxalement, la GeForce GTX 470 s’y trouve ; nous avons donc dû « hacker » Premiere pour les faire fonctionner (si l’anglais ne vous rebute pas, n’hésitez pas à consulter l’article de notre collaborateur William Van Winkle sur les performances d’Abode CS5 pour savoir comment faire). Nous n’avons pas testé les cartes AMD car il ne s’agit pas d’un match AMD/Nvidia, mais bien d’un comparatif entre le rendu matériel (GPU) et logiciel (CPU). Les cartes AMD devraient se comporter de manière très similaire aux rendus logiciels, avec un score dépendant essentiellement de notre Core i7-980X overclocké à 4,2 GHz ici.

Sans surprise, le rendu avec accélération matérielle est plus de 20 fois plus rapide que le rendu logiciel. La vraie question est toutefois la suivante : cela vaut-il la peine de mettre 500 € dans une carte graphique pour bénéficier de meilleures performances dans le Mercury Playback Engine ? Probablement pas : même notre petite GeForce GTS 450 parvient à terminer ce projet, pourtant bourré d’effets, en 1’35. Alors certes, la GTX 580 bat la 480 de quatre secondes, mais au final, cette carte n’est vraiment intéressante que si le jeu est votre priorité. Si ce n’est pas le cas, un GPU mois onéreux (et pris en charge) suffit largement.

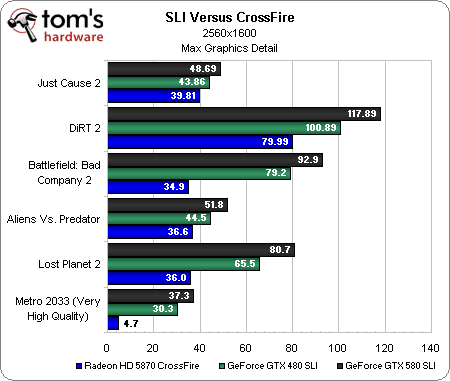

Performances en SLI/CrossFire

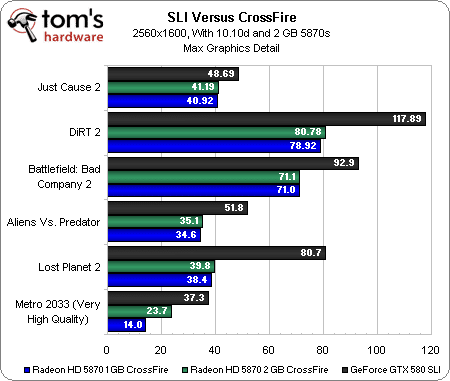

SLI contre CrossFire

Nous avons déjà vu à maintes reprises que les gains de performances apporté par le SLI sur les cartes Nvidia étaient excellents. Cela reste une fois de plus le cas avec la GeForce GTX 580.

Ce comparatif Nvidia/AMD nécessite toutefois quelques explications au cas par cas ; en effet, bien que nous désirions utiliser les paramètres de qualité maximum dans tous les titres, la Radeon HD 5870 est incompatible avec l’antialiasing de certains jeux.

Dans Just Cause 2, les cartes Nvidia fonctionnent en CSAA 32x et les AMD en MSAA 8x, et les performances sont toutes assez proches les unes des autres en 2560×1600 avec tous les détails au maximum. Passer des GTX 480 aux 580 n’apporte en fait pas grand-chose, mais bon, le framerate reste très jouable dans les deux cas.

Pour DiRT 2, la comparaison est plus simple, dans la mesure où les trois configurations fonctionnent en MSAA 4x. Pas de mauvaise surprise donc : que vous ayez deux AMD Radeon HD 5870 ou deux Nvidia GeForce GTX 580, vous pourrez monter jusqu’en 2560×1600 sans aucun problème.

Les Radeon semblent avoir quelques problèmes avec le MSAA 8x dans Battlefield: Bad Company 2. Par contre, curieusement, elles sont plus rapides que les GeForce en MSAA 4x. Les GTX 580 sont environ 17 % plus performantes que les GTX 480.

Aucun problème de comparaison non plus pour Aliens vs Predator, les trois paires de cartes étant limitées au MSAA 4x. Ici aussi, les GTX 580 se montrent à peu près 16 % plus rapide que les GTX 480.

Lost Planet 2, par contre, s’est avéré pratiquement impossible à benchmarker en MSAA 8x sur les AMD Radeon. En fait, même en MSAA 4x, le ralentissement encouru est énorme. Les GeForce, de leur côté, n’ont aucun souci avec ce titre TWIMTBP, et on note un écart de 23 % entre les GTX 580 et les 480.

Metro 2033 ne peut monter que jusqu’en MSAA 4x, mais avec les paramètres de qualité « Very High », cela suffit à mettre les cartes AMD à genoux. Si nous n’étions pas si suspicieux des optimisations réalisées en faveur de Nvidia, nous donnerions à ce jeu le titre de « nouveau Crysis » et le laisserions dans notre batterie de test pour les trois prochaines années (non, on vous rassure, c’est pour rire). Il semble qu’une fois de plus, le manque de frame buffer des cartes AMD entraîne une dégradation des performances, alors que le 1,5 Go de mémoire des GeForce s’avère bien utile aux résolutions que l’on est en droit d’attendre lorsqu’on s’est payé deux cartes à un prix pareil.

Mise à jour (AMD Catalyst Hotfix 10.10d)

Notons toutefois que les derniers pilotes AMD Catalyst Hotfix 10.10d contiennent des optimisations relatives au CrossFire dans une série de jeux. Parmi ceux-ci, un seul se trouve dans notre batterie de test : Metro 2033. Avec ces pilotes mis à jour, le framerate passe 4,7 images/s à 14,0 images/s sur notre paire de Radeon HD 5870 1 Go en CrossFire ; ce n’est pas encore jouable, mais cela représente tout de même une sacrée amélioration.

Il est également possible d’accroître les performances en optant pour des cartes équipées de 2 Go de mémoire, qui éliminent le goulot d’étranglement provoqué par les hautes résolutions et le MSAA ; avec une paire de Radeon HD 5870 2 Go, nous avons obtenu un framerate de 23,67 images/s dans Metro 2033. Malheureusement, ces cartes coûtent environ 50 € de plus chacune, ce qui signifie que le prix d’un CrossFire devient plus élevé que celui d’un SLI de GeForce GTX 480.

Nous avons aussi enregistré une hausse de performances (par rapport au premier graphique de cette page) dans Battlefield: Bad Company 2, mais celle-ci semble plus résulter du hotfix des pilotes que du gigaoctet de mémoire supplémentaire par carte. Dans l’ensemble, les cartes 2 Go ne valent pas trop le surcoût qu’elles entraînent.

Consommation, température et bruit

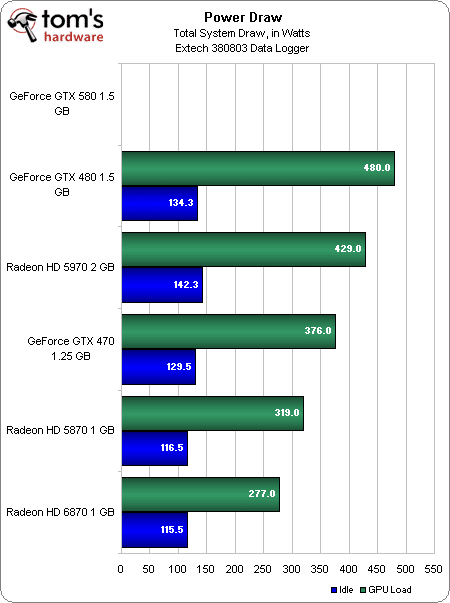

Consommation moyenne à la prise (FurMark)

N’est il pas beau notre graphique ? En charge, la GeForce GTX 480 arrive tout en haut (c’est-à-dire en dernière place…) du classement avec son processeur GF100, suivie de la Radeon HD 5970, qui est pourtant une carte bi-GPU, de la GeForce GTX 470, de la Radeon HD 5870 et enfin de la Radeon HD 6870, bien connue pour sa faible consommation.

Mais où est donc passée la GeForce GTX 580 ? Hé bien, le circuit de protection antisurtension mis en place par Nvidia réduit automatiquement la fréquence de la carte lorsqu’on tente de la faire fonctionner sous FurMark ; par conséquent, les résultats obtenus sont inférieurs à ceux de la GTX 470, mais ce n’est bien sûr absolument pas réaliste. AMD comme Nvidia ont toujours détesté FurMark et sa capacité à faire gonfler (« artificiellement ») les chiffres de consommation ; il semblerait que nous n’ayons bientôt plus d’autre choix que de l’abandonner…

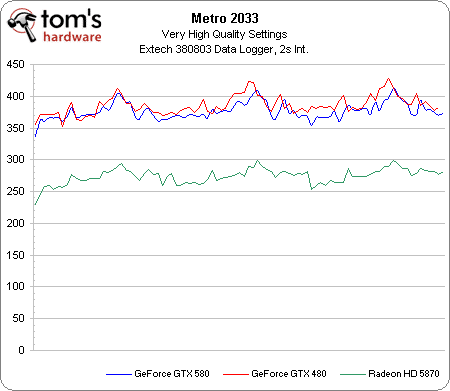

Consommation à la prise (Metro 2033)

Loin de nous avouer vaincus, nous avons mesuré la consommation des trois cartes via le benchmark intégré à Metro 2033, jeu particulièrement gourmand en puissance de traitement. Les résultats sont éloquents, et ce, à plus d’un titre. Pour commencer, nous voyons que la consommation de la GeForce GTX 580 et celle de la 480 ne s’écartent en moyenne que de 9 watts lors de ce test, ce qui peut paraître étonnant au vu des optimisations énergétiques apportées au nouveau bébé de Nvidia. L’explication réside dans le fait que le fabricant a augmenté les fréquences et a activé les 16 SM du GF110, ce qui accroît forcément la consommation.

Il est plus intéressant de constater que la Radeon HD 5870 consomme environ 100 watts de moins que les GeForce, alors que FurMark nous montrait plutôt une différence de 160 watts. Cela n’en reste pas moins un chiffre impressionnant ; c’est indéniable, les performances énergétiques des GPU Cypress d’AMD sont réellement excellentes.

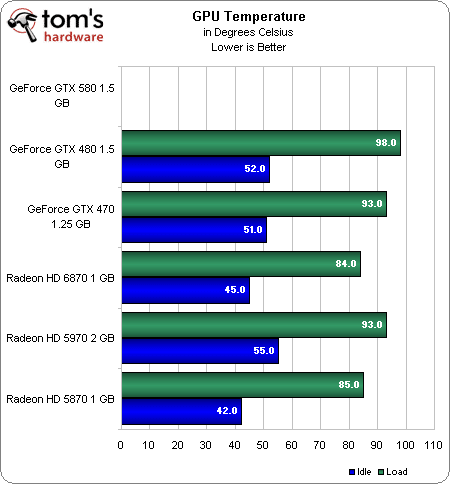

Température

Il est tout aussi difficile de mesurer la température que la consommation, car il est nécessaire pour ce faire d’appliquer une charge constante sur le GPU, et FurMark fonctionne mal avec la GeForce GTX 580. Ce qui nous laisse avec les résultats de la GTX 480.

La GeForce GTX 580 bénéficie toutefois de l’amélioration du mécanisme de refroidissement. Comparé au radiateur de la GTX 480, qui était, soyons francs, une véritable catastrophe, celui-ci est considérablement plus efficace et gère nettement mieux la dissipation thermique du processeur graphique.

La différence se remarque particulièrement en SLI : le ventilateur Scythe de notre boîtier Falcon Northwest s’est montré nettement moins bruyant avec les deux GTX 580 en charge sous Metro 2033 qu’avec les 480. Il reste recommandé d’espacer les cartes de trois emplacements, mais au moins vous ne serez plus sourd après une heure de jeu.

Conclusion

Le fait que la GeForce GTX 480 n’était pas conforme aux attentes de Nvidia est un secret de polichinelle, même si cette carte haut de gamme est parvenue à distancer la Radeon HD 5870 d’AMD sur le plan des performances. La Radeon HD 5970 n’était probablement pas visée à l’époque.

Sur le papier, ce n’était pourtant pas si mal : des performances excellentes dans les jeux actuels, une architecture apte à augmenter le framerate dans les jeux gourmands en géométrie, la prise en charge du CUDA, de PhysX et du 3D Vision. Malheureusement, les critiques ont fusé lorsque sont apparus les problèmes les plus palpables : prix élevé, consommation et chaleur incroyable, et ventilateur extrêmement bruyant. Des problèmes suffisamment fondamentaux pour que nous nous gardions de recommander la carte.

Fort heureusement, avant même le lancement de la GTX 480, Nvidia préparait déjà sa succession et œuvrait à corriger les défauts dont tout le monde avait conscience. Huit mois plus tard, nous avons entre les mains le produit de ces efforts : la GeForce GTX 580.

Mais cette carte suffit-elle à renverser la vapeur ? Cela dépend du type d’acheteur que vous êtes.

D’une part, Nvidia a réglé le problème du bruit et, bien que la GTX 580 possède un TDP similaire à son prédécesseur, elle chauffe moins facilement, ce que le fabricant a décidé d’exploiter en augmentant la fréquence et en activant le 16e SM ; au final, on a donc plus de performances (environ 15 % en moyenne) pour une dissipation thermique quasi-identique et moins de nuisances sonores. Tout cela n’apporte pas grand-chose de neuf, mais cela devrait très certainement suffire pour assurer à la nouvelle venue un accueil bien plus chaleureux. Comme nous le disait en rigolant un des partenaires de Nvidia lors d’une récente conversation : « On dirait qu’ils suivent toujours le même cycle : ego, réconciliation, innovation. Ce n’est qu’à la fin qu’on a du bon matériel ». Si tel est le cas, nous pouvons dire que la GeForce GTX 580 est la culmination du cycle.

D’autre part, nous savons qu’AMD prévoit de dévoiler ses GPU haut de gamme, les Cayman, le 22 novembre. Quelles que soient leurs performances, nous pouvons sans risque affirmer que les prix vont bouger afin de refléter les relations entre les cartes existantes et celles qui arriveront sur le marché. Il serait un peu dommage de ne pas attendre pour voir ce que valent les Cayman. Mais une chose est sûre : depuis la sortie de la GeForce GTX 580, que les futurs GPU d’AMD déçoivent ou enthousiasment, ils devront faire face à une concurrence plus coriace qu’avec GTX 480.

MAJ : AMD est en retard et ne devrait pas proposer ses Radeon HD 6900 avant mi-décembre au mieux.