Introduction

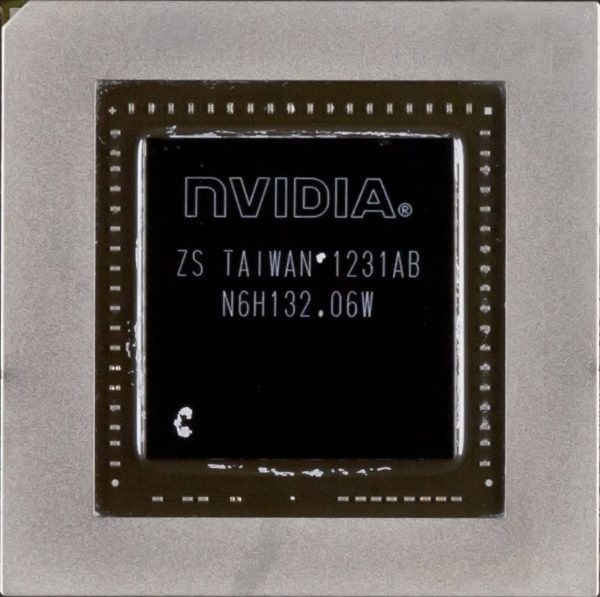

La population mondiale a récemment dépassé le cap des 7 milliards d’êtres humains. Le GPU GK110 de Nvidia, que l’on ne trouvait précédemment que dans les cartes Tesla K20 et K20X, se compose de 7,1 milliards de transistors. Cela signifie que s’il était possible de diviser le GK110 en pièces à un seul transistor, chaque habitant de la planète pourrait en avoir une ; et dire que nous en avons reçu trois en prêt, sur autant de cartes graphiques GeForce GTX Titan !

D’après Nvidia, le GK110 est la plus grande puce gravée en 28 nm que TSMC soit en mesure de fabriquer. Le bon sens voudrait par conséquent qu’elle soit chère, énergivore, sujette à la surchauffe et victime de faibles rendements en production. Deux de ces prédictions se vérifient ; les deux autres, étonnamment, pas du tout.

Comme un air de déjà vu

En dépit de son nom et de sa puce graphique complexe et imposante, la GeForce GTX Titan n’est pas une carte graphique volumineuse. À 26,5 cm, elle se situe pile entre la GeForce GTX 680 (25,5 cm) et la GeForce GTX 690 (28 cm).

Le cache en plastique bon marché de la GTX 680 fait place chez la GTX Titan à une coque clairement dérivée de celle de la GTX 690, mais on note quelques différences de taille entre les deux cartes haut de gamme. Alors que la GTX 690 avait besoin d’un ventilateur axial pour refroidir correctement ses deux GPU, la GTX Titan fait appel à un classique ventilateur centrifuge qui expulse l’air chaud par l’arrière de la carte ; c’est une bonne nouvelle, la chaleur émise par le GPU ne sera plus recyclée dans le boîtier de l’ordinateur. Malheureusement, Nvidia a estimé que la coque en alliage au magnésium de la GTX 690 était trop onéreuse ; la GTX Titan opte pour l’aluminium, à l’exception d’une fenêtre en polycarbonate (un autre élément repris de la GTX 690).

Les ventilateurs soufflants ont la réputation d’être plus bruyants que les modèles axiaux et il est vrai que si vous réglez manuellement celui de la GTX Titan carte au maximum, il vous hurlera dans les oreilles. Mais il suffit de laisser la GeForce GTX Titan assurer seule la gestion de la ventilation pour qu’elle se fasse totalement oublier. Nvidia attribue en partie cette discrétion à un dissipateur à chambre de vaporisation (une technologie que l’on retrouve aussi sur les cartes graphiques haut de gamme d’AMD), mais aussi à une interface thermique plus efficace, un radiateur aux ailettes plus longues et à l’ajout d’un isolant acoustique autour du ventilateur.

L’esthétique et le silence ne sont pas les deux seules qualités que la GeForce GTX Titan partage avec la GTX 690. Comme sa grande sœur, la nouvelle carte arbore le logo GeForce GTX le long de sa face supérieure, en un rétroéclairage vert dont l’intensité est contrôlable via un logiciel fourni.

Vous trouverez également sur la Titan deux connecteurs SLI. Il est possible de monter des configurations à deux, trois et quatre cartes, mais Nvidia admet volontiers que les gains délivrés par la quatrième carte ne se verront que dans des benchmarks, pas dans des situations de jeu réelles.

Quel que soit le nombre de cartes connectées, il est possible d’utiliser simultanément quatre écrans : trois en mode surround et un quatrième en annexe. Bien entendu, si vous n’avez qu’une seule GeForce GTX Titan, il sera nécessaire d’employer toutes ses sorties : deux DVI dual-link, une HDMI et une DisplayPort. Les configurations à deux et trois cartes offrent dans ce domaine plus de flexibilité.

Bien que le GPU GK110 qui équipe la Titan soit immense, il consomme moins que les deux GK104 (environ 3,5 milliards de transistors chacun) de la GeForce GTX 690, qui affichait un TDP de 300 watts et nécessitait deux connecteurs auxiliaires à huit broches pour fonctionner.

La GeForce GTX Titan possède un TDP de 250 watts, soit autant que l’AMD Radeon HD 7970 GHz Edition, et n’a donc plus besoin que d’un connecteur auxiliaire à huit broches et d’un autre à six broches. Sachant que le connecteur PCI Express x16 et le connecteur auxiliaire à six broches délivrent chacun 75 watts et que celui à huit broches délivre 150 watts (soit une alimentation totale de 300 W maximum), la carte dispose d’une marge de sécurité confortable. Nvidia recommande de la coupler à une alimentation d’au moins 600 watts, mais il semble que la plupart des revendeurs qui les installent dans des configurations mini-ITX s’en tirent avec des modèles de 450 ou 500 watts.

| GeForce GTX Titan | GeForce GTX 690 | GeForce GTX 680 | Radeon HD 7970 GHz Ed. | |

|---|---|---|---|---|

| Shaders | 2 688 | 2 x 1 536 | 1 536 | 2 048 |

| Unités de texture | 224 | 2 x 128 | 128 | 128 |

| ROP 8 bits | 48 | 2 x 32 | 32 | 32 |

| Fréq. GPU | 836 MHz | 915 MHz | 1 006 MHz | 1 000 MHz |

| Débit texels | 187,5 Gtex/s | 2 x 117,1 Gtex/s | 128,8 Gtex/s | 134,4 Gtex/s |

| Fréq. mémoire | 1 502 MHz | 1 502 MHz | 1 502 MHz | 1 500 MHz |

| Largeur bus mém. | 384 bits | 2 x 256 bits | 256 bits | 384 bits |

| Bande passante mém. | 288,4 Go/s | 2 x 192,3 Go/s | 192,3 Go/s | 288 Go/s |

| Capacité mém. | 6 Go GDDR5 | 2 x 2 Go GDDR5 | 2 Go GDDR5 | 3 GB GDDR5 |

| Surface du die | 569 mm² | 2 x 294 mm2 | 294 mm2 | 365 mm2 |

| Nb. transistors (109) | 7,1 | 2 x 3,54 | 3,54 | 4,31 |

| Gravure | 28 nm | 28 nm | 28 nm | 28 nm |

| Connecteurs alim. | 1 x 8-pin, 1 x 6-pin | 2 x 8-pin | 2 x 6-pin | 1 x 8-pin, 1 x 6-pin |

| TDP (carte) | 250 W | 300 W | 195 W | 250 W |

| Prix (min.) | 950 € | 900 € | 430 € | 400 € |

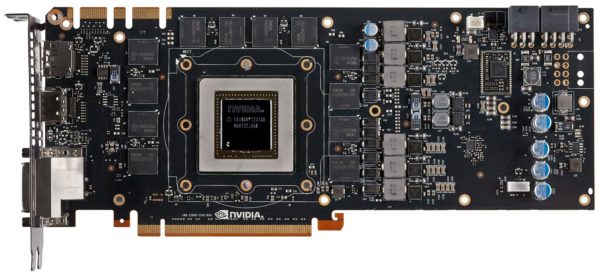

Nous avons retiré le gros ventirad de la GeForce GTX Titan afin d’examiner de plus près son GPU, son sous-système mémoire et son étage d’alimentation.

Le GK110 est cadencé à 836 MHz minimum. Cependant, il bénéficie d’une nouvelle version de la technologie Nvidia GPU Boost et monte la plupart du temps à 876 MHz, selon Nvidia. Nous l’avons constaté par expérience (cf. GeForce GTX 680 : Kepler envoie Tahiti à la retraite), GPU Boost est sensible à un nombre de variables, y compris la température ambiante de la pièce. Dans notre benchmark sous World of Warcraft, par exemple, la GeForce GTX Titan ne consomme que 70 % de sa puissance maximale. Du coup, le GPU passe à 993 MHz et se stabilise à 77 °C. Nous allons en reparler.

La carte compte 12 puces de 2 Gbit de mémoire GDDR5 sur la face avant et 12 autres sur la face arrière, pour un total de 6 Go (48 Gbit). De marque Samsung, elles affichent une latence de 0,33 ns et sont prévues pour grimper à 6 000 Mbit/s ; sachant que Nvidia les cadence à 1502 MHz sur un bus de 384 bits au total, cela nous donne une bande passante de 288,4 Go/s.

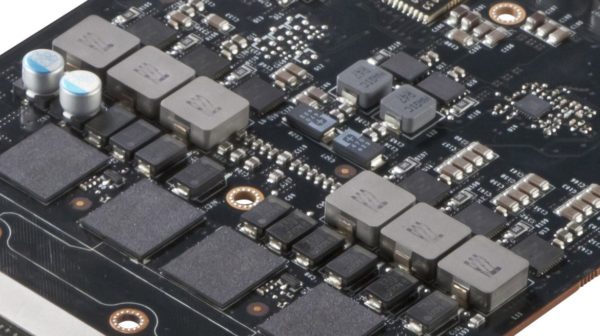

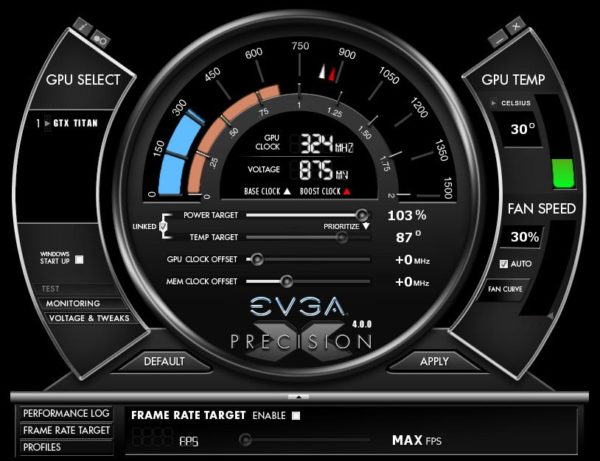

L’étage d’alimentation totalise six phases pour le GPU et deux phases pour la mémoire sont assez faciles à identifier au dos de la Titan. À titre de comparaison, la GeForce GTX 690 employait cinq phases par GPU (donc 10 au total) et deux pour la mémoire (un par GPU). Cette différence est importante car Nvidia autorise l’utilisateur à pousser la tension de la GTX Titan, ce qui permet mécaniquement de stabiliser le GPU à des fréquences plus élevées en mode GPU Boost. Ainsi, sur notre exemplaire, en poussant les tensions au maximum à l’aide du logiciel EVGA Precision X, nous sommes parvenus à faire passer la fréquence maximale du GK110 de 876 MHz à près de 1,2 GHz, sans que jamais la température du GPU ne dépasse les 87°C.

GK110 : un vrai Tank

Peut-être vous rappelez-vous des différentes catégories de produits que Nvidia avait définies pour sa génération précédente de cartes graphiques, la série 500, d’architecture Fermi : le « tank », le « chasseur » et le « sniper ». Trois types de cartes, chacun optimisé pour un rôle différent. La GeForce GTX 580, avec son GF110, était le tank : volumineuse, puissante et chère, elle incarnait le maximum de ce que l’architecture Fermi avait à offrir.

Malgré son nom et son tarif initial de 500 €, la GeForce GTX 680 n’a jamais eu vocation à succéder à la GTX 580. Son GK104 est optimisé pour le jeu, au détriment des performances en calcul généraliste (GPGPU) ; la GTX 680 fait nettement moins bien que la 580 dans les tests OpenCL. Dans un premier temps, Nvidia a minimisé l’importance de ce compromis, préférant insister sur les bonnes performances de sa puce à 3,5 milliards de transistors face aux GPU Tahiti d’AMD à 4,3 milliards de transistors.

Mais la société a ensuite lancé sa gamme Tesla K20, axée sur le GK110, et c’est là que nous avons découvert le véritable tank de la gamme (si l’on daigne oublier un instant le fait que Nvidia a cessé d’employer cette métaphore marketing).

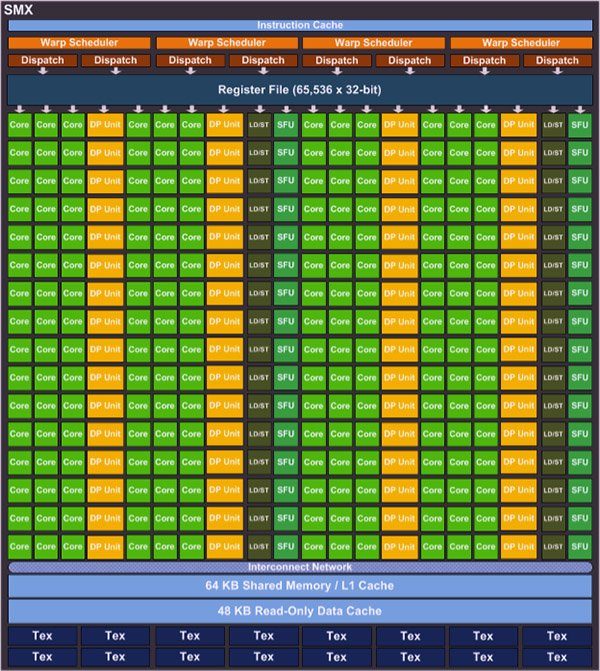

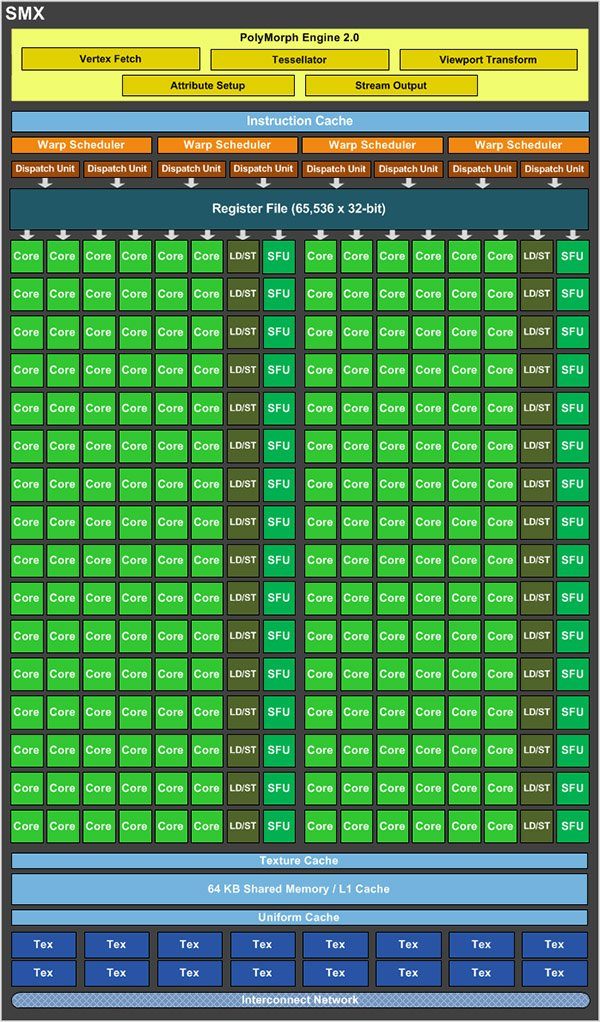

Les SMX en détail

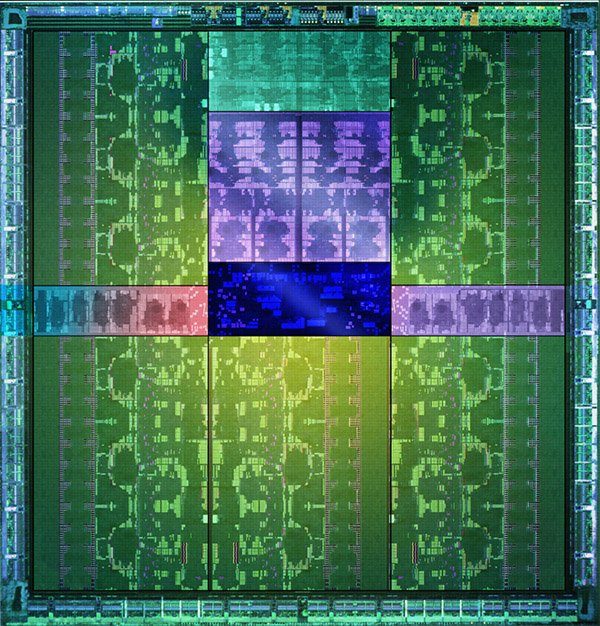

Le GK110 se compose de 15 modules SMX (Streaming Multiprocessors) assez similaires à ceux du GK104 qui alimente la GeForce GTX 680. Comme ceux de ce dernier, ils contiennent chacun 192 coeurs CUDA et 16 unités de textures accompagnés d’une structure de cache semblable. La plus grosse différence, évidemment, se situe au niveau de leur nombre : quinze au lieu de huit. Malheureusement, le GK110 est une puce si complexe que le moindre défaut de gravure affecte sérieusement les rendements de production. Il ne fait aucun doute qu’il existe des GPU parfaitement gravés, mais même les plus haut de gamme des cartes à base de GK110 comptent un module SMX désactivé. Multipliez 192 coeurs CUDA par 14 modules SMX et vous obtenez un GPU doté de 2688 cores CUDA. Multipliez 16 unités de texturing par 14 modules SMX et vous obtenez un total de 224 TMU, là où la GTX 680 n’en compte que 128.

| Par SMX: | GF100 (Fermi) | GF104 (Fermi) | GK110 (Kepler) | GK104 (Kepler) |

|---|---|---|---|---|

| CUDA Compute Capability | 2.0 | 2.0 | 3.5 | 3.0 |

| Nb. threads par warp | 32 | 32 | 32 | 32 |

| Nb. max. de warps par SMX | 48 | 48 | 64 | 64 |

| Nb. max. de threads par SMX | 1 536 | 1 536 | 2 048 | 2 048 |

| Nb. max. de blocs de threads par SMX | 8 | 8 | 16 | 16 |

| Nb. registres 32 bits par SMX | 32 768 | 32 768 | 65 536 | 65 536 |

| Nb. max. registres par thread | 63 | 63 | 255 | 63 |

| Nb. max de threads par bloc de threads | 1 024 | 1 024 | 1 024 | 1 024 |

Au-delà de capitaliser sur les ressources supplémentaires qui augmentent les performances graphiques, le GK110 rectifie le principal défaut du GK104 (a fortiori si l’on considère la GTX 680 comme successeur de la GTX 580) : les performances en calcul GPU.

Chaque SMX du GK104 compte 192 unités capables de gérer des calculs en simple précision (FP32), ce qui revient à un débit en pointe supérieur à 3 TFlops. Cependant, le nombre d’unités capables de gérer des calculs en double précision (FP64) tombe à 8, ce qui revient à diviser par 24 les performances atteignables en FP32. En comparaison, chaque SMX du GK110 compte 64 CUDA Cores capables de calculs en FP64 : les performances ne sont donc plus divisées par 24 mais par 3. D’après NVIDIA, la GTX Titan permet d’atteindre jusqu’à 4,5 TFLOPS avec des calculs en simple précision et 1,5 TFLOPS en double précision. En théorie, la nouvelle GeForce se positionne donc légèrement au-dessus de la HD 7970 GHz Edition, capable de respectivement 4,3 et 1,01 TFLOPS.

Bien entendu, nous sommes ravis de constater que le GK110 remet le calcul GPU sur le devant de la scène, mais la priorité n°1 reste sa capacité à gérer les graphismes en temps réel. Afin d’équilibrer cette hausse de 75 % du nombre d’unités de texturing et shaders, NVIDIA a également renforcé le reste de son nouveau GPU. Le GK104 possède quatre partitions ROP, capables de débiter 8 pixels entiers 32 bits par cycle ; Nvidia le résume en disant que le GK104 possède 32 « unités ROP ». Le GK110 comptant six partitions ROP, il possède 48 « unités ROP », 50 % de mieux.

La GTX 680 comme la Titan emploie de la GDDR5 cadencée à 1502 MHz. Cependant, le GK110 compte six interfaces mémoire 64 bits au lieu de quatre sur le GK104 : la bande passante maximale passe donc de 192 à 288 Go/s, soit une augmentation de 50 %. On se retrouve ainsi au même niveau que la HD 7970 GHz Edition qui embarque elle aussi de la GDDR5 1500 MHz et un bus mémoire 384 bits.

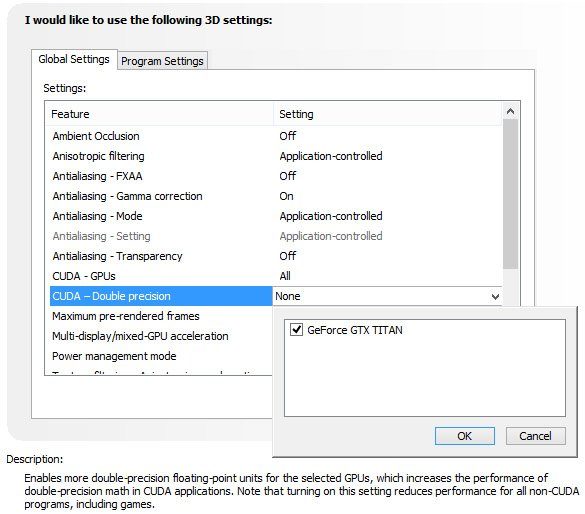

Le GPGPU bridé au profit des jeux

Durant nos tests de la GTX Titan et avant que NVIDIA puisse nous parler en détail des fonctionnalités propres à la carte, nous avons été frappés par une tendance constatée sur plusieurs logiciels de diagnostic comme SiSoftware Sandra : les performances en calcul à virgule flottante double précision se sont avérées extrêmement faibles. Alors que l’on aurait dû atteindre le tiers des performances en FP32, nos résultats étaient plus proches du 1/24 comme sur la GTX 680.

NVIDIA affirme pourtant que sa dernière carte en date est bel et bien capable d’atteindre 4,5 TFLOPS avec des calculs en simple précision et 1,5 TFLOPS en double précision ; comment donc expliquer ces résultats ?

Il s’avère que Nvidia bride volontairement les unités FP64 en les faisant tourner à 1/8e de la fréquence du GPU. Ceci permet de limiter la consommation globale et donc de laisser plus de champ au GPU Boost, pour augmenter les performances dans les jeux.

Mais les joueurs ne sont pas les seuls clients potentiels des GeForce Titan. Elles peuvent tenter les développeurs voulant tester l’accélération GPU de leurs programmes sans avoir à se délester de 5000 $ pour une Tesla K20X. Pour eux, Nvidia a laissé la possibilité de débrider le potentiel de calcul en double précision du GK110. La manipulation est simple : il faut passer par le panneau de configuration du pilote, puis « Gérer les paramètres 3D » et descendre jusqu’à l’entrée CUDA – Double précision pour y activer la GTX Titan. Cette manipulation ayant pour effet collatéral de désactiver le GPU Boost, mieux vaut s’abstenir à moins d’avoir besoin d’un maximum de performances en FP64.

À ce stade, nous pouvons d’ores et déjà confirmer que le GK110 est alors libéré, mais il nous est impossible de publier des benchmarks à l’appui, liés que nous sommes par un accord de non-divulgation avec Nvidia. Nous le pourrons cependant jeudi.

GPU Boost 2.0 : bienvenue aux overclockers

Pour mémoire, le GPU Boost est la technologie propre à NVIDIA qui permet d’adapter les performances d’une carte graphique en fonction de sa charge de travail. Comme on le sait déjà, les jeux exercent justement des charges variables sur les GPU. Historiquement, les fréquences devaient être fixées en considérant le pire des cas de figure, d’où des performances très (trop) élevées lors de charges « légères ». GPU Boost change la donne en surveillant plusieurs paramètres pour ajuster les fréquences aussi loin que possible à la hausse comme à la baisse.

Le GPU Boost première génération visait une consommation maximale cible, 170 Watts dans le cas de la GTX 680. Cependant, les ingénieurs de NVIDIA ont constaté qu’il était possible de dépasser ce seuil sans prendre de risque à condition que les températures du GPU ne s’envolent pas. En clair, il existait des marges pour optimiser cette technologie.

GPU Boost 2.0 tranche avec son prédécesseur dans la mesure où l’augmentation de la fréquence se fait en fonction d’un plafond thermique de 80°C et non plus d’une consommation maximale. On devrait donc constater des fréquences et tensions plus élevées que sur la GTX 680, dans les limites de 80°C et de ce que l’on est prêt à supporter en matière de nuisances sonores (c’est avec un ventilateur à 100 % de sa vitesse que GPU Boost 2.0 produira les meilleurs résultats). GPU Boost 2.0 réagit toujours avec une latence d’environ 100 ms. Nvidia a encore une marge de manœuvre considérable pour améliorer sa technologie en augmentant sa réactivité sur ses prochaines cartes.

Bien entendu, ces ajustements liés aux contraintes thermiques compliquent encore plus les tests que la première itération de GPU Boost. Tout élément capable d’influer sur la température du GK110 en bien ou en mal agit par ricochet sur les fréquences de la puce, ce qui pose problème lorsqu’il s’agit d’avoir des performances constantes lorsque l’on répète un benchmark à plusieurs reprises. Dans le contexte d’un laboratoire de tests, le mieux que l’on peut espérer est une température ambiante qui ne bouge pas.

Overclocking au choix pour les marques partenaires ?

Lorsque NVIDIA définit les caractéristiques d’un produit, la marque vise une durée de vie utile de 5 ans. Le choix des fréquences et tensions est un calcul délicat qui prend en compte cette durée de vie. En augmentant manuellement la tension d’alimentation, on influe négativement sur la durée de vie. Les fabricants ont donc l’habitude de dissuader l’overclocking que l’on pourrait qualifier d’agressif. Quand bien même plusieurs marques savent pertinemment qu’une frange de leurs clients (ceux qui justement sont susceptibles de lire ces lignes) n’ont que faire des mises en garde, on ne peut pas leur reprocher de refuser la prise en garantie des composants décédés prématurément du fait de l’overclocking.

Mais puisque GPU Boost 2.0 s’appuie maintenant sur les températures de fonctionnement, cette technologie empêche le GK110 d’atteindre des conditions dangereuses. En conséquence, NVIDIA laisse dorénavant la possibilité d’augmenter légèrement la tension pour améliorer la marge d’overclocking. Cette fonction peut cependant être désactivée dans le BIOS par chaque marque.

Nos cartes de référence fonctionnent à un maximum de 1,162 mV par défaut, sachant que le logiciel Precision X d’EVGA les a poussées jusqu’à 1,200 mV. Ce dernier vous demande de reconnaitre l’augmentation des risques liés à l’électromigration, mais la garantie ne devrait pas être invalidée pour autant en cas de problème.

La force brute du tri SLI…

On peut trouver quelques cas où la GeForce GTX Titan prend tout son sens (et bien plus encore où elle n’en a aucun). Le PC ultra haut de gamme dédié au jeu est bien entendu l’un d’entre eux. Mais pas une simple machine monocarte : une configuration hyper-musclée, no-limit, à deux, voire trois cartes graphiques en parallèle, destinée à atteindre des sommets dans les jeux les plus gourmands.

En effet, si vous pouvez vous contenter d’une seule carte et si vous comptez jouer en 2560 x 1600 ou en 5760 x 1080, la GeForce GTX 690 est votre meilleure option (à 1000 € tout de même). Pour aller plus loin, il faut penser à deux GTX 690 ou deux/trois GTX Titan. Bien sûr, on pourrait envisager des machines à trois ou quatre GeForce GTX 680 ou Radeon HD 7970, mais tant que nous ne les aurons pas passées au crible de notre nouvelle mesure des latences interimages, nous ne saurons pas dire si ces configurations super-parallélisées n’engendrent pas trop de problèmes de microsaccades.

Quoi qu’il en soit, pour nous montrer quels sommets pouvait atteindre la GeForce GTX Titan, Nvidia a demandé à l’assembleur américain Geek Box d’en monter trois dans une de ses configurations pour gamers « Ego Maniacal X79 ». Un véritable monstre logé dans un boîtier SilverStone Temjin TJ11B-W. Bien qu’il soit en aluminium, ce colosse pèse près de 20 kilos à vide. Rempli de ses composants, il a fallu à Fedex un semi-remorque, une palette et une grande porte levante pour le déposer dans notre garage.

Une fois installé, cependant, le produit fini montre clairement à quel point Geek Box a le souci du détail. La gestion des câbles est poussée à son paroxysme, avec des fils d’alimentation gainés individuellement et le système de watercooling appliqué au processeur et aux régulateurs de tension de la carte-mère évitent les problèmes que nous signalons à chaque fois que nous testons du matériel dans une machine refroidie par air.

Non que la circulation de l’air soit un problème sur le TJ11B-W ; en fait, l’une des plus grandes faiblesses de ce boîtier est sans doute le bruit qu’émettent ses ventilateurs. Ils ne sont pas à proprement parler bruyants, mais quand Nvidia essaie de nous montrer à quel point ses trois GTX Titan sont silencieuses et que la seule chose que l’on entend est l’air soufflé dans les radiateurs de la carte-mère, l’exercice peut paraître quelque peu futile. La bonne nouvelle, bien entendu, est que les trois Titan, même dos à dos sont effectivement incroyablement discrètes.

La majeure partie du bruit de l’Ego Maniacal est le fruit du Core i7-3970X overclocké à 4,6 GHz (stables), probablement destiné à éviter tout goulet d’étranglement derrière les trois GPU. Ce processeur hexacore trône sur une carte-mère Asus Rampage IV Extreme et est couplé à 32 Go de mémoire Corsair Dominator sur quatre canaux. Le tout assorti de deux SSD Corsair Neutron GTX formant une grappe RAID de 480 Go, qui garantit presque à cent pour cent des temps de chargement réduits à néant.

Pour éviter que les propriétés acoustiques de l’ordinateur n’interfèrent avec certains de nos benchmarks, nous avons transplanté les Titan dans notre configuration de test habituelle. Mais pas avant d’avoir lancé 3DMark 11 et généré un score de plus de [censuré: plus d’info jeudi dans nos benchmarks] avec le profil Extreme, et des fréquences dépassant les 1100 MHz.

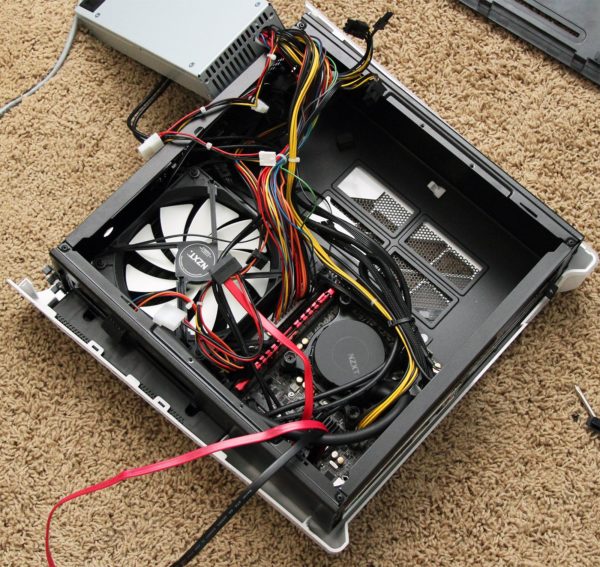

… ou l’élégance du mini-ITX

Il existe un deuxième scénario où une carte mono-GPU aussi excessive que la GeForce GTX Titan a plus de sens qu’une paire de cartes graphiques moins chères : dans les situations où il n’est pas possible d’avoir plus d’une carte. Nous sommes particulièrement amateurs des boîtiers compacts tels que le Falcon Northwest Tiki, le Digital Storm Bolt ou encore l’iBuyPower Revolt, que nous avons récemment reçu dans nos locaux.

L’exemplaire en question contient un Core i7-3770K posé sur une carte-mère iBP-Z77E/S Revolt conçue par iBuyPower. Malheureusement, celle-ci n’est assortie que d’une unique barrette de 8 Go de mémoire DDR3-1600 (la machine aurait dû nous être livrée avec deux barrettes de 4 Go en double canal). Côté stockage, nous avons droit à une architecture plutôt hybride, avec un SSD Intel 330 de 120 Go complété par un disque dur de 1 To. Le tout ne coûte que 1 515 $.

iBuyPower n’a pas encore validé officiellement la GeForce GTX Titan, mais ils ont la carte en laboratoire et nous ont affirmé qu’elle fonctionnait. Nous avons donc transféré l’une de nos GeForce Titan dans notre Revolt (à la place de la GeForce GTX 670 fournie de base). Opération que nous ne recommandons d’ailleurs pas. En effet, si le Revolt est, dans une certaine mesure, conçu pour être ouvert par l’utilisateur, le refermer sans endommager son système de watercooling représente un véritable défi.

Quoi qu’il en soit, le boîtier d’iBuyPower va comme un gant à la Titan. Elle est un petit peu plus longue que la GTX 670, mais le Revolt dispose de suffisamment d’espace. En pratique, le seul point dont il faut se soucier est le TDP de la nouvelle carte graphique, qui, avec ses 250 watts, phagocyte une bonne partie de la puissance en sortie de l’alimentation fournie (une FSP 80 PLUS Gold de 500 watts).

Verdict de l’expérience : une machine plus rapide, sans que le changement de carte graphique ait eu d’incidence sur l’acoustique. Le Tiki et le Revolt ne sont pas des boîtiers dits « silencieux », mais ils sont bel et bien discrets. La principale différence entre les deux provient plutôt de la fréquence du bruit qu’ils émettent. Le boîtier de Falcon Northwest donne un son moins aigu que celui d’iBuyPower (probablement desservi par le ventilateur de 20 mm de diamètre de son alimentation), qui se fait par conséquent un peu plus remarquer. En comparaison, le ventilateur de la carte graphique est totalement inaudible au repos et incroyablement furtif en charge.

Configuration et protocole de test

NVIDIA ayant choisi pour une raison ou pour une autre de soumettre sa nouvelle carte très haut de gamme à deux NDA successifs, notre premier aperçu s’est limité aux caractéristiques techniques de GeForce GTX Titan. Nous n’aurions pas choisi d’effectuer ce test en deux temps si l’on nous avait demandé notre avis, mais en toute honnêteté, après un premier article relativement conséquent et une semaine de tests intenses, nous n’avons pas vécu cette approche comme une punition. Voici donc la seconde partie de notre test, où vous pourrez découvrir tous les benchmark.

| Configuration matérielle | |

|---|---|

| Processeur | Intel Core i7-3970X (Sandy Bridge-E) 3.5 GHz at 4.5 GHz (45 * 100 MHz), LGA 2011, 15 MB Shared L3, Hyper-Threading enabled, Power-savings enabled |

| Carte mère | Intel DX79SR (LGA 2011) X79 Express Chipset, BIOS 0553 |

| Memoire vive | G.Skill 16 GB (4 x 4 GB) DDR3-1600, F3-12800CL9Q2-32GBZL @ 9-9-9-24 and 1.5 V |

| Disque dur | Crucial m4 SSD 256 GB SATA 6Gb/s |

| Cartes graphiques | Nvidia GeForce GTX Titan 6 GB |

| Nvidia GeForce GTX 690 4 GB | |

| Nvidia GeForce GTX 680 2 GB | |

| AMD Radeon HD 7970 GHz Edition 3 GB | |

| Alimentation | Cooler Master UCP-1000 W |

| Configuration logicielle | |

| OS | Windows 8 Professional 64-bit |

| DirectX | DirectX 11 |

| Pilote graphique | Nvidia GeForce Release 314.09 (Beta) For GTX Titan |

| Nvidia GeForce Release 314.07 For GTX 680 and 690 | |

| AMD Catalyst 13.2 (Beta 5) For Radeon HD 7970 GHz Edition | |

Au sujet de la carte mère, notons que nous avions initialement choisi la Gigabyte X79S-UP5-WiFi, laquelle s’est montrée incompatible avec Titan. Ni NVIDIA ni Gigabyte n’ont pu nous expliquer pourquoi la carte graphique refusait d’afficher le moindre signal vidéo, alors que le reste de la configuration semblait démarrer correctement.

Nous avons donc opté pour une Intel DX79SR qui n’a pas posé de problème. Sont ensuite venus s’ajouter un Core i7-3970X overclocké à 4,5 GHz, 32 Go de DDR3-1600 Gskill ainsi qu’un SSD Crucial 256 Go pour héberger les logiciels. En clair, tout a été fait pour éviter les goulets d’étranglement.

| Benchmarks | |

|---|---|

| Battlefield 3 | Ultra Quality Preset, V-Sync off, 1920×1080 / 2560×1600 / 5760×1200, DirectX 11, Going Hunting, 90-Second playback, Fraps |

| Far Cry 3 | Ultra Quality Preset, DirectX 11, V-Sync off, 1920×1080 / 2560×1600 / 5760×1200, Custom Run-Through, 50-Second playback, Fraps |

| Borderlands 2 | Highest-Quality Settings, PhysX Low, 16x Anisotropic Filtering, 1920×1080 / 2560×1600 / 5760×1200, Custom Run-Through, Fraps |

| Hitman: Absolution | Ultra Quality Preset, 2x MSAA, 1920×1080 / 2560×1600 / 5760×1200, Built-In Benchmark Sequence |

| The Elder Scrolls V: Skyrim | Ultra Quality Preset, FXAA Enabled, 1920×1080 / 2560×1600 / 5760×1200, Custom Run-Through, 25-Second playback, Fraps |

| 3DMark | Fire Strike Benchmark |

| World of Warcraft: Mists of Pandaria | Ultra Quality Settings, 8x MSAA, Mists of Pandaria Flight Points, 1920×1200 / 2560×1600 / 5760×1200, Fraps, DirectX 11 Rendering, x64 Client |

| SiSoftware Sandra 2013 Professional | Sandra Tech Support (Engineer) 2013.SP1, GP Processing, Cryptography, Video Shader, and Video Bandwidth Modules |

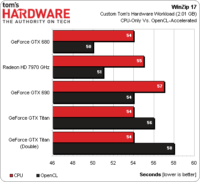

| Corel WinZip 17 | 2.1 GB Folder, OpenCL Vs. CPU Compression |

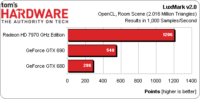

| LuxMark 2.0 | 64-bit Binary, Version 2.0, Room Scene |

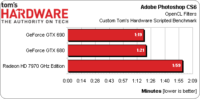

| Adobe Photoshop CS6 | Scripted Filter Test, OpenCL Enabled, 16 MB TIF |

Au niveau des écrans, nous avons réuni un Dell 3007WFP et trois Dell U2410 pour effectuer nos tests en 1920×1080, 2560×1600 et 5760×1200.

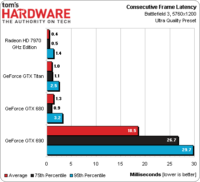

Comme par le passé, nous affichons pour chaque jeu un nombre d’ips moyen suivant la résolution et avec ou sans antialiasing. Ces moyennes restent un bon indicateur, notamment parce que l’on se fait très rapidement une idée des performances relatives de chaque carte. Cependant, on sait maintenant que l’on ne peut pas vraiment faire le tour de la question avec ces seules moyennes.

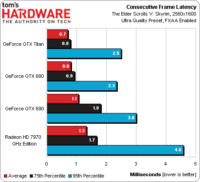

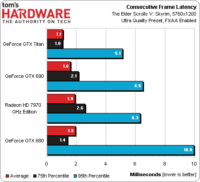

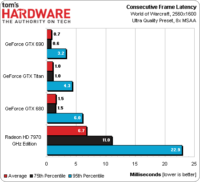

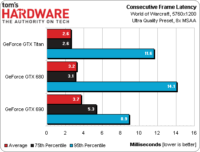

Pour cette raison, nous avons introduit une nouvelle analyse à trois composantes, inaugurée en début de semaine dans notre comparatif de processeurs pour jouer à moins de 200 euros : le nombre d’ips en moyenne, la variation du nombre d’ips pendant la durée du benchmark et enfin la nouveauté de cette année, à savoir la latence inter images. Pour mémoire, une latence élevée entre images consécutives risque d’engendrer un effet de micro saccades quand bien même le nombre d’ips en moyenne est élevé. Nous calculons donc la latence moyenne sur l’ensemble du benchmark, la latence au 75e centile (pire cas de figure entre images consécutives sur 75 % du test) et enfin au 95e centile (temps de latence des 5 % d’images les plus lentes à s’afficher).

Ces trois séries de graphiques se complètent pour nous livrer le débit d’image de chaque carte à chaque seconde, ainsi que la régularité avec laquelle elles sont affichées. On peut ainsi arriver à une analyse exhaustive, mais au lieu d’avoir un seul graphique par résolution pour chaque jeu, on en a donc trois. Nous essaierons de rendre cette masse d’informations aussi digeste que possible.

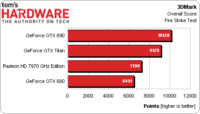

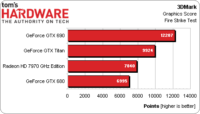

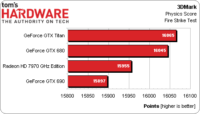

3DMark

3DMark est le seul benchmark pour lequel nous n’avons pas capturé les performances par seconde sous Fraps. Ce test synthétique est censé anticiper les performances des futurs jeux au travers de deux tests graphiques, un test portant sur la physique et enfin un quatrième qui combine charges GPU et CPU en simultané. Le score global est une moyenne pondérée des scores dans chacun de ces tests.

Le fait est que la GTX 690 reste la carte graphique la plus performante à ce jour, suivie par la GTX Titan. Toutes deux étant affichées à un peu moins de 1000 euros, nous choisirions évidemment la GTX 690.

La Radeon HD 7970 GHz Edition mérite que l’on s’attarde sur son cas : le modèle Vapor X de Sapphire est par exemple affiché à 390 euros en moyenne, alors qu’il faut compter un minimum de 410 euros pour une GTX 680. Au fil du temps et grâce à des pilotes plus aboutis, les cartes basées sur Tahiti connaissent un nouvel élan, sans même parler des titres offerts grâce au programme Never Settle Reloaded. Avec une paire d’entre elles, on devrait dépasser sans problème les performances d’une GTX 690 tout en économisant une bonne centaine d’euros au passage. D’ailleurs inutile de parler au conditionnel, le CrossFire de HD 7970 « première génération » (GPU @ 925 MHz) au laboratoire atteint les 11 629 points sous 3DMark.

Si on s’intéresse au seul test graphique, la hiérarchie ne change pas, mais les écarts deviennent un peu plus importants.

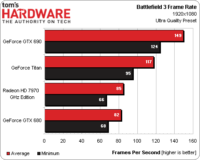

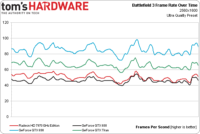

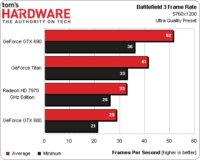

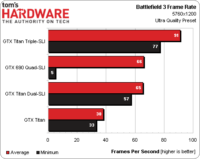

Résultats : Battlefield 3

Résolution : 1920×1080

En 1920×1080, Battlefield 3 reproduit le classement que l’on a pu observer sous 3DMark : la GTX 690 domine les débats, suivi de Titan puis la HD 7970 et la GTX 680 qui font quasiment jeu égal.

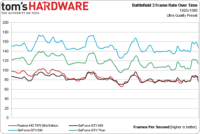

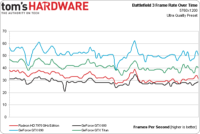

A cette résolution, le seul intérêt de ce graphique est de montrer que les quatre cartes permettent de se maintenir au-dessus de 60 ips en toutes circonstances.

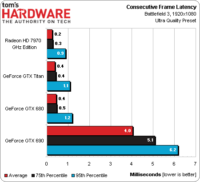

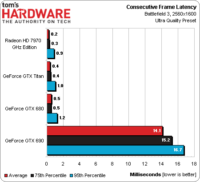

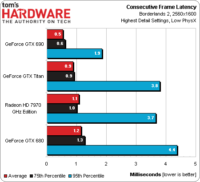

Pour sa première apparition sur cet article, la mesure de la latence inter images nécessite quelques explications. Le test est particulièrement utile pour les cartes mono-GPU : il permet de constater une variance extrêmement faible pour les trois modèles testés.

À première vue, la GTX 690 ne semble pas à son aise, mais les 6 ms mesurées pour le 95e centile constituent un très bon résultat. Mais il y a un biais important : Fraps n’est pas en mesure de capturer les latences à travers l’intégralité du pipeline graphique. Nous avons beaucoup échangé avec NVIDIA sur le sujet avant d’en conclure que les résultats de la GTX 690 sont légèrement biaisés. Il serait donc assez risqué de l’opposer à une paire de Radeon en CrossFire vu que les deux architectures se comportent différemment après la mesure des données par Fraps, ce qui a pour effet d’augmenter la variance entre nos relevés et ce que chacun pourrait constater chez soi. Il faut garder ce problème à l’esprit au fur et à mesure que la résolution augmente et avec elle la latence interimages.

Résolution : 2560×1600

L’écart entre la GTX 690 et Titan en 2560×1600 nous rappelle que cette dernière ne vise pas un rapport performances/prix agressif. De son côté, la HD 7970 GHz Edition augmente très légèrement son avance sur la GTX 680.

Ce graphique ressemble énormément à celui que nous avons vu en 1920×1080 même si les performances globales ont nettement baissé. Les quatre cartes permettent tout de même de jouer vu que la moins performante d’entre elles permet de se maintenir à 40 ips ou plus en toutes circonstances.

La tendance de fond reste la même qu’en 1920×1080 pour les cartes mono GPU, tandis que la GTX 690 voit ses latences plus ou moins tripler. Nous considérons toutefois qu’il s’agit d’un bon résultat vu que les latences restent très faibles dans l’absolu tandis que le nombre d’ips est très élevé.

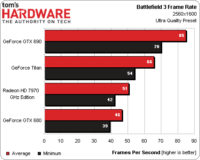

Resolution: 5760×1200

Nous voici enfin à la résolution pour laquelle la GTX 690 et Titan ont été conçues, même s’il faut reconnaitre que toutes les cartes souffrent avec des réglages graphiques en Ultra. Si la GTX 690 persiste à dominer la Titan, il faut noter que le nombre d’ips minimum est cette fois très proche entre les deux cartes et ce tout au long du benchmark (90 secondes).

La HD 7970 finit encore devant la GTX 680, mais dans un cas comme dans l’autre, les performances ne sont pas suffisantes.

La GTX 680 connait une chute qui la fait très brièvement plonger à 21 ips, alors qu’elle se situe entre 25 et 35 ips le reste du temps. La HD 7970 la surpasse tout au long du test.

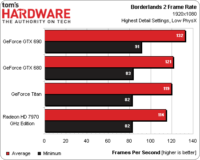

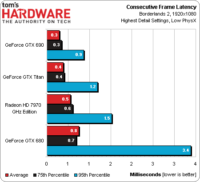

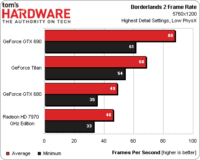

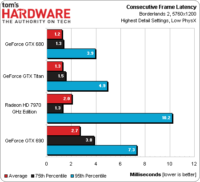

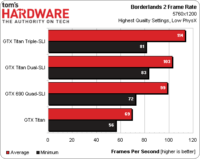

Résultats : Borderlands 2

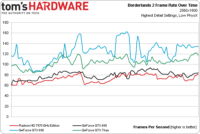

Resolution: 1920×1080

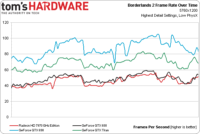

Les performances moyennes sur Borderlands 2 sont très élevées à cette résolution, tandis que le nombre d’ips minimum semble limité par notre configuration de test.

Cette supposition se confirme lorsque l’on regarde les performances dans le temps. Les performances moyennes auraient été plus serrées si la GTX 690 n’avait pas connu quelques pics de performances très courts (dont un à plus de 200 ips).

Les trois cartes mono-GPU et, dans les limites de ce que l’on peut évaluer, la GTX 690 affichent une très faible latence inter images, jusqu’au 95e centile inclus. D’un point de vue subjectif, quelques minutes de gameplay ont confirmé nos relevés : à aucun moment le jeu ne souffre de microcoupures.

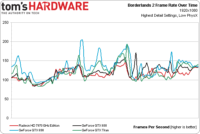

Resolution: 2560×1600

Si les performances globales ont baissé, le fait est que les quatre cartes permettent une très bonne expérience de jeu.

Très serré en 1920×1080, le graphique commence à vraiment distinguer les cartes en 2560×1600. La GTX 690 et Titan se situent au même niveau pour les performances minimum, mais la GTX 690 est plus rapide en moyenne.

Les quatre cartes voient leurs latences interimages augmenter, mais les valeurs sont trop faibles pour s’en inquiéter : Borderlands 2 reste parfaitement fluide avec les quatre cartes.

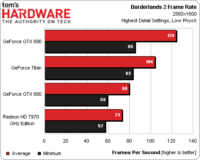

Resolution: 5760×1600

Les deux cartes de luxe du caméléon semblent taillées pour jouer sur trois écrans, tandis que le nombre d’ips minimum nous pousserait à baisser quelques options graphiques dans le cas de la GTX 680 et de la HD 7970.

Plus question d’ex aequo ici : la GTX 690 domine la concurrence, suivie par Titan.

La latence inter image ne nous soucie toujours pas. On serait plutôt tenté de baisser quelques options pour faire remonter les moyennes à cette résolution. Notons que Borderlands 2 fait partie des jeux pour lesquels AMD a spécifiquement tenté une optimisation au sein des Catalyst 13.2 Beta.

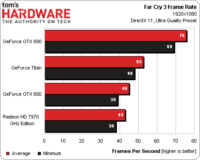

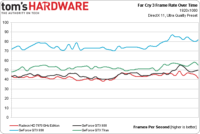

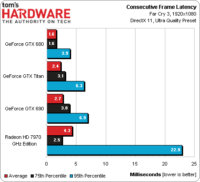

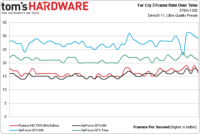

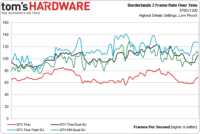

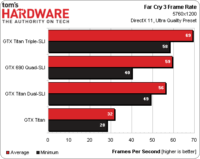

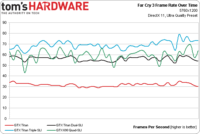

Résultats : Far Cry 3

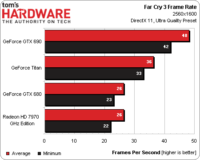

Résolution : 1920×1080

Basé sur le moteur Dunia 2, FarCry 3 est nettement plus gourmand que Borderlands 2. Dès 1920×1080, on peut voir le nombre d’ips minium descendre en dessous de 40 sur la HD 7970 GHz Edition comme sur la GTX 680. Les performances moyennes ne sont pas tellement plus élevées. De son côté, la GTX Titan ne fait pas beaucoup mieux que la GTX 680 : la GTX 690 est la seule carte du lot à se montrer parfaitement à l’aise.

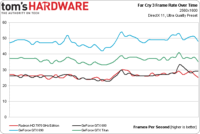

La supériorité de la GTX 690 (tout comme le décevant écart entre GTX 680 et Titan compte tenu du prix de cette dernière) est encore mieux illustrée ici. GTX 680 et Radeon HD 7970 GHZ Edition sont au coude à coude, avec un léger avantage pour la GTX 680.

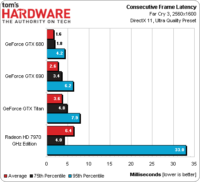

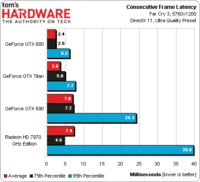

Cette fois, la latence inter images n’est pas anodine. Si AMD prétend avoir amélioré la situation dans ses pilotes pour Borderlands 2, Skyrim et Guild Wars 2, nous n’avons vu aucune indication similaire pour FarCry 3. Il y a quelque chose de perturbant à voir seulement 2,5 ms au 75e centile, une moyenne supérieure à cela et enfin, quasiment 23 ms au 95e centile. En clair, lorsque les latences inter images sont mauvaises sur la HD 7970 GHz Edition, elles ne le sont pas qu’à moitié.

Résolution : 2560×1600

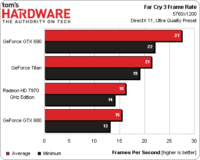

FarCry 3 punit encore un peu plus nos cartes graphiques, la GTX 690 étant la seule à offrir une expérience de jeu acceptable avec ces réglages. Les performances de Titan sont limites, tandis que la GTX 680 comme la HD 7970 GHz Edition n’arrivent même plus à 30 ips en moyenne.

Les performances globales ont certes baissé, mais le comportement des cartes reste le même qu’en 1920×1080.

La latence inter image de toutes les cartes augmente alors que leurs performances diminuent. Dans le cas de la HD 7970 GHz Edition, la moyenne n’évolue que très peu, mais le 95e centile augmente de plus de 10 ms de plus qu’en 1920×1080.

C’est également ici que les performances de la GTX 690 semblent mal évaluées par Fraps en raison de l’instant auquel le logiciel effectue ses relevés. Le nombre d’ips en moyenne ne semble pas poser problème, les performances dans le temps ne sont pas inquiétantes et la latence inter images a l’air extrêmement faible. Lorsque l’on se met vraiment à jouer (étape qui nous semble particulièrement importante pour évaluer les performances), on constate beaucoup de microsaccades. Difficile de dire si le problème tient aux 2 Go de GDDR5 par GPU ou bien à la technologie censée minimiser ces microsaccades (frame rate metering). Quoi qu’il en soit, jouer au FPS d’Ubisoft en 2560×1600 et plus avec une GTX690 n’a rien d’une expérience plaisante.

Résolution : 5760×1200

Sans surprise, aucune carte mono GPU n’est à la hauteur en 5760×1200 : à cette résolution, c’est comme si FarCry 3 nous suppliait d’utiliser une configuration multi-GPU.

Les performances s’établissant de manière uniforme sous le seuil de 30 ips : le FPS d’Ubisoft est aussi injouable que magnifique sur trois écrans.

En 5760×1200, le problème tient bien plus des performances moyennes que de la latence inter images. On note cependant que la HD 7970 GHz Edition voit son cas empirer, tandis que les problèmes rencontrés sur la GTX 690 en 2560×1600 se répètent.

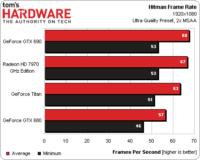

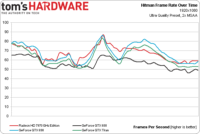

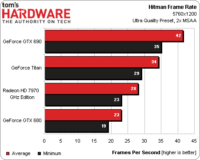

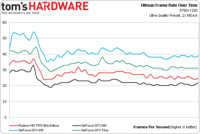

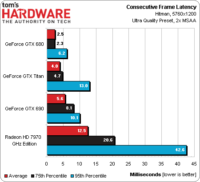

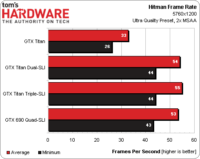

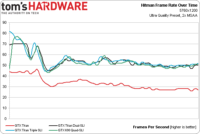

Résultats : Hitman: Absolution

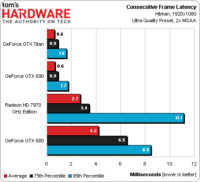

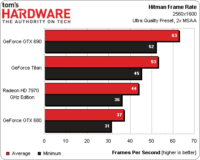

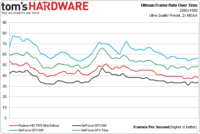

Résolution : 1920×1080

Au vu des très bonnes performances moyennes et du nombre d’ips minimum très proche d’une carte à l’autre, on peut en déduire qu’Hitman : Absolution est considérablement limité par notre CPU de test quand bien même le niveau de détails graphiques est au maximum. Malgré cette limitation, notons que la HD 7970 GHz Edition remporte une victoire de prestige sur la GTX Titan.

En observant les performances dans le temps, on constate que la GTX 680 est la seule carte à légèrement décrocher du lot. Le cas de la HD 7970 GHz Edition mérite également que l’on s’y attarde : si la carte d’AMD parvient à de bonnes performances moyennes, elle semble souffrir d’un comportement un peu plus irrégulier que les autres au fil du benchmark.

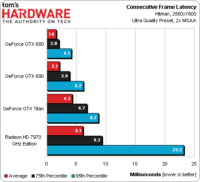

La GTX Titan démontre une latence inter images très faible, y compris au 95e centile.

Résolution : 2560×1600

La hausse de la résolution augmente la charge GPU et creuse les écarts entre nos cartes. La GTX 690 maintient son avance, suivie de la Titan. La Radeon HD 7970 GHz passe troisième, devant la GTX 680.

Le classement ne bouge pas pendant toute la durée du test.

Nous avons vérifié ces résultats plusieurs fois : la GTX 680 crée de plus grandes latences en 1920×1080 qu’en 2560×1600, mais c’est l’inverse sur la GTX Titan.

Le point important est que la Radeon HD 7970 GHz souffre de latences élevées, qui explosent littéralement au 95e centile.

Résolution : 5760×1200

Passer en 5760×1200 fait souffrir toutes les cartes. La GeForce GTX 690 parvient à maintenir une moyenne jouable et un minimum de 35 ips, alors que la GTX Titan n’atteint que 34 ips, de moyenne.

Ce graphique n’apporte pas d’informations supplémentaires : aucune carte mono-GPU ne convient à cette résolution.

Le jeu n’étant pas jouable, les latences interimages ont moins d’importance ici, mais soulignons que la Radeon HD 7970 GHz atteint 40 ms au 95e centile.

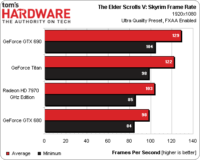

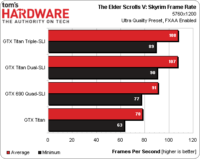

Résultats : The Elder Scrolls V: Skyrim

Résolution : 1920×1080

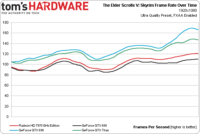

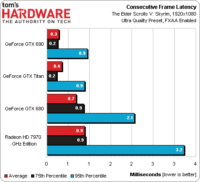

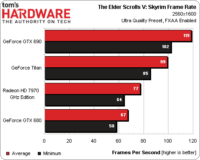

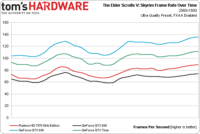

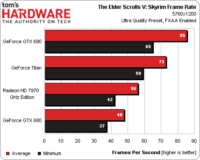

Autrefois fortement limité par le CPU, Skyrim est maintenant plus dépendant de la puissance graphique, même en 1920×1080. Pourtant, la différence entre les moyennes de la GeForce GTX 690 – la plus rapide – et la GTX 680 – la plus lente – est insignifiante.

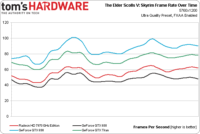

Les moyennes étant tellement élevées, les variations dans le temps ne sont pas critiques : les minima sont au-dessus de 80 ips, largement suffisants.

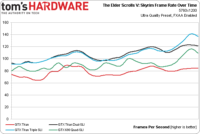

Voilà un autre jeu pour lesquels AMD a optimisé ses derniers pilotes Catalyst beta, et ces efforts se traduisent dans une augmentation nette de la régularité de le latence interimages. La GeForce GTX Titan reste cependant intouchable avec moins de 1 ms d’écart au 95e centile.

Résolution : 2560×1600

Les moyennes et les minima indiquent que toutes les configurations sont jouables, encore une fois. La Titan demeure coincée entre la GTX 690 et la Radeon HD 7970 GHz.

L’échelle est modifiée par rapport au même test en 1920×1080, mais c’est bien tout ce qui change.

La GeForce GTX Titan et la GTX 680 continuent d’afficher une régularité hors pair. La Radeon HD 7970 GHz ferme encore une fois la marche, mais dans l’absolu, ses latences sont divisées par 10 par rapport à ce qu’elles sont dans d’autres jeux

Résolution : 5760×1200

Aucun changement en 5760×1200 : le classement reste le même et toutes les cartes garantissent des framerates suffisants.

La GeForce GTX 680 tombe sous les 40 ips très brièvement mais oscille le reste du temps autour de 45 ips.

La GeForce GTX Titan se montre toujours excellente mais celle qui se distingue dans ce test est la Radeon HD 7970 GHz. Elle qui termine d’habitude en queue de peloton fait ici jeu égal avec la GTX 680 et se permet même de la battre si on considère le temps au 95e centile.

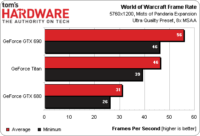

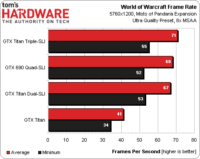

Résultats : World Of Warcraft: Mists Of Pandaria

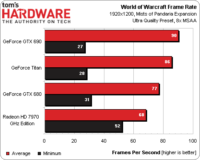

Résolution : 1920×1080

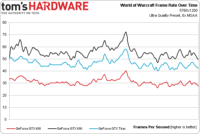

Ce graphique prouve (enfin !) l’intérêt d’analyser l’évolution du nombre d’ips au cours du test. Les trois GeForce délivrent en effet de meilleures moyennes que la Radeon mais des minima plus bas. Les moyennes étant de toute manière largement suffisantes, la Radeon semble préférable.

Sur les trois cartes Nvidia, le framerate plonge à un seul moment sous les 40 ips, même en 1920×1080. Ce phénomène ne se produit par sur la Radeon. Voilà qui explique pourquoi les GeForce affichent un moins bon minimum mais une meilleure moyenne.

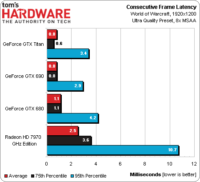

Les latences ne sont problématiques sur aucune carte ce que nous pouvons confirmer subjectivement.

Résolution : 2560×1600

L’irrégularité constatée en 1920×1080 disparaît en 2560×1600 : les minima et les moyennes donnent le même classement, avec les trois GeForce en tête. La GTX Titan est plus proche de la GTX 690 que de la GTX 680 toutefois.

Le verdict est encore plus clair sur ce graphique. Les GeForce GTX 680 et Radeon HD 7970 GHz sont au coude à coude alors que la GTX Titan et la GTX 690 naviguent un cran au-dessus.

La latence au 95e centile de la Radeon HD 7970 GHz est deux fois plus élevée qu’au 75e centile et trop élevée dans l’absolu. ON serait tenté d’en conclure que le jeu saccade avec cette carte. Pourtant, au vu de notre expérience, nous ne pensons pas que cette différence soit perceptible à l’oeil.

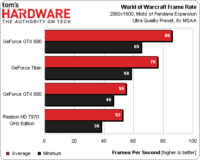

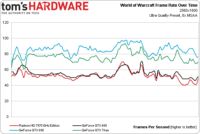

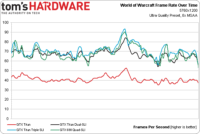

Résolution : 5760×1200

AMD a un plus gros problème dans WoW : la Radeon HD 7970 GHz ne supporte par le 5760×1200. Elle force nos trois écrans à fonctionner en mode clone.

Il est probable que la Radeon ne soit pas capable d’assurer un nombre d’images par seconde suffisant, de toute manière, vues les performances de la GTX 680. La GeForce GTX 690 et la Titan, en revanche, tiennent le choc, même en 5760×1200 en qualité Ultra.

Ce nouveau graphique ne nous apprend pas grand chose de plus : la GTX 680 tombant sous les 30 ips ne sera pas idéale pour s’attaquer aux boss.

Les latences au 95e centile montrent qu’il y a des pics susceptibles de créer des saccades, mais les écarts restent suffisamments bas dans l’absolu.

Performance en bi- et tri-SLI

Tous nos tests monocartes furent faits sous Windows 8. Malheureusement, un certain nombre de tests en tri-SLI et quadri-SLI avec les GeForce GTX Titan et 690 se sont montrés instables. Nous fûmes donc obligés d’utiliser le PC que nous avait fourni Geek Box, qui était préinstallé sous Windows 7. Nvidia ne nous a pas encore indiqué la cause de ce dysfonctionnement.

Battlefield 3

La progression des performances avec le nombre de GTX Titan en SLI est linéaire ou presque sous BattleField 3. Au contraire, deux GeForce GTX 690 en quad-SLI souffrent de problèmes et notamment d’un minimum d’ips bientôt trop faible.

Et ce n’est pas un problème ponctuel. À de multiples reprises, le quadri-SLI plonge. La moyenne est correcte mais les Titan délivrent des performances bien plus régulières et un jeu plus fliude.

Borderlands 2

La progression sous Borderlands 2 n’est pas aussi linéaire, la troisième GTX Titan n’apportant virtuellement aucun gain. Heureusment, deux GeForce GTX Titan sont déjà capables de dépasser les 100 ips. En outre, un SLI de deux Titan est plus performant qu’un quad-SLI de GTX 690.

Le quadri-SLI ne souffre pas de la même irrégularité que dans Battefield 3. Cependant, ses performances restent plus chaotiques et moins élevées que le bi-SLI de GTX Titan. Si vous avez 2 000 € de côté, préférez un duo de GeForce GTX Titan.

Far Cry 3

Deux GeForce GTX Titan sont presque aussi rapides en moyenne que deux GeForce GTX 690. Et elles assurent un meilleur framerate minimum.

Pire, en pratique, jouer sur le quad-SLI est saccadé, comme c’est déjà le cas sur une seul GTX 690 en 2560×1600 et au-delà. Far Cry 3 est la parfaite raison de préférer une paire de GK110 plutôt qu’un quatuor de GK104.

Les courbes parlent d’elles-mêmes : les Titan en bi-SLI sont d’une régularité exemplaire. Le tri-SLI n’est pas aussi stable, mais à plus de 70 ips en moyenne dans un jeu aussi exigeant, cette configuration est intouchable !

Hitman: Absolution

Hitman: Absolution apprécie moyennement le bi-SLI. Au-delà, par contre, il n’y a aucune évolution. Nvidia nous a confié qu’il y a sans doute un problème dans le benchmark intégré au jeu, les performances étant meilleures dans une partie réelle.

Il y a clairement un facteur limitant étranger aux cartes graphiques et d’après les dires de Nvidia, il s’agit d’un souci dans la séquence du benchmark.

The Elder Scrolls V: Skyrim

Skyrim à sa sortie était largement limité par le CPU, nous sommes donc agréablement surpris de voir que les performances progressent sur les configurations multiGPU. Trois GeForce GTX Titan sont inutiles cependant. Les quatre GK104 ne font pas beaucoup mieux qu’une seule Titan et nettement moins bien que deux Titan.

World of Warcraft: Mists of Pandaria

Le saut de performances apporté par une deuxième GeForce Titan est modeste dans World of Warcraft. Mais ce jeu n’est pas connu pour son moteur graphique exigeant, il y a donc sans doute d’autres facteurs limitant la progression. Comme dans Hitman, il n’y a aucune différence entre deux GK110 et quatre GK104.

L’atout du GK110 : le GPGPU

Une des plus grosses déceptions de la GeForce GTX 680 est sa puissance de calcul général. Le GK104 fut conçu et optimisé pour les jeux, ce qui explique que chacun de ses SMX ne possède que huit unités FP64. Le GK110, ne revanche, possède 64 unités FP64 par SMX, soit un total de 896 dans tout le GPU.

Mais, comme nous l’avons vu, NVIDIA bride ces unités à 1/8e de la fréquence du reste du GPU, par défaut. L’idée est de limiter la consommation de ces unités peu utiles en jeu pour laisser plus de marge à GPU Boost. Si vous vous exploitez tout le potentiel GPGPU du GK110, vous devez manuellement l’activer dans les pilotes, manipulation qui désactive GPU Boost et bloque tout le GPU à ses fréquences de base.

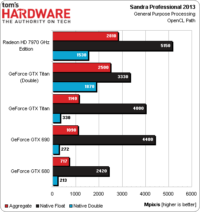

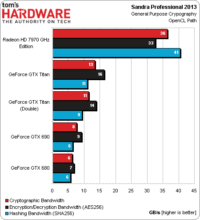

SiSoftware Sandra 2013

Commençons par SiSoftware Sandra 2013 et son module GP Processing qui exploite OpenCL :

La Radeon HD 7970 GHz Edition domine en simple précision. Mais mettons cela de côté pour regarder les résultats de la GTX Titan dans son mode par défaut et une fois le mode FP64 activé, que nous appelons “Double” sur nos graphiques. Remarquez comme les performances FP32 diminuent en mode double, à cause de la fréquence en baisse. Les performances en double précision, en revanche explosent.

Essayons d’exprimer ces résultats en Flops. En supposant 11 instructions par itération de l’ensemble de Mandelbrot que Sandra utilise, la GeForce GTX Titan atteint 1,14 TFlops en FP64. La Radeon HD 7970 GHz atteint 934 GFlops.

Mais ces chiffres n’intéresseront que ceux qui calculent calculs dans Wolfram Mathematica ou autres logiciels équivalents. Les calculs FP32 sont bien plus courants. Dans ce test, la Radeon atteint 3,14 TFlops. La meilleure carte Nvidia est alors la GTX 690 qui délivre 2,68 TFlops.

AMD est intouchable dans le module de chiffrement, qui emploie aussi OpenCL.

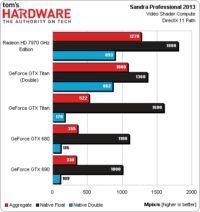

Le test video shader génère des fractales de Mandelbrot via le Shader Model 5.0 en simple ou double précision 32 ou 64. AMD remporte une nouvelle victoire dans les deux cas. Toutefois, la GTX Titan n’est pas loin en double précision une fois le mode FP64 activé (au détriment de la performance FP32, à nouveau).

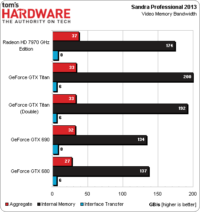

La GeForce GTX Titan et la Radeon HD 7970 GHz Edition offrent une bande passante mémoire théoriquement identique, mais la GeForce l’exploite mieux en pratique. Incidemment, Nvidia désactive le PCI-Express 3.0 sur les plateformes Intel X79, au contraire d’AMD. Cela explique que la Radeon affichent des débits d’interface plus élevés. Mais Nvidia maintient que le contrôleur PCI-Express d’Intel a un défaut qui peur se manifester en PCI-Express 3.0 sur des configurations multicartes part des saccades.

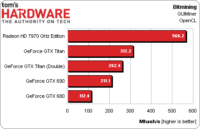

Bitmining

Notre test sous GUIMiner donne des résultats proches du test de chiffrement de Sandra. La Radeon est largement en tête. La GeForce GTX Titan fait presque trois fois mieux que la GTX 680, mais n’est toujours pas compétitive.

Photoshop CS6

Malheureusment, à partir d’ici, notre procédure de test OpenCL montre ses limites.

Nous utilisons un script sous Photoshop CS6 qui enchaîne plusieurs filtres accélérés via OpenCL. Les GeForce GTX 680 et 690 affichent des performances similaires et bien meilleures que la Radeon HD 7970 GHz. La GeForce GTX Titan, malheureusement, plante au milieu du test, Photoshop nous informant d’un problème avec le pilote graphique.

WinZip 17

Notre benchmark sous WinZip 17 compresse un dossier de 2,1 Go sur un RAM disk. Il ne fait pas planter la GeForce GTX Titan. Mais elle se montre moins rapide une fois “l’accélération” OpenCL activée que sans. Au contraire, les autres cartes montrent des gains substantiels avec OpenCL. Il y a donc un vilain bug avec la GTX Titan.

LuxMark 2.0

De même que Photoshop, LuxMark plante à mi course avec la GeForce GTX Titan. En conséquence, nous ne pouvons pas savoir comment elle se place face à la Radeon HD 7970 GHz Edition, qui termine en tête, loin devant.

Globalement, le GPGPU est un motif de déception sur la GeForce GTX Titan. Le GK110 montre son potentiel sous Sandra 2013, mais nous ne savons pas comment il se débrouillera dans les applications réelles. Pour une carte dont le GPGPU est l’un des principaux arguments, qui devait rattraper les Radeon sur ce critère, c’est un gros échec.

Nvidia nous a assuré qu’un prochain pilote résoudrait ces problèmes prochainement.

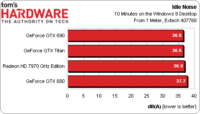

Températures et bruit

Les températures au repos ne sont pertinentes qu’en ce qu’elles affectent la vitesse des ventilateurs et donc le bruit. AMD laisse son Tahiti GPU mijoter plus chaud que les GK104 et GK110. Cela veut-il dire que le ventilateur de la Radeon 7970 GHz tourne moins vite et fait moins de bruit ?

Non ! AMD ne creuse aucun écart, mais nous sommes satisfaits de voir les quatre cartes demeurent très silencieuses au repos.

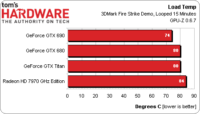

Les températures en charge sont également de bons indicateurs de l’efficacité du système de refroidissement. La GTX 680 et la GTX Titan atteignent leur plafond autorisé de 80 °C sous 3D Mark Fire Strike (en mode Extreme). La GTX 690 ne chauffe pas autant. En revanche la Radeon HD 7970 GHz monte à 84 °C.

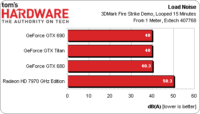

Et soudain c’est le drame, toujours le même, avec la Radeon HD 7970 GHz. Afin de refroidir son GPU Tahiti, la Radeon fait tourner son ventilateur très vite. Il émet un bruit désagréable ce faisant : avec 50 dBA, la Radeon est beaucoup – beaucoup – plus bruyante que les trois GeForce qui, elles, sont remarquablement similaires.

Le fait que la GeForce GTX Titan, parviennent à ce résultat malgré ses 7,1 milliards de transistors et son TDP de 250 W est un exploit à souligner.

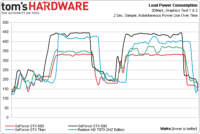

Consommation

Tous nos tests de températures, de bruit et de consommation énergétique ont été réalisés sur une machine à trois moniteurs. En effet, si vous envisagez d’acheter une GTX 690 ou une GTX Titan, vous envisagez sans doute de jouer en 5760×1080 ou 5760×1200.

Ceci dit, gardez à l’esprit que la consommation serait différente sur une configuration monoécran.

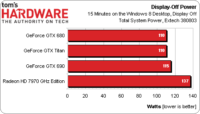

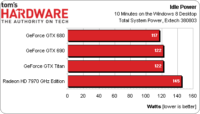

Lorsqu’on branche la Radeon à trois écrans, son GPU monte à 500 MHz et la mémoire tourne à pleine vitesse (1,5 GHz). Par conséquent, sa consommation est relativement élevée, que les écrans soient en veille ou que l’on clique sur le bureau de Windows. La consommation totale de notre configuration avec la GTX Titan pilotant les trois écrans en veille (soit après 10 minutes d’inactivité, dans le mode d’alimentation “équilibré” de Windows) est à peu près la même qu’avec la GeForce GTX 680. Une GTX 690 demande quelques Watts de plus.

Avec les trois écrans allumés mais sans activité, la GTX Titan est au niveau de la GTX 690. Seule la GTX 680 fait un peu mieux.

Ces courbes retracent l’évolution de la consommation totale de notre machine de test pendant le premier et le second test graphique de 3D Mark. Les deux GK104 de la GTX 690 consomment clairement plus, suivis par la Titan, puis la Radeon HD 7970 et enfin la GTX 680.

Notre PC avec la Titan affiche une moyenne de 311 W dans ces tests, contre 339 W avec la GTX 690, 285 W avec la Radeon HD 7970 GHz et 265 W avec la GTX 680.

GeForce GTX Titan : terriblement rapide, terriblement chère

Nous vous avions donné des éléments de conclusion mardi dernier en vous promettant que les benchmarks publiés aujourd’hui les justifiraient. Entre-temps, nous avons pu faire de nouveaux tests et en revérifier d’autres. Revisitons nos premières conclusions à la lumière de ces nouveaux résultats.

1) Si vous voulez absolument une configuration monocarte et si votre boîtier est suffisamment profond, optez pour la GeForce GTX 690. Elle demeure la carte graphique la plus rapide que nous ayons jamais testée et coûte le même prix que la GTX Titan, il n’y a donc aucune raison de ne pas la préférer.

Nous maintenons. Techniquement, il est vrai que la GeForce GTX 690 pourrait être bridée par ses 2 Go de mémoire par GPU, mais nos tests en 5760×1200 et qualité Ultra n’ont rien montré de tel. Far Cry 3 est le seul titre dans lequel nous avons remarqué des ralentissements, mais ils apparaissaient en 2560×1600, donc il est peu probable que la mémoire en soit la cause.

2) La Titan ne vaut pas 550 € de plus qu’une Radeon HD 7970 GHz Edition. Il revient moins cher d’acheter deux cartes AMD et les performances seront meilleures. Malheureusement, elles sont aussi considérablement plus bruyantes en charge et il est nécessaire d’avoir assez de place sur sa carte-mère (c’est-à-dire un slot vide au milieu des deux slots accueillant les deux Radeon). Nous ne recommandons pas ce genre de solutions habituellement, mais on obtient une configuration plus rapide pour 100 € de moins.

Ce point prête plus à discussion. Sur le seul critère de la performance moyenne par euro, deux Radeon HD 7970 GHz sont absolument moins chères et plus rapides qu’une seule GeForce GTX Titan. Mais il faut penser à leur niveau de bruit très élevé et aux microsaccades. Nos mesures montrent qu’AMD a fait de gros progrès sur ce point dans certains jeux, mais d’autres restent problématiques. Mais nous sommes pas encore en mesures de comparer les configurations multi-GPU entre elles. Nous sommes en train de mettre au point quelque chose qui nous le permettra bientôt. En attendant, les Radeon HD 7970 GHz sont intéressantes et se bonifient en vieillissant grâce aux mises à jour de leurs pilotes.

3) Si vous voulez obtenir les meilleures performances possible dans un boîtier mini-ITX tel que le Falcon Northwest Tiki ou l’iBuyPower Revolt, optez pour une GeForce GTX Titan. La GTX 690 est à déconseiller dans ce cas de figure en raison de sa longueur, de sa consommation et de son ventilateur axial.

Il n’y a aucune discussion ici. Il n’y aucun moyen de mettre une carte plus rapide que la GeForce GTX Titan dans un Tiki, Revolt, Bolt ou assimilé. Pourquoi mettre plus de 900 € dans une carte moins rapide que la GTX 690 ? Voilà pourquoi.

4) Choisissez également la GeForce GTX Titan si vous avez trois écrans 1920 x 1080, 2560 x 1440 ou 2560 x 1600 et si vous avez l’intention d’utiliser trois cartes en SLI. Dans les jeux les plus exigeants, les performances de deux GK110 évoluent de manière bien plus linéaire que quatre GK104 (deux GeForce GTX 690). Avec trois Titan, c’est Noël tous les jours.

C’est en jouent en 5760×1200 que l’on commence à douter de la GTX 690. Autant ne pas se tromper lorsqu’on investit près de 2 000 € en cartes graphiques. De notre point de vue, le choix est simple : une paire de GeForce GTX Titan est plus élégante, plus économe en énergie et laisse ouverte la possibilité d’installer une troisième GTX Titan dans le futur, si jamais on gagne au loto.

Ceci posé, nos benchmarks révèlent un certain nombre de faiblesses. Le support d’OpenCL n’est pas encore total dans le pilote de la GTX Titan. Des bugs dans les tests synthétiques et dans les applications réelles montrent que les plâtres ne sont pas encore secs – c’est toujours désagréable sur un composant aussi onéreux.

Mais au moins, le GK110 possède la puissance en GPGPU qui fait défaut au GK104. Pour les développeurs qui rêvaient d’une Tesla K20X sans pouvoir se l’offrir, la GTX Titan est une excellente affaire, même à 1 000 €. L’architecture GCN d’AMD garde cependant une avance dans certaines applications comme bitcoin.

Au final, nous maintenons qu’à près de 1 000 €, la GeForce vise deux catégories spécifiques de joueurs, que nous avons présentées en détail mardi. Pour le reste du monde, elle est une carte très rapide, très bien construite qui ne trouve pas sa place, ni face aux Radeon d’AMD, ni face aux autres productions de Nvidia.