Les NPU sont conçus pour surpasser les CPU et les GPU en termes d’efficacité et de performances pour des tâches d’IA spécifiques, telles que la reconnaissance d’images et le traitement du langage naturel. Mais quels sont leurs avantages réels, et leurs inconvénients actuels ?

L’intégration de l’intelligence artificielle dans les ordinateurs portables, les smartphones et les tablettes marque un tournant dans l’industrie informatique grand-public. Est-il pour autant judicieux d’investir dès aujourd’hui dans une machine embarquant un NPU ?

Derrière ce terme se cache un peu tout et n’importe quoi, que ce soit au niveau de la puissance de calcul disponible, de l’efficacité énergétique ou tout simplement du type de calculs et de données pris en charge. Éclaircissons dans un premier temps certaines idées et certains termes.

NPU, faut-il se fier aux TOPS ?

A défaut de communiquer sur les détails architecturaux ou sur la fréquence de leur puce, les constructeurs annoncent fièrement la puissance de calcul de leurs NPU en TOPS (Tera Operations Per Second) ou POPS (1000 TOPS, soit un million de milliards d’opérations par seconde) pour les plus rapides. Mais un TOPS en vaut-il vraiment un autre ?

Se fier uniquement aux TOPS peut en effet être trompeur et conduire à un choix inapproprié. Une compréhension globale des facteurs clés, tels que l’architecture, la consommation d’énergie, la bande passante et le taux d’utilisation, est essentielle pour prendre une décision éclairée. Hélas, les constructeurs ont déjà pris l’habitude de vanter les TOPS de leurs produits respectifs, sans rentrer dans les détails…

NPU, pour quel usage ?

Choisir le bon NPU nécessite une analyse approfondie des besoins de l’application et des caractéristiques des différentes options disponibles. Certains NPU sont conçus pour des tâches spécifiques, tandis que d’autres sont plus polyvalents et peuvent gérer un plus large éventail d’applications.

Les NPU excellent dans l’exécution des algorithmes d’apprentissage profond, surpassant largement les CPU et GPU traditionnels en termes d’efficacité et de rapidité. Cette supériorité se traduit par des performances accrues dans des applications telles que la reconnaissance d’images, la traduction automatique et les jeux vidéo. Concrètement, pour les utilisateurs, cela signifie des temps de traitement réduits, une meilleure fluidité et une expérience utilisateur globale améliorée.

L’un des exemples concrets les plus parlants est l’amélioration des appels vidéo. Grâce à l’IA assistée par le NPU, le flou d’arrière-plan devient plus précis, la résolution est améliorée et la clarté de la voix est optimisée, le tout sans impacter négativement l’autonomie de l’appareil.

Une application de traitement d’images HD nécessitant des résultats en temps réel (soit moins d’une milliseconde) exige par exemple une capacité de calcul de l’ordre de 5 TOPS. Microsoft explique de son côté que les PC “IA” Copilot+ doivent atteindre une puissance de calcul d’au moins 40 TOPS pour bénéficier de cette appellation.

Assez arbitraire, cette valeur est ironiquement déjà largement dépassée par de nombreux appareils sur le marché, pourtant dépourvus de NPU dédié. N’importe quel ordinateur portable gaming, probablement votre propre ordinateur ou même des consoles de jeu comme la Xbox Series X (de Microsoft…) atteignent facilement cette barre des 40 TOPS, ce qui n’en fait pas pour autant des “PC IA Copilot+”. Le véritable avantage d’intégrer un NPU dans un appareil est plutôt à chercher à un autre endroit.

Autonomie prolongée : un atout majeur

Au-delà des performances brutes, le NPU brille en effet par son efficacité énergétique. Sa conception optimisée pour les tâches d’inférence lui permet de traiter d’importants volumes de données tout en minimisant la consommation d’énergie. Cette caractéristique est cruciale pour les appareils mobiles comme les ordinateurs portables, où l’autonomie est un critère déterminant.

Prenons l’exemple des appels vidéo via Zoom : un ordinateur portable équipé d’un processeur Core Ultra avec NPU offre jusqu’à 38 % d’autonomie supplémentaire par rapport à un modèle dépourvu de NPU.

Applications compatibles : un écosystème en construction

Un frein majeur à l’adoption de masse des NPU persiste toutefois : le manque d’applications optimisées pour tirer pleinement parti de ses capacités. Si des logiciels comme Adobe Creative, Topaz Labs, Cisco Webex ou Zoom commencent à intégrer des fonctionnalités utilisant le NPU, l’écosystème reste à l’heure actuelle encore assez limité. Une puce dédiée n’est pas utile à l’utilisateur lambda pour profiter de ChatGPT, Midjourney ou de tout autre outil “intelligent” équivalent, et des logiciels comme LM Studio permettent de faire tourner n’importe quel LLM (Large Language Model) en local, sur un processeur un ou GPU classique…

Les applications de montage vidéo/photo, de production musicale et de conception graphique représentent tout de même un terrain fertile pour l’exploitation du NPU. L’isolation des voix, le masquage des personnes ou encore la suppression d’objets sont autant de fonctionnalités qui pourraient être révolutionnées par l’accélération matérielle offerte par le NPU, et qui le seront probablement dans un futur plus ou moins proche.

Comment comparer les NPU entre eux ?

Voici une problématique rencontrée par les utilisateurs grand-public comme par la rédaction de Tom’s Hardware : comment et sur quels critères comparer des NPU entre eux, sachant que la puissance requise pour une tâche “IA” dépend de la quantité de données d’entrée, du temps de réponse souhaité et de sa complexité ? II n’existe pas encore de suite logicielle universelle permettant de mesurer les performances de chaque solution. Il faut donc, pour le moment, s’en remettre aux données communiquées par les constructeurs.

Notons au passage que la précision utilisée pour les calculs (INT4, INT8,…) a un impact sur les performances et donc le nombre de TOPS. Une précision plus faible réduit forcément la charge de traitement mais peut affecter la précision du modèle. L’utilisation de techniques telles que la sparsité (ignorer les calculs avec des valeurs nulles) et l’élagage (suppression des redondances) améliore les performances en réduisant la charge de calcul.

Il conviendra dès lors de confronter les différents NPU à précision et optimisations équivalentes : on ne compare pas des pommes et des bananes ! Voici tout de même une liste de différentes solutions intégrant ou non un NPU, avec la puissance de calcul disponible et la consommation typique de l’appareil.

La consommation d’énergie est en effet une considération cruciale pour les appareils mobiles et embarqués. Les NPU sont conçus pour être économes en énergie, mais leur consommation réelle peut varier en fonction de la charge de travail et de l’implémentation. C’est donc aussi un critère pertinent de comparaison.

| Produit | Architecture | TOPS (INT4) | TOPS (INT8) | Consommation |

|---|---|---|---|---|

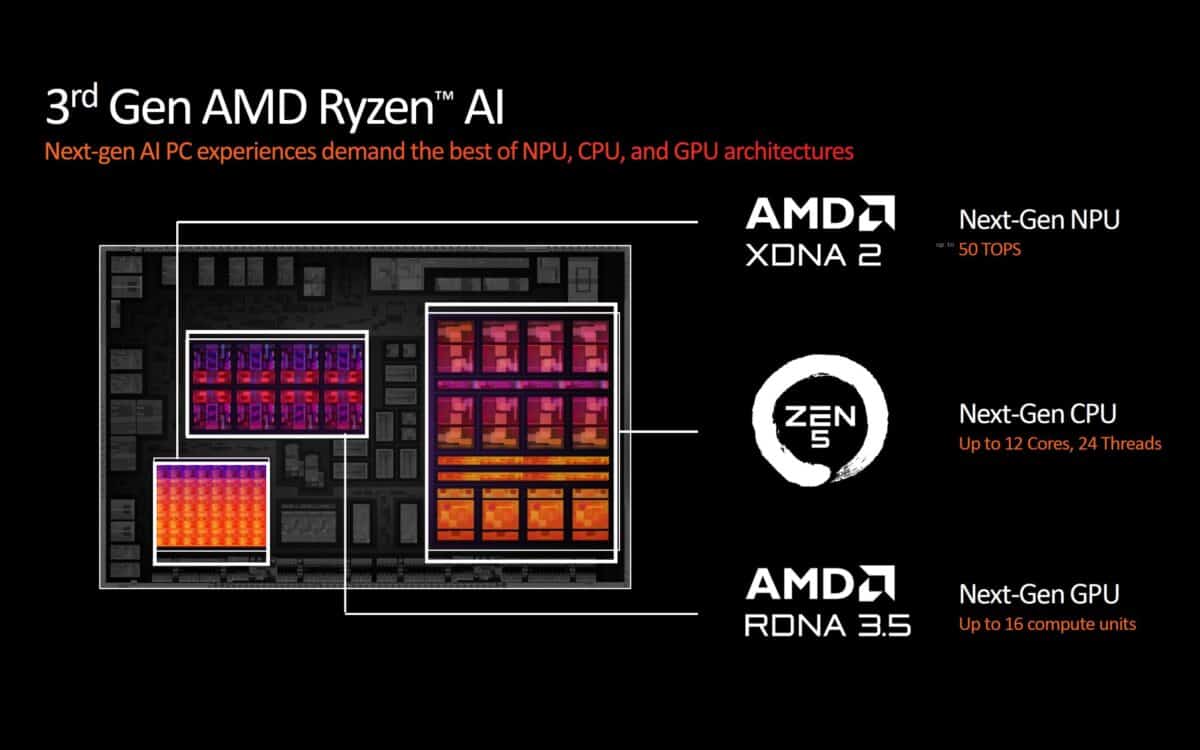

| AMD Ryzen AI 300 Series | Strix Point XDNA 2 + Zen 5/5c | 50 TOPS | ? | 28 W |

| AMD Ryzen 8040 Series | Hawk Point XDNA + Zen 4 | 16 TOPS (NPU seul) 39 TOPS (CPU+GPU+NPU)* | ? | 45 W |

| AMD Ryzen 7040 Series | Phoenix XDNA + Zen 4 | 10 TOPS (NPU seul) 33 TOPS (CPU+GPU+NPU)* | ? | 15-45 W |

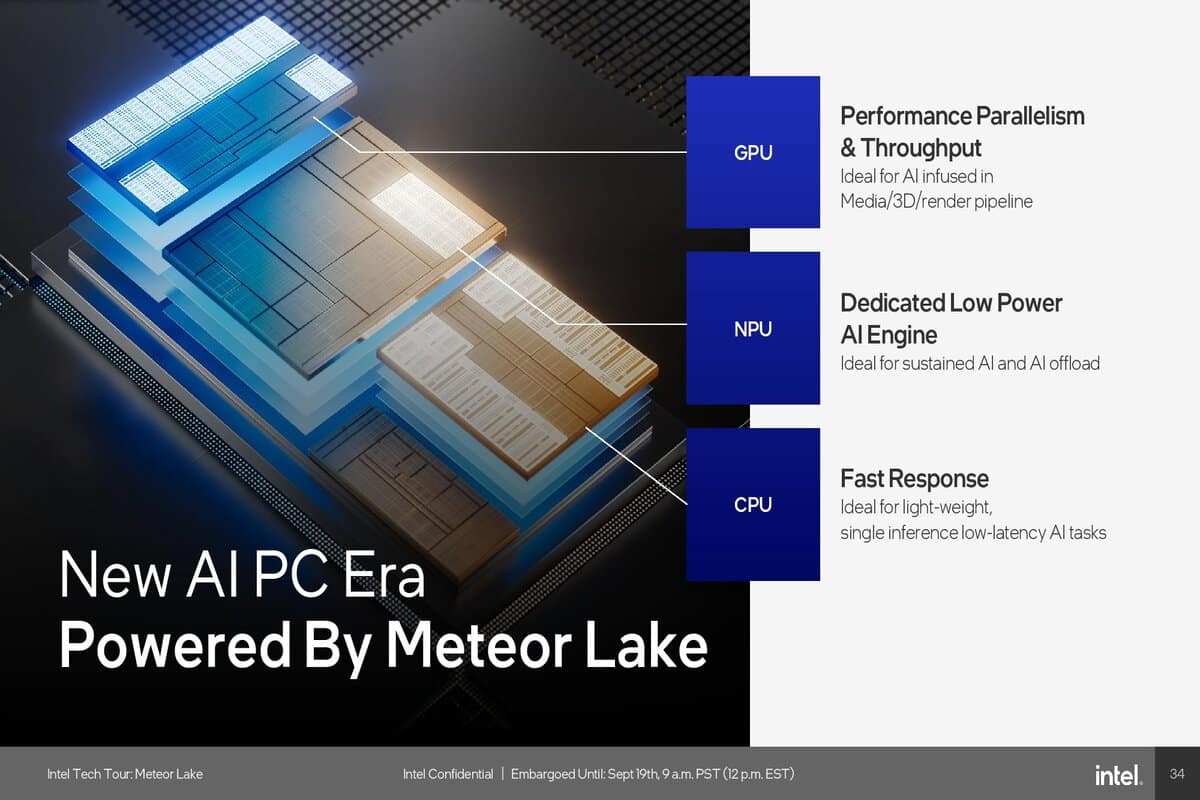

| Intel Core Ultra 200 Series | Lunar Lake NPU Gen4 | 40-48 TOPS (NPU seul) 100-120 TOPS (CPU+GPU+NPU)* | ? | 17-30 W |

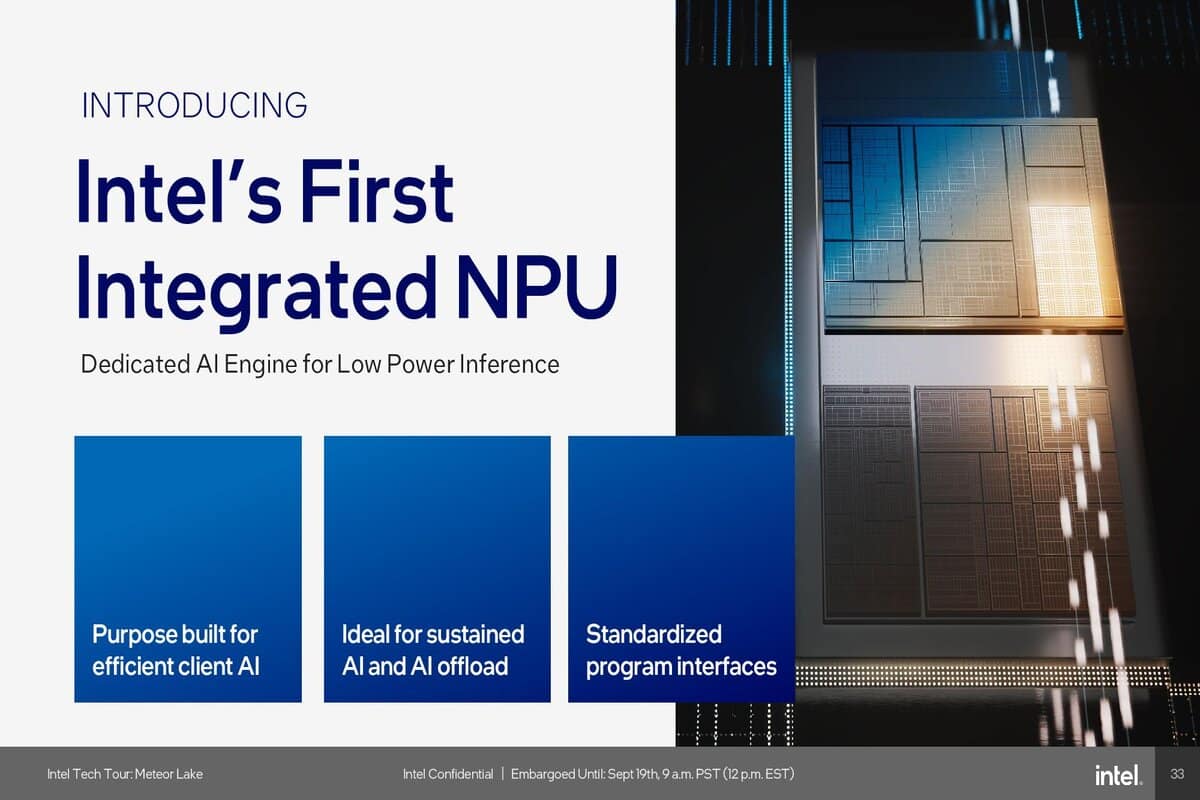

| Intel Core Ultra 100 Series | Meteor Lake | 10-11,5 TOPS (NPU seul) 34 TOPS (CPU+GPU+NPU)* | ? | 9-65 W |

| Qualcomm Snapdragon X Elite/Plus | Hexagon | 45 TOPS (NPU seul) 75 TOPS (CPU+GPU+NPU)* | ? | – |

| Qualcomm Snapdragon 8cx Gen3 | Hexagon | 29 TOPS | ? | – |

| Qualcomm Snapdragon 8c | Hexagon 690 | 9 TOPS | ? | – |

| Qualcomm Snapdragon 7x+ Gen3 | Hexagon | 6.5 TOPS | ? | – |

| Qualcomm Snapdragon 7c/7c Gen2 | Hexagon 692 | 5 TOPS | ? | – |

| Apple M3 | – | 20 TOPS | ? | – |

| Apple M4 | – | 38 TOPS | ? | – |

| Microsoft Xbox Series X | RDNA 2.0 | 97 TOPS | 49 TOPS | 200 W |

| AMD Radeon RX Vega 56 | GCN 5.0 | – | 33 TOPS | 210 W |

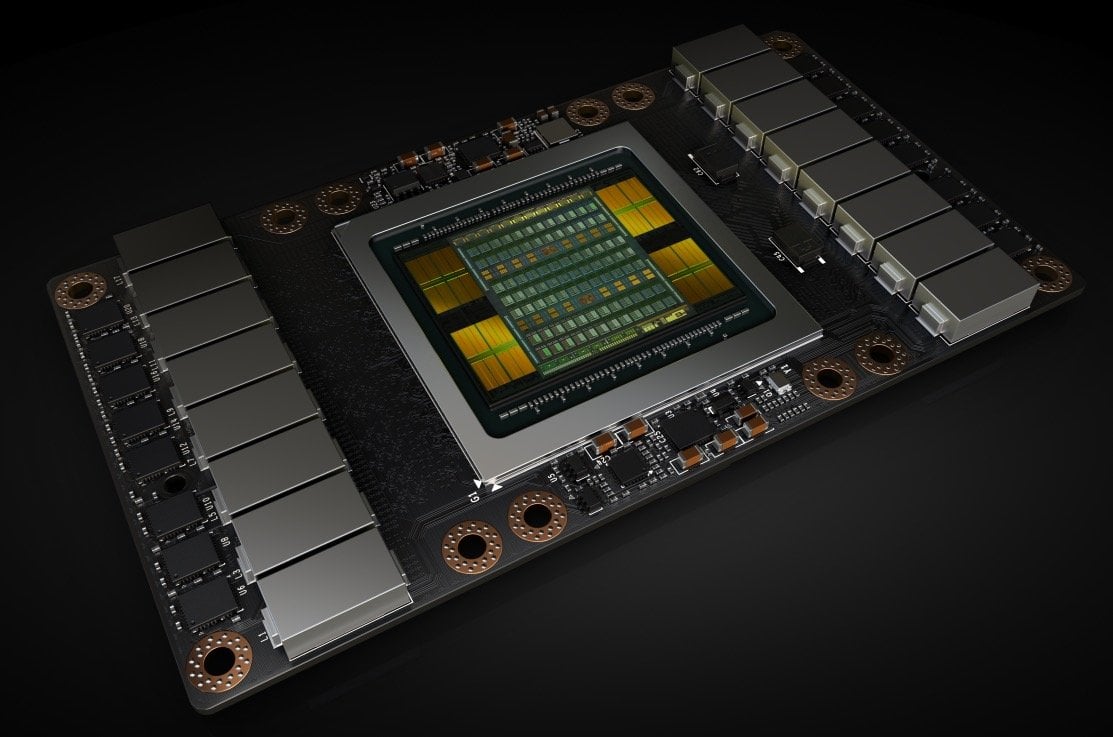

| Nvidia RTX 4090 | Ada | 1321 TOPS | ? | 450 W |

| Nvidia RTX 4090 Mobile | Ada | 686 TOPS | ? | 120 W |

| Nvidia RTX 4050 Mobile | Ada | 194 TOPS | ? | 50 W |

| Nvidia RTX 3090 | Ampere | 568 TOPS | 284 TOPS | 350 W |

| Nvidia RTX 3070 | Ampere | 325 TOPS | 163 TOPS | 220 W |

| Nvidia RTX 2080 Ti | Turing | 430-455 TOPS | 215-228 TOPS | 250-260 W |

| Nvidia RTX 2060 | Turing | 206 TOPS | 103 TOPS | 160 W |

| Nvidia GTX 1080 Ti | Pascal | – | 42 TOPS | 250 W |

| Nvidia GTX 1050 Ti | Pascal | – | 7 TOPS | 75 W |

| Nvidia Tesla T4 | Turing | 260 TOPS | 130 TOPS | 70-75 W |

| Nvidia Tesla P4 | Pascal | – | 22 TOPS | 50-75 W |

| Nvidia Tesla P40 | Pascal | – | 47 TOPS | 250 W |

| Nvidia Tesla V100 (PCIe) | Volta | – | 224 TOPS | 250 W |

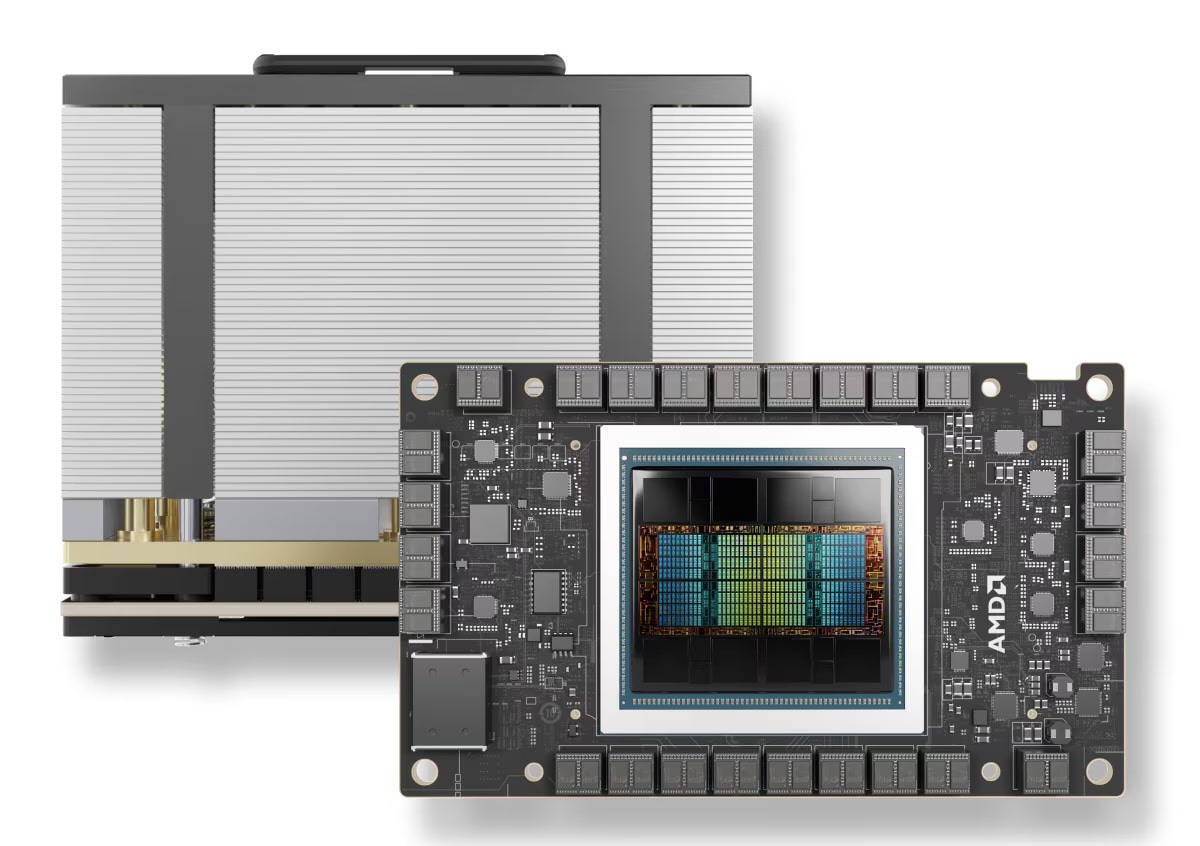

| AMD Instinct MI300X | CDNA 3 | ? | 2615 TOPS | 750 W |

| AMD Instinct MI300A | CDNA 3 | ? | 1961 TOPS | 550-760 W |

| AMD Instinct MI250X | CDNA 2 | 383 TOPS | 383 TOPS | 500-560 W |

| AMD Instinct MI250 | CDNA 2 | 362 TOPS | 362 TOPS | 500-560 W |

| AMD Instinct MI210 | CDNA 2 | 181 TOPS | 181 TOPS | 300 W |

| AMD Instinct MI100 | CDNA | 185 TOPS | 185 TOPS | 300 W |

| AMD Instinct MI50 | GCN 5.1 | – | 28.5-53 TOPS | 300 W |

Un investissement judicieux ?

Faut-il pour autant céder à la frénésie et acheter dès aujourd’hui un processeur impérativement équipé d’un NPU ? Il est à nos yeux préférable de patienter jusqu’en 2025 : le manque d’applications optimisées limite actuellement son intérêt pour le grand public. L’écosystème d’applications optimisées pour le NPU devrait se développer d’ici là, permettant aux utilisateurs de profiter pleinement de ses avantages.

Plutôt que de se précipiter, nous vous conseillons donc d’attendre l’adoption plus large de cette technologie par les éditeurs de logiciels. Cette période de transition permettra aux développeurs de logiciels de rattraper leur retard et d’offrir des expériences utilisateur réellement innovantes, et aux fabricants de puces d’améliorer les performances et l’efficacité des NPU intégrés à leurs produits. En d’autres termes, il est urgent d’attendre la prochaine génération de puces !

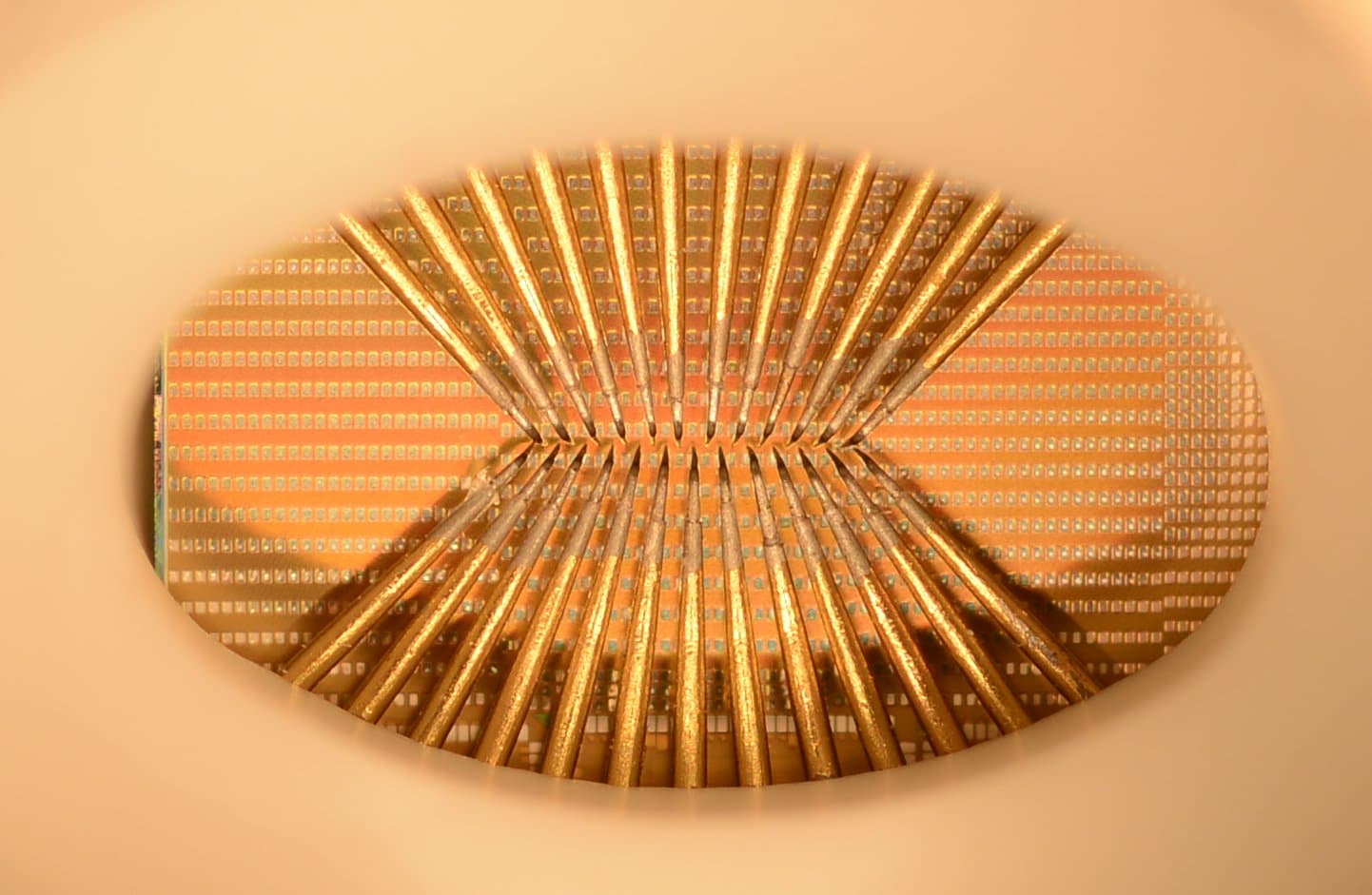

Qu’est-ce qu’un Neural Processing Unit (NPU) ?

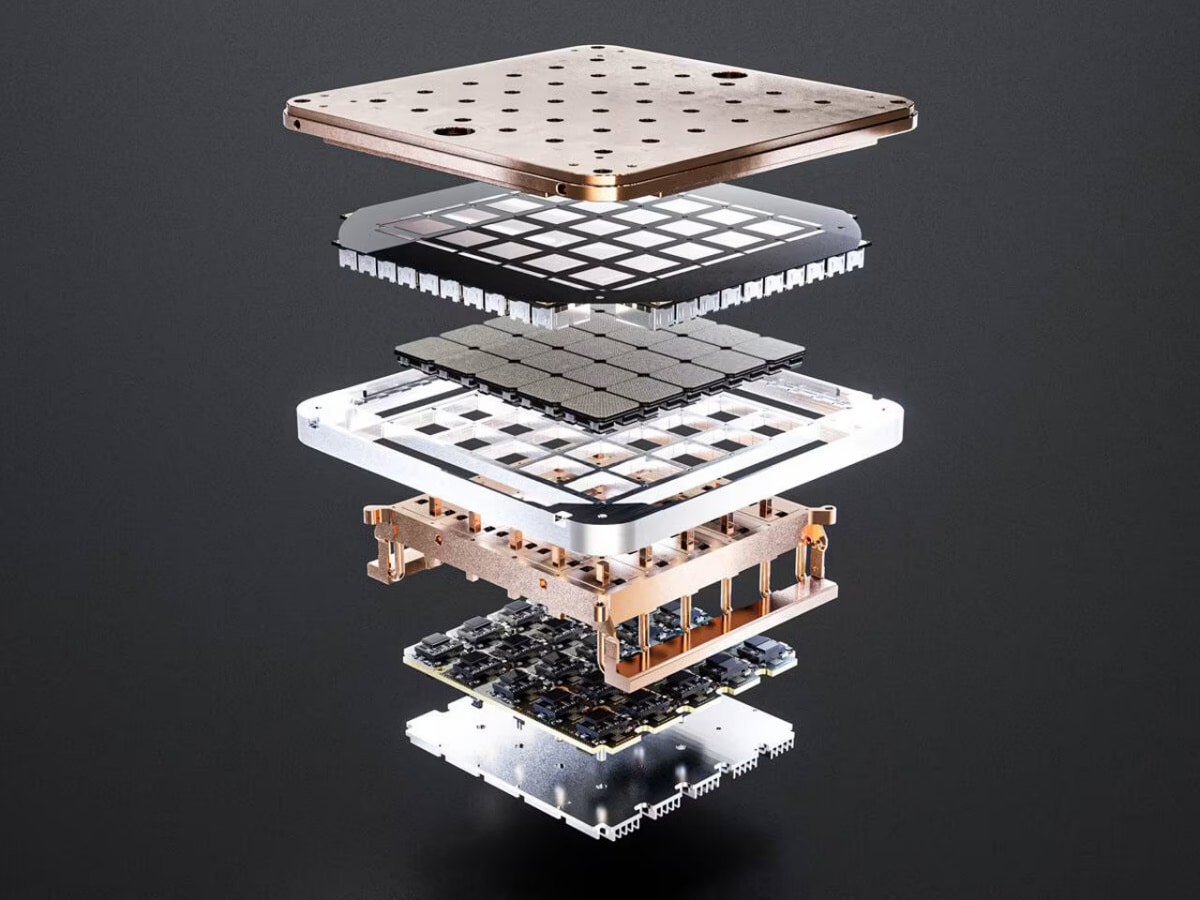

Un Neural Processing Unit, aussi appelée accélérateur d’IA ou unité de traitement neuronal, est un ensemble d’unités de calculs conçues pour accélérer les calculs des réseaux neuronaux artificiels. Les NPU excellent dans les tâches d’IA, libérant ainsi le CPU et le GPU pour d’autres tâches, et sont parfois directement intégrés à des processeurs ou à d’autres contrôleurs en tant qu’unités de calcul dédiées.

En pratique, les NPU sont utilisés dans une variété d’applications, notamment la reconnaissance d’images, la traduction automatique, l’analyse d’imagerie médicale pour un diagnostic plus rapide, la sécurité, la conduite autonome en automobile ou encore les jeux vidéo.

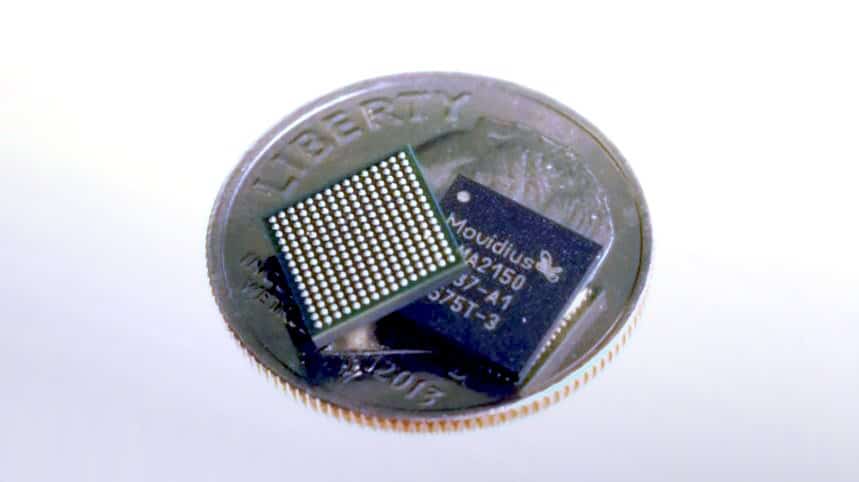

Bien que les GPU soient efficaces pour les calculs parallèles, ils dépendent du CPU pour la création de modèles de réseaux neuronaux et les flux de données. Ils consomment beaucoup d’énergie et sont encombrants, ce qui les rend inadaptés aux appareils compacts ou mobiles. Les NPU sont en revanche des processeurs spécialisés, de petite taille et économes en énergie, qui offrent des performances de calcul élevées. Ils sont donc idéaux pour les appareils mobiles et embarqués.

Ils fonctionnent en simulant le fonctionnement général du cerveau humain à l’aide d’un jeu d’instructions d’apprentissage profond, où une seule instruction peut traiter un ensemble de données ou de “neurones”. En comparaison, les CPU et les GPU nécessitent des milliers d’instructions pour effectuer le même traitement.

Quels types de NPU existent sur le marché ?

Différents types de NPU sont d’ores et déjà disponibles sur le marché, chacun ayant ses propres forces et faiblesses. Les NPU dits “autonomes” sont par exemple des puces dédiées spécifiquement aux tâches d’IA. Ils fonctionnent indépendamment du CPU principal et sont généralement utilisés dans les appareils où la consommation d’énergie est un facteur critique, tels que les smartphones, les tablettes et les appareils IoT.

De nombreux appareils mobiles récents tels que les smartphones intègrent d’ailleurs des NPU en tant que coprocesseurs dans leurs SoC. Ils sont conçus pour fonctionner en tandem avec le CPU principal, gérant des tâches spécifiques d’inférence comme la reconnaissance d’images, le traitement du langage naturel et la détection d’objets. La plateforme mobile Snapdragon 845 de Qualcomm comprend par exemple un DSP Hexagon 685 dédié au traitement de l’IA dans les applications de caméra, vocales, XR et de jeu.

-

Amazon939.99€

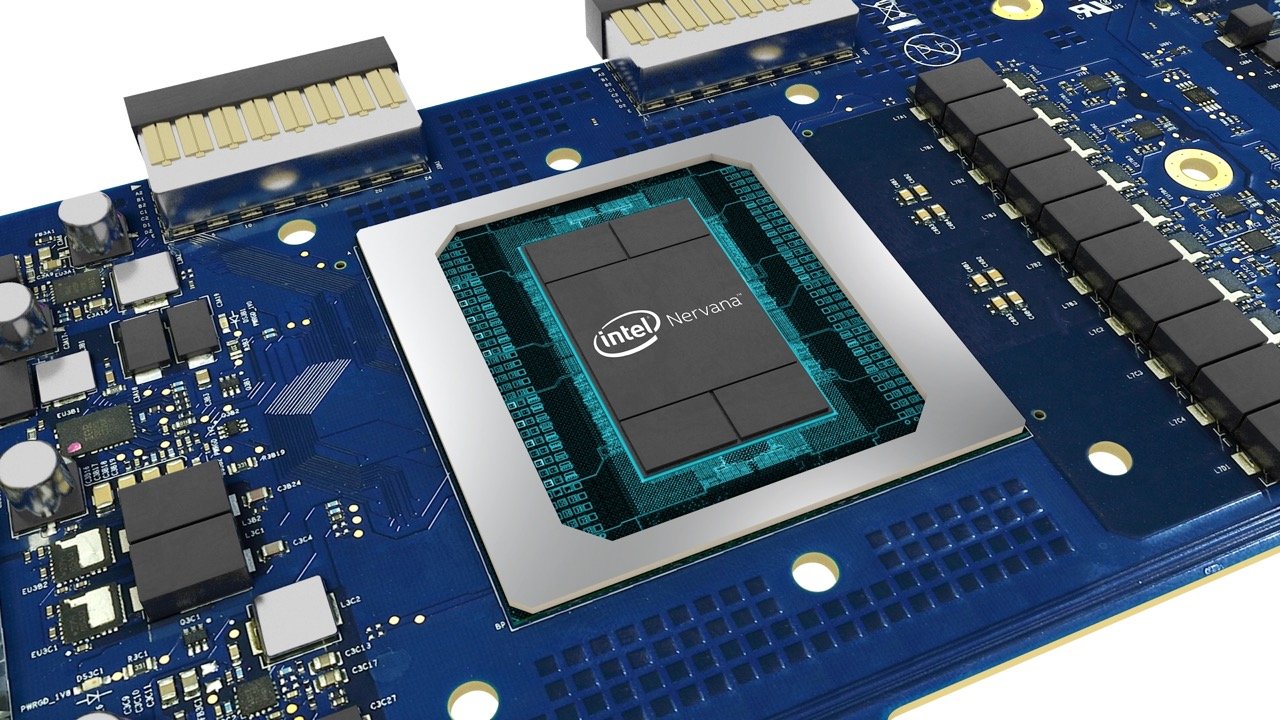

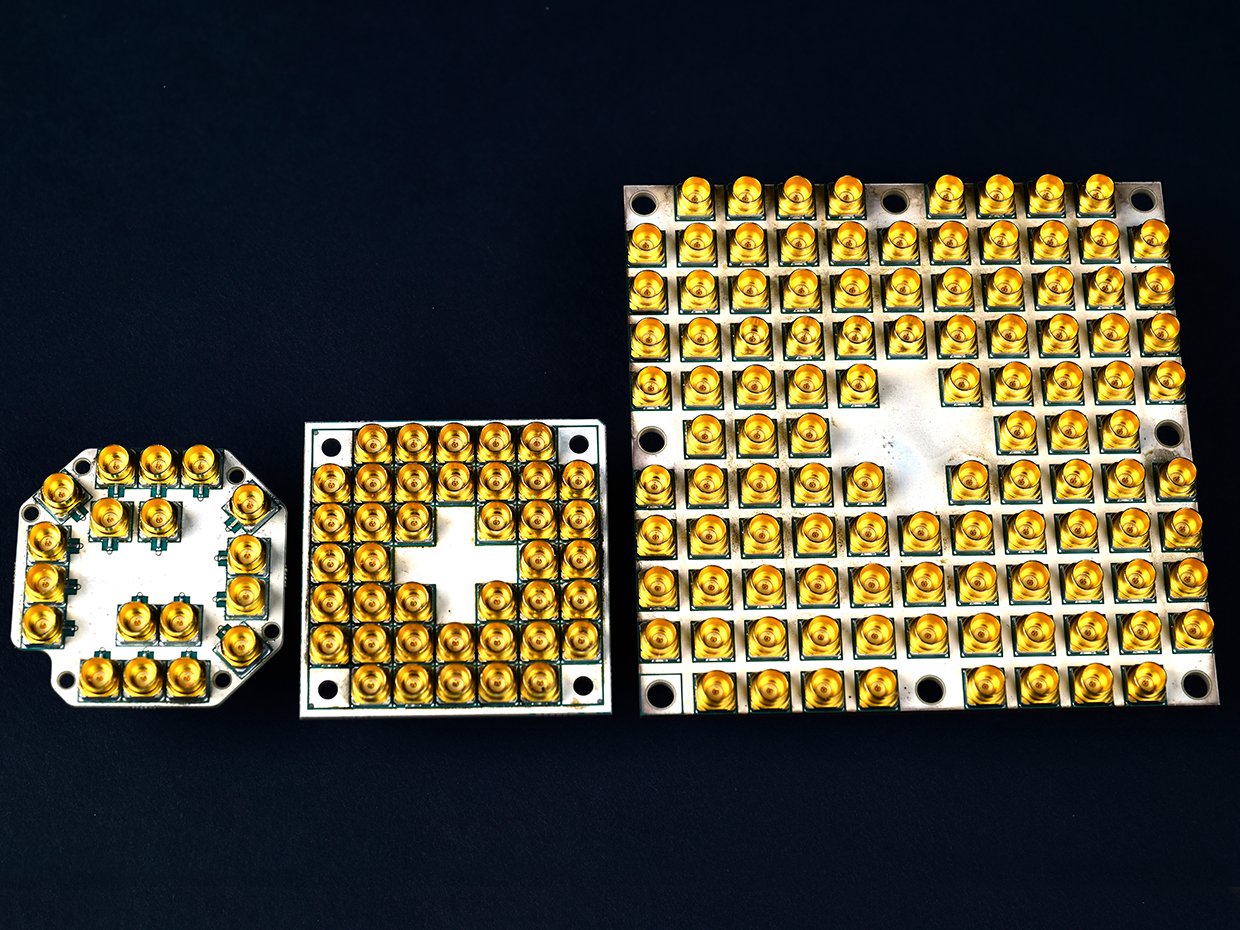

Les GPU sont de leur côté utilisés depuis longtemps déjà pour les tâches d’IA en raison de leurs énormes capacités en matière de calcul parallèle. Les progrès récents ont donc conduit au développement de GPU -qui n’ont plus de “graphiques” que le nom- spécifiquement optimisés pour les charges de travail d’IA. Ces produits, tels que les Tesla V100 de Nvidia et Radeon Instinct MI100 d’AMD, intègrent des fonctionnalités dédiées et une bande passante mémoire accrue pour accélérer les calculs d’IA.

Certains NPU sont conçus à l’aide d’architectures de flux de données, ce qui leur permet d’exécuter très efficacement des calculs d’IA. Ici, les données circulent dans un pipeline d’unités de traitement, chaque unité effectuant une opération spécifique. Cette approche minimise les transferts de données et optimise l’utilisation des ressources de calcul. L’IPU (Intelligence Processing Unit) Graphcore et le DPU (Dataflow Processing Unit) Wave Computing en sont des exemples.

Encore à l’état de recherche expérimentale, les NPU neuromorphiques s’inspirent enfin de la structure et de la fonction du cerveau humain. Ils utilisent des réseaux de neurones artificiels à impulsions qui imitent le comportement des neurones biologiques. Les NPU neuromorphiques sont particulièrement bien adaptées aux tâches telles que la reconnaissance de formes, l’apprentissage et la prise de décision en temps réel.

Super interessant! 🙂

Genre ta compris l’article ?

En gros, je crois que oui, ya des passages où il faut s’accrocher, mais dans l’ensemble ça semble bien vulgarisé pour mpn petit NPU neuromorphique ;). En complement, un intervenant sur France Info ce matin parlait plus du coté algorithmique de la chose genre chatmachin et grokbidule.

Bref, oui, c’est interessant, dangereux comme toute avancée potentiellement révolutionnaire, mais fascinant, avec derriere tout ça en plus des rivalités et autres histoires humaines.