Si des entreprises comme Auras Technology et Sun Max se frottent les mains, les consommateurs, eux, redoutent l’impact sur leur facture d’électricité.

Selon un rapport du DigiTimes, les fournisseurs taïwanais de composants de refroidissement anticipent d’excellentes ventes pour leurs produits au second semestre 2022. La raison : le lancement des cartes graphiques de nouvelle génération qui stimuleront la demande de refroidisseurs haute performance.

Le rapport du média taïwanais concerne deux entreprises, Auras Technology et Sun Max. La première rapporte avoir conçu des chambres à vapeur destinées aux cartes graphiques AMD et NVIDIA de prochaine génération (RX 7000 et RTX 4000). Or, le catalogue actuel de la société pour les chambres à vapeur se focalise surtout sur les solutions pour PC portables ; là, il est bien question d’avoir recours à cette méthode de refroidissement pour des cartes graphiques desktop.

De son côté, Sun Max, une société spécialisée dans les ventilateurs, déclare avoir dépensé plus de 2 millions de dollars en R&D et prévoit des revenus records grâce à la prochaine génération de GPU.

A lire aussi, les actualités les plus récentes au sujet de NVIDIA et ses technologies :

Une hausse des consommations…

À contre-courant de la tendance d’autres secteurs, celui du hardware grand public ne semble pas s’orienter vers la frugalité énergétique, au contraire. Concernant les cartes graphiques, il est question de monstrueux TBP allant jusqu’à 600 W pour les RTX 4000 ; d‘au moins 350 W voire 400 W pour la Radeon RX 7900 XT (contre 300 W pour la RX 6900 XT originale). Si de telles valeurs restent hypothétiques, la nouvelle norme d’alimentation ATX 3.0 (connecteur à 16 broches (12 + 4) appelé 12VHPWR) est clairement conçue pour fournir toujours plus de watts, jusqu’à 600 W par câble.

Du côté des processeurs, les puissances sont officielles pour les Ryzen 7000 : le TDP max s’envolera à 170 W, contre 105 W pour les Ryzen 5000. Pour les processeurs Intel Raptor Lake, les PBP (Processor Base Power) restent incertains pour le moment. L’augmentation du nombre de cœurs CPU devrait en principe se traduire par une hausse, mais les ingénieurs d’Intel auraient mis au point une technologie apparemment capable de réduire jusqu’à 25 % la consommation de ces processeurs.

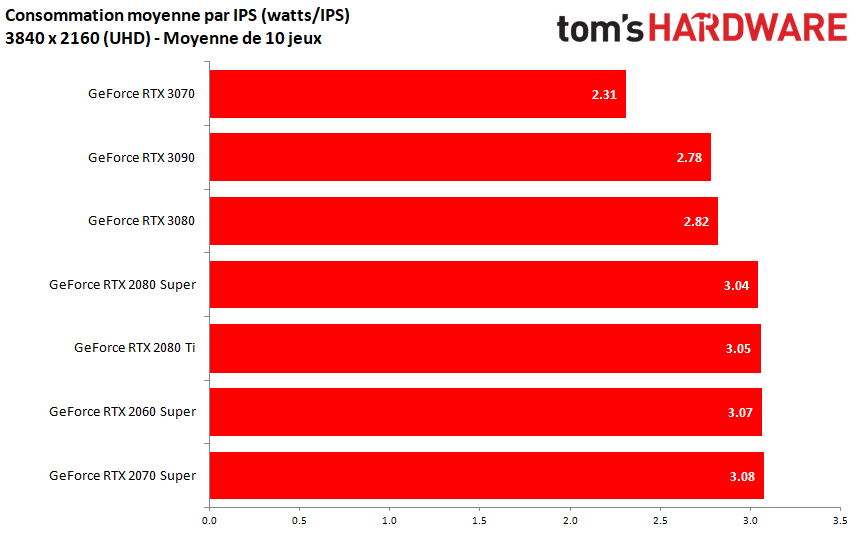

Signalons quand-même que confronter les consommations de plusieurs générations de GPU / CPU est toujours délicat. C’est un peu comme comparer la consommation d’un véhicule qui mettrait 1 heure à parcourir 60 km à celle d’un bolide capable, et surtout dont on exige / s’attend, à ce qu’il les couvre en 10 ou 15 mins.

Ainsi, dans l’absolu, pour les cartes graphiques surtout, la consommation maximale est indéniablement en hausse depuis plusieurs générations ; mais les tâches / jeux auxquelles elles sont confrontées sont aussi bien plus exigeants. De fait, pour finir par une belle lapalissade, les nouvelles générations sont – c’est la moindre des choses – toujours plus efficaces que les anciennes.

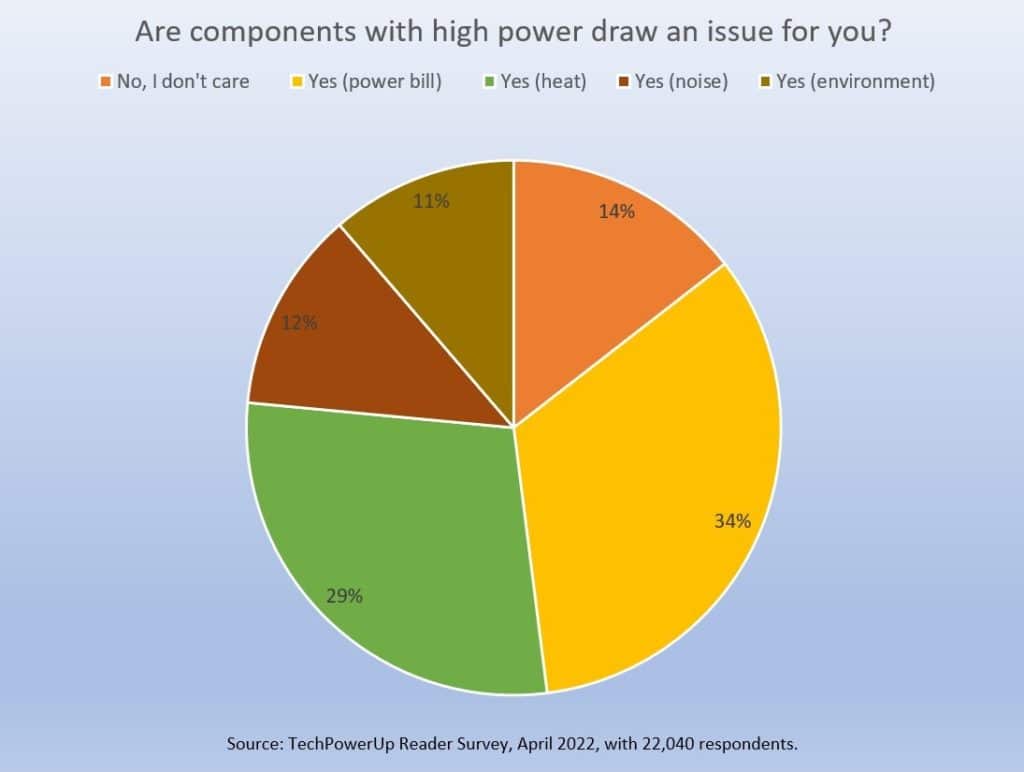

… qui préoccupe les gens

Face à ces hausses anticipées de consommation, le site TechPowerUp a interrogé ses lecteurs en leur soumettant la question suivante : “Les composants à forte consommation d’énergie sont-ils un problème pour vous ?”. Sur les 22 040 participants, une écrasante majorité, 85,5 %, se dit préoccupée. Pour environ un tiers des sondés, la principale appréhension porte sur leur facture d’électricité. Un petit tiers se soucie de l’excès de chaleur, 12 % du bruit supplémentaire que la dissipation de la chaleur génère, et enfin 11 % ont à cœur des considérations environnementales.

Pour étayer nos propos ci-dessus, l’article de notre confrère précise que dans leurs tests, la GeForce GTX 980 Ti, la carte graphique grand public la plus rapide de NVIDIA en 2015, ne consomme que 211 W dans les charges de travail de jeu de l’époque ; la GTX 1080 Ti, 231 W dans les jeux testés en 2017 ; la RTX 2080 Ti, 273 W pour les jeux de son époque (2018) ; tandis que la RTX 3090 Ti actuelle engloutit 445 W pour les jeux d’aujourd’hui. Seulement là encore, il faut garder à l’esprit que les jeux actuel sont bien plus exigeants que ceux de 2015 ; en outre, cette consommation pour la RTX 3090 Ti se constate en UHD.

Sources : TechPowerUp, Tom’s Hardware US, DigiTimes

Effectivement ça serait cohérent si on ne parlait pas de réduction de gravure !

Ce procédé est justement là pour contenir la consommation tout en augmentant les performances (loi de Moore etc..).

En revanche ce que l’on constate dernièrement c’est plus la course à l’échalote !

Le processus de gravure ne suis pas (la R&D quoi) et on empile bcp de plus de transistors dans les puces…

C’est bien ça qui fait exploser la consommation, la question c’est jusqu’ou va t on aller ?

A t on déjà construit une voiture avec 50 cylindres et qui consomme 200 litres aux 100 ?

Et bien c’est ce que l’on est en train de faire avec les CG et les CPU…

Heureusement que FSR et DLSS sont là mais ça ne freine pas la course à l’échalote.

Une moto avec 48 cylindres, ça passe 😀 ?

https://www.bikesrepublic.com/news/bulletin/meet-the-48-cylinder-whitelock-tinker-toy/

Mais si on achète un véhicule électrique alors la consommation de 600w d’un gpu est reléguée à l’état de consommation anodine voir négligeable… et comme notre état, très concerné par l’écologie, nous obligera sous quelques années à acquérir un véhicule électrique on en déduit que finalement ça ne doit pas être un problème cette conso des gpu.

Ironie à part, la consommation d’une nouvelle génération de cpu ou gpu ne devrait jamais être supérieur à la précédente, sinon ça veut dire que la copie n’est pas bonne.

De ce que j’ai vu l’explosion de la conso des dernières générations (20X0 et particulièrement 30X0 et celle qui vient 40X0) vient tout simplement du besoin de domination de Nvidia.

Jensen Huang veut pouvoir se vanter de gains incroyables à chaque génération, mais il n’y a pas de gains incroyables réels (en archi, en gravure) ces dernières années, juste des gains limités en gravure, donc il fait exploser la conso.

Les dernières cartes Nvidia et AMD ont la même efficacité, seule l’explosion de la conso initiée par Nvidia les met devant en performances brutes.

Je relativise

Depuis le 27 avril les stats steam me donne que j’ai joué 88H sur Death Stranding+ 30H sur Lord of the Fallen

Disons pour arrondir que je tourne à 100H par mois

Si ma carte graphique consomme 100W de plus que l’ancienne, cela fait 100×0.1 soit 10KWh consommé en +

Même à quasi 0.2 euros/KWh cela me ferait que dans les 2euros de + par mois

Dis autrement, environ 2€ par tranche de 100W de +, pour 100H de jeu, car les 100H de jeu /mois faut déjà les faire (je ne les fais surement pas tous les mois).

Je limite souvent mes FPS donc ma carte graphique n’est pas forcement a fond suivant le jeu

Coté CPU c’est un autre truc, on est très très loin de manger tous les cœurs a 100% en jeu, l’efficacité augmente, donc a mon avis on mange moins de watts de ce coté là par rapport a la génération de cpu d’avant( en jeu).

Et si on formait les programmeur pour qu’ils pissent un code bien plus optimisé? A l’époque des console 8 ou 16bit qui avec un transfo de quelques watt on avait droit au maximum de la machine. Aujourd’hui toujours plus, rien d’optimisé mais qui aura besoin de 12go de mémoire pour jouer? Vous savez c’est comme quand on est bordelique, quand il y a de la place pour s’étaler, il y aura toujours plus de bordel.

Le seul problème des conso c’est la chaleur. Le coût et l’écologie c’est que dalle du moment que l’électricité est en majorité décarbonée (pas de gaz ni de charbon), ce qui est le cas en France.

Sauf que le monde, c’est pas uniquement la France.

Après Intel et une nouvelle carte mère a chaque génération, les cartes graphiques avec une nouvelle alim encore plus puissante à chaque génération.

Le problème, c’est que depuis la gtx970, il n’y a plus vraiment de progrès.

Dans les années 90 et 2000, à chaque génération nous avions: 3x plus de performance, même conso ou inférieure, prix similaire (la référence moyen de gamme se faisait remplacer par la nouvelle référence moyen de gamme, à peu près dans le même segment de prix).

Là, que ce soit cpu ou gpu, où est le progrès, quand la nouvelle génération est 1.5x plus performante, 1.5x (ou 2x) plus énergivore, et 1.5 (ou 2x) plus chère? Comparez: gtx970 à 350 euros, puis gtx1050, puis rtx2070, rtx3070…

maintenant le milieu de gamme n’est plus à 300 euros, mais à 600. .. et pas 150w mais 400w

C’était quand même pas autant dans mes souvenirs. Par exemple la GeForce 2 GTS n’était “”que” 40% plus rapide qu’une GeForce 256. J’ai pas souvenir d’avoir vu du x3 (+200%) en situation réelle entre deux générations successives…