Plus de 500 FPS en QHD Ultra dans Overwatch 2 : est-ce vraiment utile ?

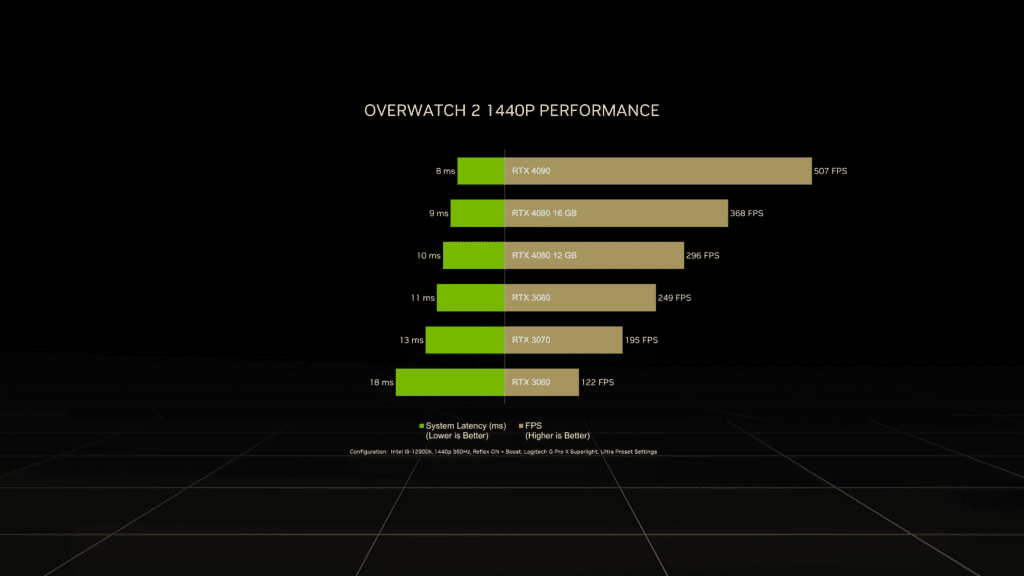

Entre les attaques DDOS, les bugs et les serveurs surchargés, Overwatch 2 a vécu hier soir un lancement très mouvementé (et les effets se font encore sentir à l’heure où ces lignes sont écrites). En attendant que vous puissiez mettre vos talents de visée à rude épreuve, NVIDIA a partagé les performances de sa GeForce RTX 4090 dans ce jeu : la nouvelle carte graphique très haut de gamme y dépasse la barre des 500 FPS, le tout en QHD et en Ultra !

- A lire aussi : NVIDIA publie un pilote GeForce Game Ready pour Overwatch 2

La barre des 500 FPS franchie dans Overwatch 2 en QHD Ultra

Même si cette carte graphique est plus orientée “créateurs de contenus” vu son tarif plutôt que “gaming pur” (sauf si vous avez les moyens), la performance reste intéressante. Il est d’ailleurs amusant que Blizzard ait justement repoussé la limite maximale du framerate dans le moteur 3D du jeu de 400 FPS à 600 FPS. La différence avec les RTX 4080 12 Go et 16 Go aurait été moins visible, ces deux cartes atteignant respectivement 296 FPS et 368 FPS dans les mêmes conditions.

On regrettera toutefois que NVIDIA n’ait pas intégré sur ce même graphique les résultats obtenus par d’autres modèles de cartes entre la RTX 3080 et la RTX 4080 12Go, dans des conditions de test identiques. Au passage, la configuration recommandée par Blizzard pour jouer à 60 FPS en Full HD à Overwatch 2 se contente d’une GeForce RTX 1060 ou d’une Radeon R9 380…

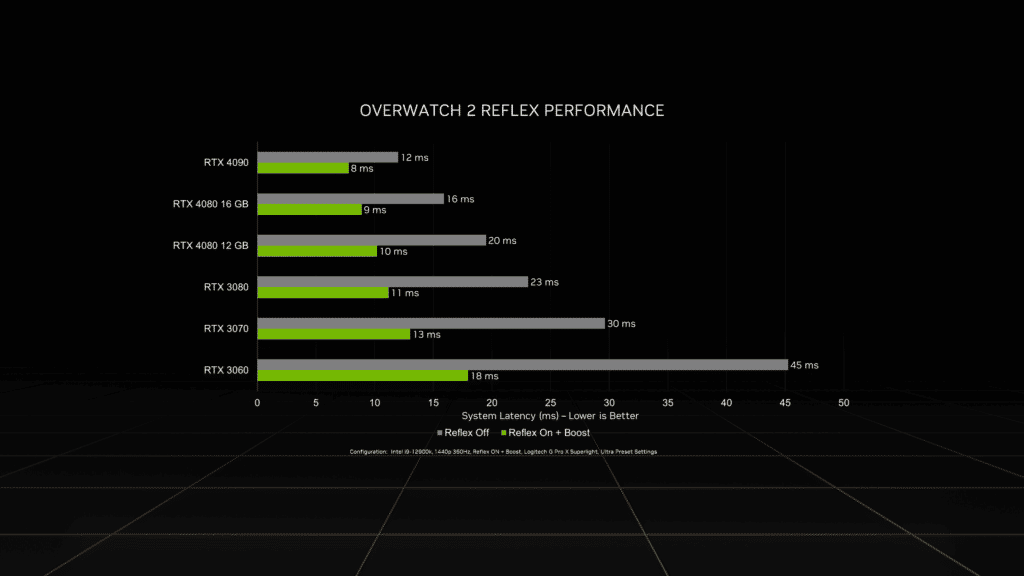

En activant les modes Reflex et Boost, NVIDIA indique également que la latence du système atteint en moyenne seulement 8 ms, contre 12 ms sans Reflex (ce qui est déjà fort honorable). C’est d’ailleurs sur cet aspect plutôt que sur les FPS que NVIDIA communique. Après tout, qui a vraiment besoin de 500 images par seconde pour jouer ? En revanche, améliorer la réactivité de l’ensemble du système peut parfois faire la différence entre la vie et la mort dans un FPS, même si bien entendu le maillon le plus lent restera souvent l’interface chaise-machine.

ça comprend “toutes” les latences, du système graphique au reste du PC en passant par la souris :

C’est pas du marketing là, c’est juste le pipeline de rendu standard…

“Qui a besoin de 500 FPS ?”

Et bien détrompez vous. Je je sais pas pourquoi c’est si peu connu dans le gaming ( alors que beaucoup de gamers s’auto proclament informaticiens ), mais il y a un calcul super simple à connaître : 1000 / FPS = input lag en ms.

Quelqu’un qui a 500 FPS aura donc 2ms d’input lag, quand quelqu’un qui a 60 fps aura 18ms d’input lag. C’est bien pour ça qu’il faut jouer en FPS illimité sur les jeux compétitifs même avec un écran 144/240Hz.

Certes désactiver le V-sync peut provoquer un peu de tearing, mais à haut niveau de compétition, il vaut mieux avoir les FPS débloqués pour avoir l’input lag le plus petit qu’il soit.

Et vous ajoutez à cela NVIDIA Reflex pour réduire au max les latences du reste du système, et vous obtenez une latence minime.

“En revanche, améliorer la réactivité de l’ensemble du système peut parfois faire la différence entre la vie et la mort dans un FPS, même si bien entendu le maillon le plus lent restera souvent l’interface chaise-machine.”

Désolé mais c’est plus que négligeable (même si plus on a de fps implique une plus grande vitesse de génération d’image et un temps de retard d’affichage plus constant), si tu forces la carte graphique à générer moins d’images elle sera toujours aussi rapide pour son temps de génération d’une seule image, (elle va juste attendre entre chaque image à générer)

C’est avoir un écran 240hz qui affiche 60hz qui est intéressant, parce qu’il affichera très rapidement la frame quelque soit le moment ou elle est générée, sans avoir à attendre 16ms.

Quand on a un carte puissante il faut limiter les fps max pour diviser la consommation électrique. L’input lag de la cg sera plus faible qu’un cg moins puissante. Donc oui avoir une cg très puissante est toujours plus avantageux qu’une cg moins puissante.

Il doit bien y avoir des gens qui ont fait joujou avec des mesures.

Reflex est probablement plus utile même que plus de fps.

Il ne faut pas se leurre le truc le plus critique en terme d’input lag gaming actuel c’est bien l’écran + sa rémanence. Certains tâtent avec les millisecondes, mais ils sont rare. Il y a peu de site web qui font des vrais mesures.

Pour gratter des perf il faut avoir un écran avec un pwm à l’affichage pour faire “clignoter” l’image et plus rapidement faire réagir notre rétine, qui est pas si rapide pour capter la lumière :p

Après on chipote mais le nombre de teubés qui jouent à 30fps depuis des dizaines d’années sur console, ça fait assez pitié 😀 C’est encore le cas en 2022.

Oui alors mais non. Il y a des stats récoltés par nVidia via geForce experience à ce niveau et les gamers avec un imput lag plus réduit et un meilleur matos performent mieux que les autres coincés en 60 fps. Stop le bs, merci.