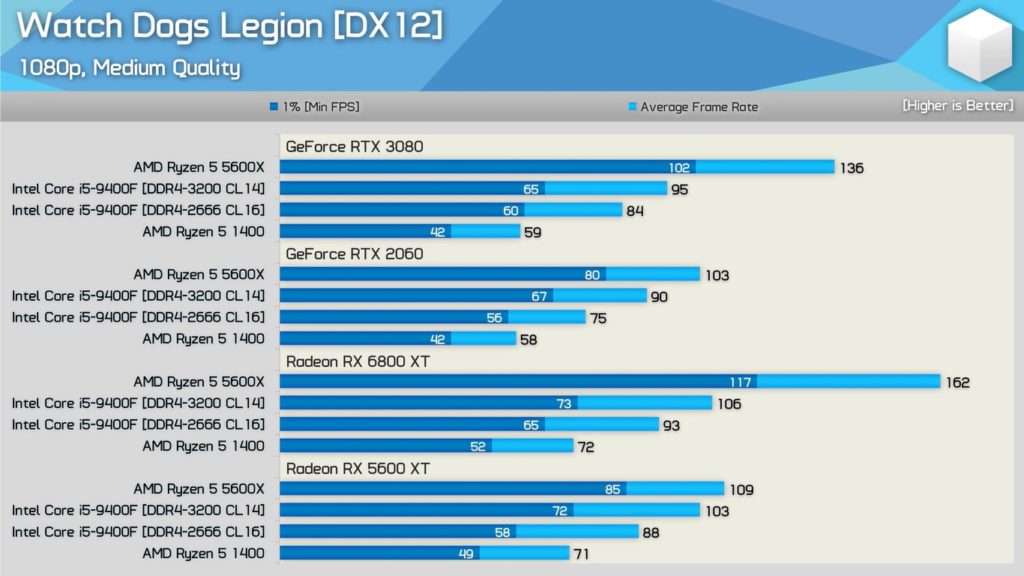

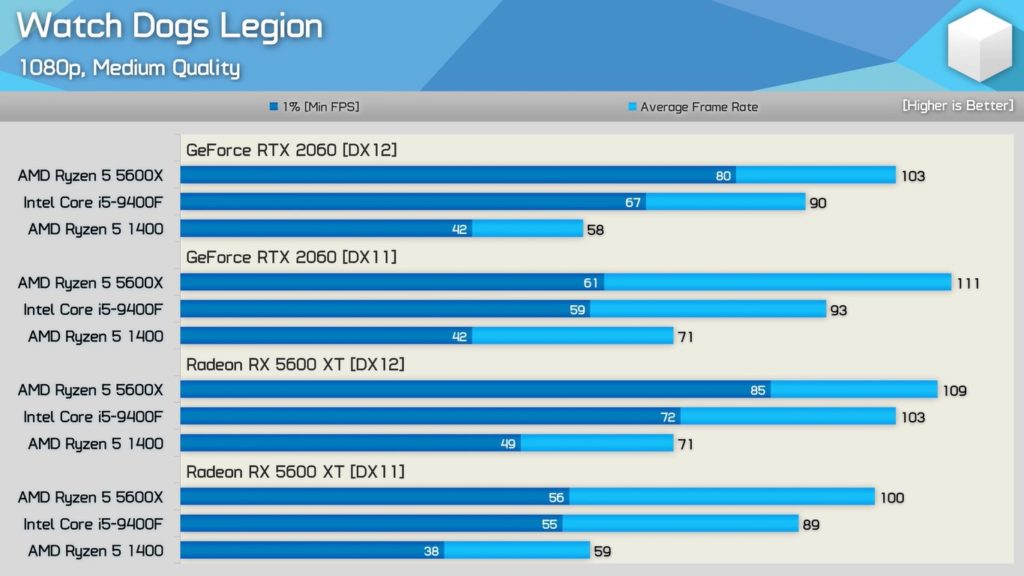

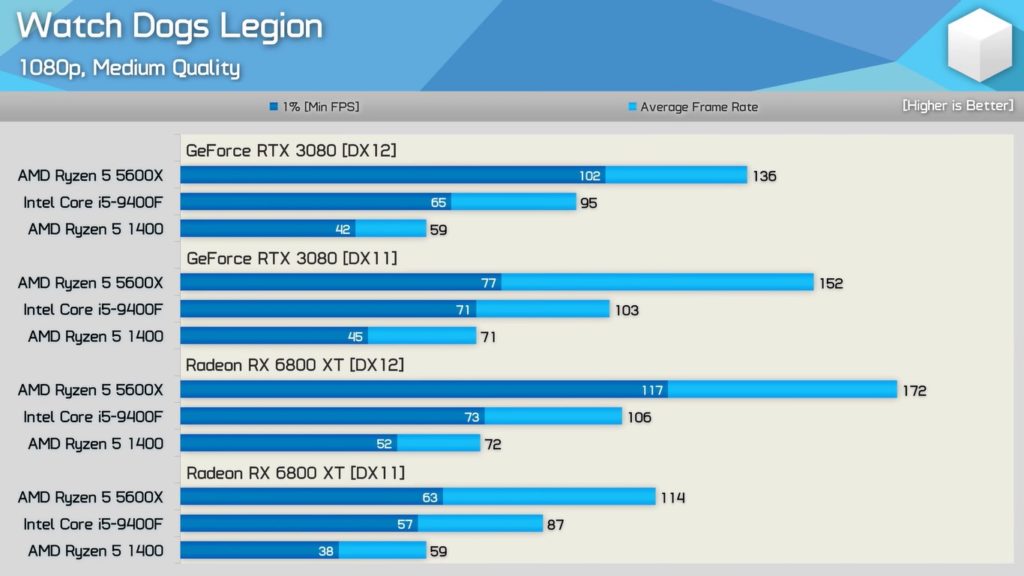

Associée à un Ryzen 5 1400, une Radeon RX 5600 XT offre un framerate moyen supérieur à une RTX 3080 sur Watch Dogs Legion ou Cyberpunk 2077.

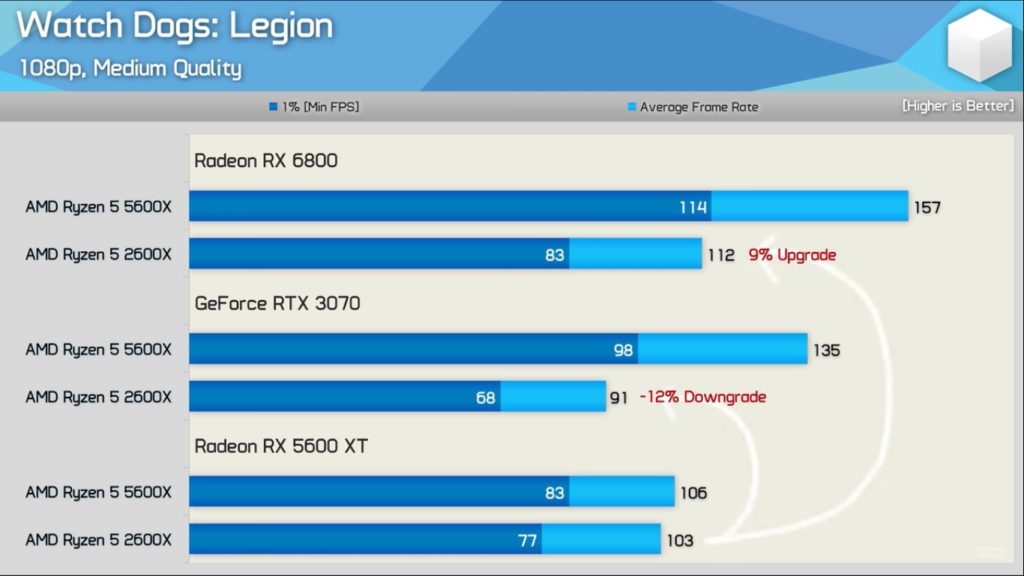

Récemment, Hardware Unboxed a publié une vidéo dans laquelle il mettait en évidence un écart de performances conséquent entre les cartes graphiques NVIDIA et AMD sous DirectX 12. Il démontrait que les RTX 3000/2000 de NVIDIA sont moins à l’aise avec des CPU anciens que ne le sont les RX 6000/5000 d’AMD. Sur un jeu comme Watch Dogs Legion par exemple, passer d’une Radeon RX 5600 XT à une Radeon RX 6800 avec un processeur Ryzen 5 2600X octroie un gain du nombre moyen d’images par seconde de 9 % ; à l’inverse, remplacer une Radeon RX 5600 XT au profit d’une RTX 3070 induirait une baisse du framerate d’environ 12 %. Pourtant, avec un processeur plus performant, en l’occurrence le Ryzen 5 5600X, la différence de puissance entre une Radeon RX 5600 XT et une RTX 3070 se matérialise bien par un net gain d’images par seconde.

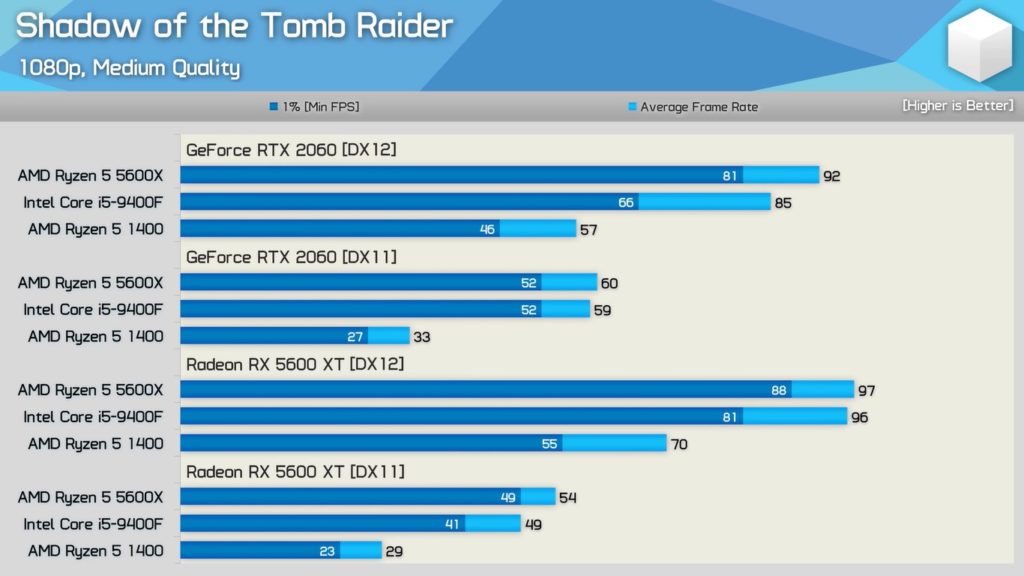

Hardware Unboxed a poursuivi ses investigations dans une second vidéo. Il estime qu’il y a un souci d’optimisation sous l’API DirectX 12 avec les GPU de NVIDIA ; à l’évidence, sous DirectX 12, les pilotes NVIDIA sollicitent bien plus le CPU que ceux d’AMD. Logiquement, un processeur un peu ancien peut donc vite représenter le facteur limitant et brider la carte graphique.

DirectX 12 plus exigeant pour le CPU avec les GPU NVIDIA

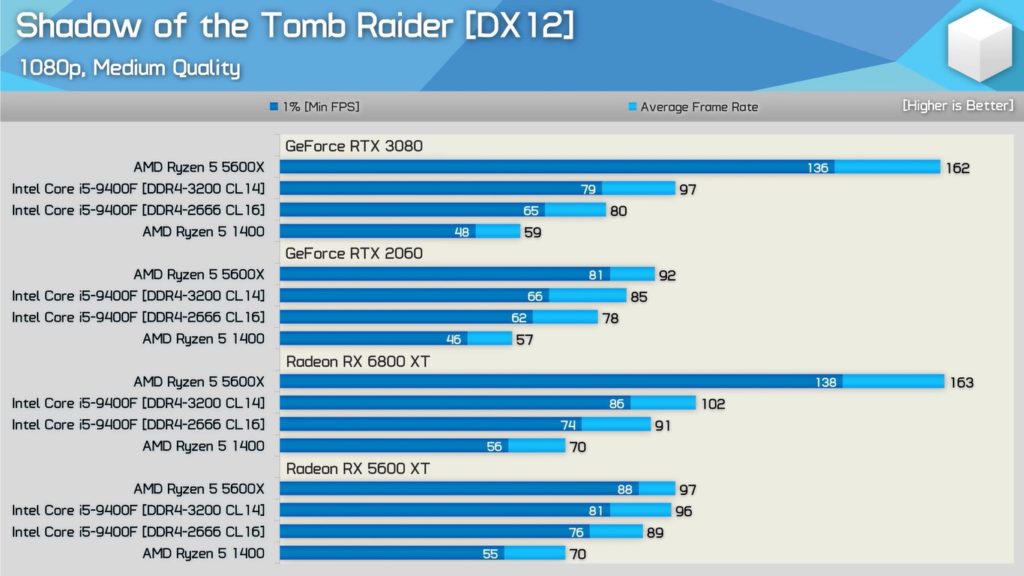

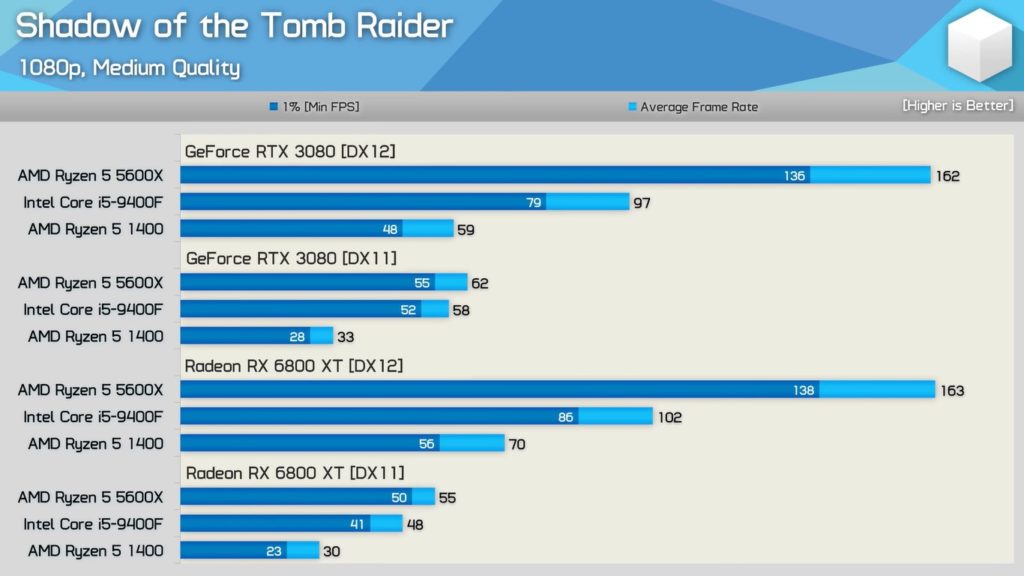

Sur Watch Dogs Legion, sous DirectX 12, un Ryzen 5 1400 associé à une Radeon RX 5600 XT permet de jouer dans de meilleures conditions que lorsqu’il collabore avec une RTX 3080, pourtant bien plus puissante. Même constat sur Shadow of The Tomb Raider.

Sous DirectX 11, le nombre d’images par seconde moyen en 1080p redevient corrélé à la puissance brute de chaque carte, souvent à l’avantage de NVIDIA d’ailleurs. En outre, la hiérarchie entre les GPU sous DirectX 12 avec un processeur puissant comme le Ryzen 5 5600X retrouve une structure plus cohérente.

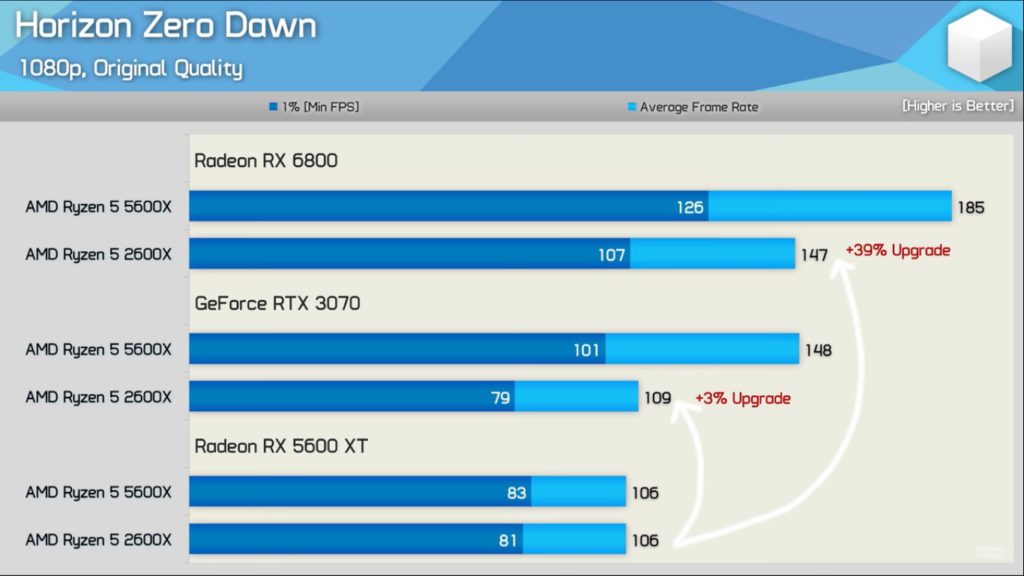

Outre les deux jeux susmentionnés, Hardware Unboxed étudie cette manifestation sur Horizon Zero Dawn, Death Stranding, Rainbow Six Siege Cyberpunk 2077 et Assassin’s Creed Valhalla.

Cette tendance est à prendre en considération si vous possédez un vieux CPU et que vous comptez changer de carte graphique dans les prochains mois. En l’état, sous DirectX 12, les GPU d’AMD sont à privilégier ; c’est l’inverse sous DirectX 11. Il sera intéressant de voir si NVIDIA réagit et tente de pallier ce phénomène via de futurs pilotes.

leur driver doit être mal multithreadé, il ne faut pas chercher plus loin.

Ou peut-être les radeon sont meilleurs en Dx12 😉 tout simplement.

pas étonnant que depuis plusieurs années, les jeux directX 12 ont tous des soucis d’opti. La faute à qui microsoft pour avoir une truc trop complexe à implémenté par rapport à du vulkan par exemple ou la faute aux devs qui ne font les choses correctement (ou apporte une compatibilité limitée à la volée).

Pour avoir été cpu limited depuis plusieurs années avec une GTX 1080, le fait que l’on constate une diff de performance si le gpu et le cpu ne sont pas équilibré me parait normal.

Bien sûr, mais ce que met en évidence Hardware Unboxed, c’es la disparité entre une RTX 3080 et un Radeon RX 6800 XT sous DirectX 12 avec un CPU “ancien”. Sur Shadow of The Tomb Raider par exemple, on voit bien qu’avec un Ryzen 5 5600X, les deux cartes offrent un framerate équivalent ; en revanche, avec un Ryzen 5 1600, la RTX 3080 est nettement en dessous. Dans les deux cas, le CPU devient le facteur limitant ; mais ce phénomène semble nettement plus marqué avec les RTX de NVIDIA qu’avec les Radeon d’AMD.