Après le format SXM4, l’architecture Ampere séduit les serveurs et datacenters disposant d’interfaces plus conventionnelles

Nous avons déjà évoqué les impressionnantes caractéristiques du GPU A100 de génération Ampere, destiné aux datacenters et à la recherche en IA. Descendant direct des GPU Tesla V100, il totalise la bagatelle de 54,2 milliards de transistors, sur un die de 826 mm² – soit 2,5 fois plus de transistors, sur une surface à peine plus large de 1,3% par rapport à la génération précédente. De telles caractéristiques sont évidemment réservées aux supercalculateurs et aux centres de recherche en intelligence artificielle. Gravé en 7 nm, le GPU offrirait, selon Nvidia, des performances vingt fois supérieures à celles d’une carte Tesla V100, en calcul simple précision (FP32).

Nvidia annonce 90% des performances du SXM4, au format PCIe 4

Plusieurs constructeurs l’ont déjà intégré à des supercalculateurs ou des serveurs hautes performances, comme Atos avec son BullSequana X2415 ou encore Asus avec l’ESC4000A-E10 ou Gigabyte avec le G292-Z40. Au total, plus de cinquante références devraient alimenter le marché d’ici la fin de l’année 2020. “L’adoption des GPU Nvidia A100 dans les offres des principaux constructeurs de serveurs dépasse tout ce que nous avons vu auparavant, déclare Ian Buck, le vice-président et directeur général de la branche Accelerated Computing. La vaste gamme de serveurs Nvidia A100 provenant de nos partenaires garantit que les clients peuvent choisir les meilleures options pour accélérer leurs datacenters pour une utilisation élevée et un faible coût”.

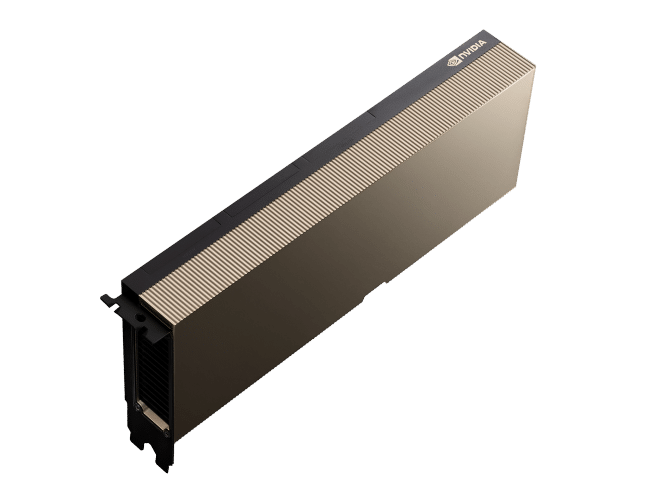

Mais si la première occurrence de l’A100 se déclinait autour du format SXM4 (carte mezzanine), Nvidia décide aujourd’hui de la proposer en PCIe 4.0. Une solution plus simple et “abordable”, autour d’un format plus propice pour les serveurs classiques, et toujours pour une utilisation scientifique – séchez vos larmes : l’architecture Ampere ne se décline pas encore à un usage gaming.

Cette variante présente toutefois un coût : le passage au PCIe 4.0 réduit le TDP à 250 W en lieu et place des 400 W de la version SXM, ce qui se traduirait par une baisse de 10% des performances selon Nvidia, dans les tâches mono-GPU. Un décalage que l’on peut expliquer par la marge limitée du PCIe par rapport au SXM, en matière d’alimentation et de refroidissement. Autre changement, la carte au format PCIe n’exploite la technologie NVLink, qui assure la communication inter-GPU, qu’entre deux cartes à la fois. On dispose malgré tout de trois connecteurs NVLink, ce qui signifie que les échanges s’opèrent à 300 Go/s pour chaque “couple” de carte, soit un débit trois fois supérieur à celui des cartes V100 au format PCIe de génération précédente.

Aucun tarif ou date de lancement n’ont été annoncés. Gageons que dans la série des “50 serveurs qui seront équipés d’une solution A100 dans l’année”, selon les propres termes de Nvidia, bon nombre d’entre eux feront le choix de cette version PCIe 4.0, entièrement refroidie de manière passive.