Grâce à son outil AutoDMP (Automated DREAMPlace-based Macro Placement), NVIDIA, comme Synopsis, utilise l’IA pour concevoir des puces. Le résultat est plus rapide et tout aussi qualitatif qu’avec les anciennes méthodes, selon l’entreprise.

Récemment, Micheal Kagan, directeur de la technologie de NVIDIA, a expliqué que l’IA était promis à un bel avenir en plus d’être bénéfique à l’humanité – contrairement aux crypto-monnaies, pour recontextualiser les propos. En matière de conception de puces, Synopsis a déjà expliqué comment son outil DSO.ai (Design Space Optimization AI) aidait les concepteurs, réduisait « les ressources d’ingénierie » notamment grâce à la capacité des algorithmes à explorer de nombreuses conceptions différentes en un temps record, et avait déjà abouti à 100 réalisations commerciales. Dans un article publié en début de semaine, signé Anthony Agnesina et Mark Ren (deux membres du NVIDIA Research), exposent une approche similaire pour l’AutoDMP (Automated DREAMPlace-based Macro Placement) de la société pour laquelle ils travaillent.

Les auteurs expliquent comment l’intelligence artificielle et l’apprentissage automatique accélérés par GPU changent la donne en matière la conception des puces au sein d’un système d’automatisation de la conception électronique (EDA). Selon eux, ces technologies permettent « d’accélérer par plus de 30 fois » le processus de positionnement.

À lire > Les postures de plusieurs personnes présentes dans une pièce déterminées grâce au Wi-Fi

Une conception plus rapide et tout autant qualitative

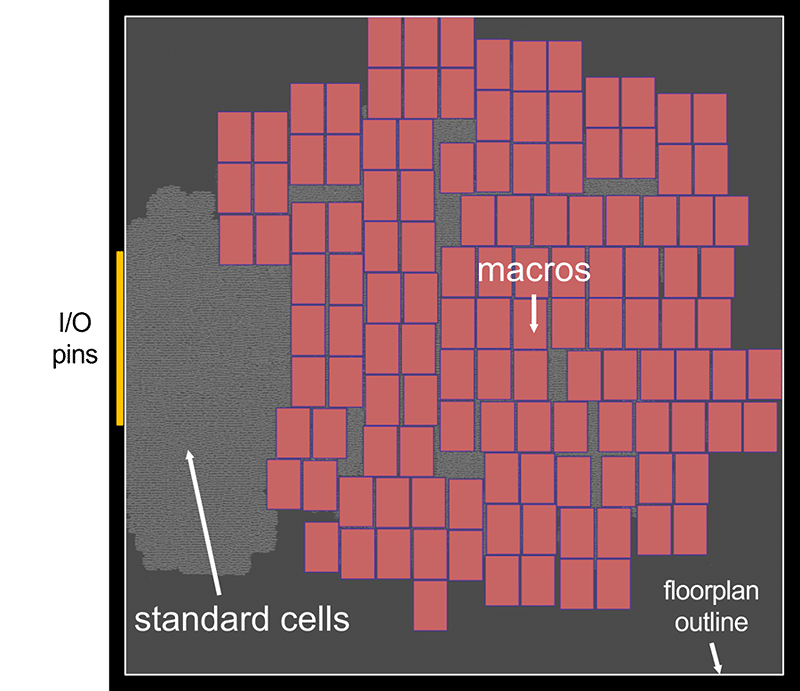

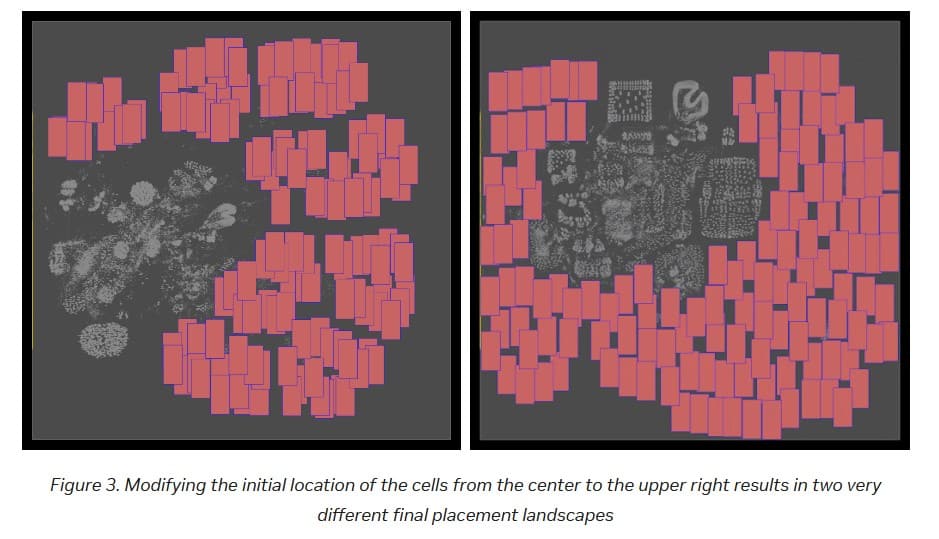

Vous l’imaginez, ce que les auteurs appellent le macro-placement a un impact significatif, puisqu’il « affecte directement de nombreux paramètres de conception, tels que la surface et la consommation d’énergie ». Anthony Agnesina et Mark Ren expliquent que le placeur analytique open-source DREAMPlace est utilisé « comme moteur de placement ». Concrètement, il « formule le problème de placement sous la forme d’un problème d’optimisation de la longueur des fils sous une contrainte de densité de placement et le résout numériquement » ; plus précisément,« DREAMPlace calcule numériquement la longueur des fils et les gradients de densité à l’aide d’algorithmes accélérés par le GPU grâce au cadre PyTorch ». Le but est bien sûr d’accélérer et d’optimiser le processus, fastidieux, de recherche de placements optimaux pour les éléments constitutifs des processeurs.

NVIDIA donne l’exemple de la recherche d’une disposition optimale pour un CPU 256 cœurs RISC-V, représentant 2,7 millions de cellules standards et 320 macros de mémoire. Il faut seulement 3,5 heures à AutoDMP pour trouver une disposition optimale sur une seule station NVIDIA DGX A100.

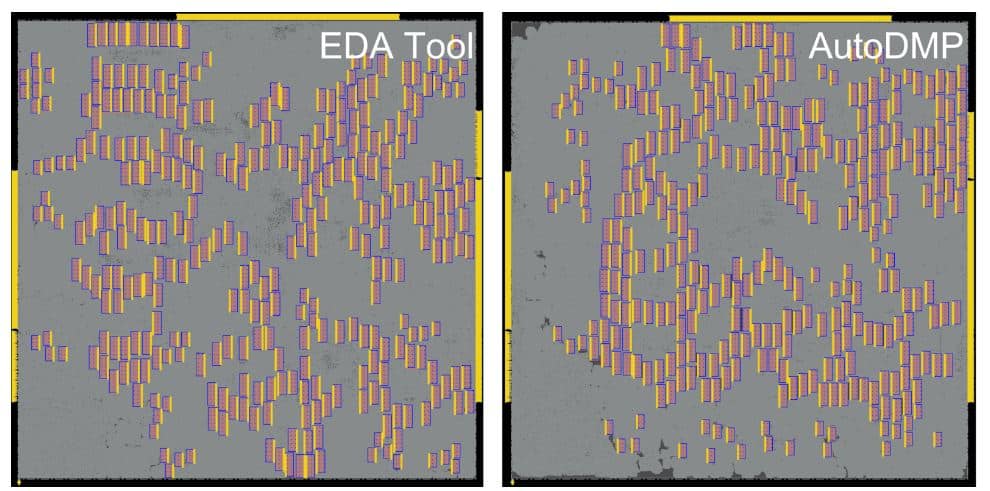

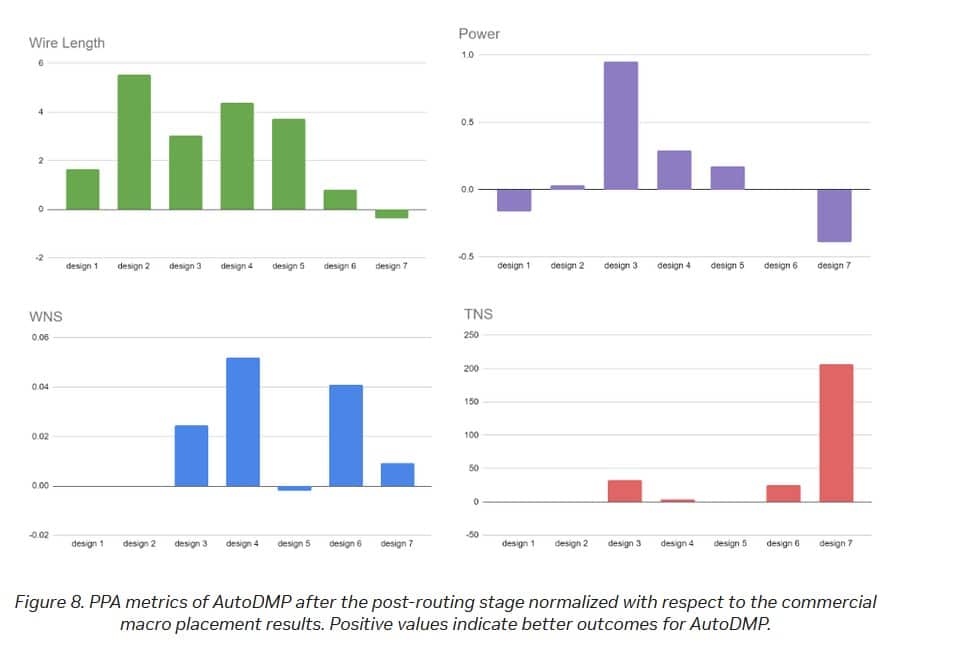

Les avantages de l’utilisation d’AutoDMP ne se limitent pas à la vitesse de conception selon les auteurs ; les gains sont également qualitatifs. Ils donnent l’exemple de sept conceptions alternatives réalisées pour une puce de test dans lesquelles « la plupart des conceptions […] sont égales ou supérieures à celles issues du flux commercial ».

A lire aussi, les actualités les plus récentes au sujet de NVIDIA et ses technologies :

- Nvidia sauve la mise avec un nouveau driver qui corrige les problèmes des RTX 5090

- Le prix des cartes graphiques risque d’augmenter drastiquement, merci Trump

- Les RTX 5060 et 5060 Ti repoussées, voici leur nouvelle date de sortie

- Vous voulez une RTX 5080/90 FE à bon prix ? Nvidia vous dit comment faire

cuLitho, la nouvelle bibliothèque logicielle pour la lithographie computationnelle de NVIDIA

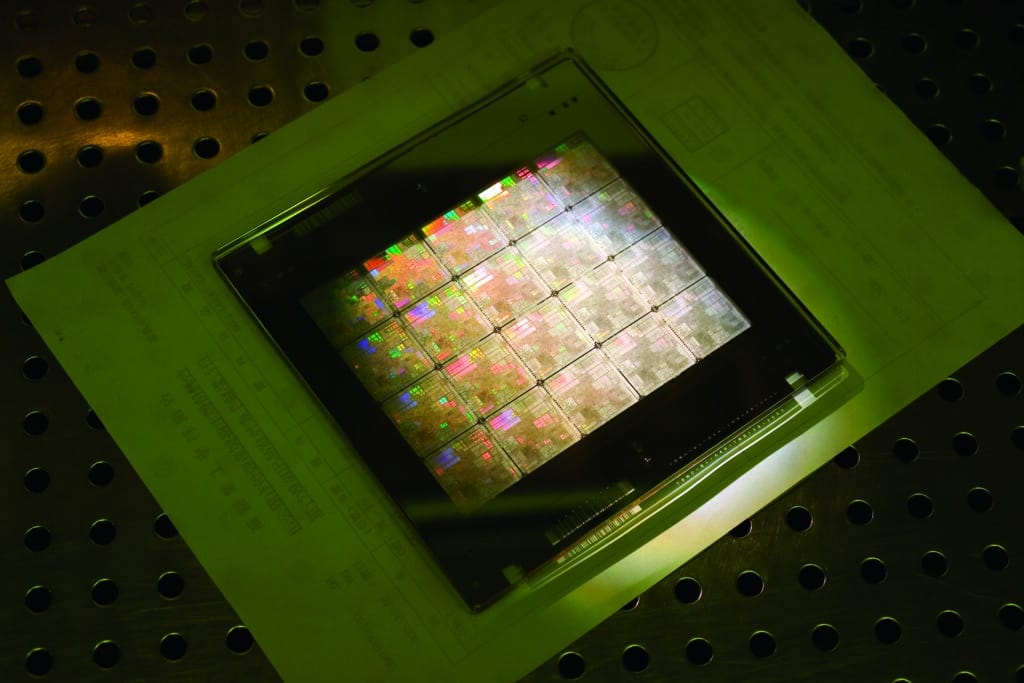

Dans un autre registre, mais en toujours en lien avec la conception de puces, sachez qu’à l’occasion de la GTC 2023, NVIDIA a présenté sa nouvelle bibliothèque logicielle cuLitho, censée accélérer la lithographie computationnelle.

NVIDIA affirme que sa nouvelle approche permet à 500 systèmes DGX H100 dotés de 4 000 GPU Hopper d’effectuer la même quantité de travail que 40 000 CPU (modèles non précisés), mais de le faire 40 fois plus rapidement et en consommant 9 fois moins d’énergie. Cette réduction de la charge de travail permettrait de réduire le temps d’élaboration d’un masque photographique de plusieurs semaines à huit heures.

NVIDIA rapporte que sa bibliothèque logicielle cuLitho est en cours d’intégration par TSMC, ainsi que par Synopsys. L’équipementier ASML prévoit également de l’utiliser.

Sources : NVIDIA (AutoDMP), NVIDIA (cuLitho)

Personnellement je n’en doute pas et quelque part t’en mieux pour eux et pour les autres. Car oui il n’y pas qu’nvidia qui a eu l’intelligence d’invertir la dedans.

En 2035 les chômeurs remercierons l’inventeur de l’ia…

On y va les pied en avant..

Si ça peut permettre de les vendre 30 fois plus cher, ça me semble une bonne occasion d’en faire de la pub.

Aucune incidence sur le prix en tout cas, sinon à la hausse lol

Et le jour où l’IA n’arrive pas à faire le taf pour n’importe quelle raison … qui sera en mesure de prendre le stylo ?

A force, on ne sait plus faire le taf, on sait qu’appuyer sur un bouton : Idiocracy !

ouais les prix aussi augmentent plus vite qu’avant. IA ou pas IA