- Introduction

- Un nouveau GPU basé sur l’existant

- Cayman : un Cypress amélioré

- AMD reconnaît l’importance de la géométrie

- Antialiasing, Eyefinity et accélération vidéo

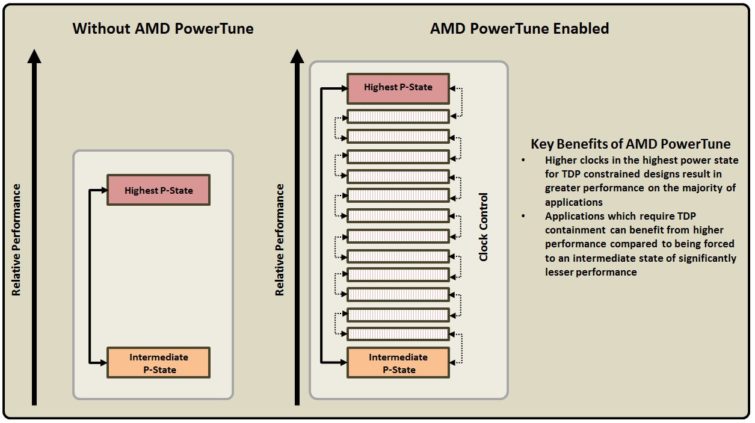

- PowerTune : plus qu’un nouvel overclocking

- Les cartes

- Configuration de test et benchmarks

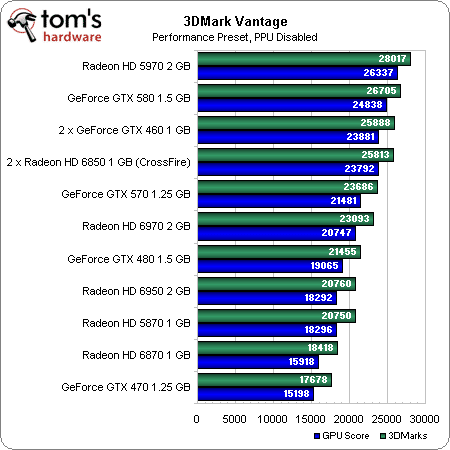

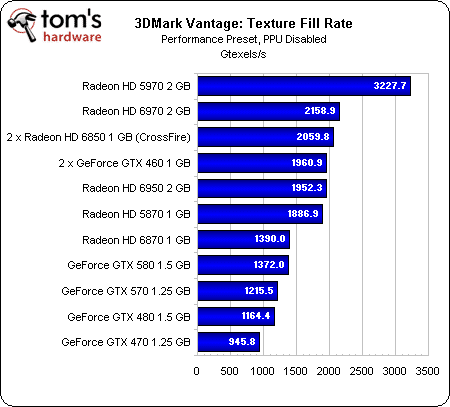

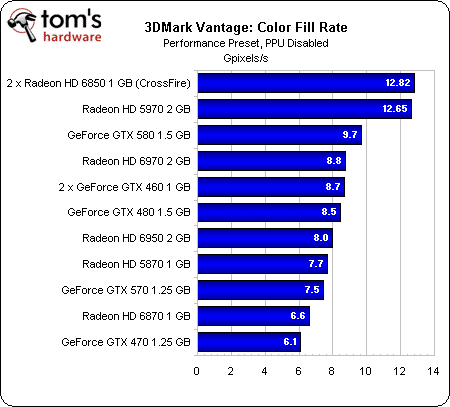

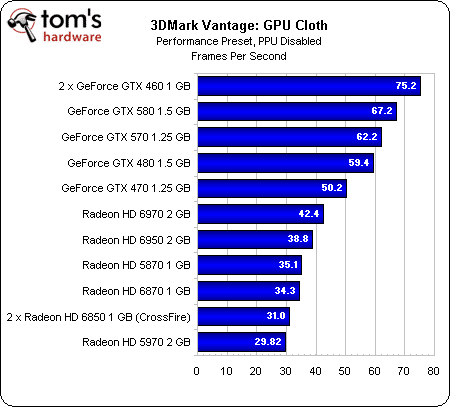

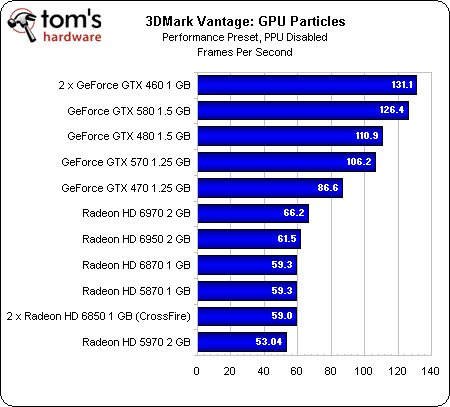

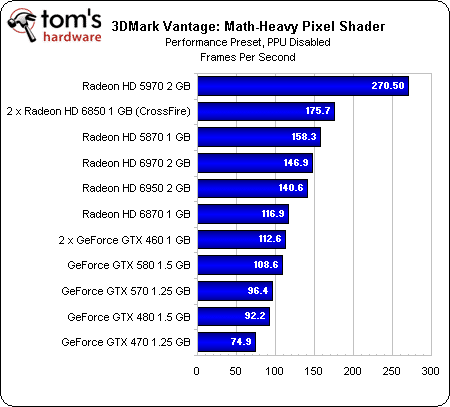

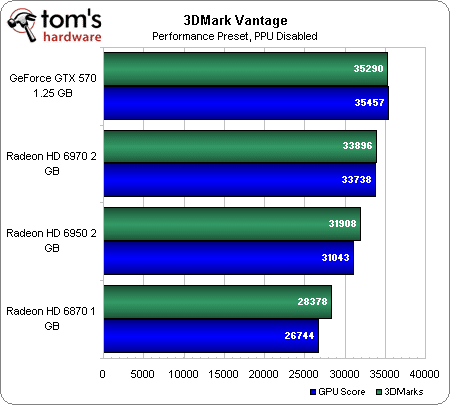

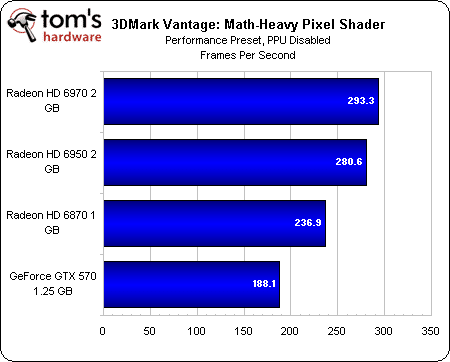

- 3DMark Vantage

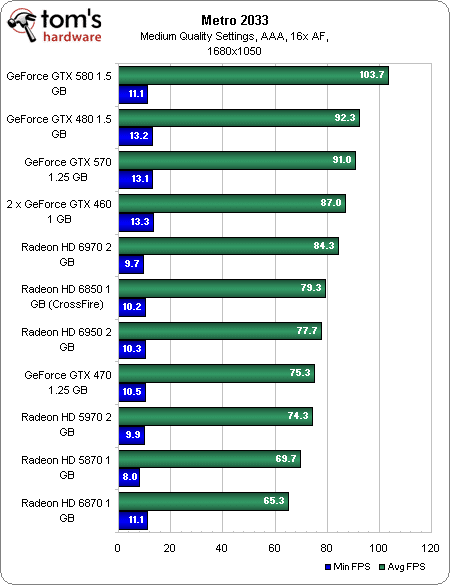

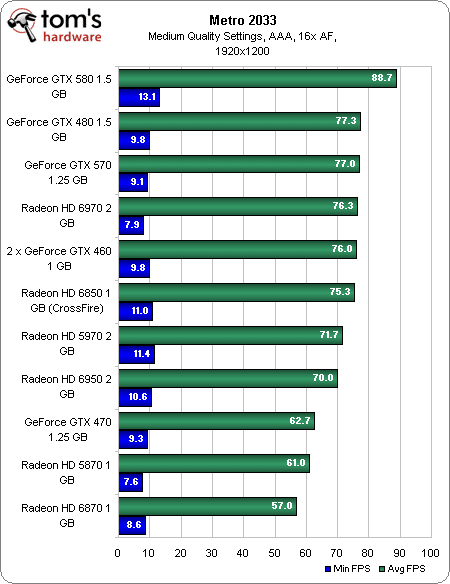

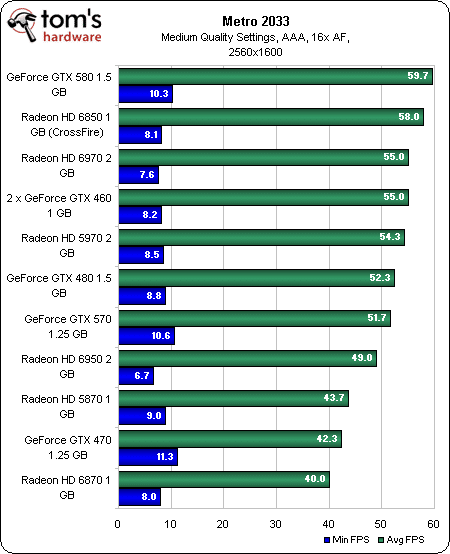

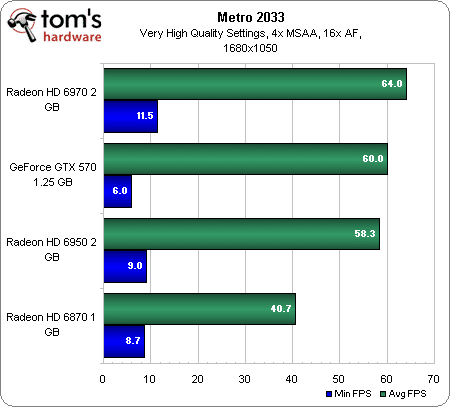

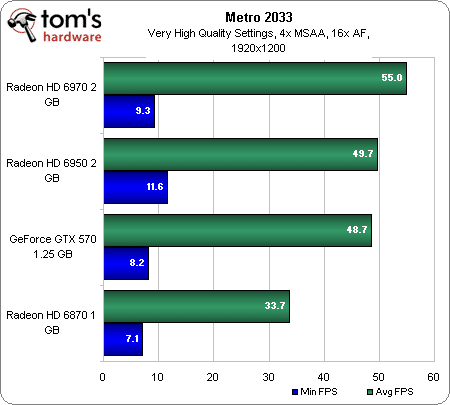

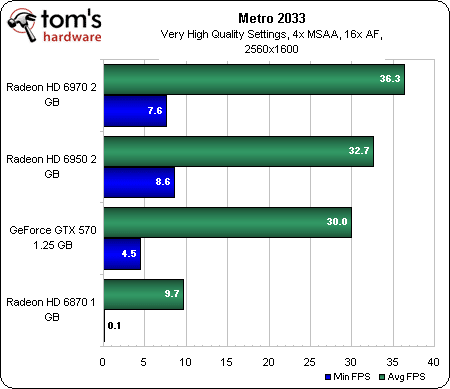

- Metro 2033

- Lost Planet 2

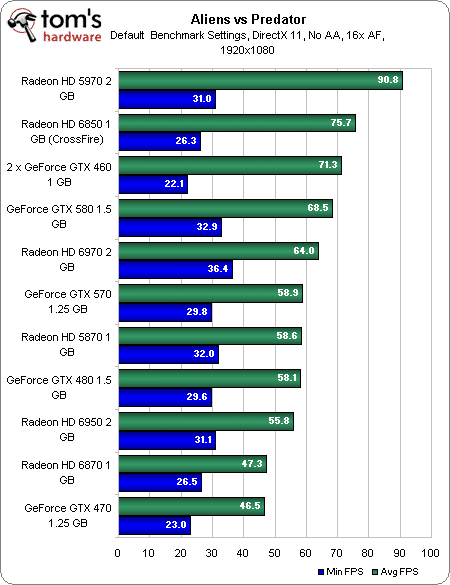

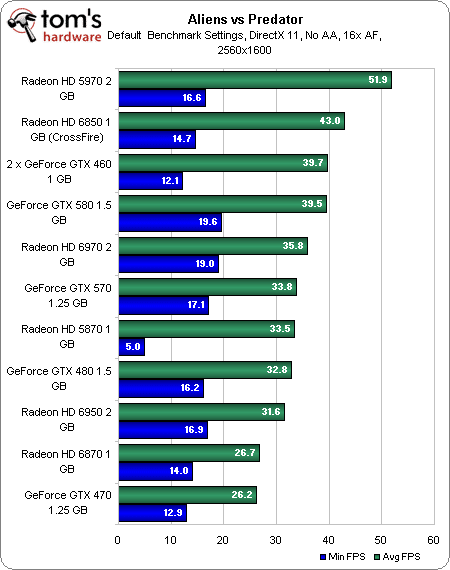

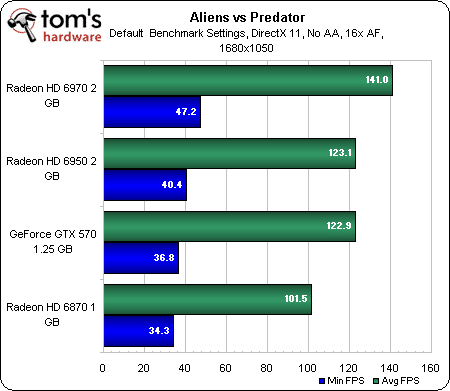

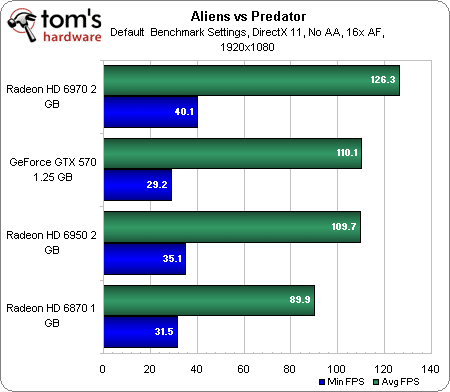

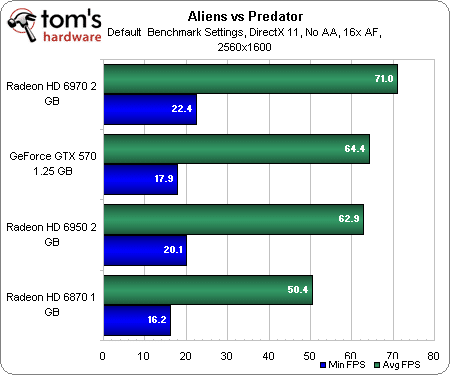

- Aliens vs Predator

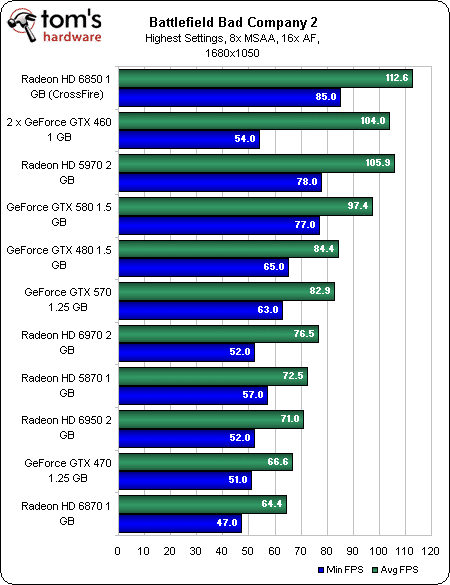

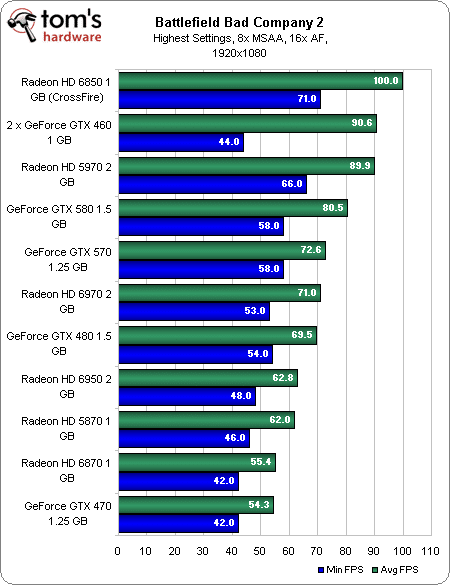

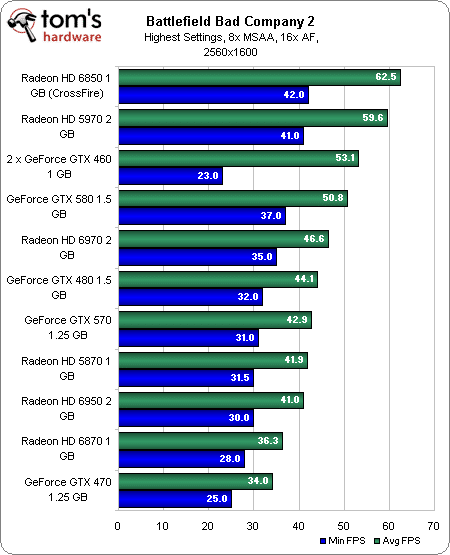

- Battlefield: Bad Company 2

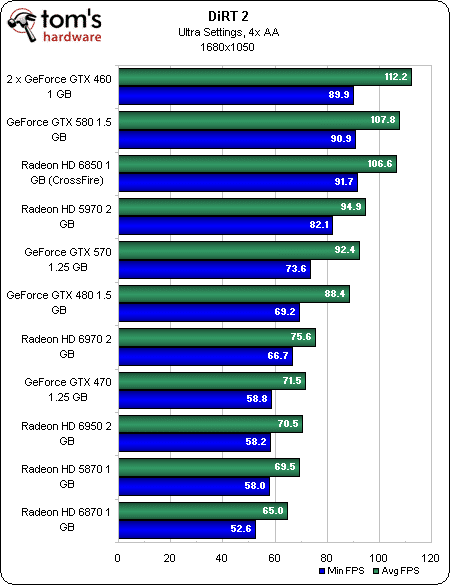

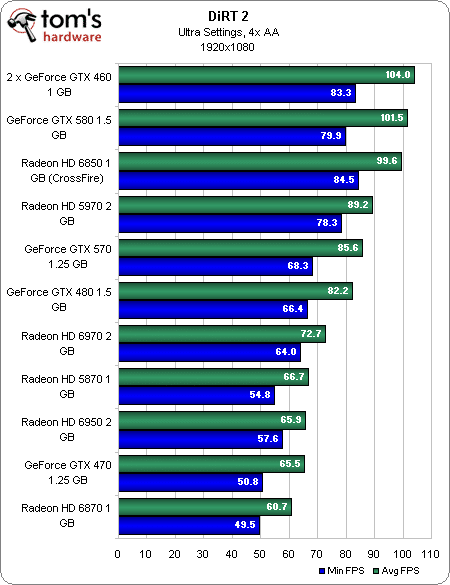

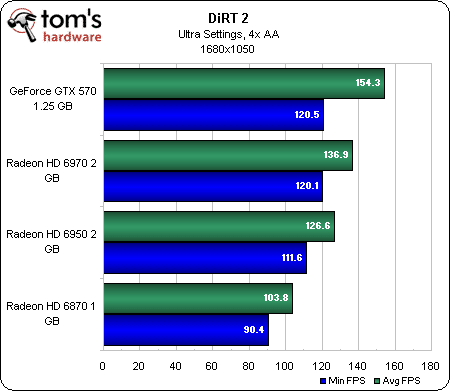

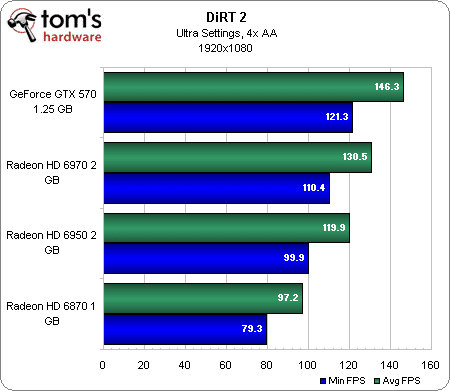

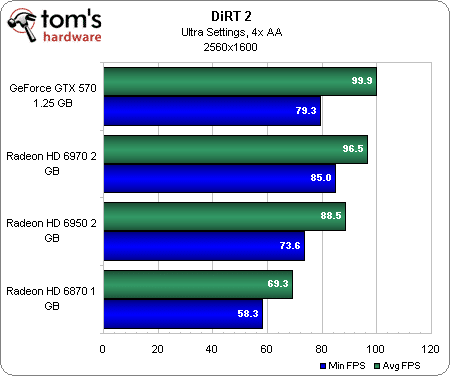

- DiRT 2

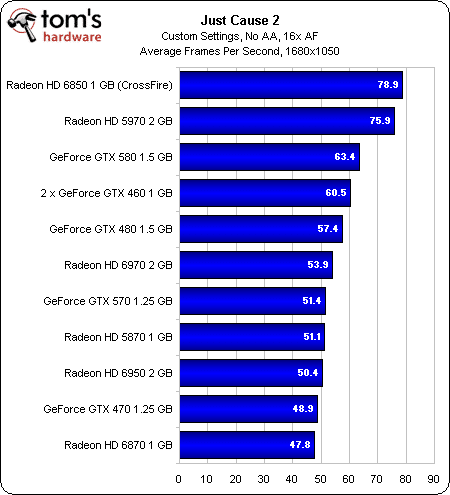

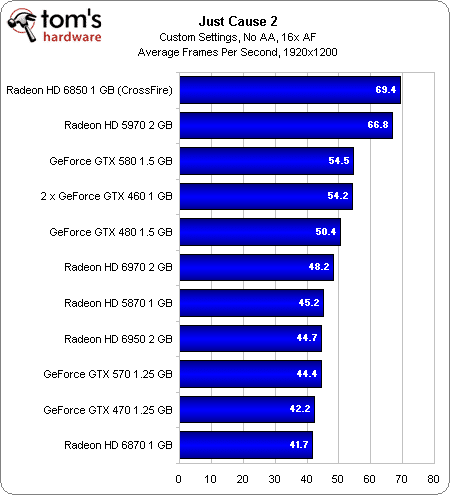

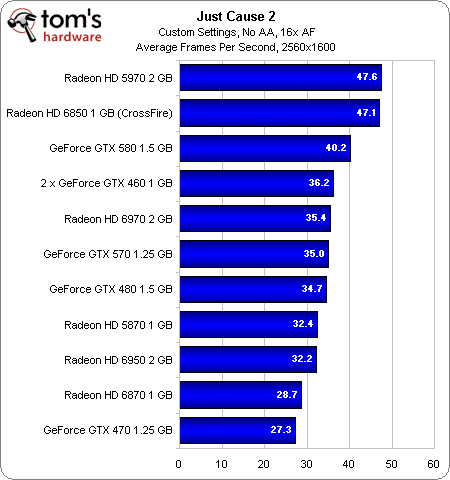

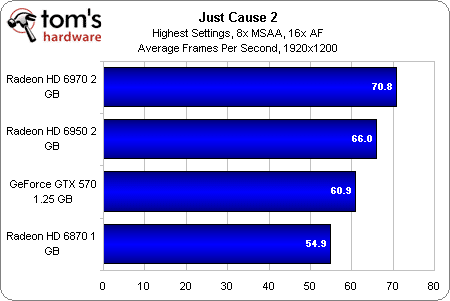

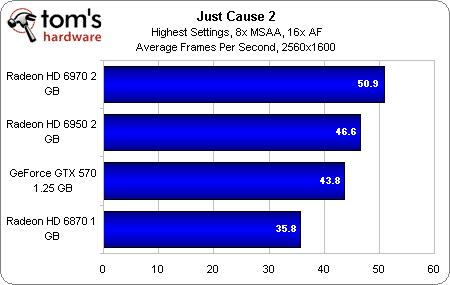

- Just Cause 2

- CrossFire/SLI : 3DMark Vantage

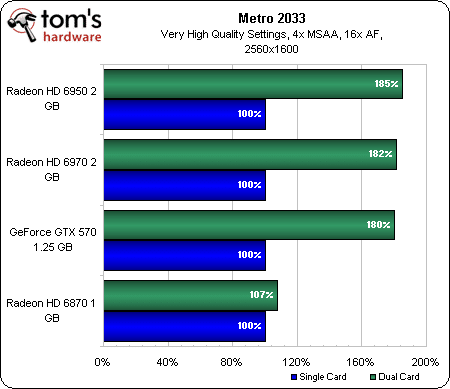

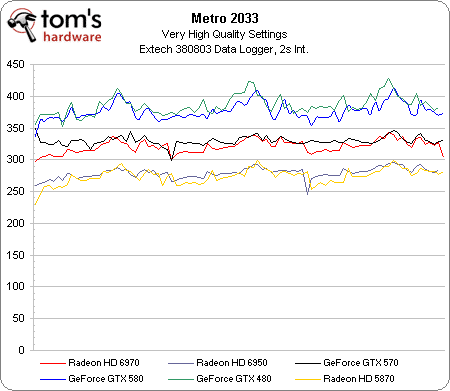

- CrossFire/SLI : Metro 2033

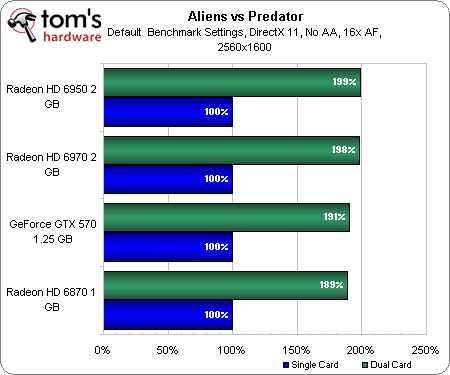

- CrossFire/SLI : AvP

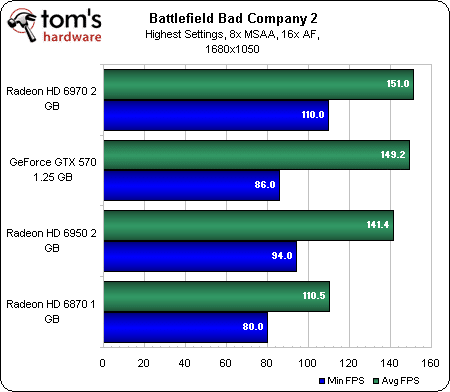

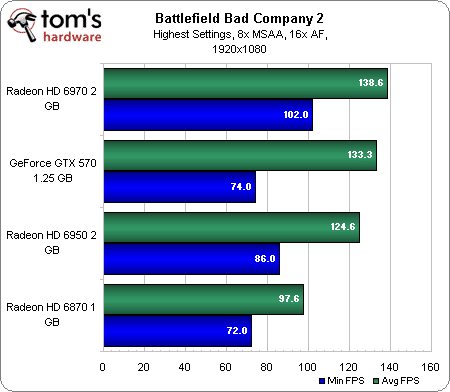

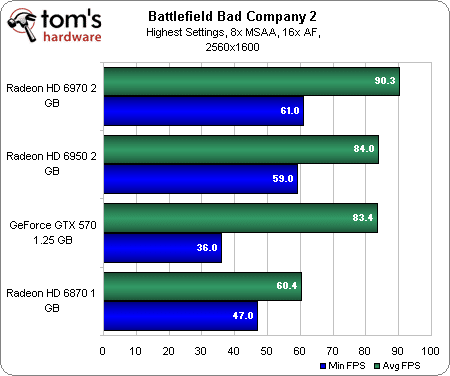

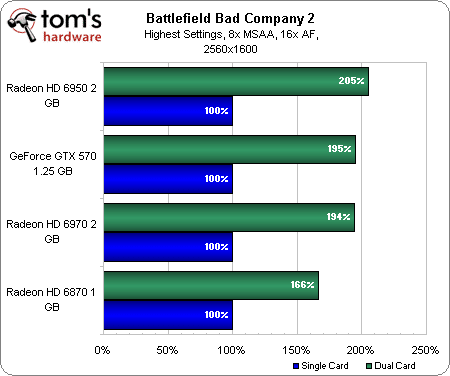

- CrossFire/SLI : Battlefield: Bad Company 2

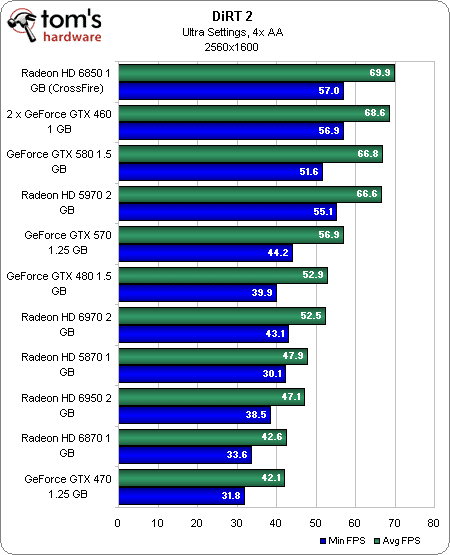

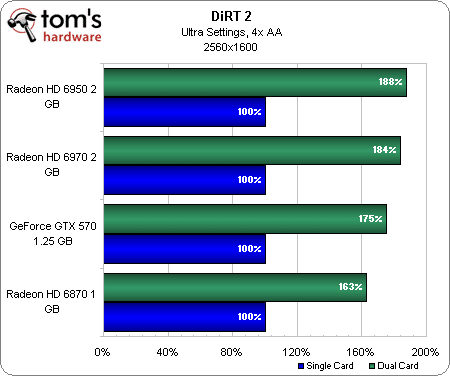

- CrossFire/SLI : DiRT 2

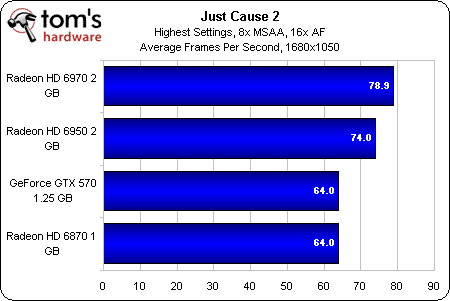

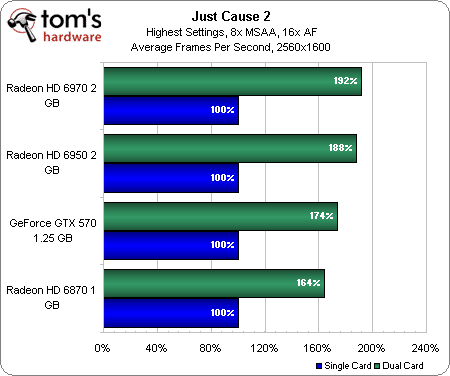

- CrossFire/SLI : Just Cause 2

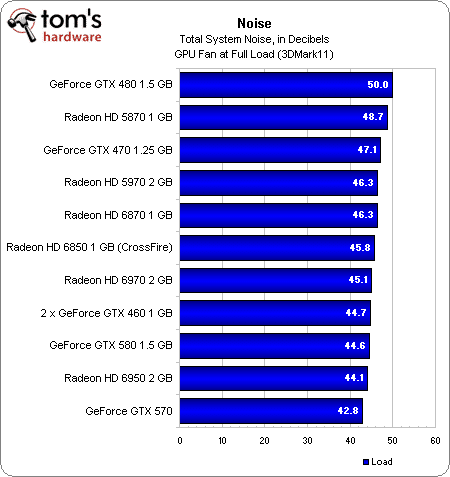

- Consommation et bruit

- Conclusion

Introduction

Dans le petit monde du hardware, on passe souvent son temps à attendre la prochaine révolution, à lire des tonnes d’articles traitant de technologies de pointe et… à remettre l’achat des composants au lendemain. Parfois, cependant, l’attente en vaut la peine. Ce qui s’est passé la semaine dernière en constitue le parfait exemple : Nvidia annonçait ses GeForce GTX 570, mais nous étions déjà en train d’être briefé par AMD sur ses nouvelles Radeon HD 6970 et 6950. Difficile de ne pas comparer les unes aux autres dans notre esprit.

Une attente… récompensée ?

S’il n’y avait sur le marché que des GeForce GTX 480 et 470, à base de GF100, l’affaire serait déjà dans le sac pour AMD, mais Nvidia ne l’a pas entendu de cette oreille : les GeForce GTX 580 et 570 montrent en effet que, même si l’architecture Fermi demeure gourmande, il reste possible de sortir une carte qui chauffe beaucoup sans que cela ne soit trop un problème, si on la dote d’un meilleur ventirad et de ventilateurs correctement réglés. Aujourd’hui, AMD a donc affaire à bien plus forte concurrence qu’il n’y a un mois.

Nous ne savons pas si cette concurrence est à l’origine du report des Radeon HD 6900, qui auraient normalement dû sortir il y a près d’un mois. Quoi qu’il en soit, les cartes sont maintenant bien là et disponibles.

Un nouveau GPU basé sur l’existant

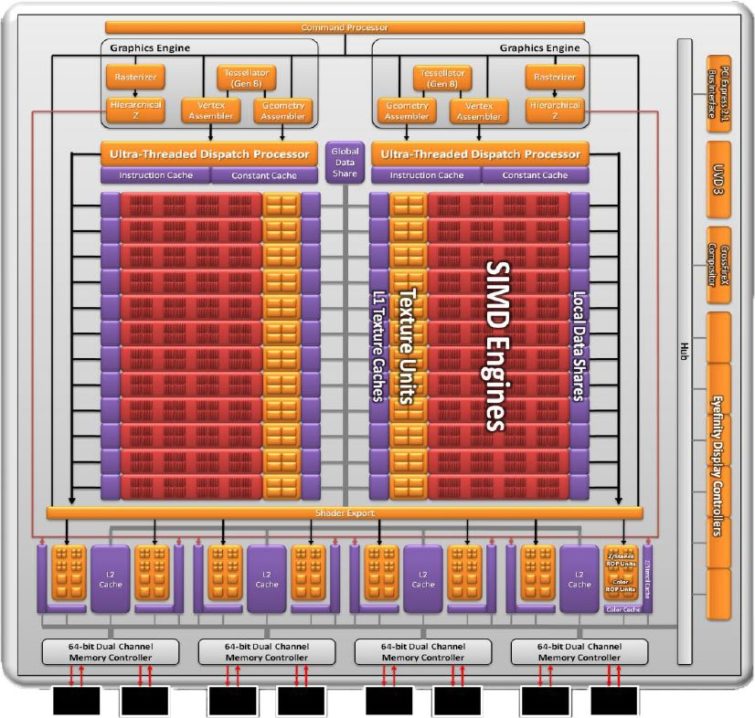

L’équipe chargée de développer les GPU AMD n’est pas connue pour ses coups de théâtre en matière d’architecture ces dernières années ; il n’est donc guère surprenant de voir que les Cayman reprennent un design plutôt familier.

Lorsqu’elle est pleinement utilisée, la nouvelle puce comporte 24 moteurs SIMD (contre 20 pour les Cypress), eux-mêmes composés de 16 processeurs de threads. La différence est que chacun de ces processeurs de threads ne compte plus que quatre ALU au lieu de cinq ; le nombre total d’ALU est donc de 1536 (24 x 16 x 4), alors que les Cypress en contenaient jusqu’à 1600. À côté de cela, chaque moteur SIMD reste relié à quatre unités de textures ; les puces Cayman en comptent donc 96 au total, contre 80 sur les Cypress.

| AMD Radeon HD 6970 | AMD Radeon HD 6950 | AMD Radeon HD 5870 | Nvidia GeForce GTX 580 | |

|---|---|---|---|---|

| Finesse de gravure | 40 nm TSMC | 40 nm TSMC | 40 nm TSMC | 40 nm TSMC |

| Taille du die | 389 mm² | 389 mm² | 334 mm² | 520 mm² |

| Transistors | 2,64 milliards | 2,64 milliards | 2,15 milliards | 3 milliards |

| Fréquence GPU | 880 MHz | 800 MHz | 850 MHz | 772 MHz |

| Stream Processors (ALU) / Cores CUDA | 1536 | 1408 | 1600 | 512 |

| Capacité de traitement (GPGPU) | 2,7 TFLOPS | 2,25 TFLOPS | 2,7 TFLOPS | 1,58 TFLOPS |

| Unités de texture | 96 | 88 | 80 | 64 |

| Fillrate textures | 84,5 Gtex/s | 70,4 Gtex/s | 68 Gtex/s | 49,4 Gtex/s |

| ROP | 32 | 32 | 32 | 48 |

| Fillrate pixels | 28,2 Gpix/s | 25,6 Gpix/s | 27,2 Gpix/s | 37,1 Gpix/s |

| Mémore | 2 Go de GDDR5 | 2 Go de GDDR5 | 1 Go de GDDR5 | 1,5 Go de GDDR5 |

| Fréquence mémoire | 1375 MHz | 1250 MHz | 1200 MHz | 1002 MHz |

| Bande passante mémore | 176 Go/s (256 bits) | 160 Go/s (256 bits) | 153,6 Go/s (256 bits) | 192 Go/s (384 bits) |

| Consommation max. | 250 W | 200 W | 188 W | 244 W |

Comme les GPU Cypress et Barts avant eux, les Cayman sont gravés en 40 nm par TSMC. Cela n’aurait probablement pas changé grand-chose pour cette fois-ci, mais TSMC a renoncé au 32 nm en 2009, ce qui a obligé AMD et Nvidia (qui se fournissent tous les deux chez ce fondeur) a revoir leurs stratégies respectives. Les spécifications techniques actuelles permettent cependant à AMD d’obtenir des dies de taille honnête tout en bénéficiant de performances en hausse. Les Cayman sont donc des bébés de 389 mm² contenant 2,64 milliards de transistors, là où les Cypress faisaient 334 mm² et comptaient 2,15 milliards de transistors. Ce qu’AMD ne voulait absolument pas faire était de suivre la voie empruntée par Nvidia, qui a créé un monstre de plus de 500 mm² contenant 3 milliards de transistors qu’il faut ensuite alimenter et refroidir. Quel que soit l’angle selon lequel on les considère, les Cayman ressemblent donc à un compromis reposant sur ce que TSMC avait à offrir.

On dirait néanmoins qu’AMD est parvenu à faire contre mauvaise fortune bon cœur grâce à une fonction inventive du nom de PowerTune, qui règle automatiquement la fréquence en fonction du TDP et permet de donner au GPU une fréquence d’usine plus élevée. Les deux modèles présentés aujourd’hui, les Radeon HD 6970 et 6950, dépassent à ce titre largement les dernières cartes du fabricant ; la vraie question, toutefois, réside dans leur capacité à faire mieux que les produits récemment lancés par Nvidia.

Cayman : un Cypress amélioré

AMD, selon ses propres dires, avait quatre objectifs lors de la création des Cayman : améliorer le rendement, améliorer les performances en géométrie, apporter de nouvelles fonctionnalités en matière de qualité d’image et améliorer la gestion de l’alimentation.

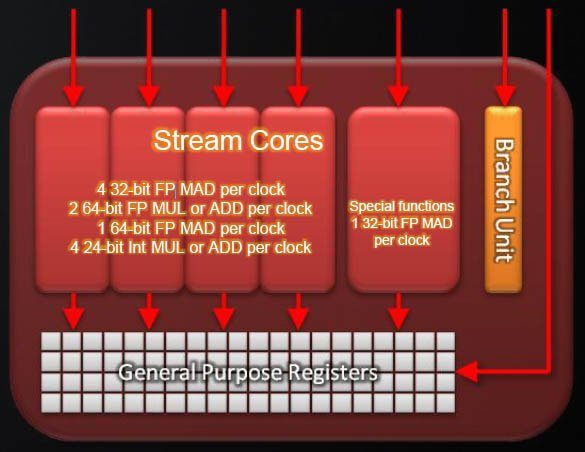

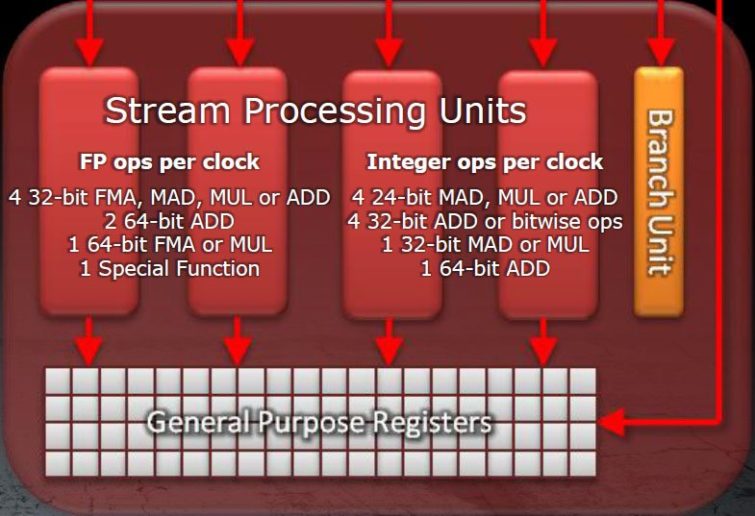

Reprenons ces objectifs un à un. Le premier était de créer une architecture graphique et processeur plus efficace, ce qui se comprend tout-à-fait quand on sait que les cartes AMD obtenaient un taux d’utilisation VLIW d’environ 3,4 dans les jeux, c’est-à-dire qu’elles exécutaient en moyenne 3,4 instructions simultanées. Inutile dans ce cas d’avoir cinq ALU par processeur de thread : en supprimant l’unité chargée du traitement des fonctions spéciales et en redistribuant ses fonctionnalités sur les quatre unités restantes, la firme optimise l’utilisation de son die sans diminuer les performances ; il est évidemment toujours possible que celles-ci en prennent un coup si le taux d’utilisation dépasse 4, mais le fondeur estime que ce scénario est peu probable.

Notons toutefois qu’AMD se devait de créer une architecture plus efficace : coincé par le processus de gravure en 40 nm de TSMC, la société n’avait pas d’autre choix que d’améliorer les performances par millimètre carré de die ; le matériel constituant un facteur limitatif, impossible de se concentrer sur les performances absolues. En passant de cinq à quatre unités ALU par processeur de threads pour son architecture VLIW, AMD peut graver un plus grand nombre de SIMD sur la même superficie et ainsi augmenter de 10 % le rapport performances/surface de ses puces.

Plus légère, cette architecture n’en est pas pour autant moins puissante : les quatre ALU (processeurs de flux) restantes ont les mêmes capacités que les cinq de la génération précédente. Chaque processeur de flux de l’architecture VLIW4 est donc maintenant capable d’effectuer :

- Quatre opérations FMA, MAD, MUL ou ADD 32 bits en virgule flottante par cycle

- Deux opérations ADD 64 bits en virgule flottante par cycle

- Une opération FMA ou MUL 64 bits en virgule flottante par cycle

- Une fonction spéciale en virgule flottante par cycle

- Quatre opérations MAD, MUL ou ADD 24 bits sur entiers par cycle

- Quatre opérations sur les bits ou ADD 32 bits sur entiers par cycle

- Une opération MAD ou MUL 32 bits sur entiers par cycle

- Une opération ADD 64 bits sur entiers par cycle

Voilà pour les shaders ; les cœurs de rendu, quant à eux, sont capables de traiter les opérations sur entiers en 16 bits deux fois plus rapidement, et les opérations en virgule flottante en 32 bits deux à quatre fois plus rapidement. Selon AMD, le gain de performances se remarque particulièrement en matière d’antialiasing.

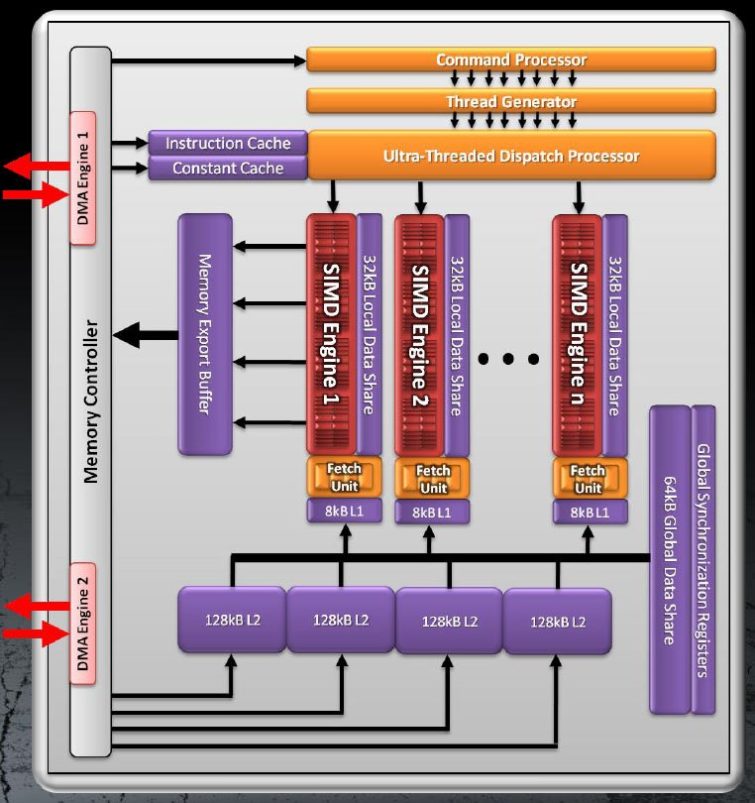

Augmentation des performances GPGPU

Bien que les aspirations d’AMD en matière de calcul GPGPU soient généralement prises avec moins de sérieux que celle de Nvidia (avec son CUDA), il semblerait qu’il s’agisse d’un domaine dans lequel les Cayman ont assez bien avancé. Ainsi, alors que les Radeon HD 58xx effectuent les calculs en double précision cinq fois moins rapidement que ceux en simple précision, les Cayman les effectuent quatre fois moins rapidement. Bien que la vitesse de pointe affichée par la Radeon HD 6970 en simple précision soit un rien moins élevée que celle de la Radeon HD 5870 (2,7 TFLOPS contre 2,72 TFLOPS), nous nous retrouvons donc avec 675 GFLOPS en double précision sur la Radeon HD 6970 contre 544 GFLOPS sur la HD 5870.

Notons en passant que les GPU Barts font complètement l’impasse sur le calcul en double précision, préférant se concentrer sur les performances dans les jeux plutôt que sur le calcul GPGPU.

Les Cayman sont également équipés de deux moteurs DMA bidirectionnels, qui doivent idéalement accélérer la communication (lecture et écriture) avec la mémoire système via le bus PCI Express.

Enfin, AMD a doté ses nouveaux GPU de la capacité de gérer les applications indépendamment ; à titre de comparaison, l’architecture Fermi de Nvidia peut gérer plusieurs kernels, mais ceux-ci doivent être générés par le même thread CPU. Il est intéressant de noter que cette fonction n’est pas prise en charge par DirectX 11, raison pour laquelle AMD va la proposer à l’avenir via OpenCL.

Mémoire cache

À côté de ces quelques adaptations fonctionnelles, les Cayman conservent la structure des Cypress en matière de cache : chaque SIMD possède 8 Ko de cache L1 pour le traitement, 16 Ko de cache L1 pour les textures et 32 Ko de cache pour le partage local des données.Quatre caches L2 de 128 Ko viennent compléter le tableau, auquel s’ajoute un cache global de 64 Ko partagé par tous les SIMD.

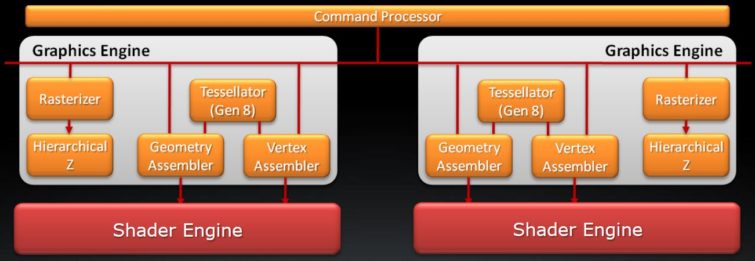

AMD reconnaît l’importance de la géométrie

Géométrie : l’architecture évolue

Lorsque Nvidia nous a pour la première fois présenté les caractéristiques orientées jeux de son architecture Fermi, il y a près d’un an, la société a avant tout mis l’accent sur la géométrie. Ce qui peut se comprendre : après tout, les GPU modernes sont extrêmement performants en termes de shading. Avec les cartes haut de gamme, pour assister à des chutes de performances, il faut adopter des résolutions que la plupart des utilisateurs ne pourraient pas prendre en charge ou qui nécessitent plusieurs écrans.

Le nombre de triangles par scène, par contre, n’a pas augmenté dans les mêmes proportions. Certes, nous avons maintenant droit à des paysages parsemés d’arbres et d’herbe particulièrement réalistes, mais les contours de l’environnement proprement dit restent très distinctement géométriques, et de ce fait, pas naturels du tout. Nvidia a tenté de résoudre ce problème à l’aide de son moteur PolyMorph, une unité de tessellation contenue dans chaque Shader Multiprocesseur destinée à booster les performances lorsque les développeurs se décideraient à exploiter les possibilités offertes par DirectX 11 en matière de complexification géométrique des scènes affichées.

À l’époque, AMD répondait que son moteur de tessellation maison était plus que capable de tenir tête à celui de Nvidia. Le benchmark Unigine Heaven, cependant, a démontré que ce n’était pas le cas, comme l’a d’ailleurs fait plus tard HAWX 2, qui nous a prouvé en pratique que l’architecture de Nvidia se débrouillait mieux dans ce domaine (encore que les résultats obtenus nous aient légèrement déçus, étant donné la manière dont Nvidia avait insisté sur les capacités du GF100).

Avec les Radeon HD 6900, AMD tente de rattraper son retard en matière de géométrie. Sur les Radeon HD 5870, nous nous étions rendu compte que ce que la firme appelait « doubles rasterizers » était en réalité de simples rasterizers composés de deux fois plus d’unités de conversion, ce qui permettait de faire passer le nombre de pixels traités à 32 par cycle. Sur les Cayman, le nombre de pixels que les rasterizers peuvent traiter par cycle ne change pas, mais le bloc d’architecture dédié à la géométrie (et donc aux transformations, au z-culling et à la tessellation) est en pratique doublé, ce qui signifie qu’au bout du compte, les ROP des nouveaux GPU sont capables de traiter deux triangles par cycle, alors que les Cypress (HD 5800) et les Barts (HD 6800) ne pouvaient en traiter qu’un. De plus, en cas de débordement des caches de la puce, ce qui est susceptible de se produire au vu du nombre de plus en plus extraordinaire de triangles que génère la tessellation (du moins lorsqu’elle est poussée un peu loin), les vertex excédentaires sont maintenant stockés dans la mémoire tampon.

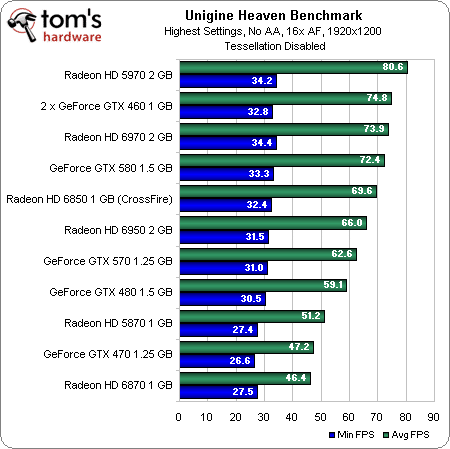

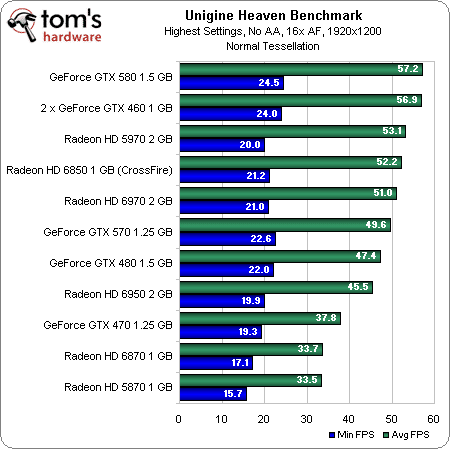

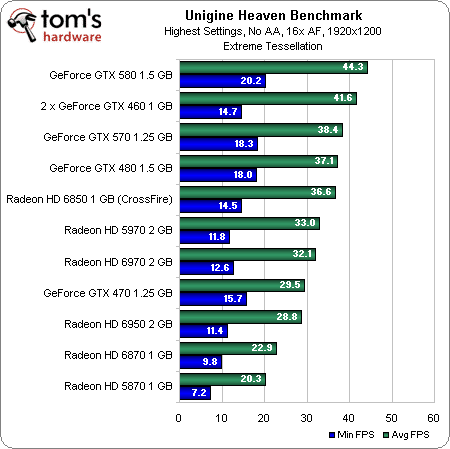

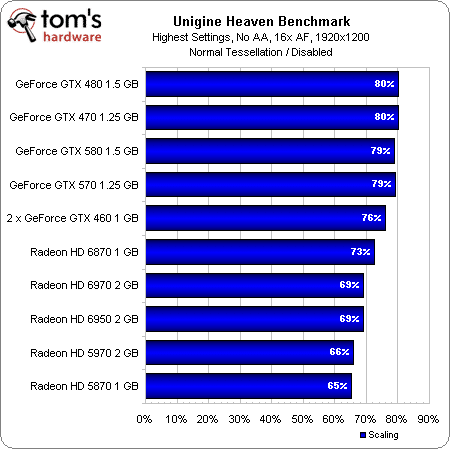

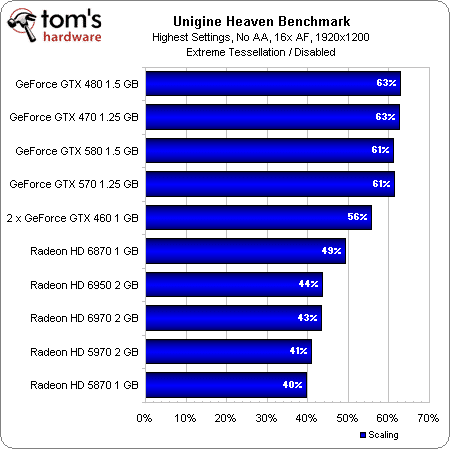

Performances en géométrie : Unigine Heaven

Mais qu’apportent ces changements en termes de performances ? Nous avons commencé par soumettre les cartes à l’un des benchmarks de référence en la matière, Unigine Heaven :

Tessellation désactivée

Tessellation normale

Tessellation extrême

Comme vous pouvez le voir, les nouveaux modèles se débrouillent bien tant que la tessellation est désactivée, tellement bien, en fait, que la Radeon HD 6970 dépasse la GeForce GTX 580. Une fois la tessellation activée, par contre, on voit les cartes AMD reculer petit à petit dans le classement, jusqu’au moment où la GeForce GTX 580 finit par faire mieux qu’un couple de Radeon HD 6850 en CrossFire !

Performances avec tessellation normale (en % des performances avec tessellation désactivée)

Performances avec tessellation extrême (en % des performances avec tessellation désactivée)

Au-delà des chiffres de framerate bruts, on remarque que les améliorations qui avaient été apportées aux Radeon HD 6800 s’avéraient plus efficaces que celles des nouvelles HD 6900 ; sur ce plan, c’est la Radeon HD 6870 qui se tient le mieux en tessellation… chez AMD. Malheureusement pour les Cayman, les cartes Nvidia sont toutes plus performantes dans ce domaine.

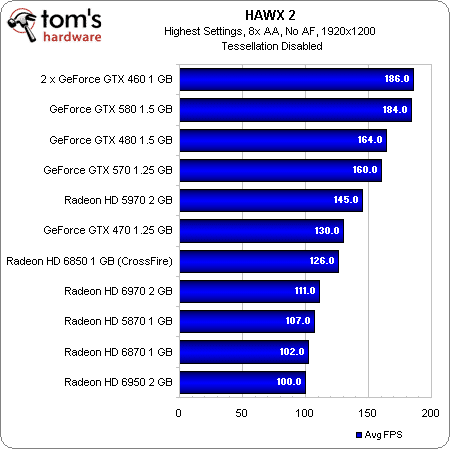

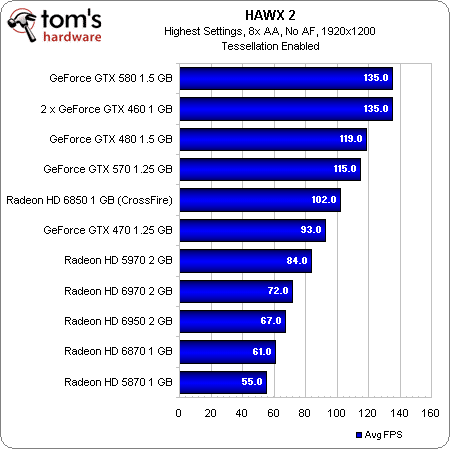

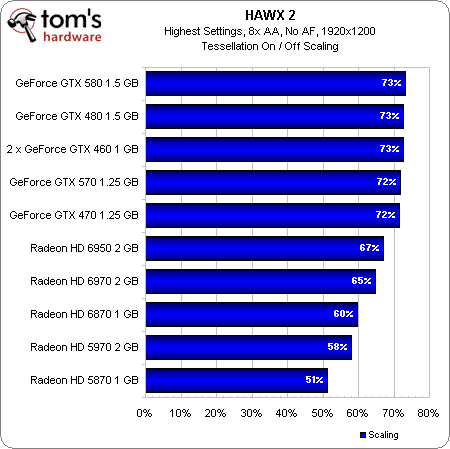

Performances en géométrie : HAWX 2

Tessellation désactivée

Tessellation activée

Les performances dans HAWX 2 (le seul jeu qui utilise réellement la tessellation pour accroître le réalisme) ne se montrent guère plus enthousiasmantes pour les Radeon HD 6900 : les nouveaux modèles arrivent bon derniers de ce classement, derrière les GeForce GTX 570 et même 470.

Performances avec tessellation activée (en % des performances avec tessellation désactivée)

Les conclusions sont toutefois légèrement différentes quand on observe le rapport entre les performances avec tessellation activée sur celles avec tessellation désactivée : la Radeon HD 6970, bien qu’elle se positionne derrière les cartes Nvidia, se rapproche nettement plus de celles-ci. La Radeon HD 6950 se paie même le luxe de faire encore mieux à ce niveau (n’oublions pas qu’il s’agit de performances relatives).

Un bémol toutefois : HAWX 2 ne semble pas tirer parti de tous les moteurs PolyMorph disponibles dans les GeForce, chacune de celles-ci voyant ses performances avec tessellation bloquées à 73 % de ses performances sans tessellation. C’est plus que probablement ce qui permet aux cartes AMD de se rattraper.

Antialiasing, Eyefinity et accélération vidéo

Connectivité : des sorties alléchantes

En matière de jeu, il est logique d’opter pour la carte offrant les meilleures performances, le moins de bruit et la meilleure fiabilité. Et pourtant, cela fait maintenant plus d’un an que nous utilisons une carte graphique AMD dans l’ordinateur qui nous sert à écrire ces lignes. Pourquoi ? Pour l’Eyefinity.

Avant cela, nous avions une Nvidia Quadro NVS, ce qui signifiait qu’il nous fallait une deuxième machine pour jouer. Cette carte professionnelle avait tout de même l’avantage de nous permettre d’utiliser quatre écrans en simultané, alors que la Radeon HD 5850 qui lui a succédé n’en acceptait plus que trois ; aujourd’hui, avec les Radeon HD 6800 et 6900, nous pouvons ressortir le quatrième moniteur du placard. Les HD 6970 et 6950, comme les deux cartes de la série 6800 avant elles, sont équipées de cinq sorties vidéo : deux mini-DisplayPort 1.2, une HDMI 1.4a et deux DVI (une single-link et une dual-link). Sur les cinq, il est possible d’en utiliser jusqu’à quatre simultanément, pour autant que deux soient des DisplayPort.

À l’avenir, nous pourrons même brancher directement six écrans sur ces cartes, ce qui rendra les éditions spéciales Eyefinity 6 (plus chères) inutiles : en 2011, il sera en effet possible de relier six écrans aux deux sorties DisplayPort 1.2, soit en les connectant en série, soit via un hub multi-stream. Ce n’est pas pour tout de suite, mais c’est à ne pas perdre de vue.

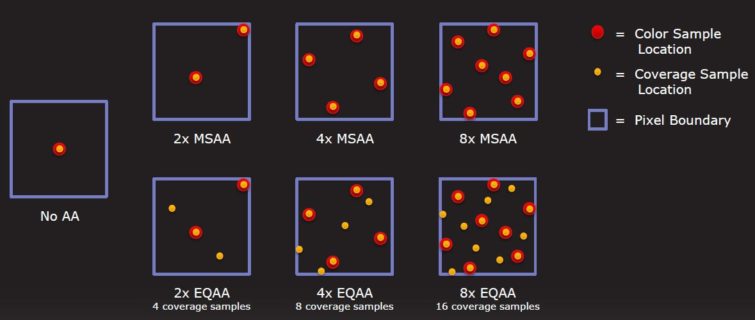

Antialising : AMD met au point son propre CSAA

Avec les Radeon HD 6800, AMD avait lancé l’antialiasing morphologique, un filtre basé sur DirectCompute permettant d’activer l’AA même dans les jeux ne le prenant pas en charge de manière native.Aujourd’hui, la société ajoute l’Enhanced Quality Anti-Aliasing (EQAA), une technologie améliorant le MSAA en lui ajoutant 16 échantillons de couverture par pixel.

Pour comprendre ce que cela signifie, il faut prendre un peu de recul : lorsqu’on applique du supersampling à une image, chaque échantillon (sample) se compose d’une nuance de couleur, de données de couleur/z/stencil et d’une couverture. En gros, c’est comme si la carte effectuait le rendu dans un buffer taille maxi puis coupait au filtrage. Le multisampling permet de réduire la baisse de performances qu’introduit cette opération en séparant les échantillons de nuance de couleur des données de couleur et de la couverture ; le traitement s’effectue donc sur moins d’échantillons de nuance, mais ne fait aucun compromis en matière de couleur/z/stencil ni de couverture.

L’EQAA, la version AMD du CSAA de Nvidia, sépare quant à lui la couverture de la couleur/z/stencil, ce qui réduit la bande passante nécessaire et par conséquent la baisse de performances engendrée par l’antialiasing. À en croire AMD, ce système autorise une meilleure séparation des couleurs que celui de Nvidia ; si les résultats sont pour l’instant plus ou moins équivalents, nous devrions assister à une différenciation des deux résultats à l’avenir.

Accélération vidéo : UVD3

Les Radeon HD 6900 sont équipées de la même unité de décodage vidéo que les 6800, à savoir l’UVD3, ce qui signifie que l’accélération du MPEG-4 ASP et du pipeline MPEG-2 est prise en charge, de même que le Multiview Video Coding, une modification du H.264/MPEG-4 AVC facilitant la lecture stéréoscopique. Au final, on se retrouve donc avec une prise en charge matérielle des Blu-ray 3D via HDMI 1.4a.

AMD se retrouve donc à peu près au même niveau que Nvidia. Notons toutefois qu’Intel est actuellement en train de préparer quelque chose qui devrait prendre les deux entreprises par surprise… nous devrions pouvoir vous en dire plus d’ici quelques semaines.

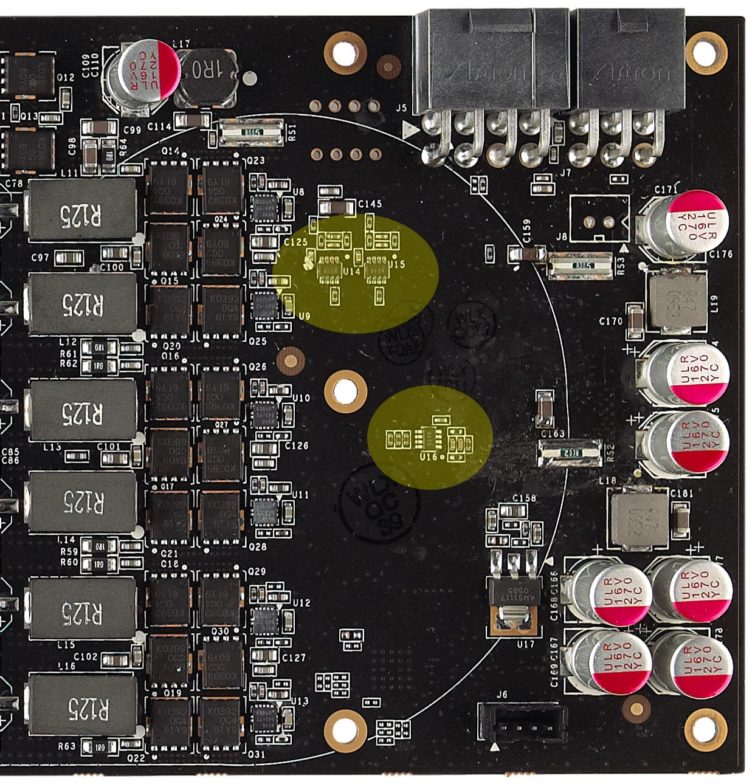

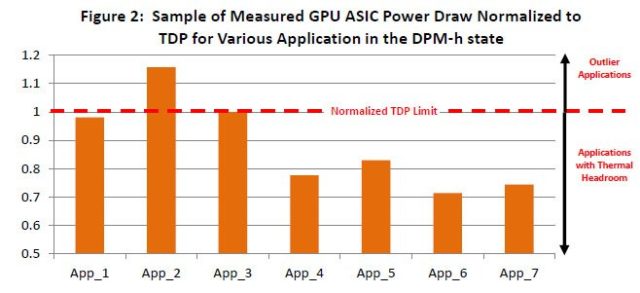

PowerTune : plus qu’un nouvel overclocking

Avant…

Au fur et à mesure des années, AMD et Nvidia ont intégré à leurs cartes des fonctions spécialement destinées à permettre à leur matériel de répondre aux besoins des applications les plus exigeantes puis de ralentir lorsque la charge de travail diminue.

En situation de stress extrême (par exemple sous l’action d’un logiciel comme FurMark, spécialement écrit pour appliquer une charge anormalement élevée), les cartes des deux sociétés réduisent automatiquement la tension et la fréquence de leurs composants afin d’éviter de surcharger le dissipateur thermique. Plus récemment, nous avons également vu apparaître des mécanismes de protection liés au régulateur de tension qui réduisent la fréquence du GPU en cas de surtension, et ce, même si aucune surchauffe n’est détectée.

À l’inverse, les Radeon comme les GeForce ralentissent lorsqu’elles n’ont rien à faire, ce qui se traduit par des économies d’énergie, mais également par uune réduction de la dissipation thermique et des nuisances sonores. Cette capacité à monter en puissance ou à décélérer en fonction des circonstance est ce qui permet de placer un GPU pour desktop dans un portable sans se retrouver avec un système inutilisable.

Les technologies de gestion de l’alimentation avancées par AMD se sont longtemps appelées PowerPlay, un nom surtout connu dans le secteur des ordinateurs portables, étant donné que c’est là que les considérations d’ordre thermique ont le plus d’incidence sur les capacités des GPU. Mais tout bien considéré, PowerPlay est un système relativement rudimentaire ; il prend en charge trois états différents : repos, pointe et intermédiaire, pour les opérations de type lecture vidéo. Pour chacun de ces états, la combinaison tension/fréquence est toutefois statique, un peu comme les barreaux d’une échelle.

Le problème est que les applications ne se comportent pas toutes de la même manière, et que leur comportement ne correspond pas nécessairement à ce que les ingénieurs avaient en tête lors de la conception des composants. Par conséquent, même si le GPU se trouve dans l’état « performances maximum », un logiciel comme FurMark va lui faire consommer, disons, 260 watts, alors que Crysis ne poussera la carte que jusqu’à 220 watts. Dans ces conditions, les concepteurs de la carte graphique ne peuvent pas se permettre de ne prendre que Crysis en compte : il est indispensable de faire en sorte qu’elle fonctionne de manière stable sous FurMark. Ce sont les scénarios catastrophes de ce genre qui entrent en ligne de compte dans la fixation du TDP (thermal design power), ce chiffre clé qui revient si souvent dans nos colonnes.

Lorsqu’elles fixent le TDP, les sociétés comme AMD et Nvidia le font pour l’ensemble de la carte ; il s’agit donc de la limite maximale de consommation totale pour garantir le bon fonctionnement, en toute fiabilité, du GPU, du circuit de régulation de la tension, de la mémoire, etc. Lorsqu’elles fixent la tension et la fréquence pour le P-state le plus élevé (performances de pointe), trois choses sont prises en compte : le TDP, la fréquence stable maximale à une tension donnée et le profil de consommation des applications les plus gourmandes.

Dans certains cas, il est donc nécessaire de plafonner artificiellement les performances du GPU pour ne pas dépasser l’enveloppe thermique allouée. C’est particulièrement courant dans les ordinateurs portables. De même, il faut parfois limiter la fréquence pour être sûr de respecter les spécifications techniques d’un élément extérieur à la carte, comme le bus PCI Express, par exemple. Malheureusement, cela signifie que l’on se retrouve parfois à limiter les performances sous World of Warcraft tout simplement parce qu’il a fallu plafonner les fréquences pour éviter que le test « Perlin Noise » de 3DMark Vantage ne fasse planter la CG. On comprend d’un coup nettement mieux pourquoi nos deux fabricants de GPU détestent les programmes comme FurMark ou OCCT : toutes ces applications entravent artificiellement les capacités réelles de leurs produits.

Quoi qu’il en soit, au final, nous nous retrouvons dans une situation où les cartes graphiques sont protégées contre les dégâts, mais où cela se fait au détriment des performances. Si vous exécutez une application qui n’atteint pas les limites de consommation de la carte, vous la sous-utilisez.

…et maintenant

Mais tout cela est sur le point de changer : AMD affirme en effet que sa technologie PowerTune règle les deux gros problèmes auxquels ont dû faire face jusqu’à présent les fabricants de GPU, et ce, via une gestion dynamique du TDP.

Au lieu de faire passer la carte d’un état d’alimentation à l’autre (repos, intermédiaire, pointe), PowerTune adapte dynamiquement la fréquence du GPU en fonction de la consommation. Si vous overclockez la carte puis lancez une application qui la pousse à dépasser son TDP, PowerTune est censé laisser le GPU dans son P-state le plus élevé, mais réduire la consommation en diminuant automatiquement la fréquence.

Ce qui ne veut pas dire que PowerTune vous évitera de crasher votre carte graphique si vous effectuez un overclocking trop agressif. Nous avons par exemple essayé de booster les fréquences de notre Radeon HD 6970 via le Catalyst Control Center en laissant PowerTune sur ses réglages par défaut, et cela n’a pas manqué : Just Cause 2 et Metro 2033 nous ont fait un beau crash. Il est également important de noter que toute utilisation de PowerTune est considérée comme de l’overclocking, ce qui signifie que si vous grillez votre HD 6xxx toute neuve à cause de cette fonction, la garantie n’entrera pas en jeu. C’est sans doute totalement injuste, mais vous êtes prévenus.

Fonctionnement

Mais les performances, dans tout cela ? Le bon point est que grâce à PowerTune, au lieu de concevoir les Radeon HD 6xxx pour un scénario catastrophe hypothétique, AMD peut maintenant régler en usine une fréquence plus élevée qu’auparavant (880 MHz dans le cas de la HD 6970) et laisser à PowerTune le soin de diminuer les performances dans les applications qui l’auraient par le passé forcée à régler cette fréquence d’usine sur quelque chose comme, par exemple, 750 MHz.

Disons, donc, que vous overclockez votre carte sans toucher aux réglages par défaut de PowerTune dans les pilotes AMD. Si vous lancez une application qui n’était pas limitée par le TDP à la fréquence d’usine et qui n’est toujours pas limitée par la nouvelle fréquence, vous constaterez la hausse de performances attendue. Si votre application n’était pas limitée par le TDP avant l’overclocking mais l’est après celui-ci, vous ne remarquerez qu’une légère hausse des performances. Et enfin, si l’application était déjà limitée par le TDP de la carte, l’overclocking ne va rien vous apporter : en effet, PowerTune modulait déjà les performances.

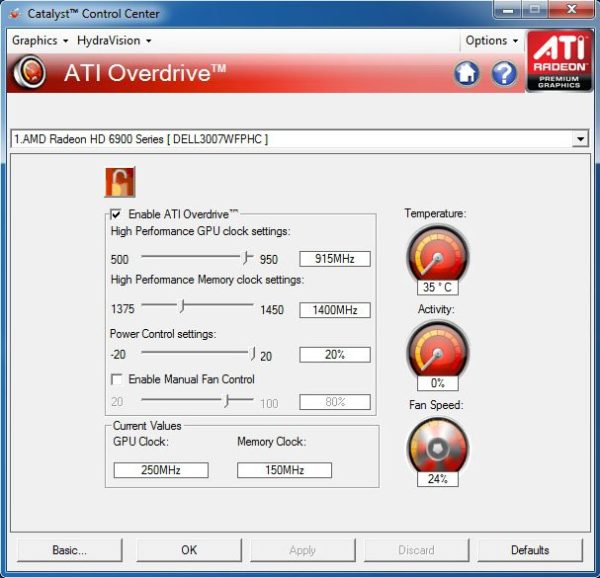

AMD vous permet toutefois de contourner ce comportement dans une certaine mesure : dans l’onglet AMD Overdrive du nouveau Catalyst Control Center, il y a maintenant une règle coulissante libellée « PowerTune » qui va de -20 % à +20 %. Si vous diminuez ce réglage, vous abaissez le TDP maximal et vous réalisez des économies d’énergie au détriment des performances ; à l’inverse, si vous l’augmentez, vous agrandissez l’enveloppe thermique et vous autorisez les applications qui étaient auparavant limitées par le TDP à bénéficier de performances plus élevées.

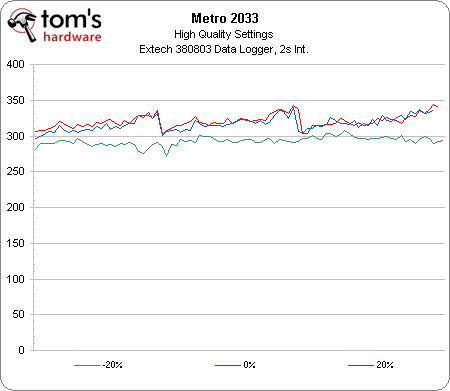

En pratique : PowerTune vs Metro 2033

Pour tester le comportement de PowerTune, nous avons lancé une série de jeux avant de finir par opter pour Metro 2033 (que nous utiliserons également plus loin dans cet article pour mesurer la consommation de nos cartes). Nous avons aussi légèrement overclocké la Radeon HD 6970 (915/1400 MHz). Résultat des courses : avec PowerTune réglé à -20 %, nous obtenons 48,54 images/s avec les paramètres visuels du jeu réglés sur « High » ; à 0 %, ce chiffre passe à 56,43 images/s ; et à +20 %, nous observons une légère hausse à 57,33 images/s.

La consommation mesurée (graphique ci-dessus) nous explique ces résultats : lorsque nous réduisons les performances via PowerTune, nous diminuons clairement la consommation (-27 watts en moyenne), mais comme Metro 2033 pompe déjà un maximum de courant, il ne reste plus aucune marge pour monter en puissance, d’où la faiblesse de la hausse du framerate.

D’une certaine manière, AMD exploite déjà au maximum la marge d’overclocking de ses Radeon HD 6900 ; on peut toujours utiliser PowerTune pour tenter d’en récupérer un peu plus, mais au final, les résultats obtenus dépendront des applications utilisées.

AMD nous a expliqué que PowerTune était une fonction matérielle, implantée au cœur du GPU à l’aide d’une série de compteurs, qui fonctionne en temps réel et sans nécessiter le moindre pilote ni la moindre prise en charge par les applications. Elle est néanmoins programmable, ce qui lui prédit de beaux jours dans la version portable des Cayman, qui porteront le nom de Blackcomb.

Les cartes

À l’heure actuelle, le GPU Cayman fait son apparition sur deux cartes graphiques assez proches, mais néanmoins différentes : la Radeon HD 6970 et la Radeon HD 6950.

Radeon HD 6970

La plus grosse des deux, la Radeon HD 6970, est dotée un Cayman « complet » comptant 24 SIMD activés et 96 unités de textures, et fonctionne à une fréquence de 880 MHz. Comme les cartes des générations précédentes, elle fait appel à un bus mémoire de 256 bits, mais cette fois, AMD a relié celui-ci à 2 Go de GDDR5 ; sachant que le contrôleur peut monter à 1375 MHz, cela nous donne une bande passante de 175 Go/s et un débit de 5500 MT/s. Nvidia fait mieux avec des contrôleurs plus lents, mais a pour cela besoin d’un bus plus large, et donc d’un GPU plus volumineux et d’un plus grand nombre de pistes sur le circuit imprimé.

D’après AMD, la Radeon HD 6970 ne consomme plus que 20 watts repos (soit 7 watts de moins que la Radeon HD 5870). Son « coefficient PowerTune » (autant dire son TDP) maximum est quand à lui de 250 watts, ce qui peut inquiéter. À titre de comparaison, la Radeon HD 5870 avait un TDP de 188 watts. Plus symboliquement, 250 watts, c’est aussi le TDP de la GeForce GTX 480 de Nvidia… et nous avons vu les résultats peu engageants que cela donnait. Fort heureusement, comme vous le verrez à la page dédiée à la consommation, les nuisances générées par la carte d’AMD n’arrivent en pratique absolument pas au niveau de celles du monstre de Nvidia ; en règle générale, dans les jeux, nous constatons plutôt une consommation de l’ordre de 190 watts.

Radeon HD 6950

La Radeon HD 6950, quant à elle, perd deux moteurs SIMD, ce qui lui confère un total de 1408 ALU (22 SIMD x 16 processeurs de threads x 4 ALU). Elle perd également quatre unités de texture par moteur SIMD, se contentant donc de 88 au lieu des 96 de sa grande sœur. AMD n’a toutefois pas modifié le back-end de la puce : nous avons donc toujours les 32 ROP de la HD 6970 (et de la HD 5870, d’ailleurs). Même chose pour la mémoire, qui reste à 2 Go, bien que la firme nous ait confirmé que certains de ses partenaires planchaient sur des versions 1 Go. Les fréquences diminuent, par contre : le core de la HD 6950 retombe à 800 MHz, et sa mémoire à 1250 MHz, ce qui lui donne un débit de 5000 MT/s et une bande passante de 160 Go/s.

Cette diminution des ressources actives ne réduit absolument pas la consommation au repos (qui reste donc coincée à 20 watts), mais est censée faire baisser le coefficient PowerTune à 200 watts et donc la consommation typique dans les jeux à 140 watts. Un écart théorique de 50 watts avec la HD 6970, donc. Nos tests en laboratoire (voir plus loin dans cet article) nous montrent plutôt un écart de 42 watts entre les deux cartes, mais nous n’allons pas pinailler.

Aspect extérieur

Physiquement parlant, la Radeon HD 6970 et la HD 6950 sont pratiquement identiques : elles mesurent toutes deux près de 28 cm de long, soit environ 2,5 cm de plus que la Radeon HD 6870 et un bon centimètre de plus que la GeForce GTX 580/570.

La Radeon HD 6970 a besoin de deux connecteurs d’alimentation auxiliaires, un à huit broches et un à six broches. Moins gourmande, la HD 6950 peut se contenter de deux connecteurs à dix broches. Mis à part cela, elles affichent les mêmes sorties vidéo et les mêmes ponts CrossFire (au nombre de deux) permettant de faire fonctionner jusqu’à quatre cartes simultanément. Comme les cartes des générations précédentes, les nouvelles Radeon emploient un dissipateur thermique à chambre de vaporisation (technologie que Nvidia a adoptée sur ses derniers produits). Les performances acoustiques sont de ce fait impressionnantes : en configuration mono-carte, c’est à peine si on entend le ventilateur, même en charge.

Dernier élément intéressant ajouté par AMD : un commutateur situé juste à coté des connecteurs CrossFire. Les deux Radeon HD 6900 sont en effet dotés de deux BIOS, l’un verrouillé par AMD et l’autre moddable ; ce commutateur permet de passer de l’un à l’autre.Alors certes, la plupart des utilisateurs ne flasheront jamais le BIOS de leur carte vidéo, mais pour ceux qui désirent le faire, cela constitue une option des plus pratiques.

Configuration de test et benchmarks

| Configuration de test | |

|---|---|

| Processeurs | Intel Core i7-980X (Gulftown) 3,33 GHz overclocké à 3,73 GHz (28 x 133 MHz), LGA 1366, QPI 6,4 GT/s, 12 Mo de cache L3 partagé, Hyper-Threading activé, fonctions d’économie d’énergie activées |

| Carte-mère | Gigabyte X58A-UD5 (LGA 1366) Intel X58/ICH10R, BIOS FB |

| Mémoire | 6 Go (3 x 2 Go) de DDR3-2000 Kingston, KHX2000C8D3T1K3/6GX @ 8-8-8-24 et 1,65 V |

| Disque dur | Intel SSDSA2M160G2GC 160 Go SATA 3 Gbit/s |

| Cartes graphiques | AMD Radeon HD 6970 2 Go |

| AMD Radeon HD 6950 2 Go | |

| Nvidia GeForce GTX 570 1,25 Go | |

| Nvidia GeForce GTX 580 1,5 Go | |

| Nvidia GeForce GTX 480 1,5 Go | |

| Nvidia GeForce GTX 470 1,25 Go | |

| 2 x Zotac GeForce GTX 460 1,5 Go en SLI | |

| 2 x AMD Radeon HD 6850 1 Go en CrossFire | |

| AMD Radeon HD 5970 2 Go | |

| AMD Radeon HD 5870 1 Go | |

| AMD Radeon HD 6870 1 Go | |

| Alimentation | Cooler Master UCP-1000 watts |

| Logiciels et pilotes | |

| OS | Windows 7 Édition Intégrale 64 bits |

| DirectX | DirectX 11 |

| Pilotes graphiques | AMD 8.79.6.2RC2_Dec7 (pour les Radeon HD 6970 et 6950) |

| AMD Catalyst 10.10d | |

| AMD Catalyst 10.10e (pour les Radeon HD 6850 1 Go en CrossFire) | |

| Nvidia GeForce 263.09 (pour la GTX 570) | |

| Nvidia GeForce 260.99 (pour les GTX 480 et 470) | |

| Nvidia GeForce 262.99 (pour la GTX 580) | |

Ce comparatif est l’un des plus étendus que nous ayons jamais publié : au total, il compte deux Radeon HD 6970, deux Radeon HD 6950, deux Radeon HD 6870, deux Radeon HD 6850, une Radeon HD 5970, une Radeon HD 5870, deux GeForce GTX 580, une GeForce GTX 480, deux GeForce GTX 570, une GeForce GTX 470 et deux GeForce GTX 460. Si nous comptons bien, cela représente plus de 47 milliards de transistors sur notre banc d’essai.

Cette profusion de modèles découle des commentaires de nos lecteurs, tant au bas de l’article que sur Twitter. N’hésitez pas à faire des commentaires constructifs ; si nous en avons la possibilité, nous répondrons à vos demandes. C’est notamment pour cette raison que nous avons ajouté le SLI de GeForce GTX 460, à titre de référence, et que nous avons procédé à des tests plus poussés en CrossFire/SLI, avec analyse de l’évolution des performances.

| Jeux | |

|---|---|

| Lost Planet 2 | Paramètres de qualité maximum, AA désactivé, MSAA 8x / AF 16x, vsync off, 1680×1050 / 1920×1200 / 2560×1600, DirectX 11, version Steam |

| Just Cause 2 | Paramètres de qualité maximum, AA désactivé / AF 16x, vsync off, 1680×1050 / 1920×1200 / 2560×1600, filtre Bokeh et eau GPU désactivés (pour les cartes Nvidia), benchmark Concrete Jungle |

| Metro 2033 | Paramètres de qualité moyens, AAA, MSAA 4x / AF 16x, 1680×1050 / 1920×1200 / 2560×1600, benchmark intégré, version Steam |

| DiRT 2 | Paramètres de qualité Ultra High, AA 4x / AF désactivé, 1680×1050 / 1920×1200 / 2560×1600, version Steam, benchmark scripté personnalisé, rendu DirectX 11 |

| Aliens Vs. Predator Benchmark | Paramètres de qualité maximum, SSAO, AA désactivé / AF 16x, vsync off, 1680×1050 / 1920×1200 / 2560×1600 |

| Battlefield: Bad Company 2 | Paramètres de qualité personnalisés (maximum), MSAA 8x / AF 16x, 1680×1050 / 1920×1200 / 2560×1600, cinématique d’introduction, séquence de 145 secondes, FRAPS |

| 3DMark Vantage | Performance Default, PPU désactivé |

| HAWX 2 | Paramètres de qualité maximum, AA 8x, 1920×1200, version boîte, benchmark intégré, tessellation activée/désactivée |

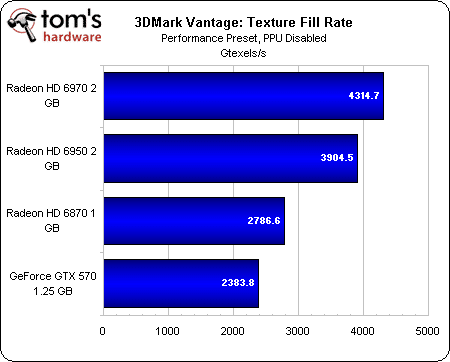

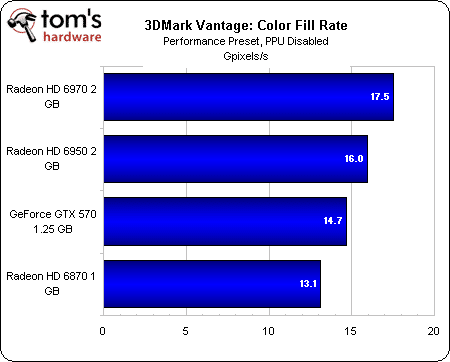

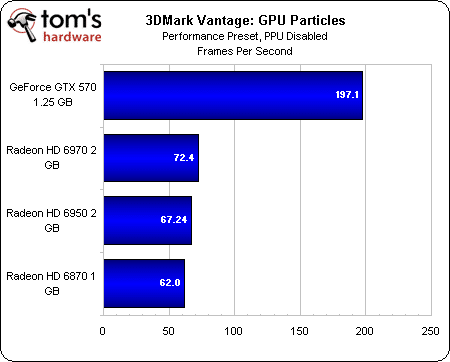

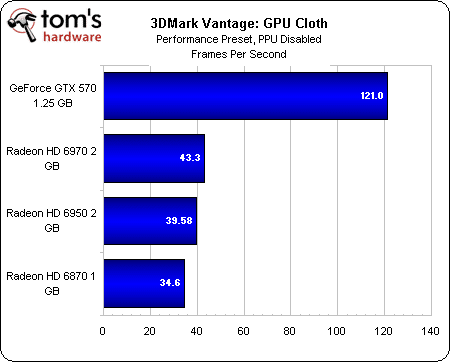

3DMark Vantage

Score global

3DMark Vantage n’est ici présent que pour référence, pour les aficionados du soft qui veulent comparer leur résultat. Mais aucune autre interprétation n’en est à faire. Voici également les résultats des tests synthétiques.

Fillrate textures

Fillrate couleurs

Pixel Shader complexe

Tissu GPU

Particules GPU

Pixel Shader mathématique

Metro 2033

1680 x 1050

1920 x 1200

2560 x 1600

Metro 2033 a posé pas mal de problèmes à AMD lors de sa sortie en mars dernier. Depuis lors, cependant, la société est parvenue à améliorer nettement les performances de ses cartes dans ce jeu : bien que la première place soit octroyée à la GeForce GTX 580 dans toutes les résolutions, le CrossFire de Radeon HD 6850 parvient à se hisser en deuxième place en 2560×1600.

La Radeon HD 6970 obtient des résultats plutôt mitigés : moins puissante que la GeForce GTX 570 en 1680×1050 et en 1920×1200, elle se rattrape en 2560×1600 au point de dépasser le SLI de GeForce GTX 460 1 Go. Le problème est sans doute que pour le prix de la HD 6970, il est possible d’acheter une paire de HD 6850 en CrossFire. Alors certes, la solution à une carte est plus élégante, mais qui a dit que performances rimait avec finesse ?

Annoncée à 270 €, la Radeon HD 6950 nous apparaît tout de suite un peu plus attrayante, dans la mesure où elle fait mieux que la HD 5870 dans toutes les résolutions et s’approche de la GeForce GTX 570 (plus chère) en 2560×1600.

On remarque par ailleurs que les résultats obtenus par les cartes graphiques AMD varient un peu selon la résolution. Il semblerait que certaines d’entre elles, comme la Radeon HD 5970 par exemple, soit particulièrement limitées par le CPU à basse résolution et ne montrent réellement ce dont elles sont capables que lorsque la charge de travail augmente. Même constat pour les HD 6850 en CrossFire.

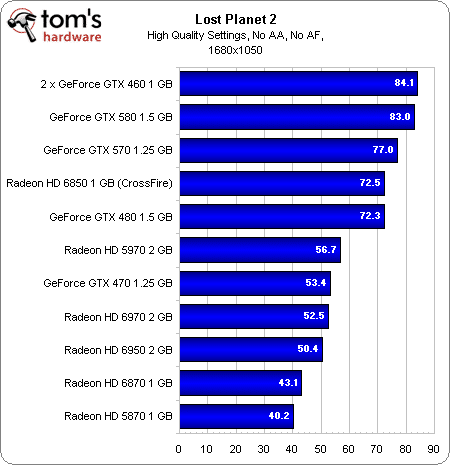

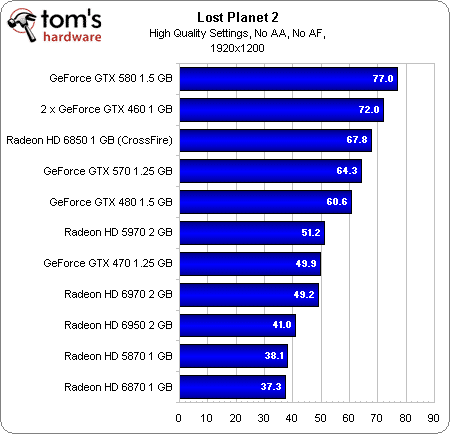

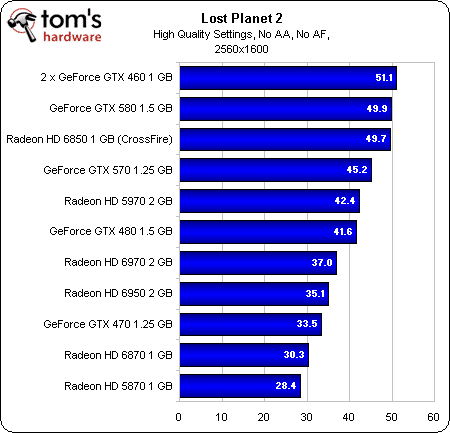

Lost Planet 2

1680 x 1050

1920 x 1200

2560 x 1600

Notre batterie de tests contient à la fois des titres soutenus par AMD et par Nvidia. Lost Planet 2 entre dans la deuxième catégorie, comme le suggèrent les résultats obtenus par les GeForce GTX 580 et 460 en SLI. Cela n’empêche toutefois pas le CrossFire de Radeon HD 6850 de se retrouver dans le peloton de tête, et même de faire mieux que la GeForce GTX 570 et pratiquement aussi bien que la GTX 580 en 2560×1600.

La Radeon HD 6970 se trouve un peu plus bas dans le classement, quelque part entre la Radeon HD 5970 et la GeForce GTX 480. Ses performances ne sont donc pas mauvaises en soi, mais quand on voit le prix et les résultats du CrossFire de HD 6850, on se demande un peu pourquoi on opterait pour cette carte.

Nous notons également avec intérêt que la Radeon HD 6950 affiche un framerate très proche de celui de la HD 6970. Étant donné les 60 € qui les séparent, la première offre donc un rapport performances/prix nettement plus élevé ; elle fait même mieux que la Radeon HD 5870.

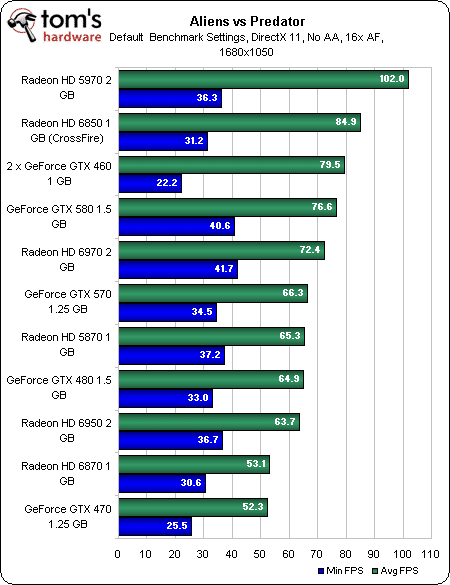

Aliens vs Predator

1680 x 1050

1920 x 1200

2560 x 1600

La Radeon HD 5970 distance toutes ses concurrentes, mais vu son prix, ce n’est pas nécessairement la carte que nous recommanderions pour ce titre ; pour une centaine d’euros de moins, il est en effet possible de se monter deux Radeon HD 6850 en CrossFire et d’obtenir des performances tout à fait respectables.

La Radeon HD 6970, quant à elle, permet d’obtenir un framerate supérieur à celui de la GeForce GTX 570 et pratiquement aussi élevé que celui de la GeForce GTX 580 (qui coûte tout de même près de 500 €).

Comme on pouvait s’y attendre, la Radeon HD 6950 dépasse la HD 6870, mais elles se font toutes deux battre par la HD 5870, ce qui est assez intéressant vu le prix de cette dernière. Apparemment, cette carte a bien mieux vieilli que la GeForce GTX 480 (sortie à peu près en même temps), dont le tarif paraît soudain sacrément exagéré.

Battlefield: Bad Company 2

1680 x 1050

1920 x 1200

2560 x 1600

Dans Battlefield: Bad Company 2, les AMD Radeon HD 6850 en CrossFire se montrent les plus rapides et se paient même le luxe de dépasser les 60 images/s en 2560×1600. Leur framerate minimum (42 images/s) est aussi amplement suffisant pour jouer, même avec le MSAA en 8x et l’AF en 16x. Les GeForce GTX 460 en SLI ne se débrouillent pas mal non plus, mais leur framerate minimum est moins attrayant, dans la mesure où il peut poser un problème de jouabilité lors des passages les plus exigeants de ce titre.

Du côté des configurations à une seule carte, la plus rapide est la Radeon HD 5970, qui dépasse même la GeForce GTX 580. Mais comme les configurations à deux cartes sont moins cher, il serait difficile de la recommander, à moins bien sûr que vous ne disposiez que d’un seul emplacement dans votre ordinateur.

La Radeon HD 6970 s’en tire avec les honneurs, se faisant devancer par la GeForce GTX 570 en 1680×1050 et en 1920×1080, mais se rattrapant en 2560×1600, où elle déborde de peu les GeForce GTX 570 et GTX 480.

En moyenne, la Radeon HD 6950 est à peu près aussi rapide que la Radeon HD 5870. Nous pouvons donc d’ores et déjà annoncer que cette carte de milieu de gamme est au niveau de l’ancien fer de lance mono-GPU d’AMD.

DiRT 2

1680 x 1050

1920 x 1200

2560 x 1600

Étonnant : alors que DiRT 2 était l’un des titres phares avancés par AMD lors du lancement de sa Radeon HD 5870, les GeForce GTX 580 et 570 y surpassent aujourd’hui la Radeon HD 6970. Les configurations les plus rapides sont le SLI de GeForce GTX 460, le CrossFire de Radeon HD 6850 et la GeForce GTX 580, mais le prix de cette dernière ne la rendra séduisante que pour les utilisateurs n’ayant pas la possibilité de consacrer quatre emplacements à une configuration en deux CG.

La Radeon HD 6970 se situe entre les GeForce GTX 470 et 480, rattrapant presque cette dernière en 2560×1600. Malheureusement, la GeForce GTX 570 est encore plus rapide, ce qui lui confère un rapport performances/prix un peu plus intéressant.

Radeon HD 6950 se positionne quant à elle derrière la HD 5870, si ce n’est en 1680×1050. Des résultats qui se montrent assez cohérents avec les prix constatés.

Just Cause 2

1680 x 1050

1920 x 1200

2560 x 1600

Seules deux concurrentes se démarquent vraiment dans Just Cause 2 : la Radeon HD 5970 et le CrossFire de Radeon HD 6850. Au vu du prix respectifs de ces deux configurations, il paraît évident qu’il vaut mieux privilégier la seconde, pour autant que vous disposiez de suffisamment d’emplacements libres sur votre carte-mère.

La GeForce GTX 580 se place en troisième position, mais une fois encore, deux GeForce GTX 460 1 Go en SLI coûteront probablement une centaine d’euros de moins.

La Radeon HD 6970 se retrouve à nouveau au milieu du classement, quelque part entre la GeForce GTX 480 et la GTX 570. Comparé à la première, qui est vraiment beaucoup trop chère et mérite d’être évitée à tout prix, elle se débrouille donc plutôt bien, voire très bien. Par rapport à la seconde, par contre, dont le tarif n’est pas tellement plus élevé, elle aura sans doute fort à faire.

Vers le bas du classement, la Radeon HD 6950 se mesure une fois de plus à la Radeon HD 5870.

CrossFire/SLI : 3DMark Vantage

Configurations à deux cartes : la question du prix

Avant d’entamer cette analyse des performances en SLI et CrossFire, parlons tarifs. À chaque fois que vous constatez un écart de prix entre deux cartes, il convient fort logiquement de le doubler pour obtenir une configuration correspondante en SLI ou en CrossFire, ce qui ne facilite pas les comparaisons. Quoi qu’il arrive, il s’agit là d’une question qu’il faudra examiner de près avant tout achat.

3DMark Vantage : score global

Le graphique ci-dessus montre bien les limites des benchmarks synthétiques comme 3DMark Vantage. Selon celui-ci, en effet, la configuration la plus rapide serait le SLI de GeForce GTX 570, suivi des deux CrossFire de Radeon HD 6900, avec le CrossFire de Radeon HD 6870 fermant la marche. Malheureusement (pour ce benchmark), cela ne se passe pas du tout comme cela dans les jeux.

Fillrate textures

Fillrate couleurs

Pixel Shader complexe

Particules GPU

Tissu GPU

Pixel Shader mathématique

CrossFire/SLI : Metro 2033

1680 x 1050

1920 x 1200

2560 x 1600

En 1680×1050, les Radeon HD 6950 arrivent presque au niveau des GeForce GTX 570, nettement plus onéreuses. Les HD 6970, mais peut-être pas suffisamment pour justifier leur prix. Après tout, ce n’est pas comme si elles vous permettaient d’obtenir une meilleure résolution que les autres produits.

En 1920×1200, les HD 6950 dépassent les GeForce GTX 570, en partie grâce à leur mémoire plus importante. L’écart se creuse en 2560×1600, mais à ce niveau, les framerates obtenus ne permettent plus jouer convenablement.

Performances en CrossFire/SLI (en % des performances avec une seule carte)

Afin de jauger l’apport des configurations à deux cartes dans ce titre décidément très exigeant, nous avons procédé à un deuxième test avec à chaque fois la carte unique correspondante. Les paramètres de qualité visuelle sont réglés sur Very High, le MSAA sur 4x et l’AF sur 16x.

Il apparaît clairement que la mémoire de la Radeon HD 6870 (1 Go seulement) l’empêche de s’exprimer pleinement en CrossFire, ce qui explique le faible écart avec les performances constatées en configuration à une seule carte. Les autres modèles, par contre, disposent de suffisamment de mémoire pour faire de Metro 2033 un titre relativement plus fluide en 2560×1600.

Le vrai choc provient des résultats obtenus par les cartes de la série Radeon HD 6900 en CrossFire, qui font toutes deux mieux que le SLI de GeForce GTX 570.

Nous avons posé quelques questions à AMD concernant le CrossFire. Selon ses dires, la société n’a apporté aux Radeon HD 6800 aucun changement susceptible d’améliorer leur comportement en CrossFire par rapport aux Radeon HD 5870, comme beaucoup l’avaient suggéré suite à notre test des HD 6800. Par contre, elle a apporté à ses pilotes quelques adaptations censées augmenter les performances des Radeon HD 6900. C’est probablement ce que nous voyons à l’œuvre dans ce test.

AMD nous a confié que ces adaptations seront portées sur les Radeon HD 6800 lors d’une future mise à jour des pilotes. Pour l’instant, cependant, les HD 5800 et HD 6800 devraient montrer des écarts de performances comparables entre les configurations à une et deux cartes, tandis que les HD 6900 continueront à se démarquer.

CrossFire/SLI : AvP

1920 x 1200

2560 x 1600

Aliens vs. Predator n’est pas aussi gourmand que Metro 2033 et, en 2560×1600, ne fait pas autant appel à la mémoire de la carte graphique, raisons pour lesquelles les Radeon HD 6870 s’en tirent nettement mieux que dans le benchmark précédent.

Les Radeon HD 6950 et les GeForce GTX 570 sont quant à elles à égalité presque parfaite en milieu de classement, tandis que les Radeon HD 6970 prennent une avance confortable. Les HD 6870 ferment la marche, évidemment, mais nous offrent tout de même un framerate relativement jouable en 2560×1600.

Performances en CrossFire/SLI (en % des performances avec une seule carte)

Les cartes AMD confirment ce que nous a dit la société concernant les améliorations apportées aux pilotes en CrossFire et voient leurs performances pratiquement doublées dans ce mode en 2560×1600. Nvidia s’en tire avec les honneurs, mais ce sont les Radeon HD 6950 et HD 6970 qui affichent les meilleurs scores.

Notons que les Radeon HD 6870 ne s’en tirent pas mal du tout, mais il est clair qu’elles ne bénéficient pas encore des pilotes optimisés dont jouissent les HD 6900.

CrossFire/SLI : Battlefield: Bad Company 2

1680 x 1050

1920 x 1200

2560 x 1600

Cela commence à devenir répétitif : les deux Radeon HD 6970 arrivent en première place dans les trois résolutions, suivies des HD 6950 et des GTX 570, ou l’inverse selon la résolution. Les AMD Radeon HD 6870 en CrossFire nous offrent quant à elles des performances jouables, mais nettement inférieures à celles affichées par les autres configurations.

Performances en CrossFire/SLI (en % des performances avec une seule carte)

Le graphique ci-dessous nous confirme que nous avons bien fait de choisir une résolution de 2560×1600 pour comparer les performances des configurations à deux cartes avec celles des configurations à une carte. Après tout, si vous êtes prêts à mettre entre 500 et 800 € pour une paire de cartes graphiques, il y a des chances pour que vous ayez déjà un écran 30 pouces ou un trio de 23 pouces en AMD Eyefinity ou en Nvidia Surround. Le fait que nous observions encore des framerates de l’ordre de 80 à 90 images/s montre bien à quel point ces configurations en ont sous le capot.

Une fois de plus, les Radeon HD 6900 font des prouesses : les HD 6950 voient leurs performances plus que doubler et les HD 6970 font à peine moins bien que les GeForce GTX 570. Les Radeon HD 6870 et leur petit gigaoctet de mémoire s’en tirent toutefois moins bien.

CrossFire/SLI : DiRT 2

1680 x 1050

1920 x 1200

2560 x 1600

Le classement en SLI/CrossFire sous DiRT 2 correspond, pour la première fois, à celui prévu il y a quelques pages par 3DMark Vantage, avec Nvidia en tête et la Radeon HD 6970 en seconde position.

Comme dans tous les benchmarks jusqu’à présent sauf Metro 2033, les performances obtenues permettent de jouer confortablement quelle que soit la paire de cartes, même les Radeon HD 6870. Rappelons qu’il n’est probablement pas nécessaire de monter une configuration de ce type pour jouer à DiRT 2, à moins d’avoir trois écrans en Eyefinity ou en Surround.

Performances en CrossFire/SLI (en % des performances avec une seule carte)

Nvidia arrive peut-être en tête de ce classement, mais l’écart de performances entre la configuration à une seule carte et le SLI est moins intéressant que celui proposé par les cartes AMD.

CrossFire/SLI : Just Cause 2

2560 x 1600

Les AMD Radeon HD 6970 et 6950 finissent en première et deuxième places dans les trois résolutions, suivies des GeForce GTX 570 et des Radeon HD 6870.

En 1680×1050, les GTX 570 et les HD 6870 affichent des performances similaires, mais les 6870 ne parviennent pas à se maintenir lors de la montée en résolution ; à l’inverse, les cartes Nvidia se rapprochent peu à peu des Radeon HD 6950.

Performances en CrossFire/SLI (en % des performances avec une seule carte)

AMD continue à faire montre de beaux écarts de performances dans ce benchmark : nous ne sommes pas tout à fait à un doublement de la vitesse, mais le gain de 90 % est clairement appréciable, surtout quand on le compare aux 74 % apportés par Nvidia avec ses GTX 570.

Lost Planet 2

Avant de clôture cette section de notre article, un petit mot sur l’absence de Lost Planet 2 : il n’est en effet pas possible d’activer le MSAA 8x avec les cartes Nvidia dans ce jeu, la société ne proposant que le CSAA. La comparaison n’aurait donc pas été juste.

Consommation et bruit

Consommation à la prise (Metro 2033)

Le profil de consommation des nouvelles AMD Radeon HD 6900 est très proche de celui des cartes existantes, du moins dans notre test consistant à exécuter trois fois, en boucle, un benchmark sous Metro 2033 en 2560×1600 avec les paramètres de qualité visuelle réglés sur Very High, le MSAA sur 4x et le filtrage anisotropique activé. Sur ce plan, la Radeon HD 6970 est très semblable à la GeForce GTX 570 et la Radeon HD 6950 ressemble fort à la HD 5780.

Cette impression initiale est confirmée par les moyennes : la consommation moyenne à la prise de notre système de test est de 321 watts avec la Radeon HD 6970, tandis que la GTX 570 consomme 329 watts ; les 279 watts de la Radeon HD 6950 sont quant à eux bien proches des 274 watts de la HD 5870.

Au repos, les Radeon HD 6900 voient leurs fréquences diminuer à 250 MHz pour le GPU et à 150 MHz pour la mémoire, ce qui permet évidemment de réaliser de belles économies d’énergie.

Bruit

Après la débâcle de la GeForce GTX 480, Nvidia s’est rattrapée en contrôlant mieux les caractéristiques thermiques et acoustiques de ses cartes haut de gamme suivantes, les GTX 580 et 570 : celles-ci sont à la fois parmi les plus performantes et les moins bruyantes des cartes testées aujourd’hui.

Chez AMD, les Radeon HD 6970 et 6950 font également très bien dans ce domaine. Bien que les GeForce GTX 570 restent les cartes les plus silencieuses de ce comparatif, les HD 6950 ne sont pas loin derrière. Et il y a bien quelques configurations qui se hissent devant la HD 6970 en matière de silence, mais il faut avouer que celle-ci saura rester très discrète.

Un bémol toutefois (qui s’applique en réalité à tous les ordinateurs destinés au jeu) : en CrossFire, il est vivement recommandé d’espacer au maximum les cartes, c’est-à-dire d’au moins trois emplacements, afin de laisser l’air circuler le plus librement possible. Si vous les placez côte-à-côte, attendez-vous à des nuisances sonores nettement plus marquées : dans une telle configuration (vraiment pas recommandée), nous avons mesuré 53,9 dB(A) sur notre paire de Radeon HD 6970, contre 49,6 dB(A) sur le SLI de GeForce GTX 570. Certes, nous avons indiqué à plusieurs reprises dans cet article que les configurations à deux cartes occupaient quatre emplacements, mais il est en fait plus réaliste de parler de cinq.

Conclusion

Le fait qu’AMD mette sa nouvelle carte étalon en concurrence avec la deuxième carte du classement Nvidia constitue probablement une triste surprise pour les fans de la société. Une surprise accentuée par le nom de cette carte, qui est incroyablement trompeur au regard de ses capacités, réelles comme annoncées. Tout de même, une Radeon HD 6970 présentée, d’emblée, comme moins puissante que la Radeon HD 5970, c’est le monde à l’envers !

Si Nvidia avait lancé une GeForce GTX 580 moins rapide que la GTX 480, et qui plus est avait eu la témérité de l’annoncer officiellement par une diapositive comme celle-ci-dessus, cela aurait probablement été la fin du monde. Quoi qu’il en soit, nous attendons maintenant une Radeon HD 6990. Prévue pour le premier trimestre de l’an prochain, il s’agira d’une carte bi-Cayman nommée Antilles qui se comportera probablement comme une paire de Radeon HD 6950 en CrossFire, pour autant qu’AMD ne soit pas obligé de réduire les fréquences à cause de la consommation. Espérons que la technologie PowerTune permettra d’éviter un tel retour en arrière.

Si cette carte sort comme prévu, elle battra enfin la Radeon HD 5970. Personne n’a encore d’informations concernant le prix, mais si AMD l’arme de 4 Go de GDDR5, elle sera chère. Après tout, si la firme se contentait de 2 x 1 Go de mémoire, la carte souffrirait de ralentissements dans les résolutions élevées, c’est-à-dire exactement là où elle est censée dominer.

La situation actuelle

Commençons par la Radeon HD 6950. S’il est vrai que cette carte apporte une meilleure prise en charge de DirectX 11, permet de brancher quatre écrans simultanément et accélère la lecture des Blu-ray 3D, il est difficile d’oublier les remises de prix que l’on peut actuellement trouver sur la Radeon HD 5870, voire sur la GeForce GTX 470. Certes, cette dernière ne s’en tire pas aussi gracieusement à haute résolution, mais elle est parfaitement suffisante pour jouer en 1920×1080. Ces deux cartes sont en fin de vie, mais d’ici à ce qu’elles aient totalement disparu des étals, elles constituent de bonnes affaires. Opter pour les technologies de l’an dernier, qui dans ce cas précis sont encore tout à fait modernes, est une bonne manière d’économiser de l’argent.

La Radeon HD 6970, par contre, mériterait presque d’être vendue une vingtaine d’euros plus cher que la GeForce GTX 570. Dans l’ensemble, les deux cartes se valent sur le plan des performances, la première étant généralement plus rapide en 2560×1600 et la seconde faisant légèrement mieux en 1680×1050. Mais rien que par ses sorties vidéo, la HD 6970 est une véritable affaire.

N’oublions toutefois pas que pour le prix d’une HD 6970, on peut se monter un CrossFire de Radeon HD 6850. Celles-ci possèdent les mêmes sorties vidéo, l’UVD3 et le MSAA, mais sont, une fois associées, plus rapides. Bref, si vous avez la place pour deux cartes sur votre carte-mère, c’est la solution à adopter. Ou bien nous pourrions aussi recommander, pour un coût à peine supérieur, une paire de GeForce GTX 460, qui serait plus rapide dans certains domaines et plus lente dans d’autres.

Les Radeon HD 6900 en CrossFire

Ce n’est pas tout : quid des Radeon HD 6900 en CrossFire ? AMD affirme en effet avoir fait quelques belles avancées dans ce domaine.

Une configuration à deux cartes haut de gamme n’a de sens que si vous jouez en résolution maximale avec les détails visuels à fond. C’est là que les 2 Go de mémoire des deux cartes de la série HD 6900 se montrent réellement utiles. Dans la plupart des cas, la paire de Radeon HD 6950 s’en sort mieux que celle de GeForce GTX 570, pourtant bien plus chères. Il est difficile d’employer les mots « rapport qualité/prix » lorsqu’on voit l’addition, mais à ce niveau, votre argent sera mieux investi dans les cartes AMD.

Il est sans aucun doute intéressant de jeter un coup d’œil aux écarts de performances entre les configurations à une et à deux cartes graphiques. Historiquement, le SLI a toujours été la référence dans ce domaine, mais aujourd’hui, c’est AMD qui se place en pole position.