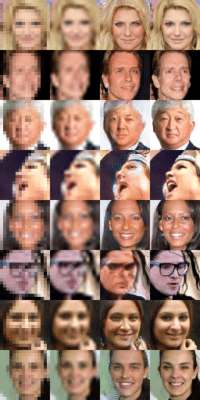

« srez » exploite la puissance de l’apprentissage automatique à l’aide d’une carte graphique grand public et un simple programme en Python. Cette branche de l’intelligence artificielle n’est clairement plus réservée aux supercalculateurs.

L’apprentissage automatique sur son PC

Le programme est petit avec seulement 200 lignes de codes pour le fichier principal et 100 lignes pour le système d’entraînement. Il est écrit en Python 3 et repose sur Tensorflow, la bibliothèque optimisée pour l’apprentissage automatique. Il est donc très symbolique puisqu’il montre qu’il est possible d’utiliser une carte graphique grand public et des outils relativement faciles à maîtriser pour profiter d’une puissance qui était réservée à des supercalculateurs il y a seulement quelques années.