Nous sommes allés examiner le prototype d’une machine ultra-puissante destinée à l’intelligence artificielle dans les labos de PNY à Bordeaux. Une machine nommée AIRI (Artificial Intelligence Ready Infrastructure) conçue avec NVIDIA, Pure

Un petit monstre qui ronronne fort

Nous sommes allés examiner le prototype d’une machine ultra-puissante destinée à l’intelligence artificielle dans les labos de PNY à Bordeaux. Une machine nommée AIRI (Artificial Intelligence Ready Infrastructure) conçue avec NVIDIA, Pure Storage et Arista Networks. Mais la particularité de cette machine, c’est qu’elle coupe l’herbe sous le pied au DGX-2 de NVIDIA, qui relève de la même idée : monter un serveur complet d’apprentissage dans un volume minimal, avec un maximum de puissance et d’efficacité. Voilà un petit tour d’horizon de cette machine, qui fait un bruit de tous les diables, comme vous pouvez le constater sur notre vidéo (et c’était au repos !).

Jusqu’à 4 pétaflops TensorFlow

La machine finale est présentée comme telle (photo marketing), avec jusqu’à quatre racks NVIDIA DGX-1, pour un total de 32 GPU Tesla V100, soit un nombre impressionnant de 163 840 coeurs CUDA et 20 480 coeurs Tensor. PNY annonce alors 4 pétaflops pour les applications Deep Learning TensorFlow de Google, soit un pétaflops par rack DGX-1. Notez que le DGX-2 de NVIDIA est plus puissant encore, avec des racks DGX-1 de seconde génération armés de deux fois plus de RAM HBM.

2 pétaflops inZeBox

Le prototype que nous avons pu voir regroupait deux racks DGX-1 de NVIDIA, soit 2 téraflops de puissance. On voit sur cette image le coeur de « l’intelligence » de la machine. Mais pour alimenter ces GPU en données, il faut toute une infrastructure pour relier stockage, mémoire et GPU.

Stockage de folie

Côté stockage, PNY a travaillé avec l’un des fabricants les plus avancés du moment : Pure Storage, qui a mis au point une baie FalshBlade capable d’accueillir 7 lames de stockage de 17 To de capacité chacune à très haute performance, capable de dépasser les 1 million d’IOPS. Cet accès aléatoire ultra-efficace est indispensable pour satisfaire tous les accès données exigés par les GPU.

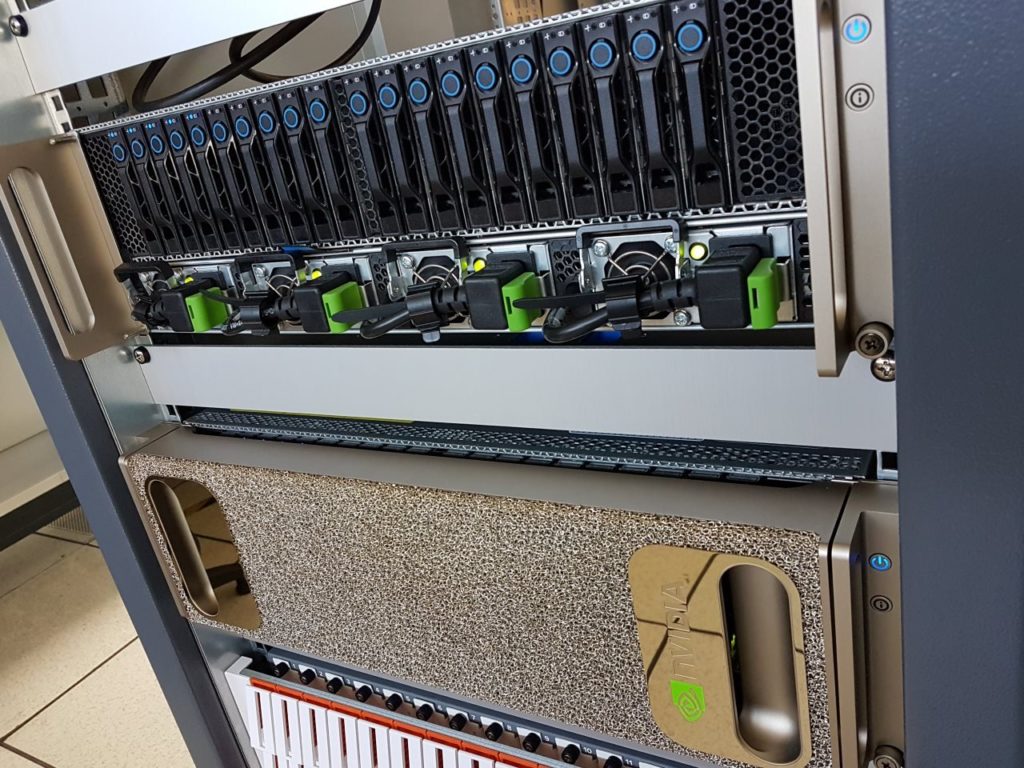

Sous le cache de NVIDIA

En retirant le cache doré de NVIDIA, on peut voir les slots de stockage et les branchements sur les quatre alimentations 1600 W nécessaires. Sur les slots visibles en façade, un rack DGX-1 ne peut qu’accueillir un maximum de 4x 1,92 To de données sur SSD, avec des performances inférieures à celle du FlashBlade. Il fallait donc passer par Pure Storage pour équiper la machine et assurer un fonctionnement autonome sur son propre stockage.

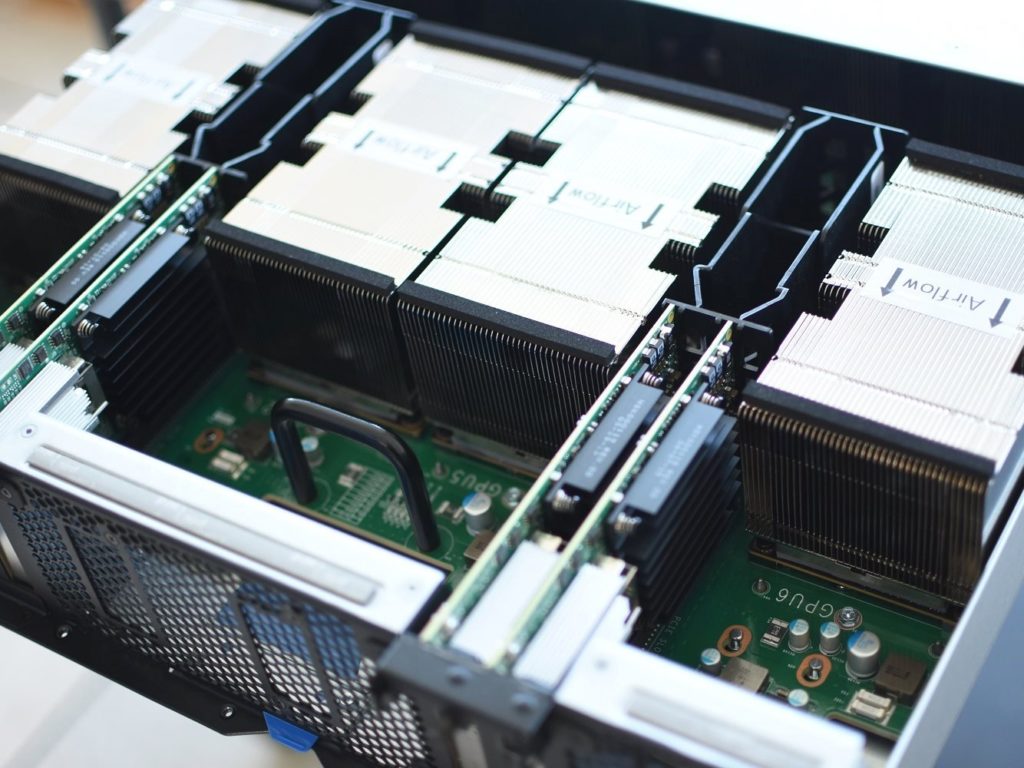

Dans un DGX-1

Cette image montre l’intérieur d’un DGX-1 en présentation lors d’un salon. On peut voir que le bruit intense de la machine est produit par les quatre grosses turbines qu’on peut voir derrière le bloc de stockage, juste avant les GPU et leur gros radiateur. Au fond, les quatre cartes InfiniBand pour connecter le rack au reste de la machine.

Zoom sur les radiateurs

Le flux d’air pulsé est aspiré en façade, projeté tout le long du rack, et passe à travers les radiateurs. Ici, on voir les vrais radiateurs sur les GPU (hors démo salon, photo prise chez PNY). Sous les GPU, une carte mère regroupe deux Xeon E5-2698 20 coeurs dans chaque rack, refroidis de la même manière.

Une lame de stockage

Dans la FlashBlade de Pure Storage, on trouve jusqu’à 7 lames de ce genre. Des énormes SSD épaulés par des processeurs ARM en guise de contrôleurs, mais aussi par un processeur Xeon et sa DRAM dédiée. Voilà comment obtenir 16 Go/s de débit et surtout 1 millions d’IOPS. Une configuration maximale avec 15 lames de 52 To peut monter à 1800 W de consommation.

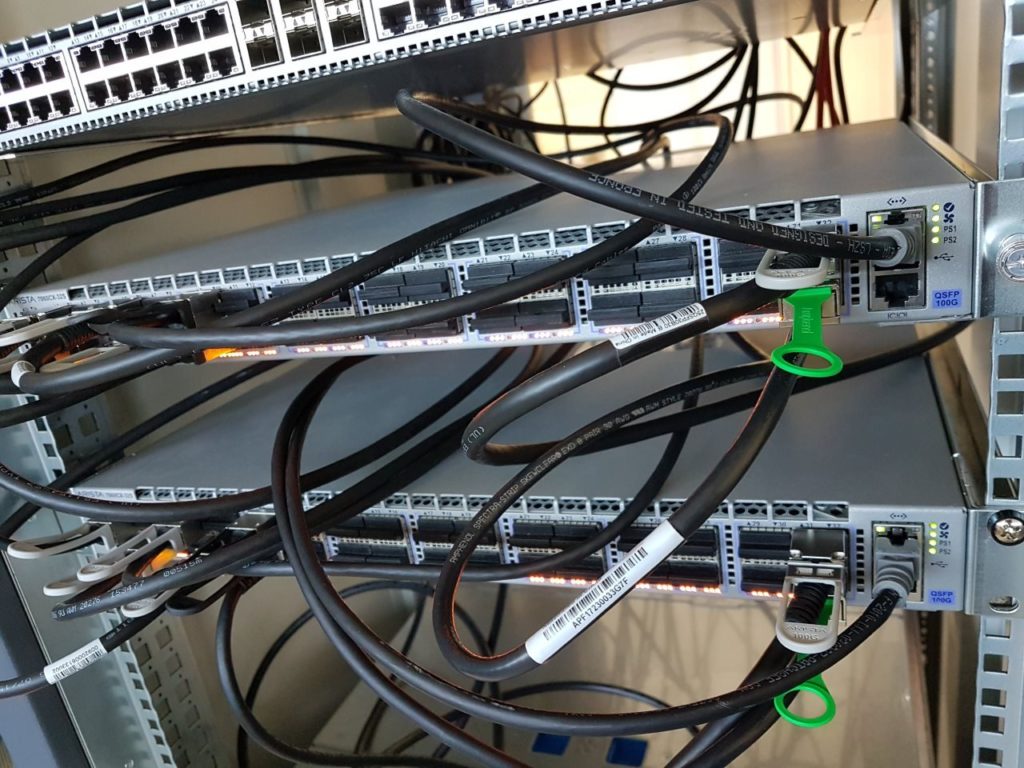

Ethernet 100 Gbit

Pour interconnecter toute cette puissance sans perte, il a fallu dépasser les 10 Gbit et passer par du 100 Gbit Ethernet fourni par les Arista Network. Avec une telle bande passante, PNY explique, test à l’appui, que les DGX-1 cumulent leur puissance avec un bon scaling, sans goulot d’étranglement, même avec quatre racks et 32 GPU. Le DGX-2 de NVIDIA monte à 300 Gbit/s.

Cable pr0n

Derrière la machine, un déluge de câbles permet de tout interconnecter, sans oublier les câbles d’alimentation, qui sont aussi très nombreux, comme on va pouvoir le voir dans le dernier slide.

Dernière gourmandise

Pour finir ce petit périple, voilà la manière donc la machine de test était branchée dans les labos de PNY. Evidemment, pour une installation plus finale, il faudra un branchement plus sérieux. Mais pour cette machine à 8000 W, cette installation électrique tenait le coup sans problème !