La 30ème édition du SuperComputing s’est tenue mi-novembre. Voici en images les stands qui ont piqué notre curiosité

Introduction

En ce mois de novembre, le salon annuel Supercomputing a fêté ses 30 ans d’existence. L’enjeu est de réunir les plus brillants spécialistes mondiaux en calcul de haute performance (on parle de HPC pour High Performance Computing) pour échanger sur les dernières technologies de pointe s’agissant de calcul intensif. Durant six jours, brèves sessions techniques en groupes restreints, présentations de travaux de recherche, tutoriels, panels et ateliers s’enchainent, sans oublier le concours de clusters réservé aux étudiants.

En parallèle, le salon regorge des dernières technologies en date pour le calcul intensif. Nous nous sommes donc rendus à Dallas pour rapporter du contenu : certaines démonstrations sont absolument incroyables comme on le verra plus loin.

Pourquoi ne pas immerger son PC ?

3M est notamment connu pour son liquide Fluorinert, lequel est utilisé pour l’immersion afin de refroidir les centres de données, comme les configurations de calcul intensif, par changement de phase. Cette fois, la marque américaine a mis en avant un prototype contenant un Core i7-7700K overclocké à 4,5 GHz sur l’ensemble de ses cores ainsi qu’une NVIDIA GTX 1080, reliée par deux tuyaux à un boitier étonnamment compact. La configuration consommait environ 250 Watts durant la démonstration et pourtant, les composants fonctionnaient dans une plage de températures très raisonnable. Ce boitier immergé ferait de l’effet sur un bureau sans pour autant être encombrant mais malheureusement, 3M n’a pas prévu de le commercialiser. Quid du bruit des bulles ?

Milan et « Volta-Next » font bon ménage

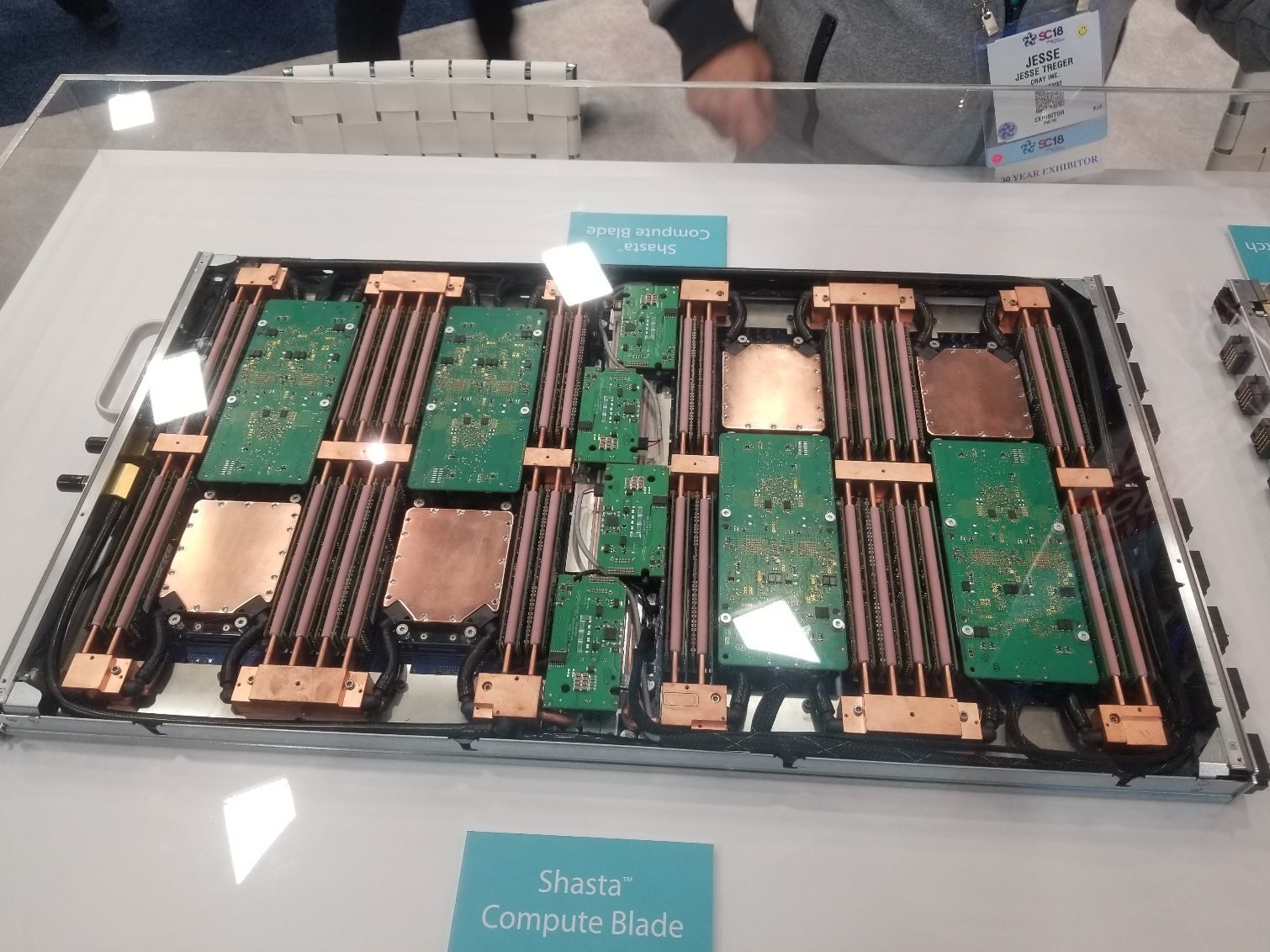

Le Shasta de Cray est un serveur lame décliné en plusieurs versions pour autant de finalités en calcul. La lame ci-contre permettra d’embarquer huit processeurs AMD Milan (basés sur Zen 3) sans dépasser les dimensions d’un rack 1U, soit 44,45 mm. Cette dernière est épaulée par des nœuds de calcul GPU et lames réseau pour former ce qui sera l’un des supercalculateurs les plus puissants au monde.

Lors du Supercomputing 2018, le département de l’Énergie américain a annoncé avoir retenu le Shasta dans une configuration associant les Milan d’AMD au successeurs de Volta chez NVIDIA pour alimenter son futur supercalculateur : Perlmutter. Ce dernier est de classe exscale, c’est-à-dire qu’il est capable d’atteindre un milliard d’opérations par seconde. Le département de l’Énergie américain prévoit de déployer Perlmutter en 2020.

Zen trouve sa voie en Chine

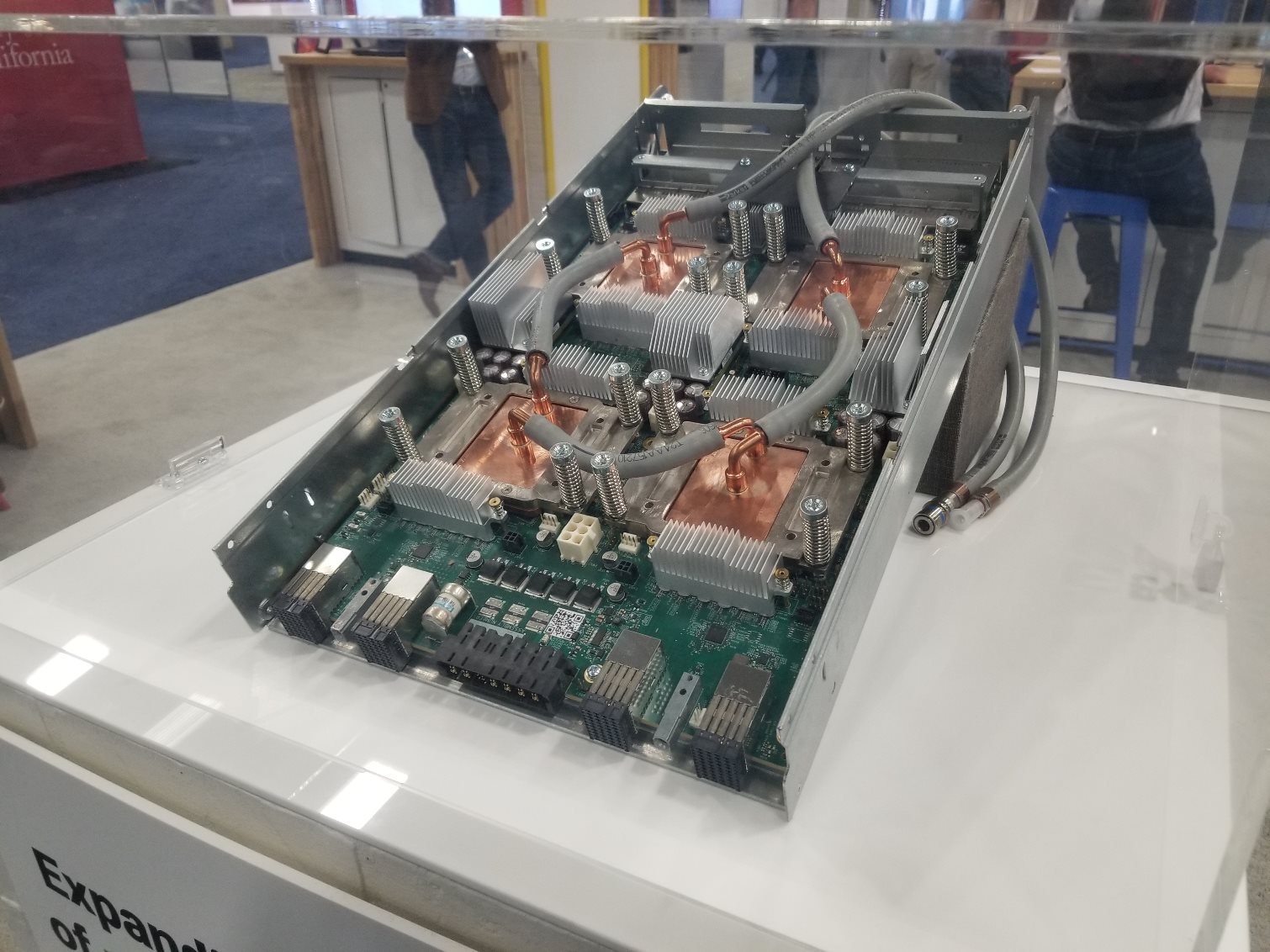

Sugon nous montre ici un serveur rack Nebula plein format, dont les unités de calcul en immersion embarquent chacune quatre NVIDIA Tesla et quatre processeurs. Ce serveur est particulièrement intéressant au motif que ses processeurs sont des Hygon Dryhana fabriqués en Chine, lesquels sont des clones des processeurs AMD EPYC.

Le refroidissement par immersion a l’avantage de proposer des performances inégalables au regard de l’encombrement, mais nécessite une infrastructure dédiée au refroidissement par changement de phase. Capable d’accueillir 42 lames, le Nebula est livré avec une seconde baie à cet effet. Comme on peut le voir dans la vidéo ci-contre, les lames proposent un système d’attache permettant un branchement/débranchement à chaud ou presque, sans les contraintes d’une tuyauterie complexe. Les différents supercalculateurs de Sugon sont représentés à 57 reprises dans le top 500 mondial en cette fin 2018.

L’ordinateur quantique d’IBM

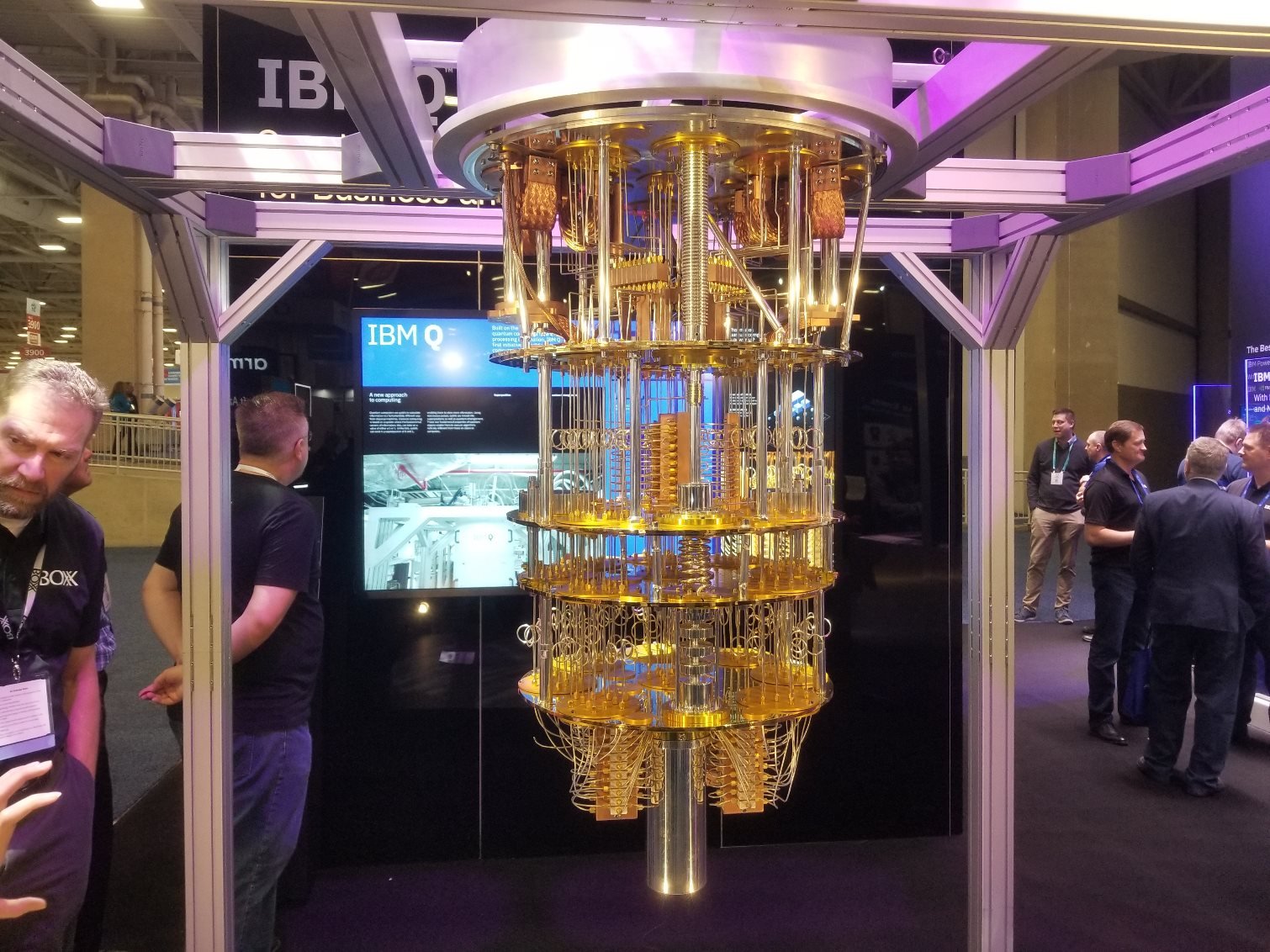

L’ordinateur quantique 50 qubits d’IBM a fait une apparition remarquée. La structure en forme de lustre assure le refroidissement des qubits regroupés sur un wafer, lequel est abrité par une cartouche située en bas de la configuration. La marque américaine utilise de l’Hélium 3 et 4 pour maintenir le sommet de l’ordinateur à 3 Kelvin, tout en sachant que plus l’on descend vers la base, plus le système de refroidissement se rafraichit.

La cartouche métallique que l’on voit sur l’image est ainsi refroidie à 0,15 millikelvins, ce qui en fait tout simplement l’entité la plus froide de l’univers lorsque cet ordinateur fonctionne. Ce froid extrême lui permet d’atteindre une puissance de calcul qui le place dans le top 10 des supercalculateurs mondiaux, mais cette puissance est pour le moins éphémère : l’ordinateur fonctionne durant 100 millisecondes. Au fur et à mesure qu’IBM le perfectionnera, chaque qubit supplémentaire apportera un gain de performances exponentiel. En d’autres termes, l’ajout d’un seul qubit suffirait à le rendre aussi puissant que deux des dix meilleurs supercalculateurs mondiaux.

EPYC partout

Autant AMD a timidement montré ses processeurs EPYC Naples lors de la précédente édition du Supercomputing, autant cette année, le géant vert s’en est donné à cœur joie. Les serveurs basés sur EPYC étaient présents sur les espaces de presque tous les fabricants de cartes mères et surtout, on les retrouvait chez plusieurs intégrateurs majeurs. HP comme Dell montraient plusieurs serveurs complets, nous rappelant au passage que l’architecture EPYC est en train de débarquer massivement dans le secteur des centres de données. D’autres succès sont à mettre à son crédit, comme sa présence dans le supercalculateur Perlmutter que nous avons évoqué un peu plus tôt. Au vu de ces éléments, il nous semble qu’EPYC s’inscrit déjà dans le long terme.

Quatre TPU dans un pod

L’été dernier, Google a annoncé la troisième version de son TPU (Tensor Processing Unit), des ASIC spécifiquement conçu par le géant de Mountain view ASIC gérer des tâches d’apprentissage automatique. Refroidie par watercooling, cette troisième version trouve sa place dans des infrastructures gigantesques baptisées « pods ». On entend dire qu’un seul d’entre eux regroupe la bagatelle de 1024 TPU V3 et d’après Google, un pod peut dépasser sans encombre les 100 pétaflops.

Google n’est pas spécialement bavard s’agissant des caractéristiques techniques, mais on sait que les TPU V3 peuvent atteindre les 420 téraflops et fonctionnent avec 128 Go de HBM.

NVIDIA T4 : Turing débarque

Le Tesla T4 s’est fait une place au sein de plusieurs serveurs Supermicro dernière génération, mais l’on s’attend surtout à ce que ce GPU à hautes performances pour l’intelligence artificielle (plus particulièrement le raisonnement) soit massivement adopté dans les centres de données. Le T4 s’appuie sur la même architecture Turing que les GeForce RTX série 20, mais il a été conçu pour les réseaux neuronaux traitant vidéo, langage, moteurs de recherche et images.

Sur le plan technique, le T4 embarque 320 cœurs Turing Tensor, 2650 cœurs CUDA et 16 Go de GDDR6 assurant une bande passante allant jusqu’à 320 Go/s. Basé sur le die TU104, le T4 se contente de 40 SM actifs sur 48 possibles de manière à respecter un profil de consommation de 75 Watts.

Le T4 gère les calculs à précision variable, comme par exemple FP32, FP16 et INT8. En outre, le GPU de NVIDIA propose également des modes de précision INT4 et INT1 (à titre expérimental), ce qui constitue une avancée notable par rapport au GPU précédent, à savoir le P4.

Allied Control : 20 NVIDIA RTX 2080 !

La société américaine a présenté une configuration refroidie par immersion abritant la bagatelle de 20 NVIDIA RTX 2080 et un serveur bi-Xeon E5. Pour arriver à ce résultat, Allied Control a utilisé des ASIC personnalisés ainsi qu’une carte mère spécifique. Les dissipateurs d’origine des RTX 2080 ont été remplacés par une plaque en cuivre d’un millimètre d’épaisseur, ce qui permet de limiter à seulement 2,5 mm l’espace entre chaque GPU. Nous sommes bien loin des dissipateurs de nos cartes graphiques !

PCIe 4.0 passe-partout

OSS (One Stop Systems) conçoit des grappes de stockage pour SSD et câbles pour GPU externes à destination d’un public très hétérogène : armée, centres de données et supercalcul. Nous avons d’ailleurs eu l’occasion de tester l’un des produits de la marque il y a quelques années dans un duel entre 32 SSD Fusion ioMemory 3,2 To contre 30 SSD Intel NVMe DC P3700.

L’industrie progresse sans arrêt : les connexions PCIe 4.0 reliant de gros boitiers abritant plusieurs cartes graphiques d’une part et périphériques de stockage d’autre part doubleront la bande passante vers la configuration hôte. OSS a conçu ce qu’elle présente comme étant le premier adaptateur PCIe 4.0 : le HIB616-x16 est une carte fille sur laquelle on vient brancher un câble optique via une prise Mini-HD SAS standard qui a été configurée pour relayer un signal PCIe. Cette prise se branche sur l’un des quatre ports de la carte fille, chacun pouvant assurer une connexion 4x entre deux appareils. Précisons que le HIB616-x16 peut également fonctionner avec des câbles en cuivre, mais dans la limite de six mètres maximum.

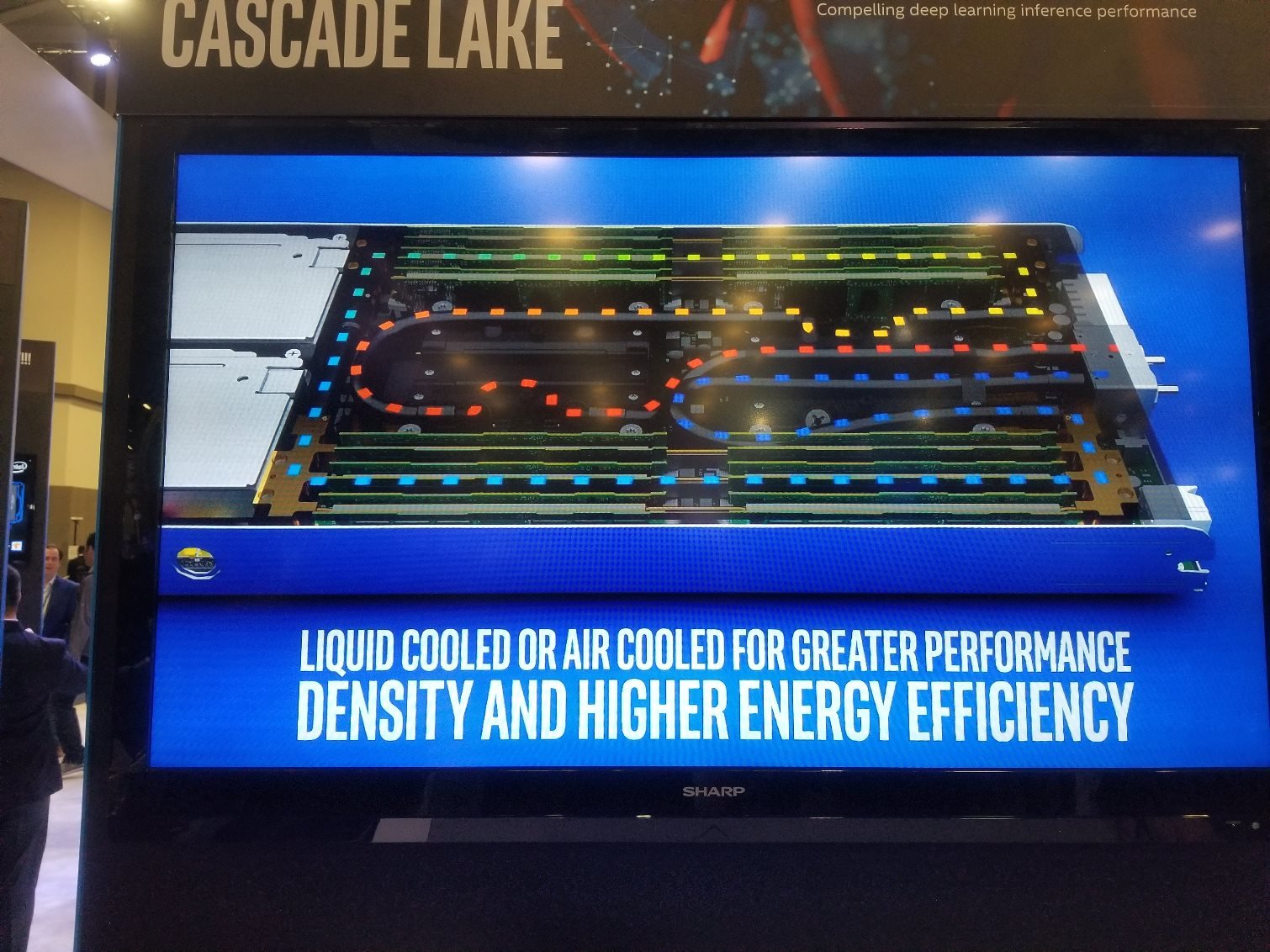

Même Intel s’est mis au MCM

L’annonce des processeurs Cascade Lake AP (AP pour Advanced Performance) quelques jours avant le Supercomputing 2018 a fait grand bruit quand bien même Intel s’est montré avare en détails. Le géant de Santa Clara a néanmoins confirmé que ses futurs processeurs s’appuient sur une conception MCM (Multi-Chip Module), c’est-à-dire plus d’un die au sein d’un processeur comme c’est déjà le cas des processeurs d’AMD.

Toujours lors de cette présentation, plusieurs sources nous ont officieusement confirmé que les modèles les plus haut de gamme (les Platinum –AP) afficheront un TDP allant jusqu’à 350 Watts : pas de salut sans watercooling pour ces modèles, ne serait-ce qu’à fréquence d’origine. Cela étant dit, les déclinaisons plus modestes pourront se contenter d’un refroidissement par air étant donné que leur TDP sera moins élevé.

Plateforme NVIDIA HGX-2

NVIDIA disposait déjà du DGX-2 que Jensen Huang a tout simplement qualifié de GPU le plus dense au monde lors du Supercomputing, mais nous avons surtout vu pléthore de nouvelles variantes du HGX-2 sur le salon. Ce dernier constitue une plateforme hyperscale (dont la priorité est l’échelonnement des performances) permettant aux partenaires de monter des supercalculateurs standardisés. A l’image du DGX-2, lequel est vendu directement par NVIDIA, le HGX-2 embarque seize GPU Tesla V100 et un demi-téraoctet de mémoire dédiée reliés entre eux par douze NVSwitches. Ceci permet d’atteindre un maximum de douze pétaflops par machine.

Le grand nombre de HGX-2 est encourageant pour NVIDIA, la firme au caméléon cherchant à affirmer sa domination en matière d’apprentissage profond au sein des centres de données.

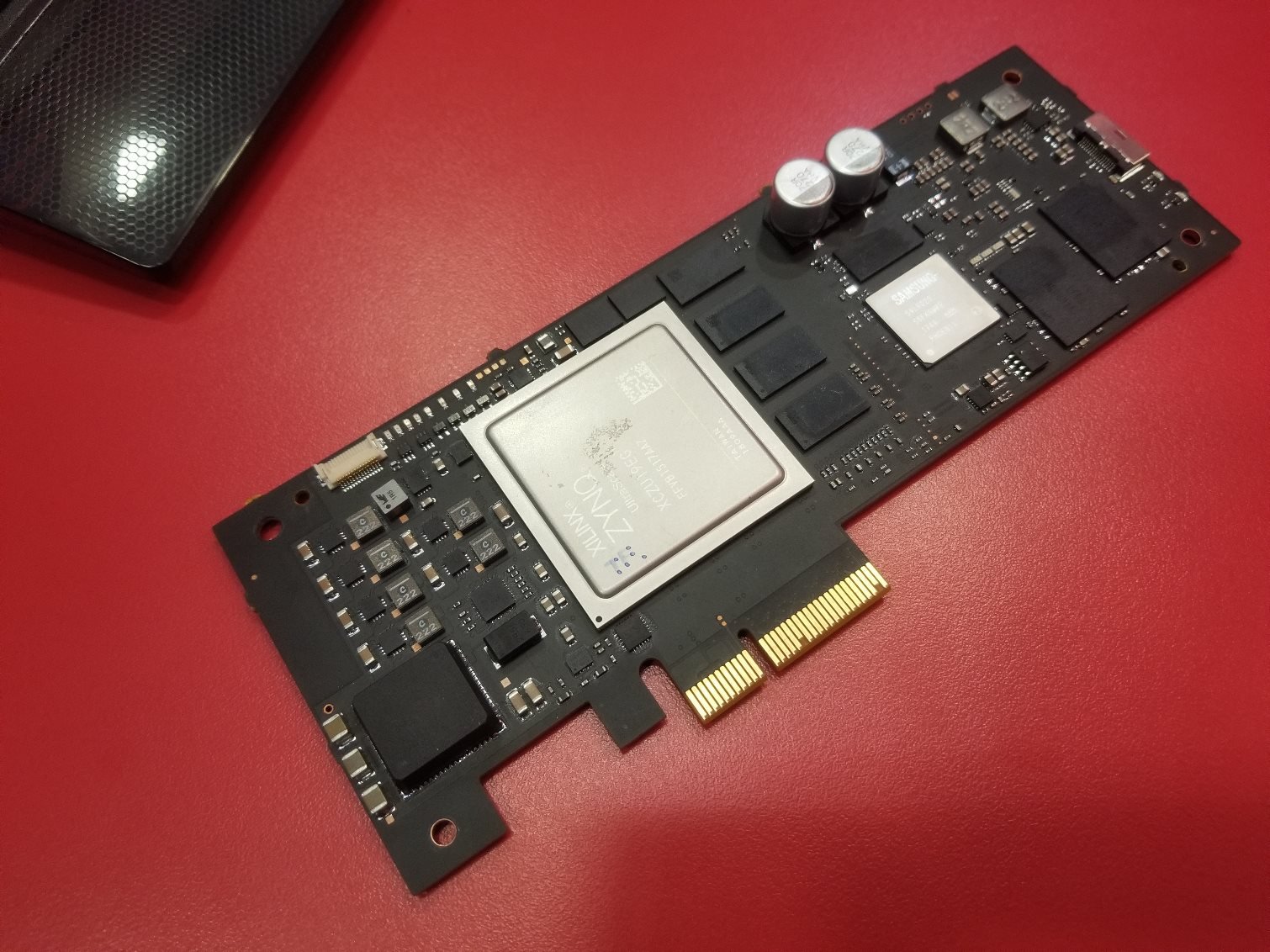

Xilinx allie PCIe 4.0 et FPGA

Xilinx a dévoilé son nouveau FPGA (circuit logique programmable) Alveo U280 lors du salon. Le stockage, la mémoire ou encore la puissance de calcul sont autant de goulets d’étranglement potentiels pour tout type de tâche : la U280 vise à en minimiser plusieurs d’entre eux. Dans cette optique, la carte de Xilinx apporte plusieurs innovations sur le secteur des FPGA : interface PCIe 4.0, 8 Go de HBM2 embarqués et gestion du CCIX. L’amélioration de l’interface PCIe permet ainsi de meilleurs débits en entrée/sortie, tandis que le débit mémoire maximal grimpe à 460 Go/s grâce à la HBM2.

Le protocole d’interconnexion CCIX contribue à minimiser les latences, apporter une bande passante élevée et une cohérence de cache pour les accès à la mémoire partagée avec les autres périphériques compatibles CCIX, pavant ainsi une voie prometteuse au fur et à mesure que l’environnement CCIX progresse.

SSD Samsung NF1

Nous avons retrouvé les nouveaux SSD NF1 de Samsung dans plusieurs serveurs sur le salon, signe que le format propriétaire de la marque coréenne rencontre un certain succès dans l’industrie. Cela étant dit, nous avons également remarqué quelques produits reprenant le format EDSFF (également connu sous le nom de « règle ») promu par Intel qui est devenu un standard.

Le fait est que les clients pour les centres de données comme les OEM tendent à concevoir des solutions basées sur des standards industriels, ce qui n’augure rien de bon pour le format propriétaire de Samsung. A vrai dire, le consortium PCI-SIG responsable de la norme PCI Express a même récemment alerté sur l’incompatibilité entre NF1 et SSD M2 : on pourrait y voir le premier signe d’une existence compliquée pour ce format pourtant prometteur.

Des puces NAND Flash utilisées comme mémoire cache

En reprenant comme base ses SSD SN200 destinés à un usage professionnel pour ensuite revoir leur partie logicielle, Western Digital a créé le nouveau ME200. Ce SSD NVMe permet d’utiliser la mémoire flash comme une extension de la mémoire système, augmentant ainsi la quantité de mémoire adressable dans un serveur de manière conséquente, puisqu’il est proposé en version 1 To, 2 To et 4 To. Le SN200 est décliné au format U.2 ainsi qu’en carte fille de manière à assurer une compatibilité aussi large que possible avec les infrastructures existantes.

Une fois installé, Western Digital affirme qu’il propose des performances proches de la mémoire système sur un large panel d’usages caractéristiques des serveurs. L’utilisateur gagne par ailleurs l’assurance d’avoir des données préservées sur le disque et si l’endurance des SSD est toujours une source de préoccupation, WD estime que la capacité du SN200 à encaisser 17 écritures journalières sur l’intégralité de sa capacité suffit dans pratiquement tout cas de figure ou presque. Enfin, la marque américaine prétend que cette approche innovante réduit les coûts de licence en plus d’augmenter la capacité mémoire pour un modeste surcoût par rapport à un SSD classique.

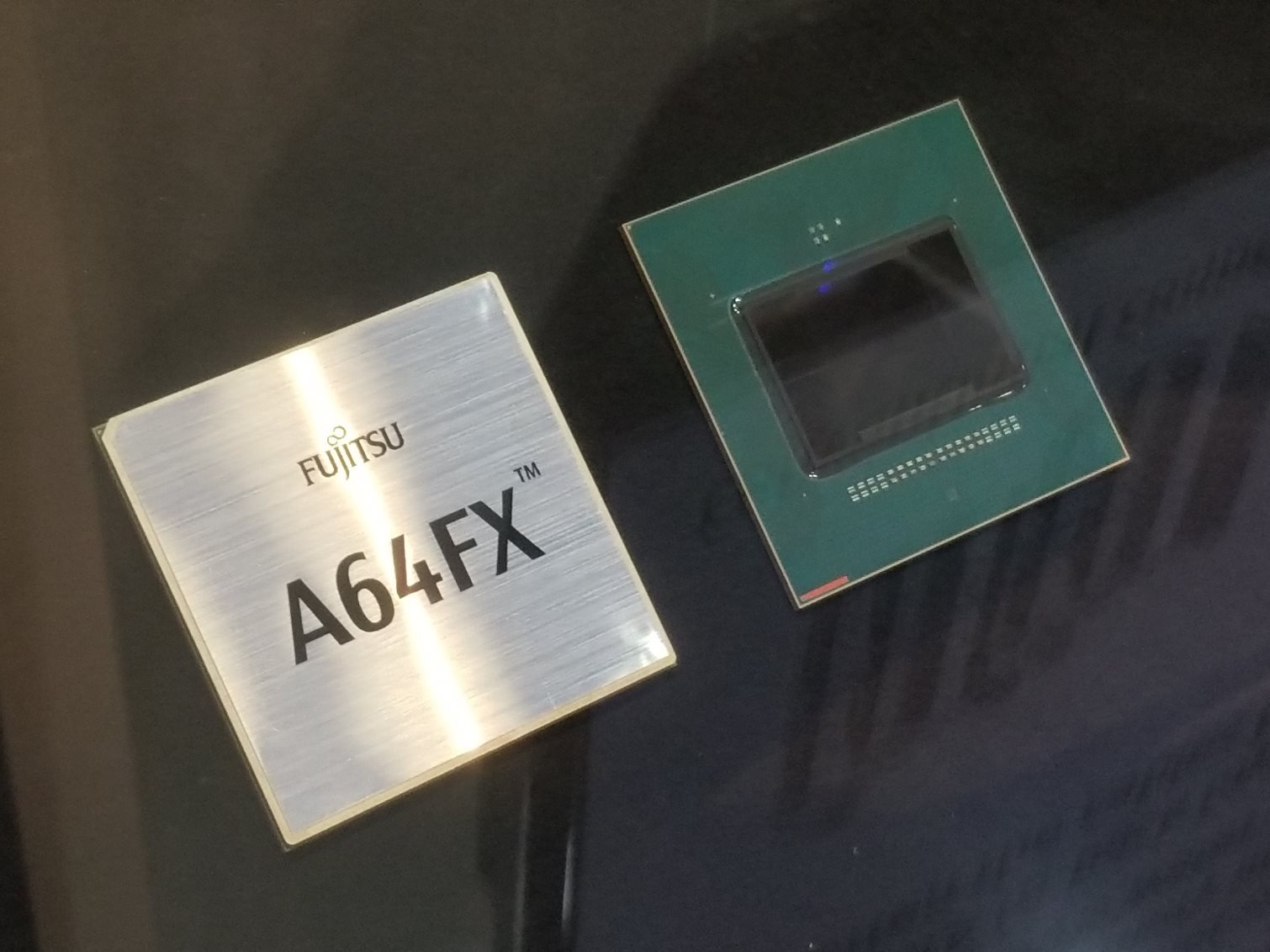

Fujitsu AF64FX

Le supercalculateur japonais Post-K ne devrait pas voir le jour avant 2021, mais Fujitsu travaille déjà d’arrache-pied sur sa pièce maîtresse : la nouvelle puce ARM A64FX fabriquée en 7 nm et comptant 8,7 milliards de transistors. Ce processeur embarque 48 cœurs et 4 cœurs « assistants » pour briller sur les tâches inhérentes à l’intelligence artificielle : on attend de lui jusqu’à 2,7 téraflops pour les opérations en FP64, 5,4 téraflops en FP32, 10,8 téraflops en FP16 et enfin 21,6 téraflops pour le calcul d’entiers sur 8 bits.

Fujitsu affirme que l’A64FX propose un rendement incroyable sans fournir de chiffres. Notons enfin que le processeur abrite 32 Go de HBM2 et peut gérer des débits maximums de 1024 Go/s depuis sa mémoire principale.

La course aux performances avec la Z-NAND

Samsung a présenté son 983 ZET, un SSD exploitant de la Z-NAND : cette technologie a été conçue comme alternative moins coûteuse à l’Optane d’Intel. Plutôt que de partir de zéro, la marque coréenne a simplement retravaillé la NAND flash SLC en réduisant lignes de mots et lignes de bits. Le 983 ZET est proposé comme carte fille au format HHHC (half-height half-length) avec une capacité de 480 ou 960 Go. Dans les deux cas, on compte 1,5 Go de DRAM LPDDR4.

Parmi les indicateurs de performances impressionnants, notons le débit maximum en lecture/écriture séquentielle de 3400/3000 Go. Malheureusement, Samsung n’a pas communiqué sur le domaine primordial, à savoir les performances aléatoires. Nous savons en revanche que le modèle 960 Go peut encaisser 17 520 To d’écritures et profite d’une garantie de cinq ans.

Des SSD « intelligents » ?

Le Samsung SmartSSD PM983 embarque une puce FPGA permettant le traitement des données au niveau du SSD sans consommer de cycles processeur ou nécessiter de mouvements vers la configuration hôte. Le PM983 dispose ainsi d’une connexion à bande passante élevée entre le SSD et la puce FPGA de manière à réduire le temps nécessaire au traitement des données. Si cette puce a été conçue en lien avec Xilinx, la marque coréenne a repris l’environnement de développement SDAccel pour FPGA.

Samsung propose son SmartSSD exclusivement au format carte fille à ce jour, mais une variante U.2 est prévue à l’avenir. D’après les représentants de la marque, le SmartSSD se destine aux tâches de type base de données, vidéo, intelligence artificielle, apprentissage automatique, stockage et virtualisation.