La carte : design extérieur

Avec cette carte, AMD veut se relancer dans le domaine professionnel, après une longue absence, ou du moins une offre actuelle adaptée. La gamme des Radeon Pro est depuis un moment dans un état plutôt comateux. Ainsi, au contraire de Nvidia qui doit veiller à ne pas cannibaliser les ventes de sa carte professionnelle Quadro P6000, AMD peut redonner de l’attractivité à la série des Radeon Pro avec une carte de course, sans se soucier d’une segmentation de l’offre de son catalogue.

Au contraire de la Titan XP de Nvidia, la Vega Frontier Edition permet d’utiliser les pilotes Radeon Pro en cas de besoin. Ceux-ci sont indispensables au bon fonctionnement de nombreuses applications professionnelles. Que l’on soit un particulier dont l’activité professionnelle requiert ces pilotes, ou bien qu’on change d’échelle pour répondre aux besoins d’une d’entreprise aux multiples stations de travail, cette carte bleue de l’équipe rouge est en mesure de répondre à ces besoins.

La carte est donc conçue pour intéresser une large palette de professionnels, du producteur de contenus à l’utilisateur CAD classique. Bien sûr, on peut aussi jouer avec cette carte. Cependant, soyons bien clair dès le départ : ce n’est PAS sa vocation première. Pour le jeu sans concession, il faudra attendre encore quelques semaines la sortie des RX Vega. Ces cartes seront également bien moins onéreuses que cette carte professionnelle.

Comme cette carte est donc avant tout destinée au monde professionnel, nous allons donc devoir la comparer avec la concurrence, ici la Quadro P6000, actuellement trois fois plus cher que la Radeon Vega Frontier Edition.

Notre test est donc intéressant à trois égards : tout d’abord, nous allons voir ce que cette carte permet d’économiser par rapport à la concurrence (rappelons que la très chère Quadro P6000 n’est pas plus puissante en jeu que la Titan XP). Ensuite, nous allons tester cette carte avec des logiciels pro, au contraire de beaucoup d’autres articles se bornant à la performance en jeu.

Design extérieur en détail

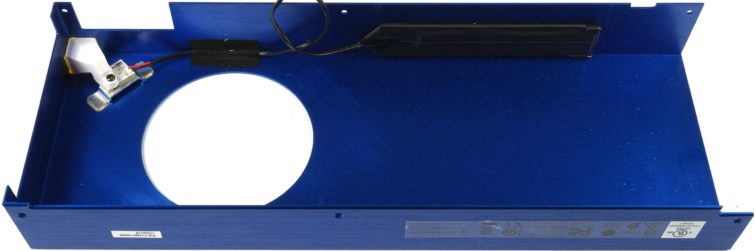

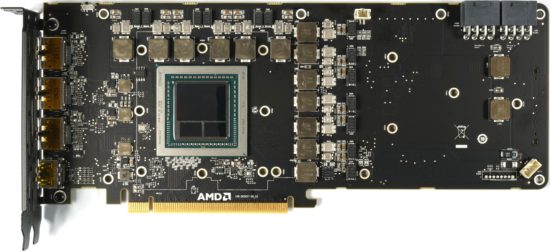

Cette carte, qui pèse tout de même 1050 grammes, est longue de 26,8 cm (de l’extrémité de l’équerre PCI au bout de la coque du système de refroidissement), large de 10,5 cm (de l’extrémité de la fente PCIe au sommet de la coque) et épaisse de 3,5 cm. C’est donc une carte au format dual slot, même si la plaque arrière dépasse de 4 mm du PCB.

La coque et la plaque arrière sont en aluminium anodisé et revêtent une couleur bleue plutôt attrayante et haut de gamme. Les vis sont laquées d’une couche de noir mat. À part ça, l’apparence reste minimaliste et seul le symbole Radeon attire l’œil. AMD reprend ici le code couleur de la série Radeon Pro que l’on retrouve par exemple sur les cartes WX, même si le bleu est plus foncé et plus intense.

Le dessus de la carte laisse apparaître deux connecteurs d’alimentation PCIe à huit broches. On note aussi le logo Radeon rétroéclairé de couleur jaune qui forme au coin un cube.

L’extrémité de la carte est close et on retrouve les trous habituels pour les cartes pro qui sont prévus pour leur fixation. L’équerre PCI de couleur noire matte est équipée de trois sorties DisplayPort et une sortie HDMI 2.0. On a renoncé à une sortie DVI-I afin de laisser plus de place pour l’évacuation de l’air chaud à travers la grille de l’équerre. Une grille encore un peu trop dense à notre goût.

Caractéristiques

Modèle | Radeon | Radeon | Titan | Quadro | Geforce |

|---|---|---|---|---|---|

Vega FE | R9 Fury X | Xp | P6000 | GTX 1080 Ti | |

GPU | Vega 10 XTX | Fiji XT | GP102 (450-A1) | GP102 (350-K1-A1) | |

Surface du die | 484 mm² | 596 mm² | 471 mm² | 471 mm² | |

Transistors | inconnu | 8.9 milliards | 12 milliards | 12 milliards | |

Fréquence de base | 1138 MHz (?) | ND | 1480 MHz | 1506 MHz | 1480 MHz |

Fréquence boost | 1382 MHz | 1050 MHz | 1582 MHz | 1645 MHz | 1582 MHz |

Shader/SIMD | 4096/64 | 4096/64 | 3840/30 | 3584/28 | |

Unités de texture / ROP | 256/64 | 256/64 | 240/96 | 224/88 | |

Pixel fillrate | 88,4 GPixel/s | 67,2 GPixel/s | 151,9 GPixel/s | 144,6 GPix/s | 141,7 GPixel/s |

Texture fillrate | 353,8 GTexel/s | 268,8 GTexel/s | 379,7 GTexel/s | 361,4 GTexel/s | 354,1 GTexel/s |

Bus mémoire | 2048 bits | 4096 bits | 384 bits | 352 bits | |

Type de RAM | HBM2 | HBM | GDDR5X | GDDR5X | |

Bande passante mémoire | 483,8 Go/s | 512,0 Go/s | 547,6 Go/s | 432,0 Go/s | 484,0 Go/s |

Débit RAM | 1,89 Gbit/s | 1,0 Gbit/s | 11,4 Gbit/s | 9 Gbit/s | 11,0 Gbit/s |

Quantité de RAM | 16 Go | 4 Go | 12 Go | 24 Go | 11 Go |

Niveau DX12 | 12_1 | 12_0 | 12_1 | 12_1 | |

Alimentation | 2 × 8 broches | 2 × 8 broches | 6 + 8 broches | 8 broches | 6 + 8 broches |

TDP | 300 W | 275 W | < 250 W | < 225 W | < 250 W |

Système de test

Le tout nouveau système de test et la méthodologie employée ont déjà été décrits en détail. Vous pouvez tout savoir en consultant notre article sur nos nouvelles méthodes de test des cartes graphiques.

| Configuration de test | Intel Core i7-6900K @4,3 GHz MSI X99S XPower Gaming Titanium Corsair Vengeance DDR4-3200 Toshiba OCZ RD400 1 To (M.2, Système) 2 Toshiba OCZ TR150 960 Go (Stockage, images) Be Quiet Dark Power Pro 11, 850 Watts Windows 10 Pro Creators Update |

Désassemblage : dissipateur et PCB

Pour ôter la coque du système de refroidissement, il faut dévisser les six petites vis à l’aide d’un tournevis Torx (T5). On découvre alors le radiateur et le cadre de maintien.

Comme de coutume, AMD a conçu une carte DHE (Direct Heat Exhaust) qui expulse l’air chaud directement hors du boitier.

La plaque arrière est aussi fixée au PCB à l’aide de six vis T6. Sa fonction est purement esthétique et elle ne participe pas au refroidissement. Nous avons essayé de remédier à cela en appliquant quelques pads thermiques, sans grand succès hormis localement au niveau des puces de doubling.

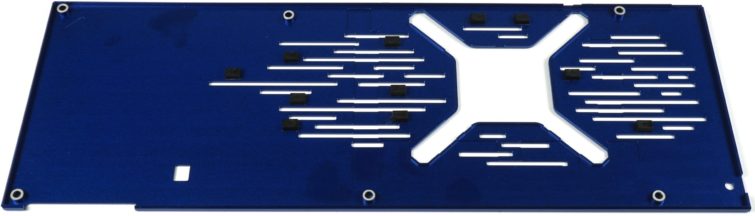

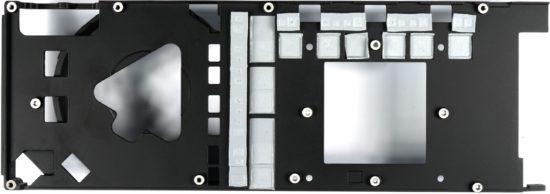

La face avant du PCB est recouverte d’un cadre de maintien massif en métal massif, qui sert aussi au refroidissement. Le design du cadre est bien pensé. Comme sur la GTX 1080 Ti Xtreme Edition de Gigabyte (Aorus), la surface des bobines est plane ce qui facilite l’évacuation de la chaleur via des pads thermiques. Les VRM ont droit aussi à leurs pads. Nous verrons à la page traitant des températures si cela fonctionne bien.

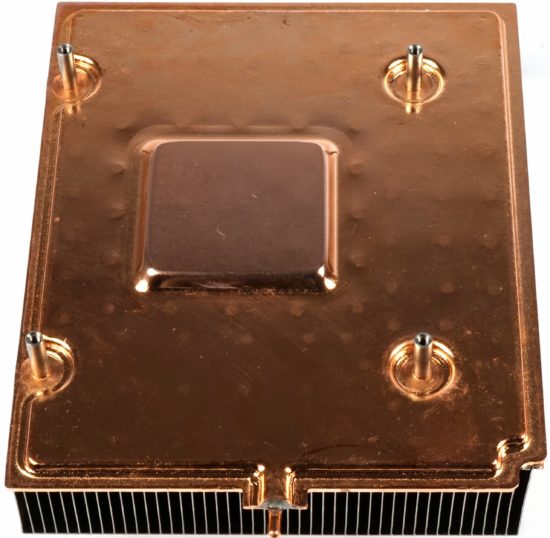

Le radiateur en lui-même est doté de fines ailettes en aluminium et repose sur une chambre à vapeur en cuivre constituée d’une seule pièce et épousant les formes du package. Au bas de l’image, on peut voir la sortie scellée. Au démontage, il faudra veiller à ne pas plier cette partie sensible.

Le ventilateur radial de 7 cm est un modèle à roulement à billes produit par Delta. Il devrait être bien moins bruyant que celui présent sur le modèle précédent qui pouvait monter à 10 000 tpm. Ici, le BVB1012 tourne à un maximum bien plus raisonnable de 5000 tpm. Une fois la température cible atteinte, le ventilateur tourne à environ 40% de sa puissance, ce qui équivaut à 2000 tpm. Nous verrons tout à l’heure que le bruit produit par le ventilateur ressemble à celui de la Founders Edition de Nvidia.

Le PCB en lui-même est dominé en son centre par le package GPU + mémoire. L’analyse des différents composants est à la page suivante, ici, nous nous bornons à la spécificité ce package.

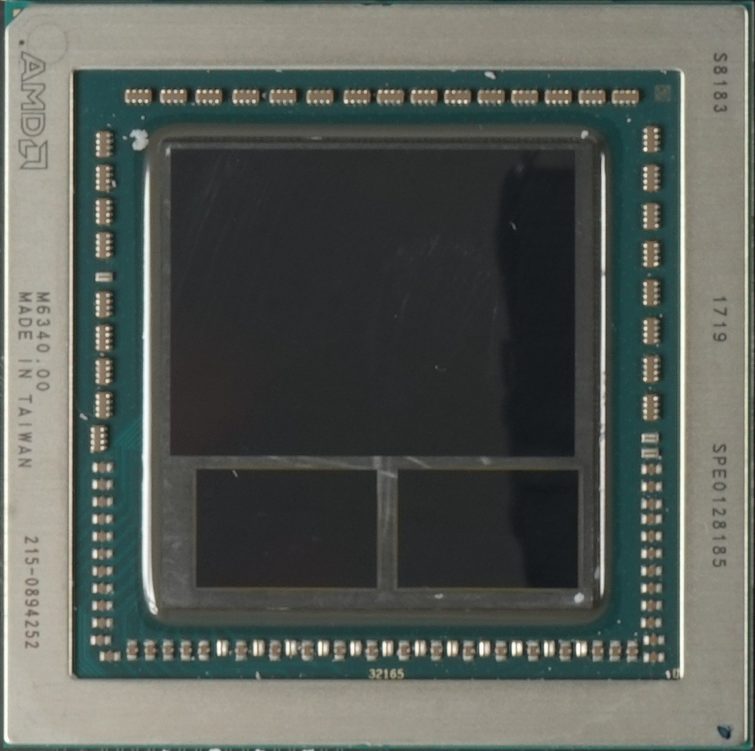

Le package : GPU et mémoire fondus sur un interposer

Comme il est difficile de souder directement un GPU (ici GPU et mémoire) sur le PCB, ces composants sont donc tout d’abord placés à l’aide d’une machine spécialisée (ASE ou autre) dans un package. Celui-ci est bien plus facile à manipuler ensuite par les constructeurs de cartes. Ce package est placé par procédé STM sur une bande de transfert par une machine et ensuite positionné sur le PCB.

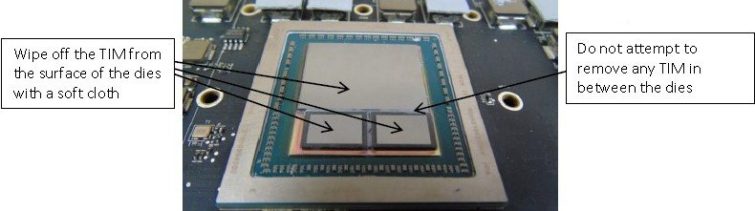

Si on compare le package final avec les prototypes montrés lors des démonstrations ou sur les diapos, on remarque un vide assez important entre le GPU et les modules mémoire, comme sur Fiji. En effet, ces composants sont assez protubérants. L’interposer sur lequel repose le package est lui très fin et fragile. Du coup, sur les diapo internes réservées au personnel manipulant les chips pendant le développement, on avait indiqué qu’il fallait faire particulièrement attention lors du nettoyage de la pâte thermique sur le GPU.

Ce qui est fragile pour une main humaine l’est naturellement aussi pour une machine, d’autant plus que des espaces peuvent se former entre l’underposer (le dessous du package) et l’interface du PCB, ce qu’on appelle dans le jargon des problèmes d’underfill. Si on observe par contre le package de la Vega FE, on constate qu’AMD a eu recourt au molding : le GPU et la mémoire ont été fondus dans une masse, ce qui augmente leur stabilité.

Cette modification ne dispense pas de faire toujours très attention lors du nettoyage du GPU, mais cela permet d’envisager la chose avec plus de sérénité.

Alimentation et composants

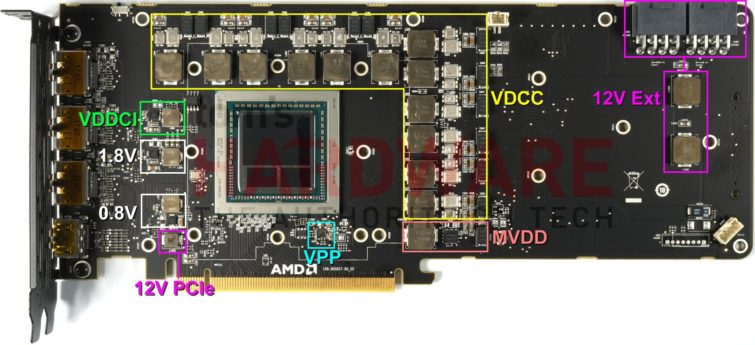

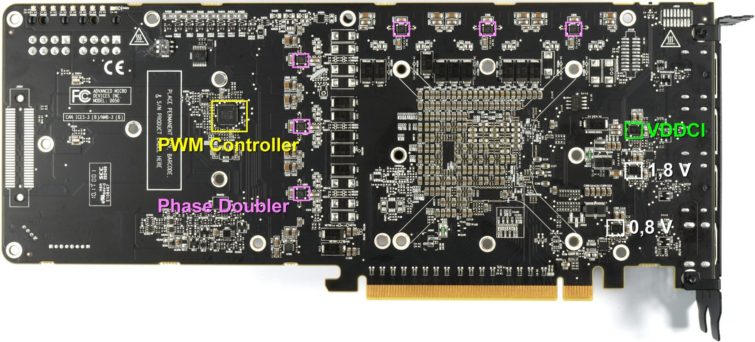

Répartition des composants sur le PCB

Grâce à la place gagnée par la disparition des modules mémoire sur le PCB, AMD a pu imaginer un design assez original. À la place des modules mémoire, on retrouve donc l’étage d’alimentation à 6+1 phases pour le GPU et la mémoire ainsi que quelques convertisseurs de tension supplémentaires pour les tensions intermédiaires. Nous reviendrons en détail sur ce point.

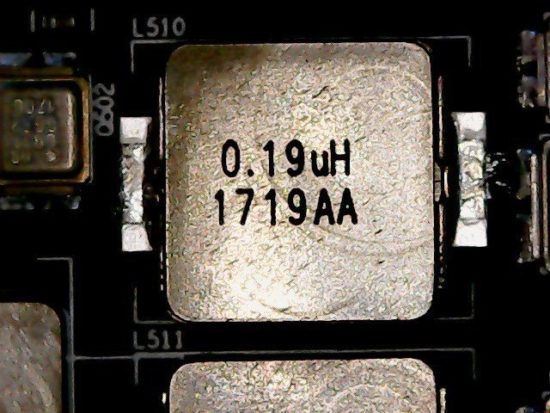

Les deux connecteurs d’alimentation à 8 broches sont reliés à deux bobines, ce qui permet de lisser les pics de tension. Elles ne sont toutefois pas épaulées par des condensateurs.

Sur la face arrière du PCB, on voit que les composants sont concentrés au niveau du socle GPU. En retrait, on remarque le contrôleur PWM et quelques autres composants sur lesquels nous reviendrons dans une vidéo.

Alimentation du GPU

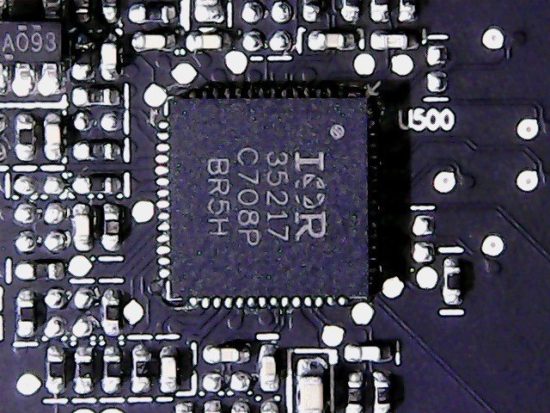

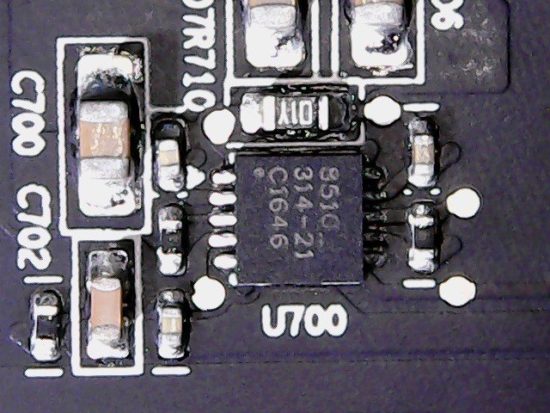

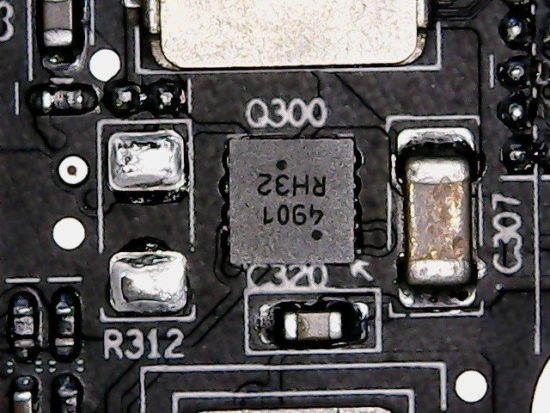

Le contrôleur PWM est un IR3521 d’International Rectifier, un contrôleur multiphases numérique à double sorties capable de gérer 6 phases GPU et 2 autres phases sur lesquelles nous reviendrons. On compte douze convertisseurs de tension car les six phases sont doublées en deux rails de VRM. Nous parions que de telles précautions ne seront pas forcément prises sur la version XL, plus grand public. Les VRM sur la face arrière du PCB devraient alors disparaitre ou le design du PCB être adapté.

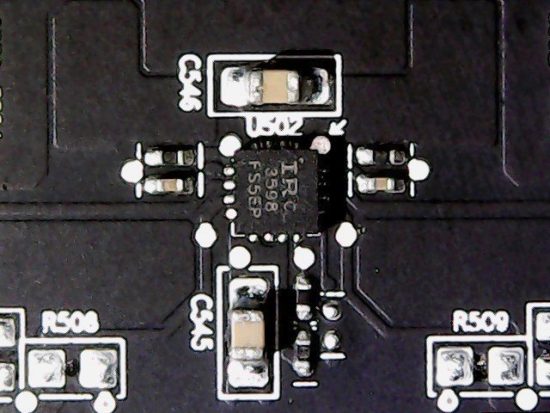

Le doubling est assuré par six IR3598 placés sur la face arrière du PCB. La vidéo suivante montre comment le contrôleur PWM fait tourner la charge au repos entre les phases afin de bénéficier de l’efficacité accrue d’une phase pleinement utilisée sans pour autant engendrer de point chaud à un endroit en particulier.

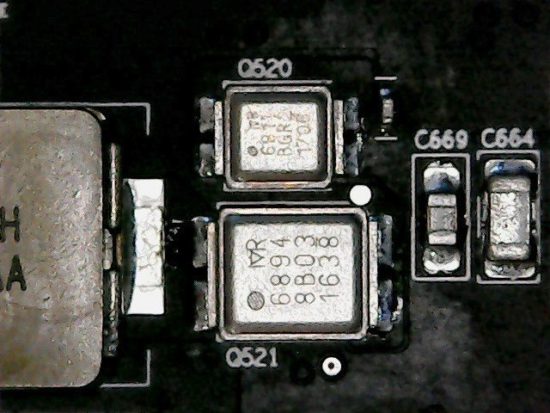

La conversion du courant à proprement parler est assurée par des convertisseurs de tension IRF6811 en high side et des IRF6894 en low side, lesquels intègrent aussi une diode Schottky. Ces deux HEXFET déjà employés par AMD sont produits par International Rectifier. Les bobines sont en ferrite encapsulée.

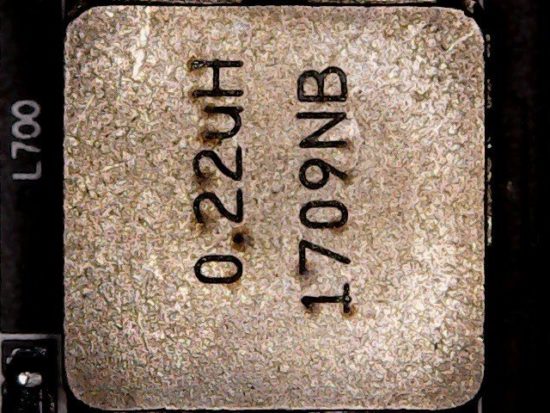

Alimentation de la mémoire

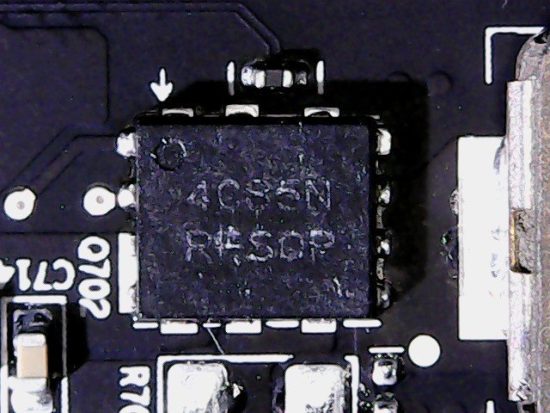

Comme évoqué plus haut, la phase mémoire est gérée par un IR35217. Une phase est largement suffisante car la mémoire consomme peu. Le driver, un CHL815, est placé à l’arrière du PCB tandis que le convertisseur de tension est un NTMFD 4C85M de ON Semiconductor. Ce MOSFET à double canal N travaille en high et low side.

On notera qu’AMD renonce aux condensateurs en forme de tubes au profit de leur déclination plate. On compense leur capacité un peu plus faible en les doublant sur l’arrière du PCB, ce qui permet de mieux répartir la chaleur sur une surface supplémentaire, et permet aussi d’employer des condensateurs moins résistants à la chaleur et donc moins onéreux. Ici, tout le monde y gagne.

Autres convertisseurs de tension

La conversion du VDDCI ne consomme pas beaucoup, mais c’est tout de même une étape déterminante. La VDDCI a pour fonction la transmission du signal entre le GPU et la mémoire, c’est à dire le passage entre la tension de la mémoire et celle du GPU sur le bus I/O. De plus, elle fournit deux sources constantes pour du 1,8 V et du 0,8 V.

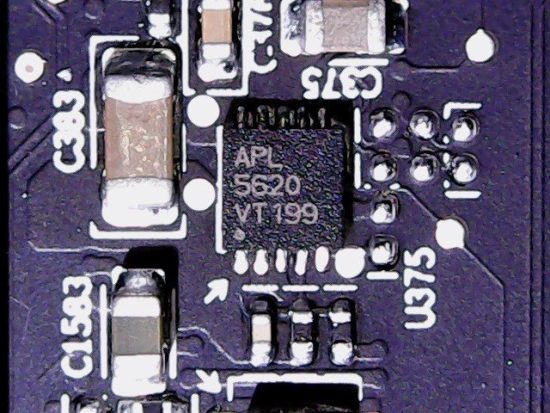

Sous le GPU, on retrouve un APL5620 d’Anpec pour la VPP. Cette puce ultra low dropout génère une tension très faible pour le circuit PLL (Phase Locked Loop).

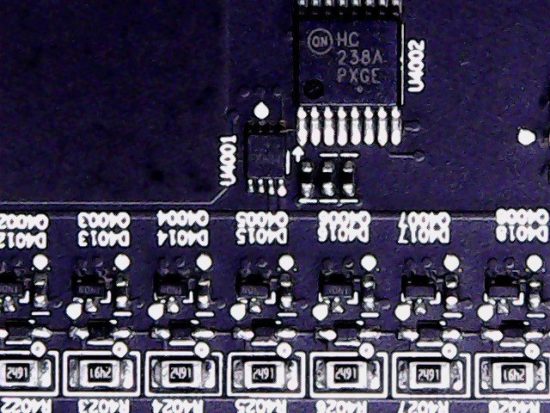

Le HC238A de ON Semiconductor réalise quant à lui le spectacle lumière des LED indiquant le niveau de charge des entrées d’alimentation. Un détail bienvenu si l’intensité lumineuse n’était pas aussi forte, ce qui s’avère gênant surtout la nuit dans un boitier vitré.

Nous ne nous étendons pas sur le reste des composants qui ne réservent pas de surprise.

Performances de rendu 2D

Remarque préliminaire concernant les benchmarks applicatifs

Nous avons déjà expliqué dans l’intro pourquoi nous avions décidé de comparer cette carte à une Quadro P6000 et pas à une Titan XP ou une GeForce GTX 1080 Ti. Il y aussi une autre raison à cela. Dans le domaine semi-professionnel, un écran avec une profondeur de couleur de 10 bits est souvent indispensable et pour coller à ce cas de figure, nous utilisons pour nos tests un Eizo EV3237-BK plutôt qu’un écran gaming traditionnel.

Pour juger de la capacité réelle de la Radeon Vega Frontier Edition, il faut en effet l’utiliser pour ce pourquoi elle a été conçue. Or si la Quadro P6000 et la Radeon Vega Frontier Edition supportent cette option pour DirectX et pour OpenGL, la Titan Xp, aussi puissante qu’elle soit en jeu, n’est pas capable de gérer OpenGL en 10 bits et s’exclut de ce fait du domaine professionnel.

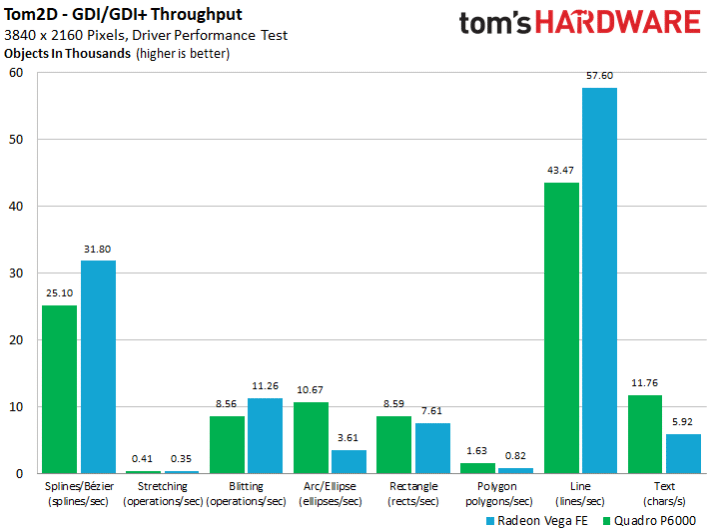

Débit des pilotes pour le rendu à l’écran

Depuis que les cartes graphiques utilisent l’architecture Unified Shading, les fonctions d’accélération 2D ont complètement disparu des cartes graphiques. Depuis Windows Vista, l’accélération graphique est aux abonnés absents (sauf pour la copie d’images bitmaps) et il faut systématiquement passer via le pilote par Direct3D. Si on peut regretter ce pas en arrière, c’est aussi l’occasion de tester les capacités du pilote en détails.

Nous testons séparément les fonctions graphiques les plus usuelles avec un programme dont la mission est d’afficher le plus possible d’objets à l’écran en un temps donné. La succession et la forme des objets est générée aléatoirement afin d’éviter un éventuel effet de cache, mais le début est toujours identique, de sorte que la succession aléatoire peut être exactement reproduite sur deux tests. La couleur des contours et celle de remplissage des objets géométriques changent pour chaque nouvel objet généré.

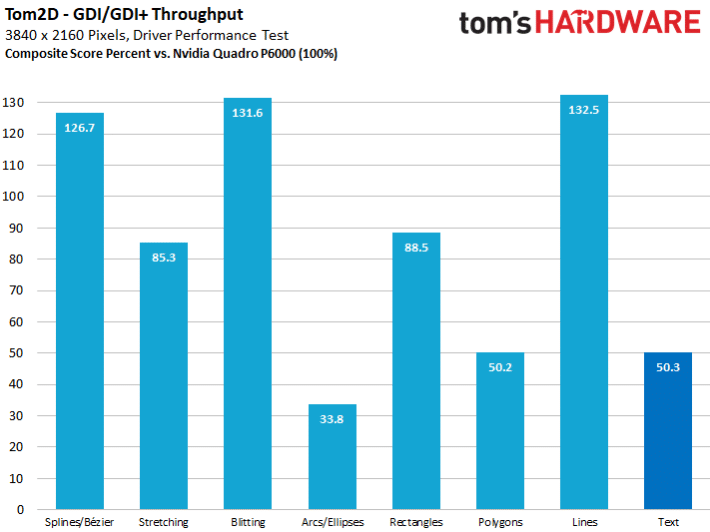

On voit sur le graphique que si la carte AMD parvient à faire jeu égal dans un certain nombre de cas avec la Quadro, il y a encore des progrès à faire pour le rendu de textes, de polygones et de formes elliptiques. Les lignes et les courbes sont par contre mieux maitrisées que la concurrence. N’oublions pas qu’un tel test sollicite aussi fortement le processeur, ce qui pourrait aussi indiquer un overhead des pilotes.

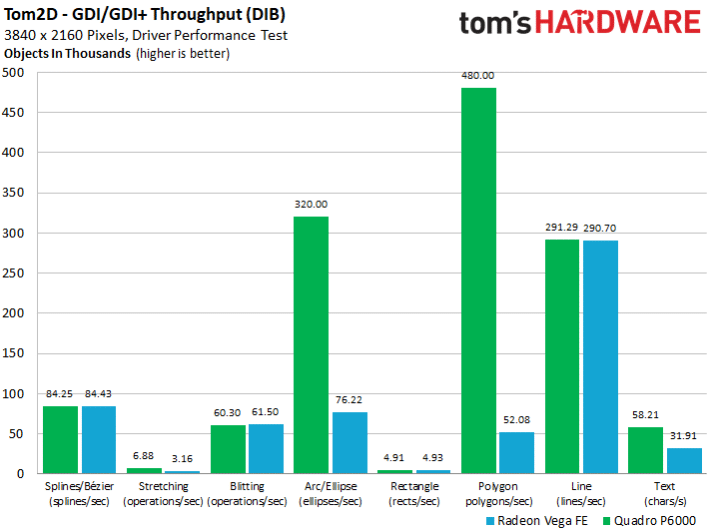

Débit des pilotes en affichage sur écran

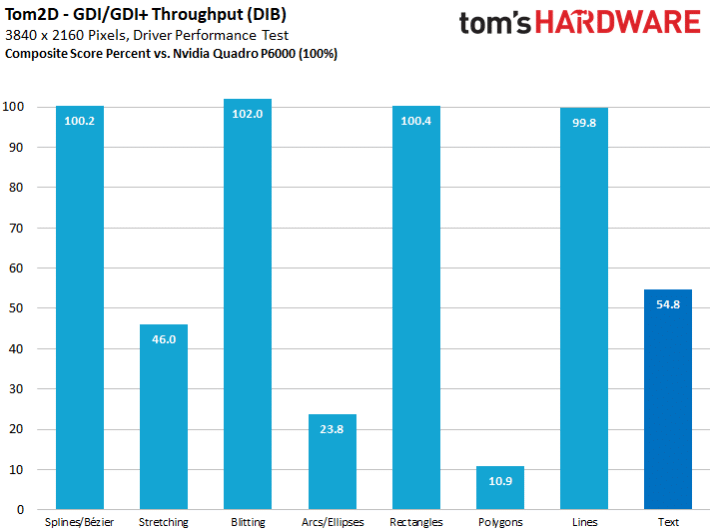

Maintenant, inversons les choses. On stocke d’abord une image bitmap dans la mémoire vive du système avant de la copier d’un coup dans la mémoire graphique. Ici on voit que le chantier de l’optimisation des pilotes est encore loin d’être achevé et qu’il y a une grande marge d’amélioration possible.

C’est surtout la faiblesse au niveau des polygones qui interpelle le plus : on atteint à peine 11% de la performance ce la Quadro P6000. C’est un vrai problème puisque la copie d’un bitmap en temps réel est une opération très commune.

Même si ces deux benchmarks ne présument pas de la performance véritable en CAD, ils sont tout de même fort instructifs.

On voit avec ces deux tests qu’il est encore possible d’améliorer grandement les pilotes dans certains cas de figure en adaptant les fonctions ou bien modifiant la façon dont les objets sont générés. Mais ces optimisations requièrent beaucoup de temps et de personnel et sont donc surtout mises en œuvre sur les pilotes Radeon Pro et Quadro, ce qui explique en partie le coût élevé à l’achat du matériel qui doit couvrir ces dépenses importantes.

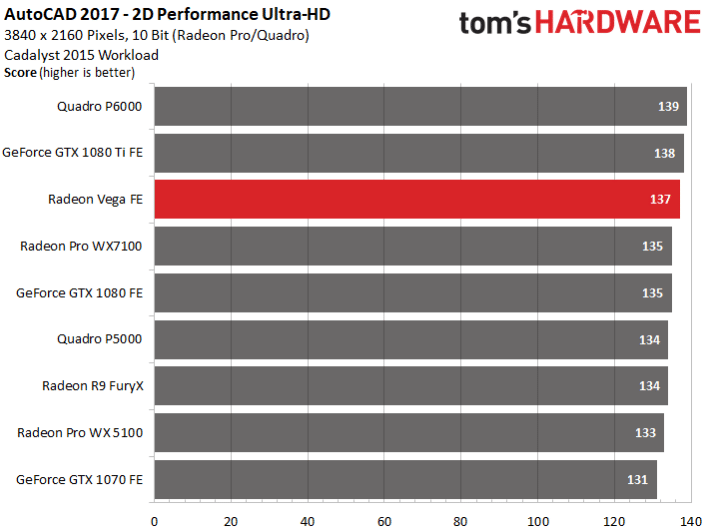

Performance 2D dans AutoCAD 2017

Pour clore cette partie, nous simulons une masse importante de calculs 2D dans AutoCAD. Comme on est surtout ici limité par le CPU, l’écart est plus réduit que prévu. En construction 2D, le choix entre telle et telle carte ne revêt donc pratiquement aucune importance, tant que la mémoire suit. Même les cartes modestes comme la Quadro P2000 obtiennent 130 points, à peine moins que la Quadro P6000.

Performances stations de travail 3D

Qui triche le mieux ?

Depuis notre dernier test des CPU Intel Skylake-X et Kaby Lake-X, nous avons revu notre série de benchmarks. En effet, nous comparons ici les cartes graphiques de différents fabricants et malheureusement, l’optimisation des pilotes pour ces benchmarks joue souvent un rôle plus important que la performance applicative réelle.

Nous avons ainsi renoncé aux benchmarks réalisés avec SPECviewperf Freeware car ils ne donnent pas une idée des performances réelles à attendre en station de travail ou CAD, puisque les tests effectués sont bien trop courts et dépassés. De plus, certains des programmes ne fonctionnent pas du tout ou seulement partiellement sur les cartes grand public à cause de leurs pilotes.

Les pilotes actuels ont tendance être spécialement optimisés pour les tests effectués par les suites de benchmark populaires. Nous en avons déjà eu un aperçu à la page précédente. Le problème, c’est que ces benchmarks ultra optimisés ne sont plus représentatifs de la performance réelle à attendre et l’écart entre une carte pro et une carte grand public est parfois tellement important, c’est parfois surprenant (par exemple sur Maya). Naturellement, c’est bon pour le marketing, mais ça rend toute comparaison honnête quasi impossible.

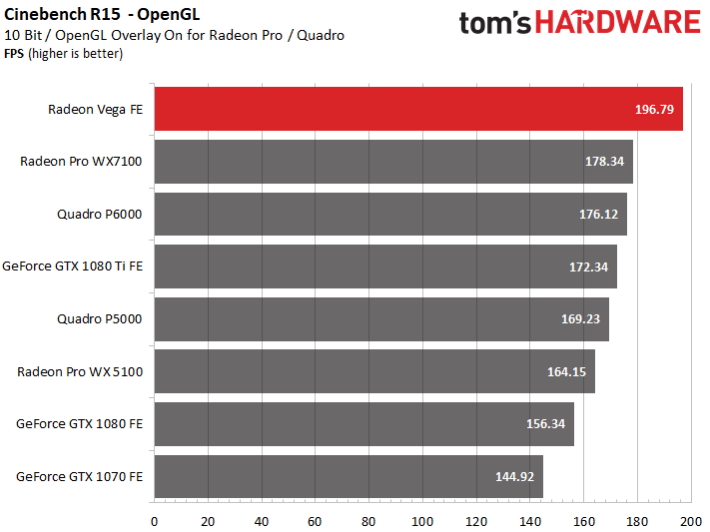

L’un des exemples les plus éclatants de cette tendance est Cinebench OpenGL. Nous avons retesté les cartes avec les derniers pilotes et les résultats obtenus sont vraiment suspects. À l’avenir, nous nous passerons aussi de Cinebench lorsque nous testerons des cartes aux pilotes différents.

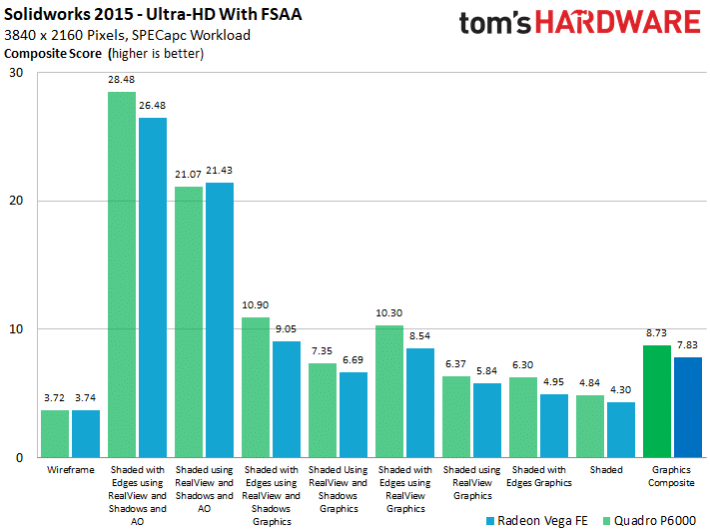

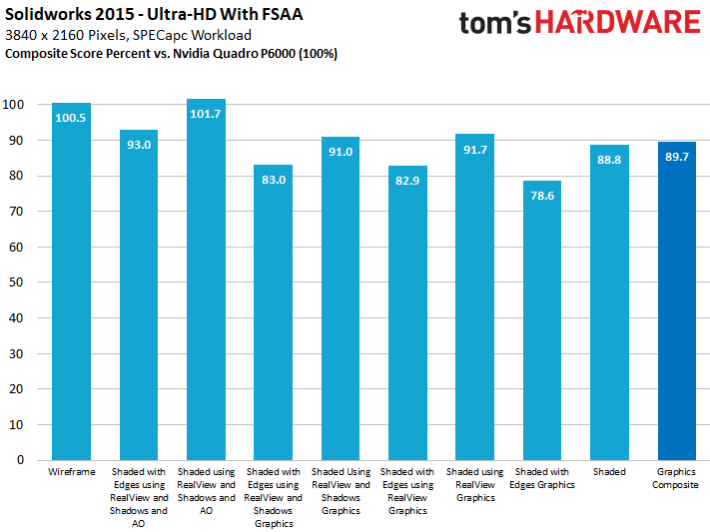

SolidWorks 2015

Pour une comparaison plus honnête, nous avons donc préféré effectuer nos tests avec des logiciels vraiment représentatifs, comme par exemple SolidWorks. Ici, la Radeon Vega FE obtient environ 90% de la performance la Quadro P6000 alors qu’elle ne coûte qu’un tiers de son prix. Si la Quadro P6000 reste devant, la Radeon Vega FE se défend vraiment bien et se situe aux environs d’une Quadro P5000 (équivalant à une GeForce GTX 1080). La comparaison performance prix étant toujours à l’avantage d’AMD : la Vega coûte à peine plus de la moitié de la Quadro.

Les différents benchmarks réalisés montrent que la carte performe de manière très constante sans aucune faiblesse notoire. Nous affichons à nouveaux les résultats obtenus, mais cette fois en pourcents, 100 % représentant la performance obtenue par la Quadro P6000.

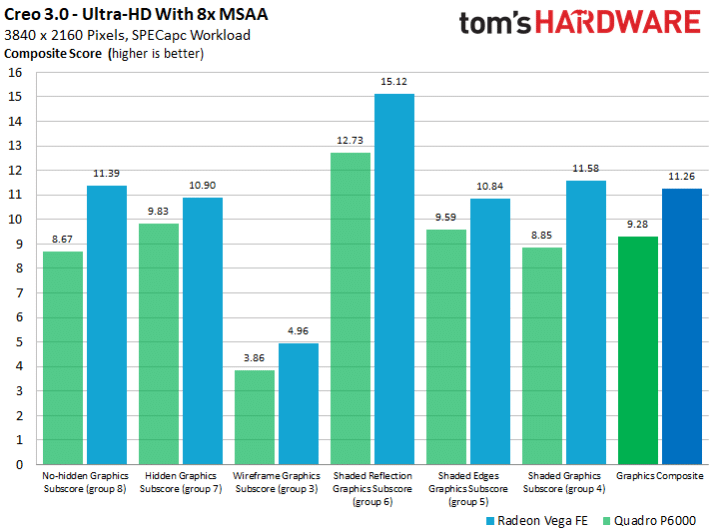

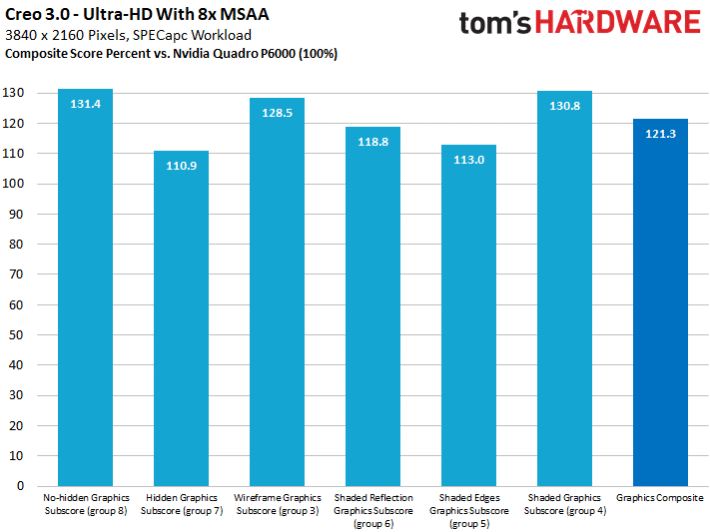

Creo 3.0

Creo 3.0 fonctionne aussi sur la Radeon Vega FE, et même sacrément bien ! Quel que soit le test, la Radeon Vega FE surpasse la Quadro P6000. On voit ici qu’un gros travail d’optimisation a été fait en considérant le programme dans son ensemble. Ce teste montre la vraie performance à laquelle on peut s’attendre au quotidien dans ce logiciel et pas une séquence benchmark de quelques secondes à partir de laquelle on extrapole des résultats fantaisistes. La qualité du rendu des images était dans les deux cas très bonne.

Le graphique suivant compare la performance de la Radeon avec la Quadro P6000. En moyenne, la Radeon est 20% plus rapide, ce qui est un excellent résultat. Il y a cependant fort à parier que Nvidia réduira l’écart dans les prochains mois avec des pilotes optimisés. Ici, la course à l’optimisation profite vraiment à l’utilisateur final, de la même façon qu’avec les profils optimisés pour tel ou tel jeu sur les cartes gaming.

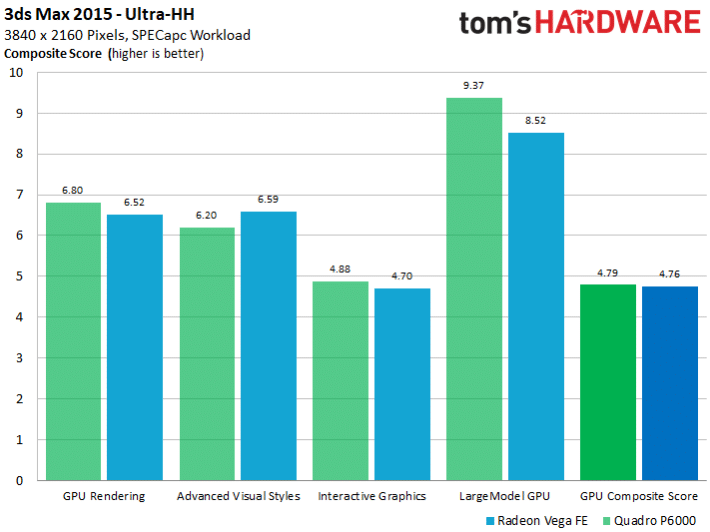

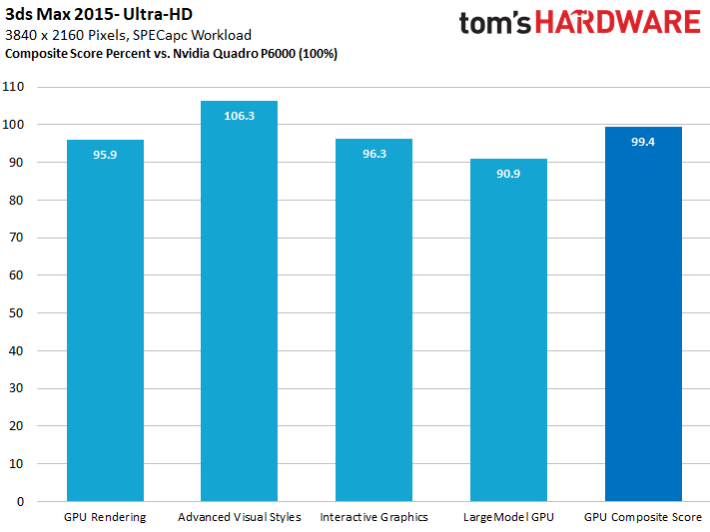

3ds Max 2015

Difficile ici de départager les deux cartes qui obtiennent des résultats très similaires dans ces tests longs et exigeants. Le score moyen obtenu est d’ailleurs quasi identique.

Les résultats affichés en pourcentage, on voit que l’écart ne dépasse jamais 10 % et que la Vega devance même la Quadro de 6 % dans un des tests les plus importants. Au final, la Vega n’est que 0,6 % moins rapide, c’est à dire à peine plus que la marge d’erreur.

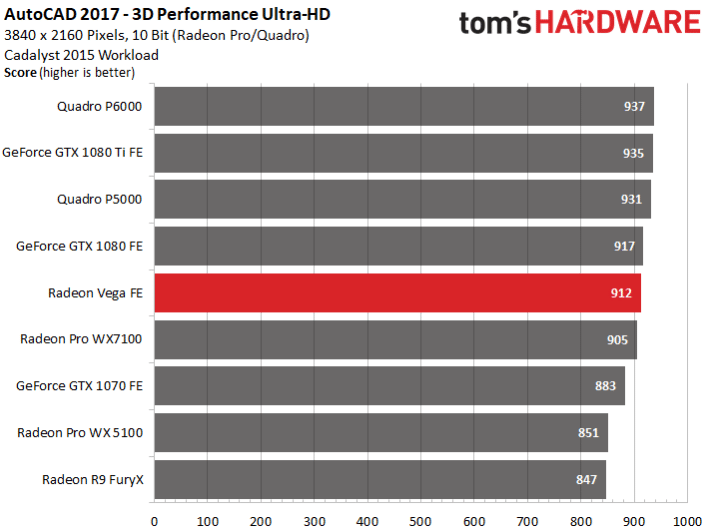

Performance 3D dans AutoCAD 2017

Nous passons maintenant à AutoCAD en utilisant cette fois non pas OpenGL et les bibliothèques graphiques personnalisées, mais tout simplement DirectX avec la plupart du temps les bibliothèques Microsoft classiques. La Radeon Vega FE se place alors entre la GeForce GTX 1080 et la GTX 1070, plus proche cependant de la GTX 1080.

Très difficile à optimiser, et donc difficilement manipulable par les fabricants, ce test pourrait être assez représentatif des performances réelles de Vega dans les applis DirectX, on pense ici aux jeux… Des performances plutôt mitigées, en face de la GTX 1080, et nos tests de jeux tendent à le confirmer en page suivante.

Performances en jeux vidéo

Cette carte n’étant pas destinée aux jeux vidéo (nous parlons surtout de ses pilotes), nous ne l’avons testée qu’avec trois jeux. Mais nous avons choisi des titres majeurs, et surtout dans les trois API majeures du moment : DX12, DX11 et Vulkan.

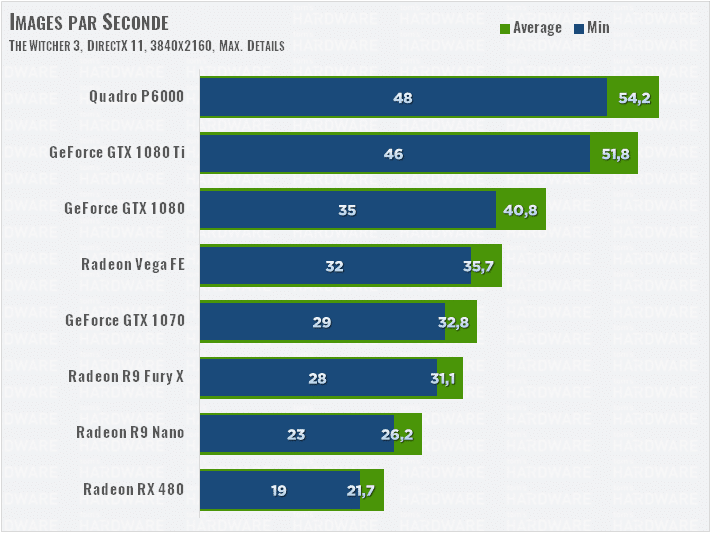

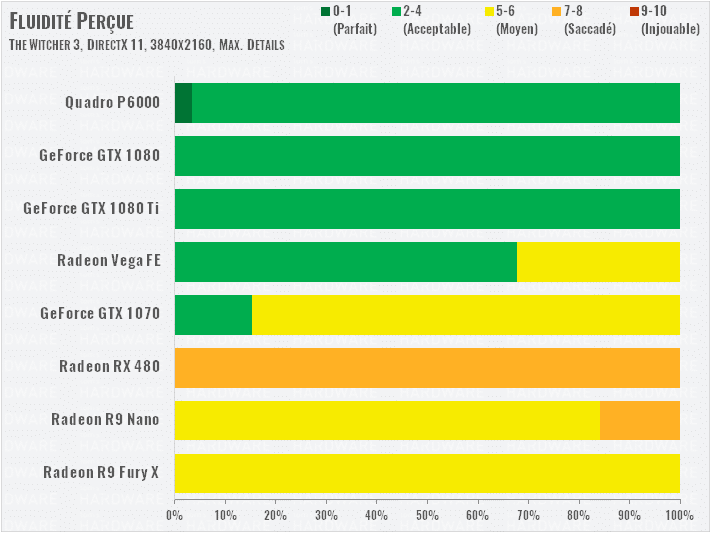

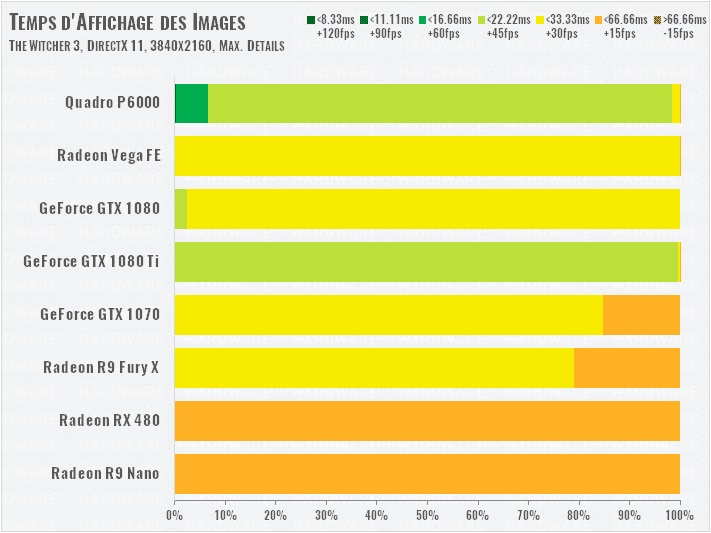

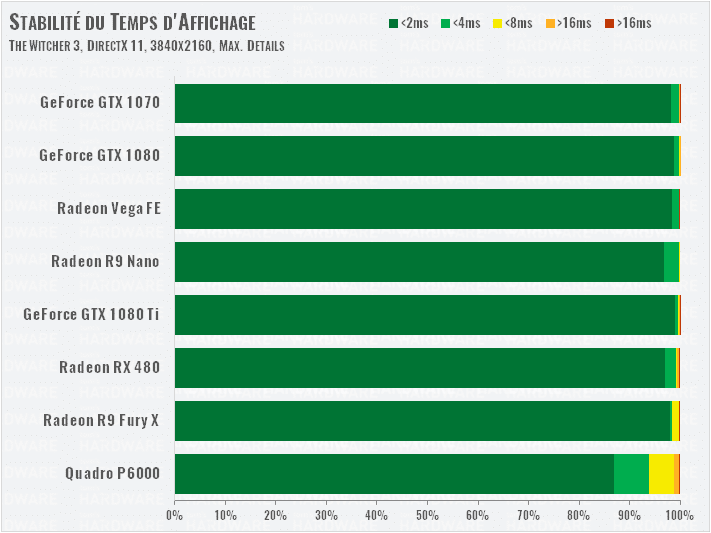

The Witcher 3 (DirectX 11)

Difficile de se démarquer dans ce jeu pour la Vega FE, alors qu’on sait que les cartes NVIDIA Pascal sont particulièrement à l’aise en DirectX 11. La carte d’AMD se retrouve pile entre les GTX 1070 et 1080, très loin derrière là 1080 Ti. Notez que la techno NVIDIA Hairworks était désactivée, pour ne pas pénaliser les Radeon.

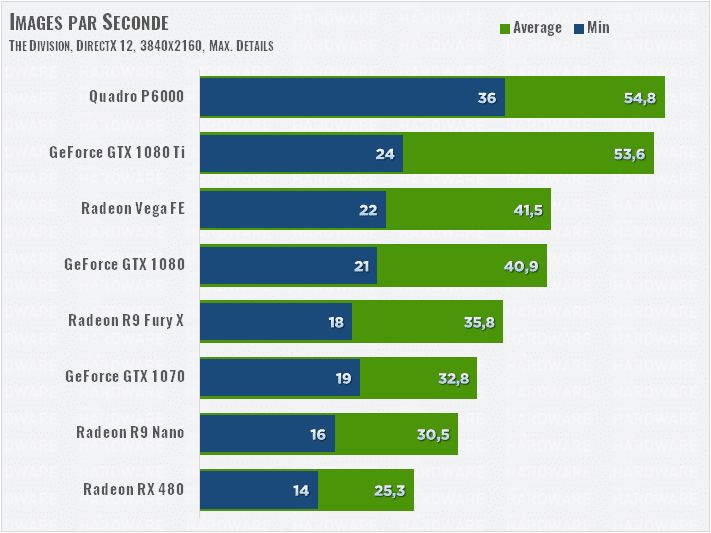

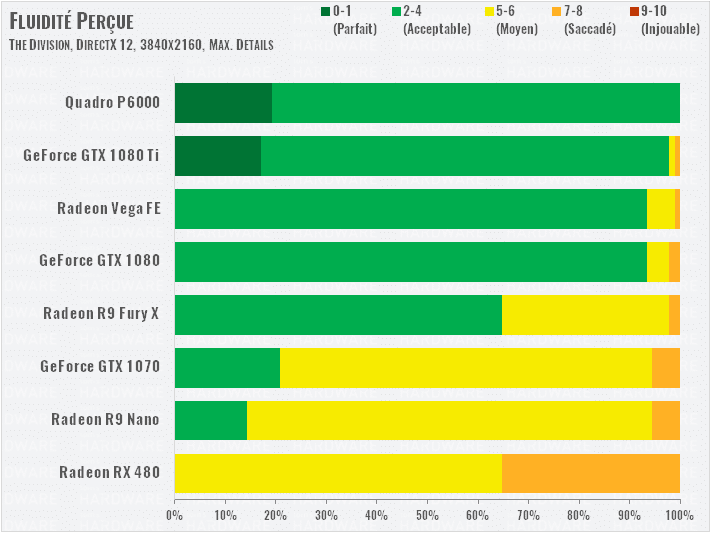

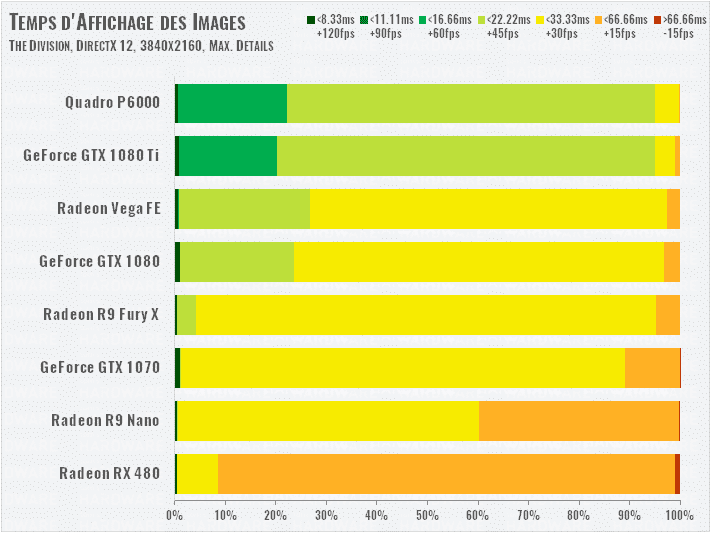

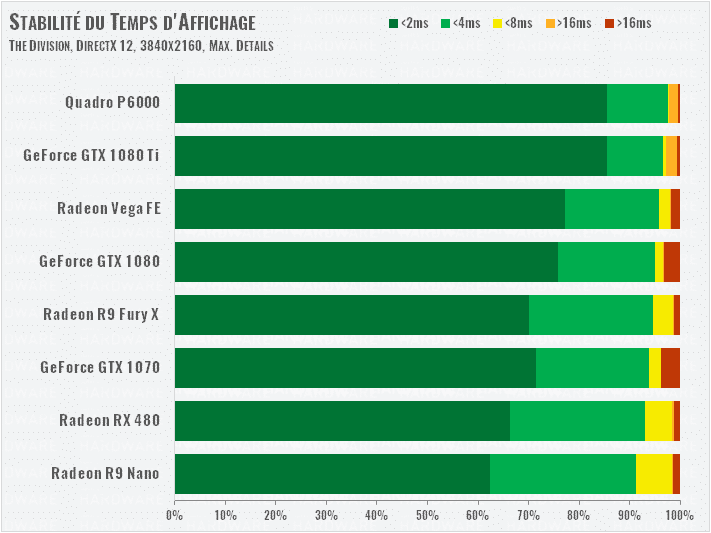

The Division (DirectX 12)

Difficile de faire un maître étalon de performances avec un seul jeu sous DirectX 12, mais au moins, The Division nous paraît être le moteur le plus sérieux sous DirectX 12, mieux que le Hitman ou Tomb Raider. Ici encore, la Vega FE est 22 % moins performante que la GTX 1080 Ti, mais elle se hisse juste au dessus de la GTX 1080. Ce qui nous laisse imaginer que les Vega RX grand public seront certainement en duel avec la 1080 Ti, moyennant des pilotes plus adaptés.

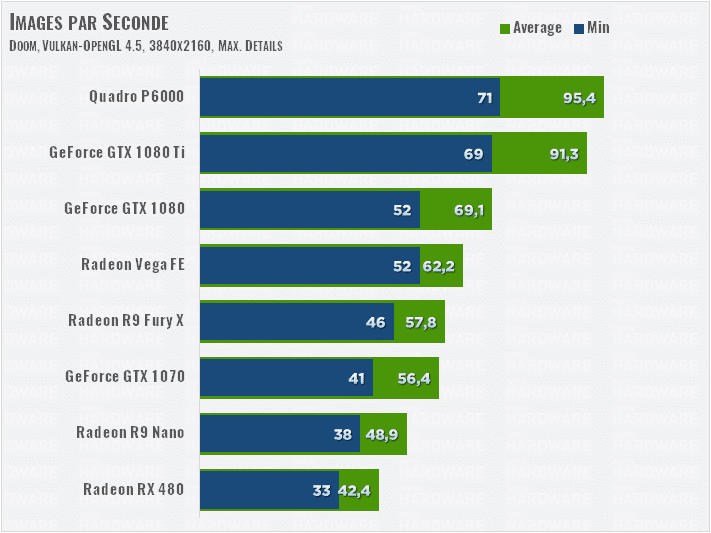

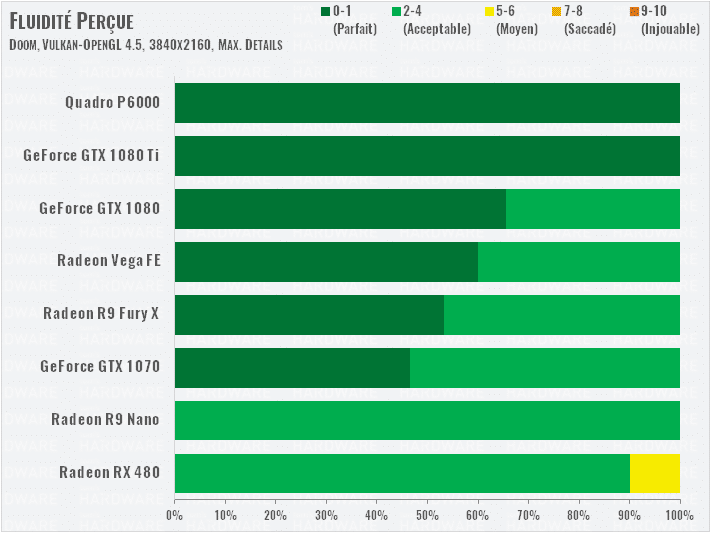

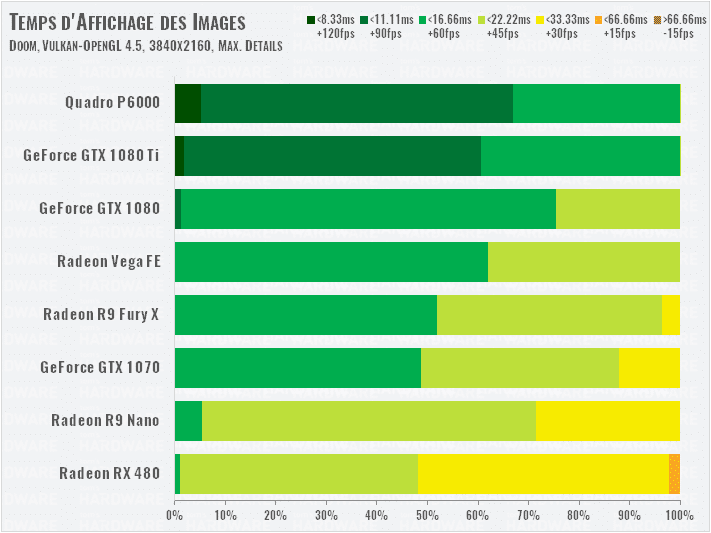

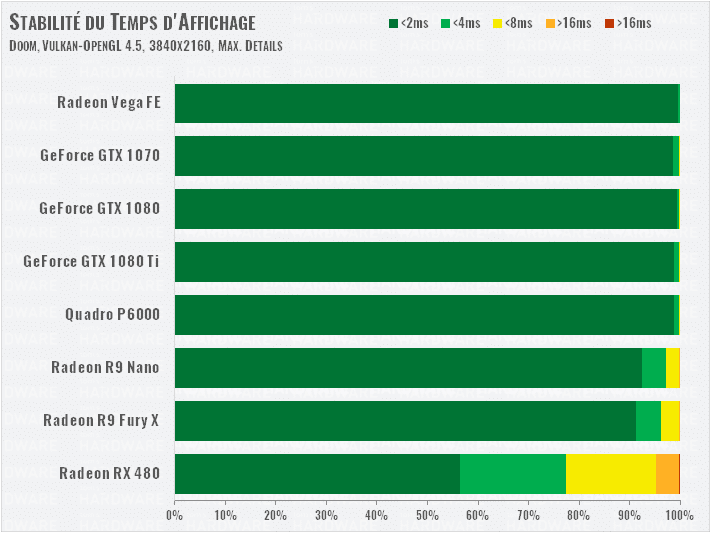

Doom (Vulkan)

Normalement, Doom est le domaine de prédilection des architectures GPU d’AMD, particulièrement sous Vulkan. Mais la Vega FE ne semble pas trop en profiter : juste sous la GTX 1080 et loin derrière la GTX 1080 Ti. Remarquez toutefois que sur ce jeu, NVIDIA a récemment optimisé les performances de ses GPU sous Vulkan, avec des résultats payants !

Consommation en détail

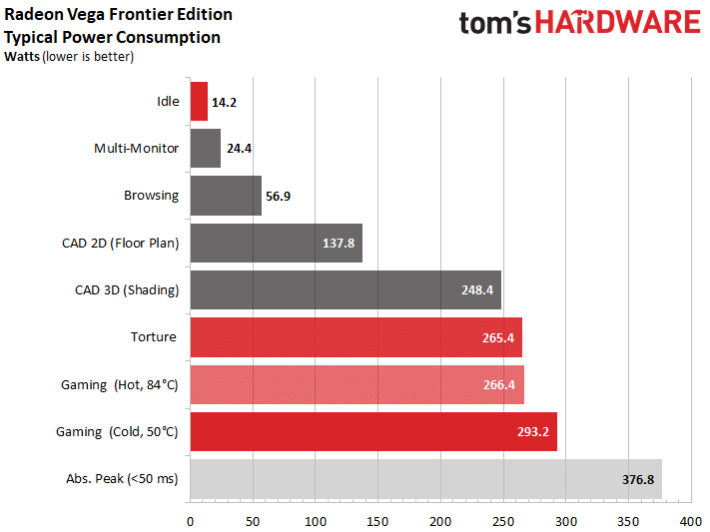

Au repos, la carte consomme 14 W, ce qui est correct si on compare cela avec ce qu’elle est capable d’engloutir, même si nous aurions préféré une valeur un peu moins élevée. La consommation s’affole un peu en mode multi-écrans avec des résultats très aléatoires : 24 W pour deux moniteurs identiques, cela passe encore, mais 40 W pour trois moniteurs différents, au repos, c’est clairement trop.

Dans des tâches de productivité classiques, on oscille entre 140 W (dessin en 2D, rendu wire frame d’objets 3D) et presque 250 W (dans OpenGL), avec des pointes à 265-275 W en rendu (selon la température du GPU).

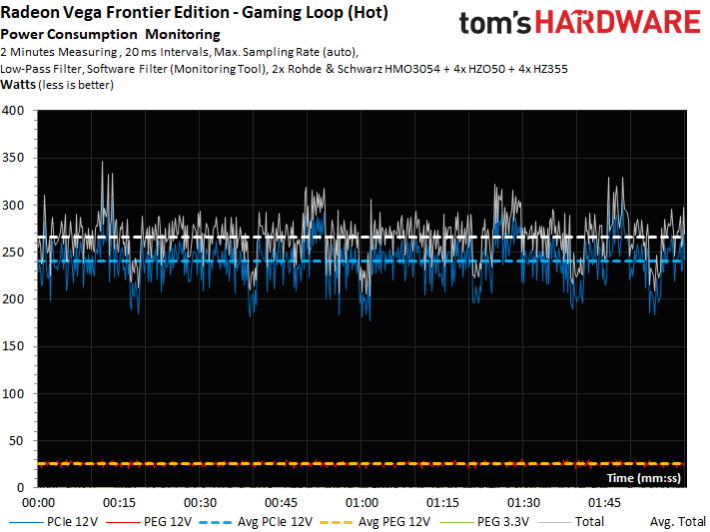

Consommation en jeu

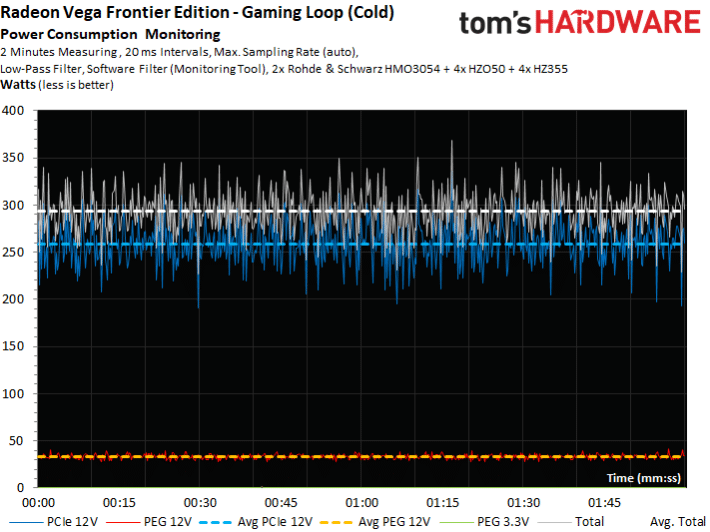

La consommation du GPU et sa fréquence dépendent de la température du GPU. Si la carte n’est pas chaude, la consommation peut monter à 300 W et atteint de courts pics à 380W. C’est beaucoup, mais pas non plus dramatique, la plupart des alimentations actuelles sont en mesure de répondre à ces besoins très ponctuels.

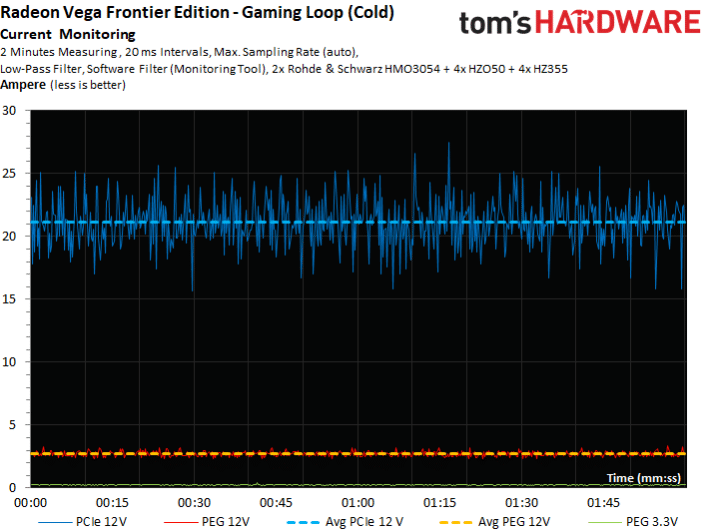

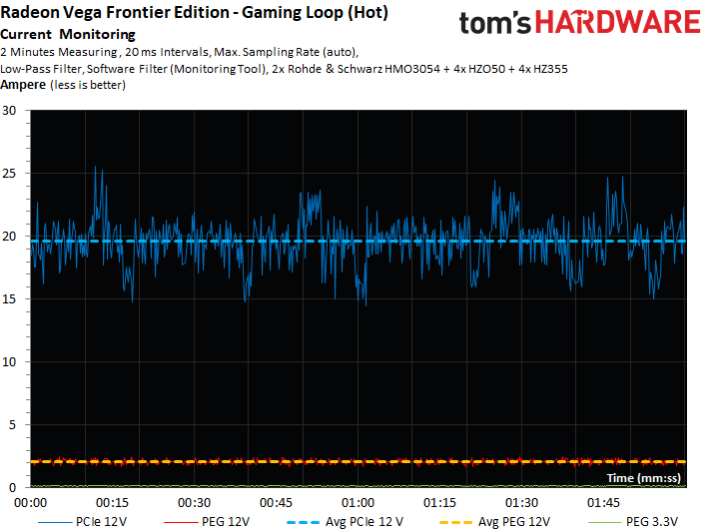

L’intensité du courant est très semblable :

Une fois que la carte a atteint la température cible de 84°C, la consommation et la fréquence diminuent, on tombe alors à environ 266 W :

L’intensité du courant diminue logiquement de la même manière :

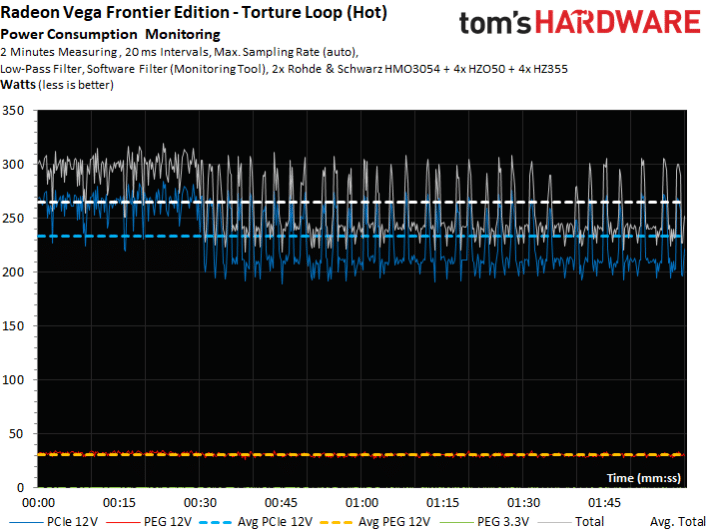

Stress test et coups de frein

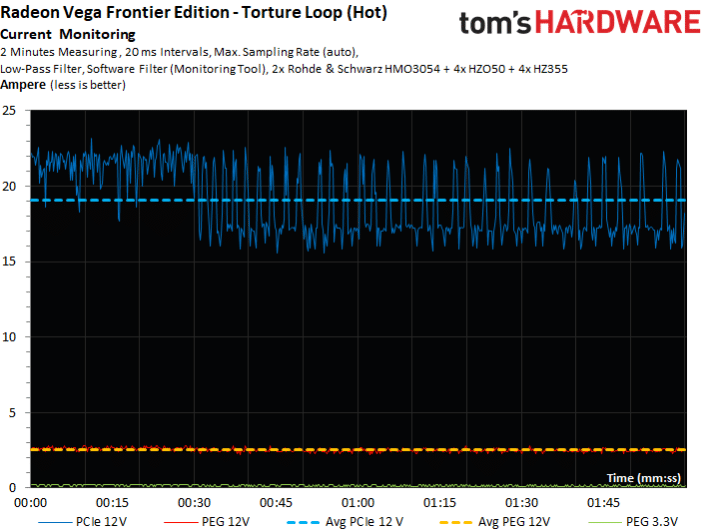

Observons ce qui arrive quand la consommation augmente trop. Le graphique suivant montre que le gestionnaire de consommation baisse fortement celle-ci, puis relâche la pression quelques instants pendant lesquels elle s’envole à nouveau, avant d’être de nouveau freinée. Le comportement de la carte est ici très différent de celui en début d’échauffement.

L’intensité du courant enregistre les mêmes variations importantes :

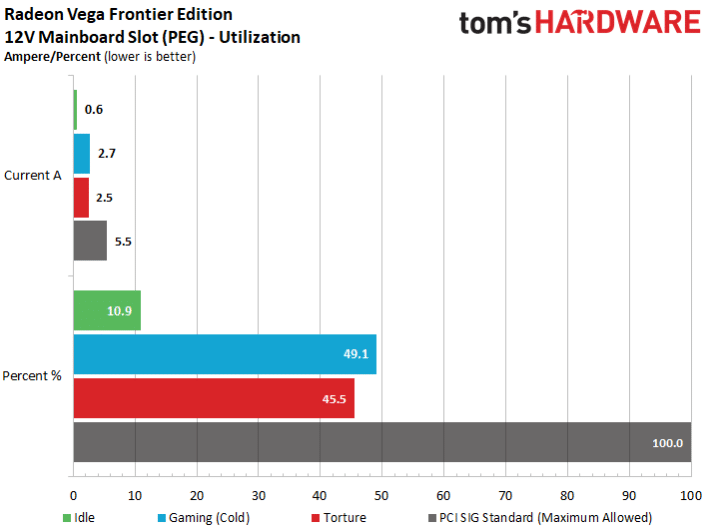

Sollicitation de l’alimentation de la carte mère

C’est un aspect que les lecteurs nous demandent à chaque fois de tester depuis le lancement de la Radeon RX 480 qui tirait beaucoup trop de courant de la carte mère. Depuis, nous vérifions que chaque carte qui passe entre nos mains respecte les normes en vigueur. Cette fois, aucune raison de s’inquiéter, la carte tire au maximum 2,7 A de la carte mère, c’est à dire à peine plus de la moitié de ce qui est permis.

Températures et bruit

Évolution de la fréquence par rapport aux températures

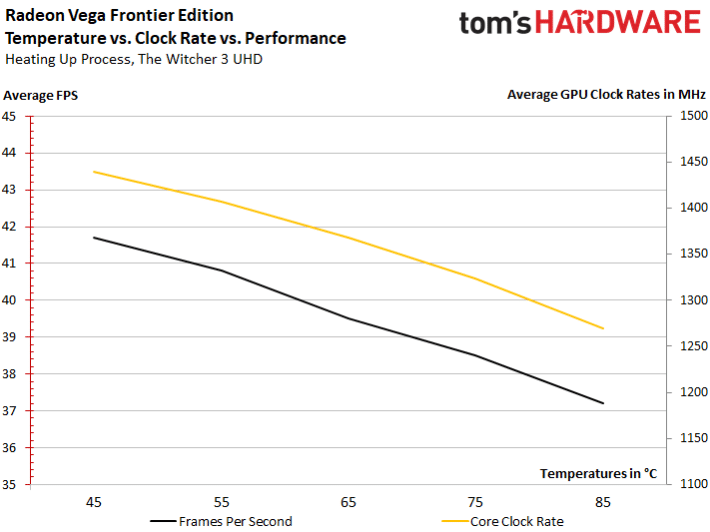

Le ventilateur est réglé de manière conservative, de sorte que la température maximale de 84°C est vite atteinte (et très ponctuellement dépassée). Au-delà, la carte réduit d’environ 10% sa performance en diminuant la fréquence du GPU. Nous avons mesuré la perte de performance concédée aux cours de nos tests par tranche de 5 degrés. La fréquence oscille entre 1440 MHz quand la carte est encore froide et 1269 MHz au plus chaud. Le graphique suivant montre que la performance et la fréquence diminuent de manière similaire, et si on prend les 1269 MHz comme point de départ, on note un gain de performance de 10 % pour une fréquence 12 % supérieure à 1440 MHz lorsque la carte est encore froide.

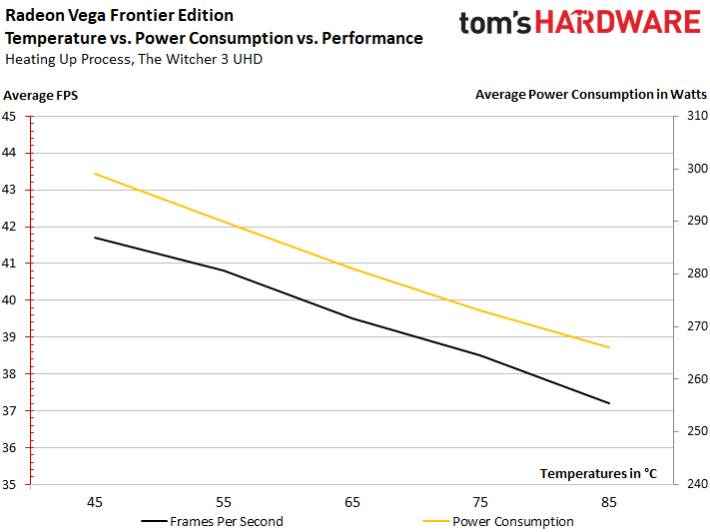

Évolution de la température et de la consommation

C’est ici que ça se corse. En pleine charge à 1269 MHz, la carte consomme 266 W, à 1440 MHz près de 300 W. Pour une fréquence 12% supérieure, la consommation augmente ainsi d’environ 13 % tandis que la performance en jeu augmente d’environ 10%. C’est un rapport plus qu’honnête qui laisse espérer des gains significatifs pour les cartes capables de dissiper correctement les 300 W (et plus) de chaleur émis. Il est cependant peu probable que les cartes partenaires dépassent nettement cette valeur déjà extrême.

On constate aussi que les fuites de courant dues aux hautes températures sont quasi inexistantes. Le temps où les cartes pouvaient consommer jusqu’à 40 W de plus lorsqu’elles étaient chaudes est heureusement révolu.

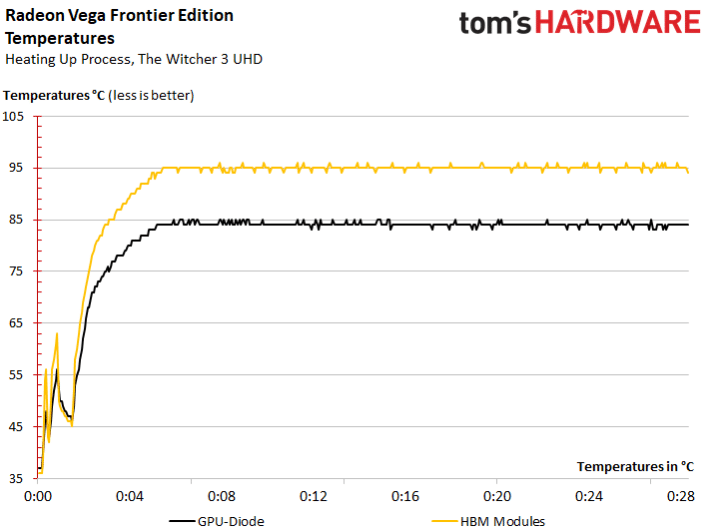

Évolution des températures du GPU et des modules HBM2

En nous basant sur les capteurs internes, nous relevons une température maximale de 84°C (85°C très ponctuellement) pour le GPU et un maximum de 95°C (ponctuellement 96°C) pour les modules HBM2. La température mémoire peut sembler élevée puisque c’est la limite officielle préconisée pour les modules de GDDR5X. Nous garderons cette valeur à l’œil dans les tests suivants, puisque nous ne pouvons pas garantir à 100 % la fiabilité des capteurs de température.

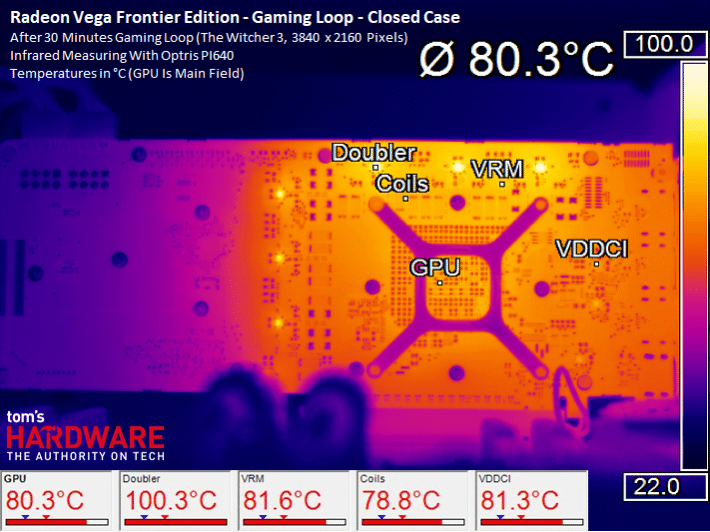

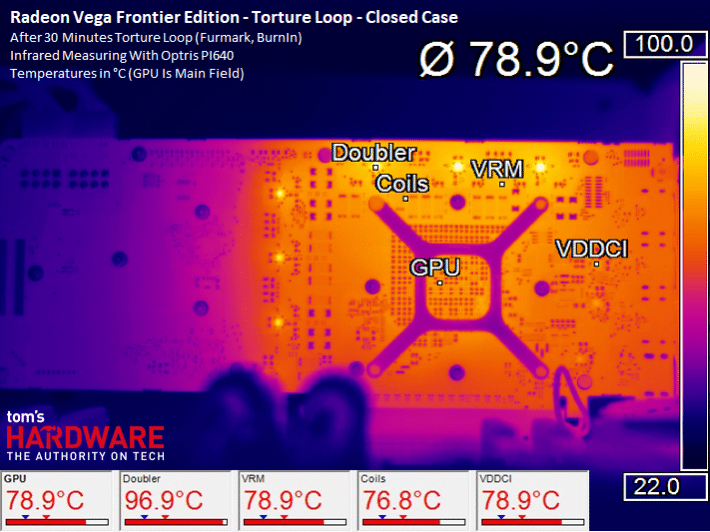

Températures à la surface du PCB

Une chose saute aux yeux : la température sous le socle GPU est environ 5°C inférieure à la température interne du GPU. La raison est à chercher du côté de l’épais package situé entre l’interposer et le PCB, comme nous le décrivons à la deuxième page. L’interposer semble en outre ne pas être parfaitement posé sur le package (problème de type « underfill »), de sorte que l’air fait office de couche d’isolation.

La vidéo suivante montre l’échauffement de la carte en accéléré (les 20 minutes sont accélérées 10 fois) :

En stress test, la température diminue un peu en raison de l’augmentation de la vitesse de rotation du ventilateur conjuguée à la baisse de fréquence, comme indiqué plus haut.

Nuisances sonores

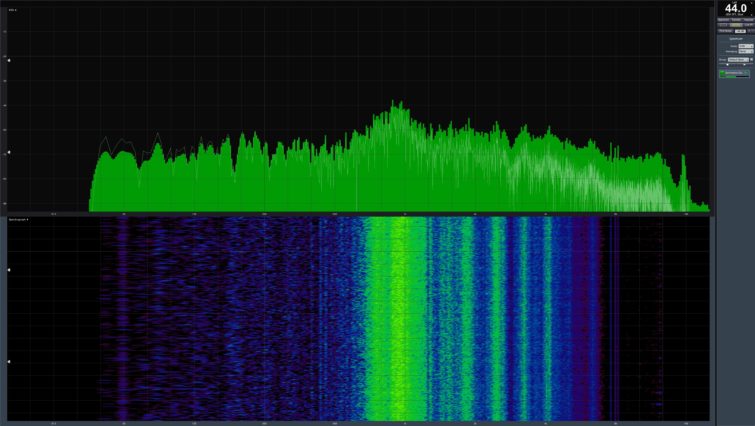

On a ici affaire au meilleur système de refroidissement sur une carte de référence AMD depuis la Radeon HD 2900. Le ventilateur radial produit par Delta permet en effet de se hisser au niveau de la GeForce GTX 1080 Founders Edition. On mesure au maximum 44 dB. Le phénomène de vibration des bobines typique quand on joue à un niveau de FPS élevé est presque indéfinissable dans le reste de la masse sonore. La vidéo suivante donne une idée de ce à quoi il faut s’attendre :

Cette impression subjective est confirmée par l’analyse du spectre sonore. On n’observe aucun ronronnement dans les basses fréquences souvent dus à des roulements à bille ou des moteurs de mauvaise qualité, et le léger couinement des bobines aux alentours de 8 KHz est bien fondu dans la masse, comme on peut le voir :

Le bruit produit est généré principalement par le souffle du ventilateur et reste contenu. Une GeForce GTX 1080 Ti consommant 250 W n’est pas beaucoup plus silencieuse, alors qu’elle a moins de chaleur à évacuer. Si on augmente le Power Target de la GeForce à 270 W, les nuisances sonores sont comparables. Les deux constructeurs sont donc au coude à coude et feront difficilement mieux à l’avenir, puisqu’il n’est pas physiquement possible de faire mieux sans repenser entièrement le refroidissement. Or, un système de refroidissement ne doit pas valoir plus de 35 dollars et économiquement parlant, cela ne ferait pas de sens d’en proposer un plus performant.

Conclusion

En résumé

Depuis bientôt un an, AMD tient en haleine tout le monde avec sa nouvelle architecture annoncée comme révolutionnaire, mais malgré toutes les annonces, nous ne saurons finalement que fin juillet, avec la sortie des pilotes pour les Radeon RX Vega, si cette nouvelle architecture est vraiment en mesure de rétablir AMD dans le haut de gamme pour les jeux vidéo. L’un des enjeux centraux pour ce comeback, c’est le bon fonctionnement du DSBR (Draw Stream Binning Rasterizer). Pour l’instant, on ne peut donc toujours pas dire, malgré ce test, ce qu’il en sera finalement. Cette analyse approfondie devrait plutôt être vu comme un aperçu de ce qui nous attend plutôt qu’une conclusion définitive.

Ce qu’on a appris dans ce test, c’est qu’AMD ne prétend pas vendre avec la Radeon Vega Frontier Edition une carte gamer. Sa performance dans les jeux n’est donc pas forcément représentative, même si nous soupçonnons une concurrence face à la GTX 1080. Par contre, en tant que carte pro et en laissant de côté les benchmarks ultra optimisés, la carte a pu convaincre avec une prise en charge d’OpenGL et de la gestion efficace des couleurs en 10 bits dans les programmes testés. La Titan XP de Nvidia doit, elle, se contenter de DirectX.

La performance dans ce domaine nous a vraiment surpris, car c’est un marché de niche dans lequel les cartes nettement plus chères de la concurrence sont à la peine. La carte fonctionne donc très bien si les pilotes Radeon Pro ont été correctement optimisés. On aurait donc tendance à penser que la Vega FE est en fait plus une carte pro WX qu’un véritable hybride aussi bon en workstation qu’en gaming.

Ce compromis est réalisé avec un mélange de pilotes pro et gamer. Il faut cependant dire que la partie gaming consiste principalement en la mise à disposition de profils gamings, de Wattman, etc. La partie Radeon Pro permet quant à elle de faire tourner des applications professionnelles uniquement disponibles avec ces drivers, ce qui ouvre donc de nombreuses perspectives.

Alors oui, on peut jouer avec cette carte, mais tout ne fonctionne pas encore parfaitement. Nous ne pouvons malheureusement en l’état pas en dire plus, puisqu’on ne sait toujours pas ce que les pilotes nous réservent. Nous nous bornons à dire qu’on a été un poil déçus, on aurait attendu un peu mieux. Mais peut-être est-ce un dernier bluff pour nous surprendre encore plus ? En l’état, la performance en jeu n’atteint même pas celle d’une GeForce GTX 1080, un saut en performance pas vraiment intergalactique.

Conclusion

Une chose est sûre : une carte pro qui sache aussi jouer est une alternative séduisante. Surtout quand son prix reste relativement modéré. Ce n’est pas une carte pour gamer, c’est une carte avant tout pour travailler, qui répond surtout aux attentes des pro.

Si l’un des programmes pro les plus utilisés tourne bien sur la Radeon Vega Frontier Edition, on peut même dire que c’est une sacrée bonne affaire. Compatibilité totale des pilotes pour une fraction du prix de la concurrence : de cette façon, la fuite vers un marché de niche peut devenir une fuite en avant qui pourrait réussir. Oui, pourrait, car à la fin, c’est toujours le client qui décide.