Une Titan X pour tous

Le lancement de la GeForce GTX 1080 Ti lors de la Game Developer Conference ne fut une surprise pour personne. Selon l’habitude prise depuis 2013, la Ti vient offrir à peu près les performances du modèle Titan, pour un prix « cassé ». Pourquoi la lancer maintenant ? Parce qu’elle est prête, nous répond Nvidia. Et parce que son éventuelle concurrente la Radeon RX Vega, elle, ne l’est pas, pourrait-on ajouter.

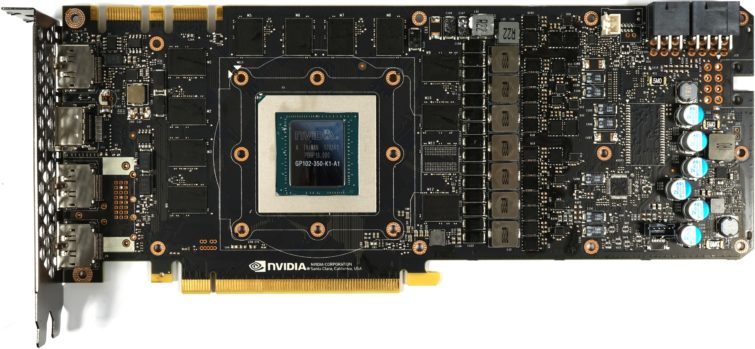

GeForce GTX 1080 Ti Founders Edition

-

€

geforce gtx 1080 ti founders edition349.99€

-

349.99€

-

1198€

-

1198€

Transformer un défaut en qualité

Il existe deux catégories de cartes basées sur un GPU GP102 : la Titan X et la Quadro P6000. La première possède une version du GPU privé de deux Streaming Multiprocessors alors que la seconde est la seule à utiliser un GP102 complet et parfait. Mais puisqu’il s’agit d’une puce de 12 milliards de transistors, sa production ne peut pas être si bonne que toutes les puces tombent dans l’une ou l’autre de ces catégories. C’est pourquoi Nvidia a créé la GTX 1080 Ti.

| GeForce | Quadro P6000 | Titan X | GTX 1080 Ti | GTX 1080 | GTX 980 Ti |

|---|---|---|---|---|---|

| GPU | GP102 | GP102 | GP102 | GP104 | GM200 |

| Cœurs CUDA | 3850 | 3584 | 3584 | 2560 | 2816 |

| Fréquence de base (MHz) | 1506 | 1417 | 1480 | 1607 | 1000 |

| Fréquence Boost (MHz) | 1645 | 1531 | 1582 | 1733 | 1076 |

| VRAM | 24 Go GDDR5X | 12 Go GDDR5X | 11 Go GDDR5X | 8 Go GDDR5X | 6 Go GDDR5 |

| Taille du die | 471 mm² | 471 mm² | 471 mm² | 314 mm² | 601 mm² |

| Gravure | 16 nm | 16 nm | 16 nm | 16 nm | 28 nm |

| Transistors | 12 milliards | 12 milliards | 12 milliards | 7,2 milliards | 8 milliards |

| Streaming Multiprocessors (SM) | 30 | 28 | 28 | 20 | 22 |

| GFLOPS (Fréquence de base) | 10 883 | 10 157 | 10 609 | 8228 | 5632 |

| Unités de texture | 240 | 224 | 224 | 160 | 176 |

| Texture Fill Rate (GT/s) | 361,4 | 317,4 | 331,5 | 257,1 | 214 |

| ROP | 96 | 96 | 88 | 64 | 96 |

| Pixel fillrate (Gpix/s) | 144,6 | 136 | 130,24 | 114,2 | 116,7 |

| Débit mémoire (Gbit/s) | 9 | 10 | 11 | 10 | 7 |

| Bus mémoire | 384 bits | 384 bits | 352 bits | 256 bits | 384 bits |

| Bande passante RAM totale | 432 Go/s | 480 Go/s | 484 Go/s | 320 Go/s | 336 Go/s |

| Cache L2 | 3 Mo | 3 Mo | 2816 Ko | 2 Mo | 3 Mo |

| TDP | 250 W | 250 W | 250 W | 180 W | 250 W |

Petite cuisine interne

La 1080 Ti utilise un GP102 presque identique à celui de la Titan X : seuls 28 de ses 30 Streaming Multiprocessors (SM) sont actifs, ce qui se traduit par un total de 3584 coeurs CUDA et 224 unités de texture. Nvidia pousse la fréquence sur la 1080 Ti à 1480 MHz de base et 1582 MHz en Boost. Pour comparaison, la Titan X tourne respectivement 1417 MHz et 1531 MHz.

On commence à trouver des différences entre les GeForce 1080 Ti et Titan X au niveau du back-end. La Titan X, comme la Quadro P6000, profite des 12 contrôleurs mémoire 32 bits du GP102, de tous ses ROP et de tous ses caches L2 – ce qui ne laisse pas de place aux défauts de fabrication. Plutôt que mettre des GPU imparfaits au rebus, Nvidia les récupère pour la GTX 1080 Ti, qui est privée d’un contrôleur mémoire, d’un ROP et de 256 ko de cache L2. Sa fiche technique paraît ainsi bizarre, avec un bus mémoire sur 352 bits, 88 ROP et 2816 ko de cache L2.

La GeForce GTX 1080 Ti part donc avec un léger handicap au niveau de la bande passante mémoire. Mais depuis le lancement de la GeForce Titan X Pascal, Micron a lancé de nouvelles puces de GDDR5X plus rapides à 11 et 12 Gbit/s. Cette mémoire tombe à pic pour Nvidia et fait plus que compenser le rétrécissement du bus mémoire : la GeForce GTX 1080 Ti offre ainsi d’une bande passante de 484 Go/s, contre seulement 480 Go/s pour la Titan X.

Amputer la carte d’un de ses canaux mémoire a tout de même une conséquence : sa capacité diminue de 12 Go à 11 Go. Pas de quoi s’inquiéter quand ses concurrentes, comme la Radeon R9 Fury X, n’embarquent que 4 Go et se débrouillent en 4K. La GTX 1080 Ti ne pas réitère ainsi pas l’erreur de la GTX 970, qui était elle aussi privée d’une partition ROP/cache L2, mais avait conservée sa mémoire, au prix d’une bande passante sacrifiée sur les derniers 512 Mo. Sur la 1080 Ti, les 11 Go tournent à pleine vitesse.

Analyse physique de la carte

Apparence, construction et branchements

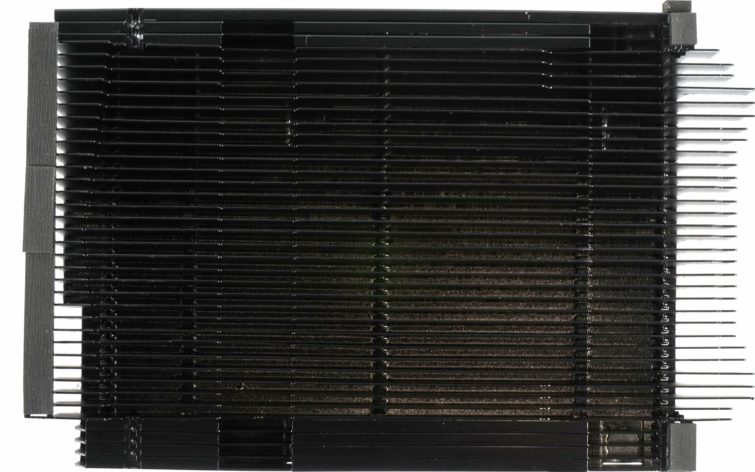

Lors de la présentation de la carte, Nvidia a tenu à préciser que, depuis sa première monture sur la Titan X (génération Pascal), le design du système de refroidissement avait été revu en profondeur. Ce qu’il en est vraiment, nous le verrons tout à l’heure. Car, à l’œil nu, il est bien difficile de constater un changement : même mélange de matériaux en aluminium et plastique, même mise en valeur du ventilateur radial de 6,2 cm et même police utilisée pour nommer la carte.

Avec une longueur de 26,9 cm de l’extrémité de la coque de refroidissement à l’équerre PCI, une largeur de 10,5 cm entre le port PCIe et l’extrémité de la coque, et une épaisseur de 3,5 cm, la carte possède exactement les mêmes dimensions que la Titan X (Pascal). Même gabarit, mais un peu plus de poids sur la balance : on mesure 1039 grammes.

Le dessus de la carte reprend le design habituel des cartes de référence : on retrouve le logo vert rétroéclairé et deux connecteurs d’alimentation externe, l’un à six broches, l’autre à huit. Mentionnons pour finir le dessous de la carte entièrement recouvert par la coque du dissipateur.

L’extrémité intérieure de la carte est dotée des ouvertures d’aération habituelles par lesquelles s’échappe une partie de l’air chaud dans le boîtier, même si cela devrait rester marginal en raison de la conception du système de refroidissement. Nos mesures nous en diront plus.

Pour faire de la place à la grille d’aération et optimiser ainsi le flux d’air, Nvidia a renoncé à la sortie DVI traditionnelle sur l’équerre PCI. On retrouve tout de même trois sorties DisplayPort et une HDMI.

Système de refroidissement

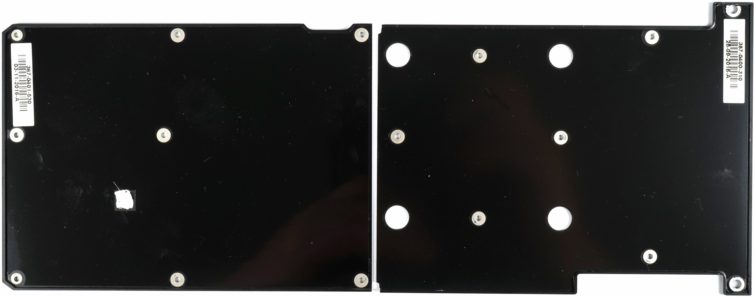

À l’arrière, on ne retrouve pas une, mais deux plaques. Celles-ci sont fixées au reste à l’aide de minuscules vis de 0,5 mm. Elles viennent se loger dans la tête de vis plus larges qui servent à la fois d’écrous et d’armature, car elles assurent aussi la rigidité de l’ensemble. Ces entretoises ne sont visibles qu’une fois les plaques enlevées et leur tête a une forme hexagonale (type M2.5) plutôt inhabituelle.

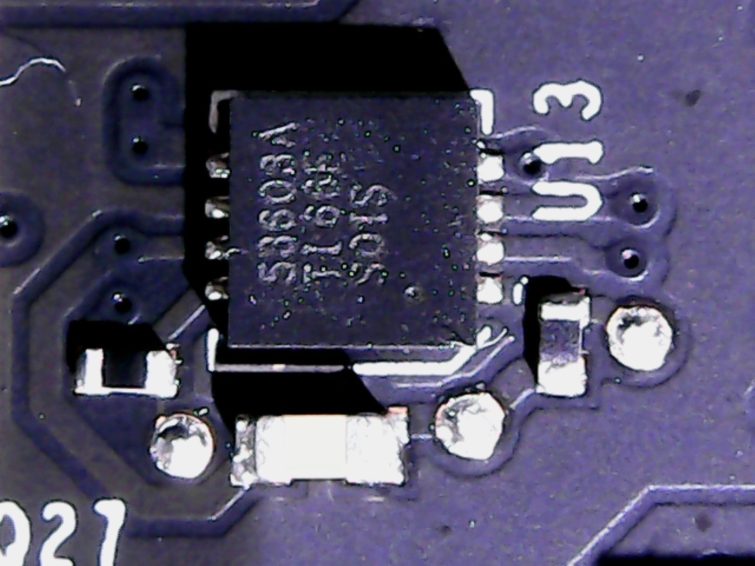

Premier changement visible : Nvidia a placé sous le contrôleur PWM un pad thermique épais en fibres – un matériau inhabituel – qui transmet la chaleur à l’une des deux plaques arrière. Bonne idée.

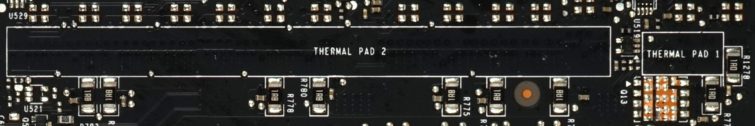

Observons un instant la face arrière du PCB. On remarque deux espaces libres nommés « Thermal Pad 1 » et « Thermal Pad 2 », ce qui suggère qu’Nvidia avait initialement prévu de placer des pads thermiques à ces endroits précis. Pourquoi le constructeur a finalement changé d’avis, nous ne le saurons probablement jamais, mais ces emplacements sont disponibles pour les partenaires qui souhaiteraient utiliser le PCB de référence.

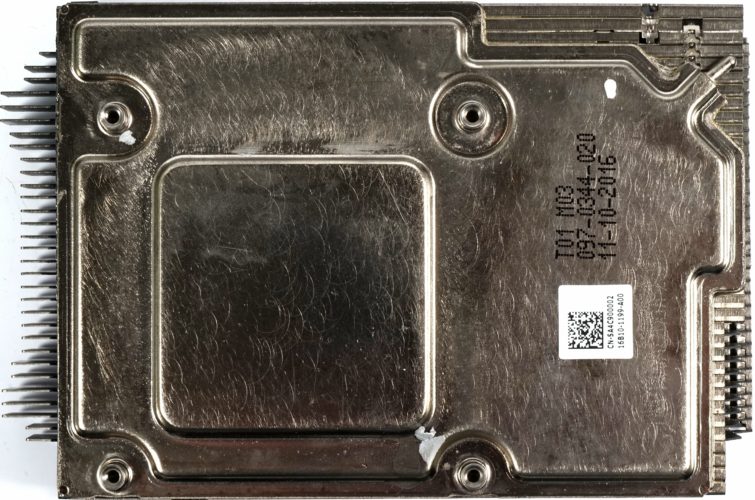

Le massif cadre du système de refroidissement est doté des pads thermiques attendus au niveau des convertisseurs de tension et des modules mémoire. On remarque aussi de nouveaux pads en fibres qui viennent refroidir des composants supplémentaires comme les drivers, diodes et MOSFET. Voilà donc les sont les seuls changements que nous avons pu constater sur le système de refroidissement.

Comme sur les autres cartes Founders Edition, Nvidia a placé une chambre à vapeur juste au-dessus du GPU. Celle-ci est fixée à l’aide de quatre vis à ressorts au PCB et fait office de bloc de refroidissement GPU. Les autres composants sont refroidis par le cadre massif évoqué plus haut.

Qualité des composants et disposition sur le PCB

Pour finir, jetons un coup d’œil au PCB et aux améliorations annoncées par Nvidia. On remarque tout de suite que les convertisseurs de tension ont reçu du renfort puisqu’ils sont maintenant au complet. Sur la Titan X (Pascal), l’espace pour certains d’entre eux était laissé libre.

Nvidia utilise ce modèle depuis la Quadro P6000. On retrouve en effet les huit trous à l’extrémité du PCB initialement prévus pour un connecteur d’alimentation à l’arrière de la carte professionnelle, mais qui ne sont ici pas utilisés.

On s’étonne un peu que Nvidia n’ait pas choisi à la place les MT58K256M321-Ja120, qui montent encore plus en fréquence. Sûrement par peur de problèmes de surchauffe au niveau des modules mémoire dont la tension peut monter à 1,35 V, même s’ils sont spécifiés pour supporter des températures allant jusque 95°C.

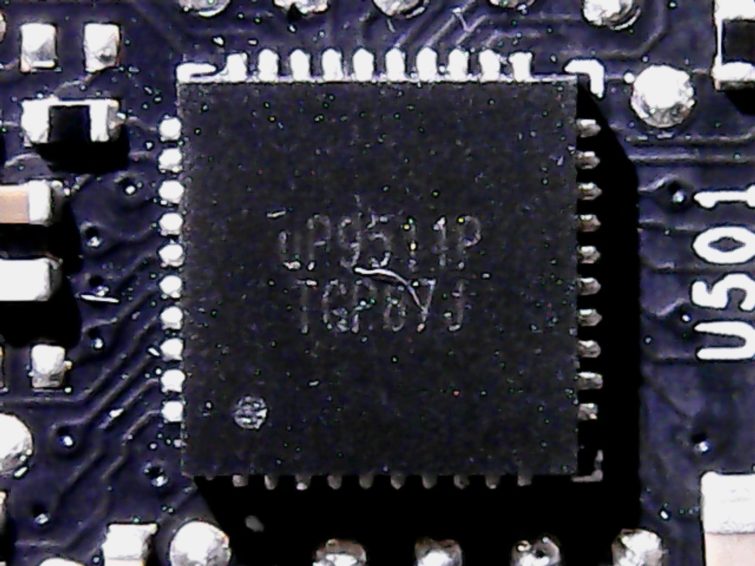

Pas de changement au niveau des convertisseurs de tension du GPU puisque l’on retrouve les sept étages habituels gérés par le contrôleur uP9511, à sa place coutumière à l’arrière du PCB. Le choix de ce contrôleur est logique puisqu’il peut gérer de manière simultanée les sept étages à la différence des contrôleurs à 6 (+2) étages.

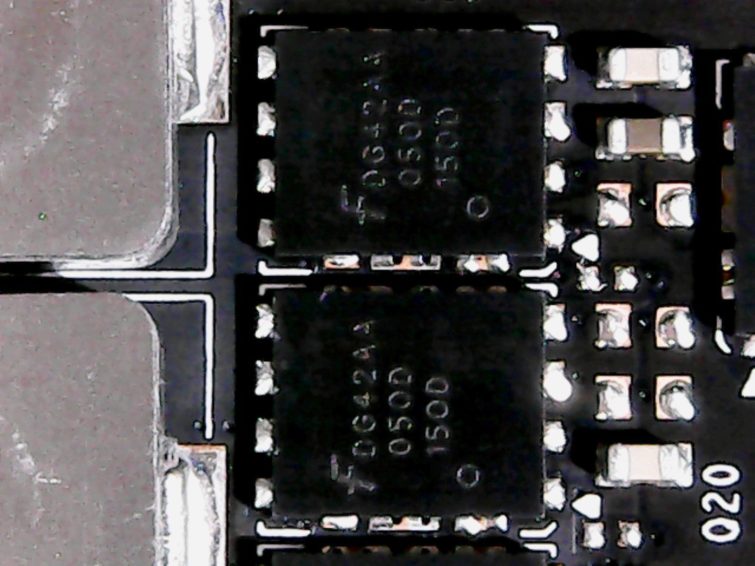

Les étages de conversion de tension sont à la fois simples et efficaces. Simples, car Nvidia se contente d’un convertisseur Buck (le LM53603) pour le haut étage et d’un duo de MOSFET canal N D424 de Fairchild en bas-étage, ce qui permet de répartir sur une plus grande surface le dégagement de chaleur et évite ainsi les points chauds.

Les bobines en ferrite encapsulée sont de qualité comparable aux Magic-Coils de Foxconn. Elles ne traversent pas le PCB et peuvent donc être placées sur le PCB à la machine. On ne comprend par contre pas pourquoi Nvidia ne place pas de pad thermique pour les refroidir, alors qu’il le fait pour les condensateurs juste à côté.

La mémoire est ravitaillée en courant par deux étages d’alimentation régis par un contrôleur uP1685. La conversion du courant en bas étage est assurée par un duo de MOSFET double canal N Logic Level PowerTrench E6930 – une combinaison inhabituelle – et pour le haut étage le FD424 déjà évoqué. Comme ces étages sont plus modestes, les bobines sont logiquement plus petites.

Que peut-on conclure de ce système de refroidissement repensé ? À la lumière des informations récoltées lors de notre démontage, il semble que l’on se soit simplement borné à compléter la panoplie de convertisseurs de tension et à ajouter des pads thermiques sur plus de composants pour améliorer le transfert de chaleur. S’il s’agissait d’un logiciel, on ne parlerait pas de mise à jour, mais plutôt d’un patch.

Méthode de test

Cette carte de luxe prendra place sur des plateformes de luxe. Nous l’avons donc testée avec un système haut de gamme à base de CPU Core i7-7700K sur une carte mère MSI Z170 Gaming M7, avec un kit de mémoire vive G.Skill F4-3000C15Q-16GRR. Le 7700K reste le processeur le plus efficace pour les jeux vidéo, avec une très haute fréquence de 4,2 à 4,5 GHz, il est notamment plus efficace que les processeurs dotés de plus de coeurs, mais tournants à des fréquences moins hautes. L’ensemble est accompagné d’un dissipateur Noctua NH-12S et d’un SSD Crucial MX200, le tout alimenté par un bloc be quiet! Dark Power Pro 850 W.

Nous avons comparé la carte à plusieurs modèles haut de gamme :

- NVIDIA GeForce TITAN X (Pascal) à 1300 euros

- AMD Radeon R9 Fury X

- GeForce GTX 1080

- GeForce GTX 1070

- GeForce GTX 980 Ti

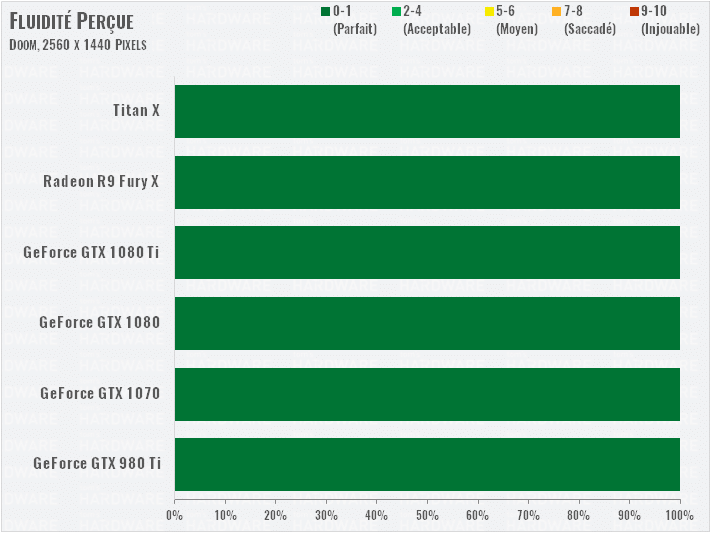

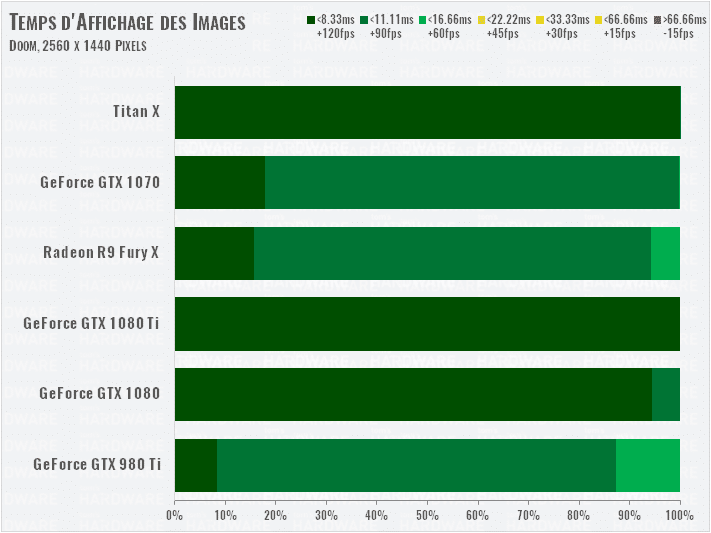

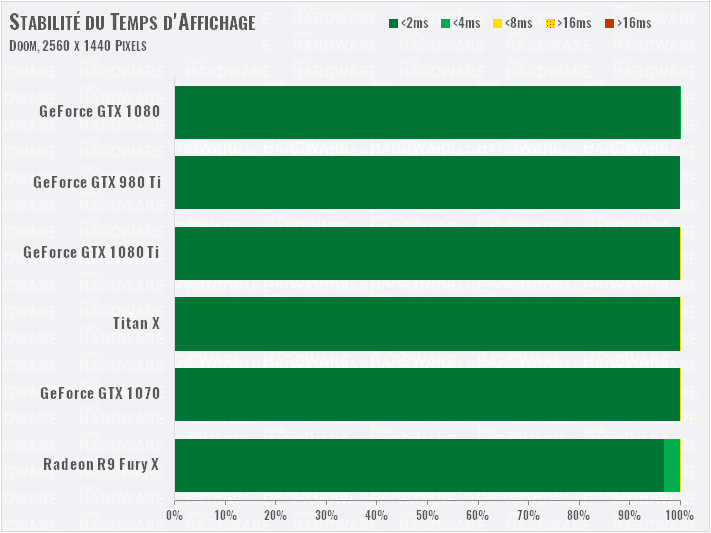

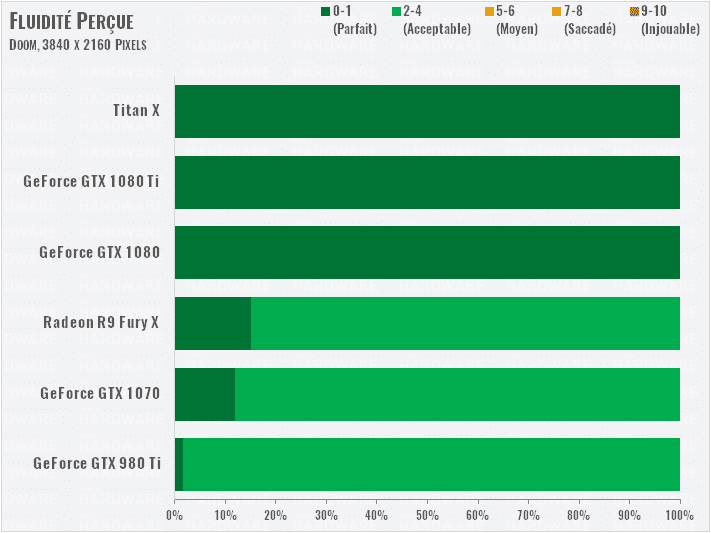

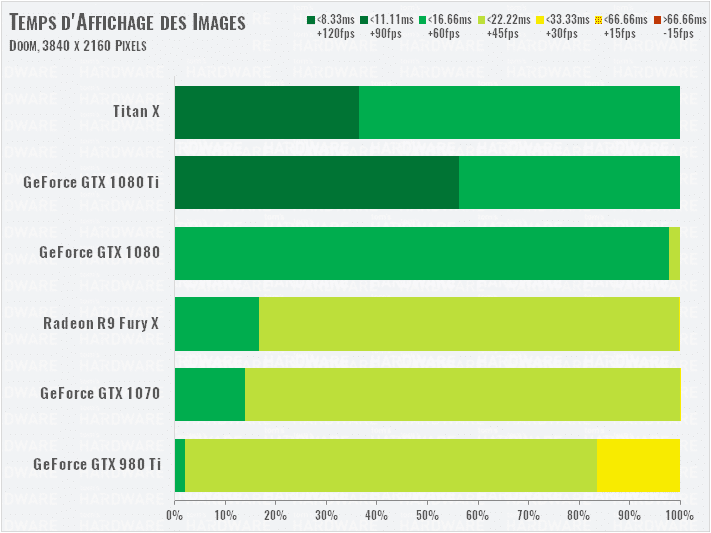

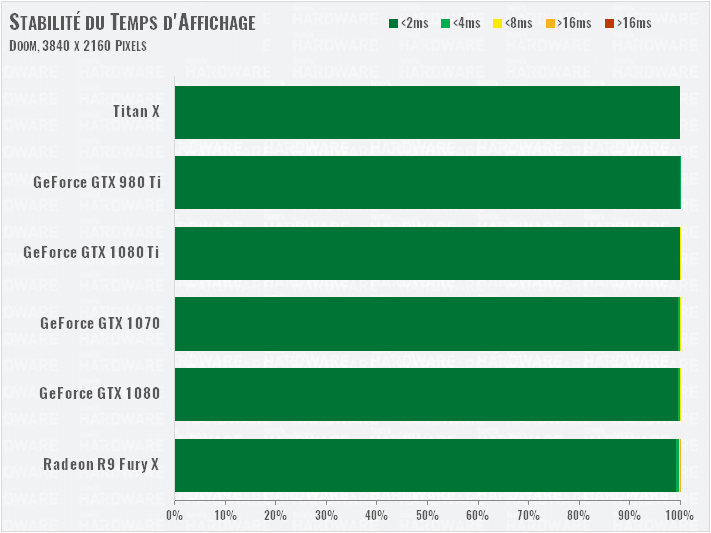

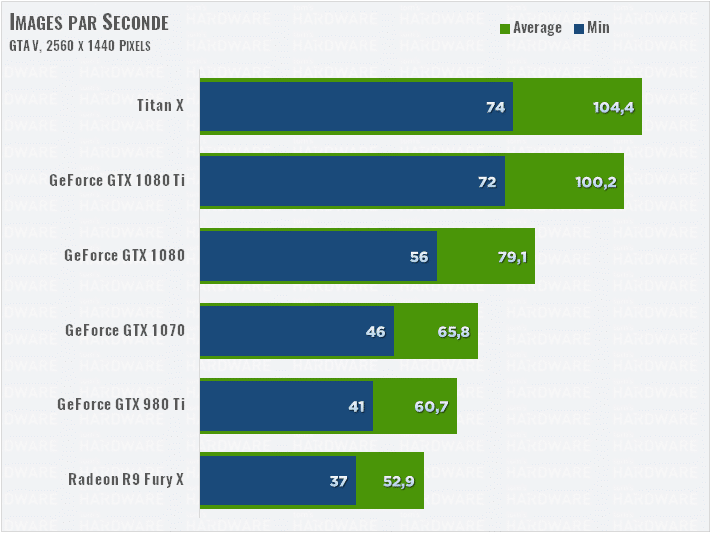

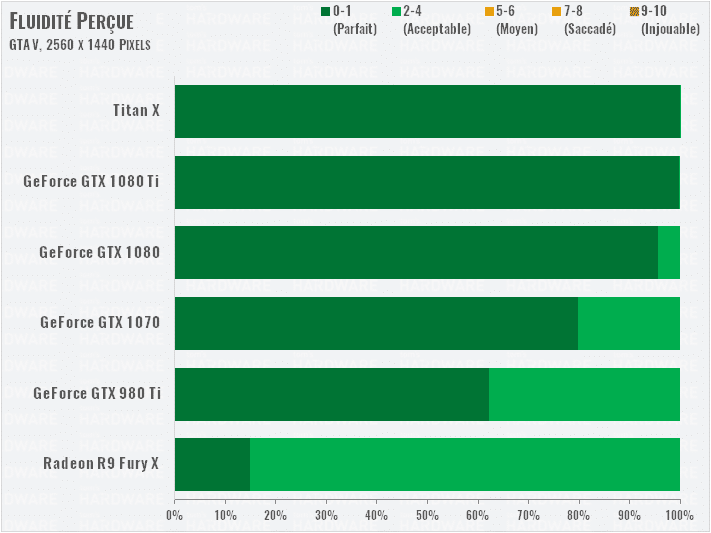

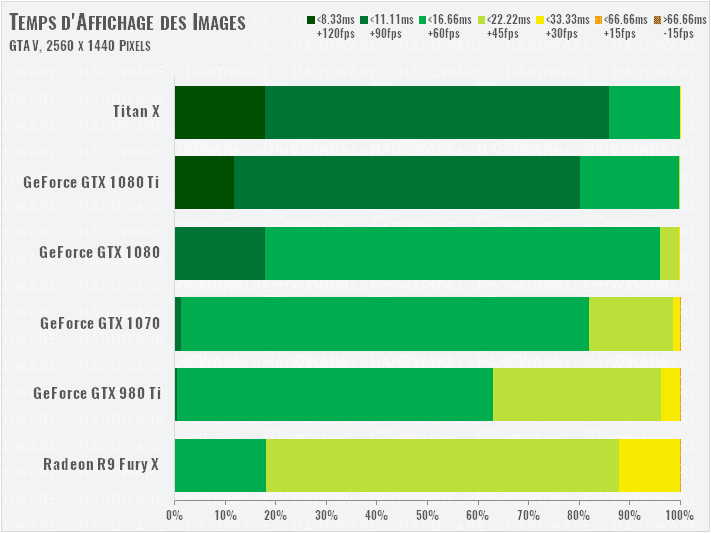

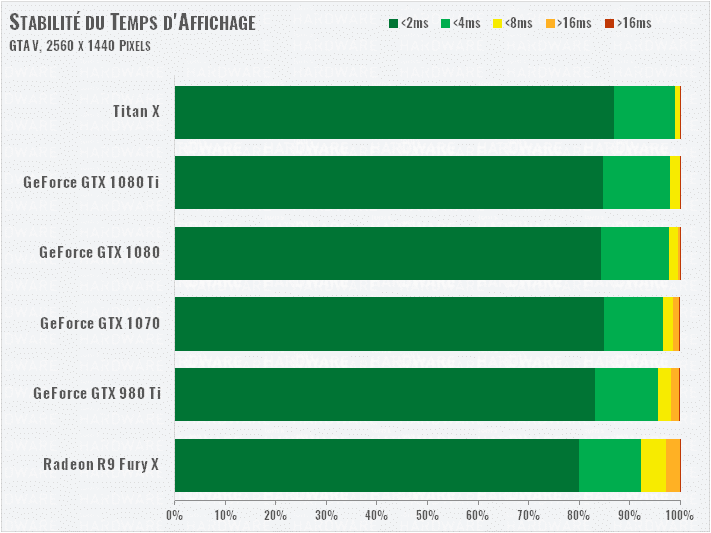

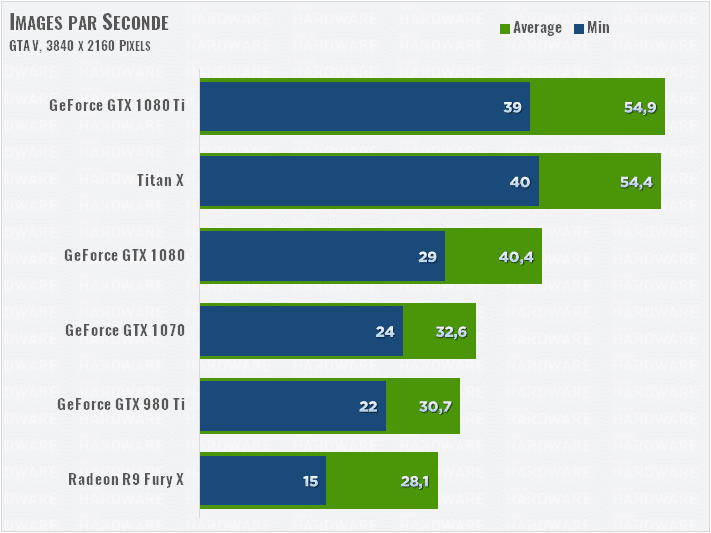

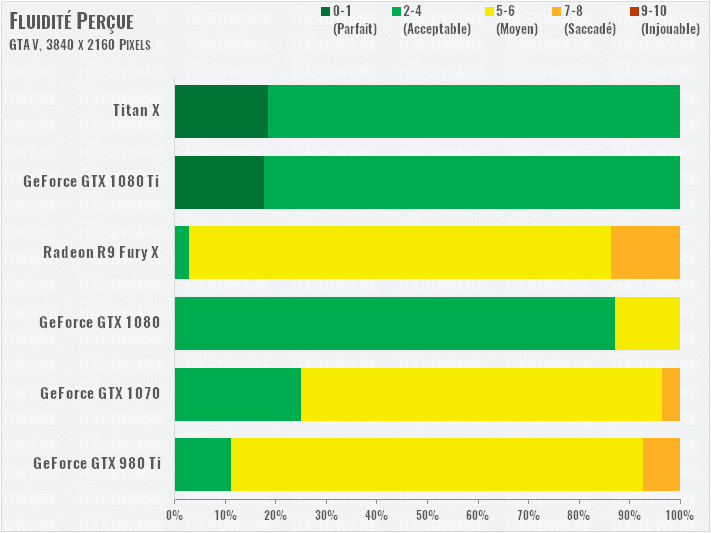

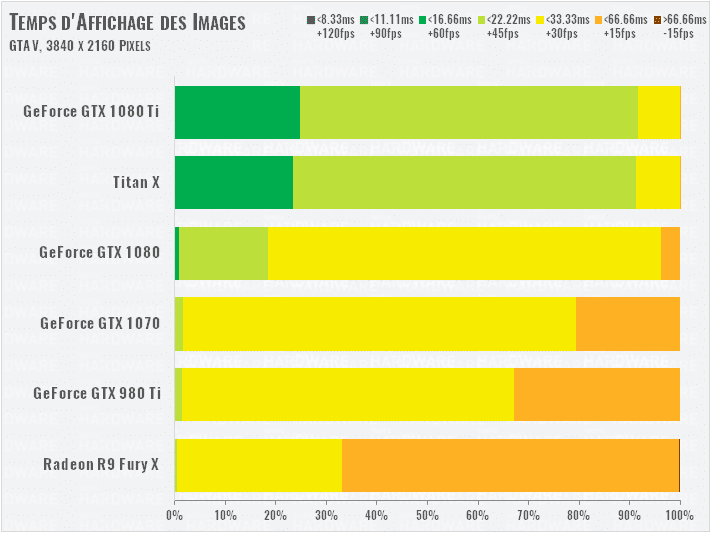

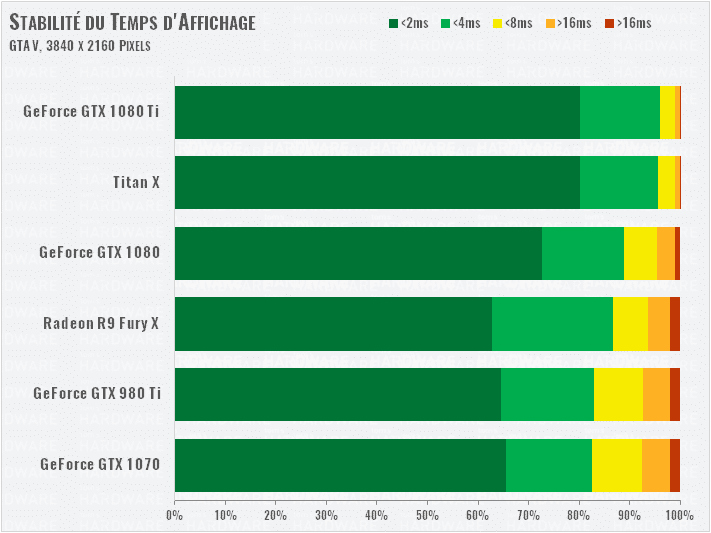

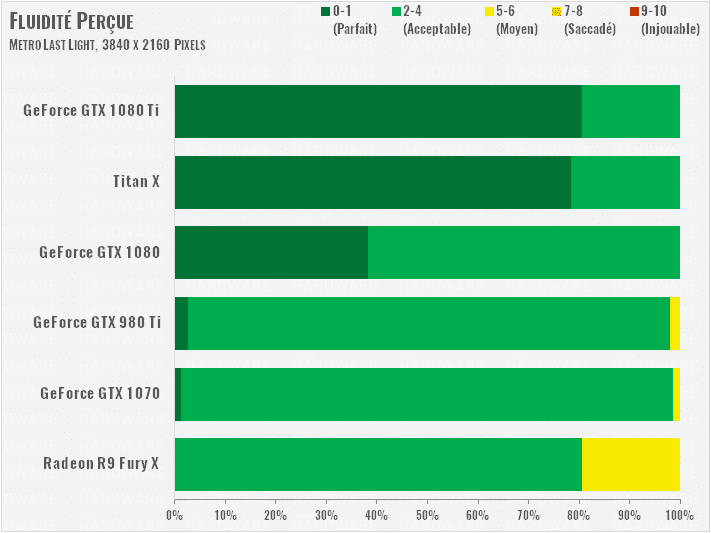

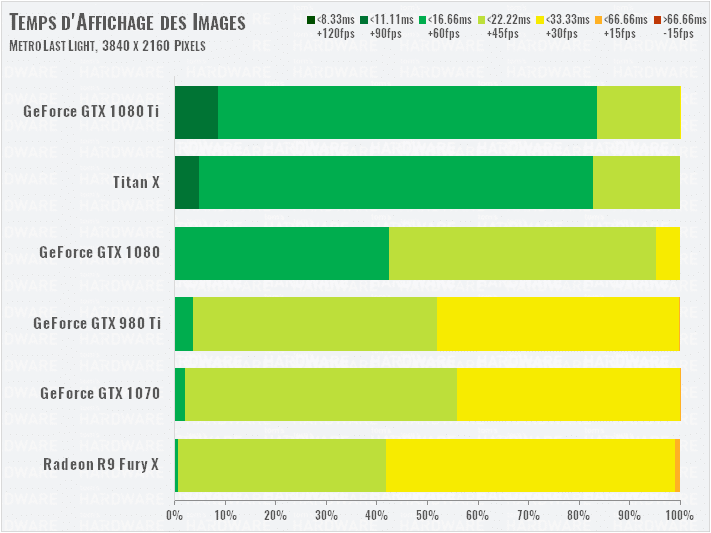

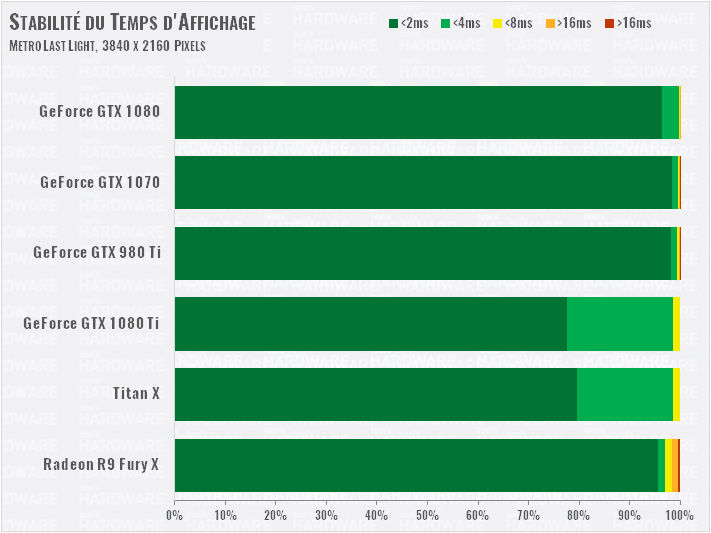

La méthode de test exploite plusieurs logiciels pour analyser les performances en profondeur : PresentMon avec notre propre interpréteur de données fait maison, pour offrir des résultats détaillés, et notamment un indice de fluidité réelle constatée à l’écran. Nous utilisons aussi AIDA64 pour plus d’informations. Nous pouvons ainsi en tirer plusieurs graphiques :

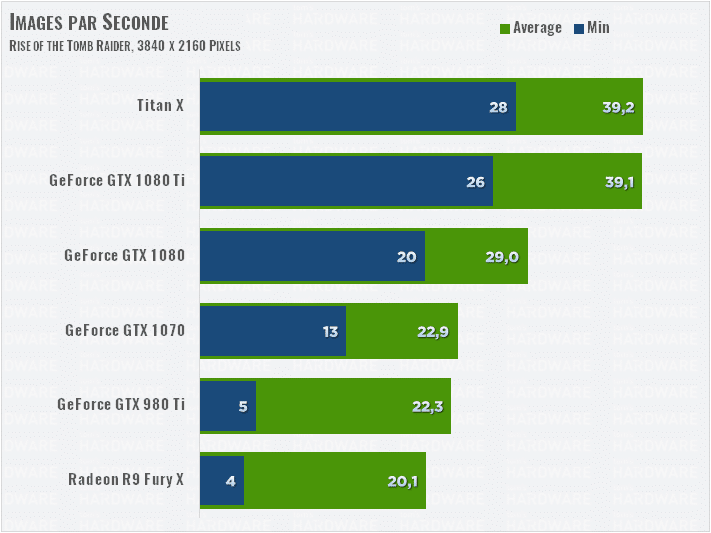

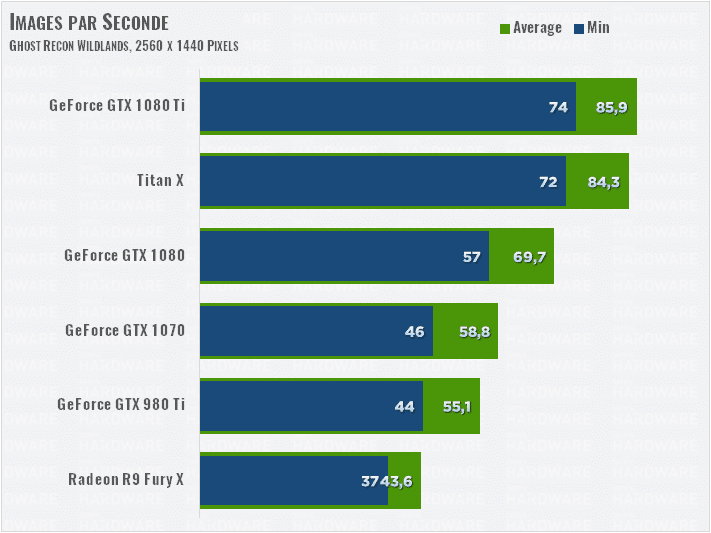

- Le classique nombre d’images par seconde (ips ou fps) : minimal et moyen

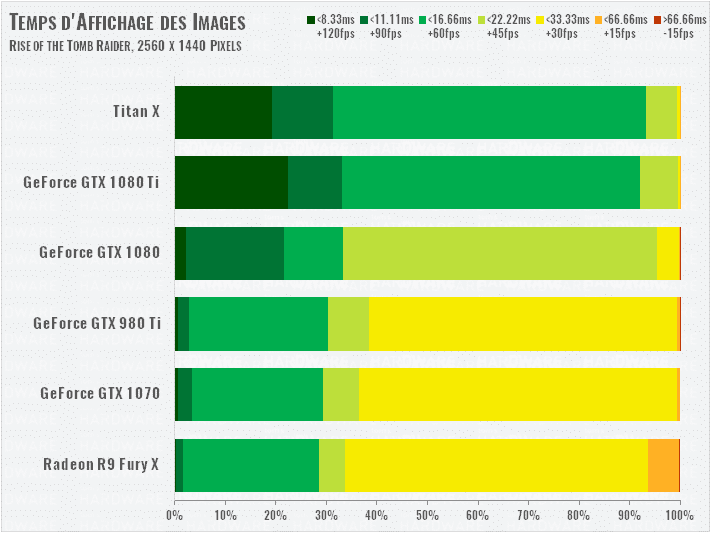

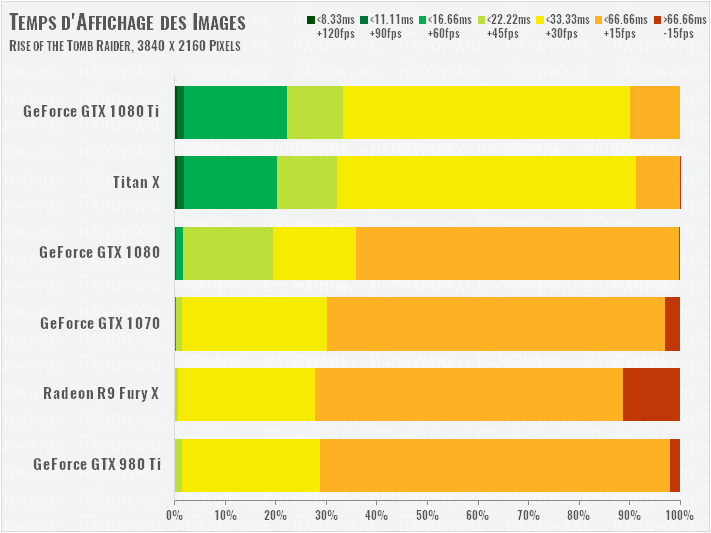

- Le temps d’affichage réel de chaque image (en % des images affichées)

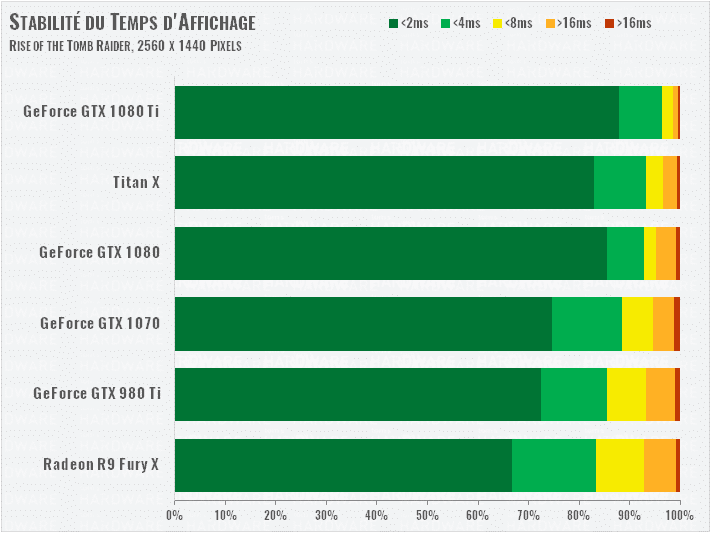

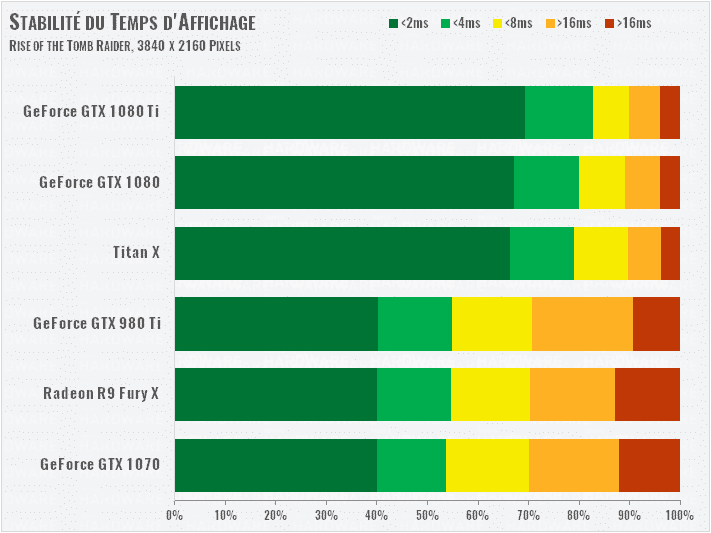

- La stabilité du temps d’affichage : différence de temps d’affichage de chaque image par rapport à la précédente.

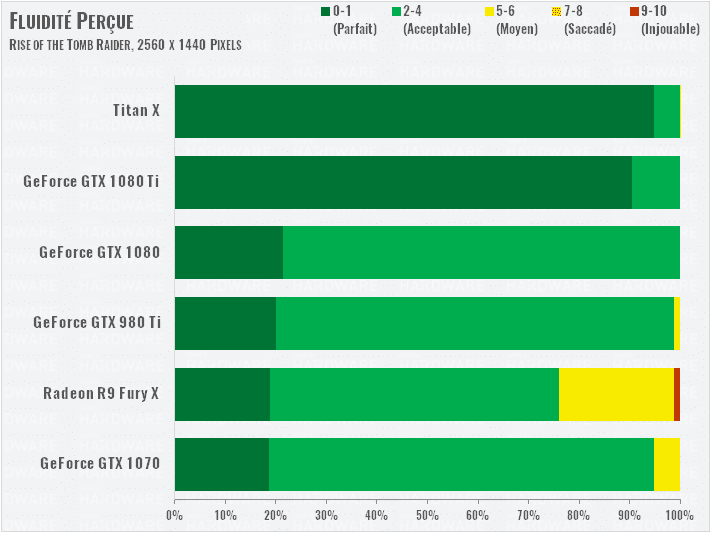

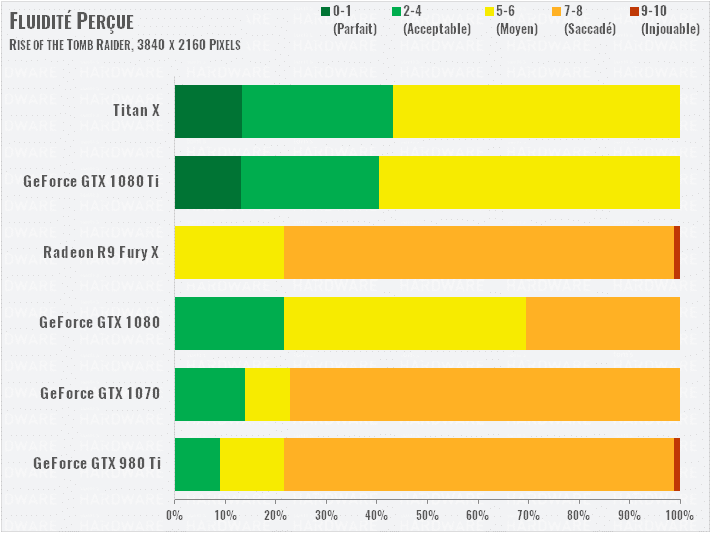

- Un indice de fluidité réelle, calculé à partir des trois précédents graphiques.

Pilotes et benchmarks

Du côté logiciel, pas mal de changements sont à signaler. Nous avons notamment refait tous les tests des cartes graphiques en présence avec leur toute dernière version de pilotes respectifs : Game Ready 378.78 pour NVIDIA, et Crimson ReLive Edition 17.2.1

Nos benchmarks concernent les jeux suivants : Ashes of the Singularity, Battlefield 1, Civilization VI, Doom, Grand Theft Auto V, Hitman, Metro: Last Light, Rise of the Tomb Raider, Tom Clancy’s The Division, Tom Clancy’s Ghost Recon Wildlands, et The Witcher 3. Cette liste substantielle laisse tomber Battlefield 4 (remplacé par le « One » !) et Project CARS, dont les résultats de benchs sont trop spécifiques, mais voit l’arrivée de nombreux autres jeux.

Tous les résultats que vous verrez dans ce dossier sont donc « tout frais », issus de tests refaits pour l’occasion avec les derniers pilotes. Les définitions retenues sont aussi haut de gamme : QHD et UHD/4K, ce qui diminue aussi l’importance du CPU et fait reposer un maximum de boulot sur le GPU que nous souhaitons tester.

Méthode de test pour la température et la consommation

Ces tests sont faits par notre testeur allemand, et vous pouvez consulter leur méthode en détail dans ces deux articles :

- Comment mieux tester une carte graphique : notre nouvelle méthode

- La science au service de nos tests : bien utiliser une caméra thermique

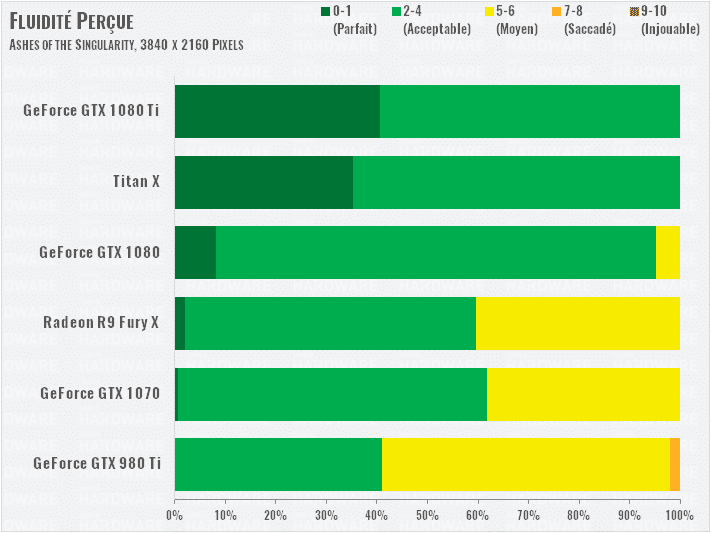

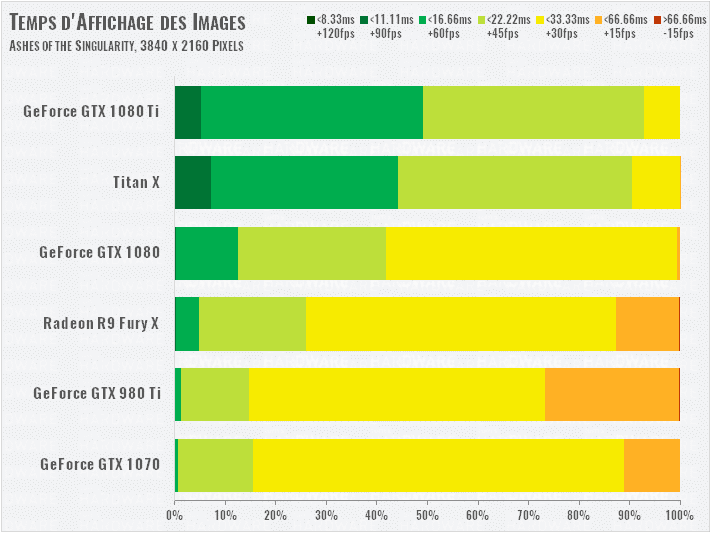

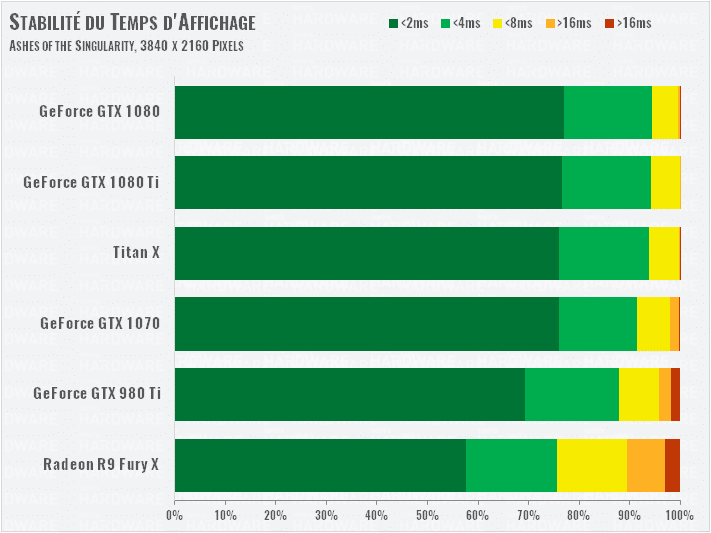

Performances : Ashes of the Singularity et Battlefield 1

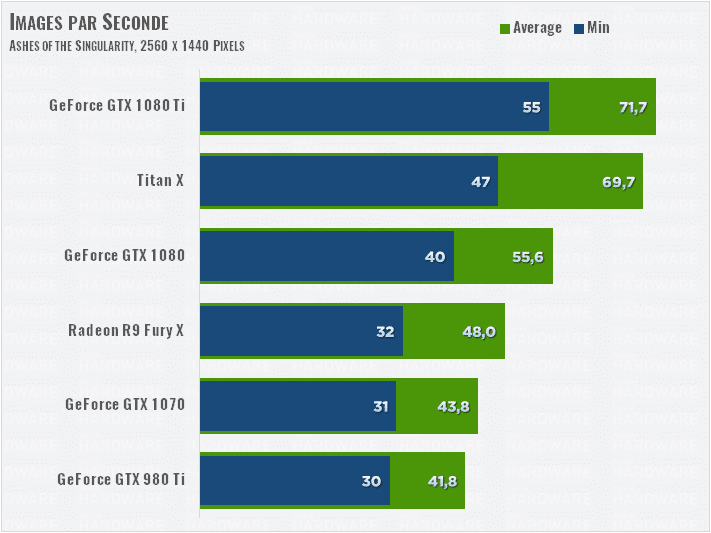

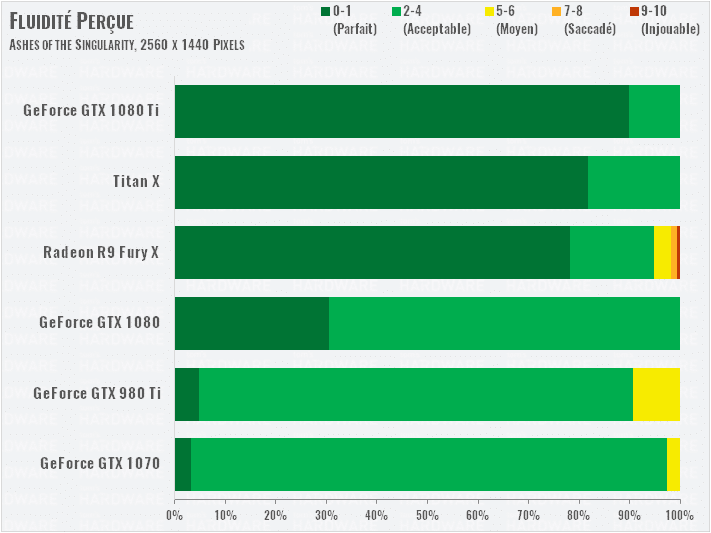

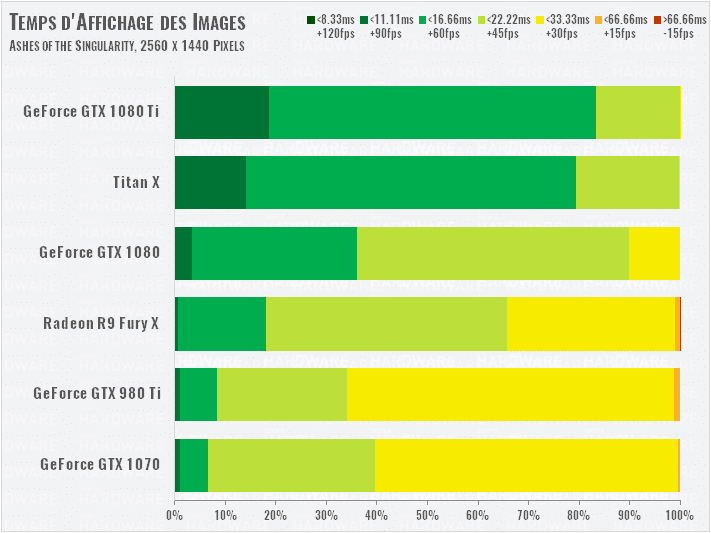

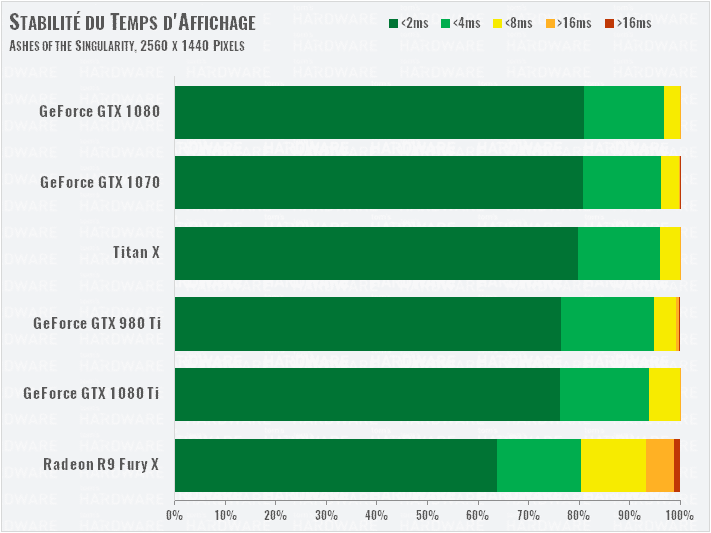

Ashes of the Singularity (DX12)

Dans nos tests précédents, nous utilisions le benchmark d’AotS avec ses réglages Extreme. Cette fois, vue la puissance des cartes, nous sommes passés au niveau Crazy.

La GTX 1080 Ti se montre légèrement plus rapide que la Titan X Pascal.

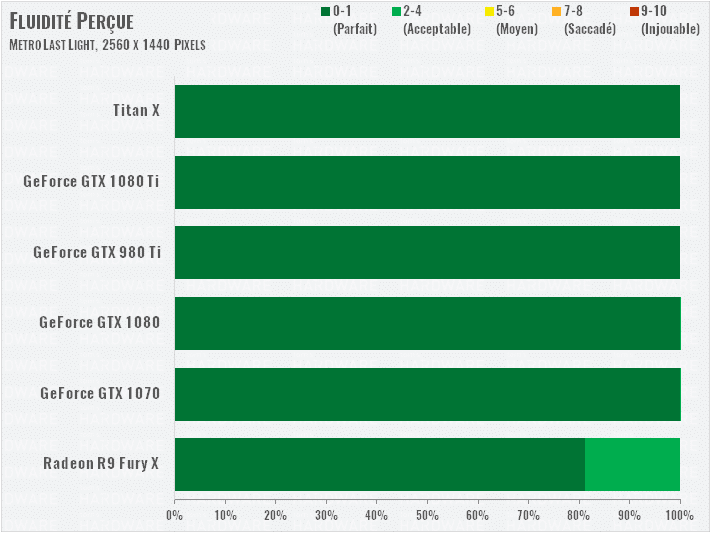

La Radeon R9 Fury X se place remarquablement devant les GeForce GTX 980 Ti et 1070 sur la moyenne d’images par seconde, mais son débit d’images est plus irrégulier que les autres. Elle reçoit donc un indice de fluidité plus faible, avec seulement 80 % du benchmark parfaitement fluide.

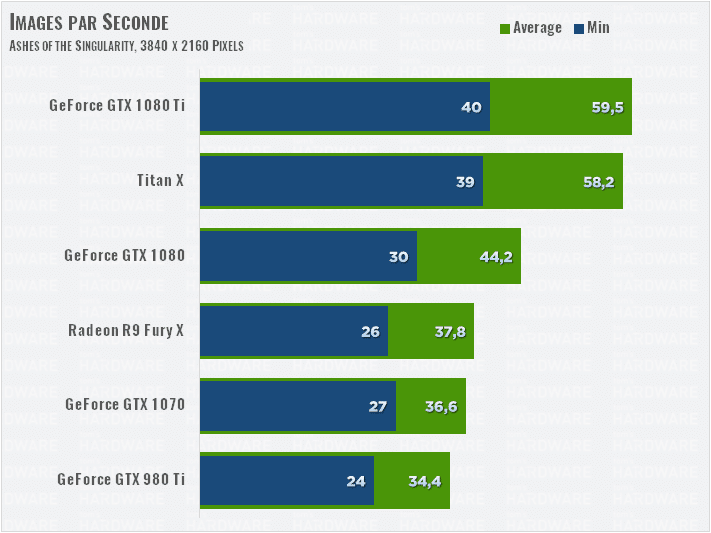

En UHD, le classement est identique, la 1080 Ti parvenant se maintenir au-dessus des 40 images par seconde, avec une moyenne à 60 images par seconde.

La Radeon R9 Fury X se place au milieu de notre peloton de test. Mais même une GTX 1080 ne permet pas vraiment de jouer à ce niveau de détails et cette résolution.

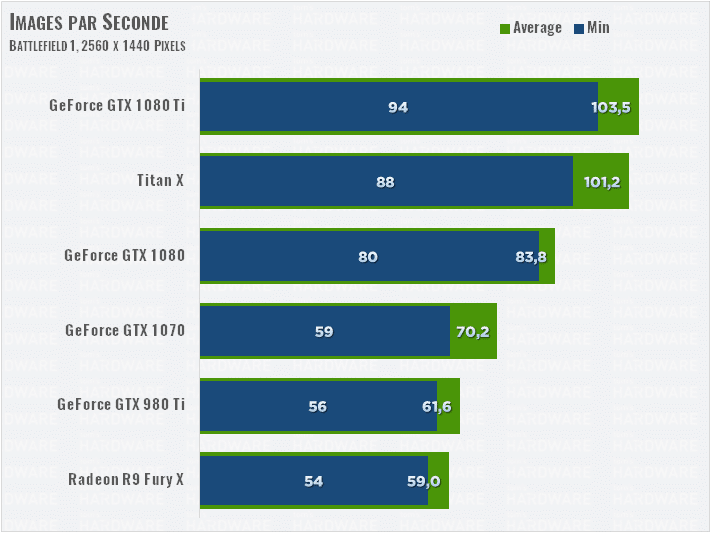

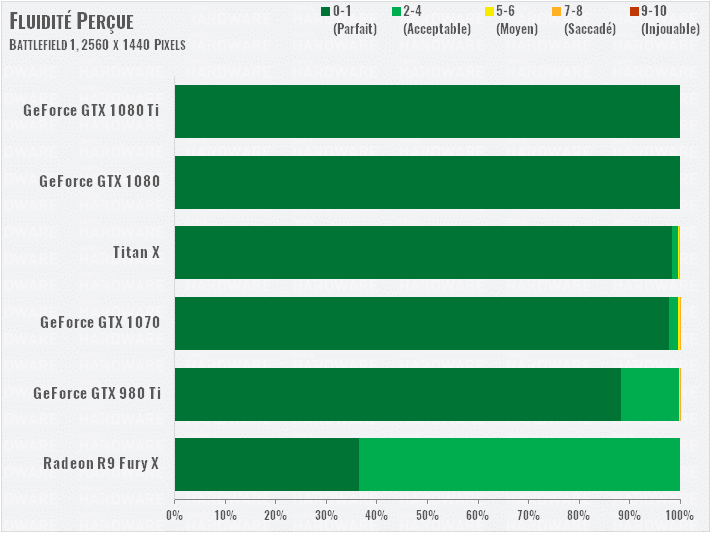

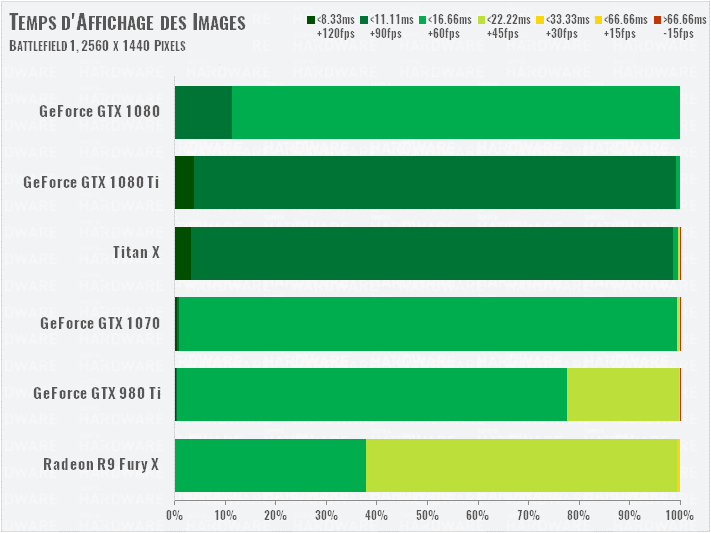

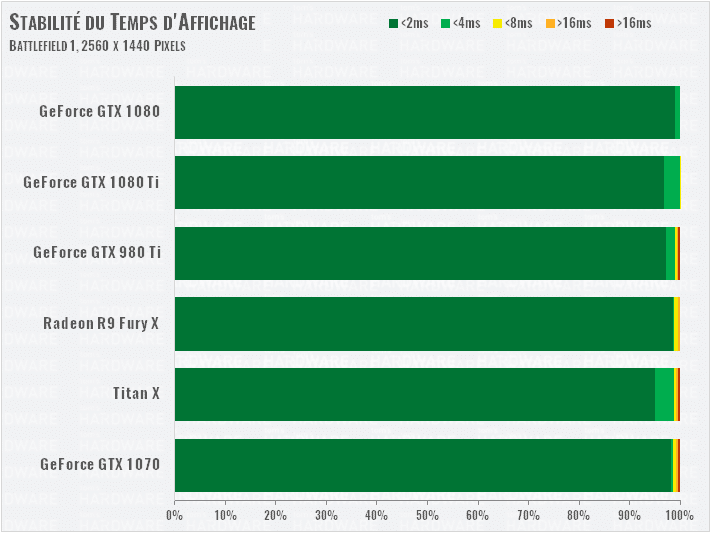

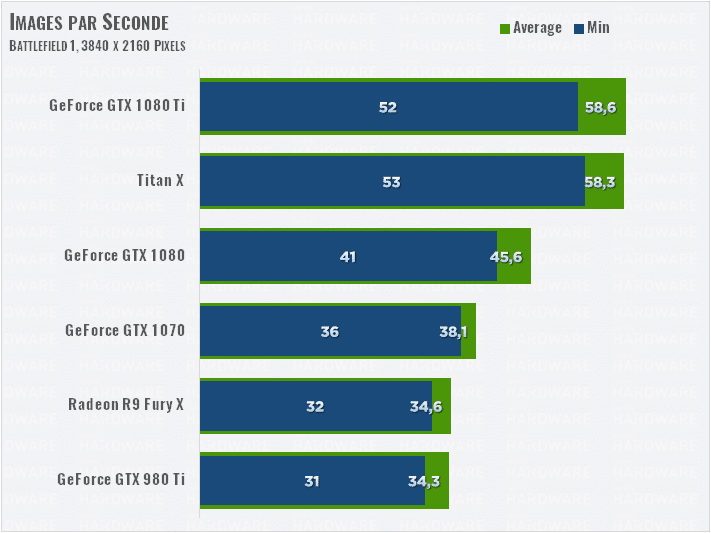

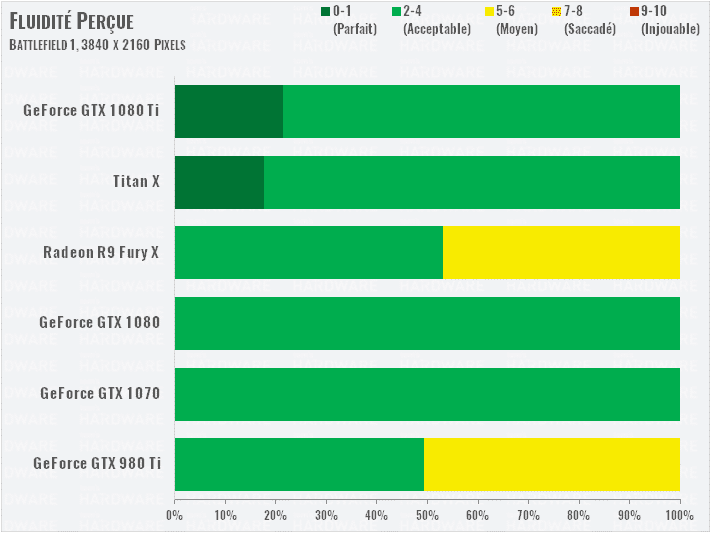

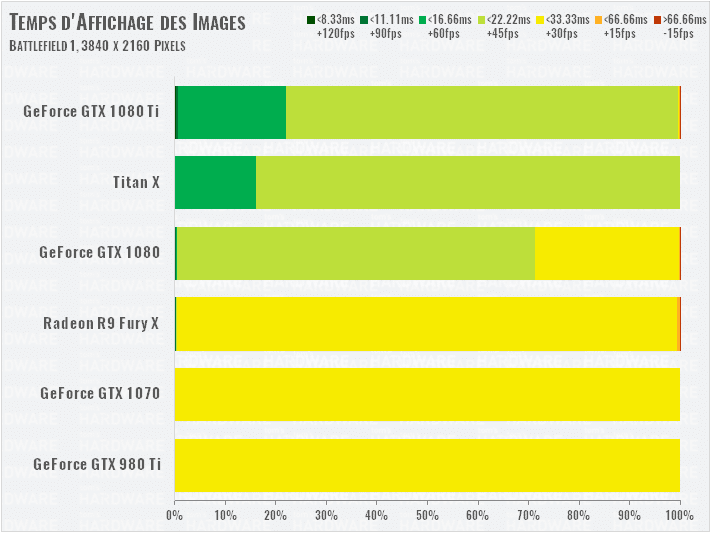

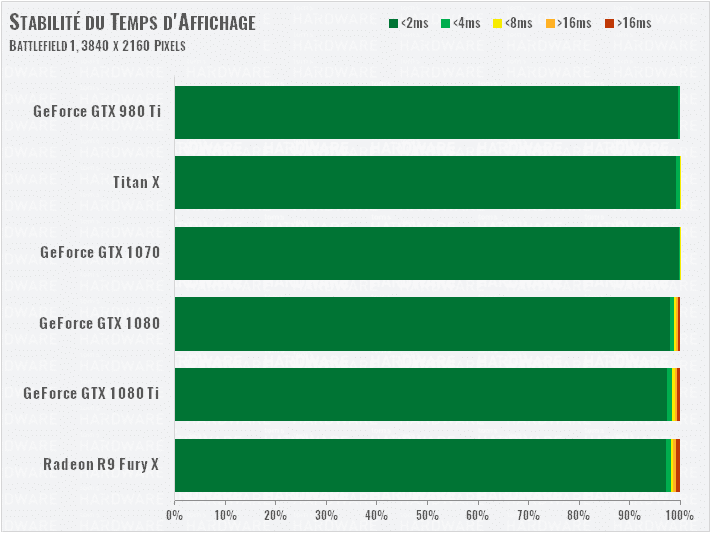

Battlefield 1 (DX12)

Notre séquence de test est extraite du chapitre Avanti Savoia!. Nous courons pendant 80 s au début de O La Vittoria. Le jeu est réglé en DirectX 12 en qualité Ultra.

La GTX 1080 Ti montre un gain de 24 % par rapport à la 1080 normale, et dépasse les 100 i/s de moyenne. C’est aussi 68 % de mieux que sa prédécesseuse, la GTX 980 Ti. AMD est largué, la R9 Fury X attend désespérément d’être relevée par la RX Vega.

Les choses deviennent plus intéressantes en 4K. La GeForce GTX 1080 Ti accroît son avance sur la GTX 1080 à 29 %. En chiffres bruts, la 1080 Ti parvient à délivrer 50 i/s en moyenne alors que la GTX 1080 flirte avec les 40 i/s/. La GTX 1080 Ti reste aussi légèrement devant la Titan X Pascal.

Notre indice de fluidité montre que les GTX 1080 Ti et Titan X Pascal maintiennent un jeu fluide alors que les GeForce GTX 980 Ti et Radeon R9 Fury X passent la moitié du test dans la zone « moyenne ».

Performances : Doom et Civilization VI

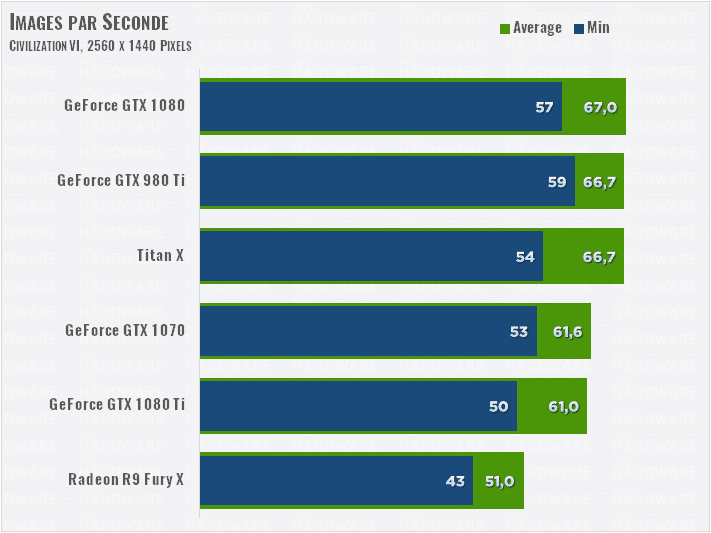

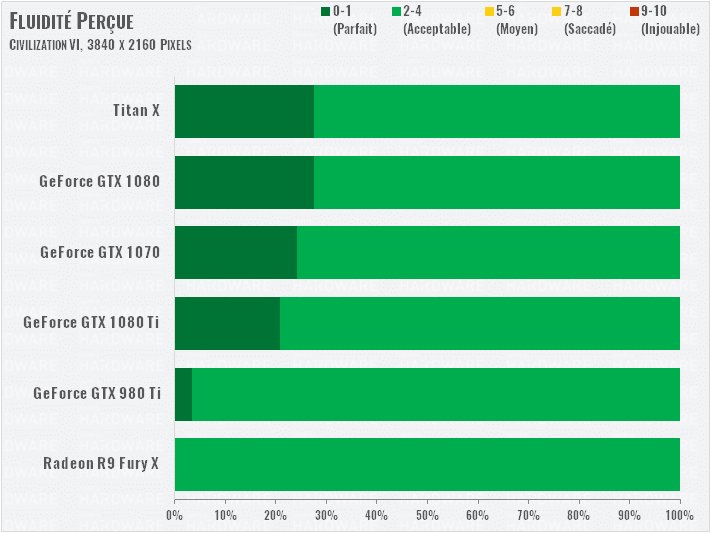

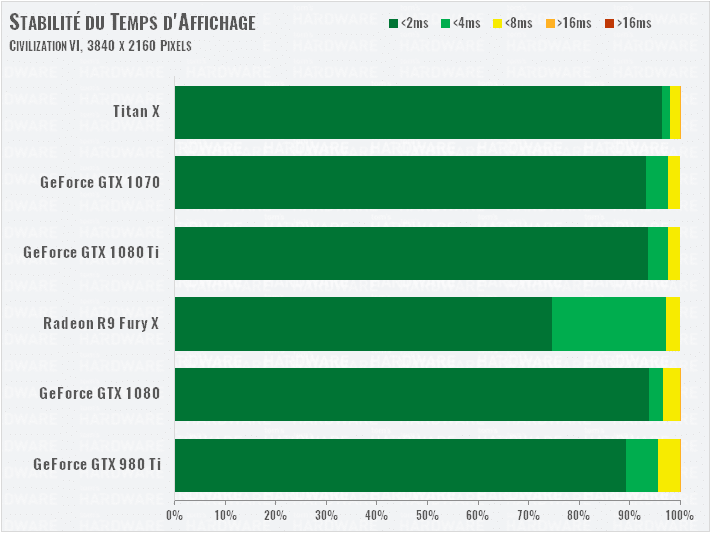

Civilization VI (DirectX 12)

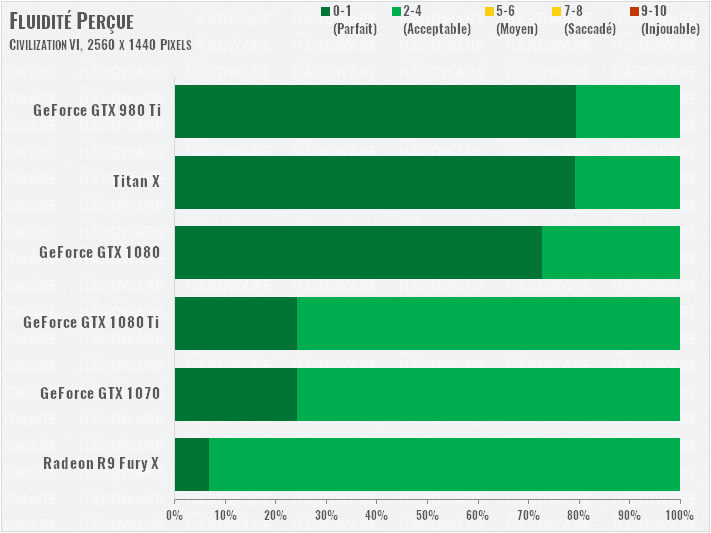

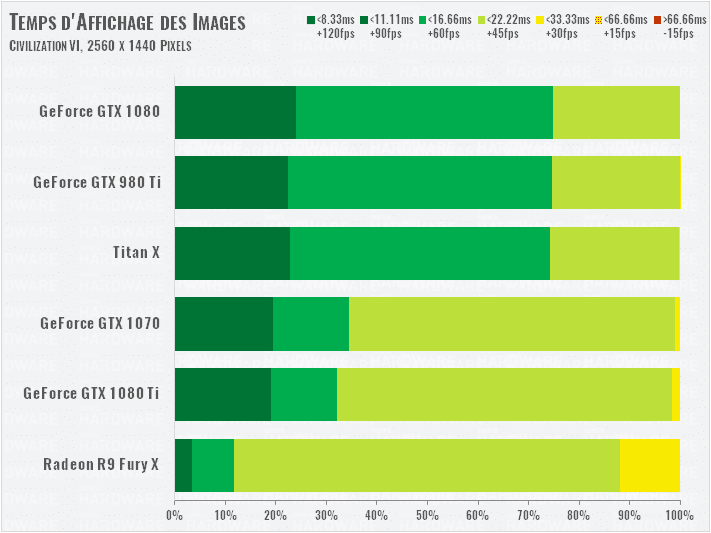

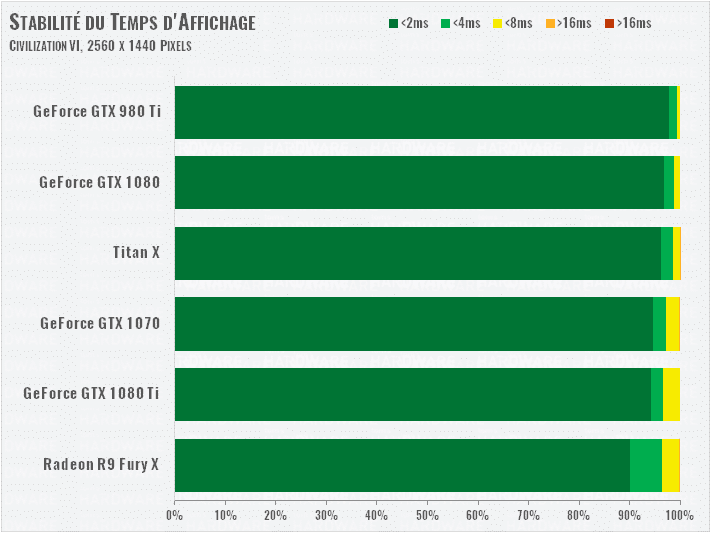

Soyons honnêtes, Civilization VI n’est pas un excellent benchmark pour cartes graphiques. Il est largement limité par les performances CPU, mais sur notre Core i7 7700K. Mais nous le conservons, car c’est un jeu populaire. Alors nous poussons tous les réglages « Avancés » au maximum et nous activons le MSAA 8x pour augmenter la charge sur le GPU autant que possible.

Malgré nos précautions, en 2560×1440, toutes les cartes finissent dans un mouchoir de poche… et la GTX 1080 Ti en bas du tableau !

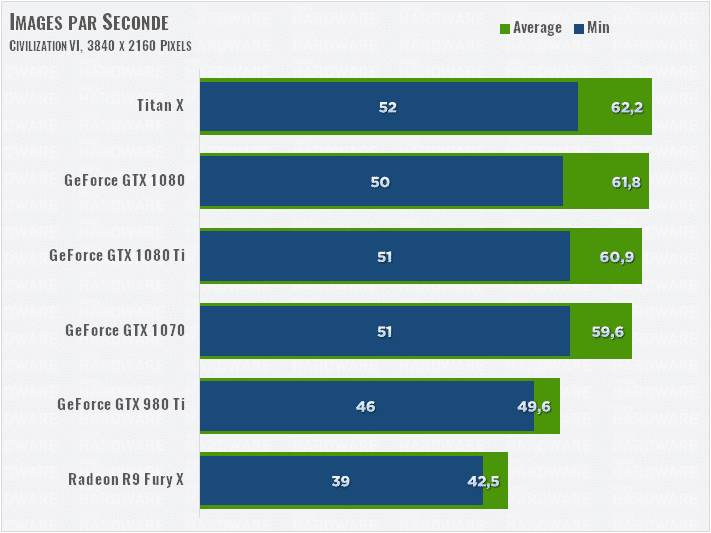

Pousser la résolution en Ultra HD permet au GP102 d’exprimer un peu mieux son potentiel, mais le fait que quatre cartes terminent groupées à 60 i/s montre bien que la puissance CPU reste le facteur limitant (oui nous avions pensé à désactiver la V-Sync et le limiteur interne du jeu).

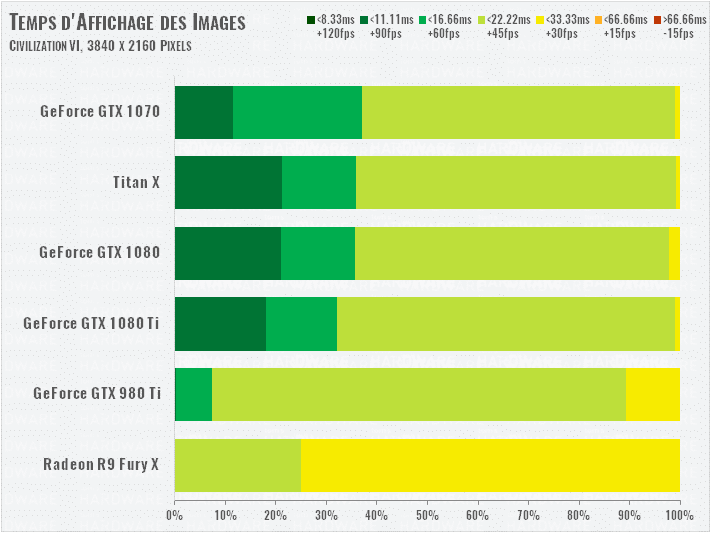

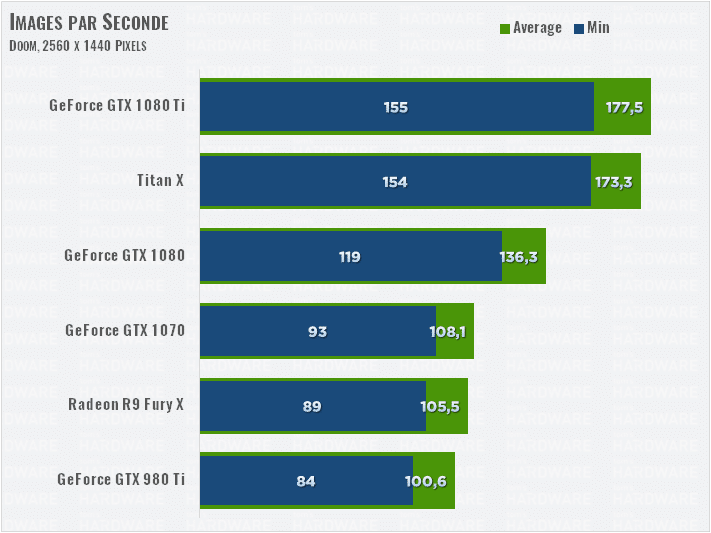

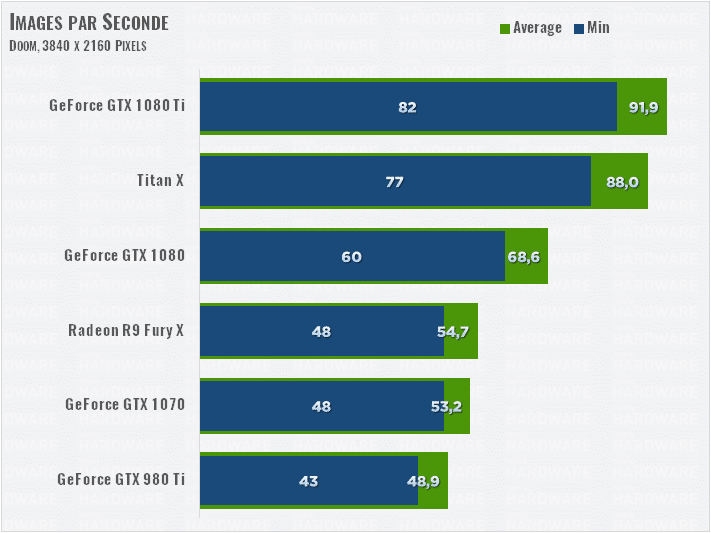

Doom (Vulkan)

Puisque nous utilisons la même séquence de test et les mêmes réglages graphiques, nous pouvons comparer les résultats d’aujourd’hui avec ceux du test de la GeForce Titan X Pascal à son lancement. Pourquoi ? Parce que Nvidia a récemment insisté sur le fait qu’il avait amélioré les performances des GeForce dans les jeux DirectX 12 et Vulkan.

L’écart entre la « vieille » GeForce GTX 1080 et la GTX 1080 Ti se monte à 30 %. Face à la GTX 980 Ti, la nouvelle venue est 76 % plus rapide. La 1080 Ti coiffe même la Titan X Pascal au poteau.

Les gains promis par Nvidia sont bel et bien là. Le score de la Titan X Pascal est supérieur de 12 % à celui qu’elle obtenait lors de son lancement. Toutefois , entre temps nous avons aussi mis à jour notre plateforme de test avec un Core i7 7700K au lieu d’un Core i7 6700K, alors vérifions en passant en Ultra HD.

En 4K, la Titan X Pascal gagne encore plus : elle est maintenant 14 % plus performante qu’en août 2016.

La GeForce GTX 1080 Ti est encore une fois la plus rapide : 34 % plus rapide que la GTX 1080 et 88 % plus rapide que la vieille GTX 980 Ti. Et 68 % plus rapide que la meilleure Radeon. Ceci dit, toutes les cartes sont suffisamment rapides pour jouer à Doom en 4K.

Performances : GTA V et Hitman

GTA V (DX11)

Notre test sous GTA V est réglé pour être encore plus demandeur, par l’utilisation d’antialiasing 4xMSAA, même pour les reflets. Toutes les autres options graphiques sont poussées au maximum.

Cette fois, la Titan X s’en sort mieux que les autres, de peu. La 1080 Ti est 26 % plus rapide que la 1080, et 65 % plus puissante que la 980 Ti. Les Radeon sont particulièrement à l’aise en DirectX 12, mais ce jeu DirectX 11 montre plutôt l’avantage de NVIDIA avec cet API : la 1080 Ti est 89 % plus rapide que la Radeon R9 Fury X !

En 4K, les écarts se creusent avec la Radeon, et la nouvelle GeForce 1080 Ti dépasse la Titan X.

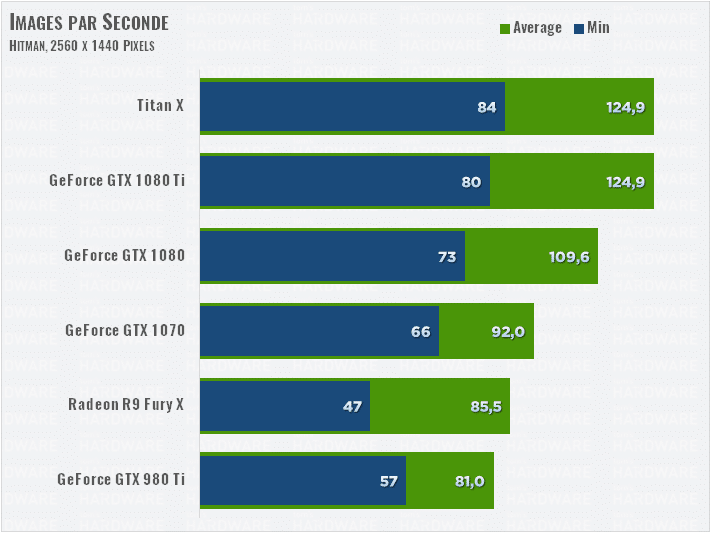

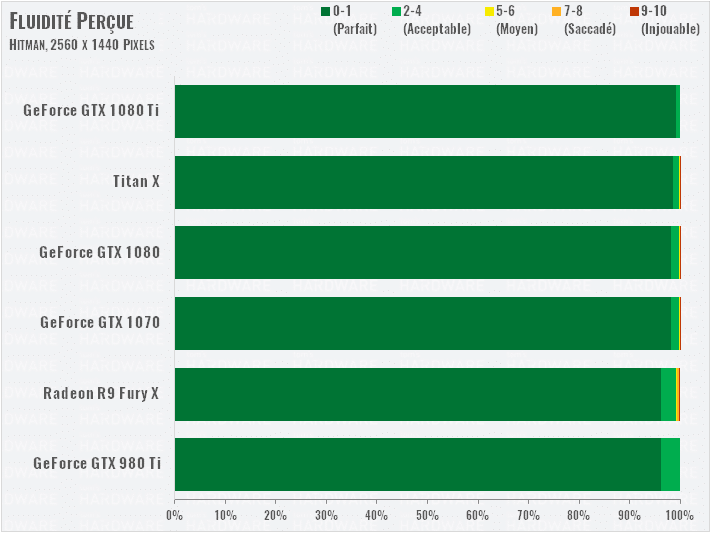

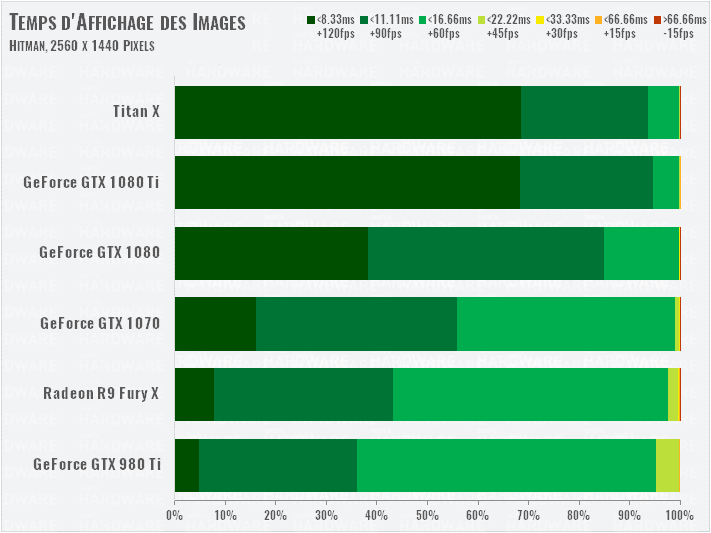

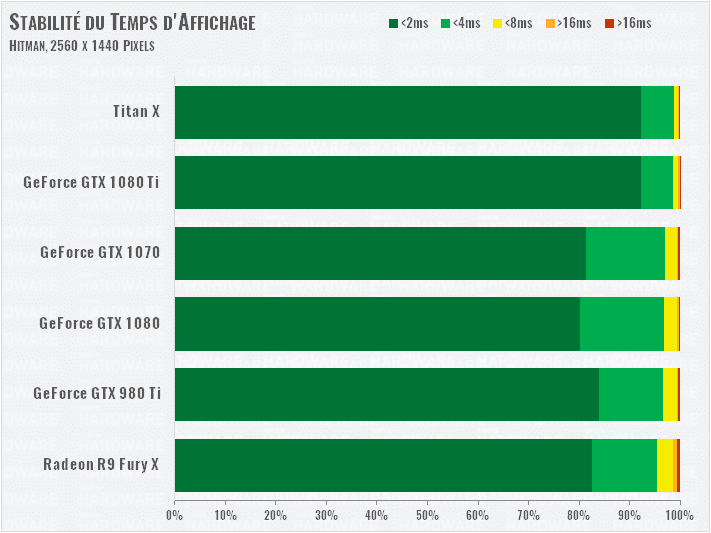

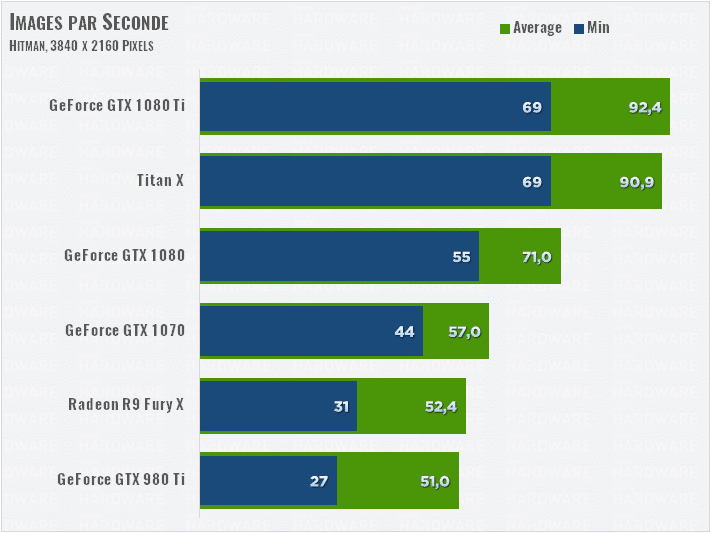

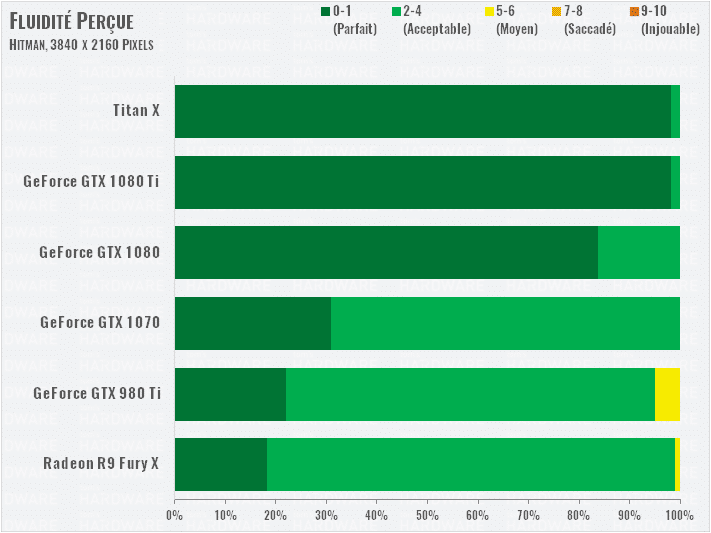

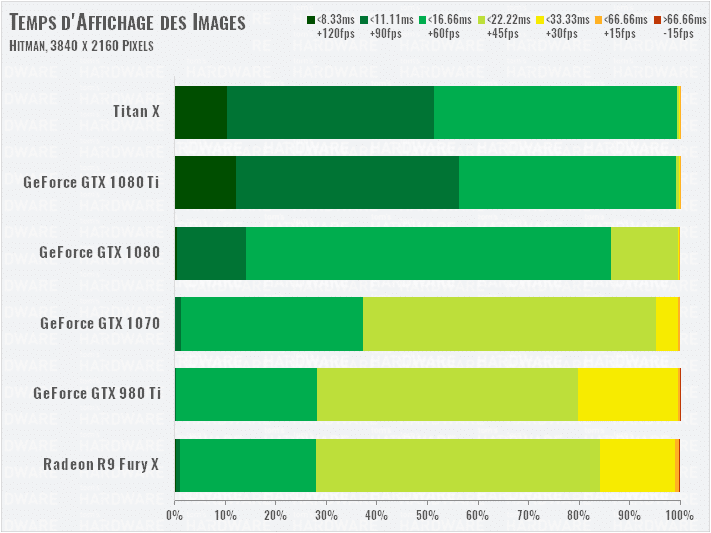

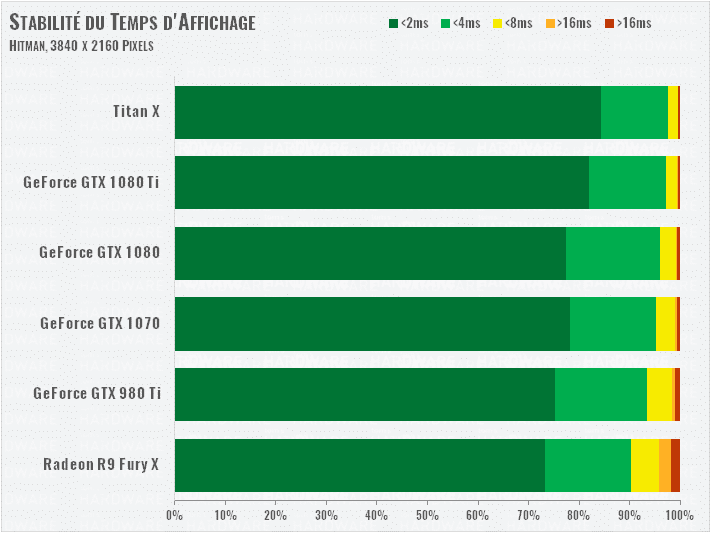

Hitman (DX12)

La GeForce GTX 1080 Ti fait jeu égal avec la Titan X dans Hitman, et n’est que 14 % plus rapide en moyenne que la 1080.

L’indice de fluidité est très élevé pour nos six concurrentes, même au niveau de détails Ultra. Passons donc en 4K pour augmenter la charge sur les GPU.

Lorsque le test devient plus exigeant, la GTX 1080 Ti se détache de la Titan X grâce à sa fréquence plus élevée. Dans le même temps, l’écart par rapport à la GTX 1080 grandit, à 30 %. Et la 1080 Ti enterre la GTX 980 Ti, se montrant 81 % plus puissante. Un résultat remarquable, particulièrement en 4K.

Toutes les cartes testées aujourd’hui ici assurent une expérience de jeu fluide, à peu de choses près.

Performances : Metro: Last Light et Rise of the Tomb Raider

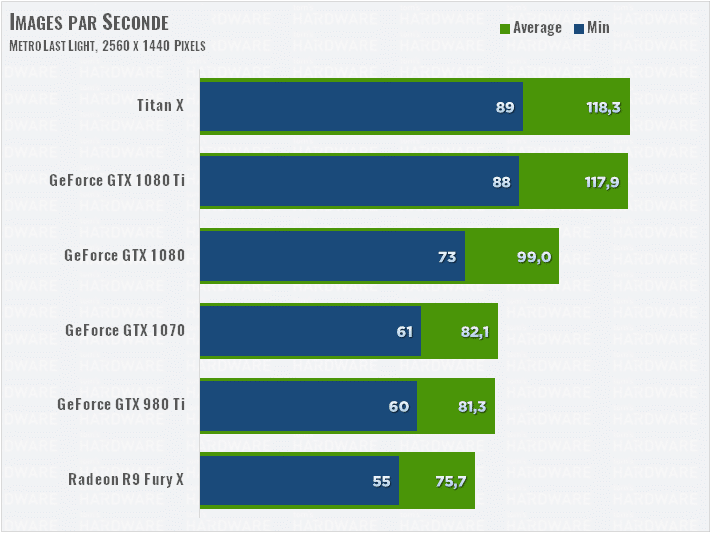

Metro: Last Light (DX11)

Malgré son âge, ce jeu reste utilisé dans notre suite de benchmark parce qu’il est capable de charger les cartes graphiques les plus rapides. C’est d’ailleurs aussi le jeu qui nous permet de relever les consommations GPU maximales en jeu, et pour cause ! Nous utilisons le mode graphique Very High avec un filtrage anisotrope 16x, du Motion Blur en Normal et Tessellation en Normal.

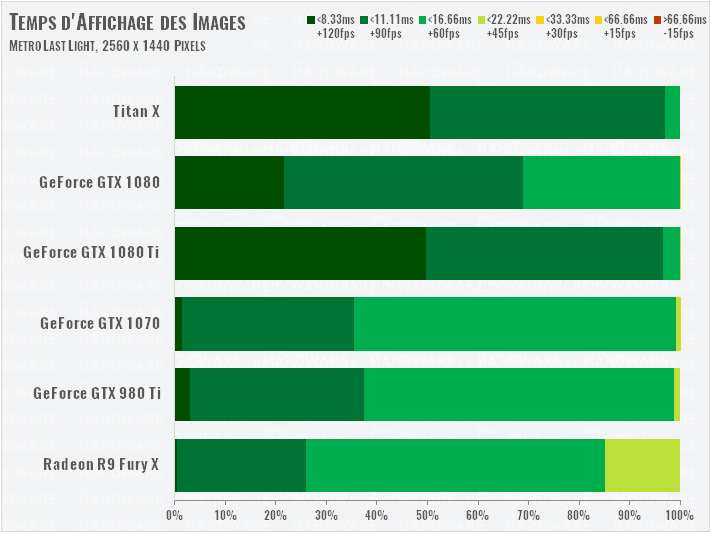

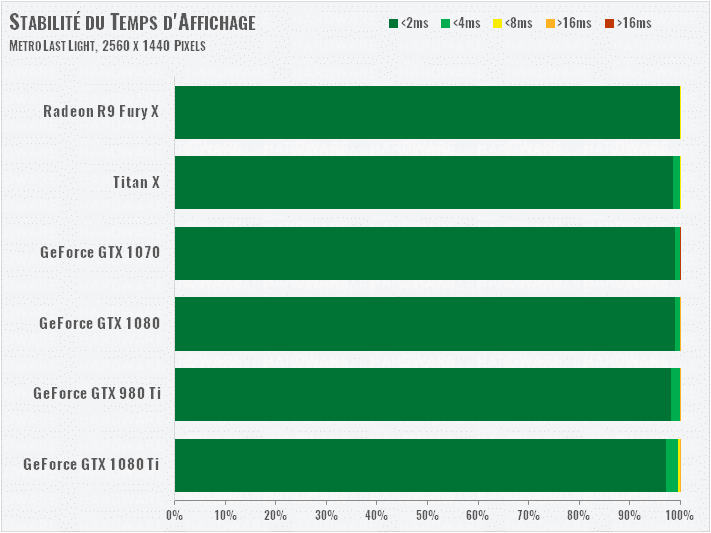

Toutes ces cartes haut de gamme se débrouillent bien sous Metro en définition QHD. Les deux Titan X et 1080 Ti affichent des performances presque identiques.

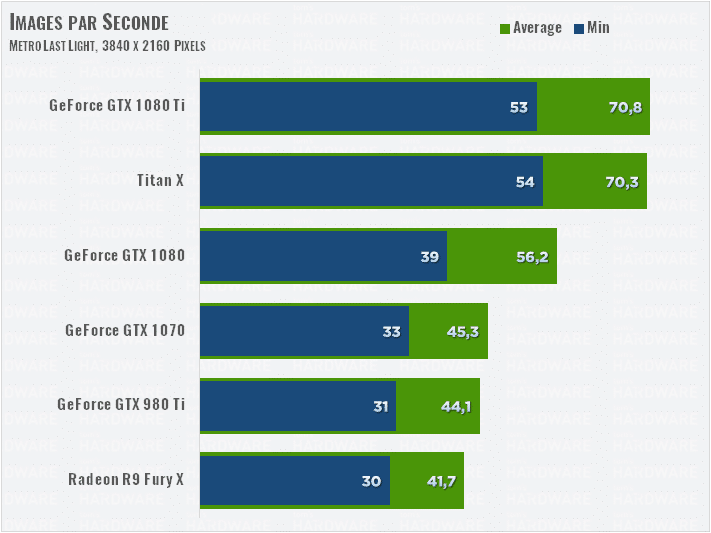

En 4K, les résultats sont un peu plus intéressants : seules les cartes de dernières générations s’en sortent correctement. La 1080 Ti reprend la tête face à la Titan X dans cette très haute définition.

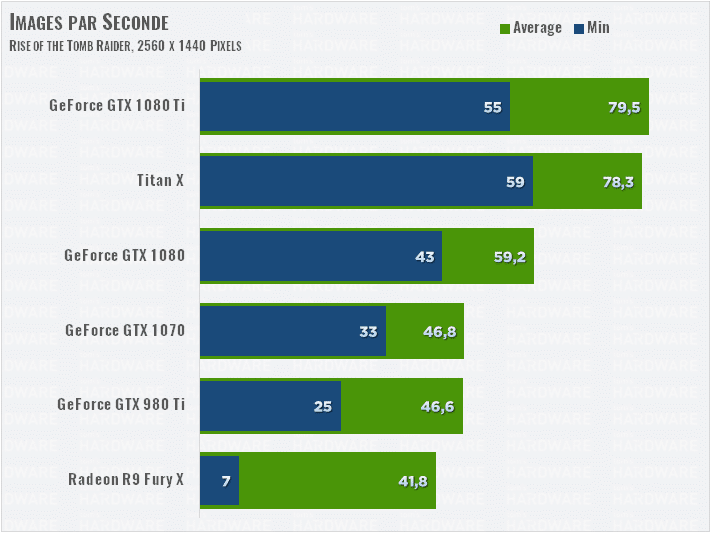

Rise of the Tomb Raider (DX12)

Nous avons poussé encore les options graphiques de ce jeu pour qu’il soit encore plus demandeur pour le GPU : activation du SSAA 2x au lieu du SMAA.

Ce paramètre impacte durement les performances : la Titan X passe de 110 ips avec SMAA lors de son premier test, à 80 ips avec SSAA 2x. La 1080 Ti assure un niveau de performance similaire, 34 % supérieur à celui de la 1080.

Même dans ce titre DirectX 12, la Radeon rencontre des difficultés à suivre, avec de gros pics de ralentissement, réduisant fortement la fluidité perçue durant le jeu.

Même les GeForce les plus rapides souffrent du super-sampling en 4K. Notre indice de fluidité réelle montre que c’est encore jouable avec une Titan X et une 1080 Ti, mais les autres cartes saccadent. Quoi qu’il en soit, avec la densité de pixels d’un écran 4K (même en 30 pouces), il est possible de réduire l’antialiasing pour que tout soit jouable !

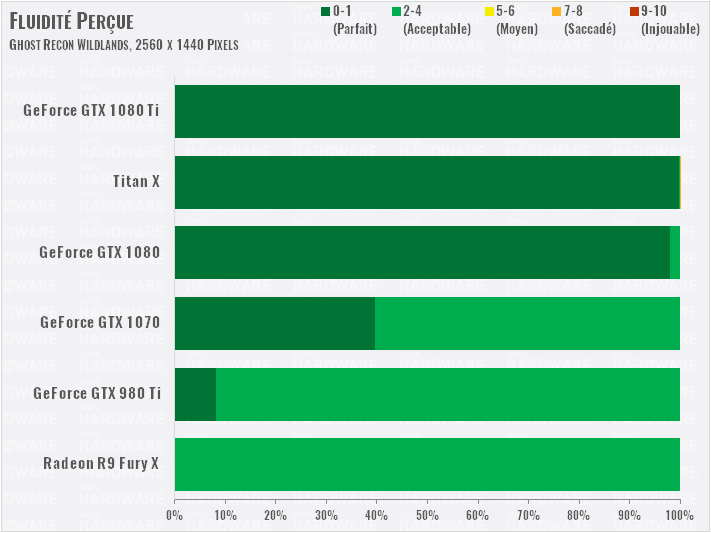

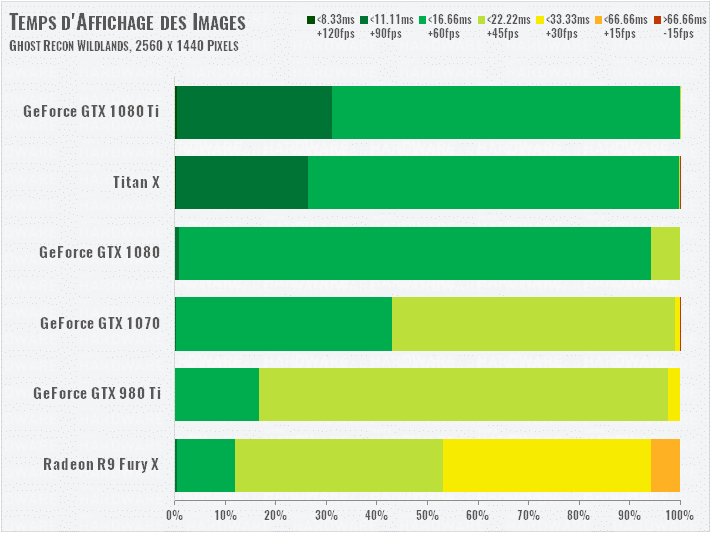

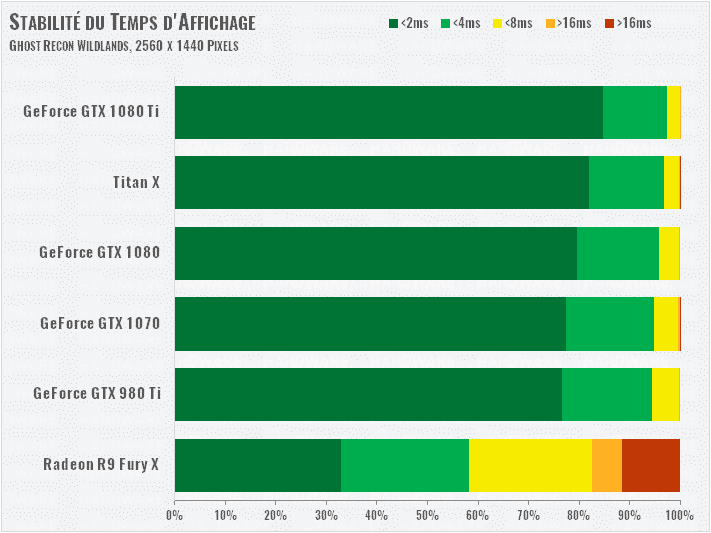

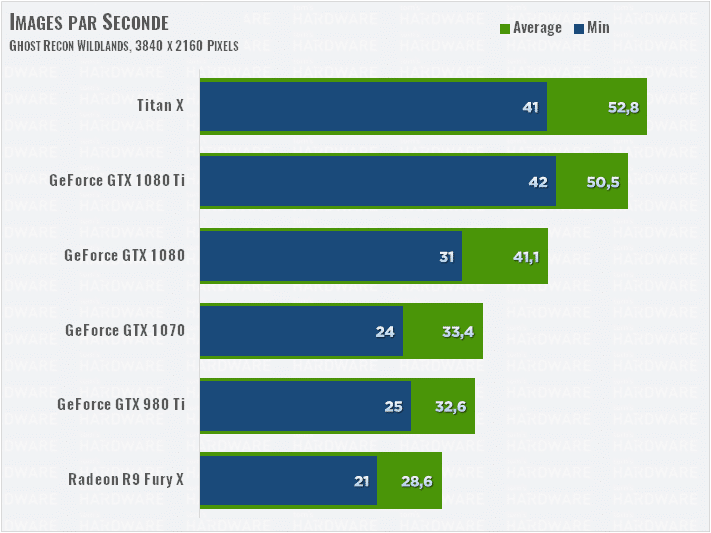

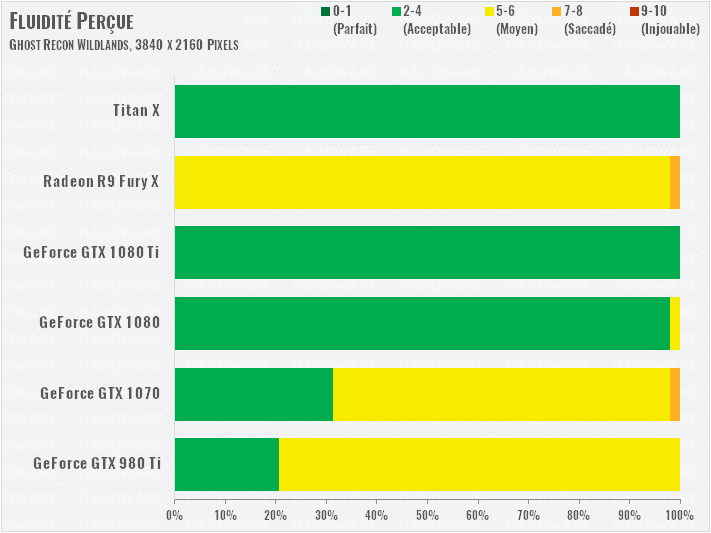

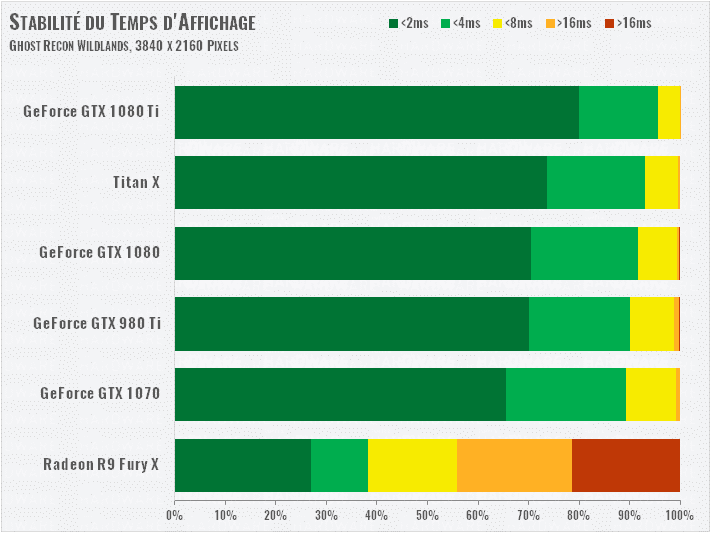

Performances : Ghost Recon Wildlands

Nous avons reçu notre clé de test de Ghost Recon Wildlands juste à la fin des tests de notre GTX 1080 Ti. Nous avons finalement décidé de prolonger la torture pour ajouter ce jeu, qui intègre de nombreuses technologies NVIDIA.

En mode Ultra, le maximum, le jeu impacte fortement les performances du GPU, alors que ses graphismes ne sont pourtant pas révolutionnaires. Nous l’avons donc réduit en mode Very High, qui permet notamment de désactiver la technologie Turf Effect de NVIDIA. Nous voulions, dans un souci d’équité, quantifier tout d’abord l’impact de cette techno sur les GPU AMD.

Le jeu utilise le même moteur AnvilNext 2.0 engine que The Division. Ce dernier a été patché pour DirectX 12, mais Ghost Recon reste en DirectX 11 pour son lancement. Pas vraiment d’étonnement quant à la supériorité des cartes NVIDIA sur ce jeu, compte tenu de ses optimisations. Il faudra donc plutôt les comparer entre elles : la 1080 Ti est un peu plus rapide que la TItan X, 23 % plus puissante que la 1080, et 56 % plus que la 980 Ti.

En UHD/4K même la plus rapide des cartes souffre énormément. La Titan X prend la tête du classement, alors que la 1080 Ti est seulement 18 % plus rapide que la 1080. Notre indice de fluidité montre qu’aucune carte ne parvient à offrir un bon niveau de jouabilité en 4K dans ce jeu. Il est possible qu’un patch optimise, le jeu, sinon, il faudra acheter une seconde 1080 Ti (et pourquoi pas !).

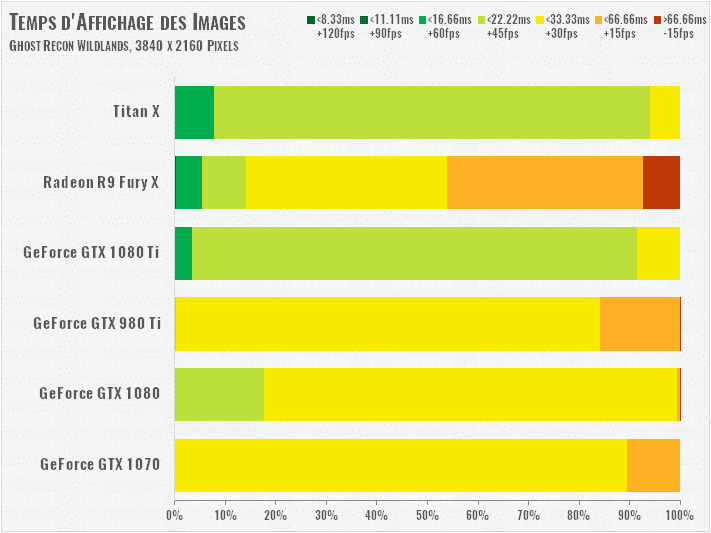

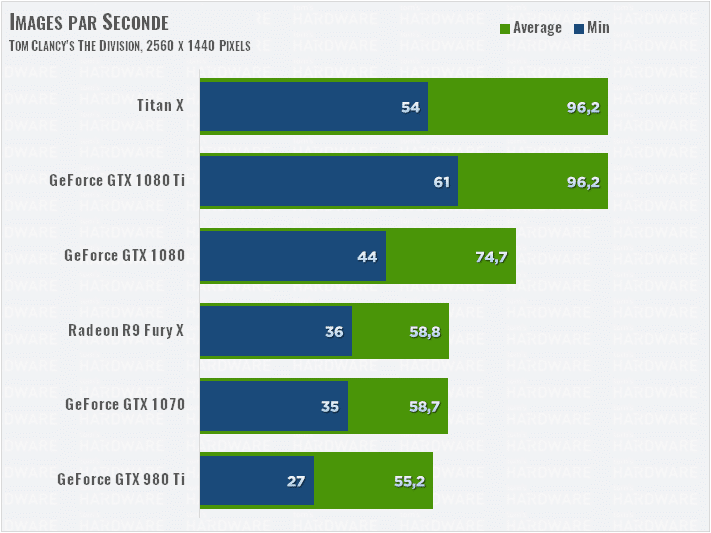

Performances : The Division et The Witcher 3

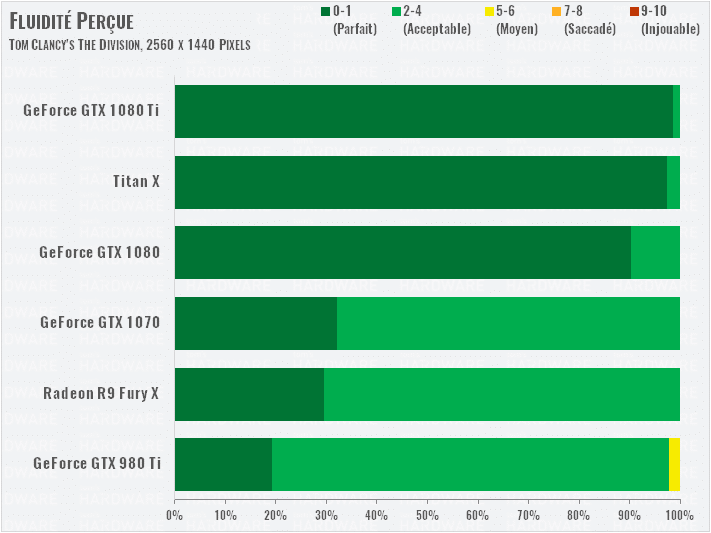

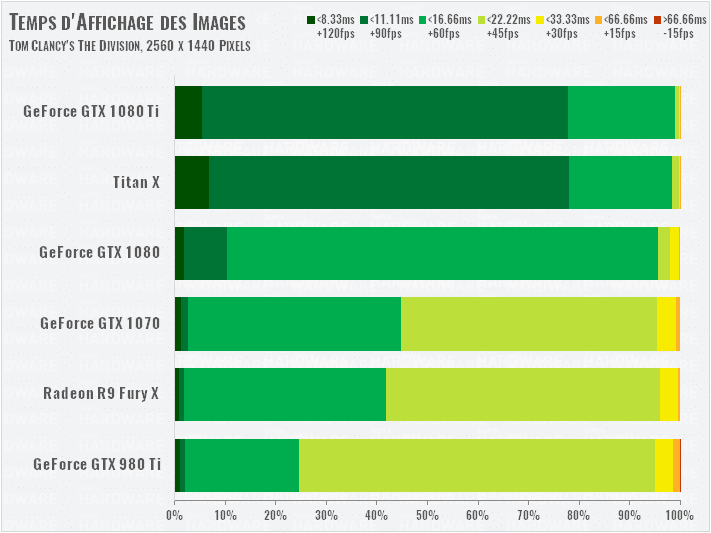

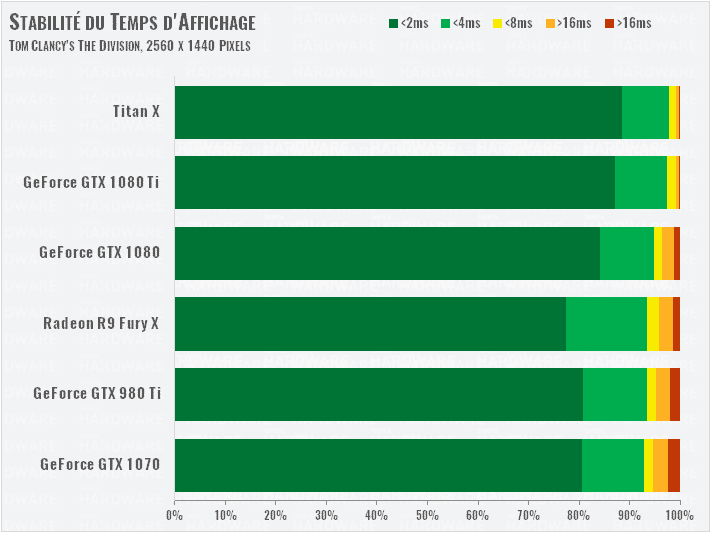

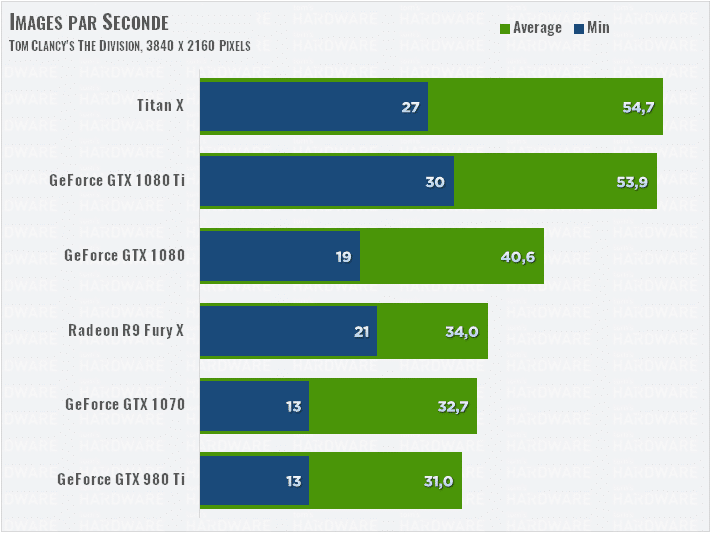

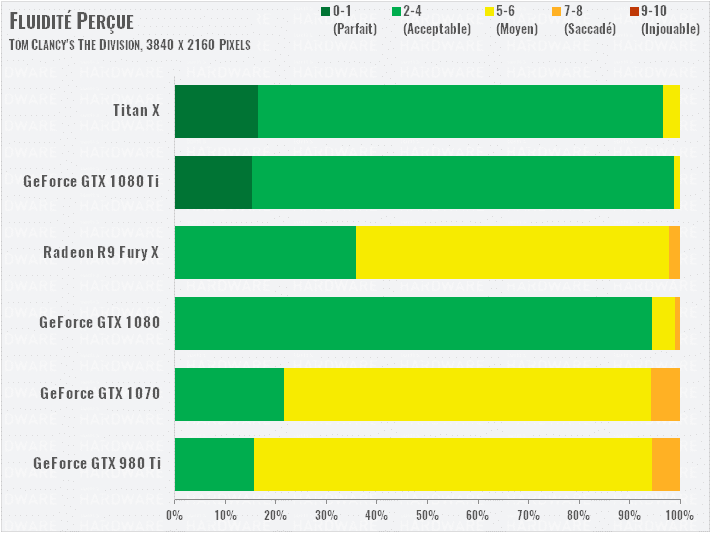

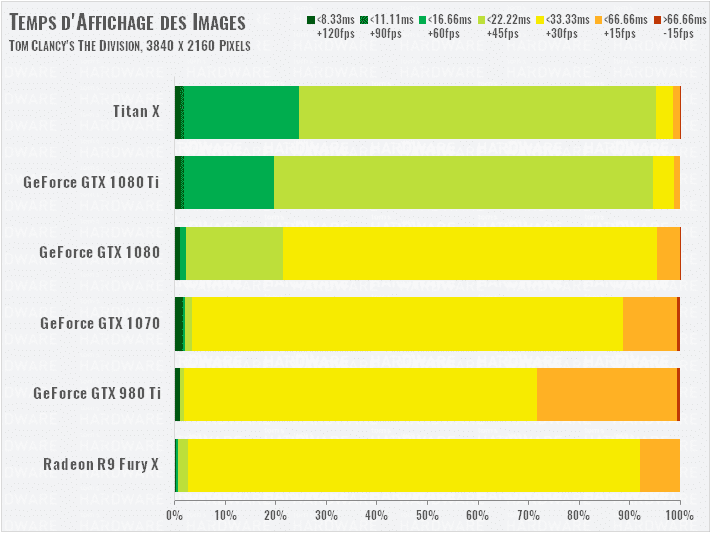

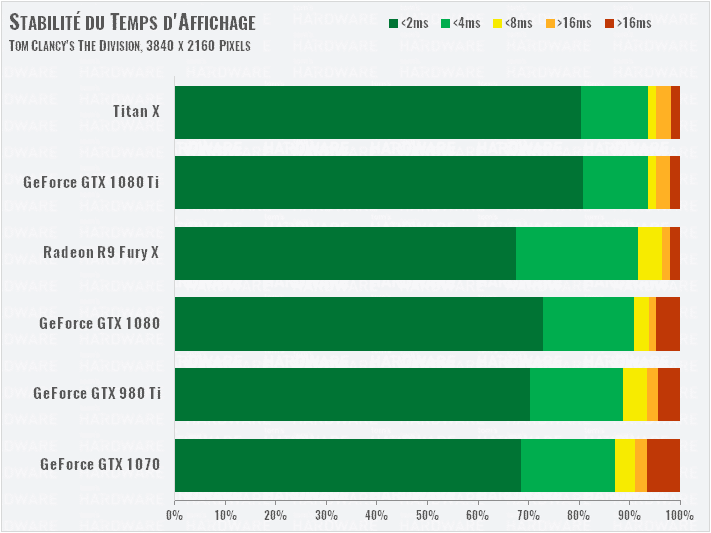

Tom’s Clancy’s The Division (DX12)

Nous utilisons encore le mode de qualité Ultra dans ce jeu, mais nous passons cette fois en DirectX 12.

Par rapport au précédent test de la TITAN X, cette carte gagne 10 % de performances, notamment grâce à l’apport du processeur 7700K. La Radeon monte aussi ses performances d’un peu plus de 10 %.

La 1080 Ti affiche un taux minimal d’images par seconde plus important que la Titan X. Seule la GTX 980 Ti affiche des pics de temps d’affichage qui se ressentent dans notre graphique de fluidité réelle.

Le gain de performances de la TITAN X se réduit à 7 % par rapport à notre précédent test, contre 3 % pour la Radeon. La Titan X offre un jeu jouable en 4K, mais pas la Radeon. La 1080 Ti se retrouve juste en dessous de la TITAN X, mais elle est 33 % plus rapide que la 1080.

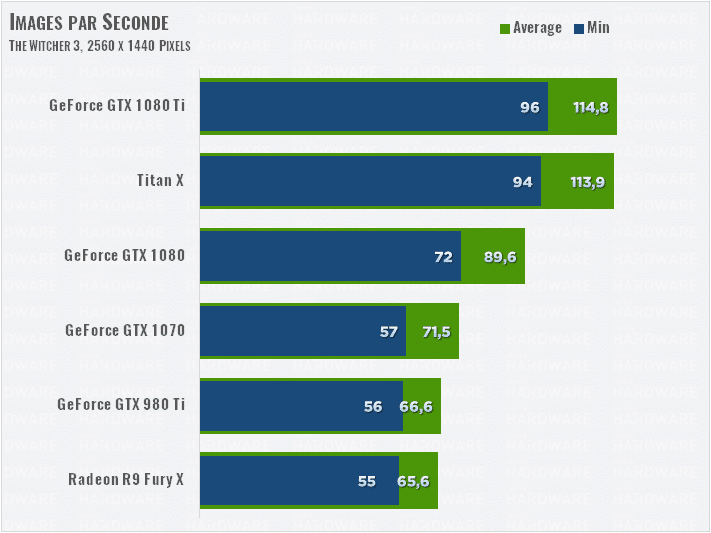

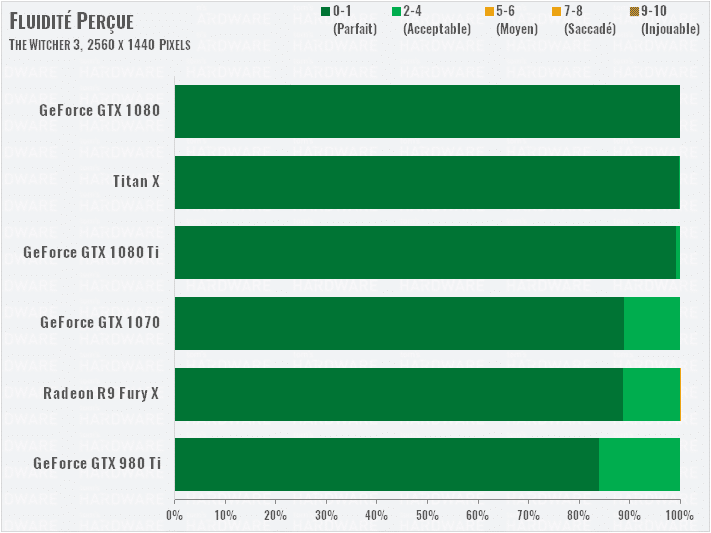

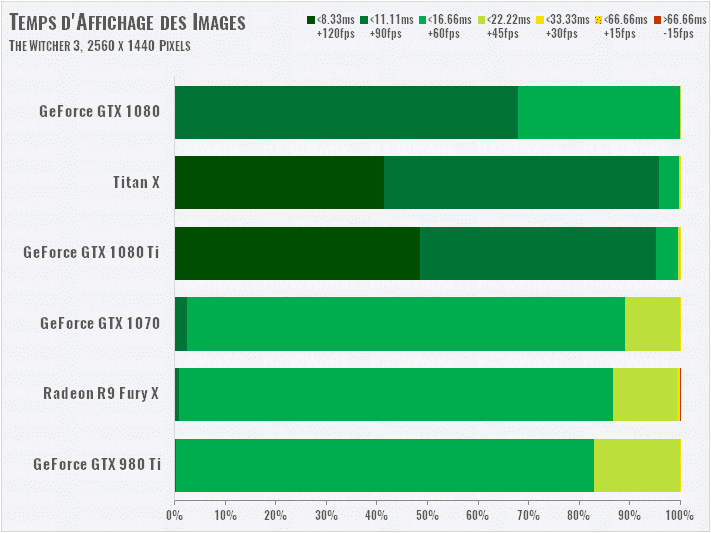

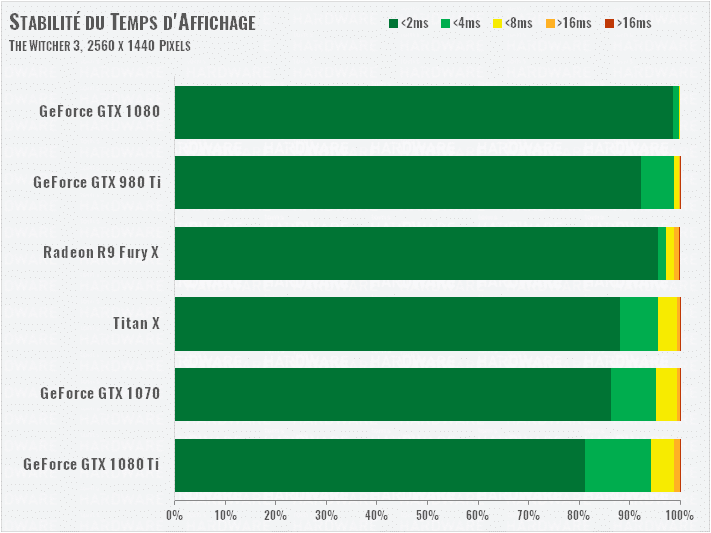

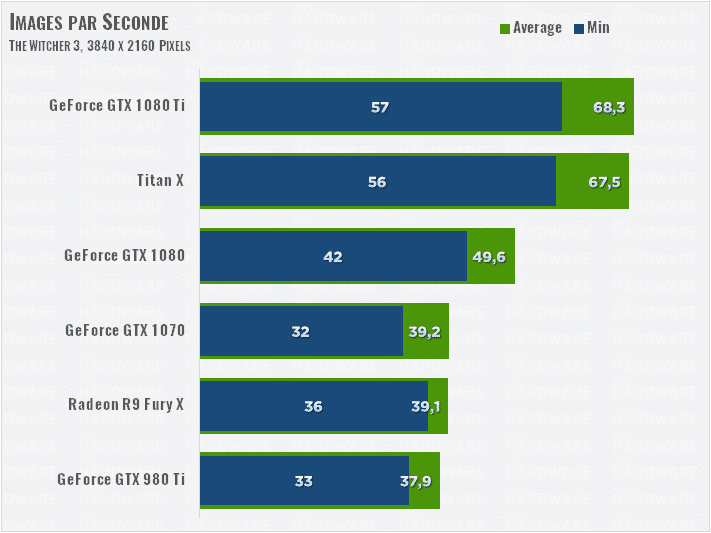

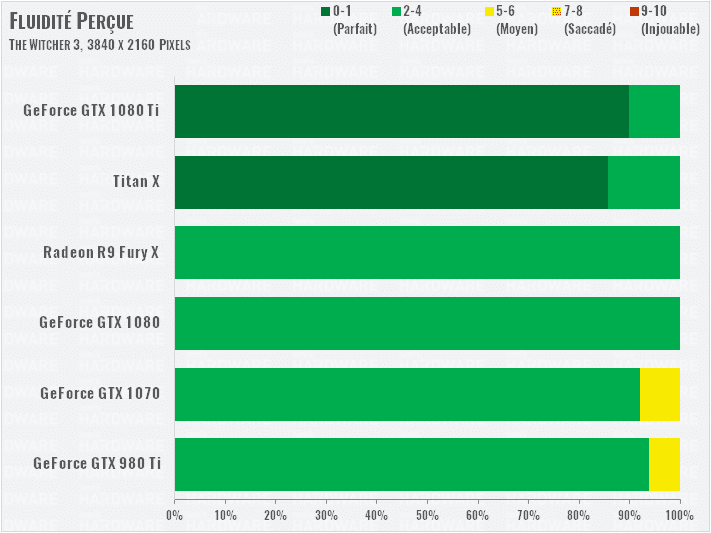

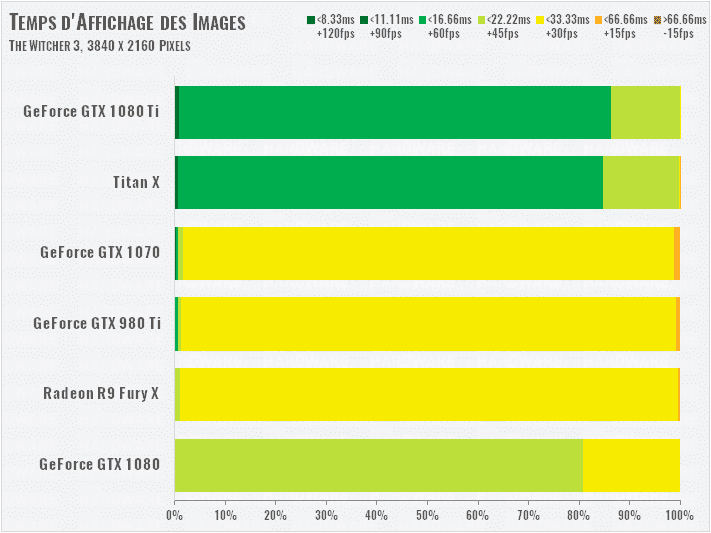

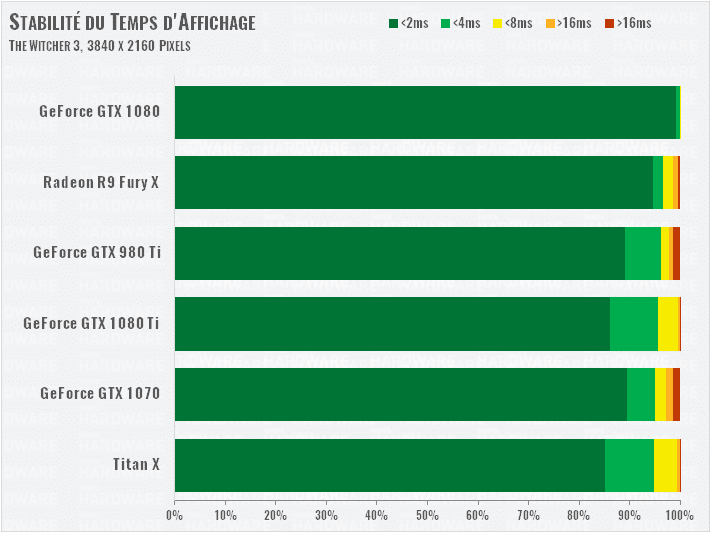

The Witcher 3 (DX11)

Malgré de nouveaux pilotes, les résultats de nos tests dans ce jeu sont identiques à ceux de nos précédents tests d’août 2016. Toutes les cartes apportent un bon niveau de fluidité dans ce jeu en QHD. La 1080 Ti est 28 % plus rapide que la 1080.

La 1080 Ti est cette fois 38 % plus rapide que la 1080 en 4K ! Autrefois, il fallait une carte à 1300 euros pour obtenir une bonne fluidité en 4K dans ce jeu, aujourd’hui cela ne vous coûtera que 800 euros, une broutille !

Les cartes plus lentes s’en sortent aussi, mais il faudra penser à réduire la qualité graphique pour obtenir une bonne fluidité réelle.

Fréquences et consommation

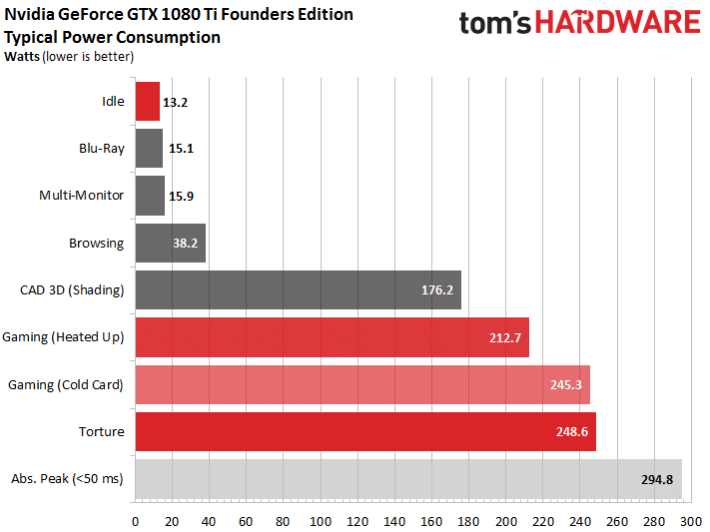

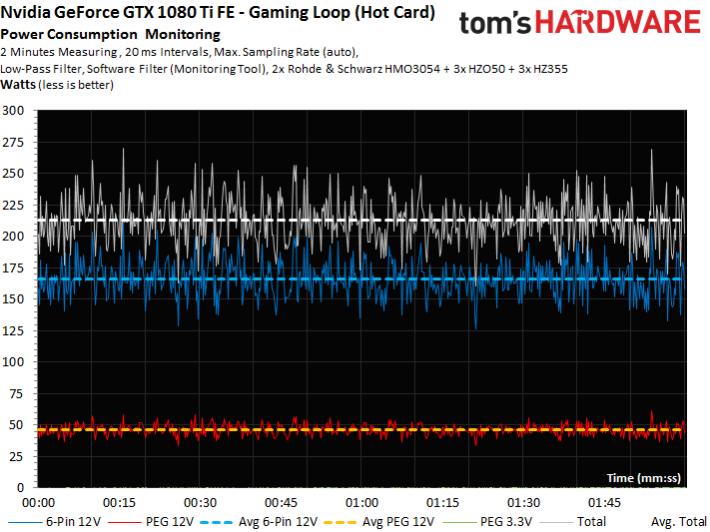

Consommation

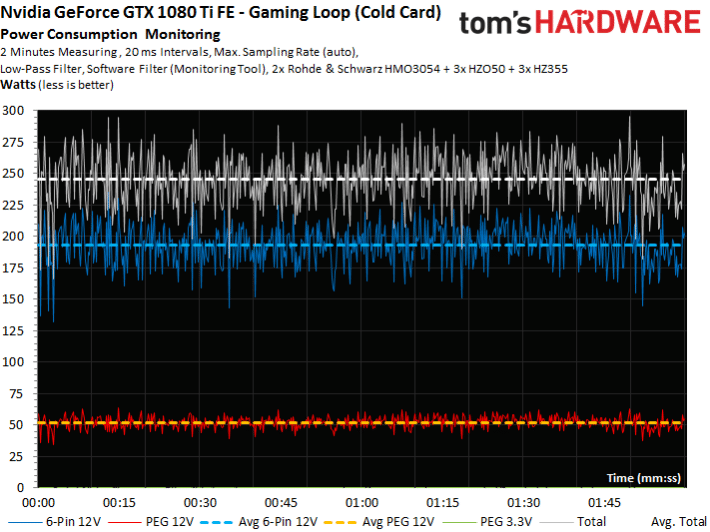

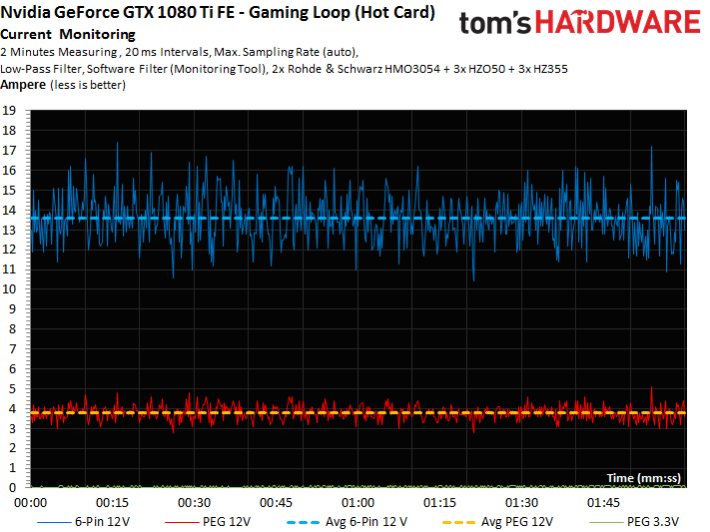

La consommation au repos s’élève à environ 13 W, en ligne avec ce qu’on pouvait attendre. Ce qui nous a par contre surpris, c’est l’écart de consommation quand la carte est chaude : la carte chaude consomme environ 30 W de moins ! Cela signifie que le système Boost est avant tout limité par la température et doit réduire la consommation pour éviter la surchauffe.

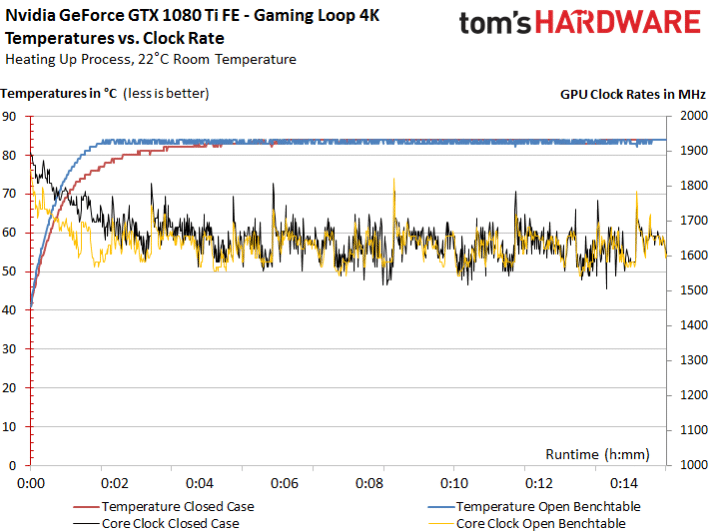

Pour étayer nos affirmations, nous avons enregistré l’évolution de la fréquence et de la température GPU dans la phase d’échauffement de la carte. Voilà ce que cela donne :

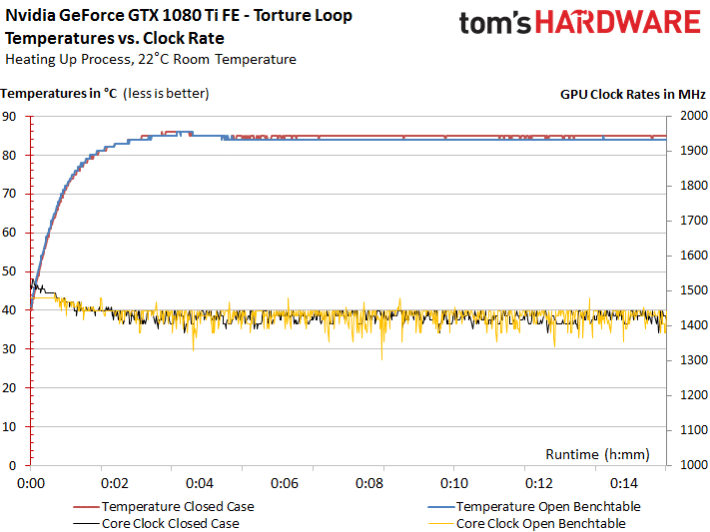

On observe la même baisse de fréquence en stress-test, même si moins prononcée en raison d’une charge supérieure :

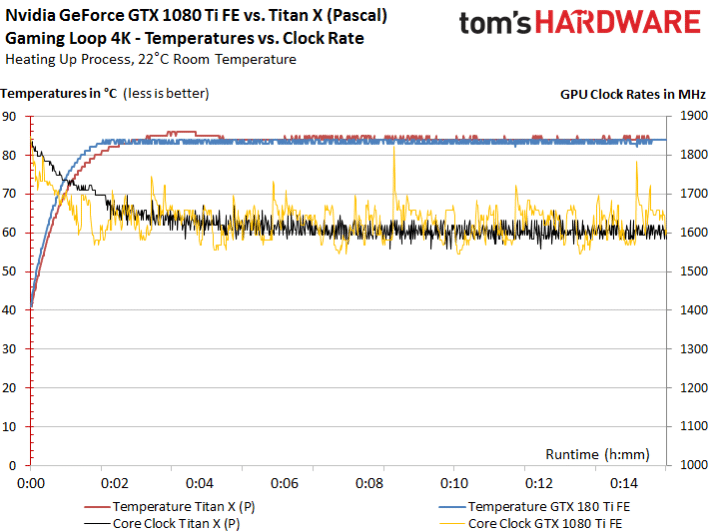

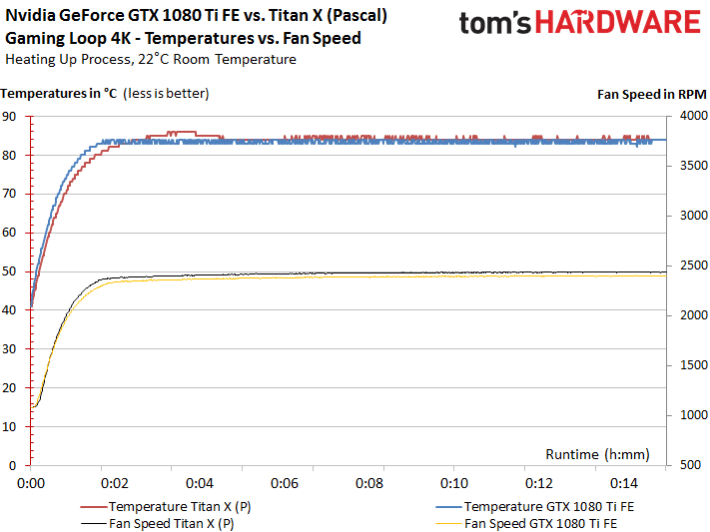

Est-ce que la Titan X (Pascal) se comportait de la même manière ? Notre banque de données nous donne des éléments de réponse : si la fréquence de la GeForce GTX 1080 Ti est un poil supérieure une fois les cartes chaudes, la Titan X (Pascal) chauffe moins rapidement, ce qui lui permet dans un premier temps de maintenir une fréquence légèrement supérieure.

On constate aussi que la Titan X (Pascal) a une fréquence beaucoup plus régulière, tandis que le système Boost de la GeForce GTX 1080 Ti montre quelques à-coups. Pour compléter ces observations, nous montrons ci-dessous les graphiques d’évolution de la consommation de la carte en jeu, selon que la carte démarre à froid ou lorsqu’elle est déjà chaude.

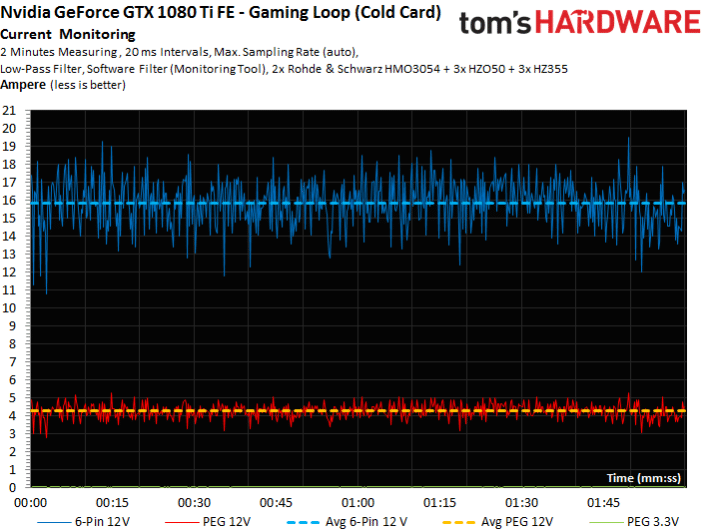

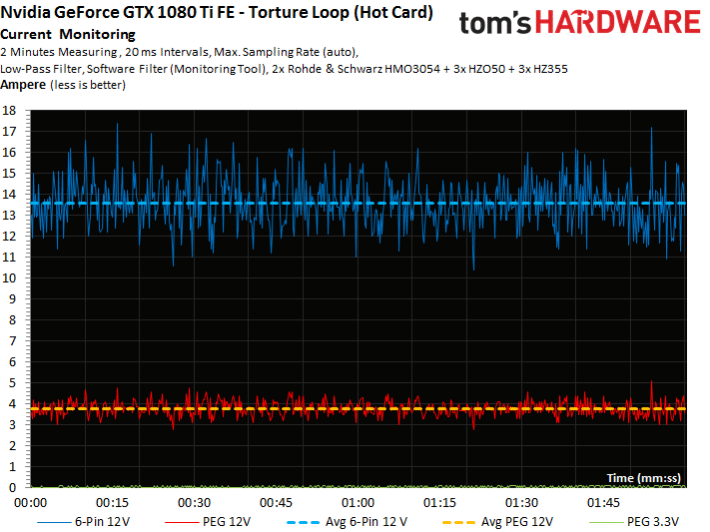

Toujours en jeu, le graphique de l’évolution de l’intensité du courant aux entrées d’alimentation montre une baisse similaire une fois la carte chaude :

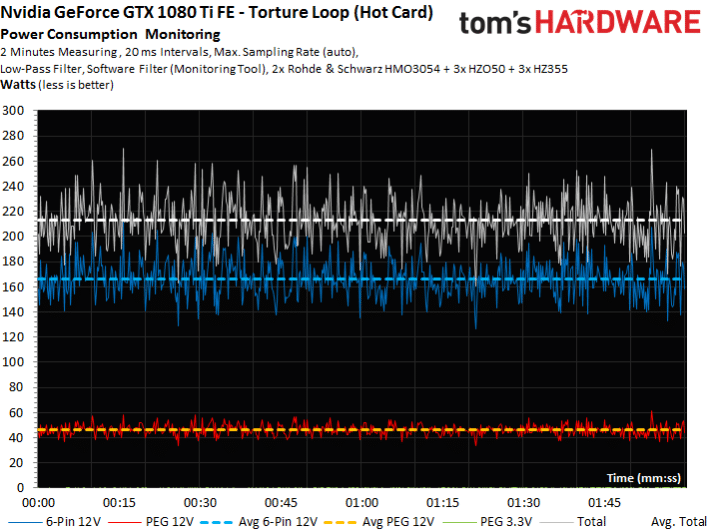

Nous avons répété ces mesures en stress-test. Comme les résultats carte froide ou chaude sont analogues, nous présentons seulement le second cas de figure. Ces résultats identiques sont dus à la limite de consommation fixée à 250 W, qui est dans les deux cas le facteur limitant, ce qui illustre le soin apporté par Nvidia à ce que la carte qui ne dépasse jamais cette valeur.

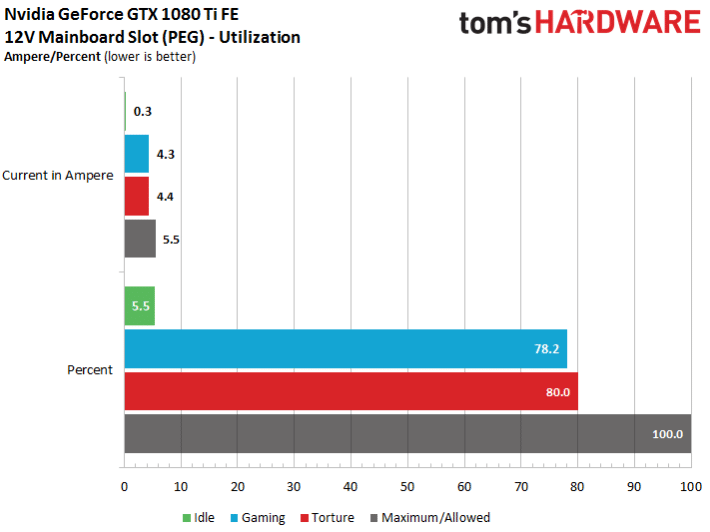

Respect des normes

Depuis la sortie de la Radeon RX 480, nous accordons une place particulière au respect des standards en vigueur et vérifions chaque carte qui passe entre nos mains. Même chose pour la GeForce GTX 1080 Ti FE, dont le comportement est exemplaire puisqu’elle reste toujours bien en dessous de la limite PCI SIG préconisée pour l’alimentation 12 V de la carte mère. Nous ne montrons pas les résultats sur l’alimentation 3,3 V de la carte mère puisque la carte ne l’utilise pas.

Avec 4,4 A au maximum, la carte tire bien moins de courant que la limite préconisée de 5,5 A. Pas d’inquiétude de ce côté-là.

Températures et bruit

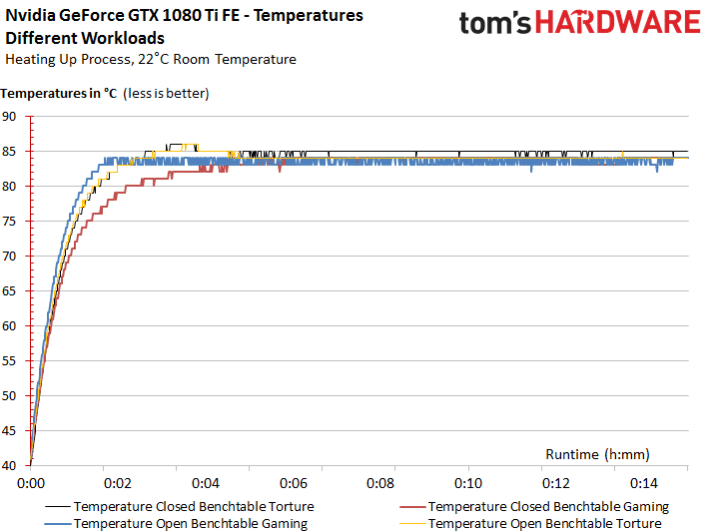

Températures en charge

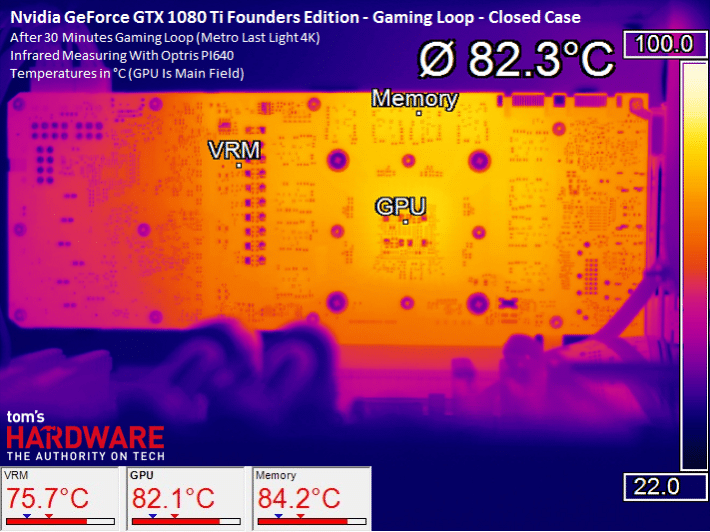

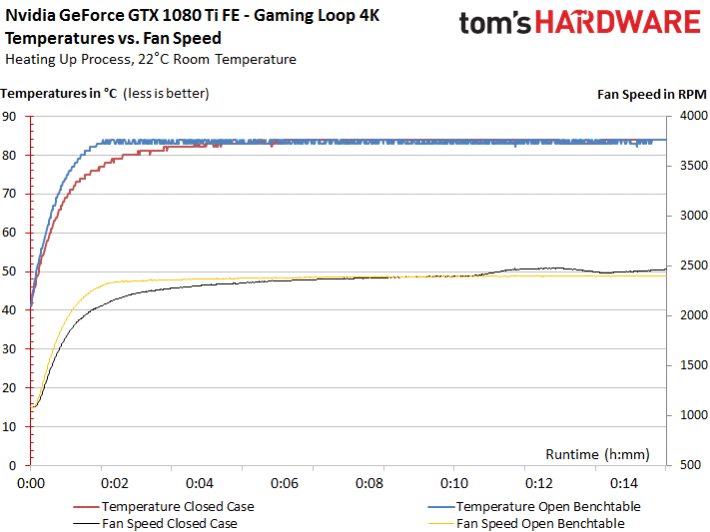

Comparons tout d’abord les courbes d’évolution des températures. L’avantage d’un système DHE (Direct Heat Exhaust pour Évacuation Directe de la Chaleur), c’est que la température en fin de test reste identique, quel que soit le cas de figure. On observe même un échauffement moins rapide dans le cas « boîtier fermé en jeu » en raison du courant d’air frais dans le boîtier. Sinon, les courbes se superposent. La carte sera donc aussi à l’aise dans un petit boîtier.

Comme nous l’avons vu à la page précédente grâce aux mesures de consommation et de l’évolution de la fréquence en fonction de la température, la dissipation thermique sur cette carte est un des facteurs limitants, tout comme sur la Titan X (Pascal). Pour compléter ces mesures, nous allons montrer à l’aide de notre caméra infrarouge haute définition comment les températures sont réparties sur le PCB. En effet, il n’y a pas que la température GPU qui compte, celles des autres composants qui ont tendance à chauffer sont aussi cruciales.

Échauffement de la carte en images et vidéo

Nous avons enregistré l’échauffement de la carte en jeu et en stress-test boîtier fermé et ouvert, ce qui fait en tout quatre vidéos, que nous avons condensées en une seule. Comme ce processus d’échauffement est relativement lent, nous avons accéléré la vidéo dix fois, ce qui permet de raccourcir considérablement la durée de visionnage. Sur chaque vidéo, nous ne mesurons en temps réel que la température au niveau du GPU.

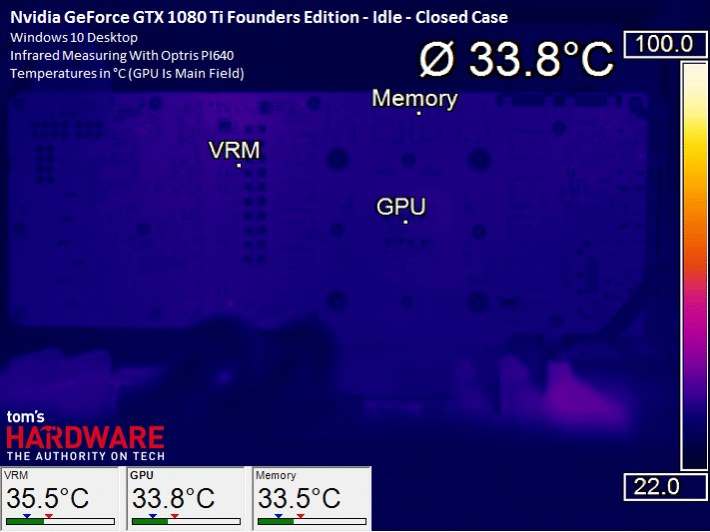

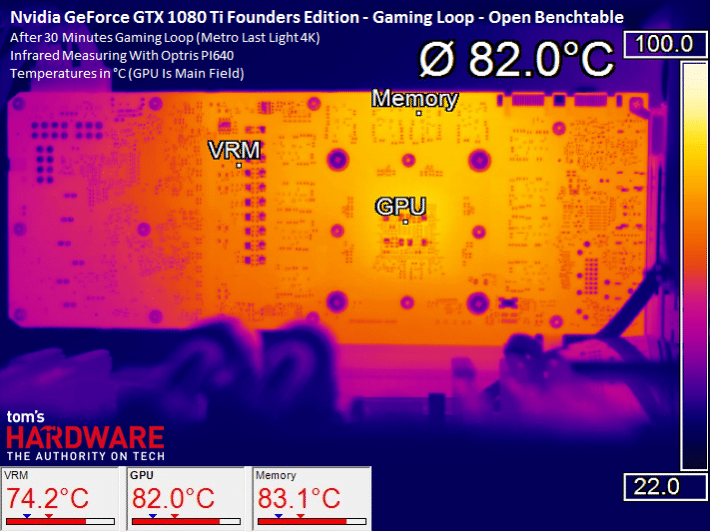

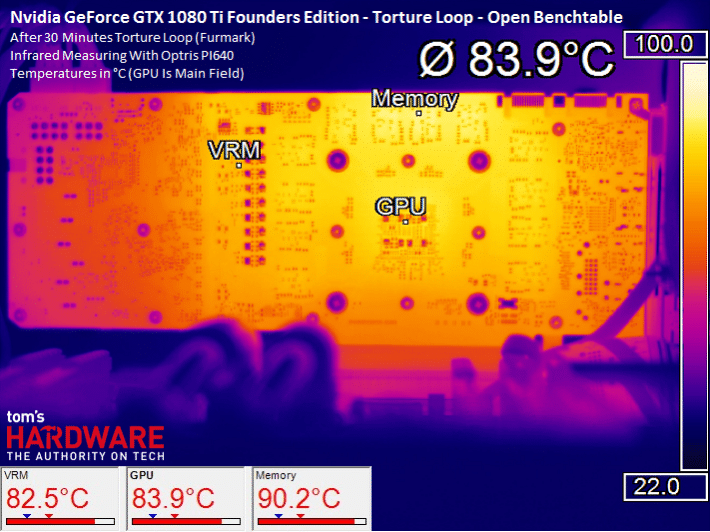

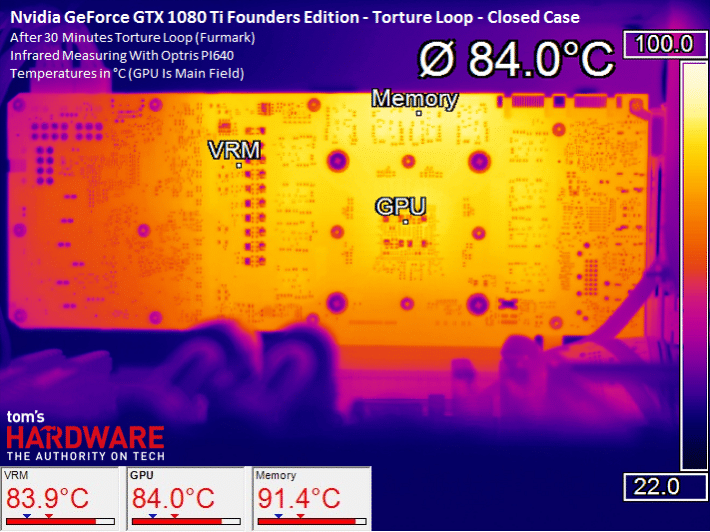

Pour les pressés ou ceux pour qui tout va trop vite, on récapitule les résultats en images. Celles-ci sont prises à la fin du test et complètent les vidéos puisqu’elles indiquent aussi les températures relevées au niveau des convertisseurs de tension et de la mémoire.

Au repos

Au repos ou dans des tâches légères (surf, vidéo), le ventilateur tourne à environ 1000 tpm (et parfois moins) tout en assurant une température GPU agréablement fraîche par rapport à d’autres cartes GTX.

En jeu

En jeu, après échauffement, nos mesures confirment une nouvelle fois que la carte fait (presque) aussi bien boîtier fermé que sur la table de benchmark :

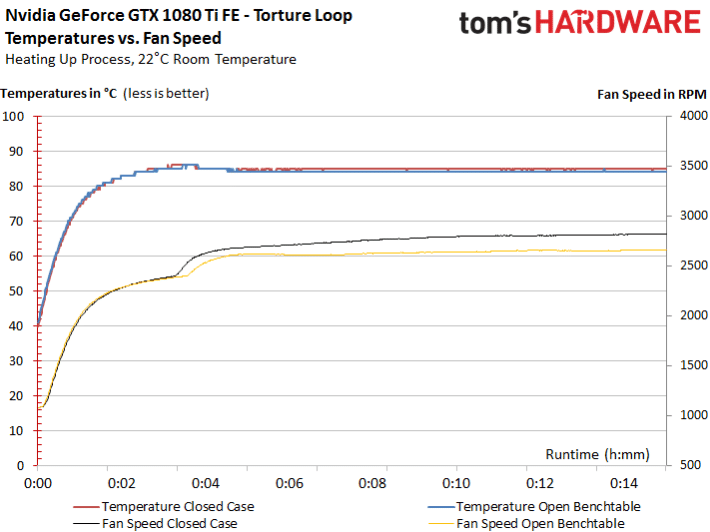

Torture

Passons au test le plus exigeant. Même constat : les températures sont dans les deux cas presque identiques, la mémoire ne prend qu’un tout petit degré à 91°C. Si cela peut paraître beaucoup, n’oublions pas que la mémoire G5X de Micron est spécifiée pour supporter des températures allant jusque 95°C et que Furmark stresse bien plus les composants que n’importe quel jeu.

On peut donc dire que le système de refroidissement effectue sa tâche avec bravoure, mais pas forcément dans la plus grande discrétion, comme nous allons maintenant le voir.

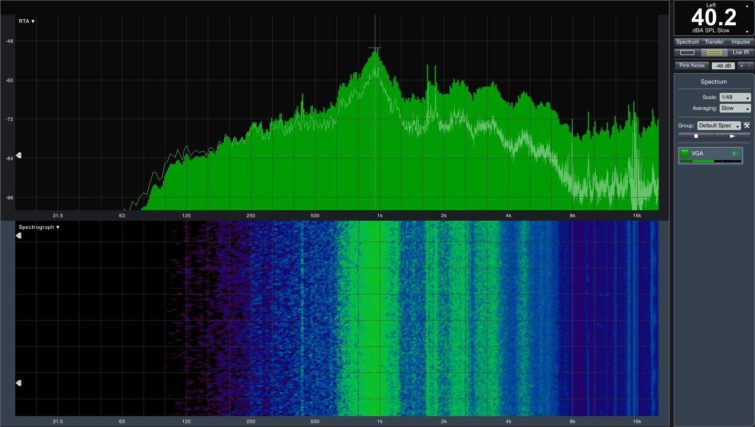

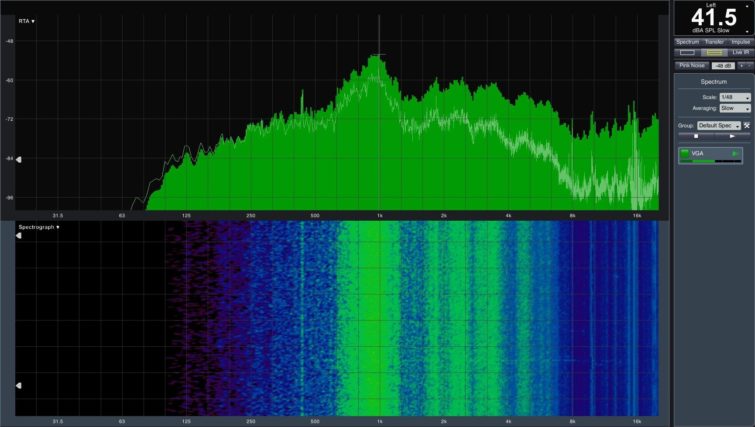

Nuisances sonores

Le bruit émis par la carte une fois chaude est nettement perceptible. On est donc loin d’une carte silencieuse et chacun devra juger si les nuisances sonores sont acceptables ou non. Observons pour commencer l’évolution de la vitesse de rotation des ventilateurs en réaction à l’augmentation des températures en jeu :

En stress-test boîtier fermé, après une phase d’échauffement semblable, le ventilateur finit par tourner nettement plus vite que sur la table de benchmark pour maintenir la température à la limite prescrite.

Si on superpose les courbes obtenues sur la Titan X (Pascal) à celles de la GeForce GTX 1080 Ti FE, on constate qu’elles sont pratiquement identiques que ce soit au niveau des températures ou des tours par minute du ventilateur.

Si Nvidia a vraiment changé quelque chose au ventirad, c’est peut-être au niveau des lamelles de dissipation au-dessus de la chambre à vapeur, car le spectre sonore diffère légèrement de celui de la Titan X (Pascal), même si à l’oreille, on n’entend aucune différence. Le niveau de nuisances sonores est à peu près identique et n’est que marginalement plus élevé une fois la carte chaude, malgré une vitesse de rotation des ventilateurs inférieure. La fréquence est par contre supérieure et ces petites variations sont sûrement dues aux variations dans la production d’un exemplaire à l’autre.

En stress-test, le ventilateur turbine pour respecter coûte que coûte la limite de température fixée malgré le surcroit de charge. La carte est donc logiquement plus bruyante.

À ce point de l’article, nous n’avons donc pas pu constater de changement significatif par rapport à la Titan X (Pascal). Certains trouveront cela dommage, d’autres se réjouiront, c’est selon.

Conclusion

Nvidia GeForce GTX 1080 Ti

-

€

nvidia geforce gtx 1080 ti329.99€

-

329.99€

-

349.99€

- Performances inégalées

- Rapport performance/prix

- PCB soigné

- GPU bridé par le radiateur

- Ceux qui ont acheté une Titan X vont pleurer

La GTX 1080 Ti offre les performances de la Titan X au prix de la GTX 1080. Pour tous ceux qui n’avaient pas craqué pour une 1080 ou une 1070 l’an dernier, c’est une excellente nouvelle. Cette carte permet de jouer de façon fluide en Ultra HD, avec les réglages poussés au maximum dans beaucoup de jeux. Elle sera aussi parfaite pour un écran 1440p à haute fréquence et pour les jeux en VR qui nécessitent un rafraîchissement à 90 Hz.

Lire le test

Avant que Jen Hsun Huang n’officialise la GTX 1080 Ti, nous avions un débat interne sur le prix auquel elle serait lancée. Nous ne nous attendions pas à la voir débarquer à 700 dollars soit le prix d’origine de la GTX 1080. La conversion en euros est un peu défavorable, puisqu’elle met la 1080 Ti à 824 euros contre 789 euros pour la 1080.

À ce tarif, la GTX 1080 Ti ridiculise la Titan X. Le seul argument de la Titan X est son Go de GDDR5 supplémentaire. Nvidia devra donc baisser son prix ou la faire disparaître totalement. Nvidia a toujours la possibilité d’utiliser son processeur GP100, avec ses 3840 coeurs, si jamais le constructeur décide de sortir une Titan plus rapide…

Les Radeon RX Vega déjà battues ?

Soulignons que le tarif de 824 euros s’applique aussi bien aux GTX 1080 Ti Founders Edition de Nvidia qu’aux autres modèles que lanceront des partenaires de la marque. Il y aura évidemment des modèles plus coûteux, dotés de radiateurs plus performants et donc encore plus puissants, mais les Founders Edition devraient empêcher les prix de s’envoler comme nous l’avons vu l’an passé sur les Pascal.

Cette tarification agressive a déjà d’autres conséquences positives : les GTX 1080 ont beaucoup baissé, on en trouve à moins de 500 euros. Même les Founders Edition sont tombées à 635 euros sur le site de Nvidia. Les GTX 1070 n’ont pas encore bougé. Nvidia attend peut-être Vega. Nous attendons toujours de découvrir ce dont les Radeon RX Vega seront capables, mais honnêtement, il est difficile d’imaginer qu’elles sauront offrir un rapport performance/prix vraiment meilleur que ce que nous avons testé aujourd’hui. S’il vous plaît, AMD, donnez-nous tort !